LobeChat+ollama大语言模型本地Docker部署

LobeChat+ollama大语言模型本地Docker部署

前言

学习了docker-compose需要实践一下,于是决定蹭DeepSeek的热度弄一个webui+LLM的部署方案。

准备工作

本文是在Linux环境下载进行的,其他系统也可以参考。

安装docker,新建一个文件夹myllm。

参数配置

在myllm中新建文件docker-compose.yaml,内容如下:

services:

ollama:

image: ollama/ollama

deploy:

# 启用GPU

resources:

reservations:

devices:

- driver: "nvidia"

count: "all"

capabilities: [ "gpu" ]

volumes:

- ollama:/root/.ollama # 持久化保存下载下来的模型文件

environment:

- "OLLAMA_ORIGINS=\"*\"" # 允许跨域连接ollama服务

lobe-chat:

image: lobehub/lobe-chat

ports:

- "3210:3210" # 映射服务端口到宿主机

depends_on:

- ollama

environment:

- "OLLAMA_PROXY_URL=http://ollama:11434" # ollama代理URL

volumes:

ollama: # 声明volume给ollama服务使用

构建启动

在myllm路径下执行以下指令

$ docker-compose up -d

[+] Running 3/3

✔ Network lobe-chat_default Created 0.1s

✔ Container lobe-chat-ollama-1 Started 0.1s

✔ Container lobe-chat-lobe-chat-1 Started 0.0s

- -d选项:detach模式启动,释放shell。

docker-compose logs [service]可以查看对应service的日志。 - 此处镜像已经提前拉取,所以启动速度快,未拉取镜像时会从头进行拉取。

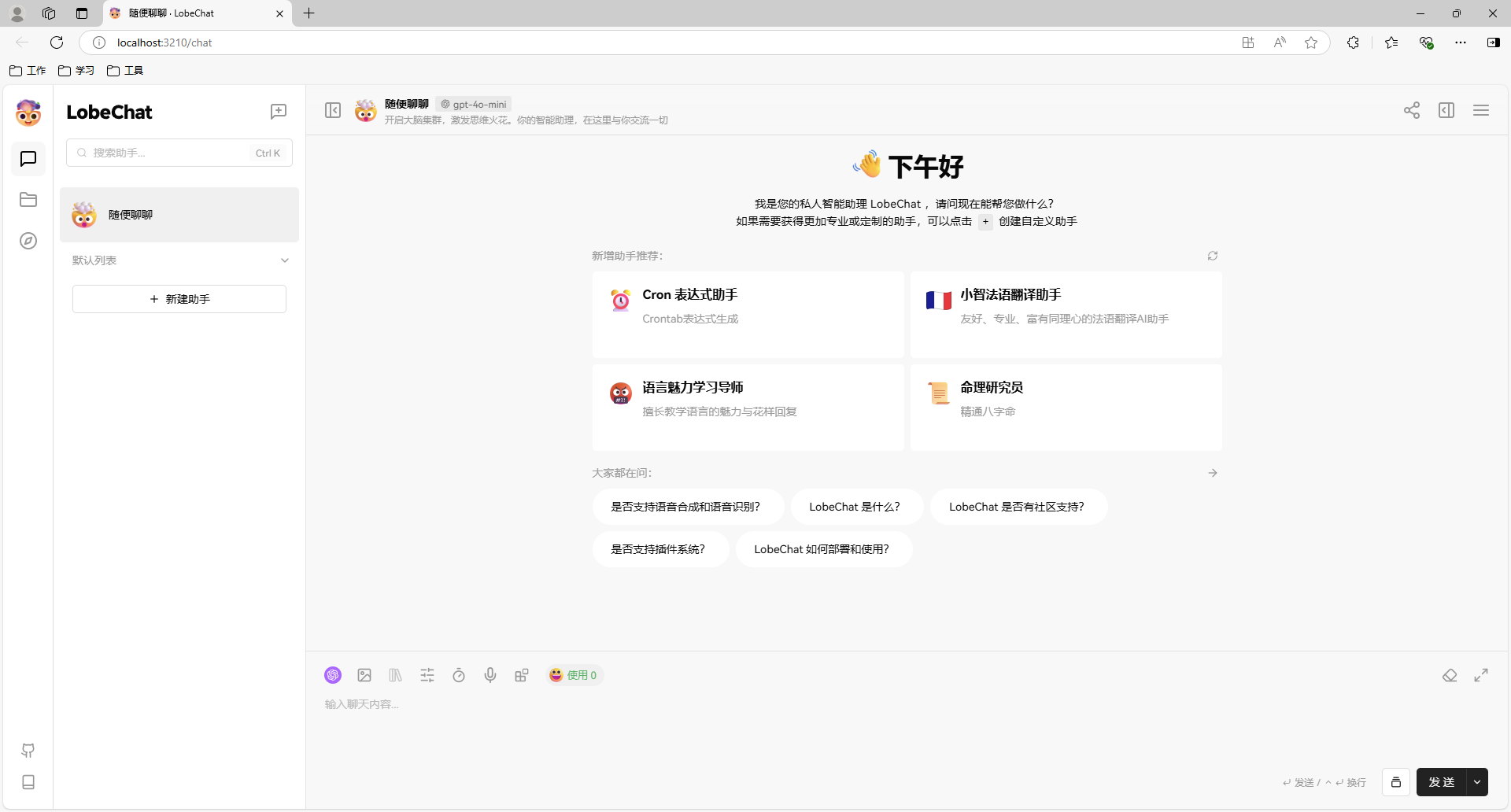

启动成功后可以访问localhost:3210查看,如果页面可以成功打开说明运行正常。

模型下载

拉取一个模型,比如deepseek-r1:1.5b。更多模型可以在ollama官网上探索。

$ docker-compose exec ollama ollama pull deepseek-r1:1.5b

pulling manifest

pulling aabd4debf0c8... 100% ▕█████████████████████████████████████████████████████████▏ 1.1 GB

pulling 369ca498f347... 100% ▕█████████████████████████████████████████████████████████▏ 387 B

pulling 6e4c38e1172f... 100% ▕█████████████████████████████████████████████████████████▏ 1.1 KB

pulling f4d24e9138dd... 100% ▕█████████████████████████████████████████████████████████▏ 148 B

pulling a85fe2a2e58e... 100% ▕█████████████████████████████████████████████████████████▏ 487 B

verifying sha256 digest

writing manifest

success

- exec:用法与docker exec用法一致,只是将容器名替换为服务名。

ollama 设置

由于默认的模型列表与实际对不上,因此要进行一下刷新。这里我还下载了一个8b的模型。

正式使用

选择模型后就可以使用了。lobechat有很多内置的功能,可以自行探索使用。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义

· 地球OL攻略 —— 某应届生求职总结

· 周边上新:园子的第一款马克杯温暖上架

· Open-Sora 2.0 重磅开源!

· 提示词工程——AI应用必不可少的技术