mapreduce整理

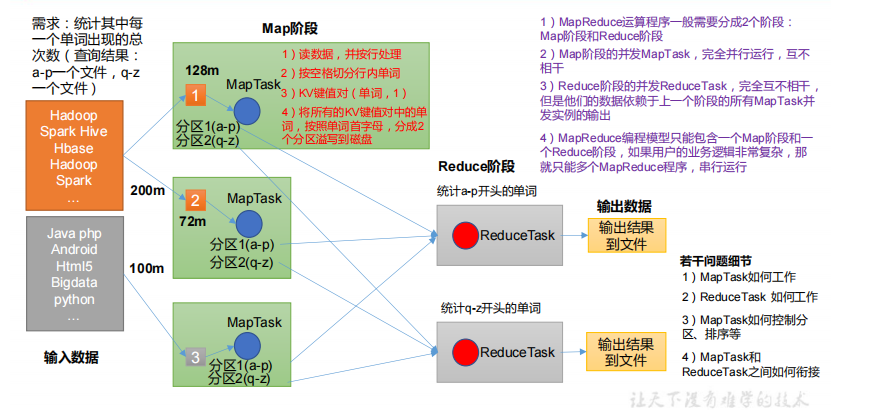

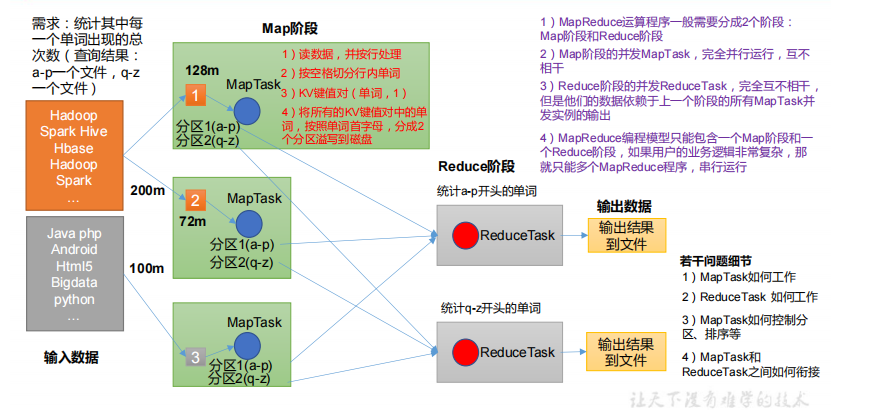

mapreduce工作流程分成maptask和reducetask俩个阶段。其实就类似于spark和flink中的map算子和 reduce算子

主要关注这几个方面

- 逻辑切片如何决定maptask并行度

- maptask计算开始前,job如何提交然后知道将文件分成多少逻辑切片

- fileinputFormat切片机制是怎么样的

- mapreduce工作流程

- shuffle机制

这些可以在以下整理的链接中去查看具体信息

mapreduce工作流程分成maptask和reducetask俩个阶段。其实就类似于spark和flink中的map算子和 reduce算子

主要关注这几个方面

这些可以在以下整理的链接中去查看具体信息