Python爬虫教程-16-破解js加密实例(有道在线翻译)

python爬虫教程-16-破解js加密实例(有道在线翻译)

- 在爬虫爬取网站的时候,经常遇到一些反爬虫技术,比如:

- 加cookie,身份验证UserAgent

- 图形验证,还有很难破解的滑动验证

- js签名验证,对传输数据进行加密处理

- 对于js加密

- 经过加密传输的就是密文,但是加密函数或者过程一定是在浏览器完成,

也就是一定会把js代码暴露给使用者 - 通过阅读加密算法,就可以模拟出加密过程,从而达到破解

- 怎样判断网站有没有使用js加密,很简单,例如有道在线翻译

-

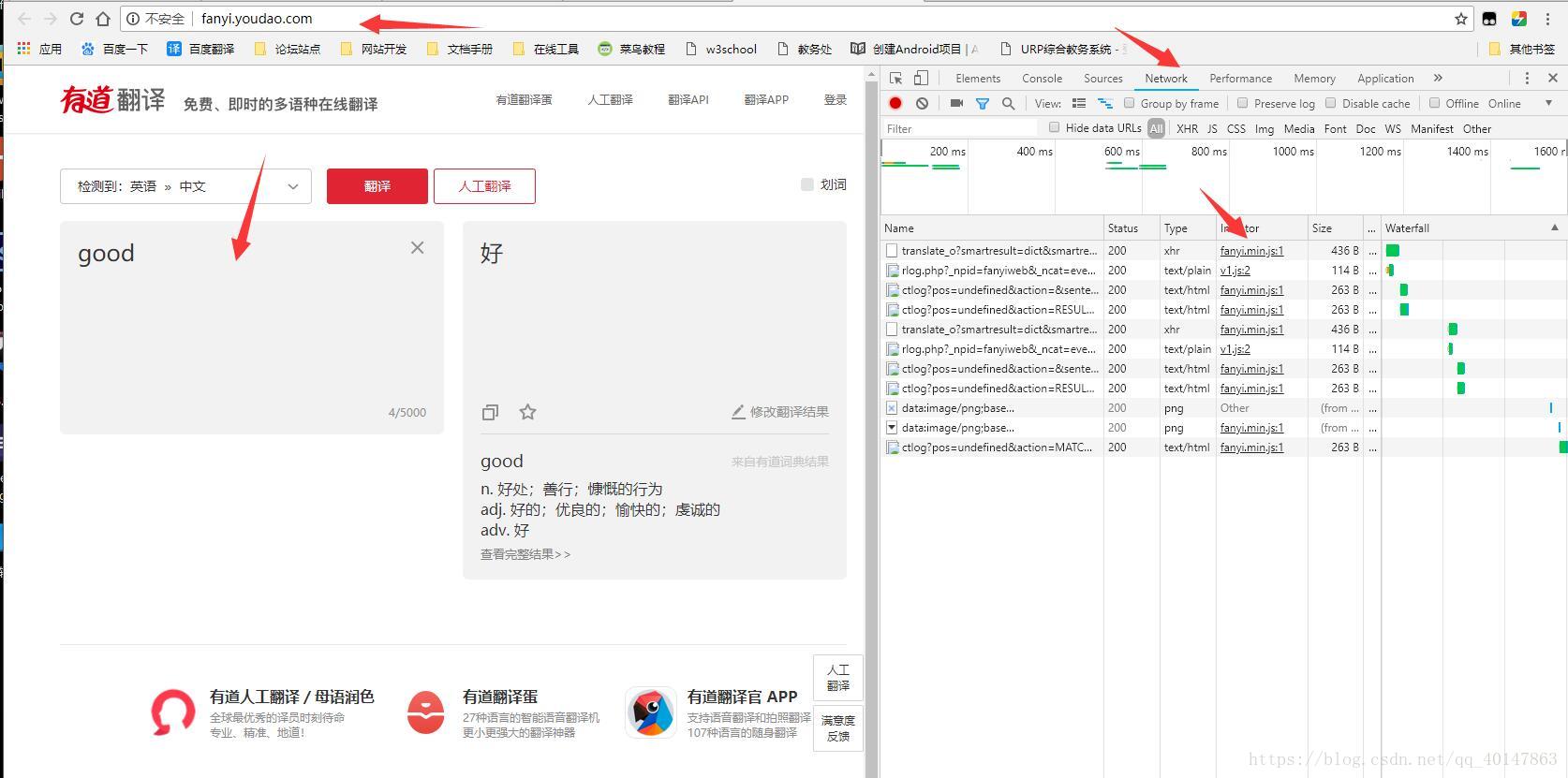

1.打开【有道在线翻译】网页:http://fanyi.youdao.com/

-

2.【右键检查】,选中【Network】

-

3.【输入单词】

-

4.在请求中,找到关于翻译内容的Form Data,可以看到有下面两项说明js加密

"salt": "1523100789519",

"sign": "b8a55a436686cd8973fa46514ccedbe",

-

- 经过加密传输的就是密文,但是加密函数或者过程一定是在浏览器完成,

分析js

- 一定要按照下面的顺序,不然的话会有很多无用的东西干扰

- 1.打开【有道在线翻译】网页:http://fanyi.youdao.com/

- 2.【右键检查】,选中【Network】

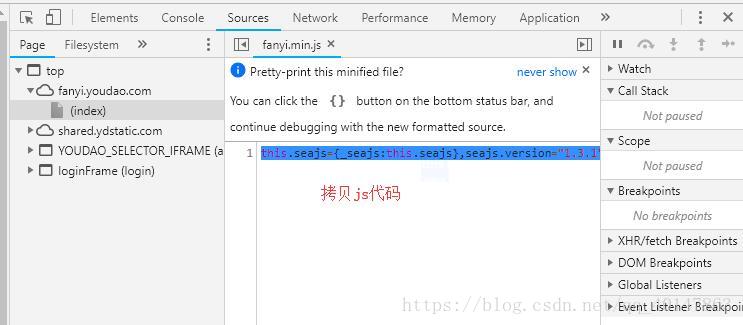

- 3.【输入单词】,【抓取js代码】

- 操作截图:

- 我们得到的js代码是一行代码,是压缩后的min代码,我们需要进行格式转换

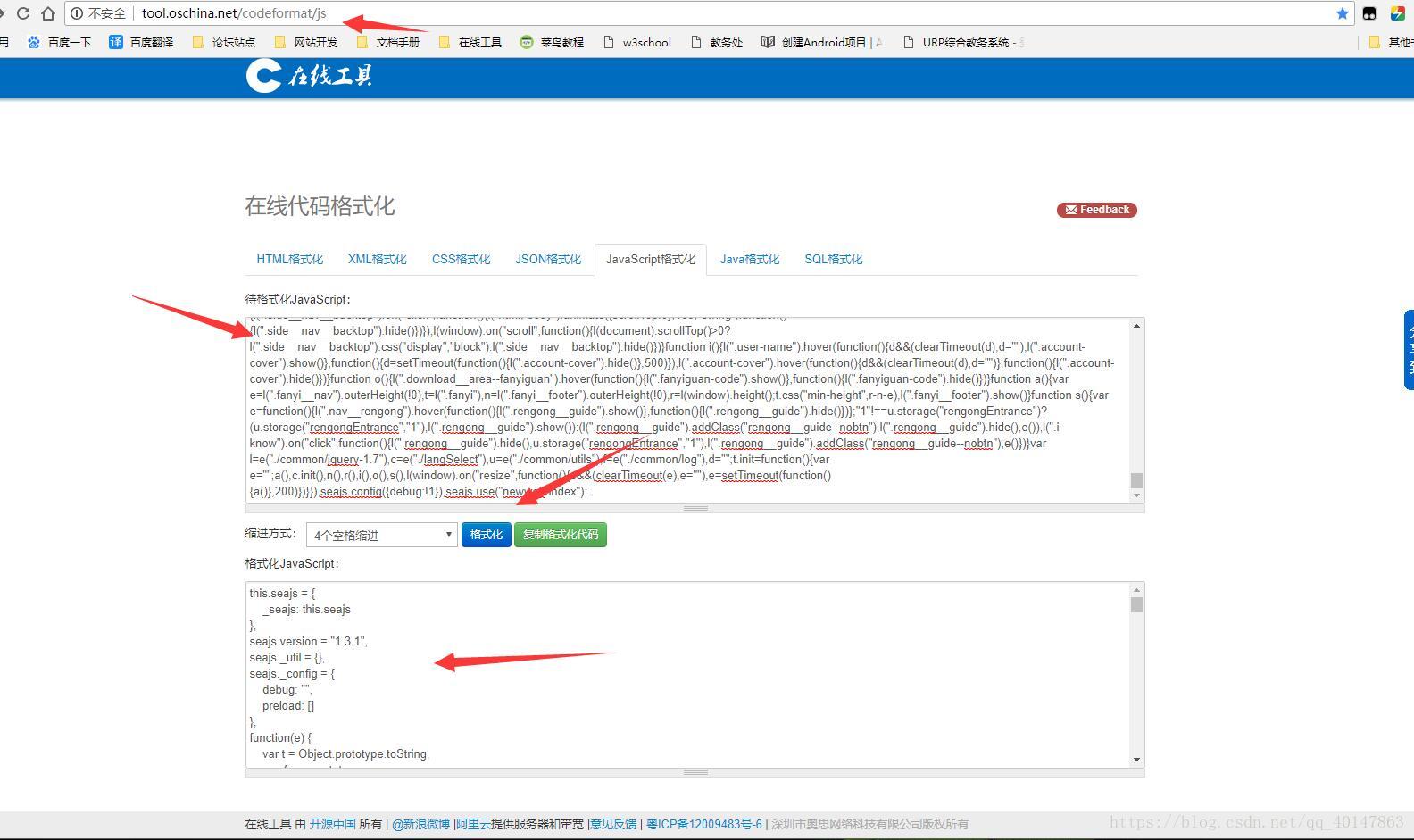

- 4.打开在线代码格式化网站:http://tool.oschina.net/codeformat/js

- 5.将拷贝的一行格式的js代码,粘贴在表单中,点击【格式化】

- 操作截图:

- 然后将格式化后的js代码,拷贝到一个可以搜索的代码编码器,备用

- 编写第2个版本

- 案例v18文件:https://xpwi.github.io/py/py爬虫/py18js2.py

# 破解js加密,版本2

'''

通过在js文件中查找salt或者sign,可以找到

1.可以找到这个计算salt的公式

r = "" + ((new Date).getTime() + parseInt(10 * Math.random(), 10))

2.sign:n.md5("fanyideskweb" + t + r + "ebSeFb%=XZ%T[KZ)c(sy!");

md5 一共需要四个参数,第一个和第四个都是固定值得字符串,第三个是所谓的salt,

第二个参数是输入的需要翻译的单词

'''

from urllib import request, parse

def getSalt():

'''

salt的公式r = "" + ((new Date).getTime() + parseInt(10 * Math.random(), 10))

把它翻译成python代码

'''

import time, random

salt = int(time.time()*1000) + random.randint(0, 10)

return salt

def getMD5(v):

import hashlib

md5 = hashlib.md5()

md5.update(v.encode('utf-8'))

sign = md5.hexdigest()

return sign

def getSign(key, salt):

sign = "fanyideskweb" + key + str(salt) + "ebSeFb%=XZ%T[KZ)c(sy!"

sign = getMD5(sign)

return sign

def youdao(key):

# url从http://fanyi.youdao.com输入词汇右键检查得到

url = "http://fanyi.youdao.com/translate_o?smartresult=dict&smartresult=true"

salt = getSalt()

# data从右键检查FormData得到

data = {

"i": key,

"from": "AUTO",

"to": "AUTO",

"smartresult": "dict",

"client": "fanyideskweb",

"salt": str(salt),

"sign": getSign(key, salt),

"doctype": "json",

"version": "2.1",

"keyform": "fanyi.web",

"action": "FY_BY_REALTIME",

"typoResult": "false"

}

print(data)

# 对data进行编码,因为参数data需要bytes格式

data = parse.urlencode(data).encode()

# headers从右键检查Request Headers得到

headers = {

"Accept": "application/json, text/javascript, */*; q=0.01",

"Accept-Language": "zh-CN,zh;q=0.9",

"Connection": "keep-alive",

"Content-Length": len(data),

"Content-Type": "application/x-www-form-urlencoded; charset=UTF-8",

"Cookie": "OUTFOX_SEARCH_USER_ID=685021846@10.168.8.76; OUTFOX_SEARCH_USER_ID_NCOO=366356259.5731474; _ntes_nnid=1f61e8bddac5e72660c6d06445559ffb,1535033370622; JSESSIONID=aaaVeQTI9KXfqfVBNsXvw; ___rl__test__cookies=1535204044230",

"Host": "fanyi.youdao.com",

"Origin": "http://fanyi.youdao.com",

"Referer": "http://fanyi.youdao.com/",

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/68.0.3440.75 Safari/537.36",

"X-Requested-With": "XMLHttpRequest"

}

req = request.Request(url=url, data=data, headers=headers)

rsp = request.urlopen(req)

html = rsp.read().decode()

print(html)

if __name__ == '__main__':

youdao("girl")

运行结果

返回翻译后的值,才算是成功

注意

按照步骤,熟悉流程最重要

更多文章链接:Python 爬虫随笔

- 本笔记不允许任何个人和组织转载

浙公网安备 33010602011771号

浙公网安备 33010602011771号