双向lstm原理

参考:https://blog.csdn.net/qq_17677907/article/details/86485461

https://zhuanlan.zhihu.com/p/626611179

https://zhuanlan.zhihu.com/p/690262925

https://blog.csdn.net/weixin_43589681/article/details/103699352

一、RNN原理

RNN是一种专门处理序列数据的神经网络结构,它的特点是具有循环连接,能够在网络中传递信息,从而捕捉序列中的时序依赖关系。

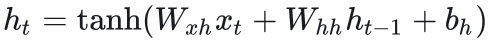

上述两公式,直接阐述了RNN的工作原理。W为连接层,h为状态,x为输入,b为偏置,y为输出。

二、lstm原理

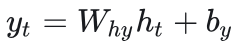

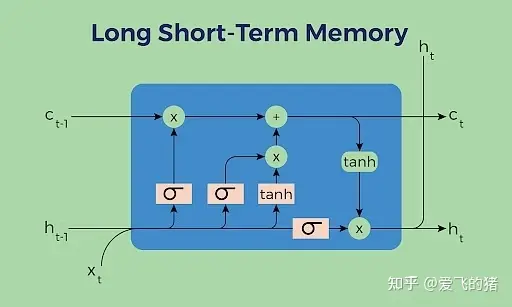

RNN存在梯度消失、不能保持长期记忆的问题,由此提出了lstm。主要是提出了门限的概念,减缓梯度消失、长短期记忆的问题。

tanh主要作用是调节、压缩数值为状态,使其数值为(-1,1)。sigmoid则发挥门限作用,保留重要信息。细胞状态则保证信息能够传递长距离信息。

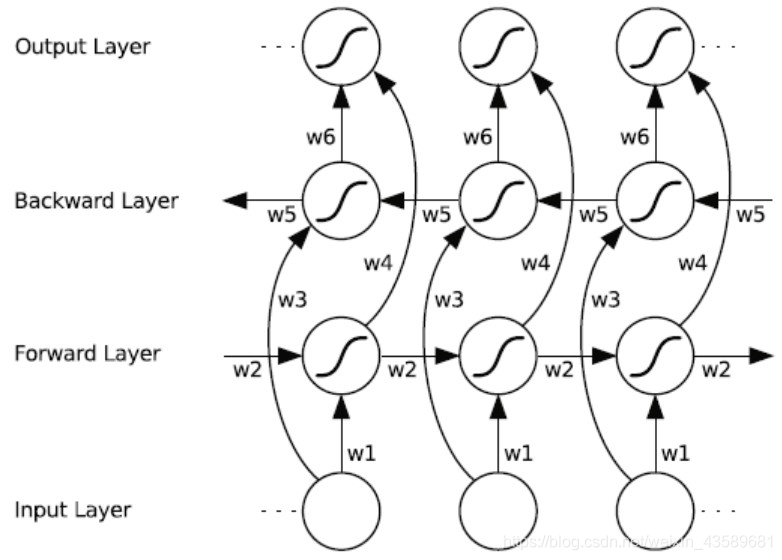

三、双向lstm

一言以蔽之,就是如上图所示那样。主要是让其发挥上下文联系的作用。transfomer可能受此启发,设计了transformer的decoder部分,而参照单向lstm设计了transformer的encoder部分。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· 开发者必知的日志记录最佳实践

· SQL Server 2025 AI相关能力初探

· Linux系列:如何用 C#调用 C方法造成内存泄露

· 终于写完轮子一部分:tcp代理 了,记录一下

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 别再用vector<bool>了!Google高级工程师:这可能是STL最大的设计失误

· 单元测试从入门到精通

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理