Differentially Private Federated Learning: A Client Level Perspective

2023.03.13周一 快中期答辩了(3.20),最近甲流高发期

毕设期间,今天学习了联邦学习的一篇论文———Differentially Private Federated Learning: A Client Level Perspective(差分隐私联邦学习:客户端级)

关键点

-

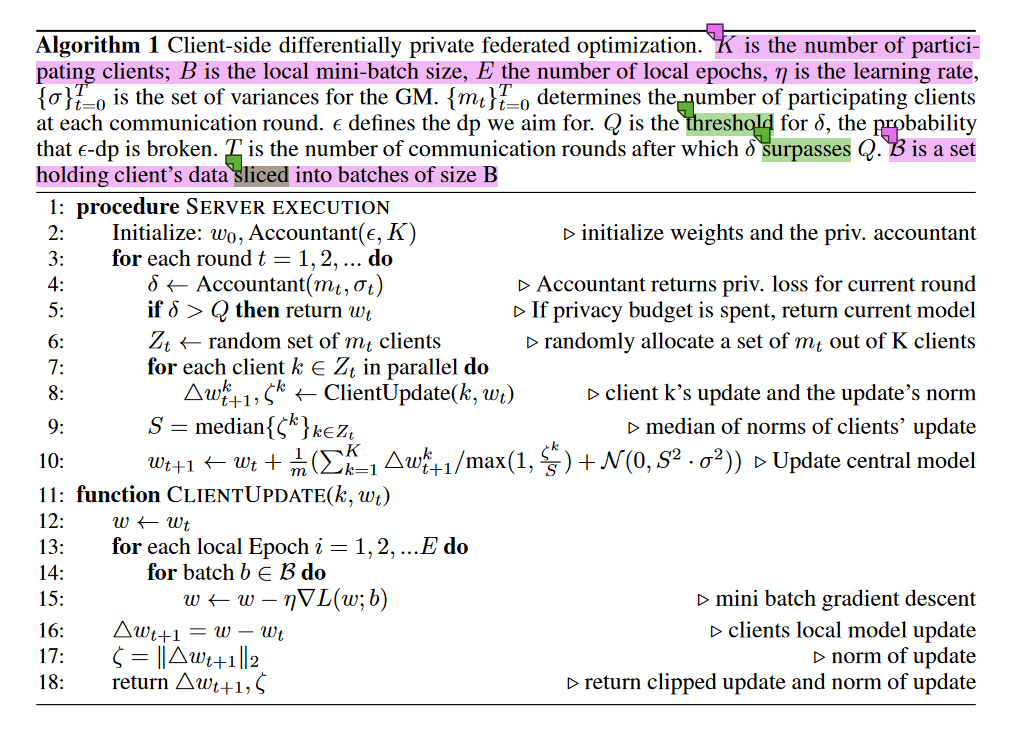

本篇论文介绍了一种基于客户端级,而非基于单条数据样本的差分隐私联邦学习保护机制。

“However, opposed to [1] we do not aim at protecting w.r.t. a single data point only. Rather, we want to ensure that a learned model does not reveal whether a client participated during decentralized training. This implies a client’s whole data set is protected against differential attacks from other clients.” 然而,与 [1] 相反,我们的目标不是保护 w.r.t.只有一个数据点。相反,我们希望确保学习模型不会揭示客户是否参与了分布式训练。这意味着客户端的整个数据集都受到保护,免受来自其他客户端的差分攻击。

注:我认为这种方法的使用要有以下几个条件:- 客户端数量足够大,毕竟要达到的目的是要敌手无法区分该客户端是否在数据集内,也就是无法提取某客户端的特征。

- 场景有待探索。据论文中说“这种领域的一个例子是医院。几百人可以联合学习一个模型,而关于特定医院的信息则被隐藏起来。” 但是由于这个基于客户端级别的差分隐私只能保护该客户端的训练特征不被发现。所以它能不能对抗模型逆向攻击,会不会泄露隐私数据还需要思考。

-

算法流程如下图:

本文作者:Xmasker^_^

本文链接:https://www.cnblogs.com/xmasker/p/17213367.html

版权声明:本作品采用知识共享署名-非商业性使用-禁止演绎 2.5 中国大陆许可协议进行许可。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 地球OL攻略 —— 某应届生求职总结

· 周边上新:园子的第一款马克杯温暖上架

· Open-Sora 2.0 重磅开源!

· 提示词工程——AI应用必不可少的技术

· .NET周刊【3月第1期 2025-03-02】