Federated Machine Learning: Concept and Applications

2022.11.26周六

今天学习了联邦学习中又一篇很经典的论文——Federated Machine Learning: Concept and Applications(联邦机器学习:概念和应用)

这篇文章是杨强教授团队于2019年所写的一篇综述。

论文概览

1.摘要

针对数据孤岛以及数据的隐私安全两大挑战,在谷歌于 2016 年首次提出的联邦学习框架之外,作者对安全联邦学习框架做了详尽的调研,本文引入了一个全面的安全联邦学习框架,包括 horizontal federated learning,vertical federated learning 和 federated transfer learning。作者建议在不同的组织之间建立基于联邦机制的数据网络,在不损害用户隐私的前提条件下实现知识共享。作者分别从定义、结构以及应用三个方面进行了介绍,同时介绍了已有的相关研究工作。

2.引言

随着AlphaGo的成功,人们自然地希望在生活的各个方面,可以实现如AlphaGo强大的、由大数据驱动的人工智能技术。然而,真实情况不尽如人意;除了一些少数的行业,大多数领域仅拥有有限的数据或低质量的数据,为人工智能技术的应用带来了很大困难。是否可以将不同组织机构的数据集合在一起?事实上,在许多情况下,要打破数据源之间的障碍是非常困难的。一般地,一些人工智能工程所使用的数据包含多种类型。例如,在一个人工智能驱动的产品推荐服务,买家有关于产品和用户购买记录的数据,但没有描述用户支付能力和购买偏好的数据。在大多数行业,数据以孤岛的形式存在。由于行业竞争、隐私安全和复杂的行政管理流程,甚至在同一个公司内部不同部门之间的数据整合都面临巨大的阻力。几乎不可能整合分散在全国各地和机构的数据,或成本巨大。

同时,随着大公司越来越意识到数据安全和用户隐私的重要性,数据隐私和安全性已成为全球性的问题。有关公共数据泄露的新闻引起了公共媒体和政府的极大关注。例如,Facebook最近的数据泄露事件引起了广泛的抗议[70]。为了避免此类事件的发生,世界各国都在加强法律以保护数据安全和隐私。例如欧盟在2018年5月25日颁布了《通用数据保护条例》(General Data Protection Regulation,GDPR)[19]。GDPR的目的是保护用户个人隐私并保证数据安全。它要求企业在用户协议中使用清晰明了的语言,并授予用户“被遗忘的权利”,即,用户可以删除或撤回其个人数据。违反该法案的公司将面临严厉的罚款。类似的隐私和安全法案正在美国和中国实施。例如,2017年颁布的中国的网络安全法和民法通则要求,互联网企业在与第三方进行数据交易时,不得泄露或篡改其收集的个人信息,他们需要确保拟议的合同遵循法律数据保护义务。这些规则的建立将有助于建立更加文明的社会,但是同时为现如今由数据驱动的AI技术提出了新的挑战。

更具体地说,人工智能中的传统数据处理模式通常涉及简单的数据交易,一方收集数据并将其传输到另一方,另一方负责清理和融合数据。最终,一个第三方将整合数据并构建模型以供其它方使用。这种模型常常作为产品进行出售。同时,由于用户可能不清楚模型未来将如何被使用,因此,这样的做法违反了如GDPR这类法律。所以,人们面临着数据以孤岛形式存在的困境,在很多情况下,被禁止收集、融合和使用数据。如何合法地解决数据孤岛的问题成为了时下人工智能研究人员和从业者面临的主要挑战。

本文中,作者介绍了一个新的方法,联邦学习,该方法是应对这些挑战的一个可能的方案。作者调研了联邦学习中已有的研究工作,并提出了全面的安全联邦学习框架的定义、类型以及应用。作者讨论了联邦学习框架如何能成功地用于各个行业。在推动联邦学习的过程中,作者希望人工智能发展的重点从提高模型性能(这是大多数人工智能领域目前正在做的事情)转移到符合数据隐私和安全法律的数据集成方法。

3.联邦学习综述

Google最近提出了联邦学习概念[36,37,41]。Google的主要想法是,基于分布在不同设备上的数据集来构建机器学习模型,同时禁止数据泄露。在联邦学习中,人们关注的重点在于克服统计挑战[60,77]以及提升安全性[9,23]。还有一些研究工作致力于使联合学习更具个性化[13,60]。上述工作重点关注设备上的联邦学习,在这种环境中,分布式的移动用户交互,存在通信开销大、数据分布不平衡以及设备不可靠等因素。除此之外,根据用户ID或者设备ID,数据被分成不同部分。因此,数据空间被横向切割为不同的部分。关于这方面的工作高度依赖于隐私保护机器学习,[58]介绍了这方面已有的研究工作。由于需要在非中心化合作学习环境中考虑数据隐私,因此为了将联邦学习概念拓展到各个组织机构间的合作式学习场景中,作者针对隐私保护非中心化合作机器学习技术,推广了原始的联邦学习概念。在[71]中,作者已经初步概述了联邦学习和联邦迁移学习技术。在这篇文章中,作者进一步介绍了相关安全基础以及探索了一些与其它领域的关系,例如多代理理论和隐私保护数据挖掘。本节,作者提出了一个更具一般意义的联邦学习的定义,其考虑了数据分割、安全性以及应用。作者也介绍了联邦学习系统的工作流程和系统结构。

[36] Jakub Konecný, H. Brendan McMahan, Daniel Ramage, and Peter Richtárik. 2016. Federated optimization: Distributed machine learning for on-device intelligence. CoRR abs/1610.02527 (2016). arxiv:1610.02527 http://arxiv.org/abs/1610. 02527 [37] Jakub Konecný, H. Brendan McMahan, Felix X. Yu, Peter Richtárik, Ananda Theertha Suresh, and Dave Bacon. 2016. Federated learning: Strategies for improving communication efficiency. CoRR abs/1610.05492 (2016). arxiv:1610.05492 http://arxiv.org/abs/1610.05492

[41] H. Brendan McMahan, Eider Moore, Daniel Ramage, and Blaise Agüera y Arcas. 2016. Federated learning of deep networks using model averaging. CoRR abs/1602.05629 (2016). arxiv:1602.05629 http://arxiv.org/abs/1602.05629.

[60] Virginia Smith, Chao-Kai Chiang, Maziar Sanjabi, and Ameet S. Talwalkar. 2017. Federated multi-task learning. In Advances in Neural Information Processing Systems 30,I.Guyon,U.V.Luxburg,S.Bengio,H.Wallach,R. Fergus, S. Vishwanathan, and R. Garnett (Eds.). Curran Associates, Inc., 4424–4434. http://papers.nips.cc/paper/7029-federated-multi-task-learning.pdf.

[77] Yue Zhao, Meng Li, Liangzhen Lai, Naveen Suda, Damon Civin, and Vikas Chandra. 2018. Federated Learning with Non-IID Data. arxiv:cs.LG/1806.00582

[9] Keith Bonawitz, Vladimir Ivanov, Ben Kreuter, Antonio Marcedone, H. Brendan McMahan, Sarvar Patel, Daniel Ramage, Aaron Segal, and Karn Seth. 2017. Practical secure aggregation for privacy-preserving machine learning. In Proceedings of the 2017 ACM SIGSAC Conference on Computer and Communications Security (CCS’17).ACM,New York, NY, 1175–1191. DOI:https://doi.org/10.1145/3133956.3133982

[23] Robin C. Geyer, Tassilo Klein, and Moin Nabi. 2017. Differentially private federated learning: A client level perspective. CoRR abs/1712.07557 (2017). arxiv:1712.07557 http://arxiv.org/abs/1712.07557

[13] Fei Chen, Zhenhua Dong, Zhenguo Li, and Xiuqiang He. 2018. Federated meta-learning for recommendation. CoRR abs/1802.07876 (2018). arxiv:1802.07876 http://arxiv.org/abs/1802.07876.

[60] Virginia Smith, Chao-Kai Chiang, Maziar Sanjabi, and Ameet S. Talwalkar. 2017. Federated multi-task learning. In Advances in Neural Information Processing Systems 30,I.Guyon,U.V.Luxburg,S.Bengio,H.Wallach,R. Fergus, S. Vishwanathan, and R. Garnett (Eds.). Curran Associates, Inc., 4424–4434. http://papers.nips.cc/paper/7029-federated-multi-task-learning.pdf.

[58] Reza Shokri and Vitaly Shmatikov. 2015. Privacy-preserving deep learning. In Proceedings of the 22nd ACM SIGSAC Conference on Computer and Communications Security (CCS’15). ACM, New York, NY, 1310–1321. DOI:https://doi.org/10.1145/2810103.2813687

[71] Qiang Yang, Yang Liu, Tianjian Chen, and Yongxin Tong. 2018. Federated learning. Communications of the CCF 14, 11 (2018), 49–55.

3.1 联邦学习定义

定义\(N\)个数据持有者 \(\{{\mathcal{F}}_{1},\dots{\mathcal{F}}_{N}\}\) ,所有上述个体希望通过合并他们各自的数据 \(\{{\mathcal{D}}_{1},\dots{\mathcal{D}}_{N}\}\) 来训练一个机器学习模型,一种常规方法是将数据集合在一起,使用 \({\mathcal{D}}={\mathcal{D}}_{1}\cup\dotsb\cup{\mathcal{D}}_{N}\)来训练一个模型 \(M_{SUM}\) ,对于联邦学习来说,其意义在于各个数据持有者协同的来训练一个模型\(M_{FED}\)。在训练过程中各个数据持有者\(F_i\)对自己持有的数据\(D_i\)进行保护,保证不会泄露给其他人。并保证联邦学习模型 \(M_{FED}\) 的准确率 \(V_{FED}\) 尽可能接近联合学习模型 \(M_{SUM}\) 的准确率 \(V_{SUM}\) ,定义一个非负实数 \(\delta\) :

如果满足上述条件,则称这个联邦学习模型满足 \(\delta\)-accuracy loss。

3.2 联邦学习隐私保护

隐私(Privacy)是联邦学习(Federated Learning)的基本属性之一。以下介绍联邦学习的主要隐私技术:

-

安全多方计算(Secure Multi-party Computation SMC)。SMC安全模型自然涉及多方,并在一个定义明确的模拟框架中提供安全证明,以保证完全的Zero knowledge,也就是说,每一方除了其输入和输出外什么都不知道。Zero knowledge是非常理想的,但这种理想的属性通常需要复杂的计算协议,而且可能无法有效实现。

-

差分隐私(Differential Privacy DP)。另一类方法使用差分隐私或\(k\)-匿名化来保护数据隐私。差分隐私、\(k\)-匿名和多样化方法在数据中添加噪音,或使用泛化方法来掩盖某些敏感属性,直到第三方无法区分个人,从而使数据无法被还原以保护用户隐私。然而,这些方法的根基仍然需要将数据传输到其他地方,而且这些工作通常涉及准确性和隐私之间的权衡。

-

同态加密(Homomorphic Encryption)。通过在机器学习过程中的加密机制下的参数交换来保护用户数据隐私。与差分隐私保护不同的是,数据和模型本身不被传输,也不能被对方的数据所猜测。因此,在原始数据层面上,泄漏的可能性很小。

3.3 联邦学习分类

横向联邦学习、纵向联邦学习、联邦迁移学习

具体略

3.4 联邦学习系统架构

3.4.1 横向联邦学习

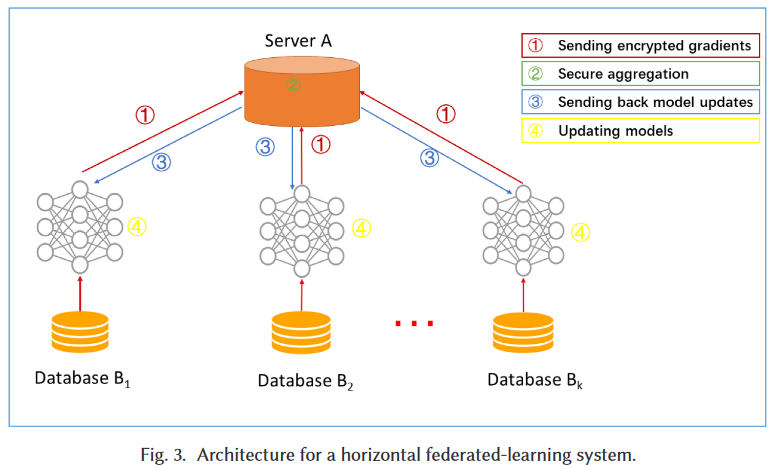

一个典型的水平联邦学习系统的架构如图 3 所示。在这个系统中,具有相同数据结构的 个参与者在一个参数或云服务器的帮助下协作学习一个机器学习模型。一个典型的假设是,用户端是安全的,服务器端可能是安全的,因此不允许任何参与者的信息泄露给服务器。这样一个系统的训练过程通常包含以下四个步骤:

- 参与者在本地计算梯度,用加密(差分隐私)掩盖部分梯度。将遮蔽的结果发送给服务器。

- 服务器在不了解任何参与者信息的情况下进行安全的梯度聚合。

- 服务器将梯度汇总后的结果发回给参与者。

- 参与者用解密的梯度更新他们各自的模型。

通过上述步骤的迭代持续到损失函数收敛,从而完成整个训练过程。这种架构独立于特定的机器学习算法(逻辑回归、DNN等),所有参与者都将共享最终的模型参数。

如果用SMC[9]或Homomorphic Encryption[51]进行梯度聚合,上述架构被证明可以保护数据不被半诚实的服务器泄露。但在另一种安全模式下,它可能会受到恶意参与者在协作学习过程中训练生成对抗网络(GAN)的攻击[29]。

[9] Keith Bonawitz, Vladimir Ivanov, Ben Kreuter, Antonio Marcedone, H. Brendan McMahan, Sarvar Patel, Daniel Ramage, Aaron Segal, and Karn Seth. 2017. Practical secure aggregation for privacy-preserving machine learning. In Proceedings of the 2017 ACM SIGSAC Conference on Computer and Communications Security (CCS’17).ACM,New York, NY, 1175–1191. DOI:https://doi.org/10.1145/3133956.3133982

[51] Le Trieu Phong, Yoshinori Aono, Takuya Hayashi, Lihua Wang, and Shiho Moriai. 2018. Privacy-preserving deep learning via additively homomorphic encryption. IEEE Trans. Information Forensics and Security 13, 5 (2018), 13331345.

[29] Briland Hitaj, Giuseppe Ateniese, and Fernando Pérez-Cruz. 2017. Deep models under the GAN: Information leakage from collaborative deep learning. CoRR abs/1702.07464 (2017).

3.4.2 纵向联邦学习

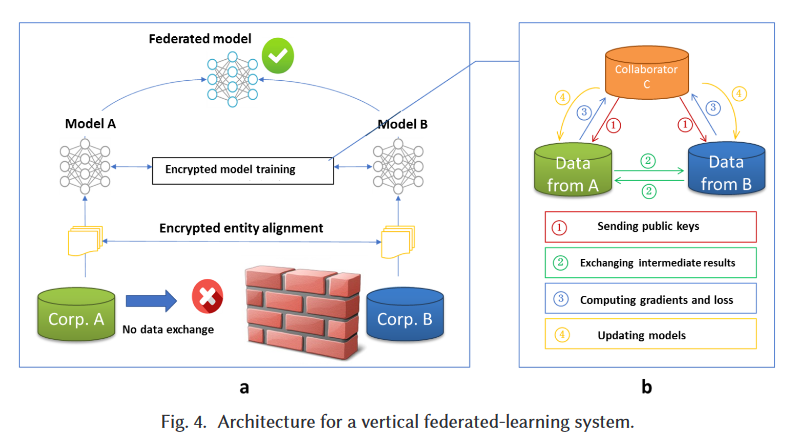

假设公司A和公司B希望共同训练机器学习模型,并且他们的业务系统各自具有自己的数据。此外,公司B还具有模型需要预测的标签数据。出于数据隐私和安全原因,A和B无法直接交换数据。为了确保在培训过程中数据的机密性,需要第三方协作者C的参与。在这里,我们假设协作者C是诚实的,并且不与A或B串通,但A和B都是诚实但好奇的。受信任的第三方C是一个合理的假设,因为第三方C可以由政府等机构扮演,也可以由诸如Intel Software Guard Extensions(SGX)[7]之类的安全计算节点代替。联邦学习系统由两部分组成,如图4所示。

第一部分 加密的实体对齐(Encrypted entity alignment)。由于两家公司的用户群不一样,系统使用基于加密的用户 ID 对齐技术[38,56],在不暴露 A 和 B 各自数据的情况下确认双方的共同用户。在实体对齐过程中,系统不会暴露彼此不重合的用户。

第二部分 加密的模型训练(Encrypted model training)。在确定共同实体后,可以使用这些共同实体的数据来训练机器学习模型。训练过程可以分为以下四个步骤(如图4所示):

- 合作者 C 创建加密对,向 A 和 B 发送公钥。

- A 和 B 加密并交换梯度和损失计算的中间结果。

- A 和 B 分别计算加密的梯度和添加额外的掩码,B 也计算出加密的损失;A 和 B 将加密的值发送给 C。

- C 解密并将解密后的梯度和损失发回给 A 和 B;A 和 B 解除梯度掩码,相应地更新模型参数。

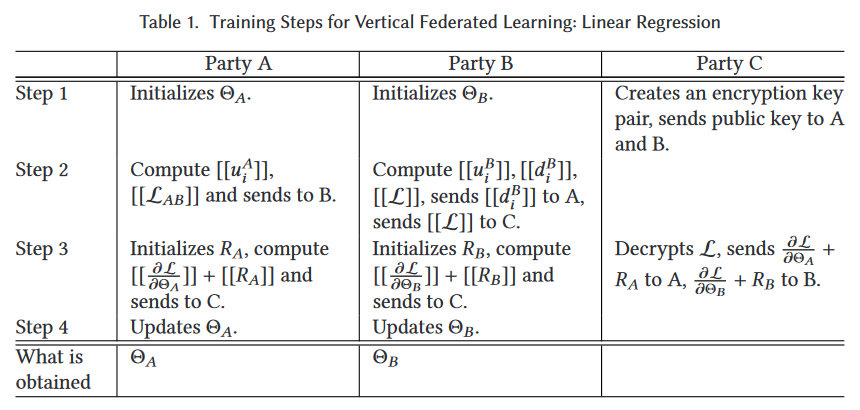

在这里,我们说明了使用线性回归和同态加密作为一个例子。 要使用梯度下降方法训练线性回归模型,我们需要安全损耗和梯度的计算。假设学习率 \(\eta\),正则化参数 \(\lambda\),数据集合 \(\{x_i^A\}_{i\in\mathcal{D}_A}\), \(\{x_i^B, y_i\}_{i\in\mathcal{D}_B}\),模型参数 \(\Theta_{A}\), \({\Theta}_{B}\),训练目标为:

令 \(u_{i}^{A}=\Theta_{A} x_{i}^{A}, u_{i}^{B}=\Theta_{B} x_{i}^{B}\),那么加密之后的 loss 为:

其中,同态加密用 \([[\cdot]]\) 表示。令 \(\left[\left[\mathcal{L}_{A}\right]\right]=\left[\left[\sum_{i}\left(\left(u_{i}^{A}\right)^{2}\right)+\frac{\lambda}{2} \Theta_{A}^{2}\right]\right],\left[\left[\mathcal{L}_{B}\right]\right]=\left[\left[\sum_{i}\left(\left(u_{i}^{B}-y_{i}\right)^{2}\right)+\frac{\lambda}{2} \Theta_{B}^{2}\right]\right]\),以及 \(\left[\left[\mathcal{L}_{A B}\right]\right]=2 \sum_{i}\left(\left[\left[u_{i}^{A}\right]\right]\left(u_{i}^{B}-y_{i}\right)\right)\),那么有:

类似道理,令 \(\left[\left[d_{i}\right]\right]=\left[\left[u_{i}^{A}\right]\right]+\left[\left[u_{i}^{B}-y_{i}\right]\right]\),我们可以计算梯度为:

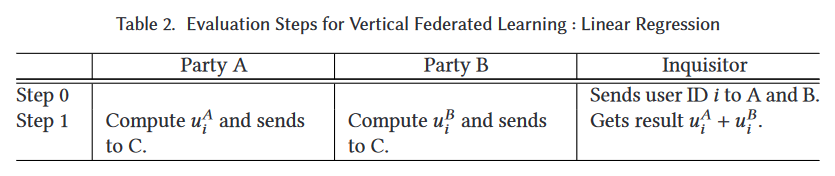

有关详细步骤,请参见表 1 和 2。在实体对齐和模型训练过程中,A 和 B 的数据保留在本地,并且训练中的数据交互不会导致数据隐私泄露。注意向 C 泄漏的潜在信息可能会或可能不会被视为侵犯隐私。为了进一步防止 C 在这种情况下从 A 或 B 学习信息,A 和 B 可以通过添加加密的随机掩码来进一步向 C 隐藏其梯度。因此,双方在联邦学习的帮助下实现了对共同模型的共同训练。因为在训练过程中,当事方收到的损失和梯度 \(VS\) 在没有隐私约束的情况下使用在同一个地方收集的数据共同建立一个模型时,他们收到的损失和梯度完全相同,也就是说,该联邦学习模型是无损的。模型的效率取决于加密数据的通信成本和计算成本。在每次迭代中,A 和 B 之间发送的信息随重叠样本的数量而定。因此,通过采用分布式并行计算技术可以进一步提高该算法的效率。

安全分析

表1所示的训练协议没有向C透露任何信息,因为所有 C 获悉的信息都是被掩盖的梯度,并且被掩盖矩阵的随机性和保密性得到了保证[16]。在上述协议中,甲方在每个步骤都学习其梯度,但这不足以使甲根据等式8从乙学习任何信息,因为标量乘积协议的安全性基于无法解决 \(n\) 个未知数中的方程[16,65]。在这里,我们假设样本数量 \(N_A\)远大于 \(n_A\),其中 \(N_A\) 是特征数量。同样,乙方也无法向甲方学习任何信息。因此,证明了该协议的安全性。请注意,我们假设双方都是半诚实的。如果一方是恶意的并且通过伪造其输入来欺骗系统,例如,方A仅提交具有一个非零功能的一个非零输入,则它可以告诉该示例该功能的 \(u_i^B\) 值。虽然它仍然不能告诉 \(x_i^B\) 或 \(\Theta_B\),并且偏差将使下一次迭代的结果失真,从而警告另一方终止学习过程。在训练过程结束时,每一方(A或B)都不会理会另一方的数据结构,并且它仅获得与自身功能相关的模型参数。在推论时,双方需要使用表2中所示的步骤来协同计算预测结果,但这仍然不会导致信息泄漏。

[38] Gang Liang and Sudarshan S. Chawathe. 2004. Privacy-preserving inter-database operations. In International Conference on Intelligence and Security Informatics. Springer, 66–82.

[56] Monica Scannapieco, Ilya Figotin, Elisa Bertino, and Ahmed K. Elmagarmid. 2007. Privacy preserving schema and data matching. In Proceedings of the 2007 ACM SIGMOD International Conference on Management of Data (SIGMOD’07). ACM, New York, NY, 653–664. DOI:https://doi.org/10.1145/1247480.1247553

3.4.3 联邦迁移学习

假设在上述垂直联邦学习的例子中,A 和 B 只有很小的重叠样本集,而我们对学习 A 中所有数据集的标签感兴趣。到目前为止,上面描述的架构只对重叠的数据集有效。为了将其覆盖范围扩大到整个样本空间,引入迁移学习。具体来说,迁移学习通常涉及学习 A 和 B 的特征之间的共同表示,并通过利用源域方(本例中为 B)的标签,使预测目标域方的标签的误差最小。因此,A 和 B 的梯度计算与垂直联邦学习不同。在推理时,仍然需要双方计算预测结果。

3.4.4 激励机制

为了在不同的组织之间充分实现联合学习的商业化,需要开发一个公平的平台和激励机制[20]。模型建立后,模型的性能将在实际应用中体现出来,这种性能可以记录在永久性的数据记录机制中(如区块链)。提供更多数据的组织将获得更好的收益,模型的有效性取决于数据提供者对系统的贡献。模式的有效性是基于联邦机制分配给各方的,并激励更多的组织加入数据联邦。

上述架构的实现不仅考虑了隐私保护和多个组织间协作建模的有效性,还考虑了如何奖励贡献更多数据的组织,以及如何用共识机制实施激励。因此,联邦学习是一种 "闭环 "学习机制。

[20] Boi Faltings, Goran Radanovic, and Ronald Brachman. 2017. Game Theory for Data Science: Eliciting Truthful Information. Morgan & Claypool Publishers.

3.5 联邦学习与其他系统区别

3.5.1 隐私保护机器学习

联邦学习可以被认为是保护隐私的分散协作机器学习,因此它与多方隐私保护机器学习紧密相关。过去,许多研究工作已致力于该领域。例如,参考文献[17,67]提出了用于垂直分割数据的安全多方决策树的算法。 Vaidya和Clifton提出了用于垂直分区数据的安全关联挖掘规则[65],安全k均值[66]和朴素贝叶斯分类器[64]。参考文献[31]提出了一种用于水平分割数据的关联规则的算法。安全支持向量机算法是针对垂直分割的数据[73]和水平分割的数据[74]开发的。参考文献[16]提出了用于多方线性回归和分类的安全协议。参考文献[68]提出了安全的多方梯度下降方法。上面的工作全部用于安全性多方计算(SMC)[25,72],以确保隐私。

Nikolaenko等人[48]为了实现水平分割数据的线性回归,使用同态加密和姚氏混淆电路,实现了一种隐私保护协议,参考文献[22,24]提出了一种用于垂直分割数据的线性回归方法。这些系统直接解决了线性回归问题。文献[47]利用随机梯度下降法(SGD)解决了这一问题,他们还提出了用于逻辑回归和神经网络的隐私保护协议。最近,有人提出了采用三服务器模型的后续工作[44]。 Aono等人[4]提出了一种使用同态加密的安全逻辑回归协议。 Shokri和Shmatikov [58]提出了通过交换更新参数对水平分割数据进行神经网络训练的方法。文献[51]使用加性同态加密来保护梯度的私密性并增强系统的安全性。随着深度学习的最新进展,保护隐私的神经网络推理也收到了很多研究兴趣[10,11,14,28,40,52,54]。

[17] Wenliang Du and Zhijun Zhan. 2002. Building decision tree classifier on private data. In Proceedings of the IEEE International Conference on Privacy, Security and Data Mining - Volume 14 (CRPIT’02). Australian Computer Society, Inc., Darlinghurst, Australia, Australia, 1–8. http://dl.acm.org/citation.cfm?id=850782.850784.

[67] Jaideep Vaidya and Chris Clifton. 2005. Privacy-preserving decision trees over vertically partitioned data. In Data and Applications Security XIX, Sushil Jajodia and Duminda Wijesekera (Eds.). Springer, Berlin, 139–152.

[65] Jaideep Vaidya and Chris Clifton. 2002. Privacy preserving association rule mining in vertically partitioned data. In Proceedings of the 8th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining (KDD’02). ACM, New York, NY, 639–644. DOI:https://doi.org/10.1145/775047.775142

[66] Jaideep Vaidya and Chris Clifton. 2003. Privacy-preserving K-means clustering over vertically partitioned data. In Proceedings of the 9th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining (KDD’03). ACM, New York, NY, 206–215. DOI:https://doi.org/10.1145/956750.956776

[64] Jaideep Vaidya and Chris Clifton. 2004. Privacy preserving naïve Bayes classifier for vertically partitioned data. In Proceedings of the 4th SIAM Conference on Data Mining, 2004. 330–334.

[31] Murat Kantarcioglu and Chris Clifton. 2004. Privacy-preserving distributed mining of association rules on horizontally partitioned data. IEEE Trans. on Knowl. and Data Eng. 16, 9 (Sept. 2004), 1026–1037. DOI:https://doi.org/10.1109/TKDE.2004.45

[73] Hwanjo Yu, Xiaoqian Jiang, and Jaideep Vaidya. 2006. Privacy-preserving SVM using nonlinear kernels on horizontally partitioned data. In Proceedings of the 2006 ACM Symposium on Applied Computing (SAC’06).ACM,NewYork, NY, 603–610. DOI:https://doi.org/10.1145/1141277.1141415

[74] Hwanjo Yu, Jaideep Vaidya, and Xiaoqian Jiang. 2006. Privacy-preserving SVM classification on vertically partitioned data. In Proceedings of the 10th Pacific-Asia Conference on Advances in Knowledge Discovery and Data Mining (PAKDD’06). Springer, Berlin, 647–656. DOI:https://doi.org/10.1007/11731139_74

[16] Wenliang Du, Yunghsiang Sam Han, and Shigang Chen. 2004. Privacy-preserving multivariate statistical analysis: Linear regression and classification. In SDM, Vol. 4. 222–233.

[68] Li Wan, Wee Keong Ng, Shuguo Han, and Vincent C. S. Lee. 2007. Privacy-preservation for gradient descent methods. In Proceedings of the 13th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining (KDD’07). ACM, New York, NY, 775–783. DOI:https://doi.org/10.1145/1281192.1281275

[25] O. Goldreich, S. Micali, and A. Wigderson. 1987. How to play any mental game. In Proceedings of the 19th Annual ACM Symposium on Theory of Computing (STOC’87). ACM, New York, NY, 218–229. DOI:https://doi.org/10.1145/28395.28420

[72] Andrew C. Yao. 1982. Protocols for secure computations. In Proceedings of the 23rd Annual Symposium on Foundations of Computer Science (SFCS’82). IEEE Computer Society, Washington, DC, 160–164. http://dl.acm.org/citation.cfm?id=1382436.1382751.

[48] Valeria Nikolaenko, Udi Weinsberg, Stratis Ioannidis, Marc Joye, Dan Boneh, and Nina Taft. 2013. Privacy-preserving ridge regression on hundreds of millions of records. In Proceedings of the 2013 IEEE Symposium on Security and Privacy (SP’13). IEEE Computer Society, Washington, DC, 334–348. DOI:https://doi.org/10.1109/SP.2013.30

[22] Adrià Gascón, Phillipp Schoppmann, Borja Balle, Mariana Raykova, Jack Doerner, Samee Zahur, and David Evans. 2016. Secure linear regression on vertically partitioned datasets. IACR Cryptology ePrint Archive 2016 (2016), 892.

[24] Irene Giacomelli, Somesh Jha, Marc Joye, C. David Page, and Kyonghwan Yoon. 2017. Privacy-preserving ridge regression with only linearly-homomorphic encryption. Cryptology ePrint Archive, Report 2017/979. https://eprint.iacr. org/2017/979.

[47] Payman Mohassel and Yupeng Zhang. 2017. SecureML: A system for scalable privacy-preserving machine learning. IACR Cryptology ePrint Archive 2017 (2017), 396.

[44] Payman Mohassel and Peter Rindal. 2018. ABY3: A mixed protocol framework for machine learning. In Proceedings of the 2018 ACM SIGSAC Conference on Computer and Communications Security (CCS’18). ACM, New York, NY, 35–52. DOI:https://doi.org/10.1145/3243734.3243760

[4] Yoshinori Aono, Takuya Hayashi, Le Trieu Phong, and Lihua Wang. 2016. Scalable and secure logistic regression via homomorphic encryption. In Proceedings of the 6th ACM Conference on Data and Application Security and Privacy (CODASPY’16). ACM, New York, NY, 142–144. DOI:https://doi.org/10.1145/2857705.2857731

[58] Reza Shokri and Vitaly Shmatikov. 2015. Privacy-preserving deep learning. In Proceedings of the 22nd ACM SIGSAC Conference on Computer and Communications Security (CCS’15). ACM, New York, NY, 1310–1321. DOI:https://doi.org/10.1145/2810103.2813687

[51] Le Trieu Phong, Yoshinori Aono, Takuya Hayashi, Lihua Wang, and Shiho Moriai. 2018. Privacy-preserving deep learning via additively homomorphic encryption. IEEE Trans. Information Forensics and Security 13, 5 (2018), 13331345.

[10] Florian Bourse, Michele Minelli, Matthias Minihold, and Pascal Paillier. 2017. Fast homomorphic evaluation of deep discretized neural networks. IACR Cryptology ePrint Archive 2017 (2017), 1114.

[11] Hervé Chabanne, Amaury de Wargny, Jonathan Milgram, Constance Morel, and Emmanuel Prouff. 2017. Privacypreserving classification on deep neural network. IACR Cryptology ePrint Archive 2017 (2017), 35.

[14] Nathan Dowlin, Ran Gilad-Bachrach, Kim Laine, Kristin Lauter, Michael Naehrig, and John Wernsing. 2016. CryptoNets: Applying Neural Networks to Encrypted Data with High Throughput and Accuracy. Technical Report. Retrieved December 26, 2018 from https://www.microsoft.com/en-us/research/publication/cryptonets-applyingneural-networks-to-encrypted-data-with-high-throughput-and-accuracy/.

[28] Ehsan Hesamifard, Hassan Takabi, and Mehdi Ghasemi. 2017. CryptoDL: Deep neural networks over encrypted data. CoRR abs/1711.05189 (2017). arxiv:1711.05189 http://arxiv.org/abs/1711.05189.

[40] Jian Liu, Mika Juuti, Yao Lu, and N. Asokan. 2017. Oblivious neural network predictions via MiniONN transformations. In Proceedings of the 2017 ACM SIGSAC Conference on Computer and Communications Security (CCS’17).ACM, New York, NY, 619–631. DOI:https://doi.org/10.1145/3133956.3134056

[52] M. Sadegh Riazi, Christian Weinert, Oleksandr Tkachenko, Ebrahim M. Songhori, Thomas Schneider, and Farinaz Koushanfar. 2018. Chameleon: A hybrid secure computation framework for machine learning applications. CoRR abs/1801.03239 (2018).

[54] Bita Darvish Rouhani, M. Sadegh Riazi, and Farinaz Koushanfar. 2017. DeepSecure: Scalable provably-secure deep learning. CoRR abs/1705.08963 (2017). arxiv:1705.08963 http://arxiv.org/abs/1705.08963.

3.5.2 联邦学习 VS 分布式机器学习

乍一看,水平联邦学习与分布式机器学习有些相似。分布式机器学习涵盖了许多方面,包括训练数据的分布式存储,计算任务的分布式操作,模型结果的分布式分布等。参数服务器[30]是分布式机器学习中的典型元素。作为加速训练过程的工具,参数服务器将数据存储在分布式工作节点上,通过中央调度节点分配数据和计算资源,从而更有效地训练模型。对于水平联邦学习,工作节点代表数据所有者。它具有本地数据的完全自治权,并且可以决定何时以及如何加入联邦学习。在参数服务器中,中央节点始终负责控制,因此联邦学习面临着更为复杂的学习环境。其次,联邦学习强调在模型训练过程中对数据所有者的数据隐私保护。保护数据隐私的有效措施可以更好地应对将来日益严格的数据隐私和数据安全监管环境。

像在分布式机器学习设置中一样,联邦学习也将需要处理非IID数据。在[77]中表明,使用非IID本地数据,联邦学习的性能会大大降低。作为回应,作者提供了一种类似于迁移学习的新方法来解决该问题。

[30] Qirong Ho, James Cipar, Henggang Cui, Jin Kyu Kim, Seunghak Lee, Phillip B. Gibbons, Garth A. Gibson, Gregory R. Ganger, and Eric P. Xing. 2013. More effective distributed ML via a stale synchronous parallel parameter server. In Proceedings of the 26th International Conference on Neural Information Processing Systems - Volume 1 (NIPS’13). Curran Associates Inc., 1223–1231. http://dl.acm.org/citation.cfm?id=2999611.2999748.

[77] Yue Zhao, Meng Li, Liangzhen Lai, Naveen Suda, Damon Civin, and Vikas Chandra. 2018. Federated Learning with Non-IID Data. arxiv:cs.LG/1806.00582

3.5.3 联邦学习 VS 边缘计算

联邦学习可以看作是边缘计算的操作系统,因为它为协调和安全性提供了学习协议。 在[69]中,作者考虑了使用基于梯度下降的方法训练的通用机器学习模型。 他们从理论的角度分析了分布梯度下降的收敛范围,并在此基础上提出了一种控制算法,该算法确定了局部更新和全局参数聚合之间的最佳折衷,以在给定资源预算下将损失函数降至最低。

[69] Shiqiang Wang, Tiffany Tuor, Theodoros Salonidis, Kin K. Leung, Christian Makaya, Ting He, and Kevin Chan. 2018. When edge meets learning: Adaptive control for resource-constrained distributed machine learning. CoRR abs/1804.05271 (2018). arxiv:1804.05271 http://arxiv.org/abs/1804.05271.

3.5.4 联邦学习 VS 联邦数据库系统

联合数据库系统[57]是集成多个数据库单元并整体管理集成系统的系统。提出了联邦数据库概念以实现与多个独立数据库的互操作性。联邦数据库系统通常使用分布式存储来存储数据库单元,实际上,每个数据库单元中的数据都是异构的。因此,就数据的类型和存储而言,它与联邦学习有很多相似之处。但是,联邦数据库系统在彼此交互的过程中不包含任何隐私保护机制,并且所有数据库单元对于管理系统都是完全可见的。此外,联合数据库系统的重点是数据的基本操作,包括插入,删除,搜索和合并等,而联邦学习的目的是在以下前提下为每个数据所有者建立联合模型。保护数据隐私,使数据所包含的各种价值和法律更好地为我们服务。

[57] Amit P. Sheth and James A. Larson. 1990. Federated database systems for managing distributed, heterogeneous, and autonomous databases. ACM Comput. Surv. 22, 3 (Sept. 1990), 183–236. DOI:https://doi.org/10.1145/96602.96604

参考资料

- Q. Yang, Y. Liu, T. Chen, and Y. Tong, “Federated Machine Learning: Concept and Applications,” ACM Trans. Intell. Syst. Technol., vol. 10, no. 2, p. 12:1-12:19, Jan. 2019, doi: 10.1145/3298981.

- 联邦学习综述:Federated Machine Learning: Concept and Applications

- 综述《Federated Machine Learning: Concept and Applications》

- 联邦机器学习:概念和应用(Federated Machine Learning: Concept and Applications)