RealityCapture重建试验

一、使用已有数据集

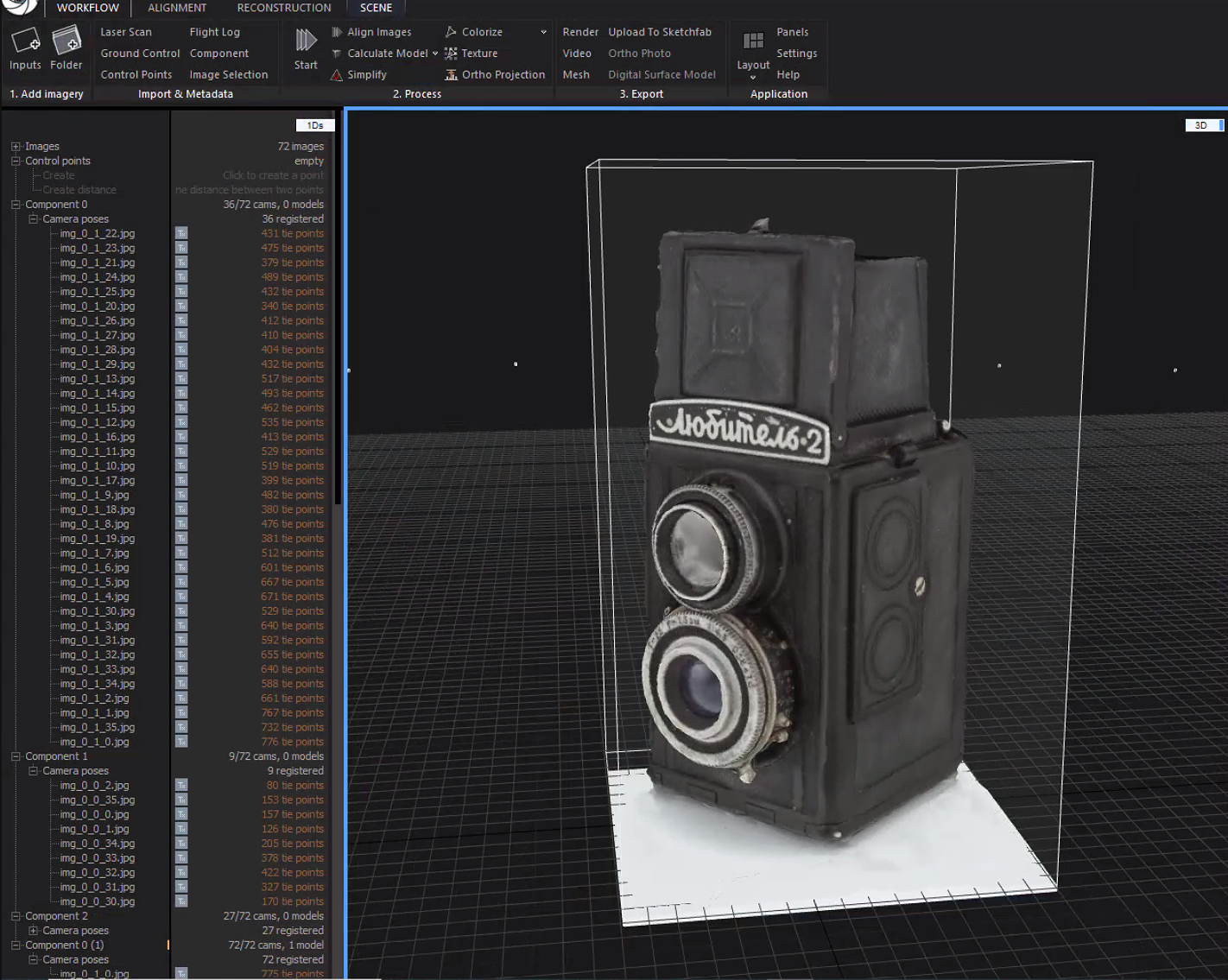

(一)小型物件(官网)

输入:Camera_Lubitel2_studio

“Lubitel Camera” consisting of 72 images

地址:https://www.capturingreality.com/advent-calendar-datasets

Captured with Canon 5D mark III

基本流程:

- Input

- Align Images

- calculate model

- colorize + texture

- adjust & export (导出时记得不要把相机加入模型)

输出:

with color and texture

评价:

重建效果令人满意,从RGB图集中可以看出清晰的拍摄镜头逻辑,中间平移一圈,中上平移一圈,中下平移一圈。因而相机位姿容易估计。同时背景简单,干扰小。对个人拍摄取景有一定指导意义,但是由于小物件重建,与大型建筑的重建在相机拍摄点位置选取上有较大的复杂度差别。

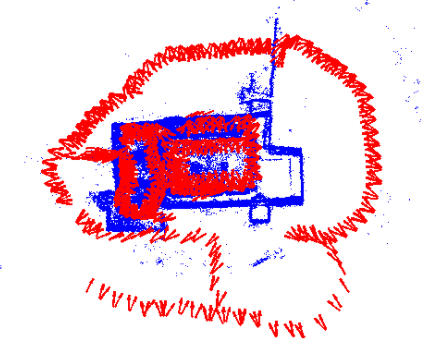

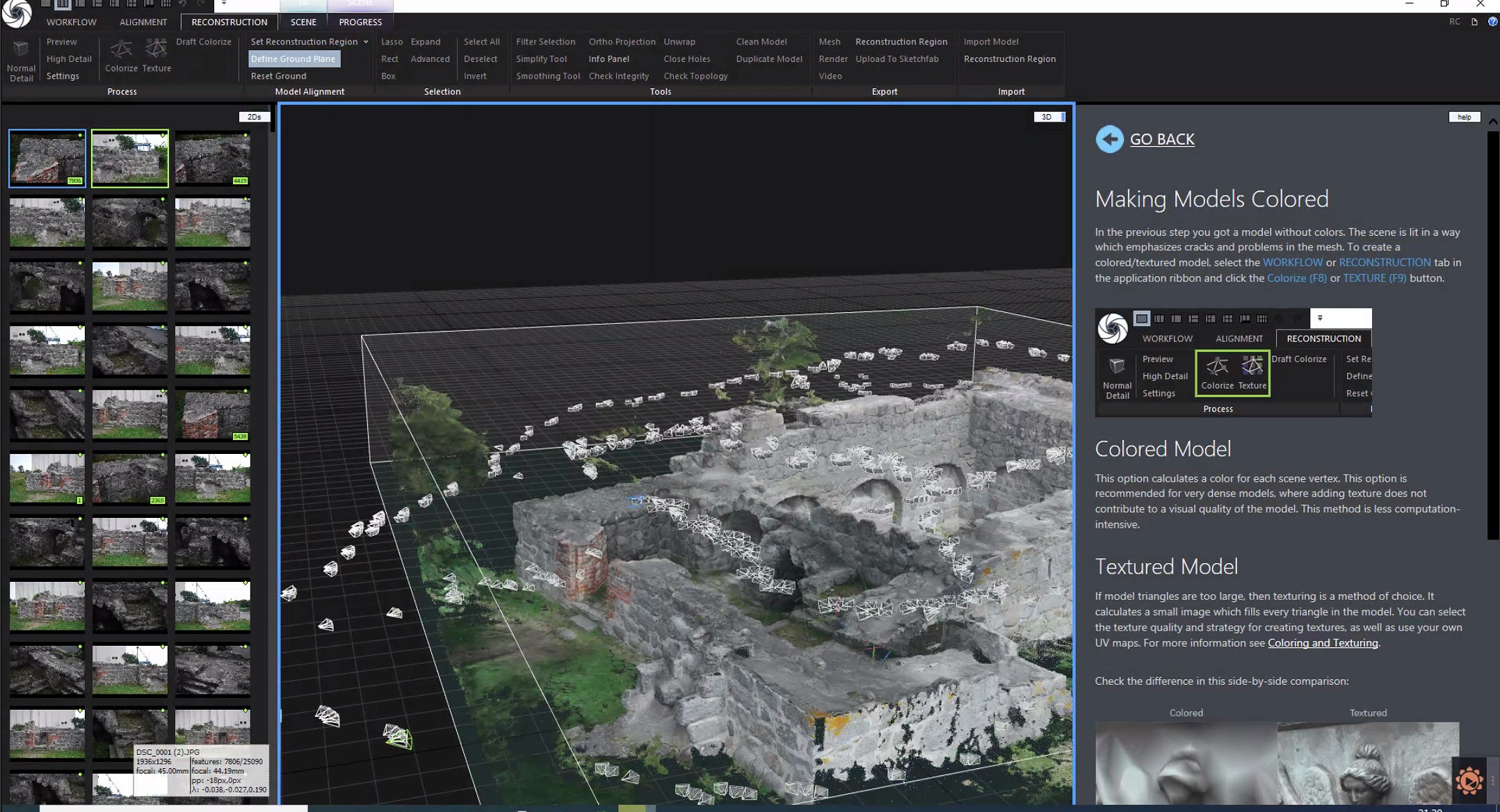

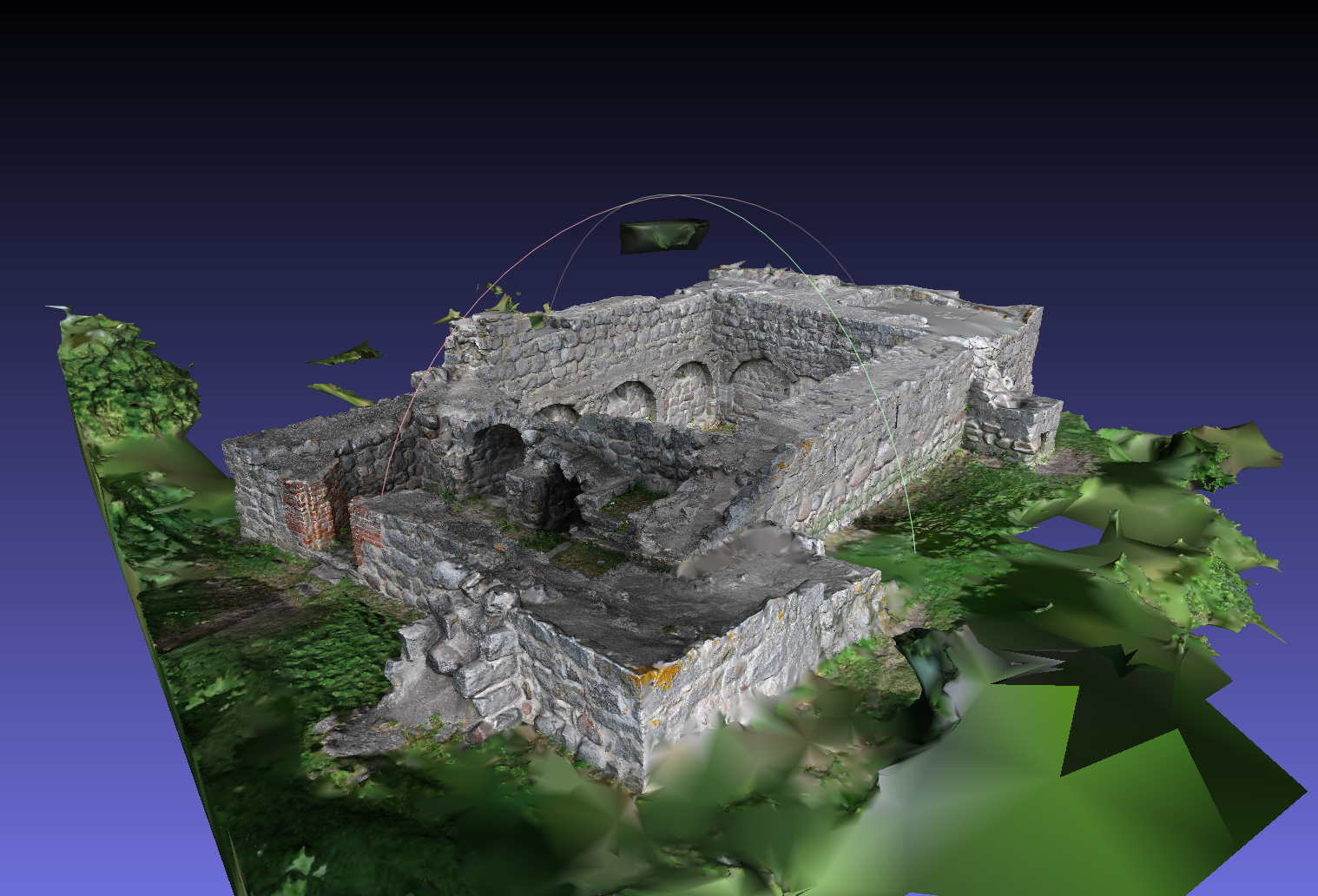

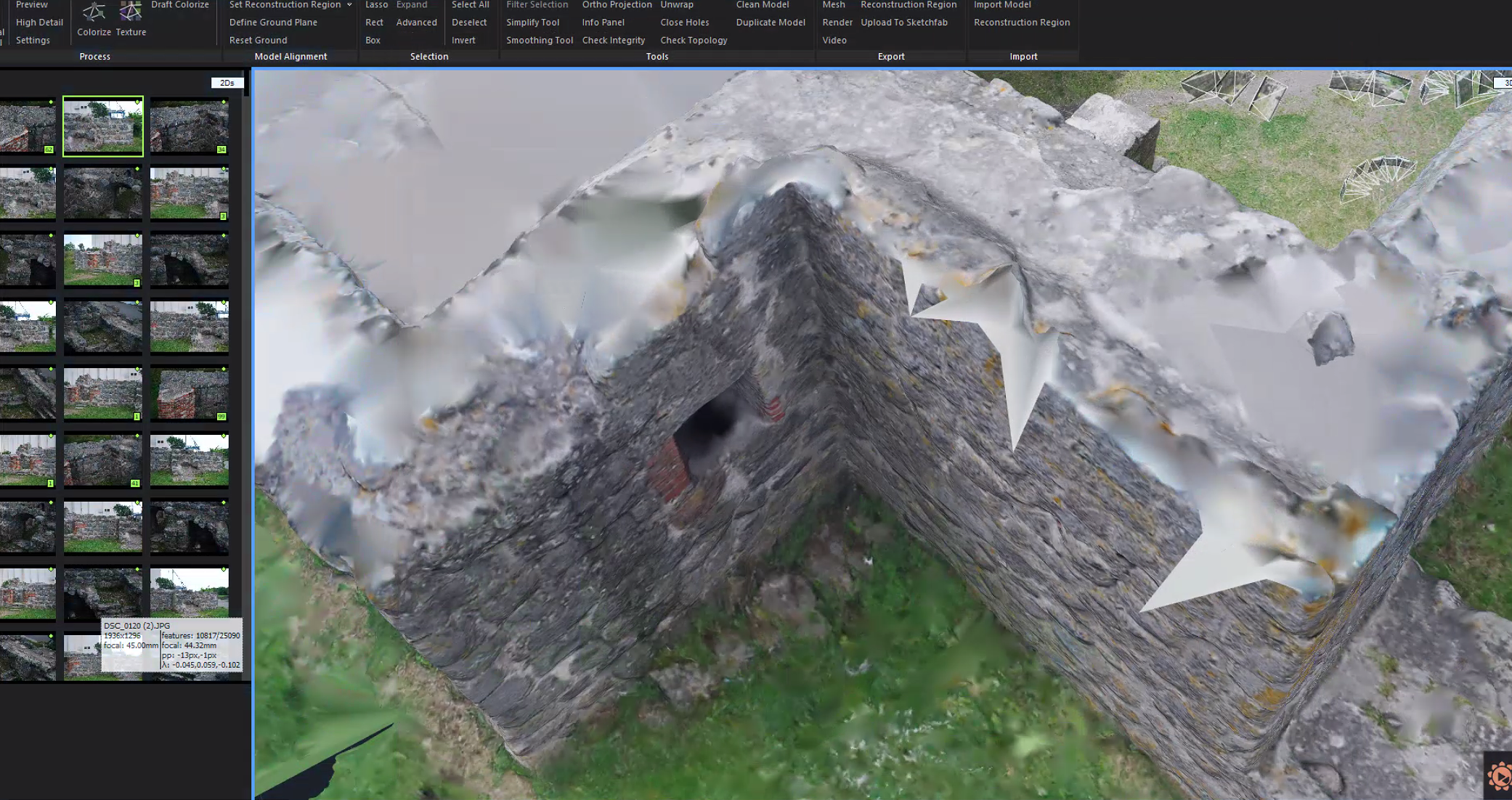

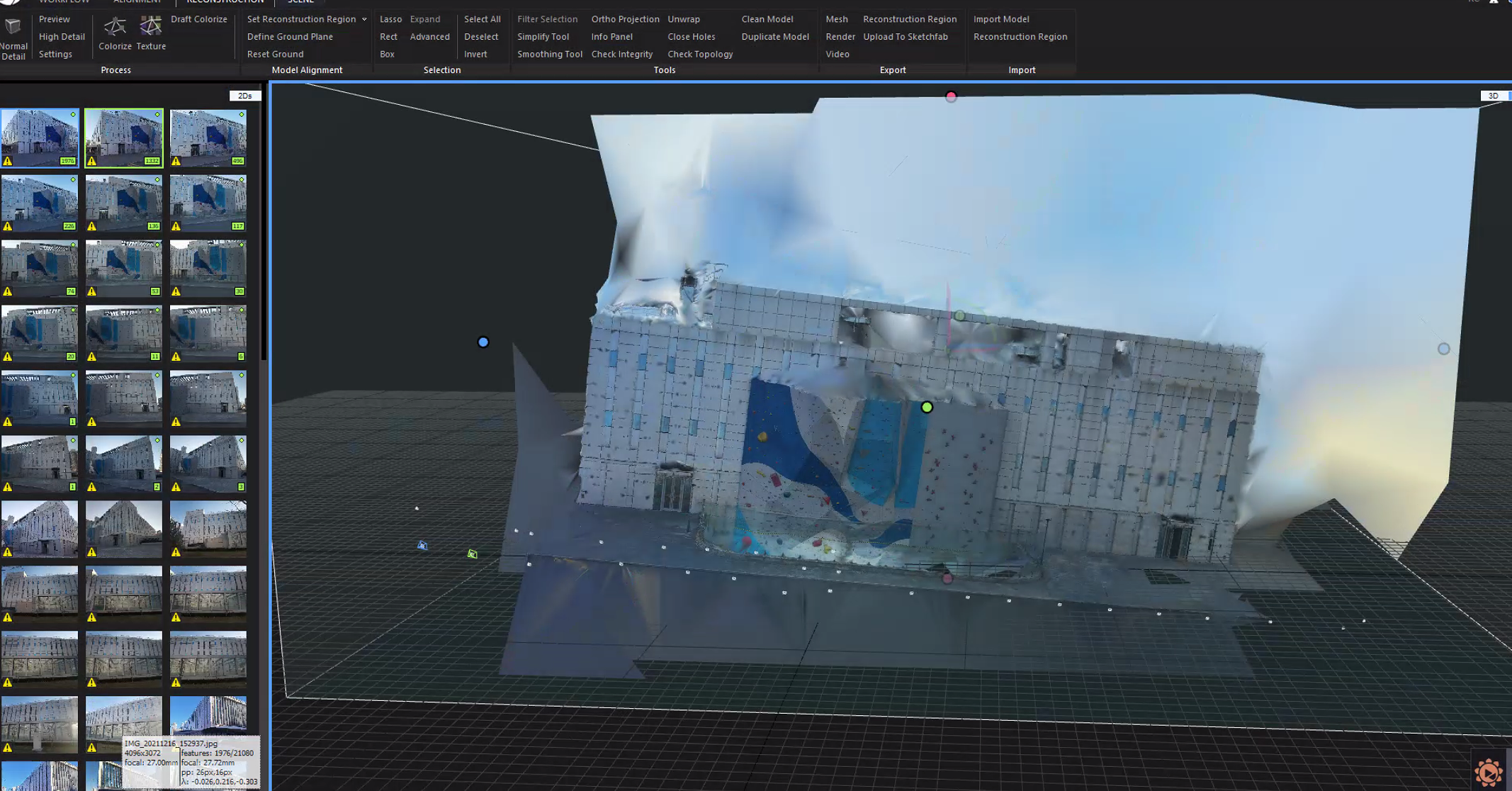

(二)大型建筑

输入:Aos Hus

consists of 811 images

地址:https://www.maths.lth.se/matematiklth/personal/calle/dataset/dataset.html

position of camera spot

流程

- 重建后:额外修剪 RECONSTRUCTION - lasso - Filter Selection 去除不需要的建模部分

输出

(meshlab打开后,操作过于卡顿)

评价:大型建筑的相机取景点就很关键。拍摄时主要应考虑不同相机位置的照片能否被关联起来。否则重建时会无法关联而重建失败。这在内景外景的合并上更重要。(inspection可以查看相机关联?

官网看到一个视频,详细介绍了建筑内外景重建的过程和一些经验

如果视频无法显示的话,这是地址:https://www.youtube.com/embed/rrXuHcqoOjQ

但同时也有毛刺:

二、使用自采集数据

一组采集了篮球场前的小雕像的图片;另一组采集了新北食堂。采集本身都有问题。会出现warning。

新北食堂只有一小组图像被重建出来,因为那一块比较干净,也没什么杂物。其他地方直接无法被重建

分析:

- 重建倾斜、重建图片无法关联...都是数据采集问题。最好的情况应该是,相机用支架撑起,下装滑轮,绕某处匀速移动,并设置拍摄间隔时间;或直接就无人机了[doge]。

总结起来就是还没能帮上忙,只是自己进一步体验了下较为完整的建模过程和自己实地采集RGB照片的体感。