转:视频编解码技术发展现状

1视频编解码技术发展现状

视频编码的主要目的就是在保证一定重构质量的前提下,以尽量少的比特数来表征视频信息。视频编码的原理是:由于表示图像和视频信息所需的大量的数据往往是高度相关的,这些相关性会引起信息的冗余,因此可以通过去除这些冗余信息来实现对视频数据的压缩。传统的基于统计特性的运动补偿+变换编码的混合编码框架在数据压缩方面取得了很大的成果,国内外的通用视频压缩标准均基于此框架,比如H.26L系列、MPEG系列以及我国的AVS-P2标准。但是随着计算机网络的不断发展和应用需求的多样化,对于视频编码技术的研究不再仅仅局限于压缩特性,而渐渐开始向网络适应性、用户交互性等方面转移。因此,这几年来,视频编码技术一方面继续以混合编码为框架研究如何进一步提高压缩特性,另一方面不断的向可伸缩编码、多视点编码等分支方向发展。

1.1. 混合编码技术

混合编码框架的技术主要包括:运动补偿、预测编码、变换编码以及熵编码等。近年来混合编码的研究主要集中于如何在技术细节方面进行进一步完善,使编码效率得到进一步的提高。

其典型代表为2003年由联合专家组JVT(Joint video team of ISO/IEC MPEG and ITU-T VCEG)制定的新一代视频编码标准H.264/AVC[1]。H.264/AVC 是一种高效的压缩方法,在保持传统的混合编码框架的基础上,主要通过以下技术提高编码效率[2]:

- 可变尺寸的运动估计(Variable block-size motion compensation)

- 更精细的1/4象素运动估计(Quarter-sample-accurate motion compensation)

- 多参考帧运动补偿(Multiple reference picture motion compensation)

- 空间域的帧内预测(Directional spatial prediction for intra coding)

- 算术编码(Arithmetic entropy coding)和基于上下文的熵编码(Context-adaptive entropy coding)

- 率失真优化(Rate-Distortion Optimal)

前4项属于预测编码,第5项属于熵编码,最后一项属于编码决策。文献[3]认为熵编码的编码效率已经接近极限。预测编码如果能采用新的思路,还有一定的发展空间。

国内标准方面,由我国信息产业部数字音视频标准专家组制定的AVS标准视频部分的基本框架也是混合编码技术。AVS对于提高压缩效率方面进行了探索,新提出技术包括:对称双向帧技术、自适应扫描技术、自适应的系数间非均匀量化技术等。这些技术都在不同程度上也提高了视频编码的效率或主观质量。

1.2 可伸缩编码技术

可伸缩技术将视频编解码技术从传统的压缩技术转变为了更多考虑网络适应性和灵活性的编解码框架。2005年2月,JVT将可伸缩性编码(Scalable Video Coding, SVC)作为H.264标准的扩展,并起草了H.264标准的可伸缩性扩展第一草案[4]。可伸缩视频编码因为具有时域、空域和质量等多方面的灵活性,不仅特别适合网络传输,而且应用到视频监控领域中还能满足监控视频资料的存储、检索、分析等方面的种种特殊需求。近两年来,可伸缩技术在视频监控中的研究已广泛展开[5-9],而且在SVC的需求文档中已将视频监控列为可伸缩视频编码技术的主要应用领域之一。所以可伸缩视频编解码技术不仅是JVT组织中的当前热点研究问题,更是视频监控技术中的研究热点问题。

到目前为止,实现可伸缩技术的方法大致上可以划分为两种:基于小波变换的可伸缩技术和基于传统的混合编码结构的可伸缩技术。

1.2.1基于小波编码的可伸缩技术方案

基于小波的视频编码[10]是指以离散小波变换(DWT)为核心的视频编码方案。由于三维小波编码方案没有形成国际标准,所以三维小波编码呈现争鸣的局面。在这些提交方案中,根据压缩处理流程的不同,可以被分为以下四大类:

- 纯三维小波方案

纯三维小波的视频编码方案[11]是在原二维平面小波基础上的直接过渡的,该方案将视频压缩看作是三维图像的信号处理,将其按三维立体空间的正交小波基展开。该方案的三维小波滤波函数具有对称性好、支集小的特点,帧内、帧间小波系数具有统一性,保证了时间维的衰减速度。但该方案不采用运动补偿机制,因此对时间维的长度要求比较苛刻,过短的时间维数据将使压缩效果大大下降;而过长的时间维数据又会影响压缩的实时性和内存需求。

- 小波框架的运动补偿方案

小波框架的运动补偿方案是DCT 框架的运动补偿方案的推广,该方案用DWT 替换原有的DCT,而其它的处理流程均继承于原DCT方案。该方案有DCT 编码体系和技术的支持,压缩性能比较好。但该方案沿用了原DCT的块结构处理的模式,空间可伸缩性会受到影响,还会产生差错传递和块效应。

- 小波子带预测方案

小波子带预测方案首先对每一帧图像进行二维空间小波变换,然后再对所得的各子带小波系数值进行帧间预测去处冗余,最后对生成的数据进行熵编码。整个处理流程是分子带进行的,子带与子带之间互不影响。

该方案的运动预测是在不同的小波子带中进行的,因此不会产生整幅图像的差错传递,这种差错只会在各个子带中传递。但该方案编码是一帧一帧分开处理的,所以时间可伸缩性的发挥相对有限。该方案还将整个编码过程形成一个闭回路,参考子带是基于解码重构而成的,影响了PSNR 的可伸缩性。

- 帧间小波滤波方案

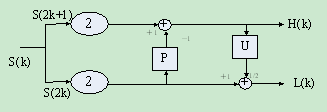

时间可伸缩技术:首先对一组连续图像进行时间维滤波(MCTF)[12]。通过运动补偿时间过滤器,沿着象素的运动轨迹,在帧上实现小波的分解和重构。其中使用了预测(P)和更新(U)两种处理方法(P和U是互逆的),它们可以自适应的选择帧内、向前、向后或双向的模式。具体过程描述如下:在GOP中,一个奇数索引帧通过相邻的帧或偶数索引帧来进行预测,从而产生一个高通帧:H(k),代表细节信息;同样的,一个偶数索引帧通过相邻的n个(n>=1)高通帧来实现自身的更新,从而产生一个低通帧:L(k),代表主要信息。其计算过程如图1所示:

H(k)=S(2k+1)-P(S(2k))

L(k)=1/2*[S(2k)+ U(S(2k+1))]

图1. MCTF中一个过滤器的示意图

图1. MCTF中一个过滤器的示意图

该方案采用了时间维处理技术,在运动方向上对相邻图像进行低通和高通滤波,因此可以在不采用传统回路预测方式的基础上来消除时间冗余。避免了传统闭合回路对于质量可伸缩的影响。再结合零树熵编码来产生嵌入式的比特流,该方案在质量上有很强的可伸缩性。不过需要注意的是时间、空间的可伸缩性相对固定。而且该方案要求一个GOP的图像一次性处理,有一定的时间延迟,并且对内存需求比较大。

1.2.2基于混合编码结构的可伸缩方案

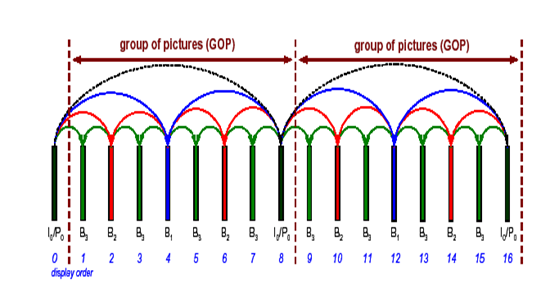

时间可伸缩:在H.264 MPEG-4 AVC的基础上,时间可伸缩性可以通过MCTF技术和分级B图片实现的。MCTF技术在前一部分已经论述,本节讨论分级B图片技术。如图2所示,关键图片(IDR)序列的显示分辨率是最低的,可以根据接受端不同的要求,在此序列上增加时间域上更高级别的高分辨率图片,并且传递出去,从而在接受端显示不同分辨率、不同质量的视频流。

图2 层次B图片结构示意图

空间可伸缩:为了满足不同用户的需求,在给定帧的基础上产生不同空间分辨率码流序列,它们在各自独立的层内编码。为了消除不同空间帧中的冗余信息,一个增强层的残差信息和运动矢量根据与其对应的基本层预测得到。在预测的过程当中,因为基本层拥有更低的分辨率,所以首先读入基本层的残差信息和运动矢量。然后在基础层之上产生一个或多个增强层。增强层的帧间编码宏块的划分方法可以由相关的基本层的对应宏块派生得到,同样,其运动矢量也可以通过比较和计算其对应的基本层的宏块的运动矢量而得到。

质量/信噪比可伸缩性:包括了两种模式,基于嵌入式量化方法的粗粒度可伸缩性(CGS,coarse grain scalability)和基于位平面编码方法的细粒度可伸缩性(FGS,Fine GrainScalability)。在SNR可伸缩技术中,使用传统的混合编码技术,即经过整数变化和量化得到基本层;基本层之上是增强层,在基本层和原始子带图片之间存在残差信息,这个差值和基本层一样使用同样的方法进行变换和量化,不同的是量化粒度更加细腻一些,即使用更小的量化参数,再进行熵编码,量化后得到的系数就是SNR的增强层。增强层和基本层一起可以看作是另外一个更高层次的增强层的基本层。这个更高层次的增强层计算方法和以上阐述的方法一样。最后基本层系数和增强层系数再使用位平面编码和行程编码相结合的方式进行熵编码,分别形成基本层码流和增强层码流输出。

总的来说,目前混合框架+MCTF技术占有一定优势,主要体现在编码效率高和兼容性较好;但是对3D小波的研究可能还不深入,还有很大的提升空间。目前关于可伸缩编码的广泛应用还没有开展起来。

1.3 多视点编码技术

多视点视频(multi-view video)是一种新型的具有立体感知和交互操作功能的视频技术,它由一组平行、会聚相机阵列拍摄得到的视频信号。

2001年,MPEG成立了3DAV工作组,其首要任务就是定义3D音视频领域的范围和应用场景,并为其中的关键技术制定标准。多视点视频是3DAV框架下,近年来迅速崛起和快速发展的研究领域。在视频监控类的应用中,多视点视频编码技术有助于实现多视角立体监控,多摄像头联动等应用。

实现多视点视频编码(MVC)可以基于传统混合编码框架(如H.264),也可基于小波编码以及分布式编码等新一代视频编码工具。视点间相关性是多视点视频序列的重要特性,它与相机阵列形式、相机间距、相机和拍摄对象间距离存在极大的关系,直接反映在同一时刻相邻视点两幅图像的视差上。

由于该类系统存在着大量的数据冗余,如何组织和压缩数据就成为重要的研究课题。所以当前MVC主要围绕如何提高压缩效率以及随机读取能力进行研究,而这些研究又可从两个主要方面来分类,一是预测结构,二是预测工具。预测工具指的是多路码流视角之间的空间预测手段,包括亮度补偿,视差/运动补偿,2D直接预测模示,视角插值。由于视角间的相关性利用是决定MVC压缩效率的主要因素,因而未来MVC压缩效率的进一步提高依赖于新型预测工具的设计。预测结构指的是多视点视频时空帧之间的相互预测参考关系,它代表将哪些帧一道进行处理以消除数据的时空冗余性,因而不管是传统的混合编码、小波,还是分布式编码,都离不开预测关系的设计。另外预测结构是决定随机读取性能、快速解码性能、网络传输代价的重要指标,因而在MVC研究中受到广泛关注。将MVC编码码流应用到传统流式传输框架下,会产生视角切换问题,因而如何设计新型的切换帧以及如何分析切换对预测结构的影响也具有重要的意义。

当前多视点视频压缩在应用上的主要问题在于数据压缩效率与随机读取能力的矛盾,多视点视频本身数据量庞大,在传输应用或本地快速解码时,用户并不需要所有的数据信息,因而要求数据之间的依赖性小,但这恰好与压缩成矛盾。多视点视频本身是相关性很强的多个信源,基于分布式编码的多信源编码理论或许能对该问题进行理论分析及探讨。多信源编码能从信息理论上解码代价、视角随机读取能力以及编码效率三者的折中,因而在MVC中具有很大的潜力。

1.5 国内外研究现状的对比和分析

国际上视频编解码技术通过几十年的发展,已经取得了众多研究成果。相对来说,我国在数字音频编码领域的研究起步比较晚,研究基础相对薄弱但是近年来的发展很快。下面就分别从混合视频编码、可伸缩编码、多视点编码和分布式编码这四个研究方向进行对比和分析。

首先,在混合编码算法的研究方面,其研究成果主要体现在编解码标准上。20世纪90年代以来,ITU-T和ISO制定了一系列音视频编码技术标准(信源编码技术标准)和建议,这些标准和建议的制定极大地推动了多媒体技术的实用化和产业化。进入新世纪以来,MPEG-4 AVC/H.264是代表最新技术水平的一项国际标准,编码效率比MPEG-2约提高一倍以上,压缩效率可达到100-150倍。缺点是实现复杂度较高,存在复杂的知识产权问题。AVS是我国牵头制定的第二代数字音视频信源标准,具有自主知识产权,在今年被批准为国家标准,并与3月1日正式 实施。它的编码效率与竞争性国际标准MPEG-4/H.264相当,代表了国际先进水平,广泛应用于广播、通信、电视、娱乐等各个领域。它具有四大特点:(1)性能高,编码效率比MPEG-2高2倍以上,与H.264的编码效率相当;(2)复杂度低,算法复杂度比H.264低;(3)实现成本低,软硬件实 现成本都低于H.264;(4)专利授权模式简单,费用明显低于同类标准。应该说,数字音视频编码标准的出台和初步应用是我国音视频领域近年来最引人注目的进展。武汉大学国家多媒体软件工程技术研究中心作为AVS工作组(数字音视频编解码技术标准工作组)发起成员之一,从2002年底至今一直参与AVS视频和音频编码标准的制定工作,推动了AVS标准制定工作。

在可伸缩视频编码研究方面,2005年2月,JVT将可伸缩性编码(Scalable Video Coding, SVC)作为H.264标准的修改,制定标准MPEG SVC。在基于小波框架和基于混合框架两套解决方案中,最终通过复杂的核心测试,选择了后者。该标准通过近两年的制定工作,有望在2007年完成。同时,国内也在积极进行可伸缩编码的研究。但是总体说来,国内的可伸缩编码算法的研究主要还是以国外的研究成果为基础,创新性和影响力和国外的研究成果相比,还比较薄弱。

多视点编码算法研究属于新兴的热点研究领域,国内外的研究均处于初级阶段。MPEG在今年7月份的文档中提出了多视点视频编码的15项编码压缩需求(也即目标),这些需求将是未来MVC发展的趋势与方向并依赖于新型的编码工具,新型的预测工具以及预测结构的探索。