《机器学习》第二次作业——第四章学习记录和心得

《机器学习》第二次作业——第四章学习记录和心得

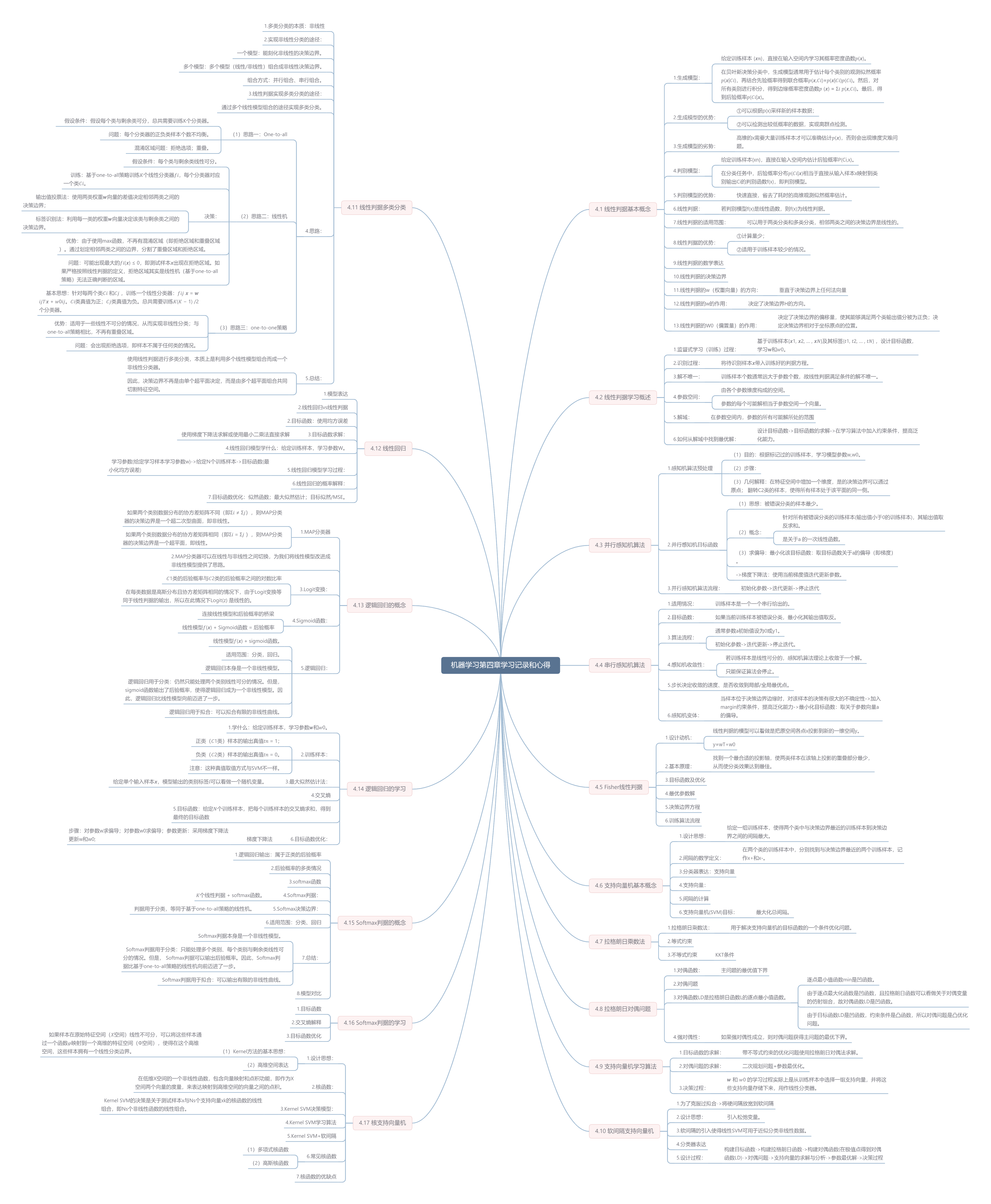

思维导图:

4.1 线性判据基本概念

1.生成模型:

给定训练样本 {𝒙𝑛},直接在输入空间内学习其概率密度函数𝑝(𝒙)。

在贝叶斯决策分类中,生成模型通常用于估计每个类别的观测似然概率𝑝(𝒙|𝐶𝑖),再结合先验概率得到联合概率𝑝(𝒙,𝐶𝑖)=𝑝(𝒙|𝐶𝑖)𝑝(𝐶𝑖)。然后,对所有类别进行积分,得到边缘概率密度函数𝑝 (𝒙) = Σ𝑖 𝑝(𝒙,𝐶𝑖)。最后,得到后验概率𝑝(𝐶𝑖|𝒙)。

2.生成模型的优势:

①可以根据p(x)采样新的样本数据;

②可以检测出较低概率的数据,实现离群点检测。

3.生成模型的劣势:

高维的x需要大量训练样本才可以准确估计𝑝(𝒙),否则会出现维度灾难问题。

4.判别模型:

给定训练样本{xn},直接在输入空间内估计后验概率P(Ci,x)。

在分类任务中,后验概率分布𝑝(𝐶𝑖|𝒙)相当于直接从输入样本x映射到类别输出Ci的判别函数f(x),即判别模型。

5.判别模型的优势:

快速直接,省去了耗时的高维观测似然概率估计。

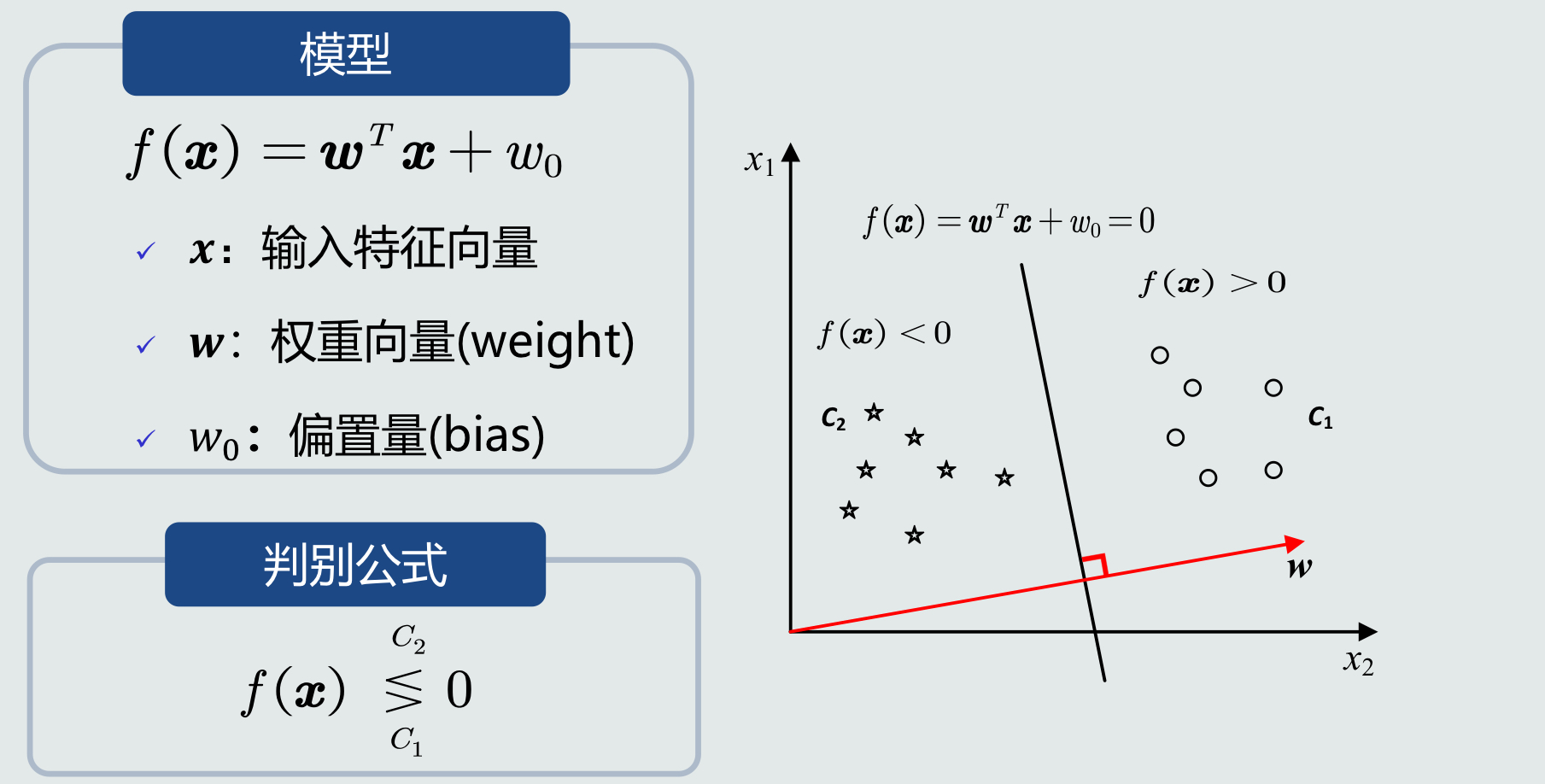

6.线性判据:

若判别模型f(x)是线性函数,则f(x)为线性判据。

7.线性判据的适用范围:

可以用于两类分类和多类分类,相邻两类之间的决策边界是线性的。

8.线性判据的优势:

①计算量少;

②适用于训练样本较少的情况。

9.线性判据的数学表达:

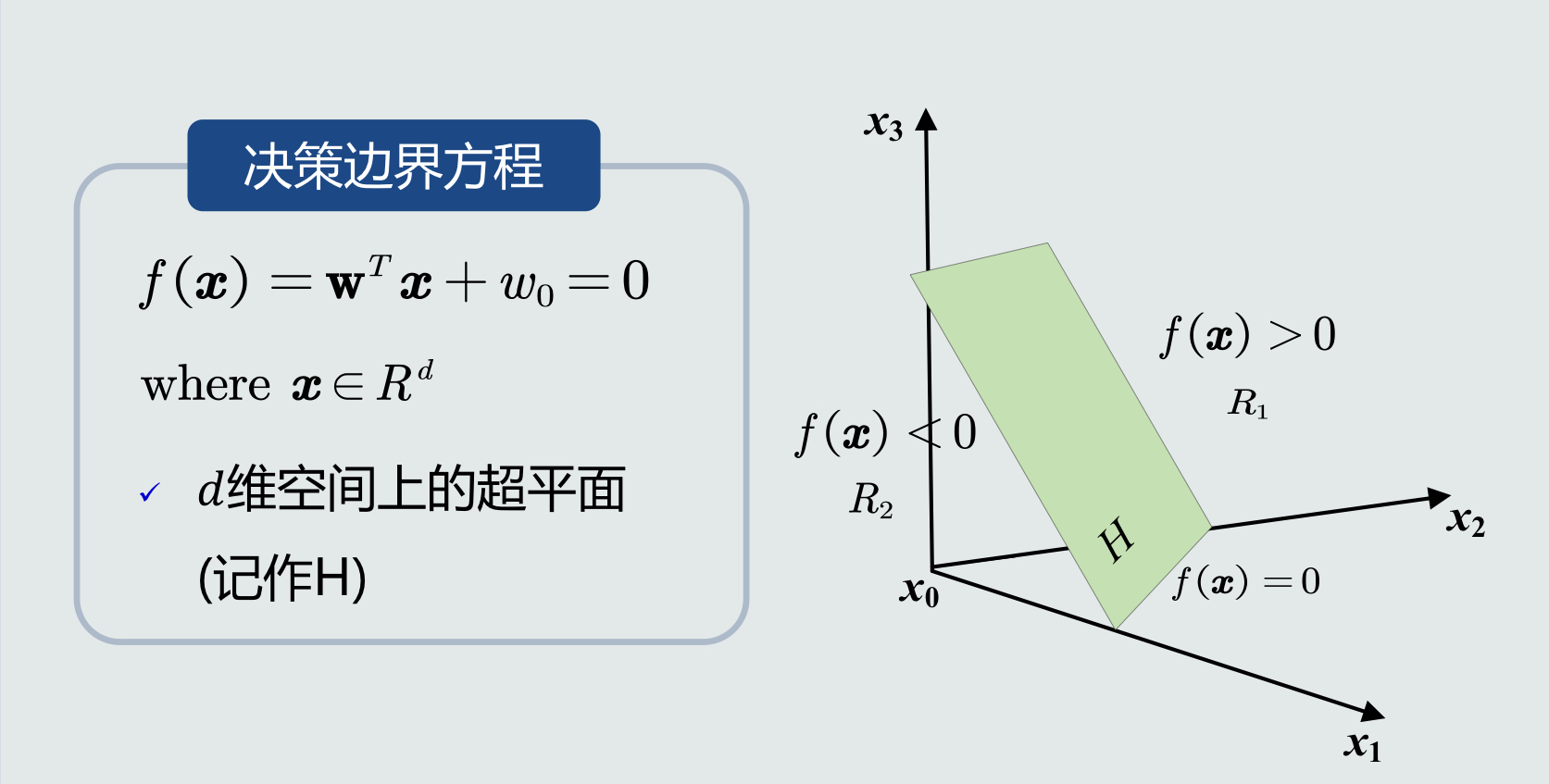

10.线性判据的决策边界:

11.线性判据的w(权重向量)的方向:

垂直于决策边界上任何法向量

12.线性判据的w的作用:

决定了决策边界H的方向。

13.线性判据的W0(偏置量)的作用:

决定了决策边界的偏移量,使其能够满足两个类输出值分被为正负;决定决策边界相对于坐标原点的位置。

4.2 线性判据学习概述

1.监督式学习(训练)过程:

基于训练样本{𝒙1, 𝒙2, … , 𝒙𝑁}及其标签{𝑡1, 𝑡2, … , 𝑡𝑁} ,设计目标函数,学习𝐰和𝑤0。

2.识别过程:

将待识别样本𝒙带入训练好的判据方程。

3.解不唯一:

训练样本个数通常远大于参数个数,故线性判据满足条件的解不唯一。

4.参数空间:

由各个参数维度构成的空间。

参数的每个可能解相当于参数空间一个向量。

5.解域:

在参数空间内,参数的所有可能解所处的范围

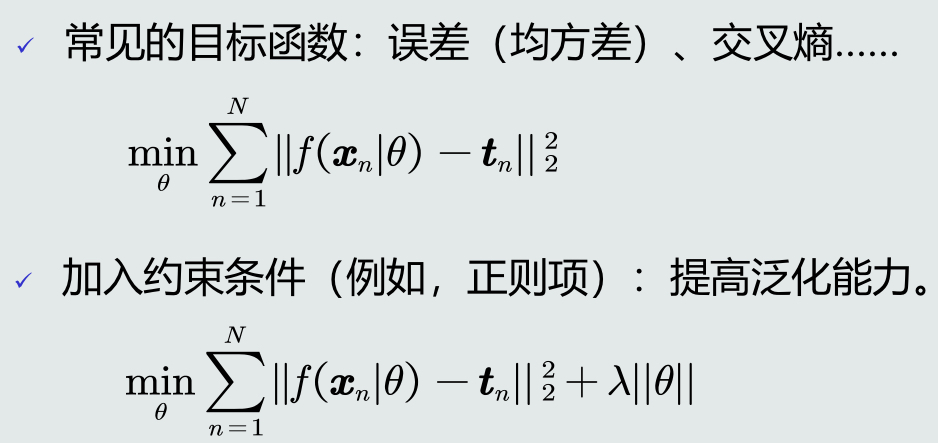

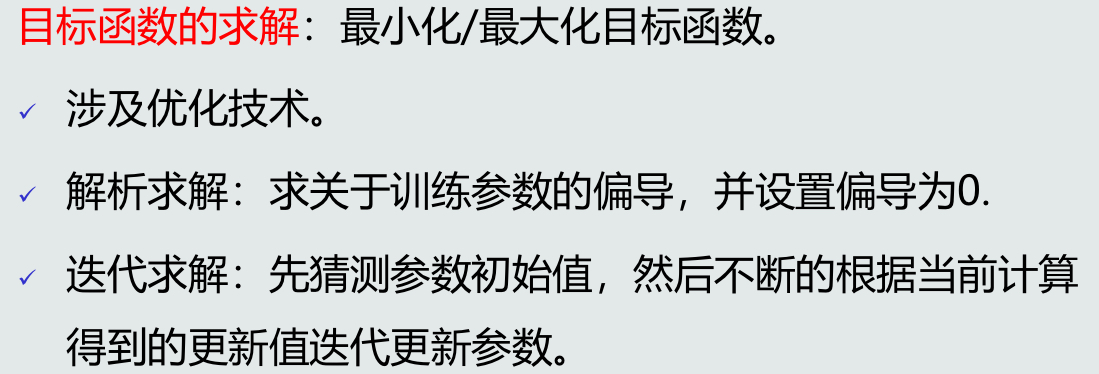

6.如何从解域中找到最优解:

设计目标函数->目标函数的求解->在学习算法中加入约束条件,提高泛化能力。

根据目标函数的不同,可以设计不同的线性判据算法

=>

4.3 并行感知机算法

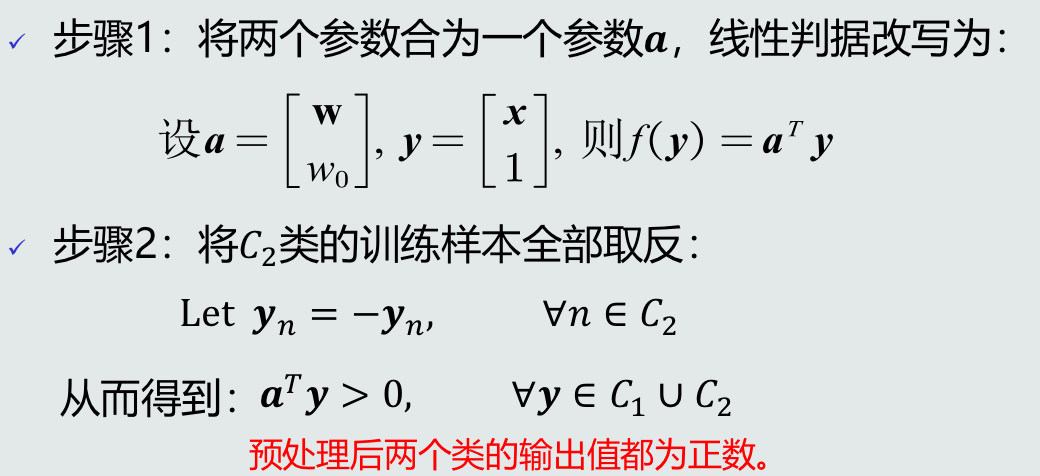

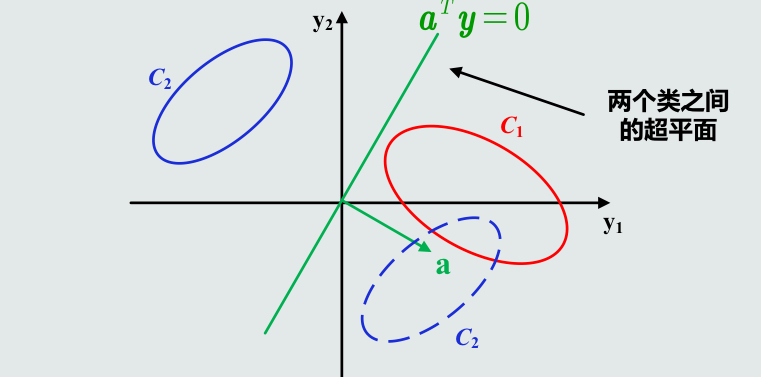

1.感知机算法预处理

(1)目的:根据标记过的训练样本,学习模型参数w,w0。

(2)步骤:

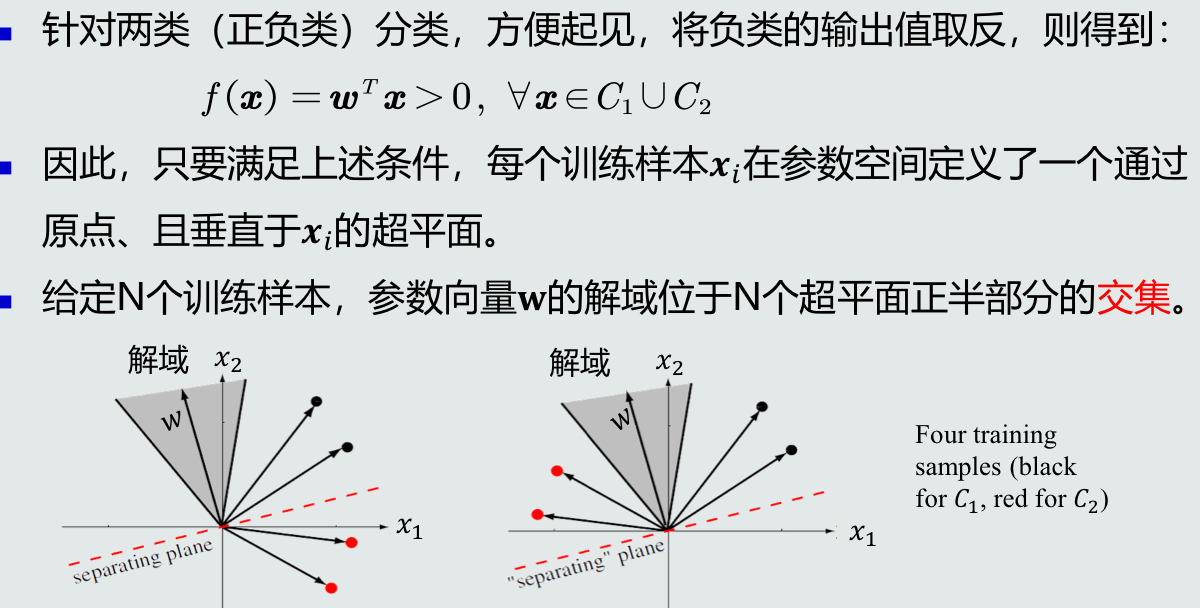

(3)几何解释:在特征空间中增加一个维度,是的决策边界可以通过原点; 翻转C2类的样本,使得所有样本处于该平面的同一侧。

2.并行感知机目标函数

(1)思想:被错误分类的样本最少。

(2)概念:针对所有被错误分类的训练样本(输出值小于0的训练样本),其输出值取反求和。

是关于a 的一次线性函数。

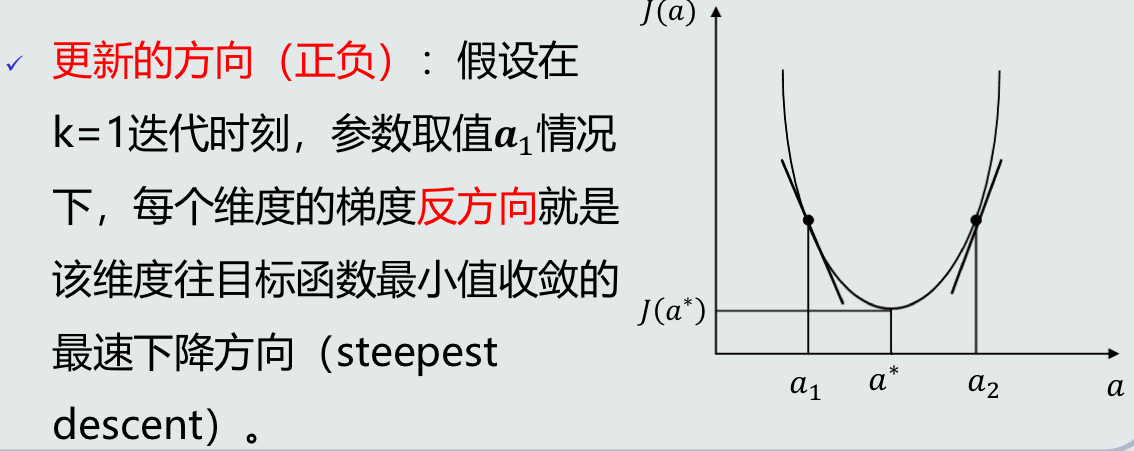

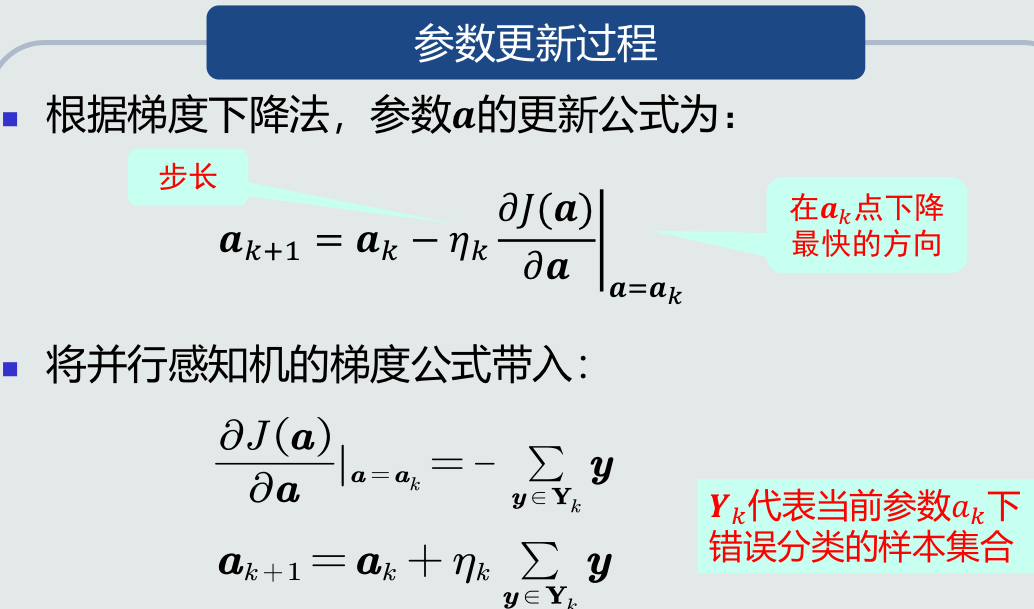

(3)求偏导:最小化该目标函数:取目标函数关于a的偏导(即梯度)。

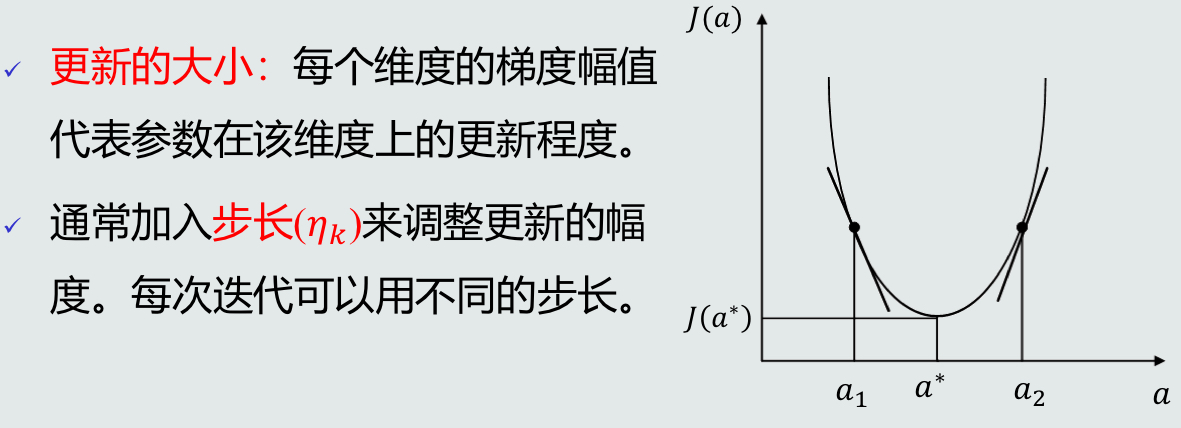

->梯度下降法:使用当前梯度值迭代更新参数。

3.并行感知机算法流程:

初始化参数->迭代更新->停止迭代

4.4 串行感知机算法

1.适用情况:

训练样本是一个一个串行给出的。

2.目标函数:

如果当前训练样本被错误分类,最小化其输出值取反。

3.算法流程:

通常参数a初始值设为0或y1。

初始化参数->迭代更新->停止迭代。

4.感知机收敛性:

若训练样本是线性可分的,感知机算法理论上收敛于一个解。

只能保证算法会停止。

5.步长决定收敛的速度、是否收敛到局部/全局最优点。

6.感知机变体:

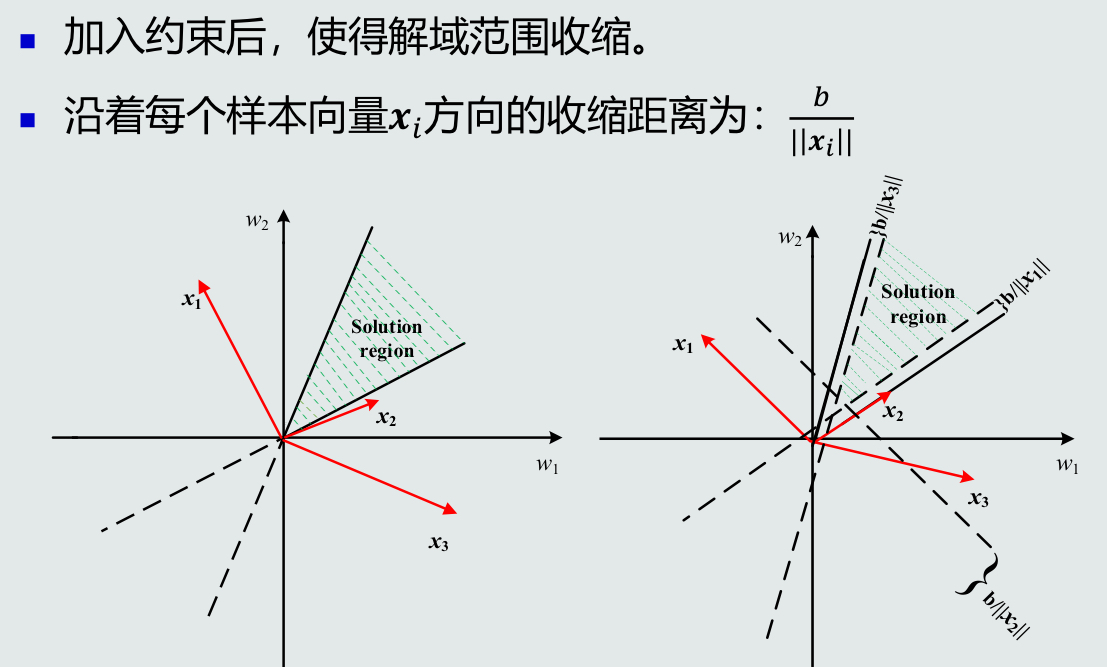

当样本位于决策边界边缘时,对该样本的决策有很大的不确定性->加入margin约束条件,提高泛化能力->最小化目标函数:取关于参数向量a的偏导。

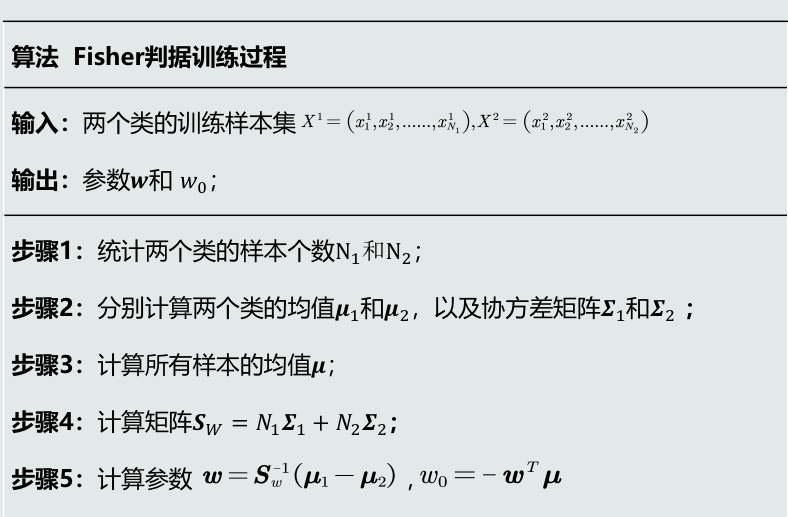

4.5 Fisher线性判据

1.设计动机:

线性判据的模型可以看做是把原空间各点x投影到新的一维空间y。

y=wT+w0

2.基本原理:

找到一个最合适的投影轴,使两类样本在该轴上投影的重叠部分最少,从而使分类效果达到最佳。

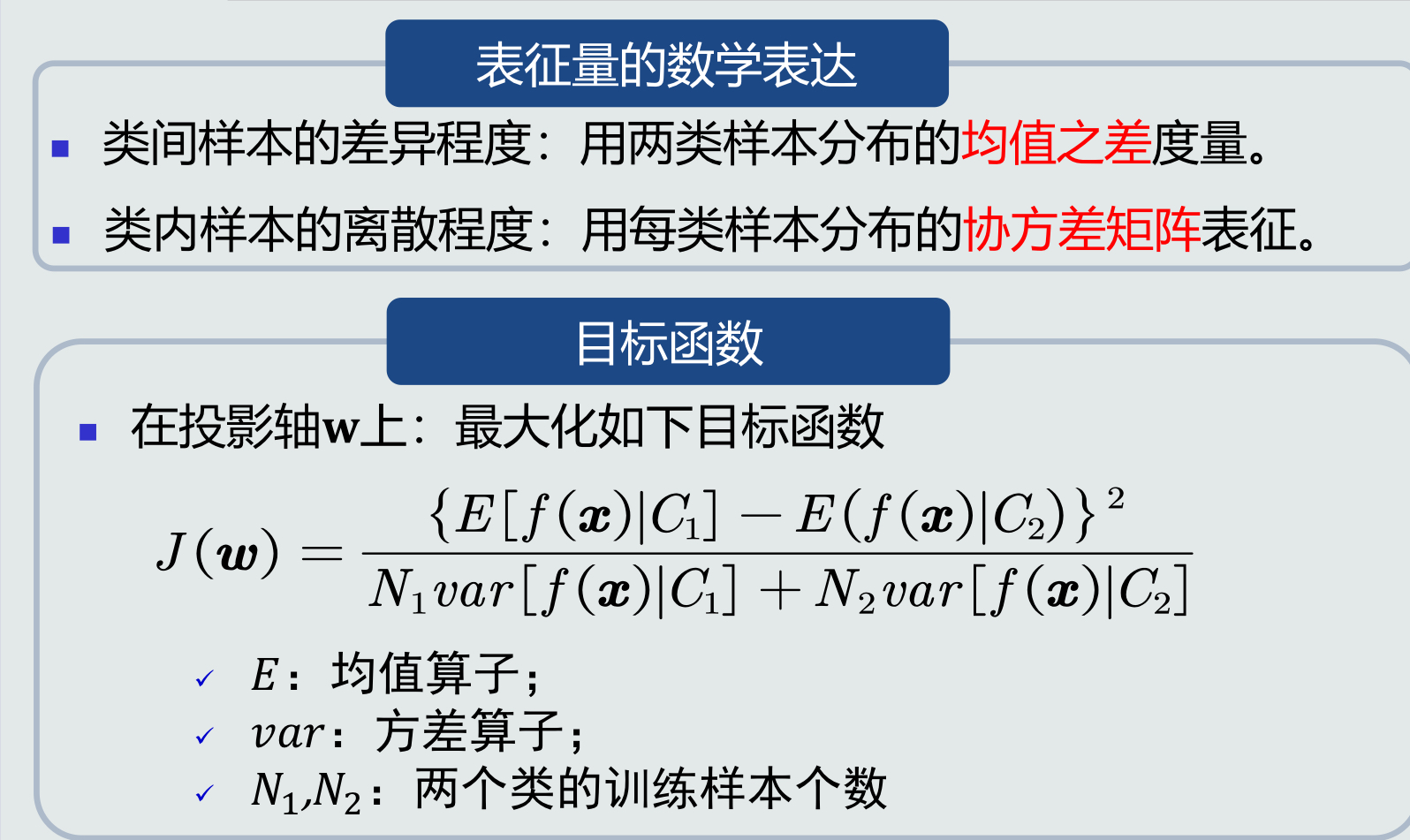

3.目标函数及优化

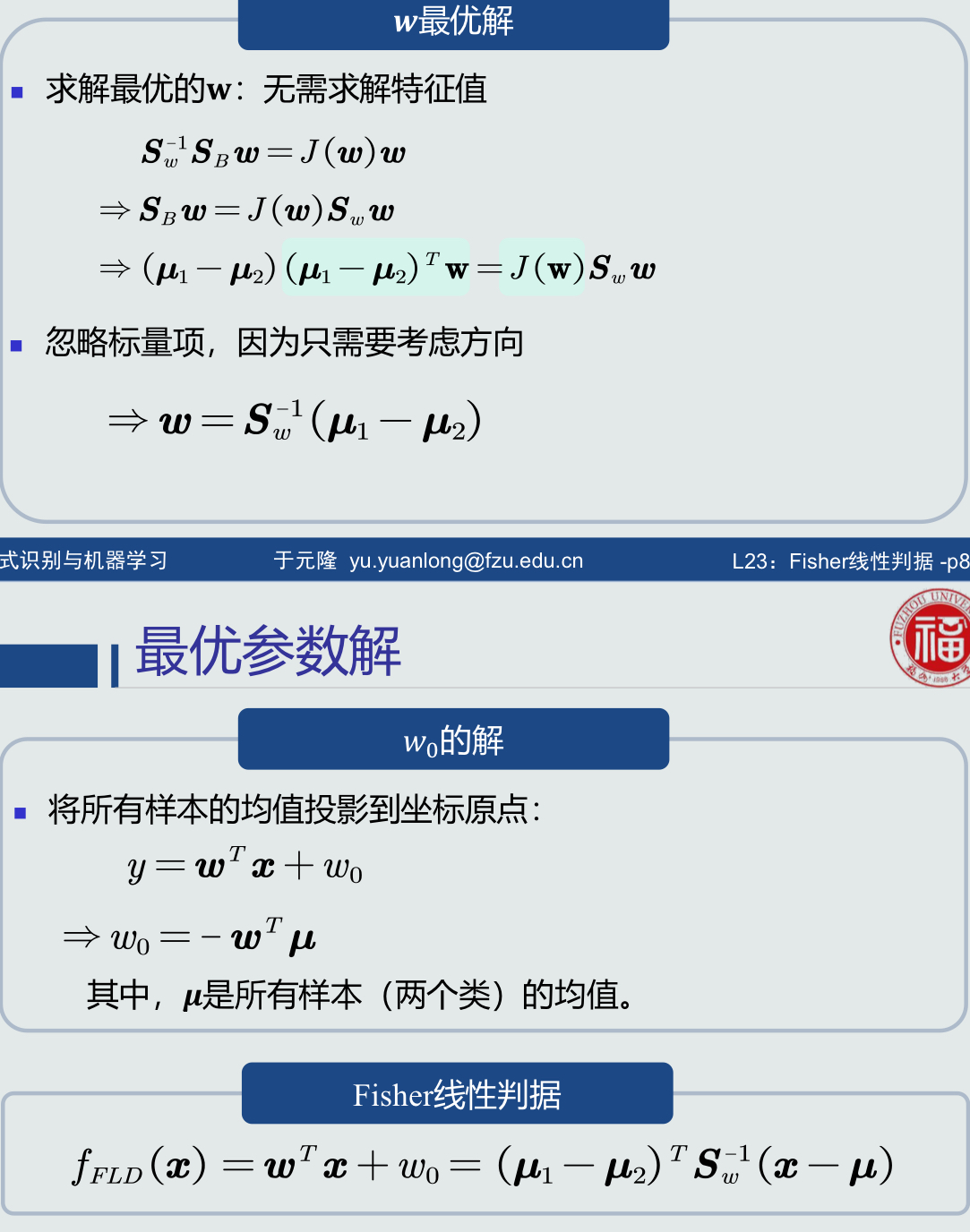

4.最优参数解

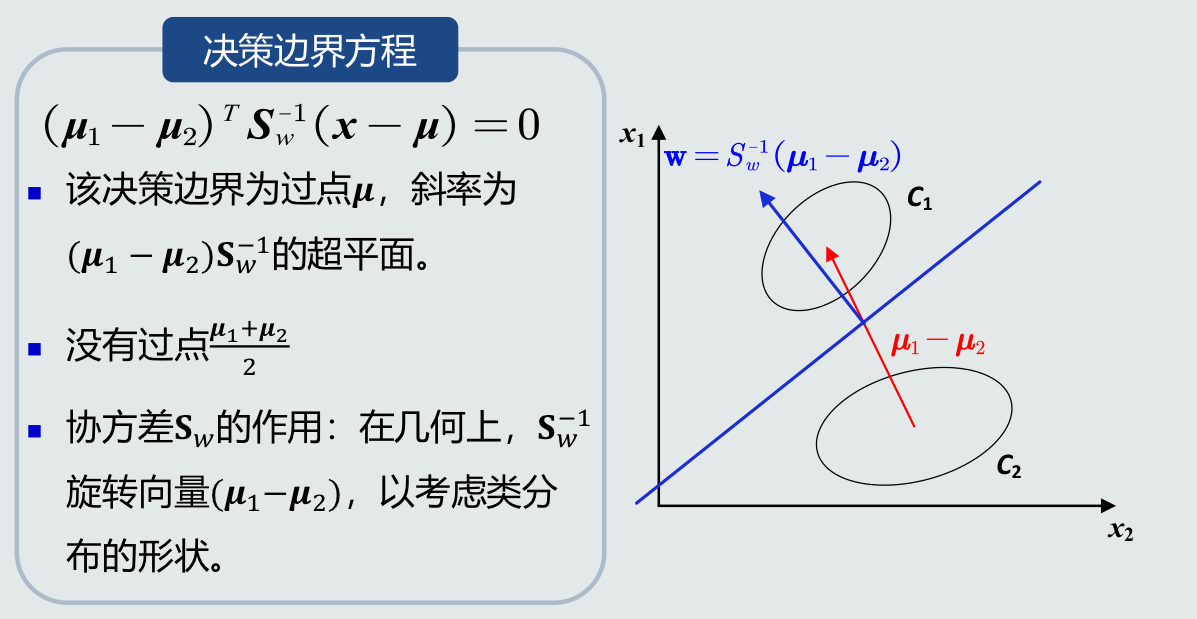

5.决策边界方程

6.训练算法流程

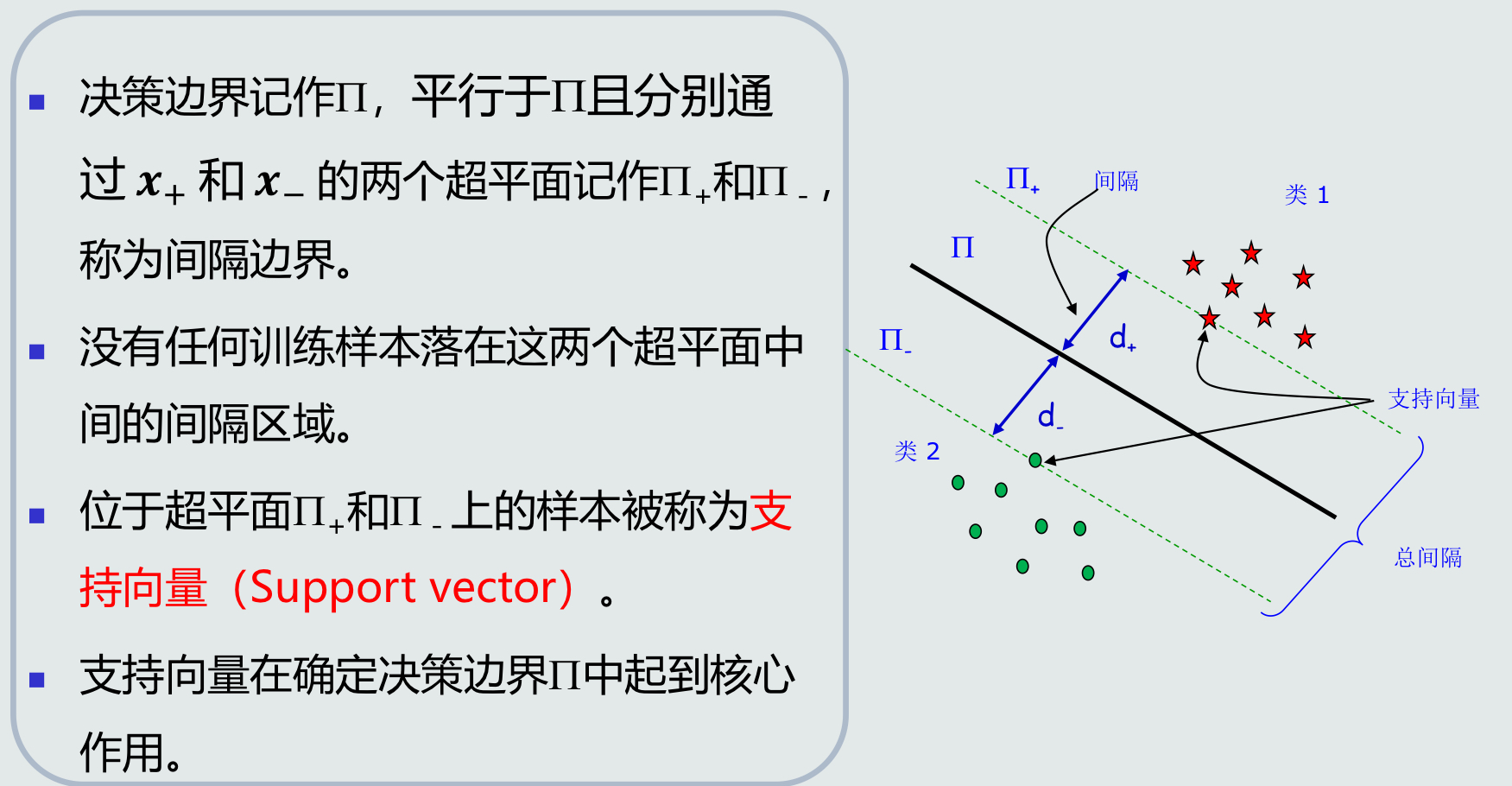

4.6 支持向量机基本概念

1.设计思想:

给定一组训练样本,使得两个类中与决策边界最近的训练样本到决策边界之间的间隔最大。

2.间隔的数学定义:

在两个类的训练样本中,分别找到与决策边界最近的两个训练样本,记作x+和x-。

3.分类器表达:支持向量

4.支持向量:

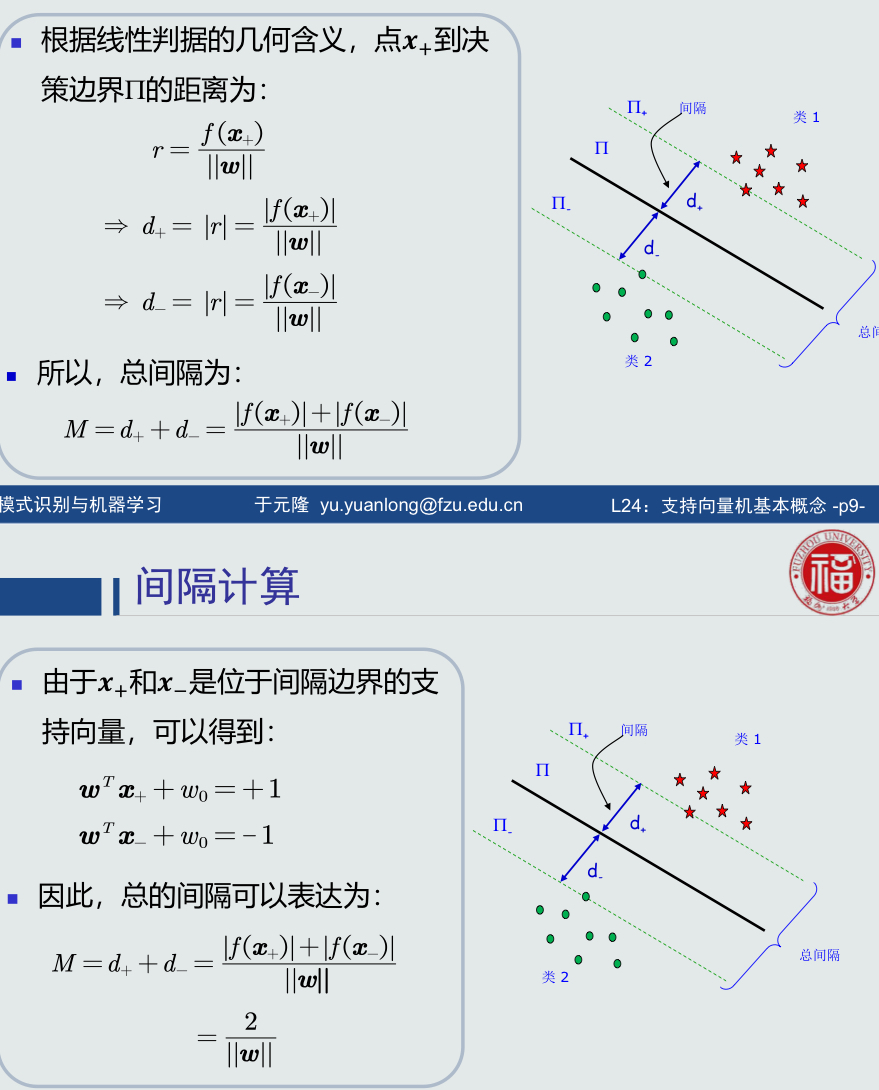

5.间隔的计算:

6.支持向量机(SVM)目标:

最大化总间隔。

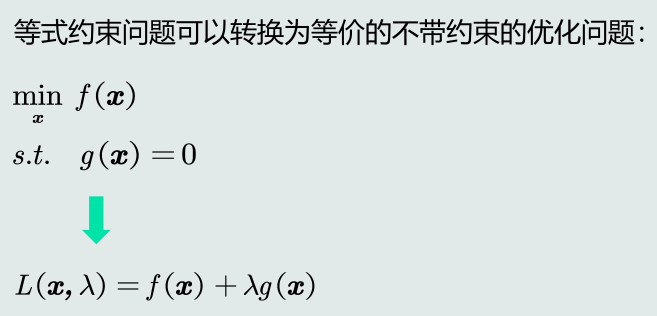

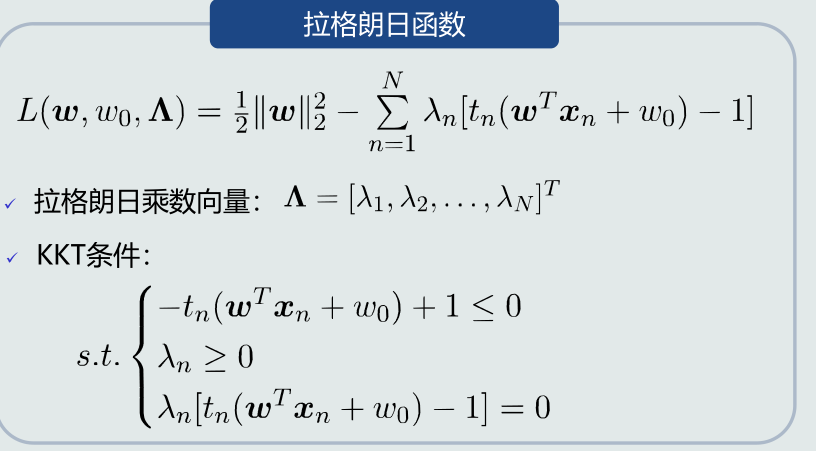

4.7 拉格朗日乘数法

1.拉格朗日乘数法:

用于解决支持向量机的目标函数的一个条件优化问题。

2.等式约束:

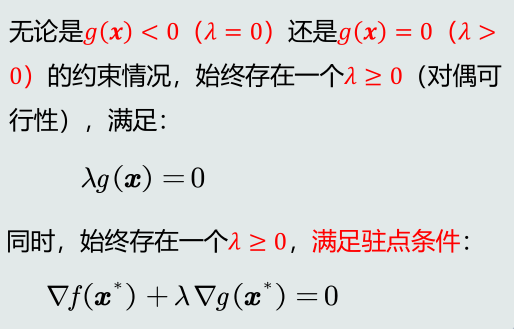

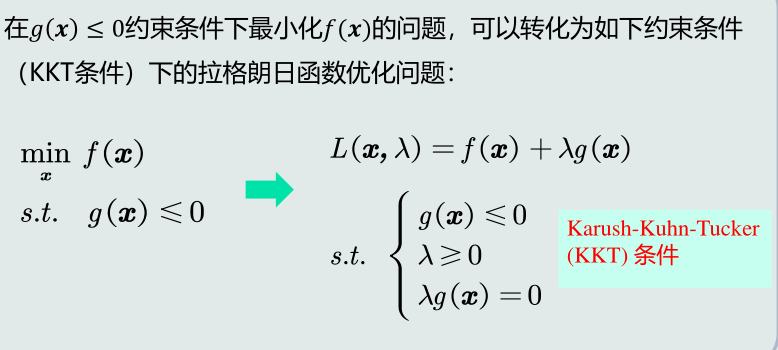

3.不等式约束:

KKT条件:

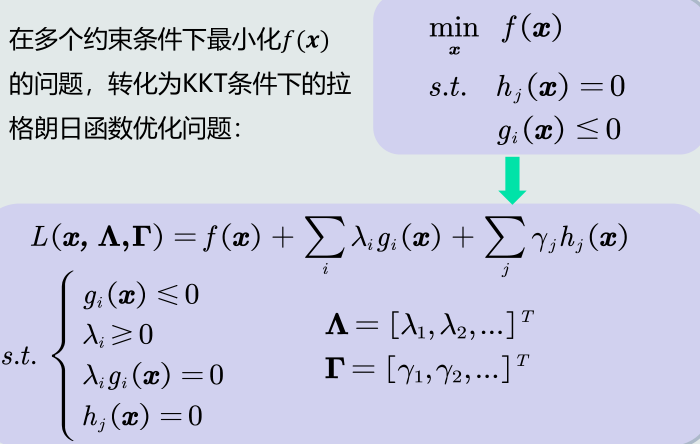

4.多个约束:

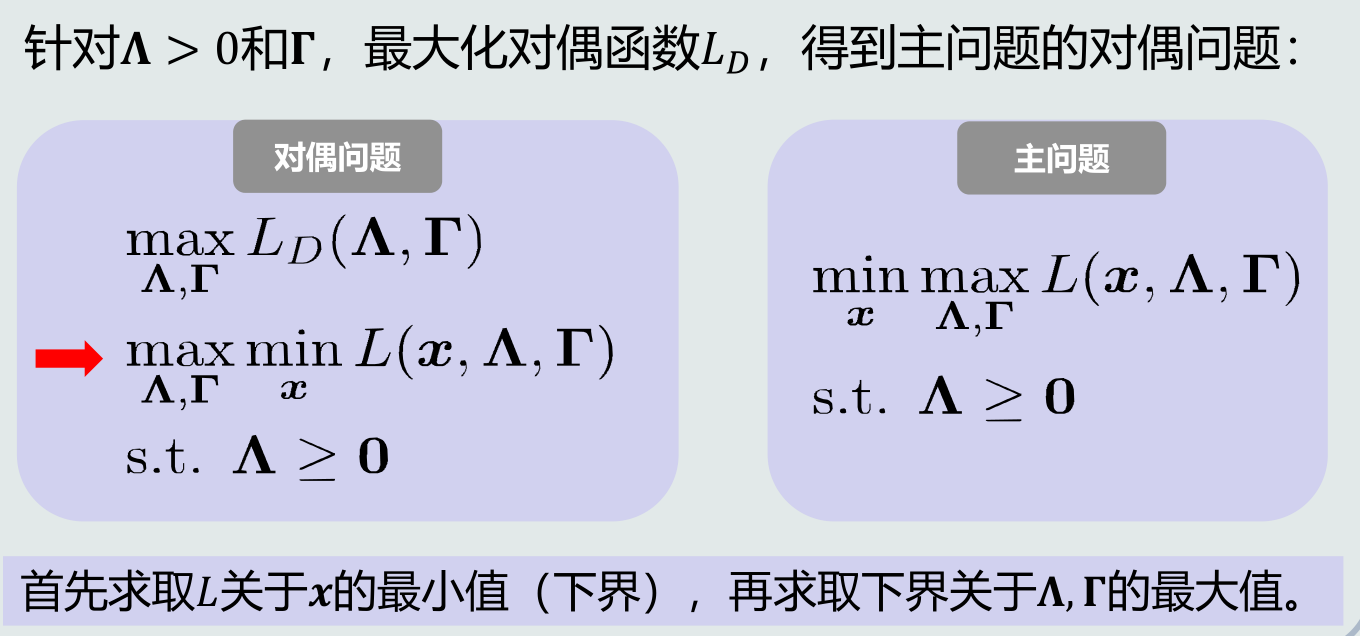

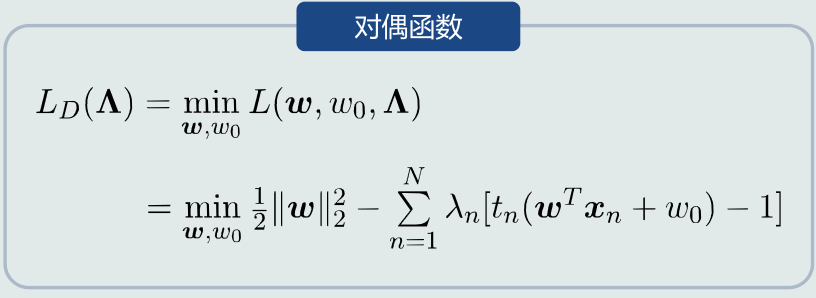

4.8 拉格朗日对偶问题

1.对偶函数:

主问题的最优值下界

2.对偶问题:

3.对偶函数LD是拉格朗日函数L的逐点最小值函数。

逐点最小值函数min是凹函数。

由于逐点最大化函数是凹函数,且拉格朗日函数可以看做关于对偶变量的仿射组合,故对偶函数LD是凹函数。

由于目标函数LD是凹函数,约束条件是凸函数,所以对偶问题是凸优化问题。

4.强对偶性:

如果强对偶性成立,则对偶问题获得主问题的最优下界。

4.9 支持向量机学习算法

1.目标函数的求解:

带不等式约束的优化问题使用拉格朗日对偶法求解。

2.对偶问题的求解:

二次规划问题+参数最优化。

3.决策过程:

𝒘 和 𝑤0 的学习过程实际上是从训练样本中选择一组支持向量,并将这些支持向量存储下来,用作线性分类器。

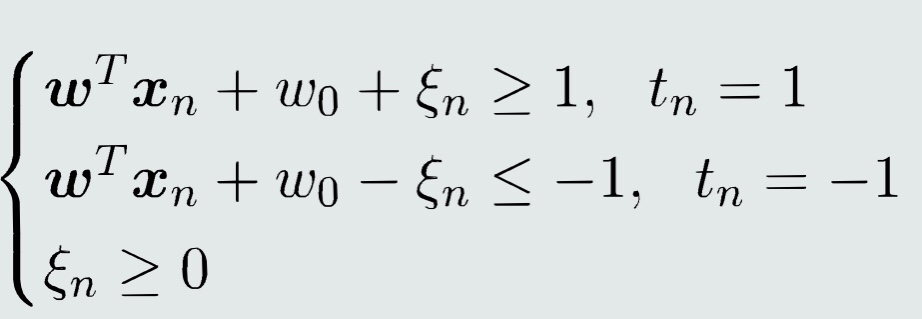

4.10 软间隔支持向量机

1.为了克服过拟合->将硬间隔放宽到软间隔

2.设计思想:

引入松弛变量。

3.软间隔的引入使得线性SVM可用于近似分类非线性数据。

4.分类器表达:

5.设计过程:

构建目标函数->构建拉格朗日函数->构建对偶函数(在极值点得到对偶函数LD)->对偶问题->支持向量的求解与分析->参数最优解->决策过程

单个线性判据只能实现二类分类

=>

4.11 线性判据多类分类

1.多类分类的本质:非线性

2.实现非线性分类的途径:

一个模型:能刻化非线性的决策边界。

多个模型:多个模型(线性/非线性)组合成非线性决策边界。

组合方式:并行组合、串行组合。

3.线性判据实现多类分类的途径:

通过多个线性模型组合的途径实现多类分类。

4.思路:

(1)思路一:One-to-all

假设条件:假设每个类与剩余类可分,总共需要训练K个分类器。

问题:每个分类器的正负类样本个数不均衡。

混淆区域问题:拒绝选项;重叠。

(2)思路二:线性机

假设条件:每个类与剩余类线性可分。

训练:基于one-to-all策略训练𝐾个线性分类器𝑓𝑖,每个分类器对应一个类𝐶𝑖。

决策:

输出值投票法:使用两类权重𝒘向量的差值决定相邻两类之间的决策边界;

标签识别法:利用每一类的权重𝒘向量决定该类与剩余类之间的决策边界。

优势:由于使用max函数,不再有混淆区域(即拒绝区域和重叠区域)。通过划定相邻两类之间的边界,分割了重叠区域和拒绝区域。

问题:可能出现最大的𝑓𝑖(𝒙) ≤ 0,即测试样本𝒙出现在拒绝区域。如果严格按照线性判据的定义,拒绝区域其实是线性机(基于one-to-all策略)无法正确判断的区域。

(3)思路三:one-to-one策略

基本思想:针对每两个类𝐶𝑖 和𝐶𝑗 ,训练一个线性分类器:𝑓𝑖𝑗 𝒙 = 𝒘𝑖𝑗𝑇𝒙 + 𝑤0𝑖𝑗。𝐶𝑖类真值为正;𝐶𝑗类真值为负。总共需要训练𝐾(𝐾 − 1) /2个分类器。

优势:适用于一些线性不可分的情况,从而实现非线性分类;与one-to-all策略相比,不再有重叠区域。

问题:会出现拒绝选项,即样本不属于任何类的情况。

5.总结:

使用线性判据进行多类分类,本质上是利用多个线性模型组合而成一个非线性分类器。

因此,决策边界不再是由单个超平面决定,而是由多个超平面组合共同切割特征空间。

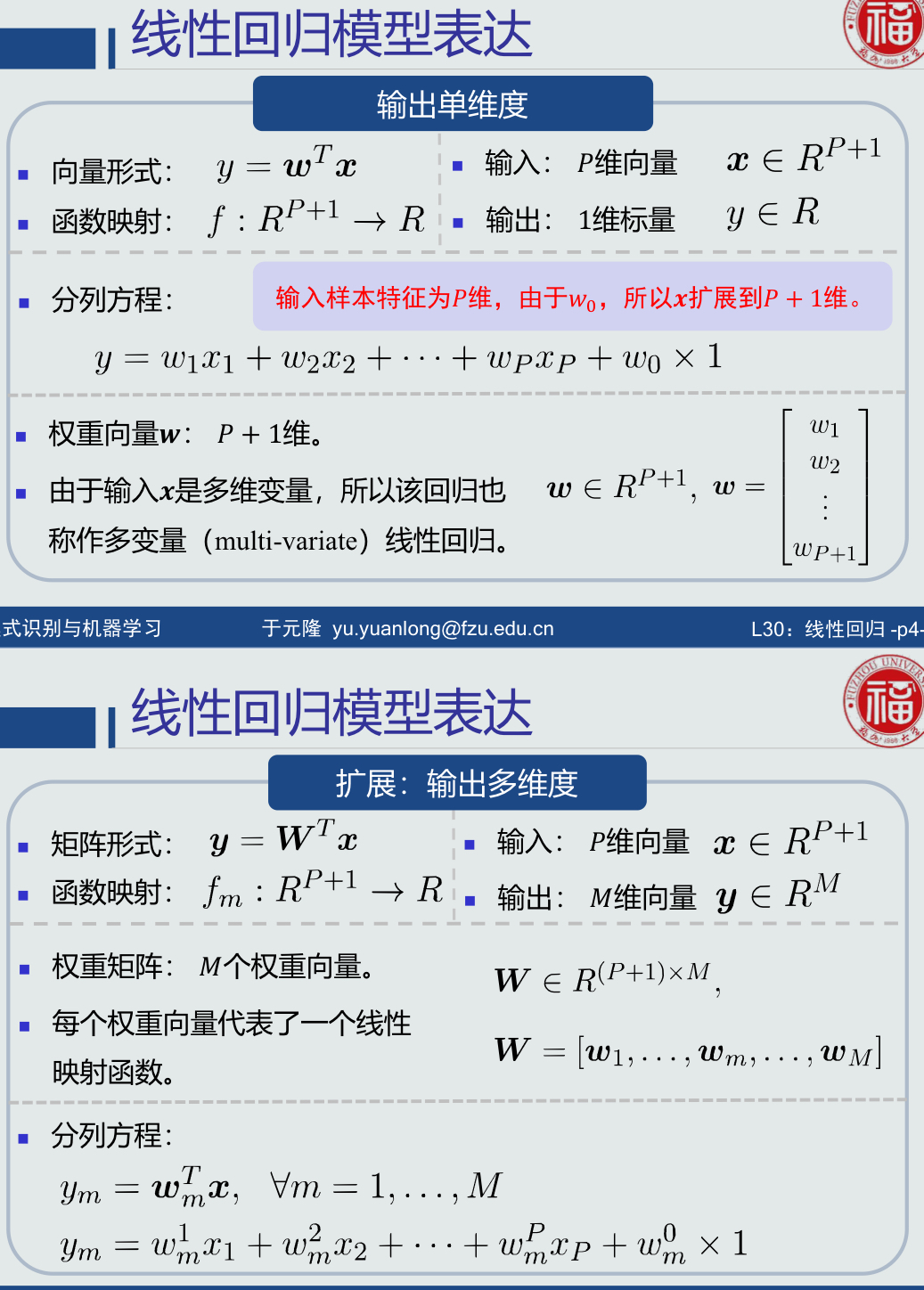

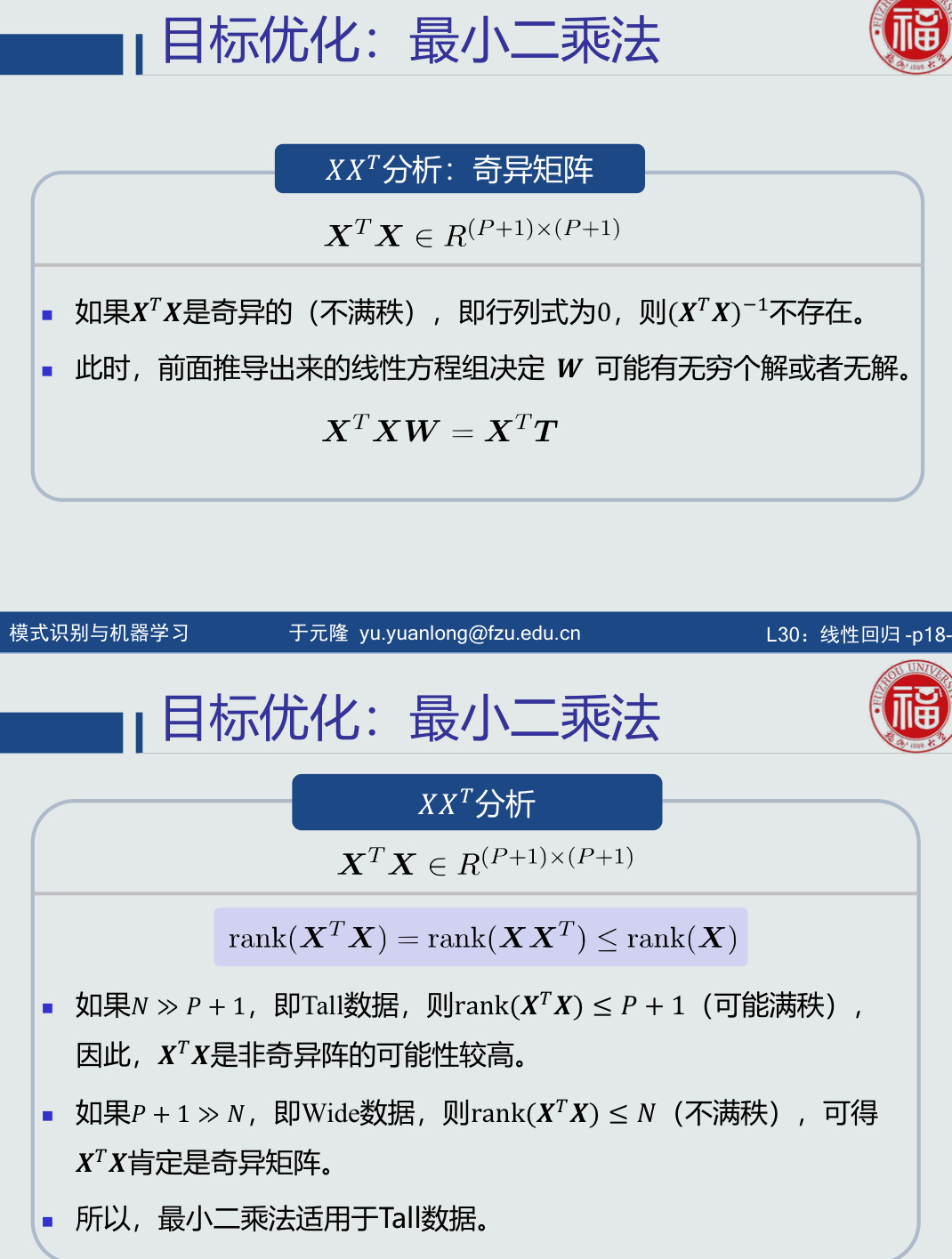

4.12 线性回归

1.模型表达

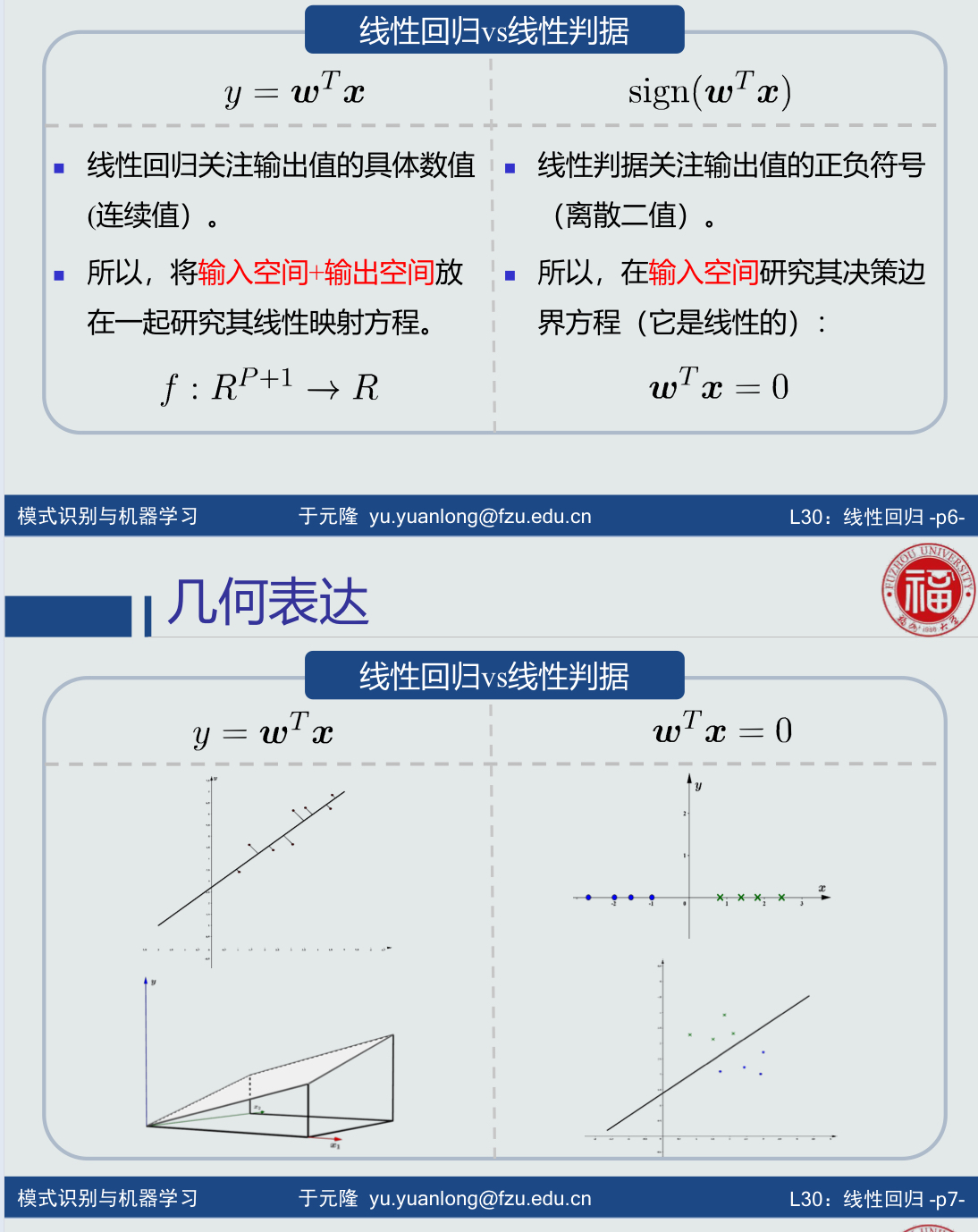

2.线性回归vs线性判据:

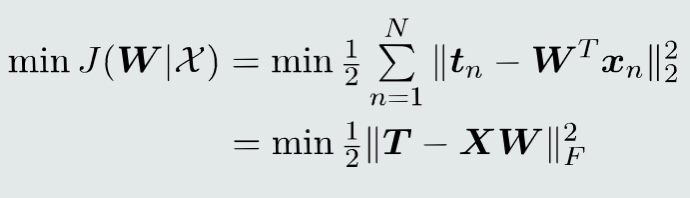

2.目标函数:使用均方误差

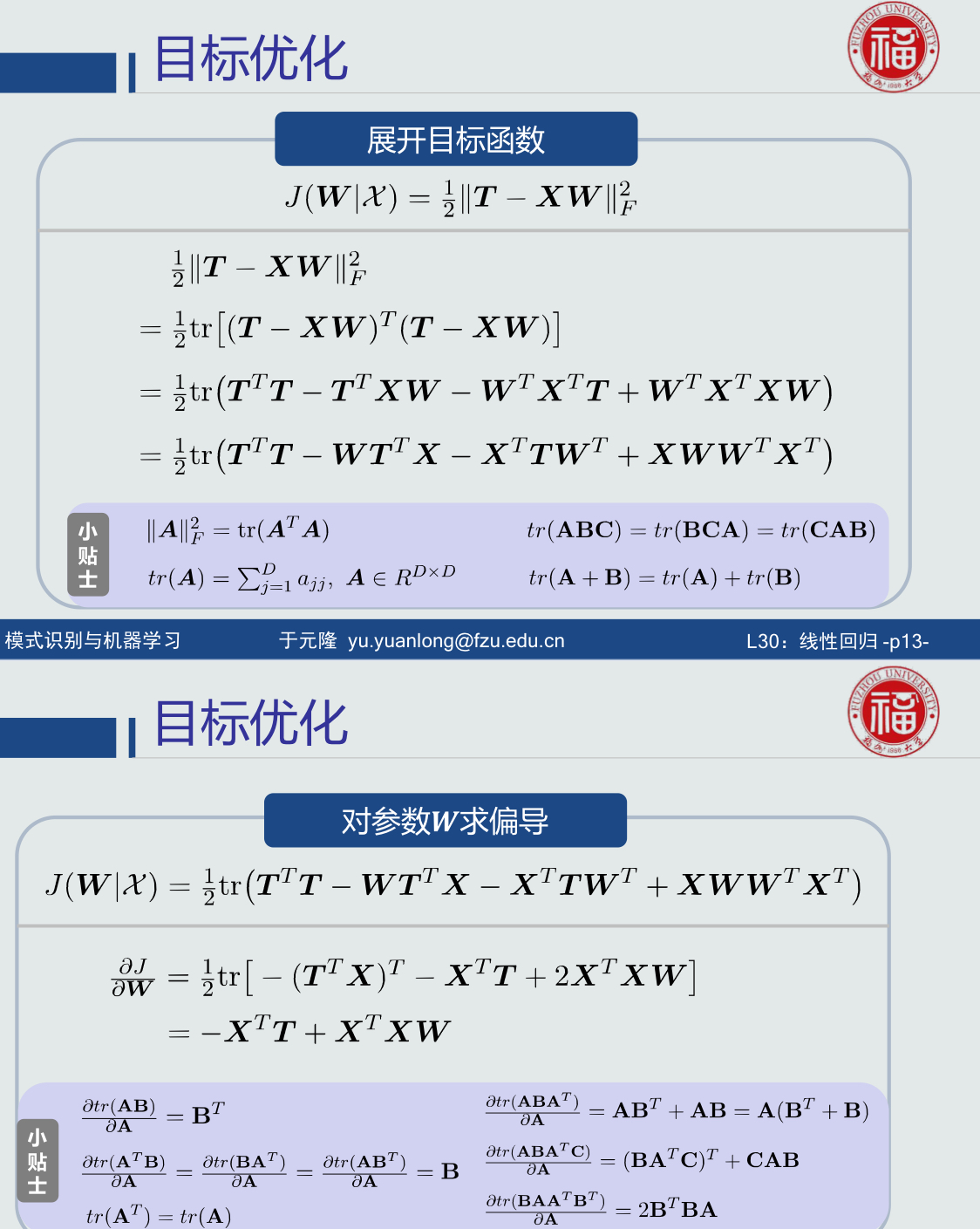

3.目标函数求解:

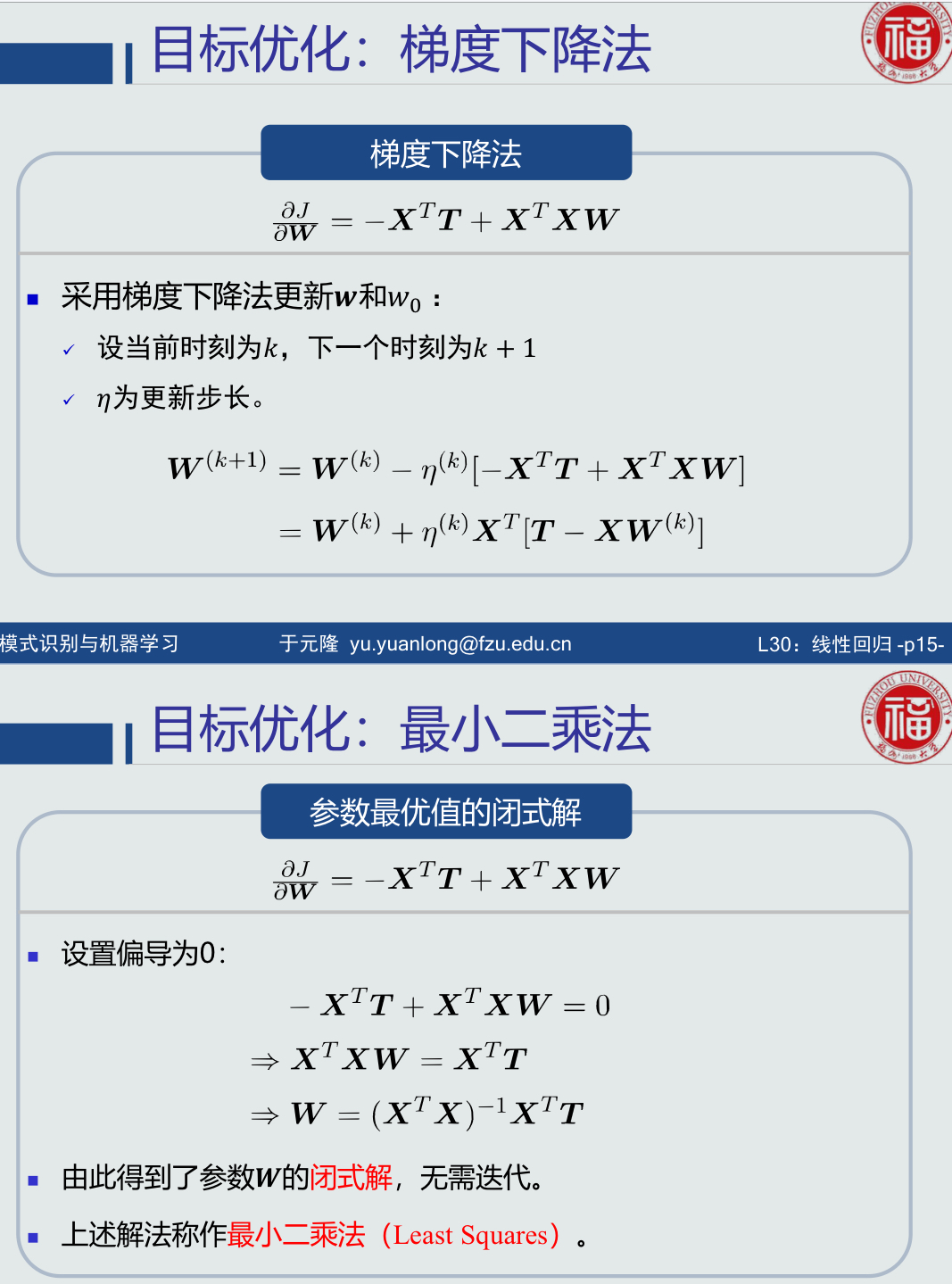

使用梯度下降法求解或使用最小二乘法直接求解

5.线性回归模型学习过程:

学习参数(给定学习样本学习参数w)->给定N个训练样本->目标函数(最小化均方误差)

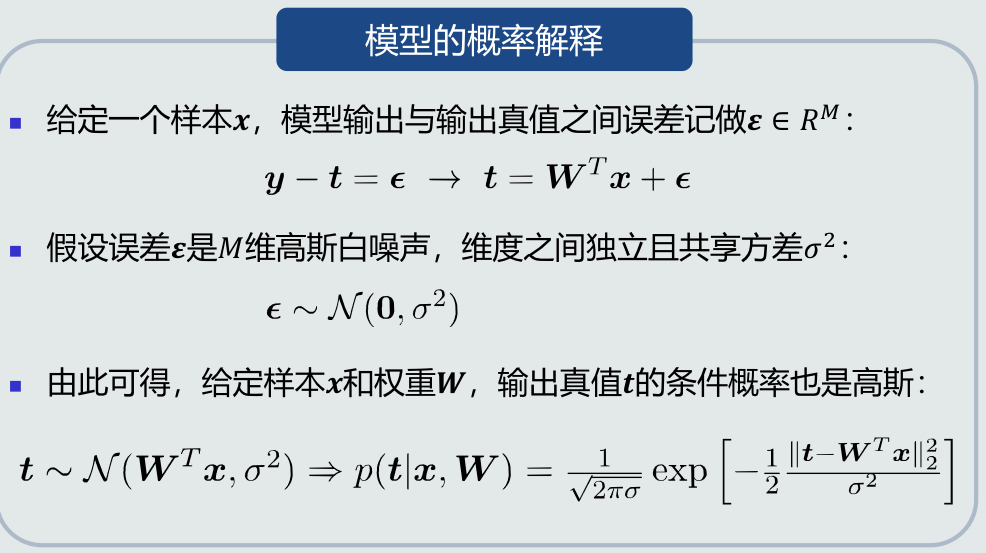

6.线性回归的概率解释:

7.目标函数优化:似然函数;最大似然估计;目标似然/MSE。

4.13 逻辑回归的概念

1.MAP分类器

如果两个类别数据分布的协方差矩阵不同(即Σ𝑖 ≠ Σ𝑗),则MAP分类器的决策边界是一个超二次型曲面,即非线性。

如果两个类别数据分布的协方差矩阵相同(即Σ𝑖 = Σ𝑗 ),则MAP分类器的决策边界是一个超平面,即线性。

2.MAP分类器可以在线性与非线性之间切换,为我们将线性模型改进成非线性模型提供了思路。

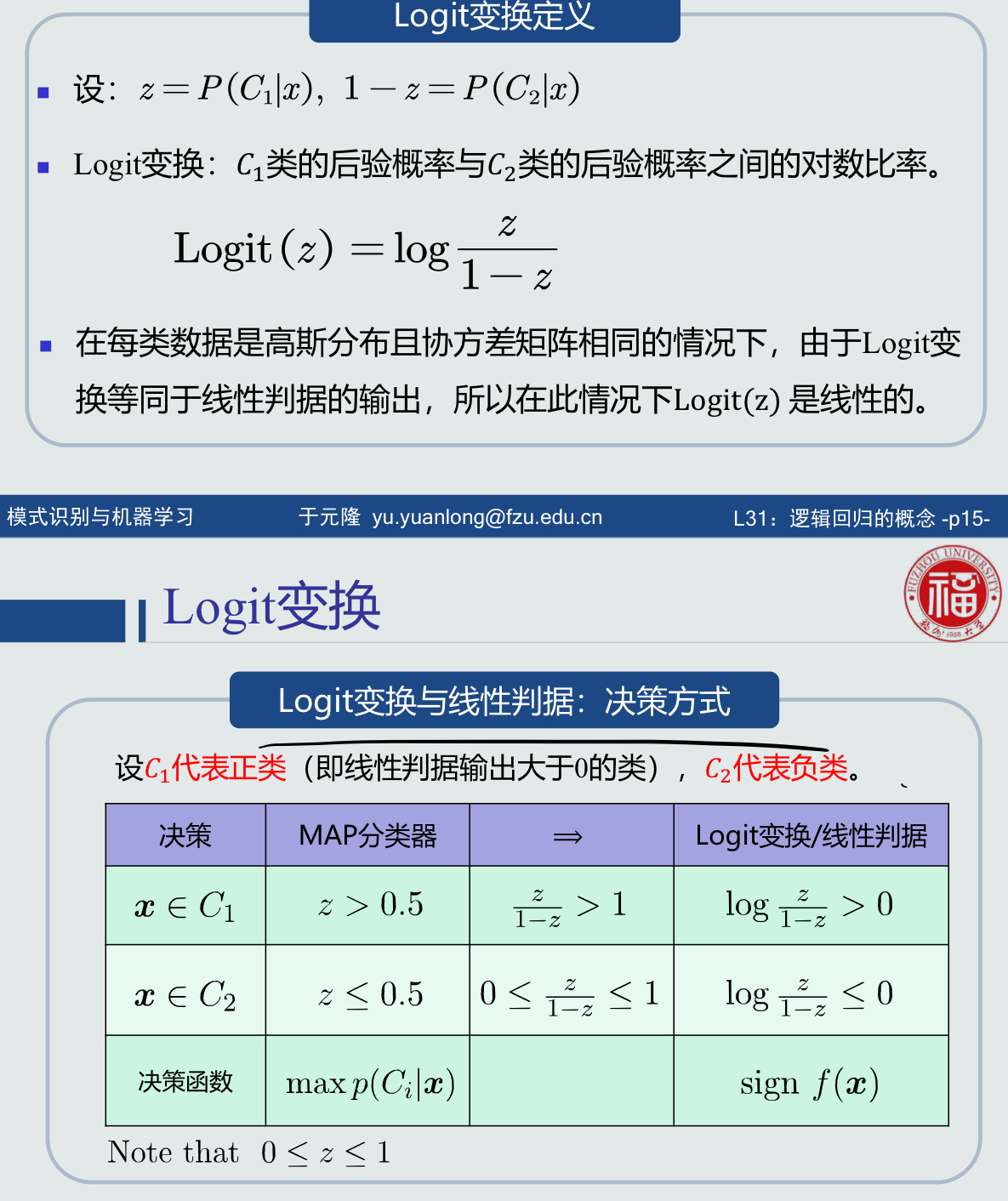

3.Logit变换:

𝐶1类的后验概率与𝐶2类的后验概率之间的对数比率

在每类数据是高斯分布且协方差矩阵相同的情况下,由于Logit变换等同于线性判据的输出,所以在此情况下Logit(z) 是线性的。

4.Sigmoid函数:

连接线性模型和后验概率的桥梁

线性模型𝑓(𝒙) + Sigmoid函数 = 后验概率

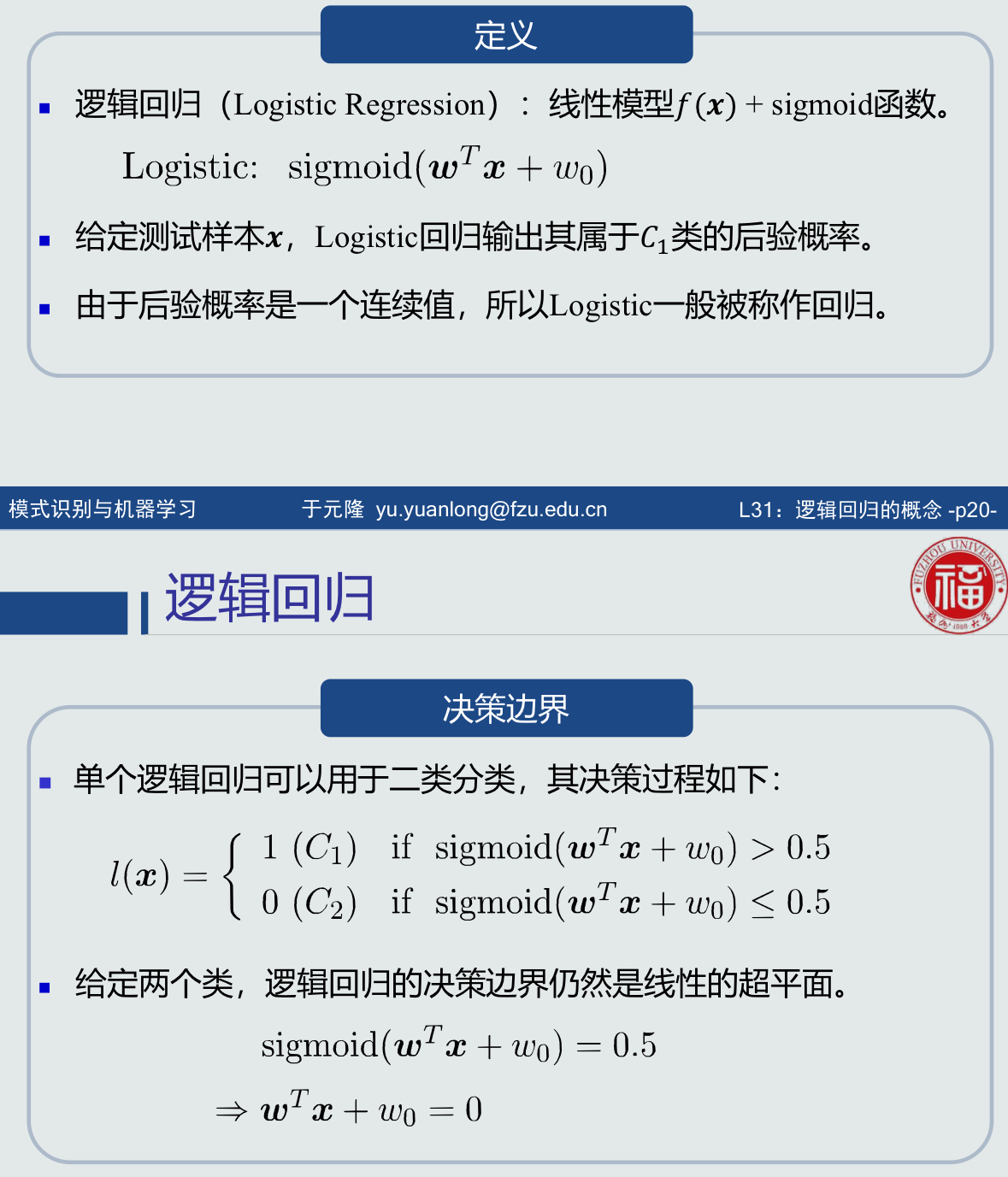

5.逻辑回归:

线性模型𝑓(𝒙) + sigmoid函数。

适用范围:分类,回归。

逻辑回归本身是一个非线性模型。

逻辑回归用于分类:仍然只能处理两个类别线性可分的情况。但是,sigmoid函数输出了后验概率,使得逻辑回归成为一个非线性模型。因此,逻辑回归比线性模型向前迈进了一步。

逻辑回归用于拟合:可以拟合有限的非线性曲线。

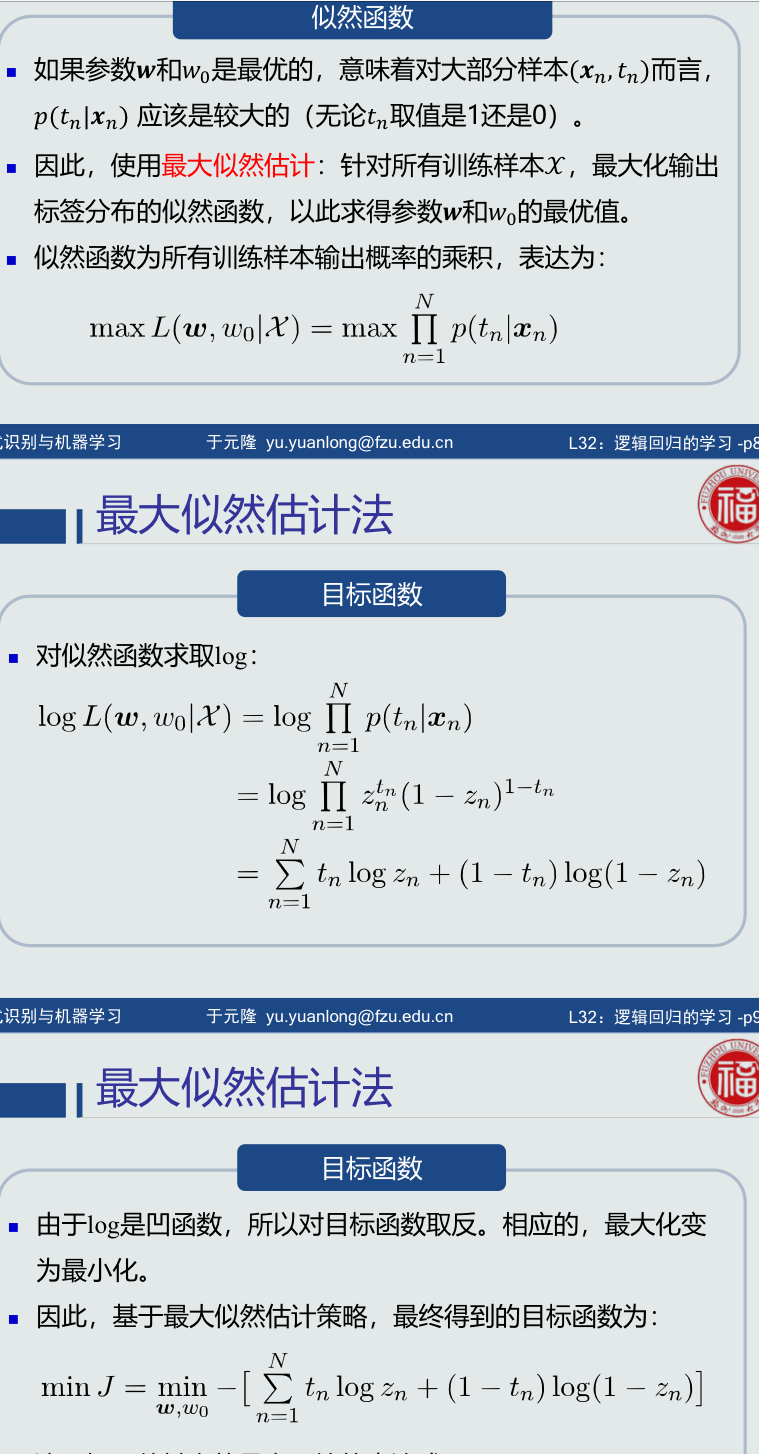

4.14 逻辑回归的学习

1.训练样本:

正类(𝐶1类)样本的输出真值𝑡𝑛 = 1;

负类(𝐶2类)样本的输出真值𝑡𝑛 = 0。

注意:这种真值取值方式与SVM不一样。

3.最大似然估计法:

给定单个输入样本𝒙,模型输出的类别标签𝑙可以看做一个随机变量。

4.交叉熵:

5.目标函数:给定𝑁个训练样本,把每个训练样本的交叉熵求和,得到最终的目标函数:

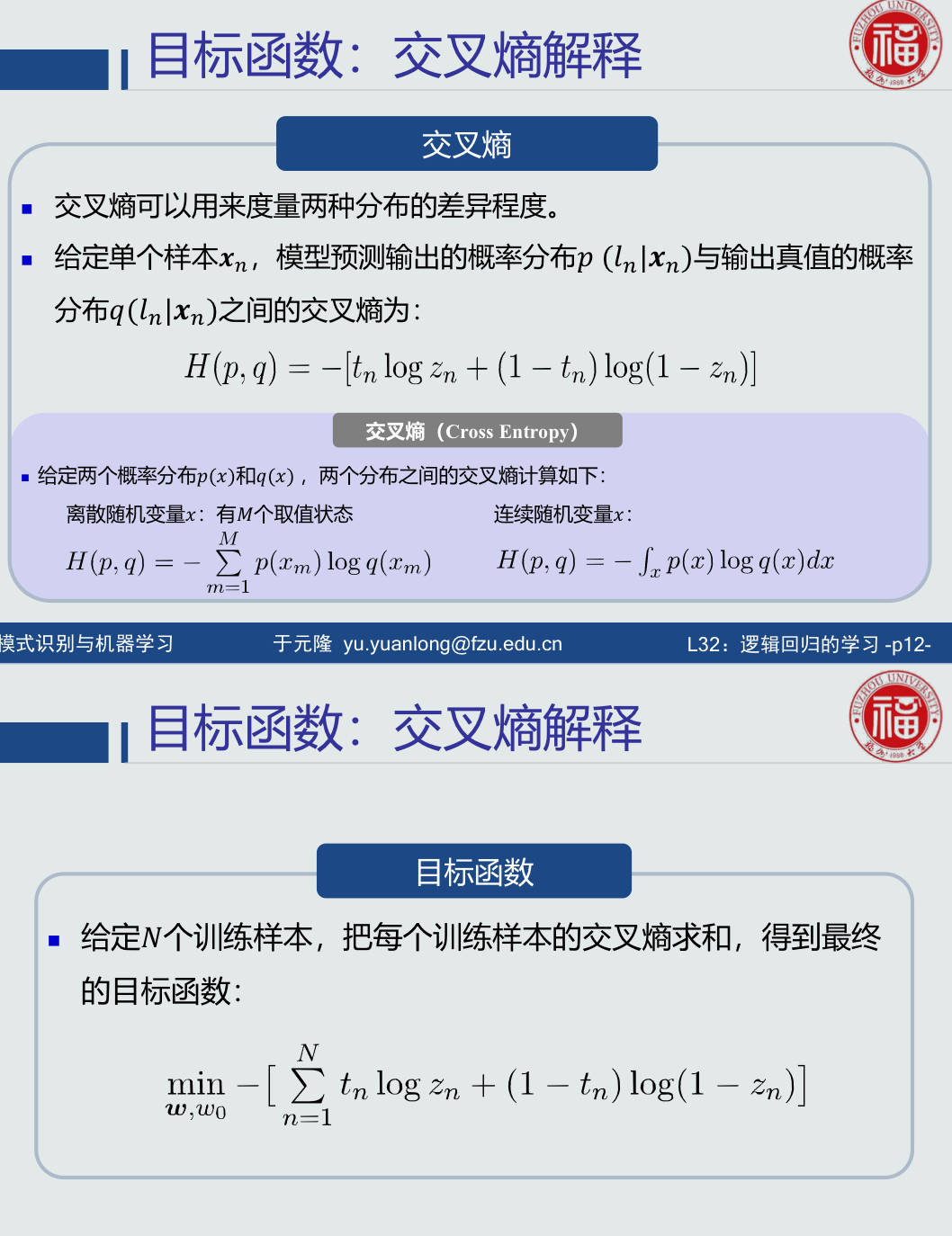

6.目标函数优化:

梯度下降法;

步骤:对参数w求偏导;对参数w0求偏导;参数更新:采用梯度下降法更新w和w0;

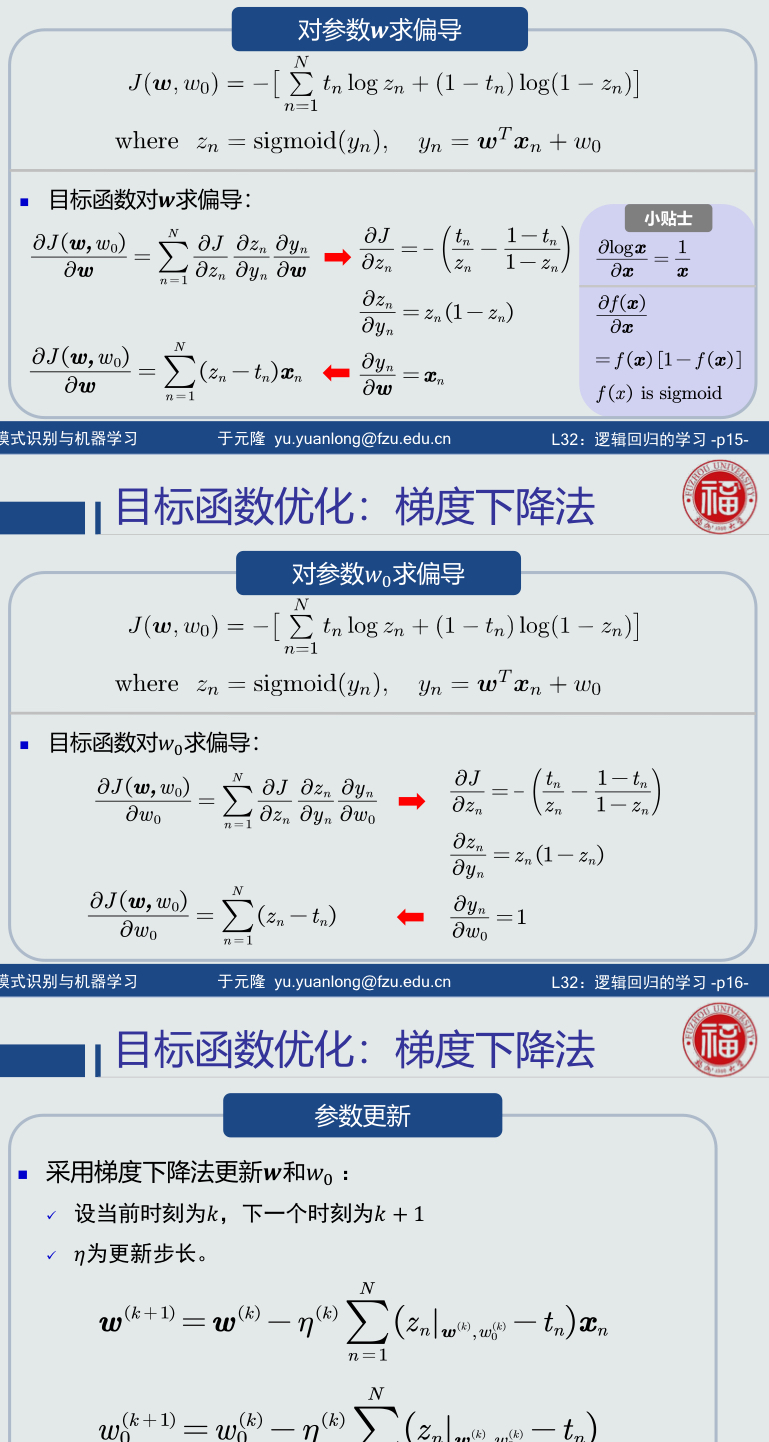

4.15 Softmax判据的概念

1.逻辑回归输出:属于正类的后验概率

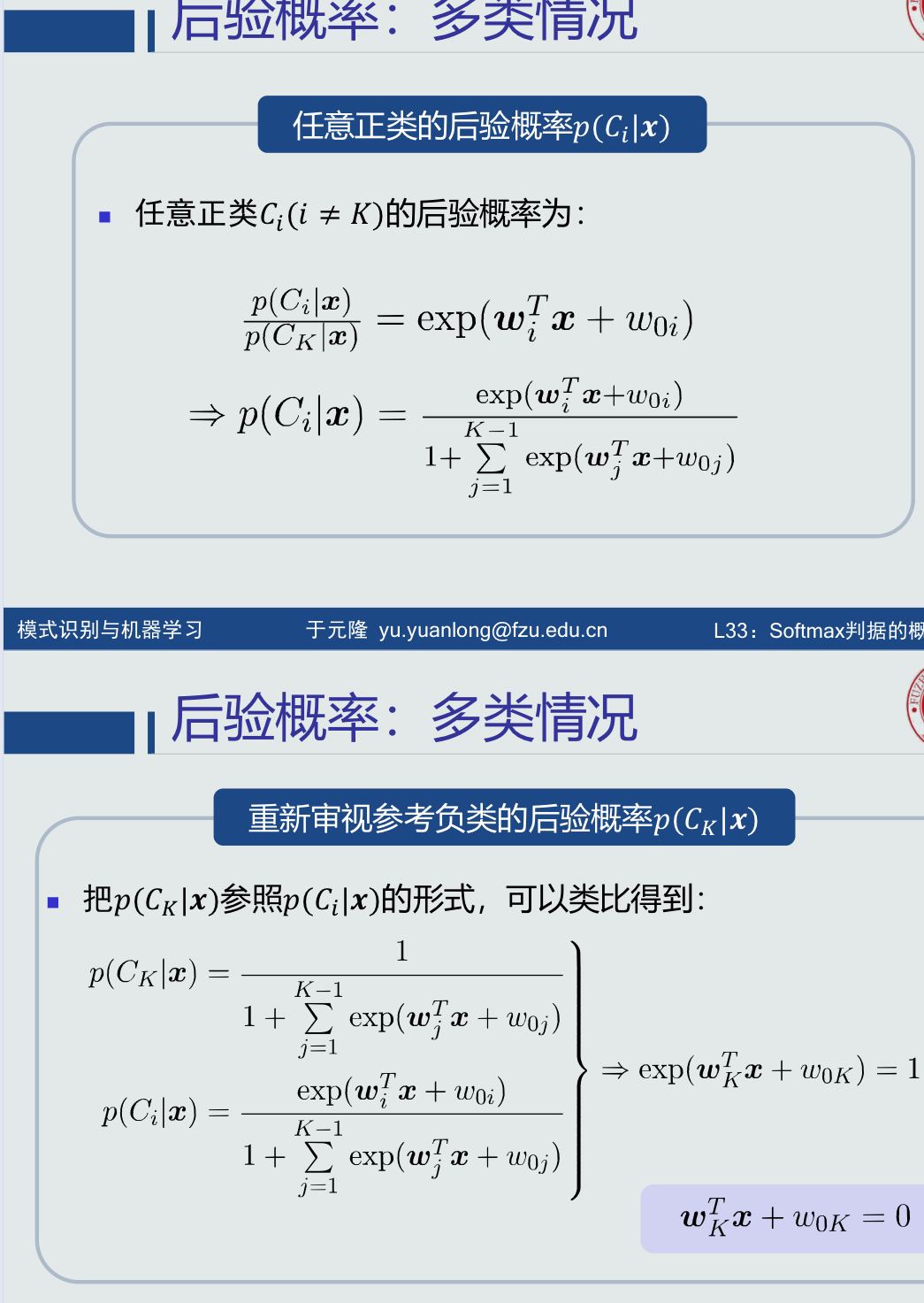

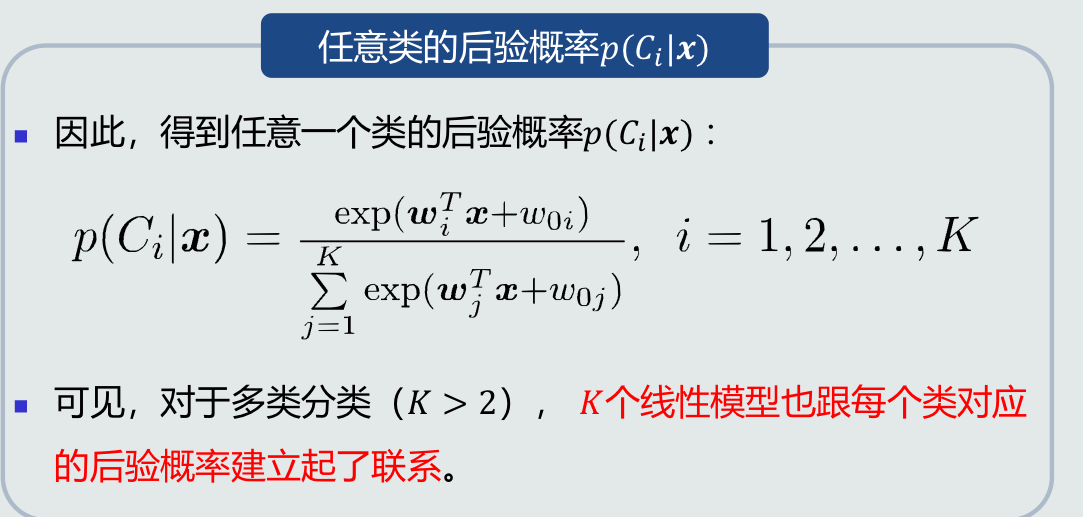

2.后验概率的多类情况:

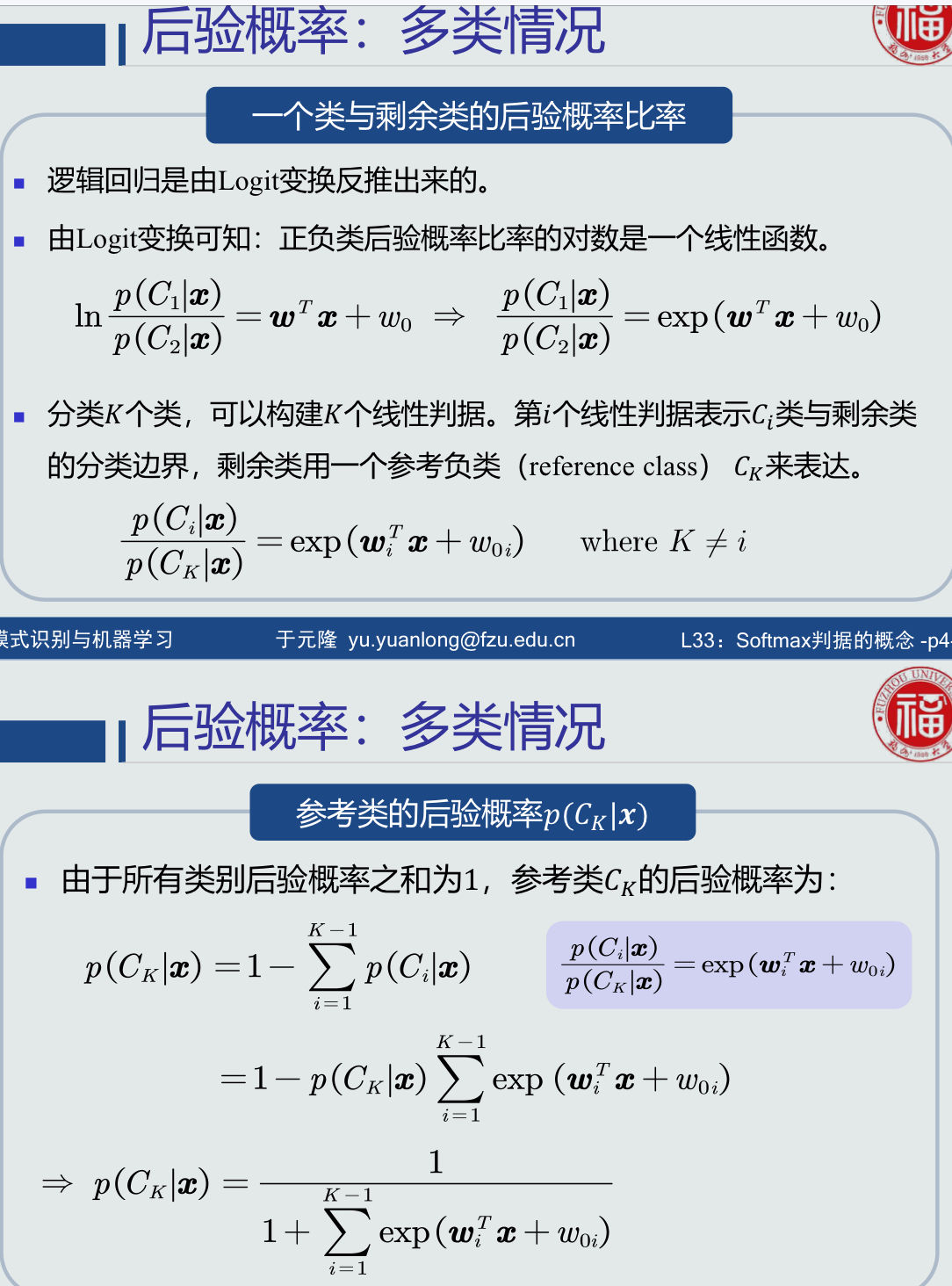

3.softmax函数:

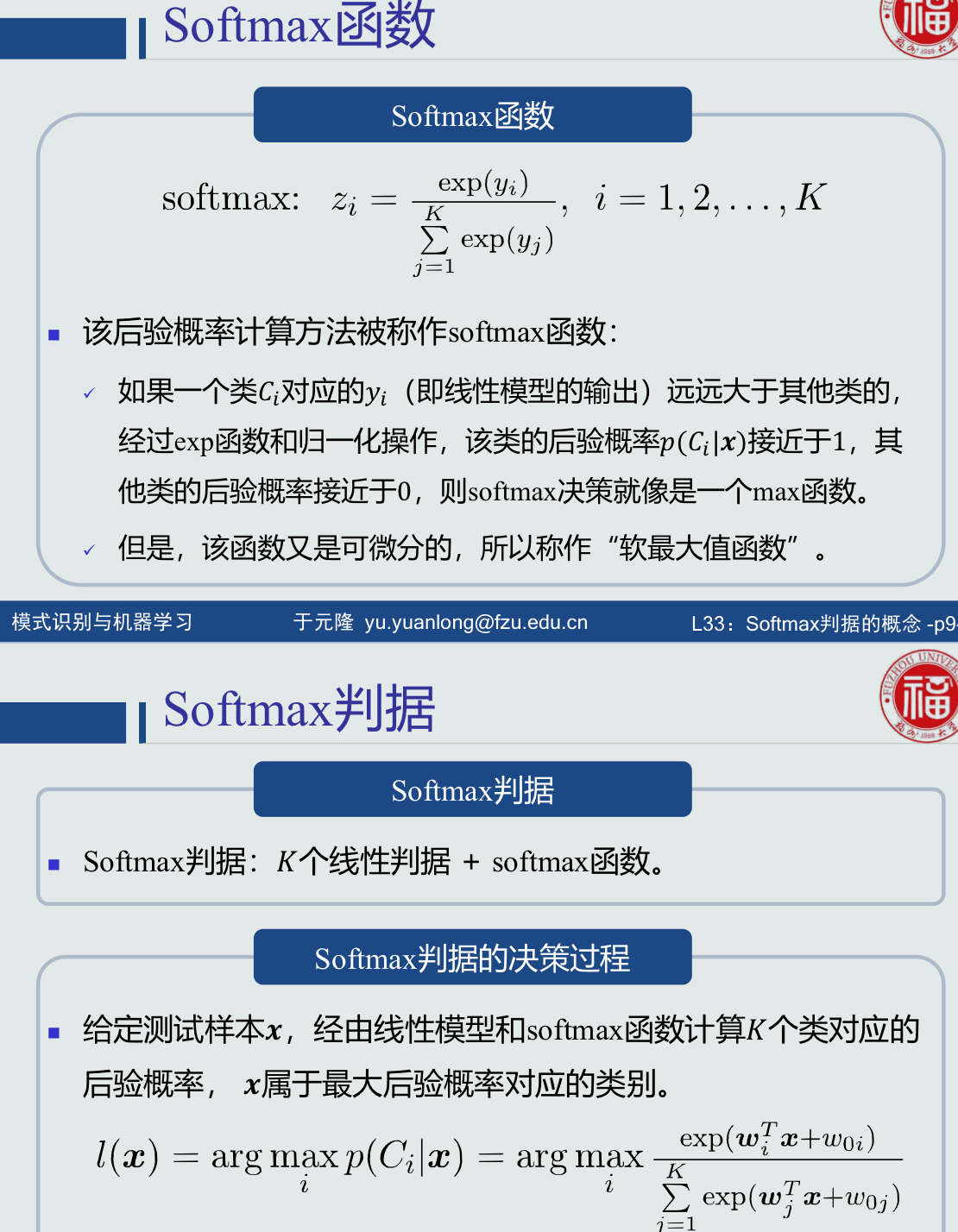

4.Softmax判据:

𝐾个线性判据 + softmax函数。

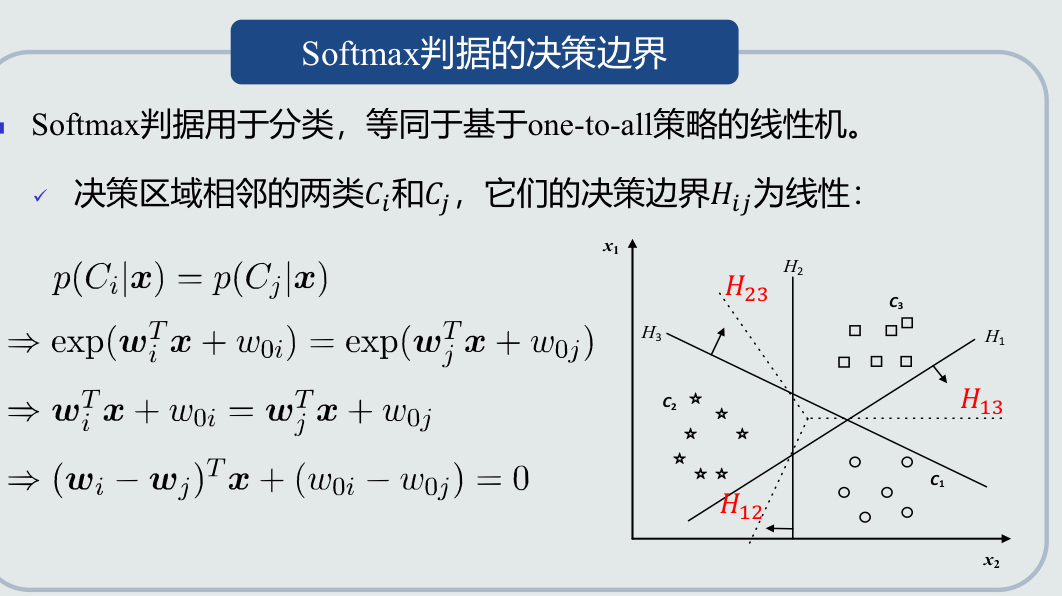

5.Softmax决策边界:

判据用于分类,等同于基于one-to-all策略的线性机。

6.适用范围:分类、回归

7.总结:

Softmax判据本身是一个非线性模型。

Softmax判据用于分类:只能处理多个类别、每个类别与剩余类线性可分的情况。但是, Softmax判据可以输出后验概率。因此,Softmax判据比基于one-to-all策略的线性机向前迈进了一步。

Softmax判据用于拟合:可以输出有限的非线性曲线。

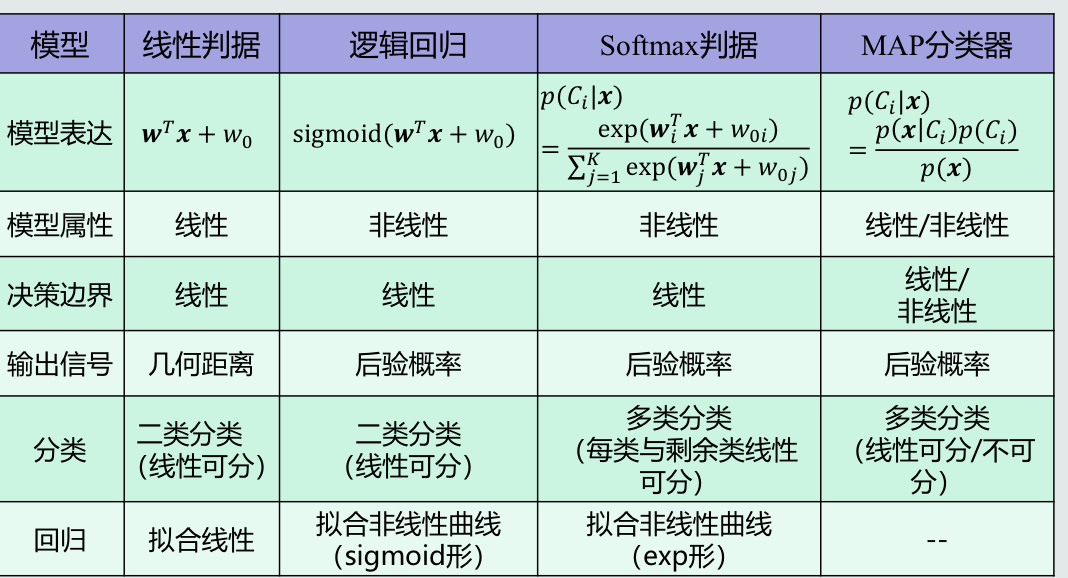

8.模型对比

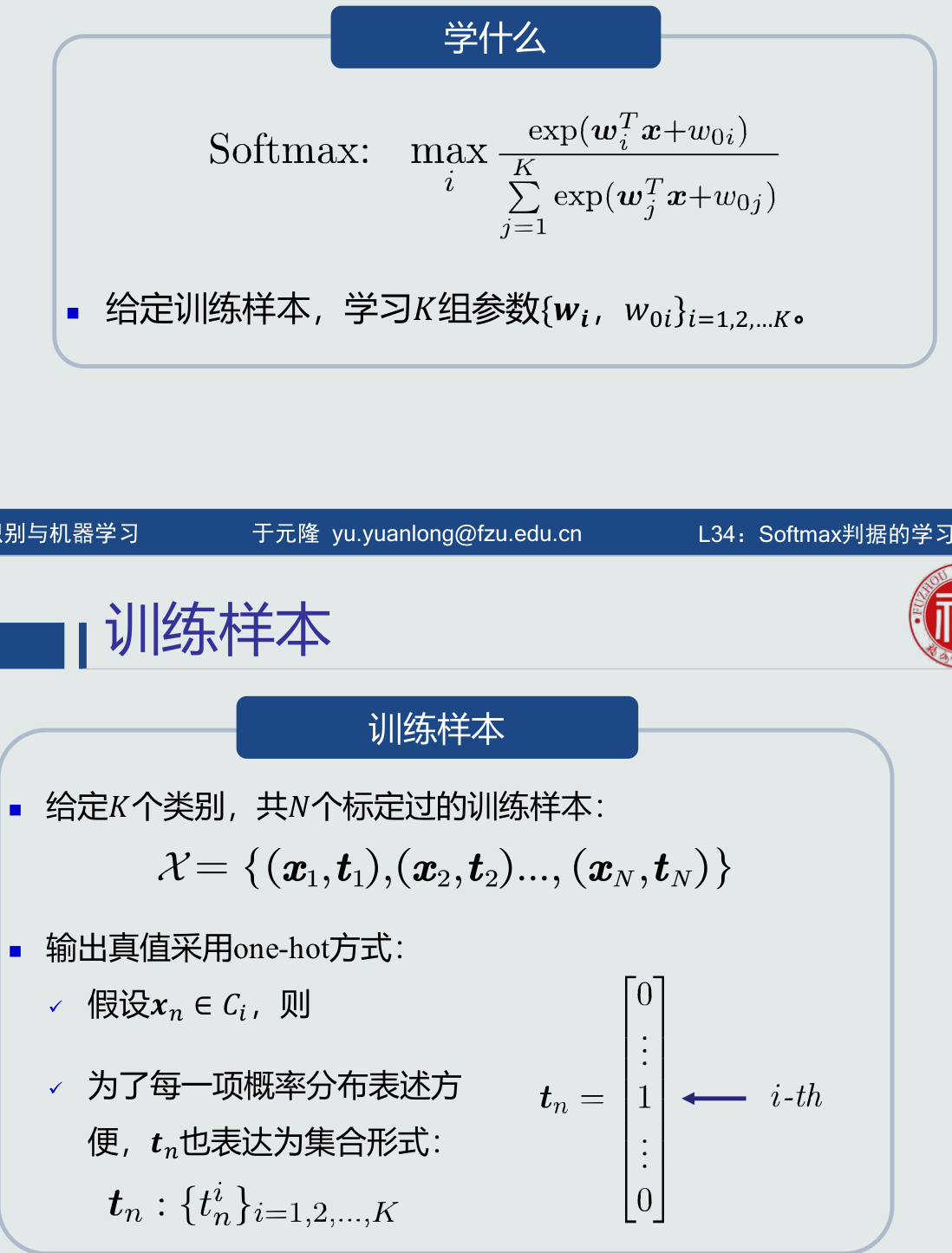

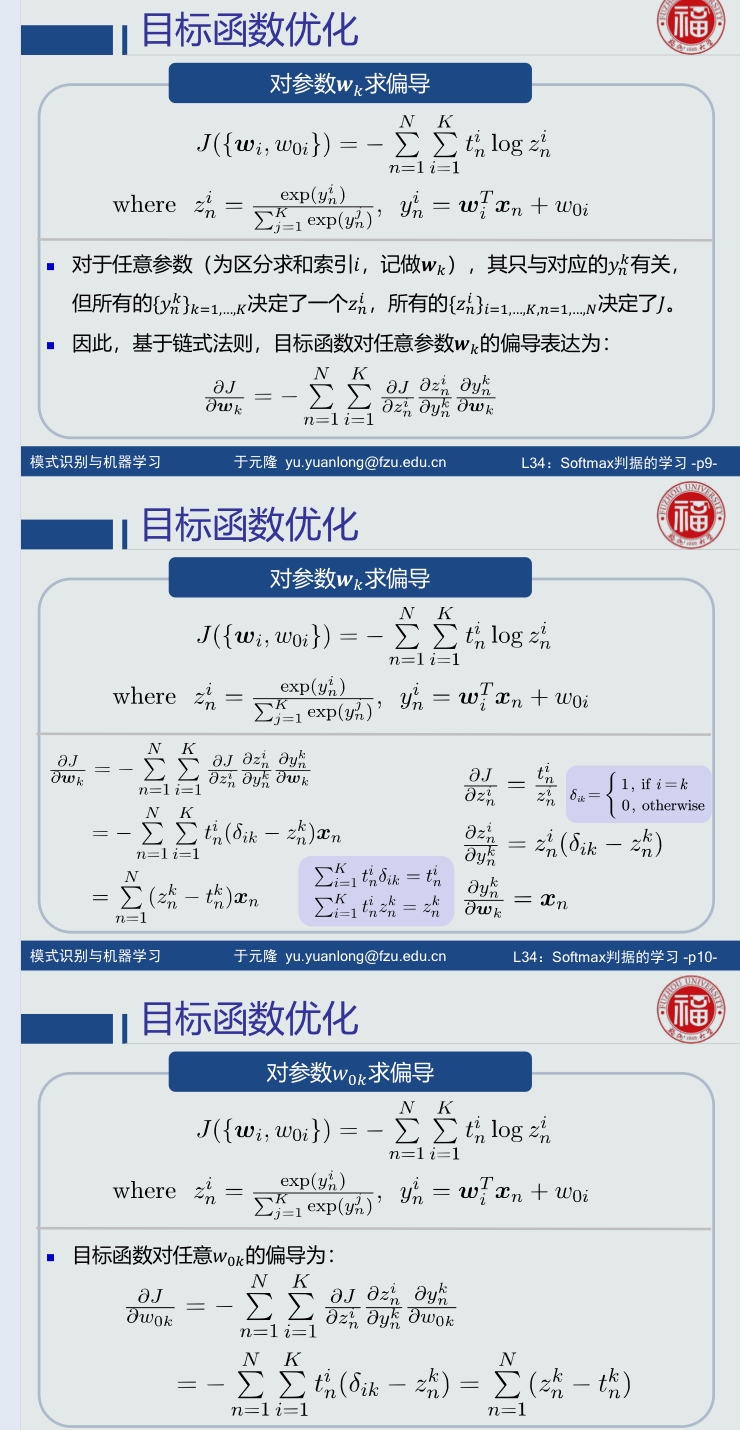

4.16 Softmax判据的学习

1.

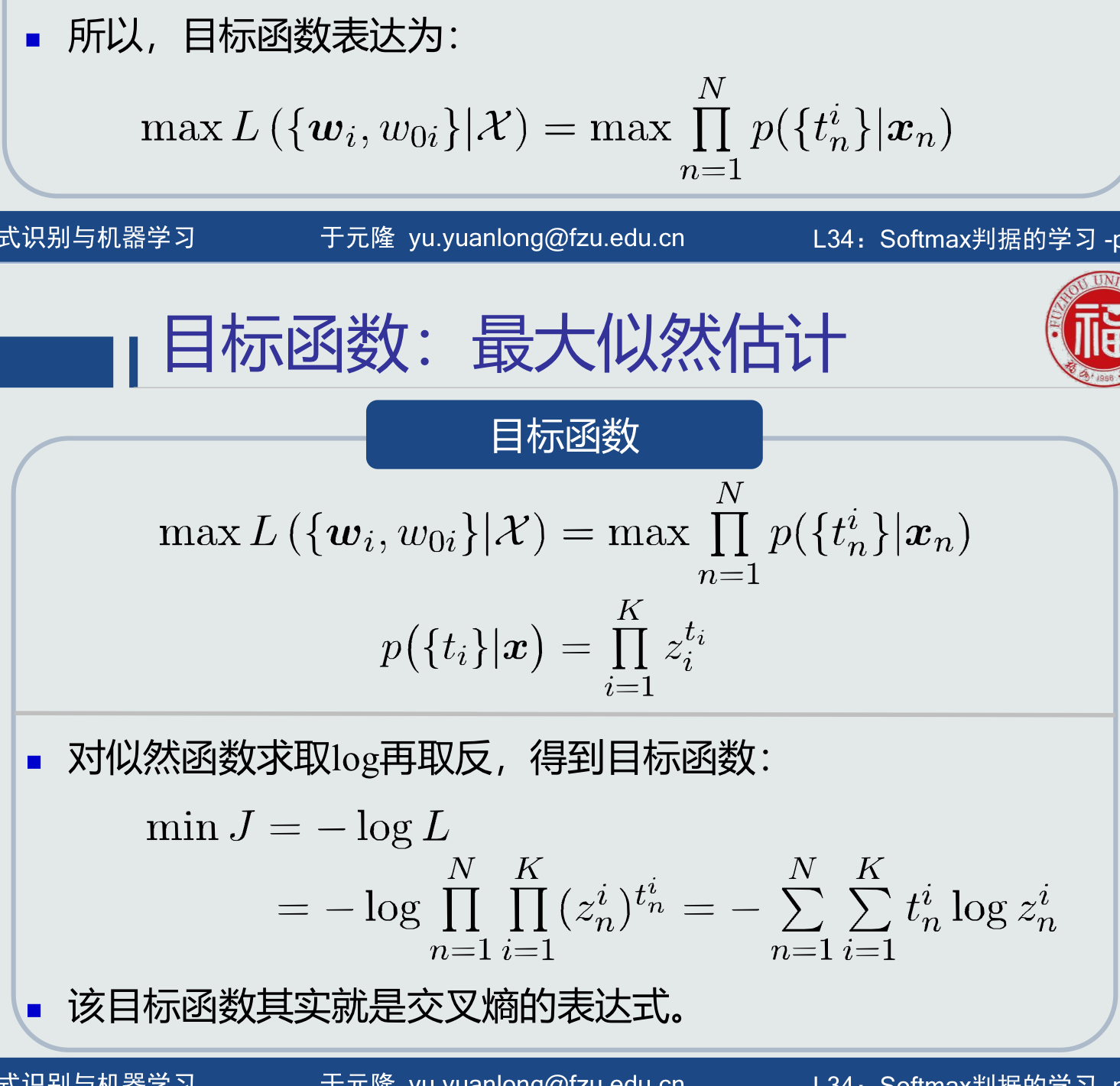

2.目标函数:

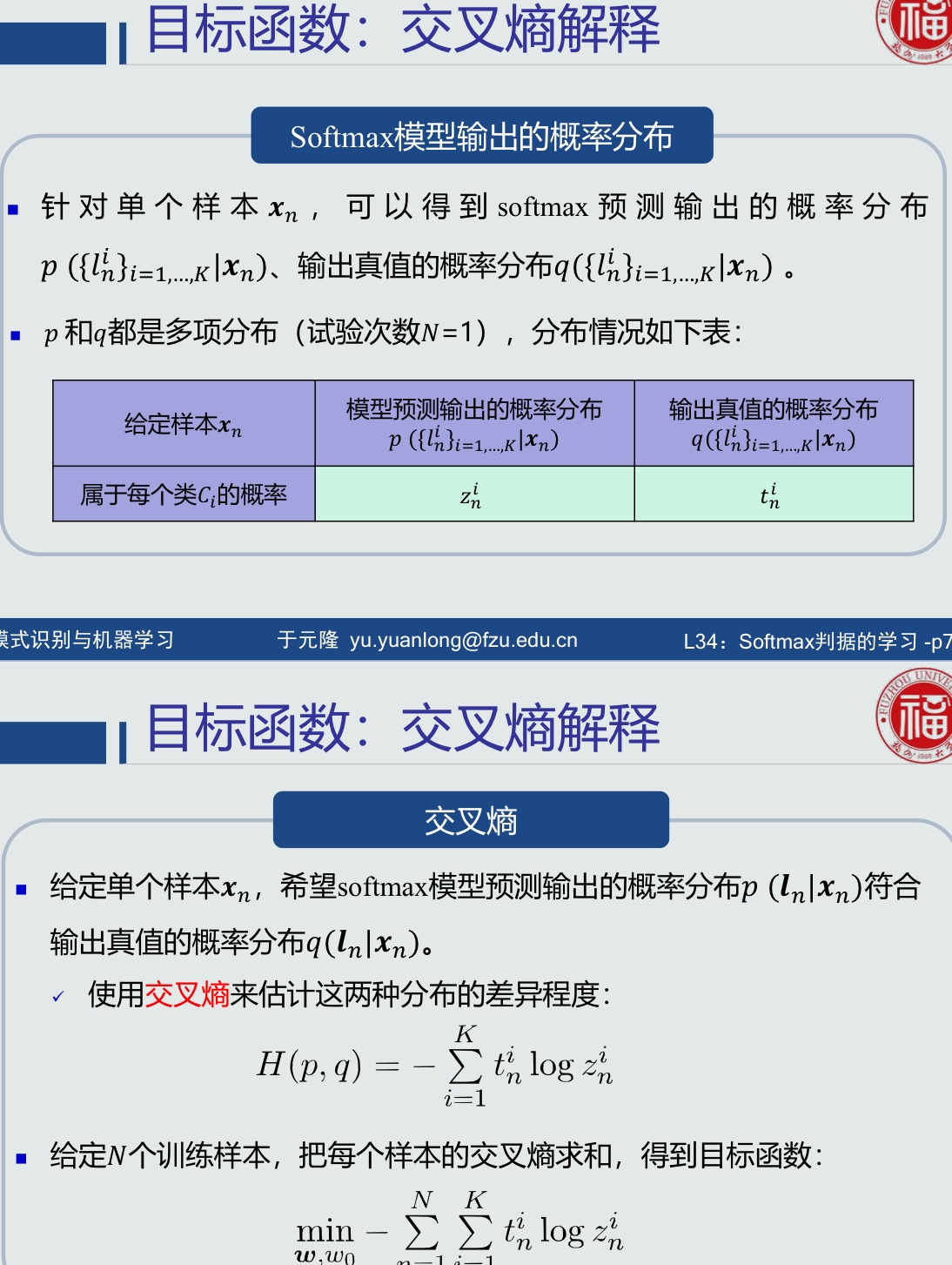

3.交叉熵解释:

4.目标函数优化:

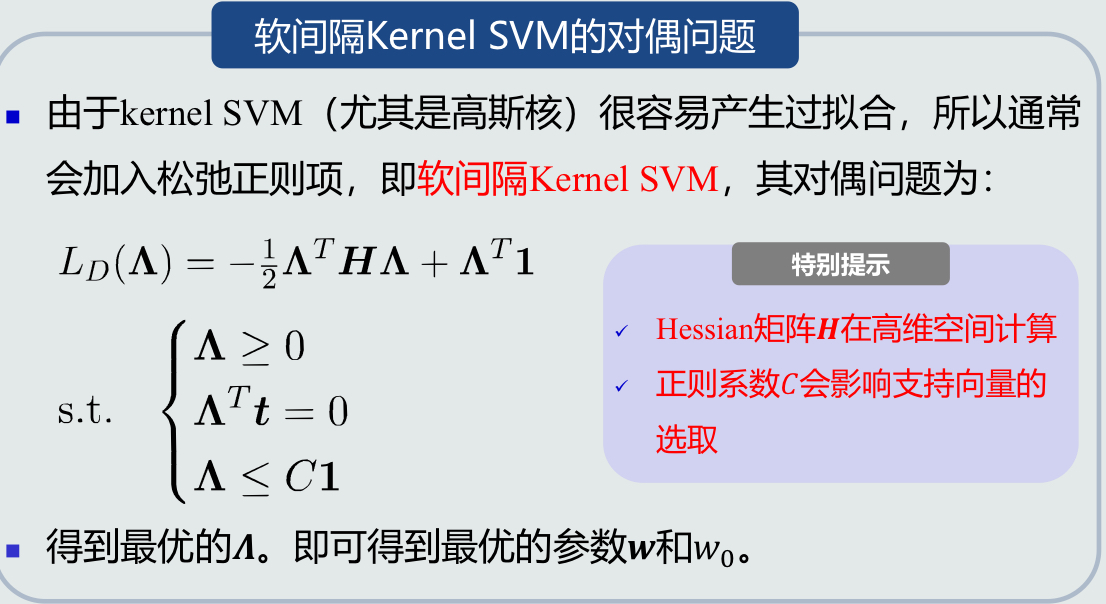

4.17 核支持向量机

1.设计思想:

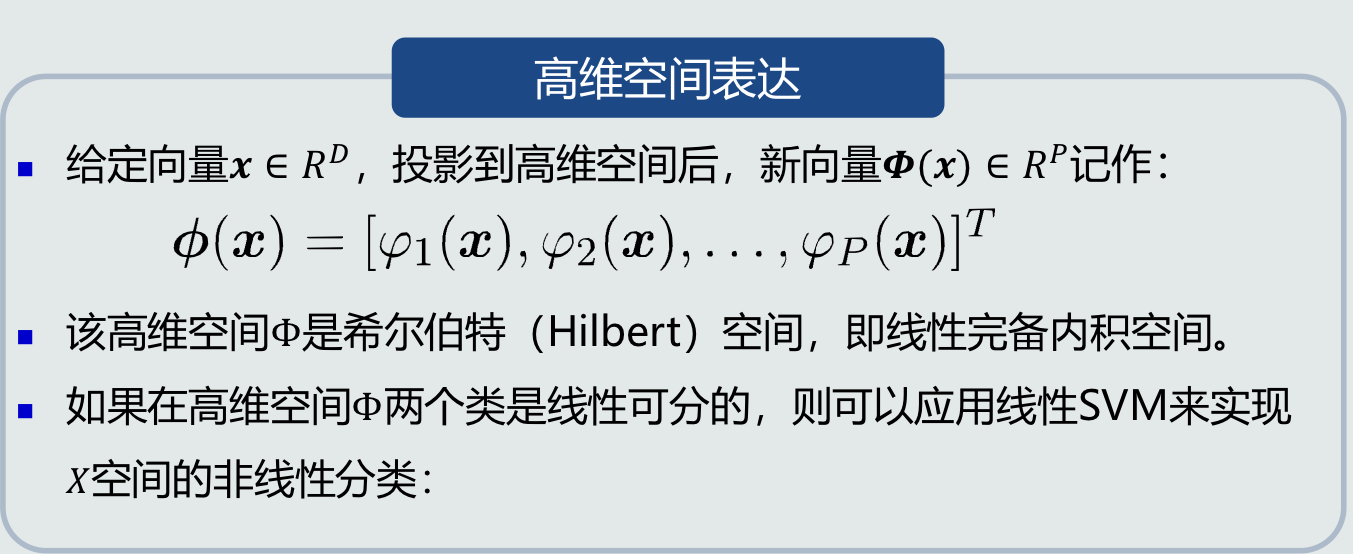

(1)Kernel方法的基本思想:

如果样本在原始特征空间(𝑋空间)线性不可分,可以将这些样本通过一个函数𝜑映射到一个高维的特征空间(Φ空间),使得在这个高维空间,这些样本拥有一个线性分类边界。

(2)高维空间表达:

2.核函数:

在低维X空间的一个非线性函数,包含向量映射和点积功能,即作为X空间两个向量的度量,来表达映射到高维空间的向量之间的点积。

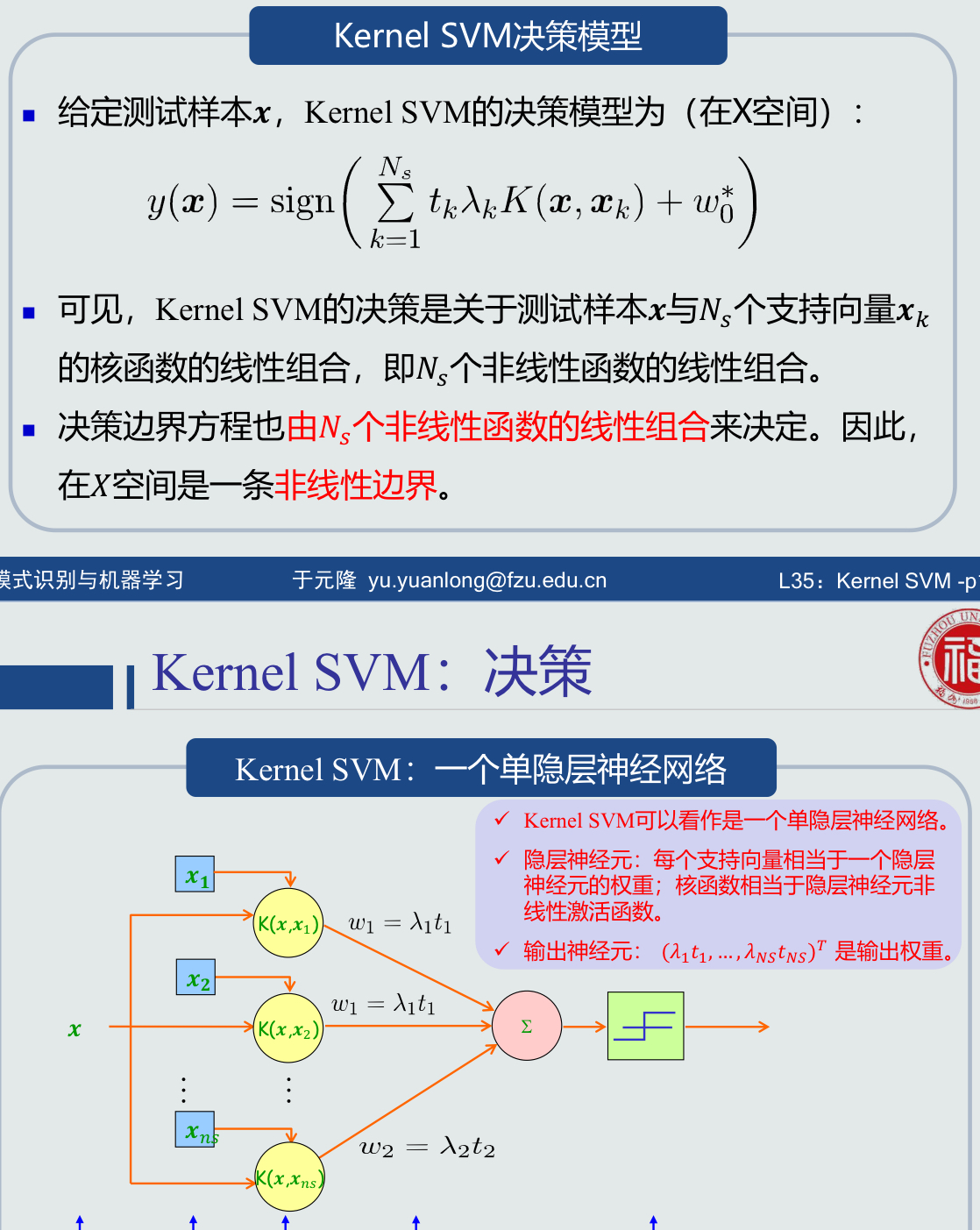

3.Kernel SVM决策模型:

Kernel SVM的决策是关于测试样本x与Ns个支持向量xk的核函数的线性组合,即Ns个非线性函数的线性组合。

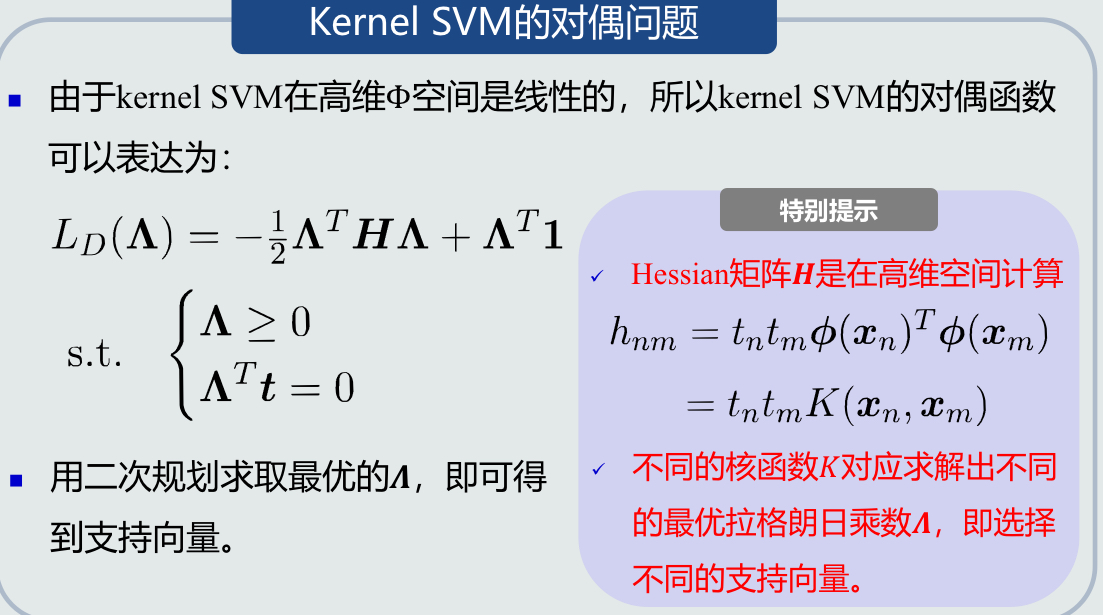

4.Kernel SVM学习算法:

5.Kernel SVM+软间隔:

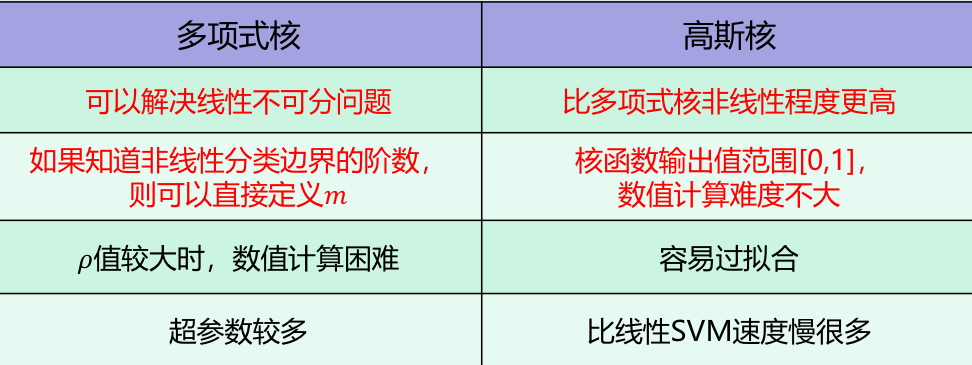

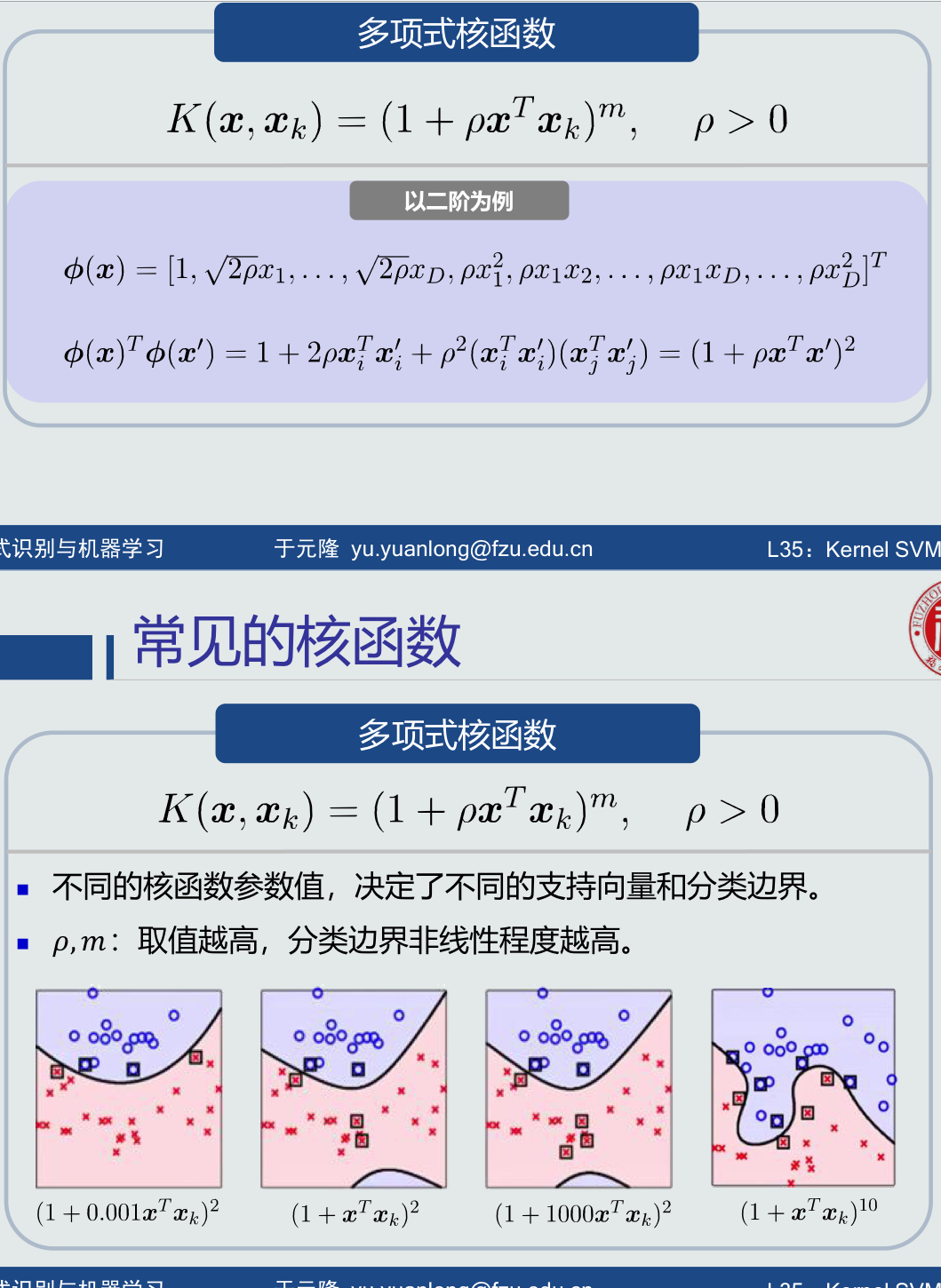

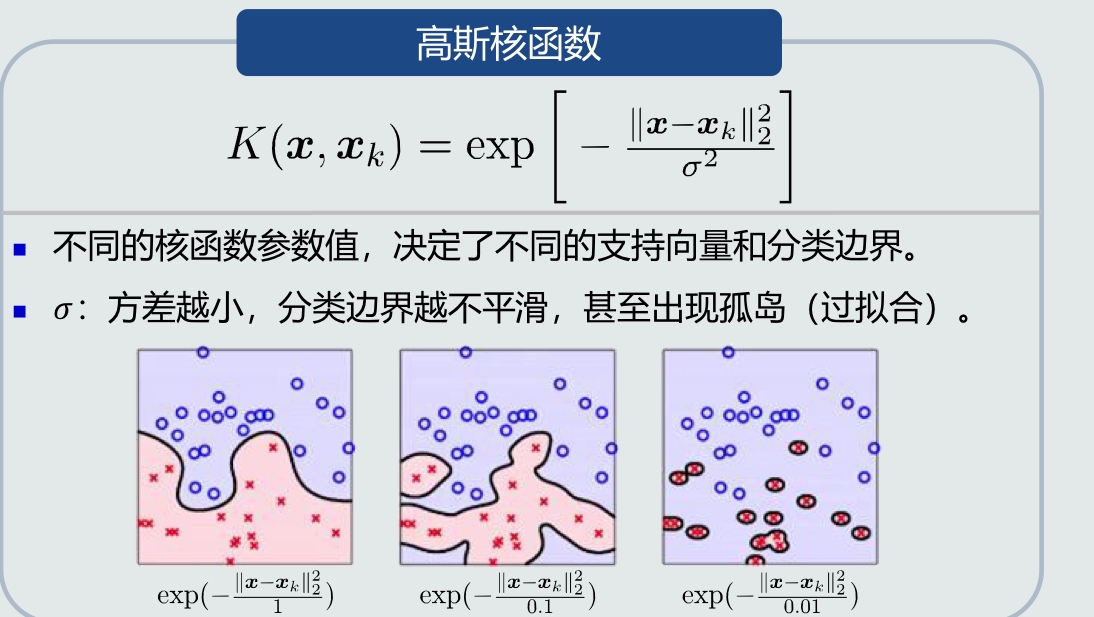

6.常见核函数

(1)多项式核函数:

(2)高斯核函数:

7.核函数的优缺点: