《机器学习》第一次作业——第一至三章学习记录和心得

第一章 模式识别基本概念

1.1什么是模式识别

1.模式识别的应用实例:

字符识别、交通标志识别、动作识别、语音识别、应用程序识别、股票价格预测等

2.模式识别的基本定义:

根据已有知识的表达,针对待识别模式,判别决策其所属的类别或者预测其对应的回归之。因此,模式识别本质上是一种推理过程。

3.模式识别的分类:

根据任务,模式识别可以分为“分类”和“回归”

(1)分类:离散的类别表达

(2)回归:连续的信号表达

二者间关系:回归是分类的基础,离散的类别值是由回归值做判别决策得到的

1.2模式识别数学表达

1. 模式识别的数学解释

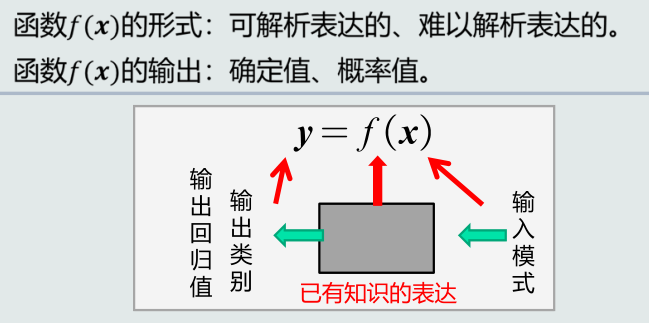

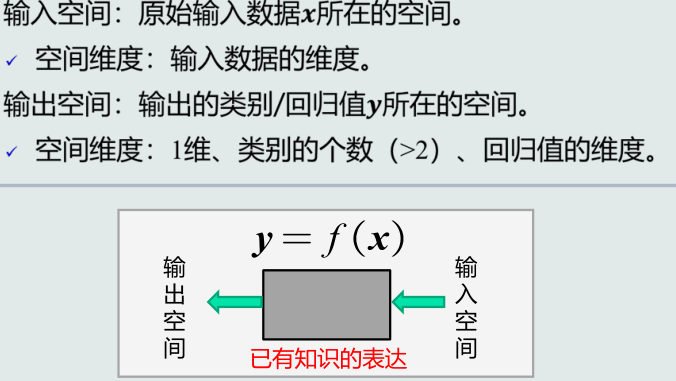

模式识别可以看做一种函数映射f(x),将待识别模式x从输入空间映射到输出空间。f(x)是关于已有知识(训练样本)的表达

2.模型的概念

(1)模型:关于已有知识的一种表达方式,即函数f(x)

(2)模型的组成:

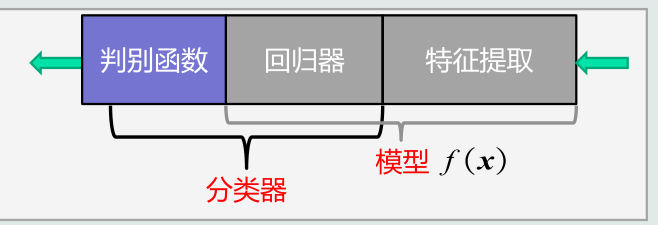

广义:特征提取+回归器+判别函数

狭义:特征提取+回归器

特征提取:从原始输入数据提取更有效的信息

回归器:将特征映射到回归值

分类器:回归器+判别函数

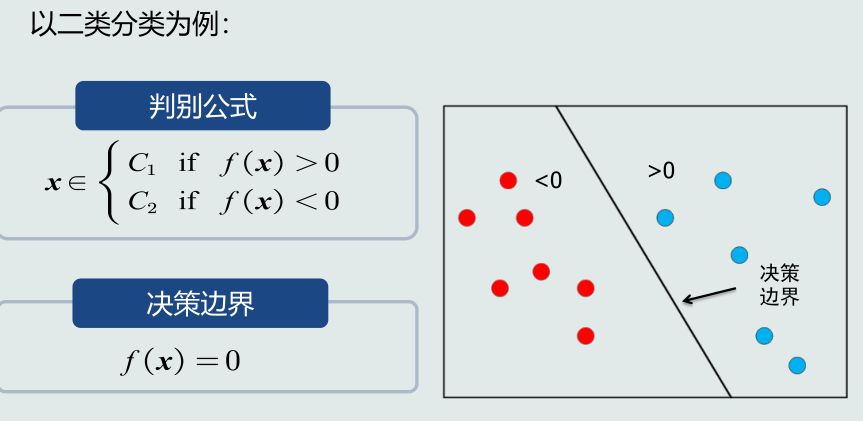

判别函数(决策边界):使用一些特定的非线性函数来实现,记作函数g。由于判别函数通常固定已知,所以不把它当作模型的一部分

二类分类的判别器:使用sign函数:判断回归值大于0还是小于0

多类分类的判别器:使用max函数:取最大的回归值所在维度对应的类别

3.特征&特征空间

(1)特征:

可以用于区分不同类别模式的、可测量的量。

特征的特性:辨别能力,鲁棒性

辨别能力:提升不同类别之间的识别性能

鲁棒性:针对不同的观测条件,仍然能够有效表达类别之间的差异性

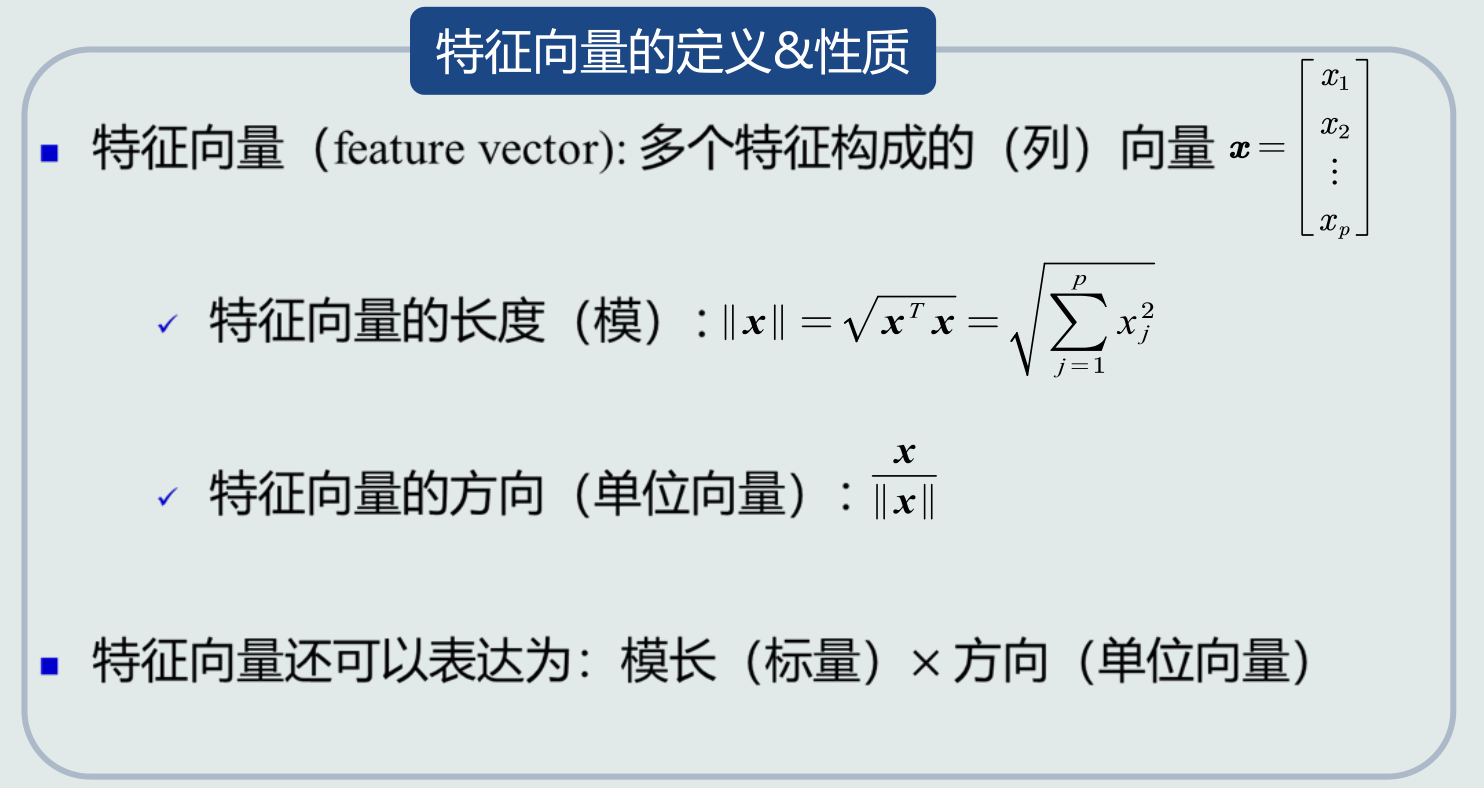

(2)特征向量:

(3)特征空间:

每个坐标轴代表一个维度的特征

空间中的每个点代表一个模式或者样本点

从坐标原点到任意一点(模式)之间的向量即为该模式的特征向量,这个点有各个维度的特征信息

1.3特征向量的相关性

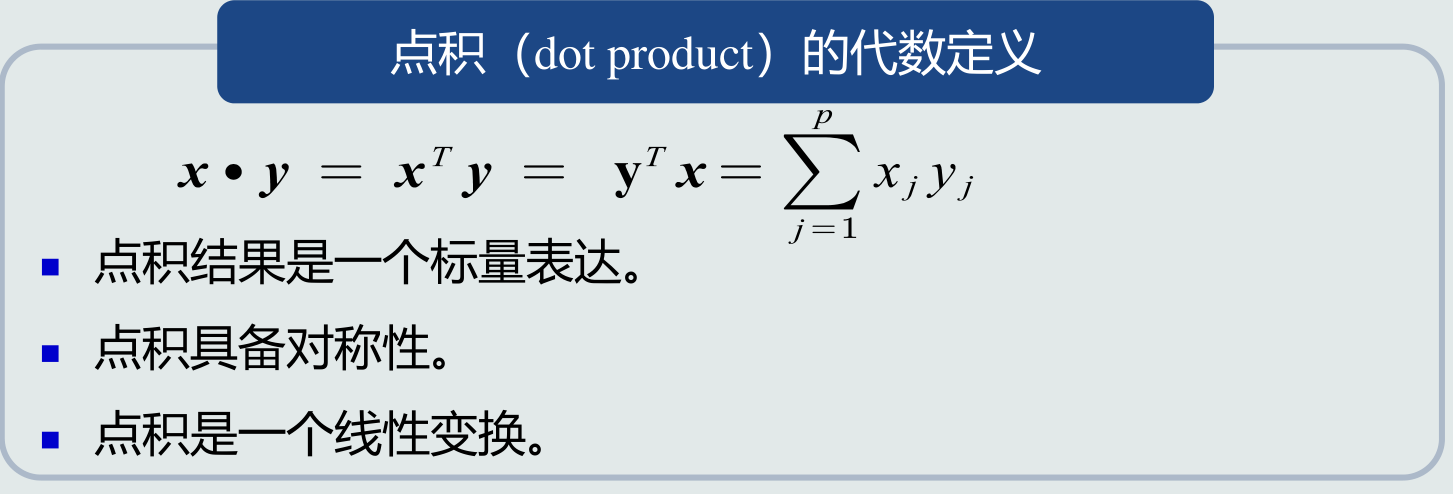

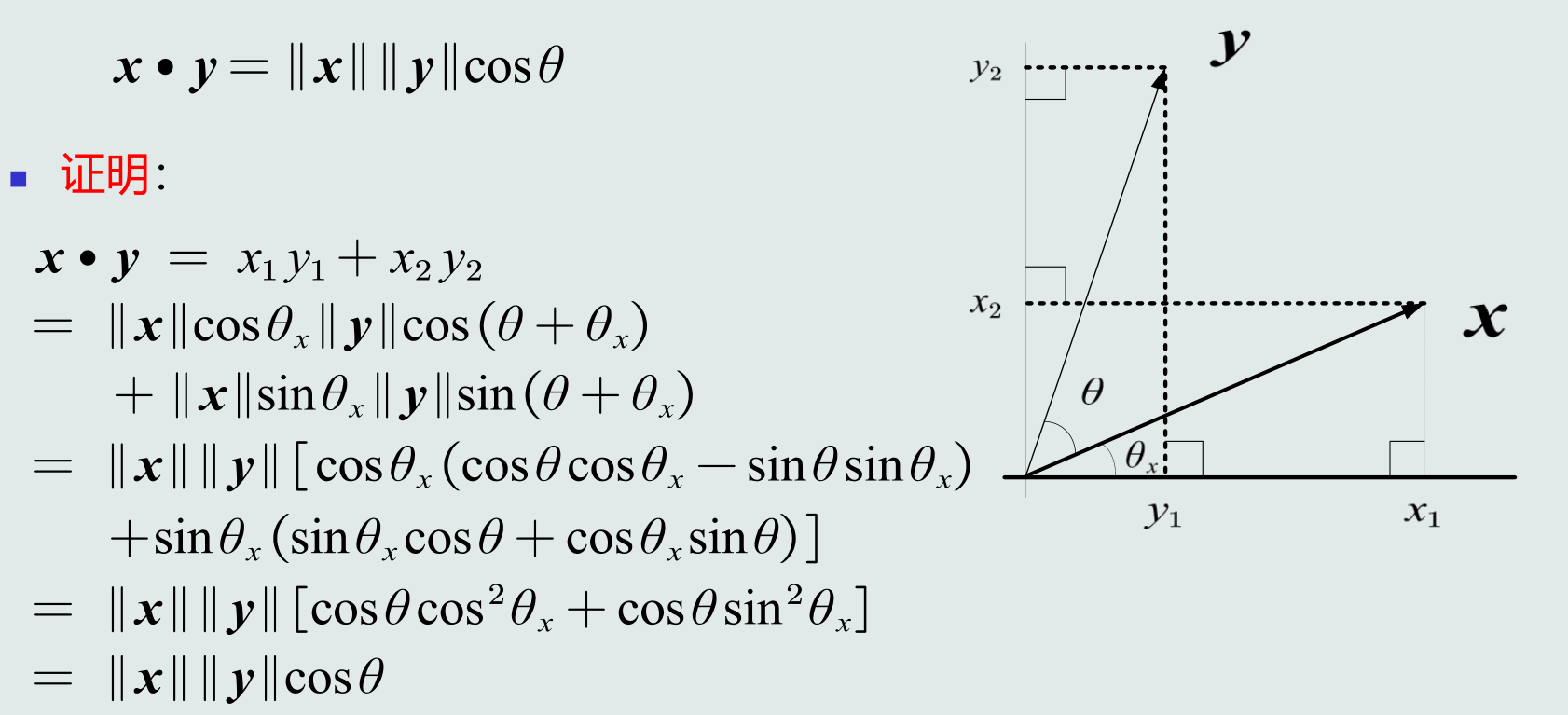

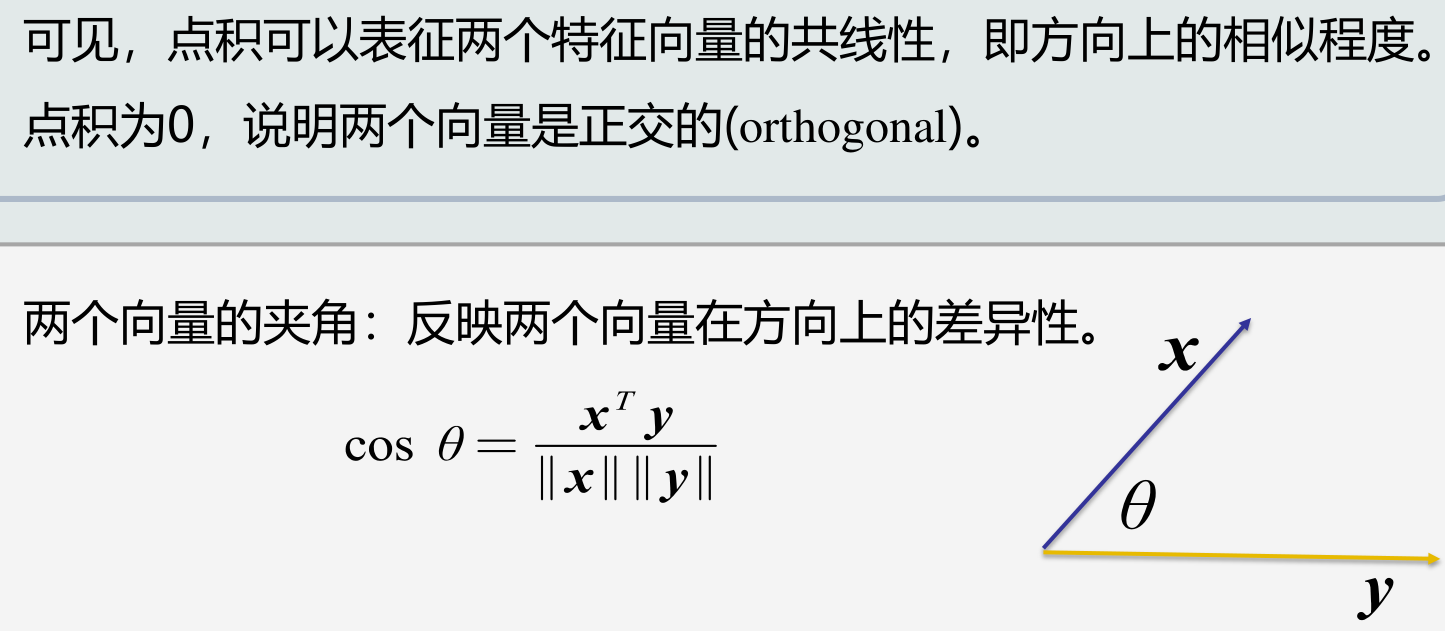

1.特征向量点积:

每个特征向量代表一个模式,故度量特征向量之间相关性是识别模式之间是否相似的基础。

代数定义:

几何定义:

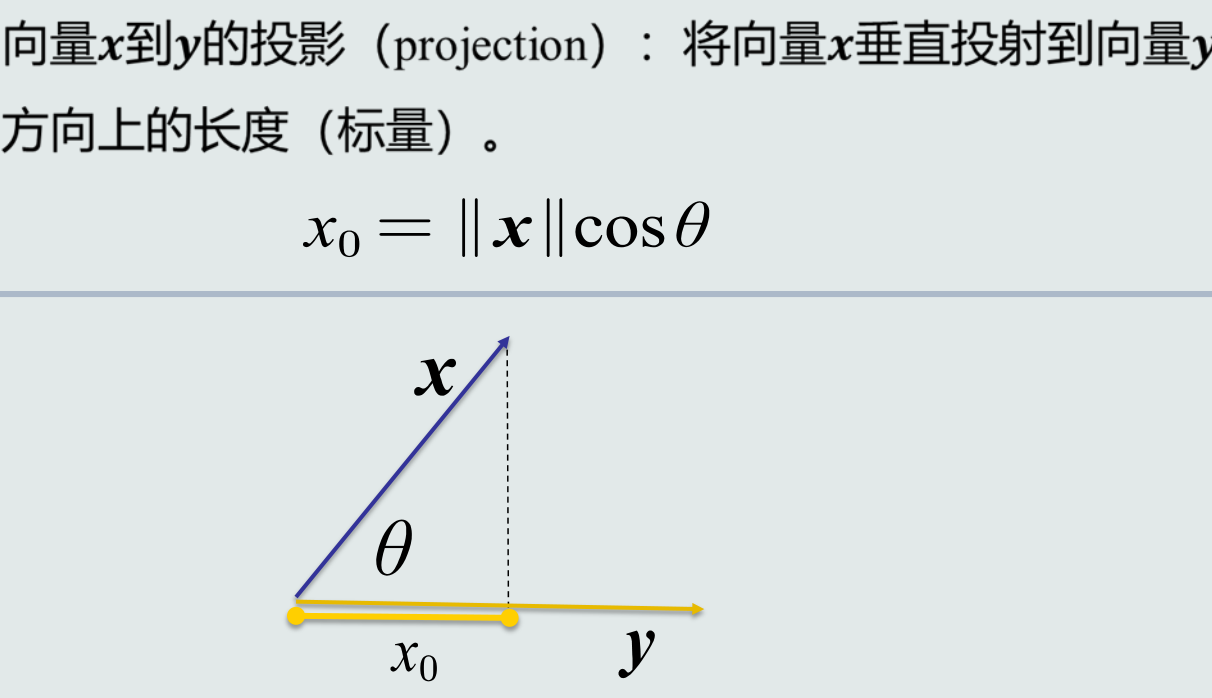

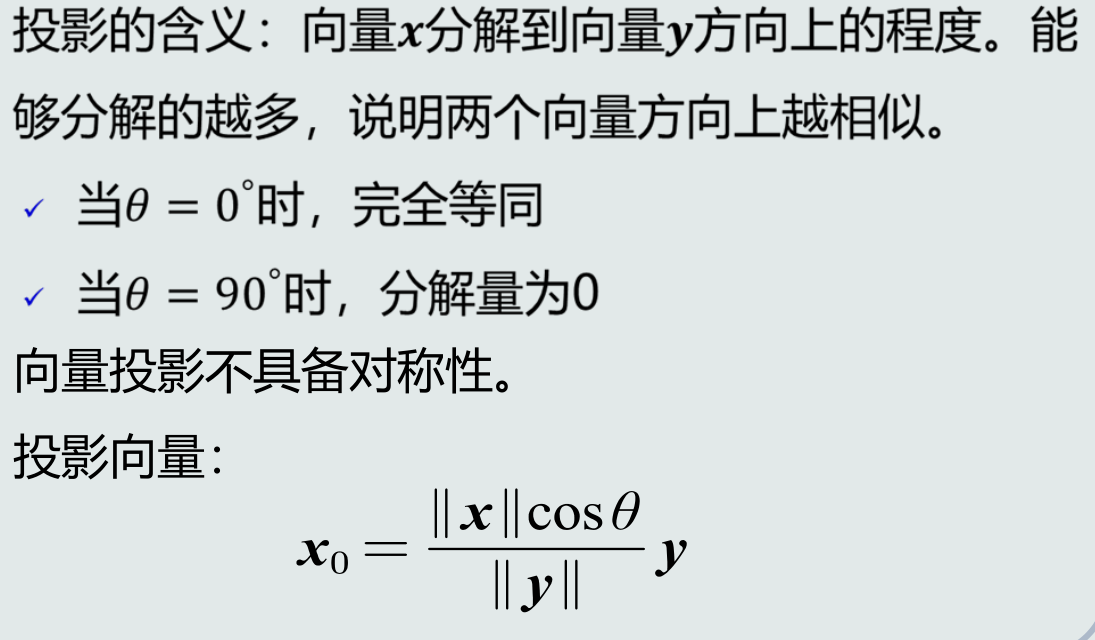

2.特征向量投影

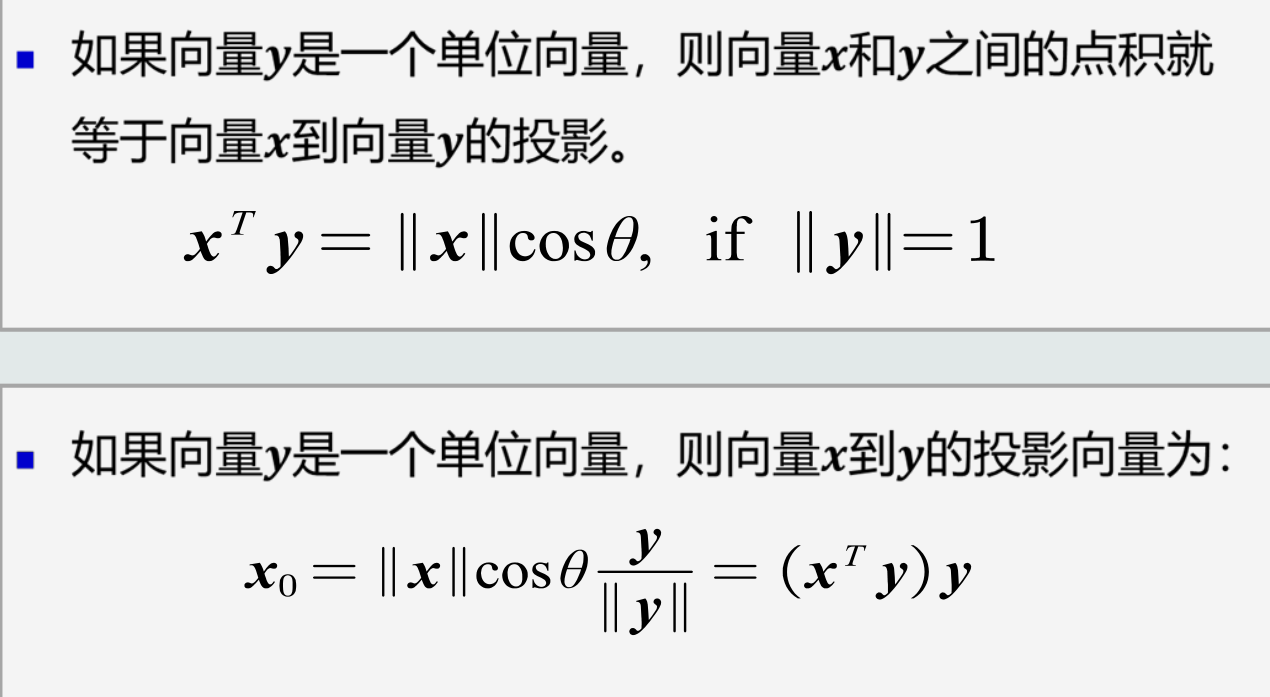

3.点积与投影:单位向量的情况

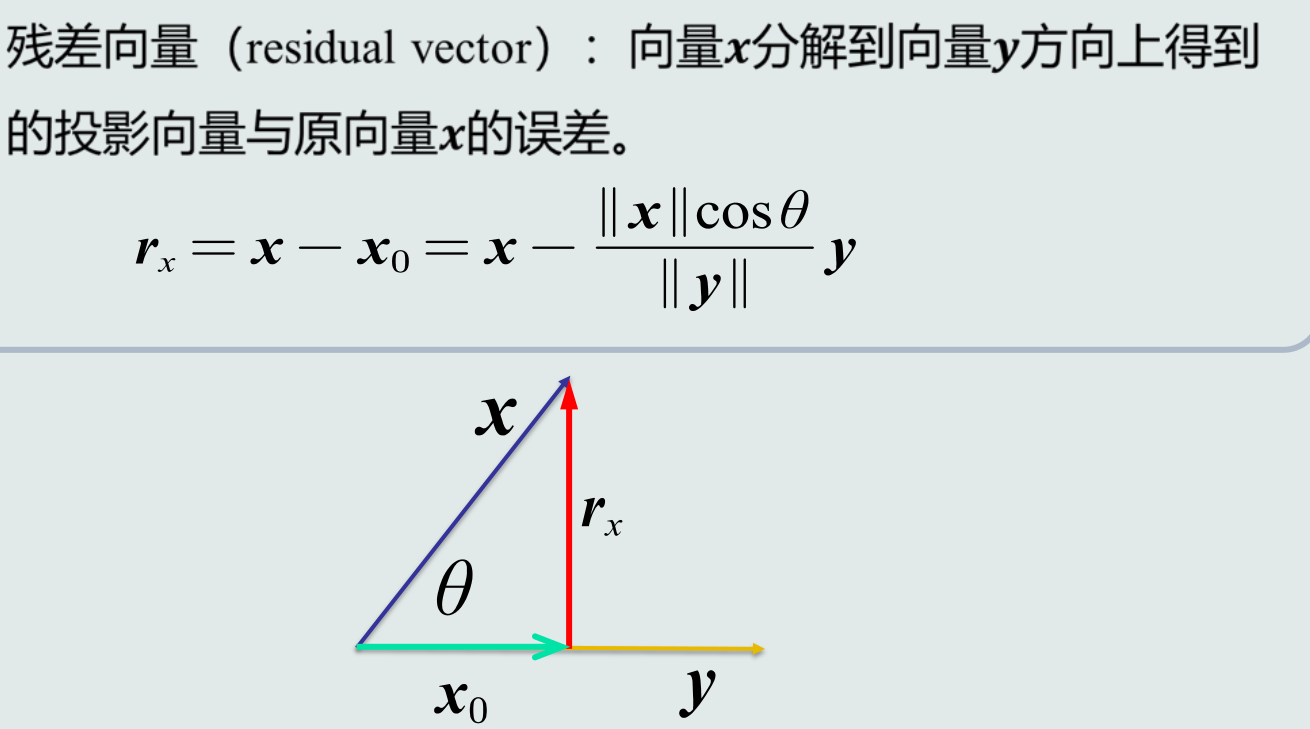

4.残差向量:

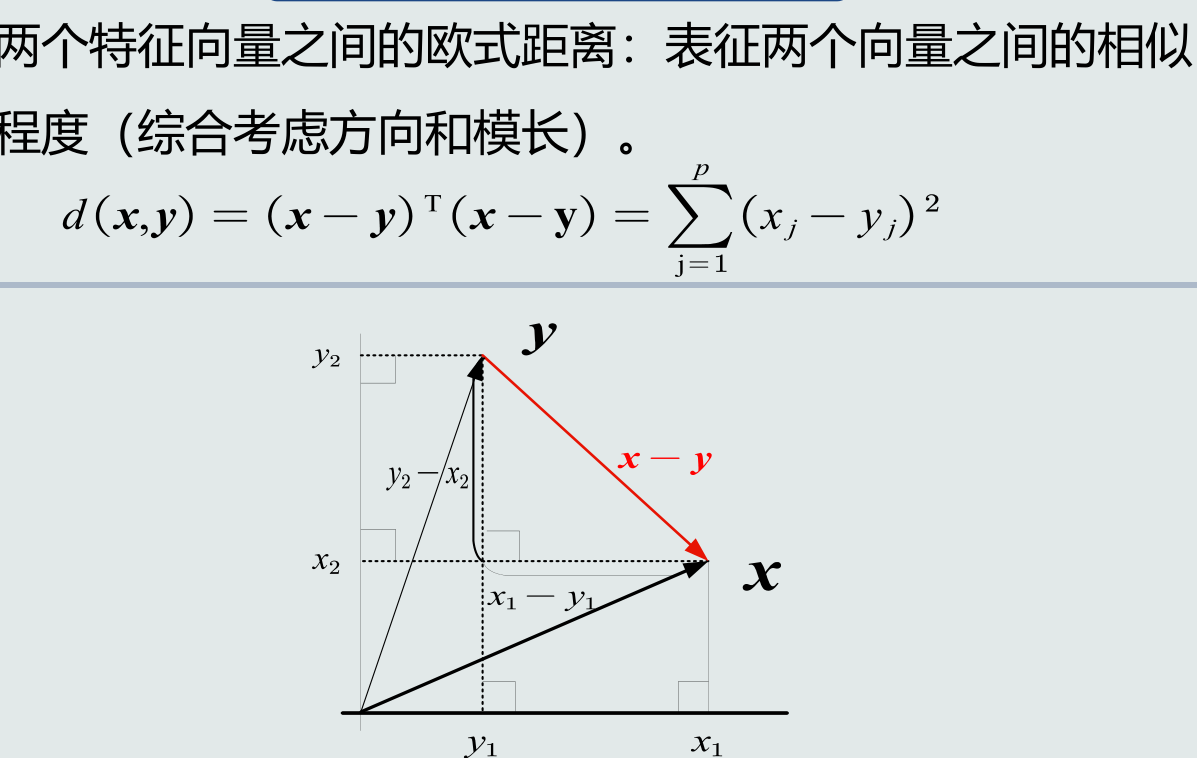

5.欧式距离:

1.4机器学习基本概念

1.模型如何得到:

使用机器学习->拿训练样本学->学模型的参数和结构

2.训练样本:

每个训练样本都是通过采样得到的一个模式,即输入特征空间中的一个向量,通常是高纬度,例如一幅图像。这组训练样本要尽量覆盖模型所有可能的分布空间

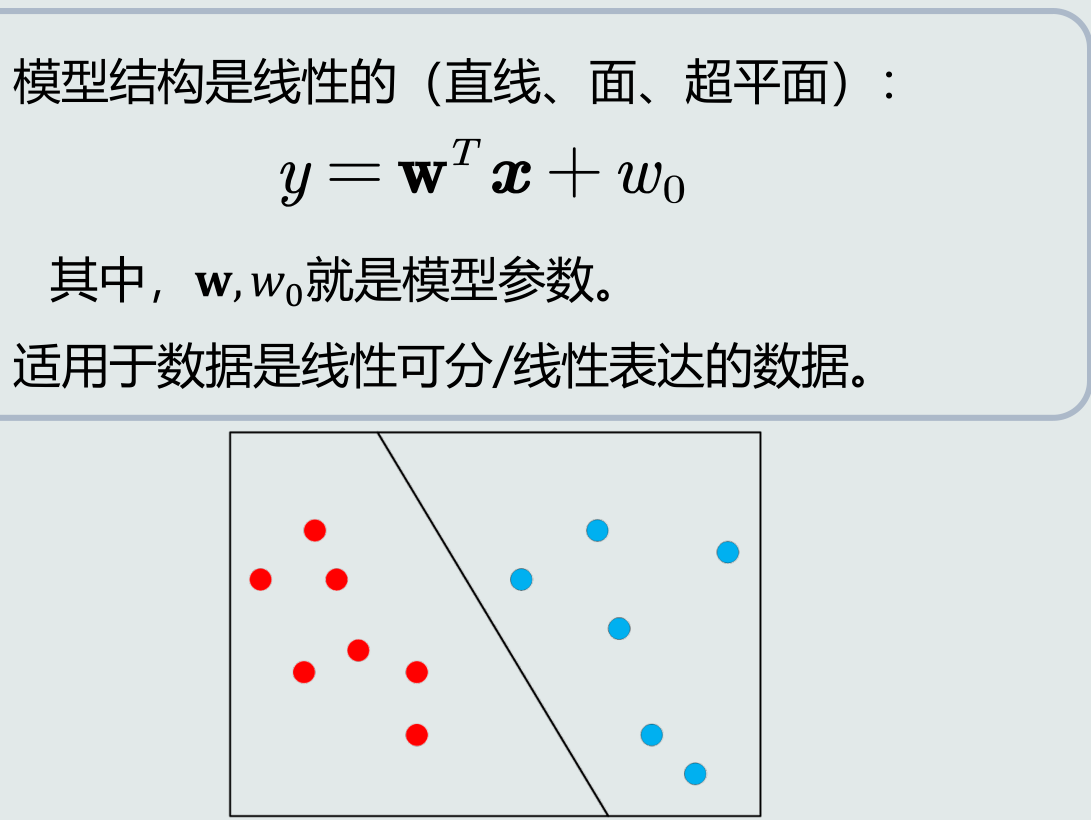

2.线性模型:

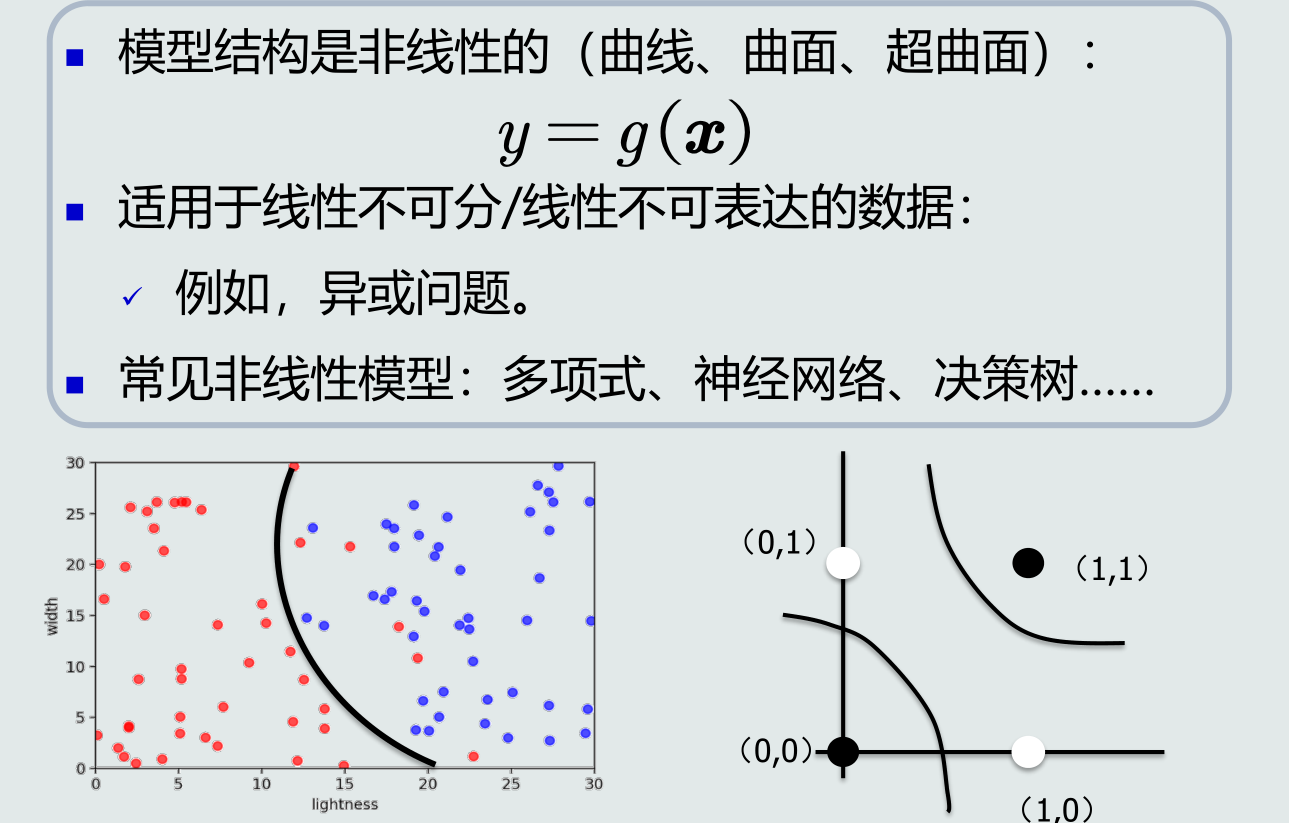

3.非线性模型:

4.参数的解的个数:

样本量vs模型参数量:训练样本格式为N,模型参数个数为M

①N = M:参数有唯一解

②N >> M:没有准确的解 添加一个标准(目标函数) L(θ|{xi})

③N << M:无数个解/无解 加入体现对于数解的约束条件,从中选出最优解

5.目标函数:

以待学习的模型参数作为自变量、以训练样本作为给定量

6.优化算法:

最小化或最大化目标函数的技术

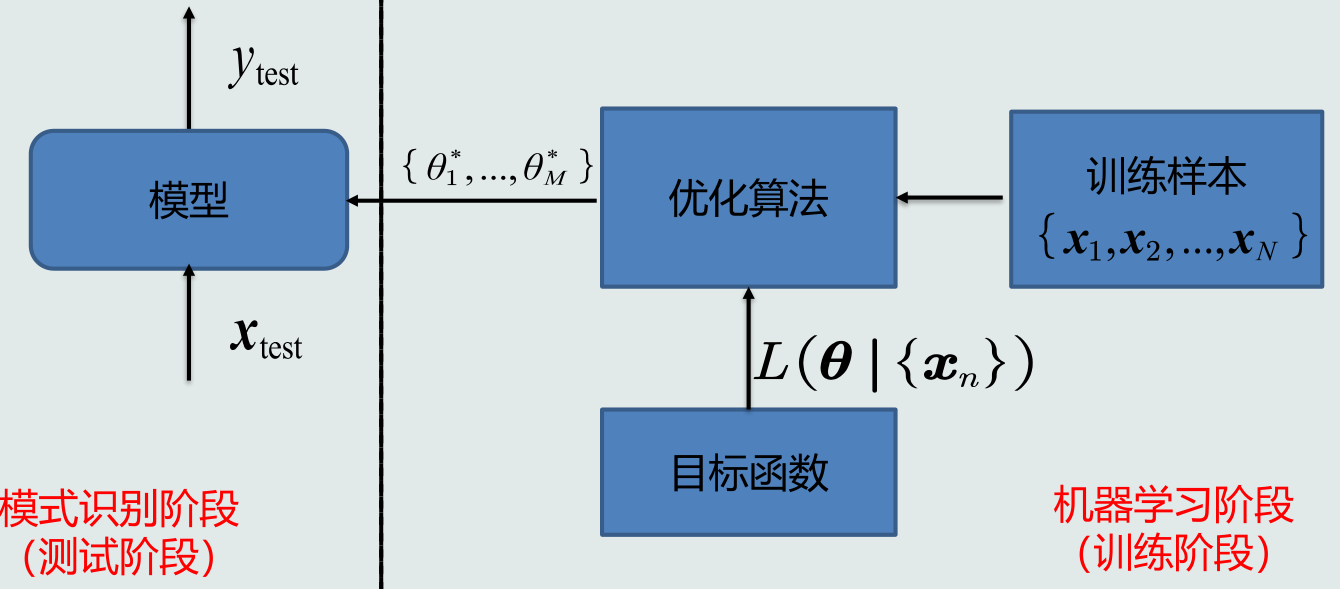

7.机器学习流程示意图

8.机器学习的方式

(1)监督式学习:

训练样本及其输出真值都给定情况下的机器学习算法

通常使用最小化训练误差作为目标函数进行优化

(2)无监督式学习:

只给定训练样本,没有给输出真值情况下的机器学习算法

典型应用:聚类、图像分割

(3)半监督式学习:

既有标注的训练样本、又有未标注的训练样本情况下的学习算法

(4)强化学习:

机器自行探索决策、真值滞后反馈的过程。

1.5模型的泛化能力

1.泛化能力:学习算法对新模式的决策能力

2.训练集:模型训练所用的样本数据

3.测试集:测试模型性能所用的样本数据,假设从样本iid采样得到的

测试集和训练集是互斥的,但假设是同分布的?

4.误差:模型(机器)给出的预测/决策输出与真值输出之间的差异,包括训练误差和测试误差

5.过拟合:模型训练阶段表现很好,但是在测试阶段表现很差

6.如何提高泛化能力:

不要过度训练

选择复杂度适合的模型:模型选择

正则化:在目标函数中加入正则项

7.调参:

如何选取合适的超参数:

需要依据泛化误差,但又不能基于测试集

从训练集中划分出一个验证集,基于验证集调整选择超参数

1.6评估方法与性能指标

1.如何量化地评估模型性能?

评估方法:留出法、K折交叉验证、留一验证

(1)留出法:

直接将数据集D划分为两个互斥的部分,其中一部分作为训练集,另一部分用作测试集

通常训练集和测试集的比例为70%:30%。

数据集的划分要注意尽可能保持数据分布的一致性,避免因数据划分过程引入的额外偏差而对最终结果产生影响。在分类任务中,保留类别比例的采样方法称为分层采样

同时要注意采用若干次随机划分避免单次使用留出法的不稳定性。

(2)K折交叉验证

交叉验证法先将数据集划分为K个大小相似的互斥子集,每次采用K−1个子集的并集作为训练集,剩下的那个子集作为测试集。进行K次训练和测试,最终返回K个测试结果的均值

(3)留一验证

留一法是K折交叉验证K=样本数时候的特殊情况。即每次只用一个样本作测试集,其它所有样本来训练,计算开销较大

2.如何通过评估选择确定超参数:

按照上述三类评估方法的思路,数据集->训练集,测试集->验证集

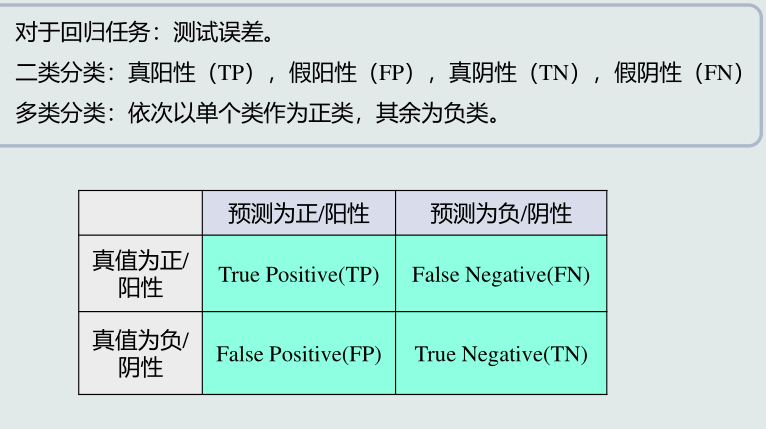

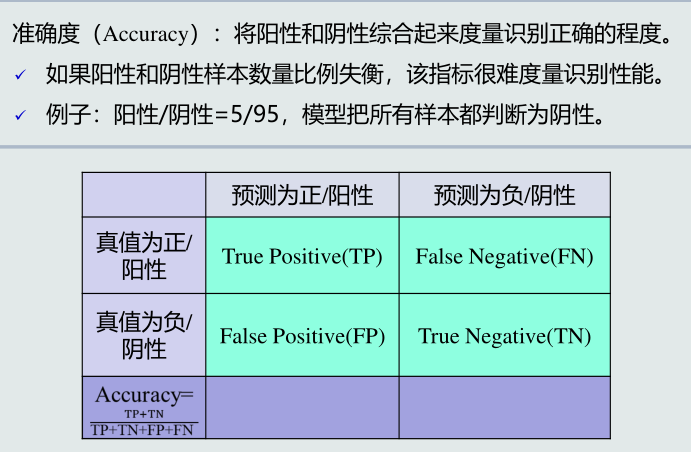

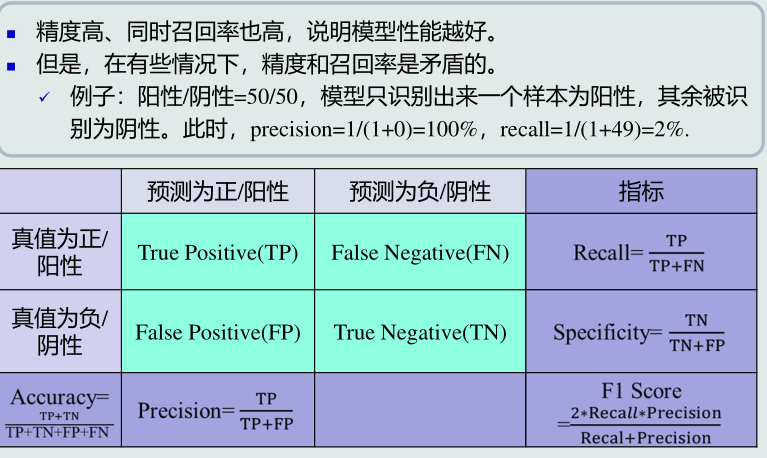

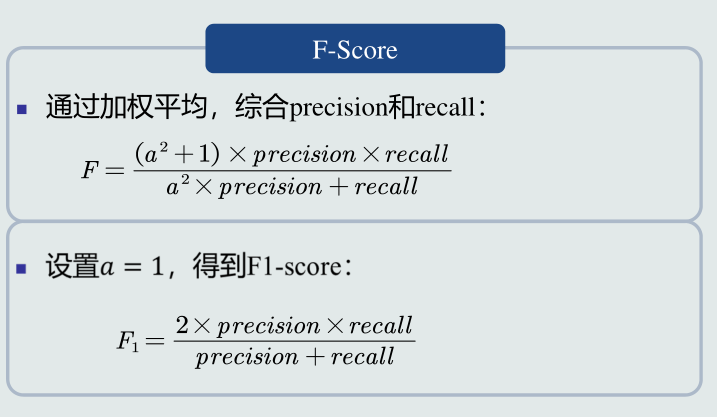

3.性能指标度量

F-Score:

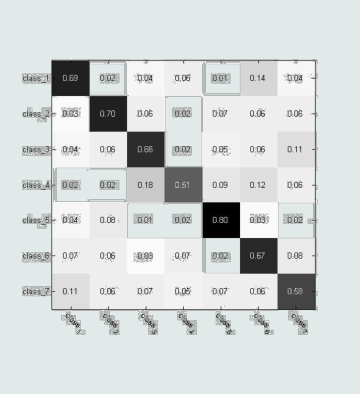

混淆矩阵:

行为真值,列为预测值,元素为计数统计值

对角线的值越大,表示模型性能越好

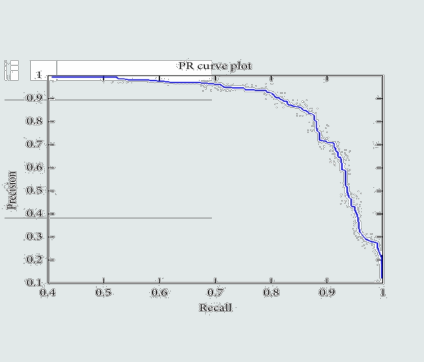

PR曲线

横轴为召回率,纵轴为精度

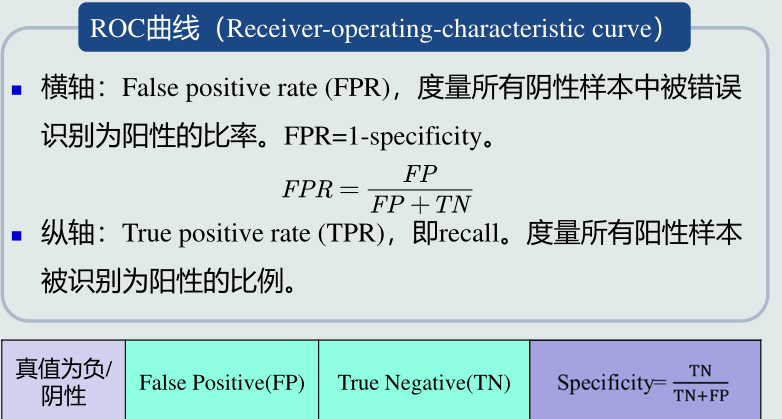

ROC曲线

横轴为假阳性比例(FPR),纵轴为召回率

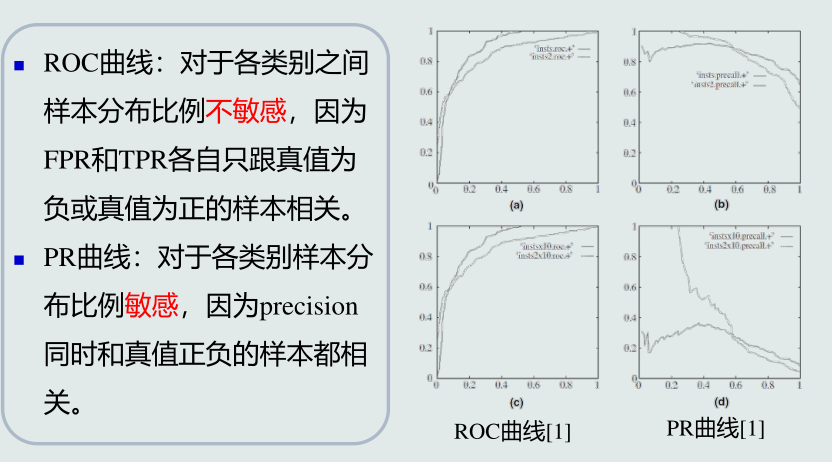

PR曲线与ROC曲线对比:

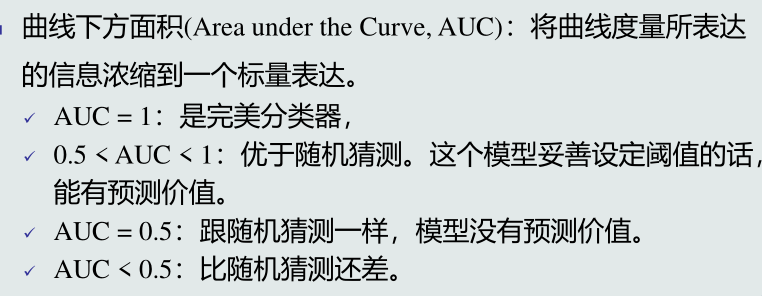

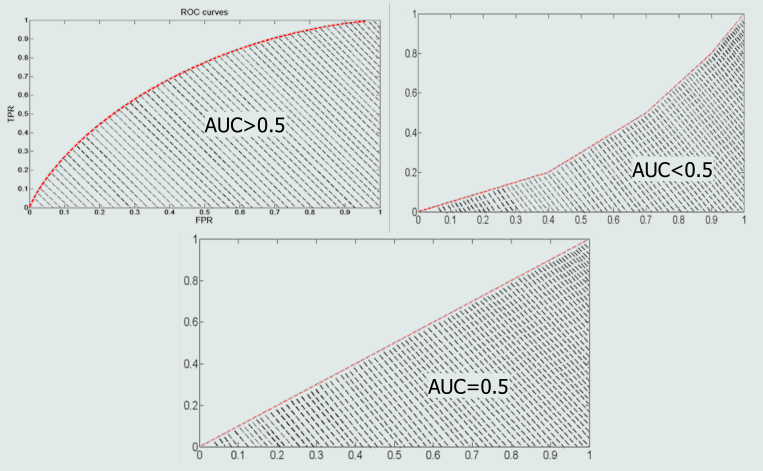

AUC

第二章 基于距离的分类器

2.1基于距离的分类器:MED分类器

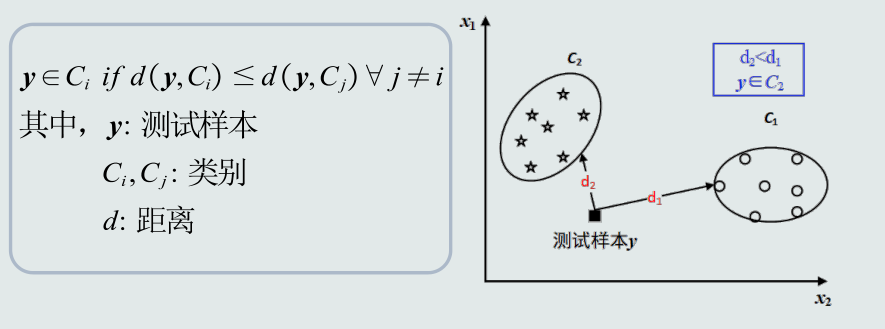

1.基于距离分类的基本概念

(1)基本概念:基于距离的决策

把测试样本到每个类之间的距离作为决策模型,将测试样本判定为与其距离最近的类

(2)判别公式

(3)基本问题

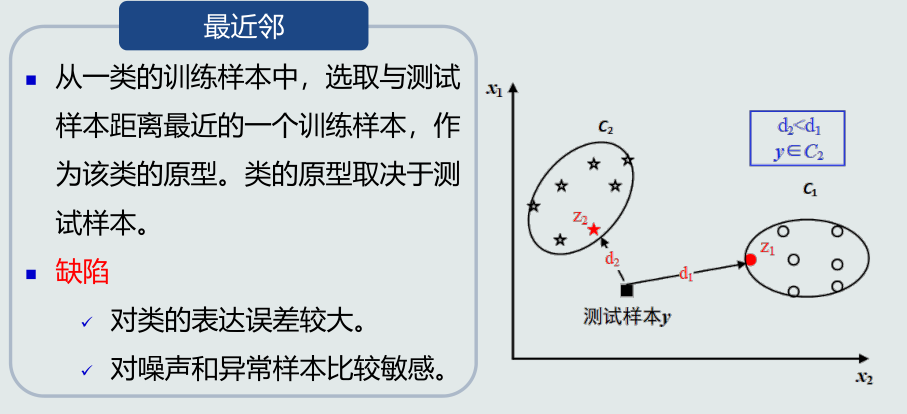

类的原型问题:如何计算单个向量到多个向量的距离

距离度量问题:计算测试样本到类的何种距离

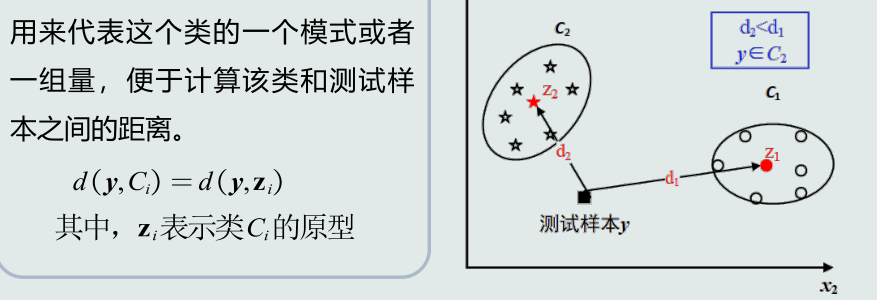

(4)类的原型:

用来代表这个类的一个模式或者一组量,便于计算该类和测试样本之间的距离

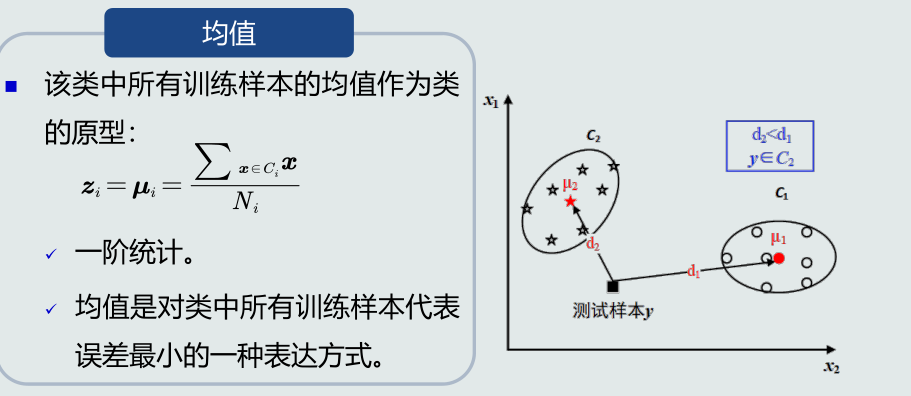

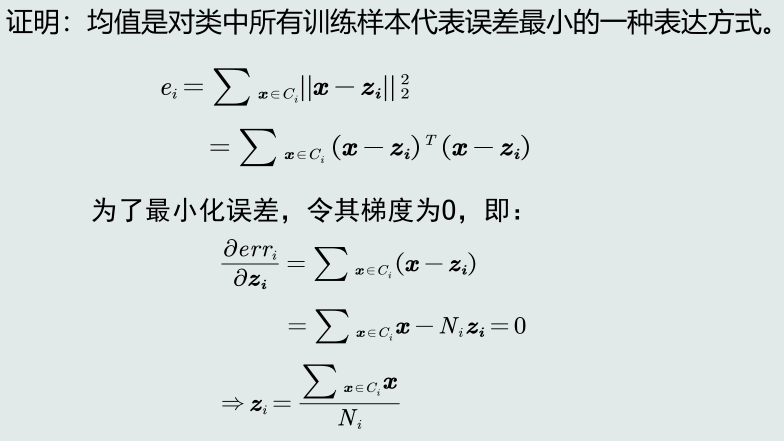

(5)原型的种类:均值、最近邻

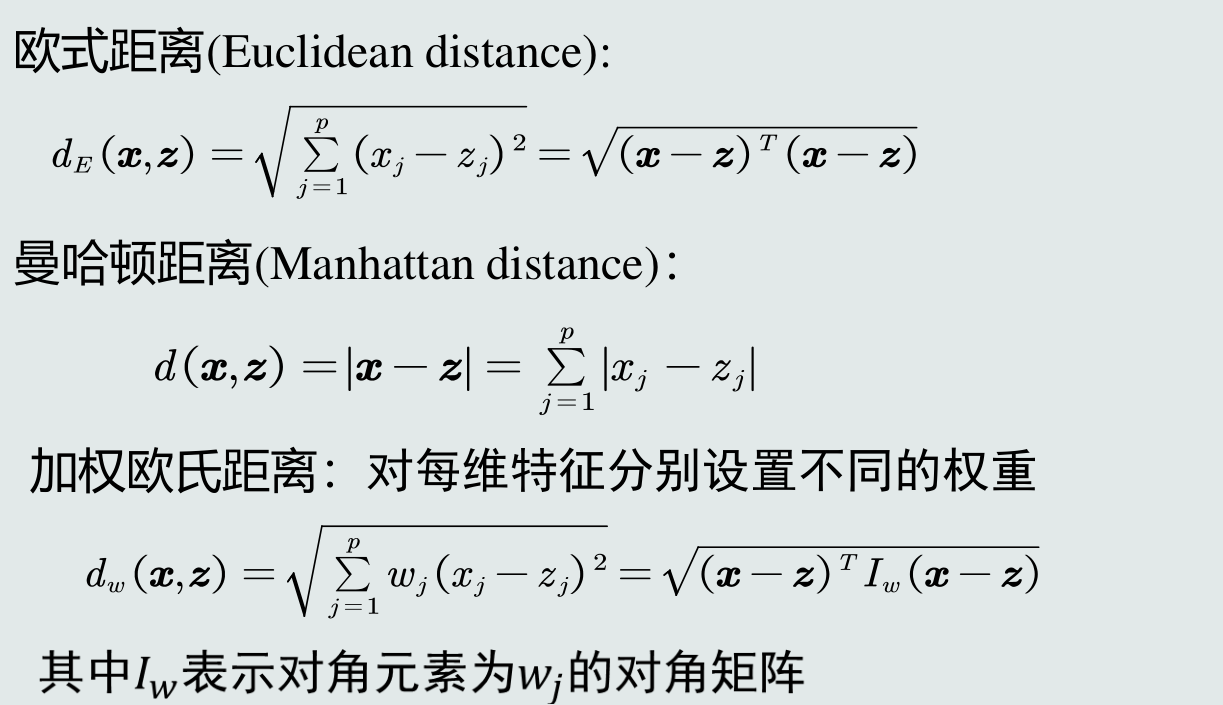

(6)距离度量

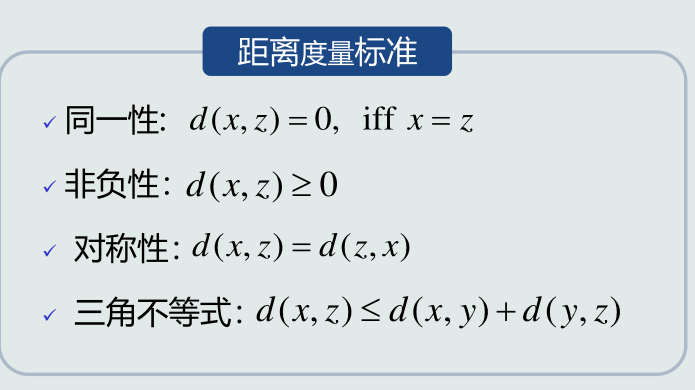

距离度量标准:同一性、非负性、对称性、三角不等式

常见的几种距离度量:

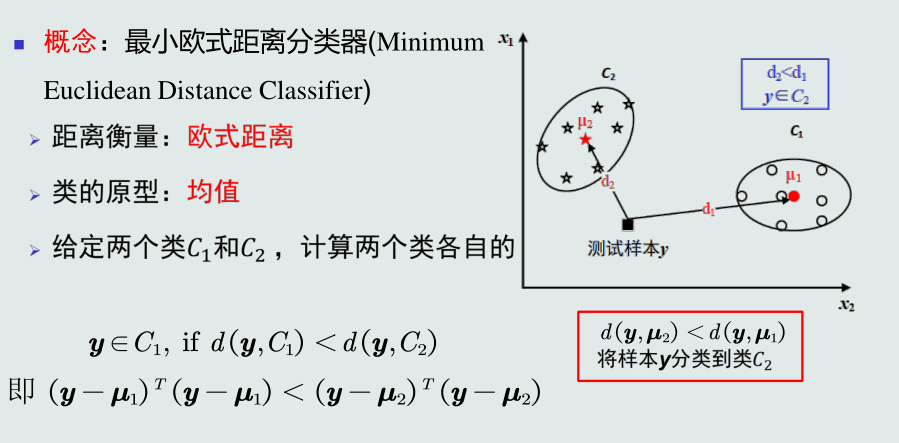

2.MED分类器

最小欧氏距离分类器

距离衡量:欧氏距离

类的原型:均值

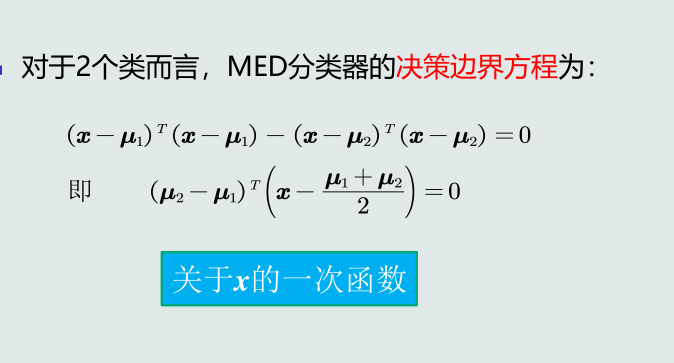

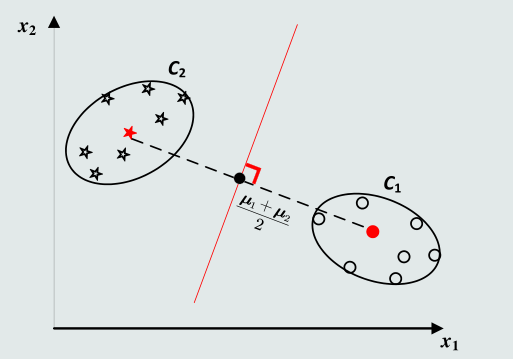

决策边界:在高维空间中,该决策边界是一个超平面,且该平面垂直且二分连接两个类原型的线

3.MED分类器的问题:MED分类器采用欧氏距离作为距离度量,没有考虑特征变化的不同及特征之间的相关性

解决方法:去除特征变化的不同及特征之间的相关性

2.2特征白化

如何去除特征相关性?使用特征白化!

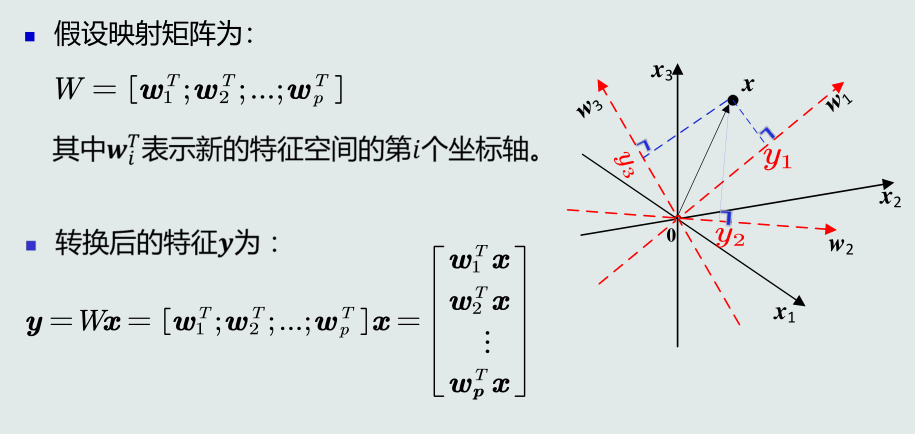

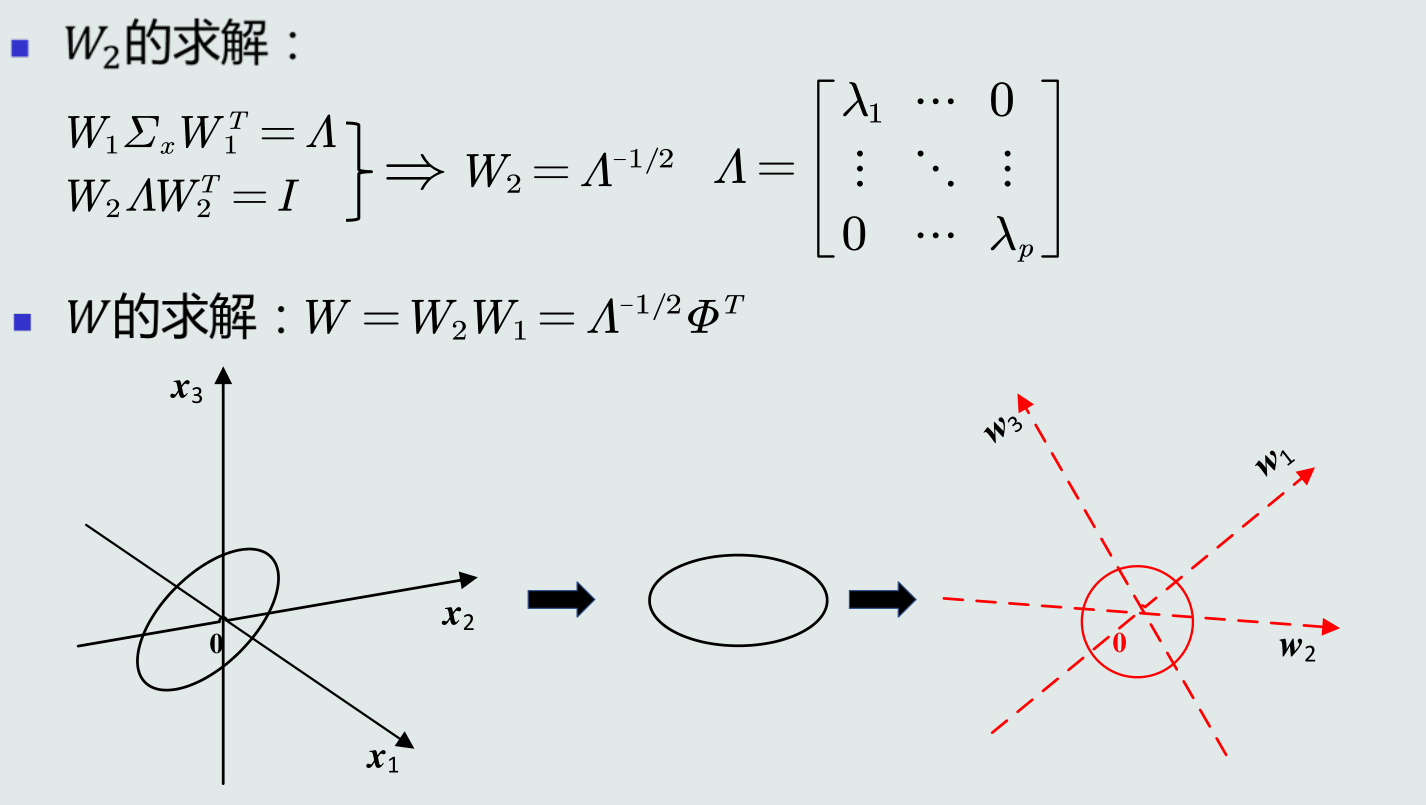

1.特征正交白化

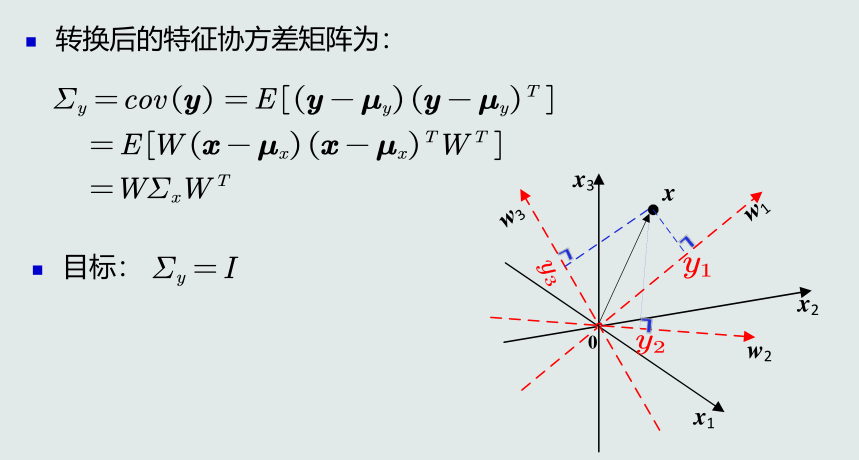

将原始特征映射到一个新的特征空间,使得在新空间中特征的协方差矩阵为单位矩阵,从而去除特征变化的不同及特征之间的相关性

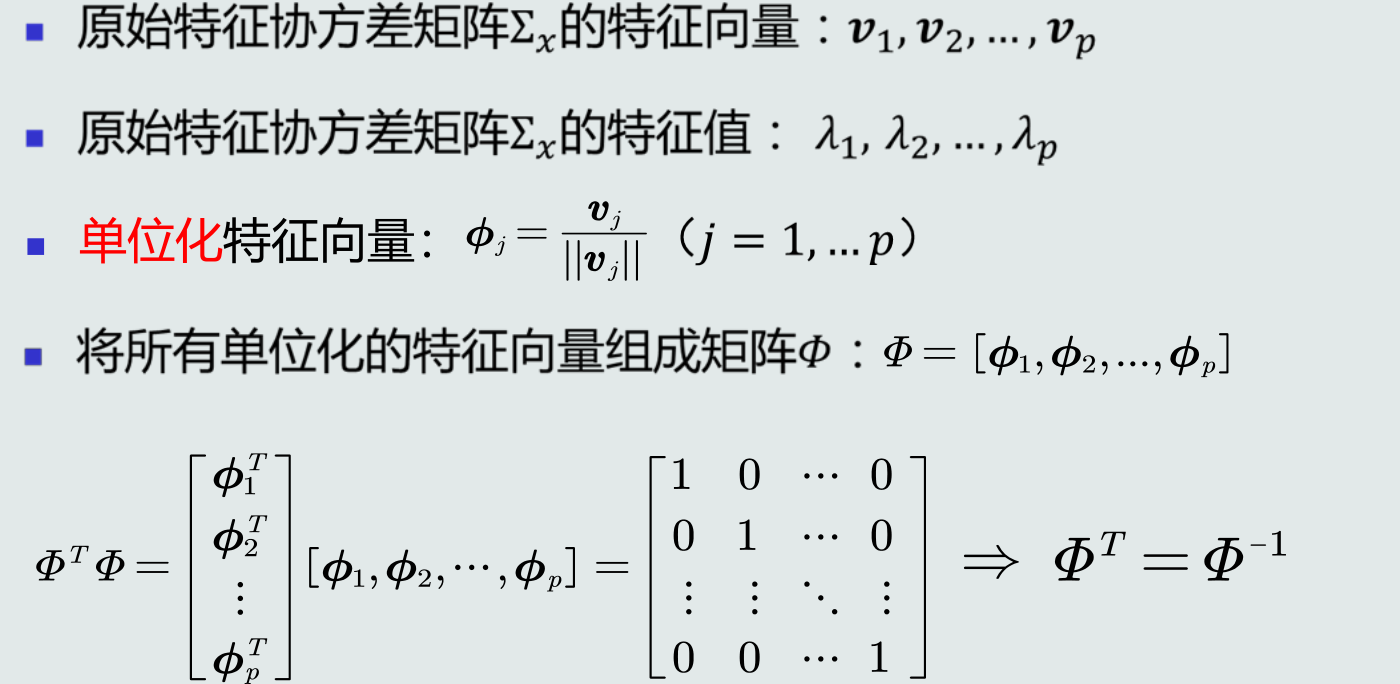

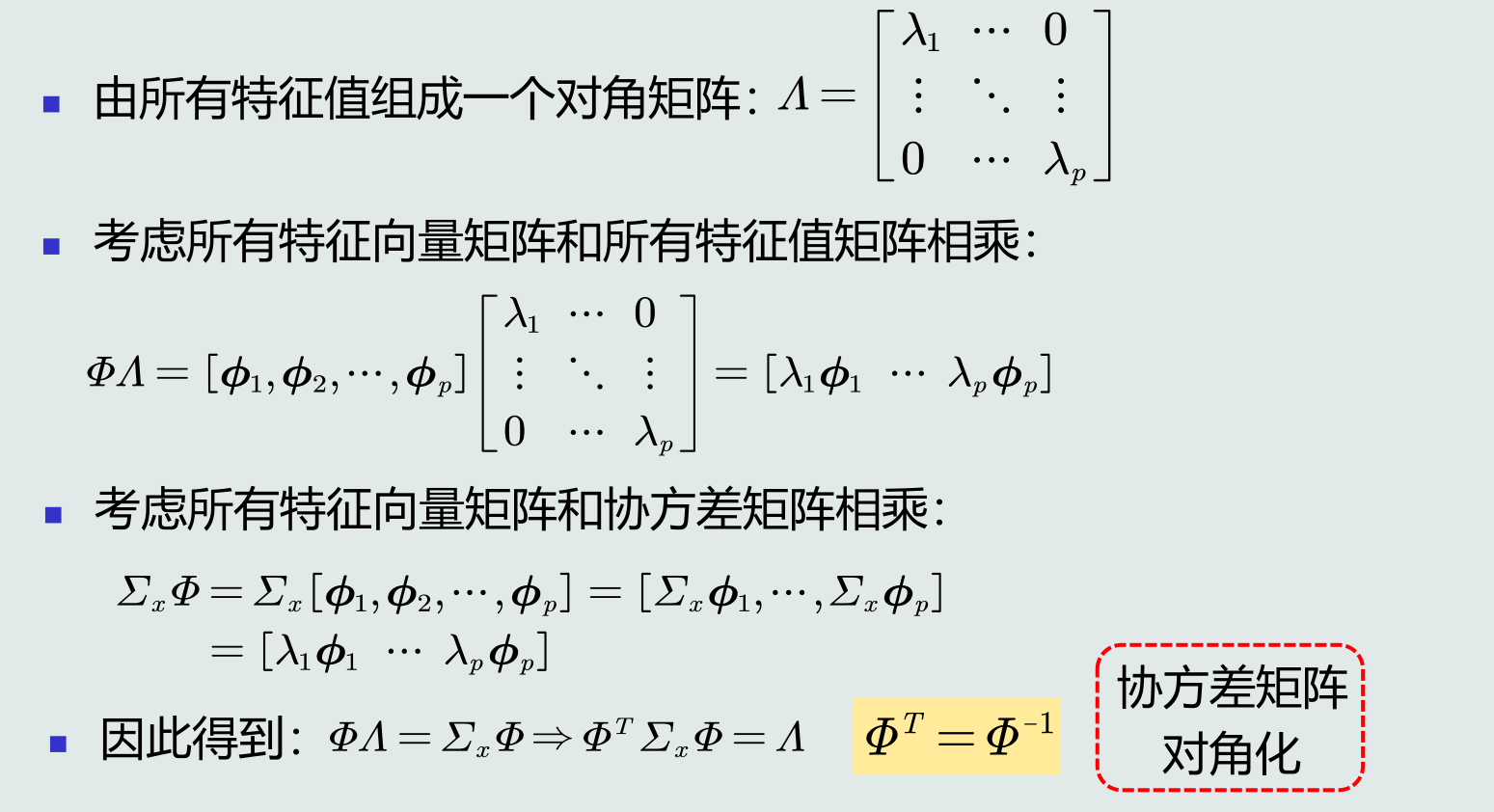

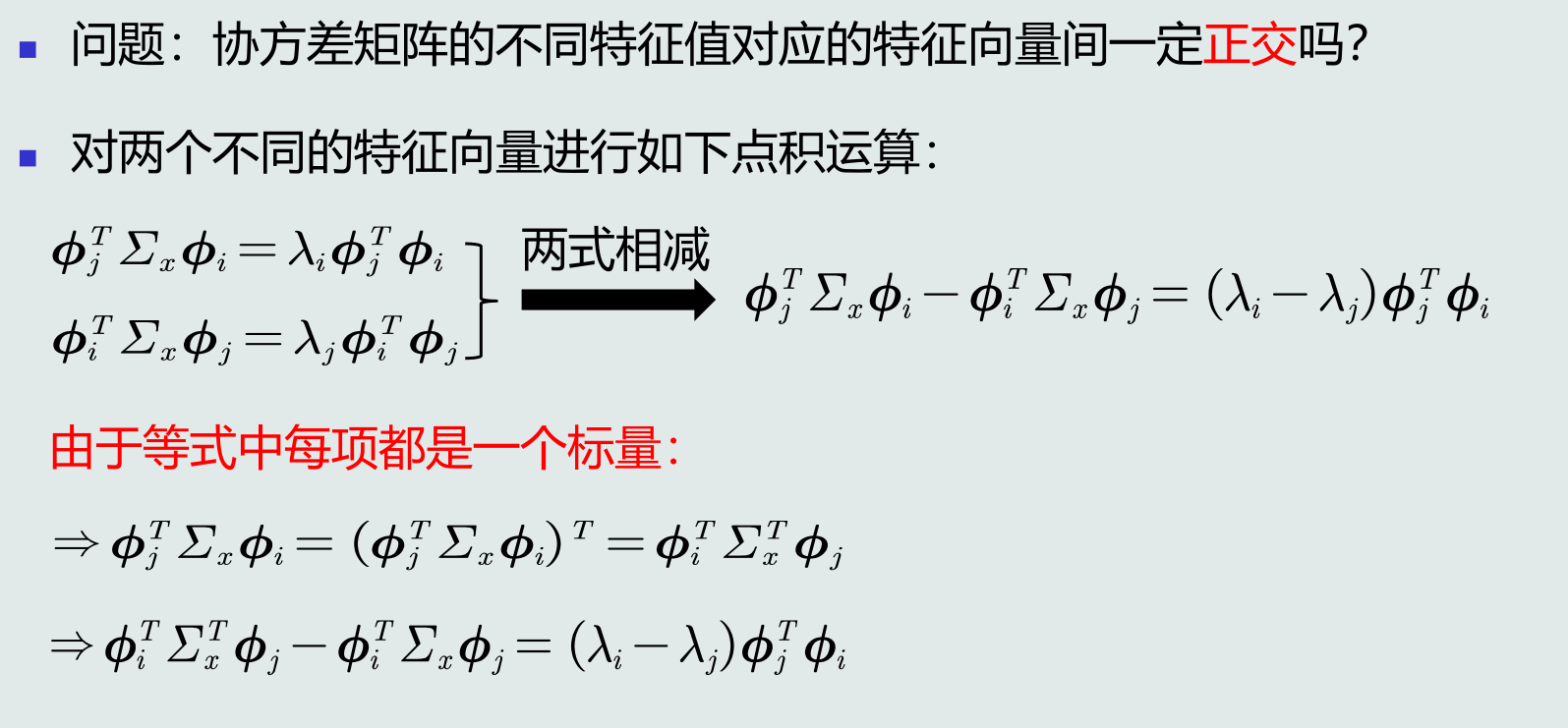

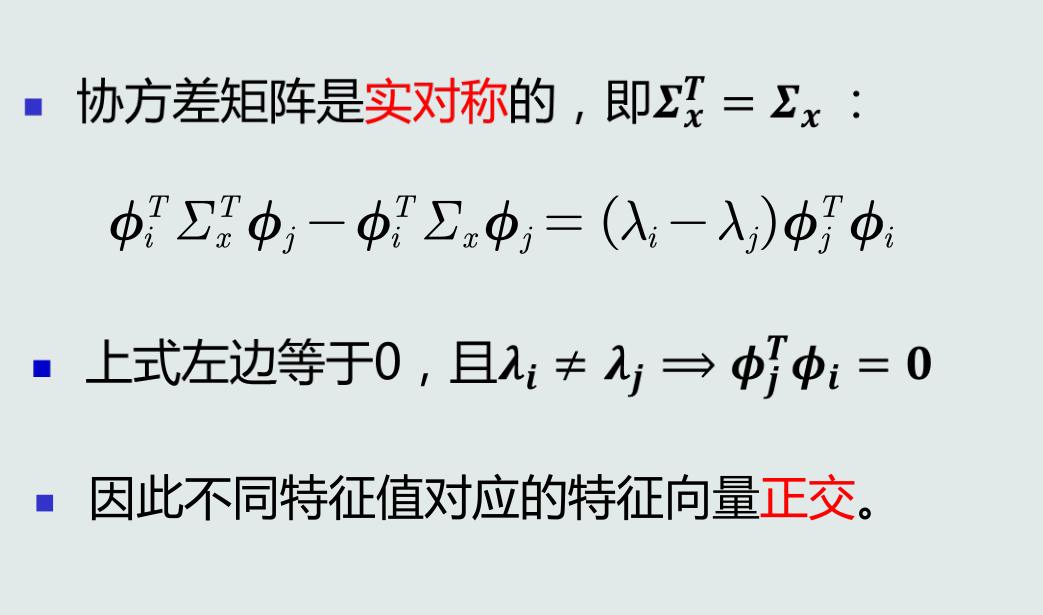

2.特征解耦任务:协方差矩阵的对角化

3.特征解耦:先去除特征之间的相关性

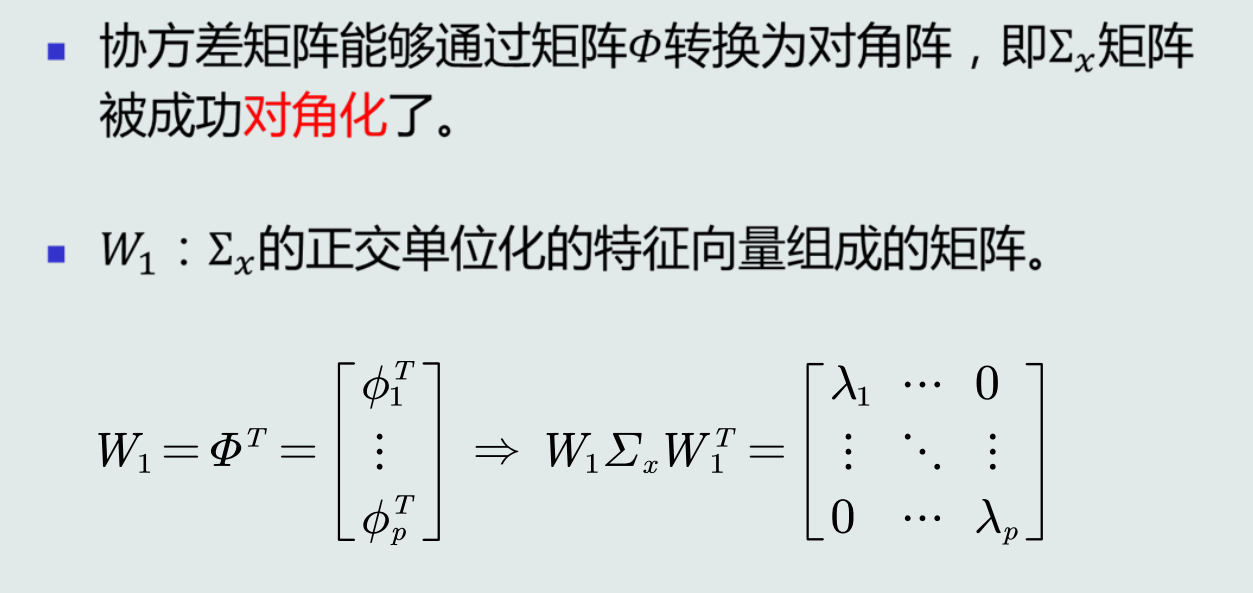

4.特征白化:在解耦的基础上再对特征进行尺度变化

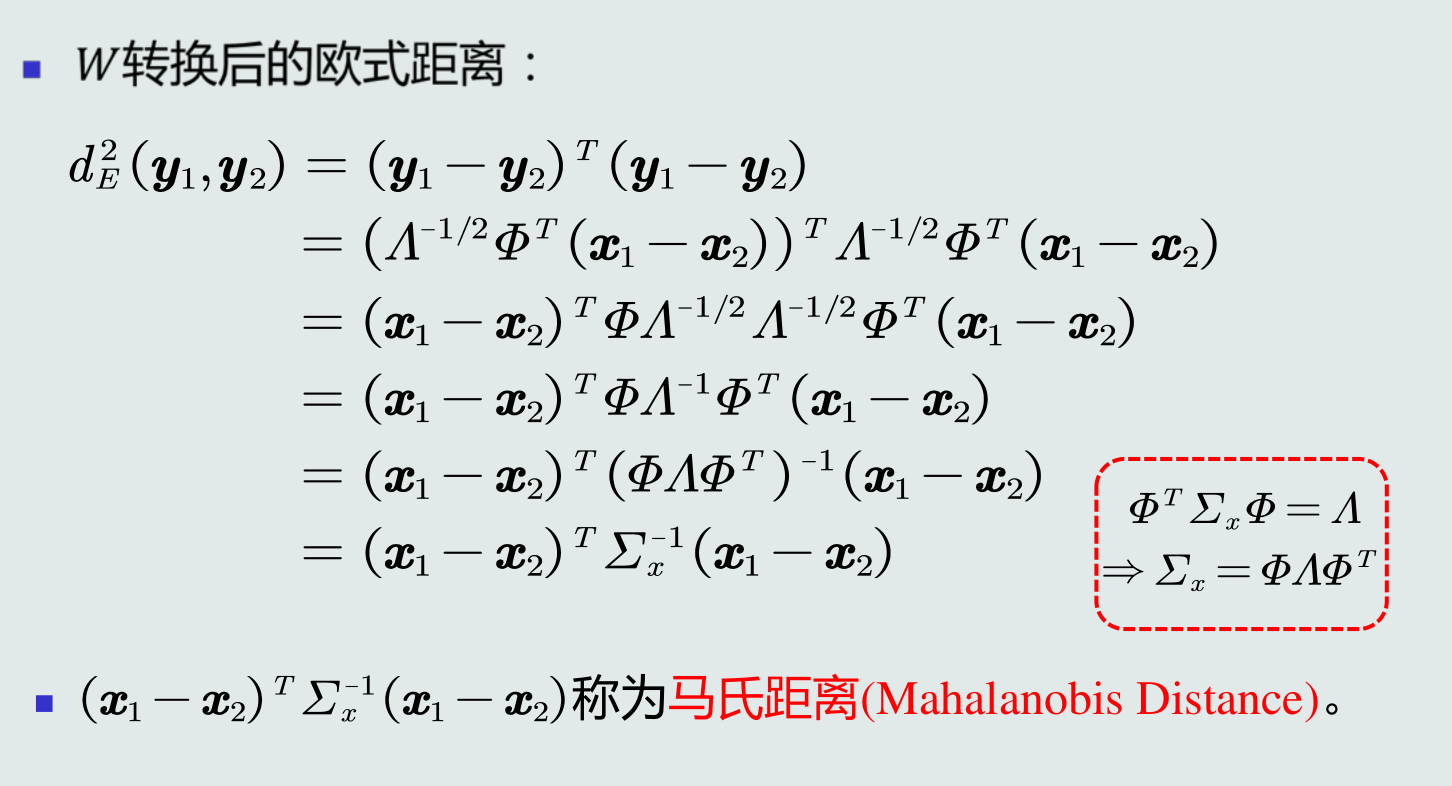

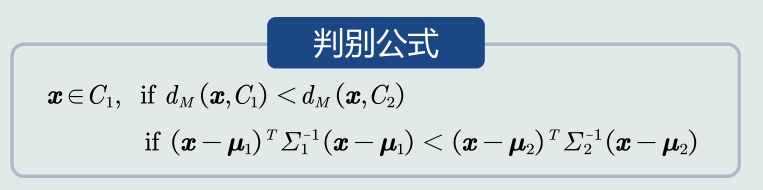

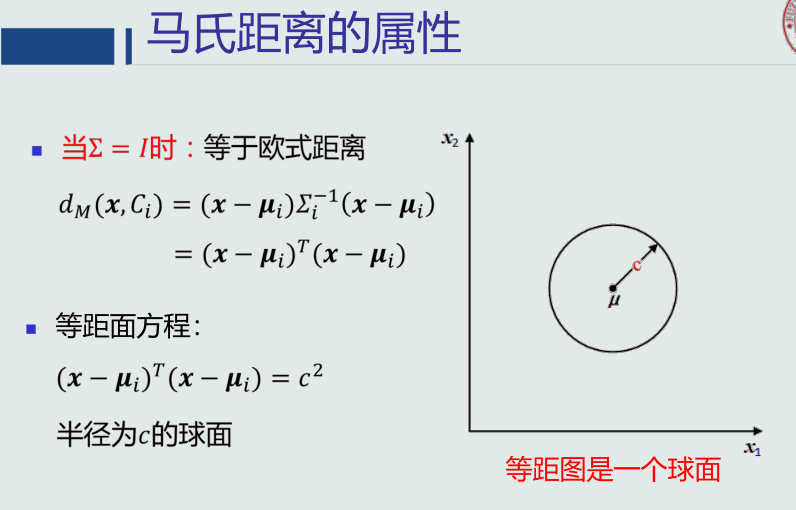

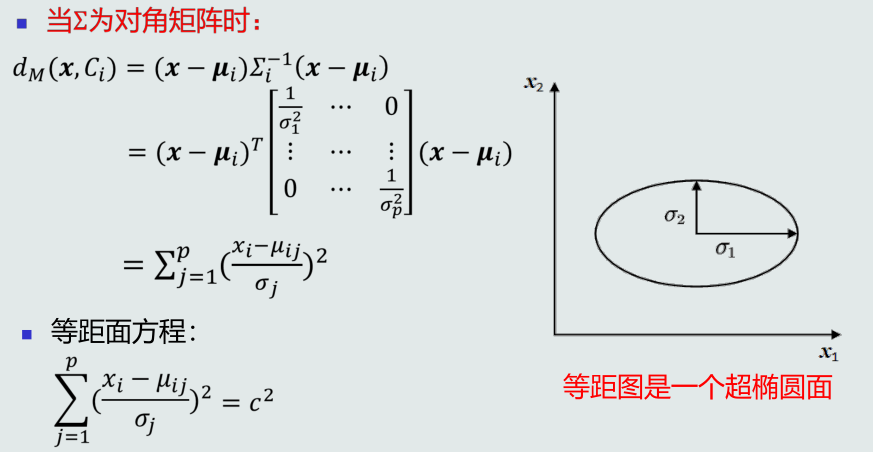

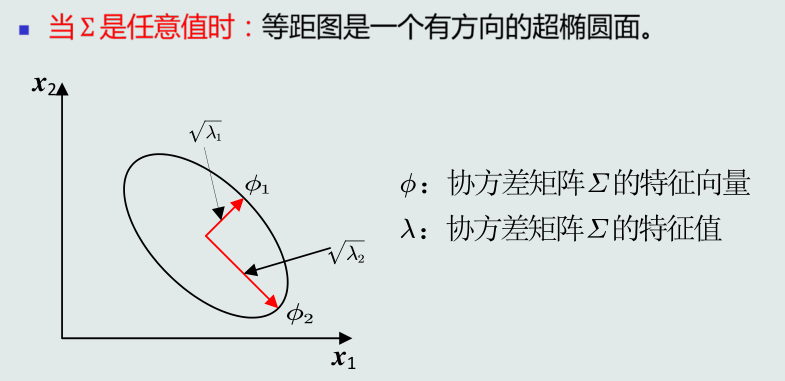

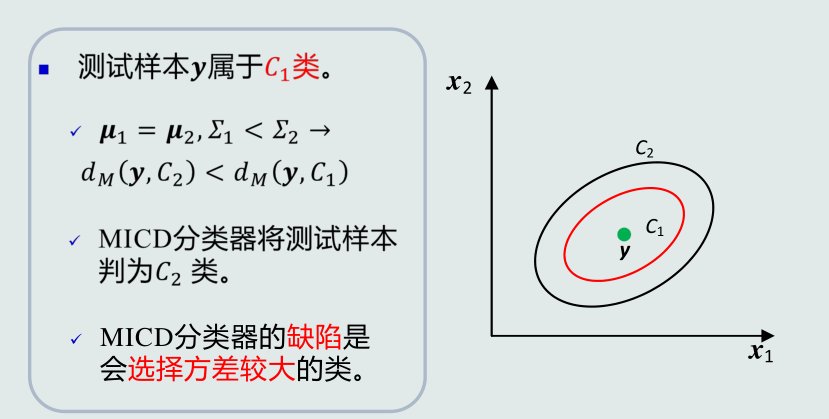

- 2.3基于距离的分类器:MICD分类器

最小类内距离分类器

距离度量:马氏距离

类的原型:均值

MICD分类器的决策边界:对于二类分类而言,MICD分类器的决策边界位于到两个类的距离相等的面上

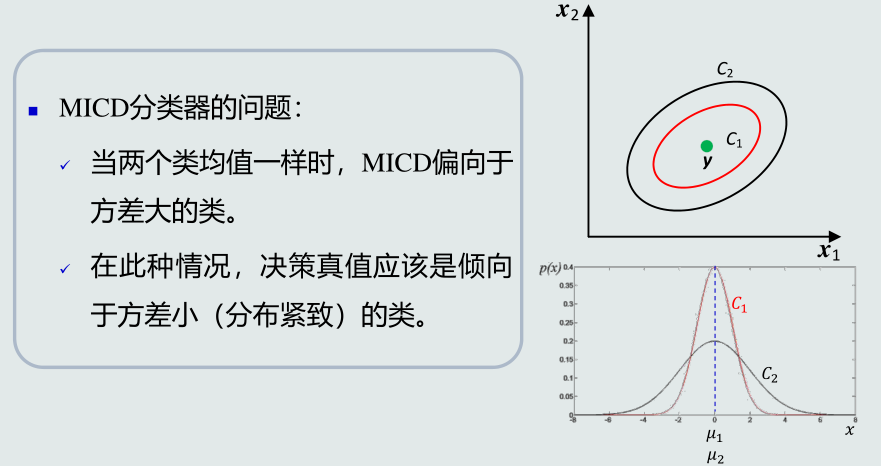

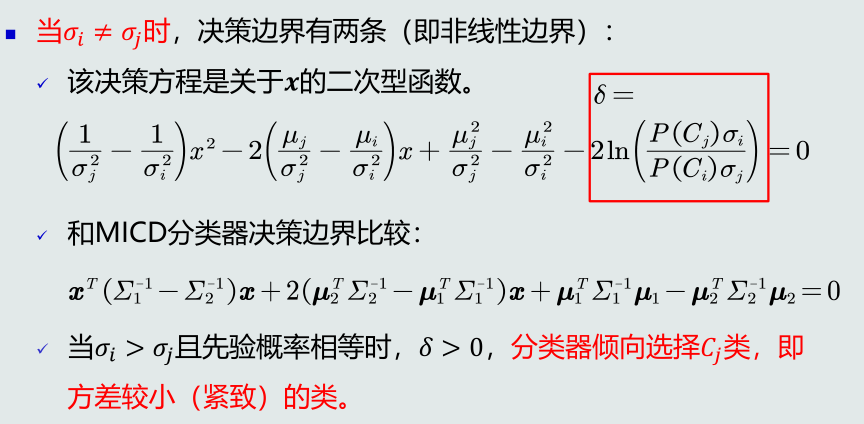

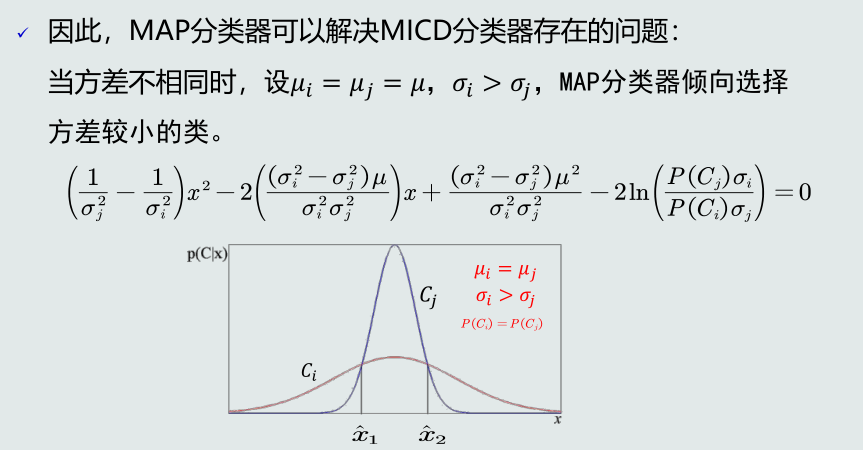

问题:MICD分类器的缺陷是会选择方差较大的类

第三章 贝叶斯决策与学习

3.1贝叶斯决策与MAP分类器

1.存在的问题:

基于距离的决策:

仅考虑每个类别各自观测到的训练样本的分布情况

没有考虑类的分布等先验知识,例如,类别之间样本数量的比例,类别之间的相互关系

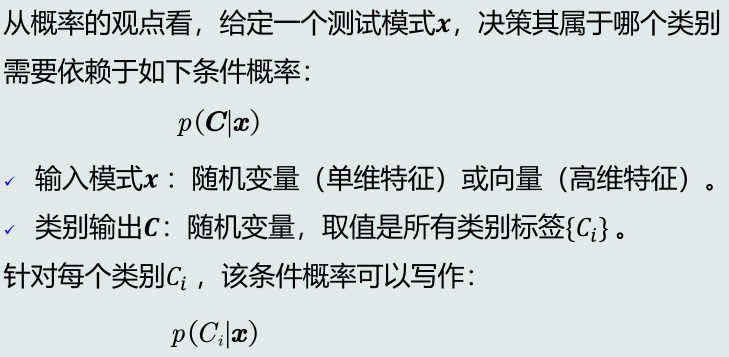

2.后验概率:用于分类决策

如何得到后验概率?见3

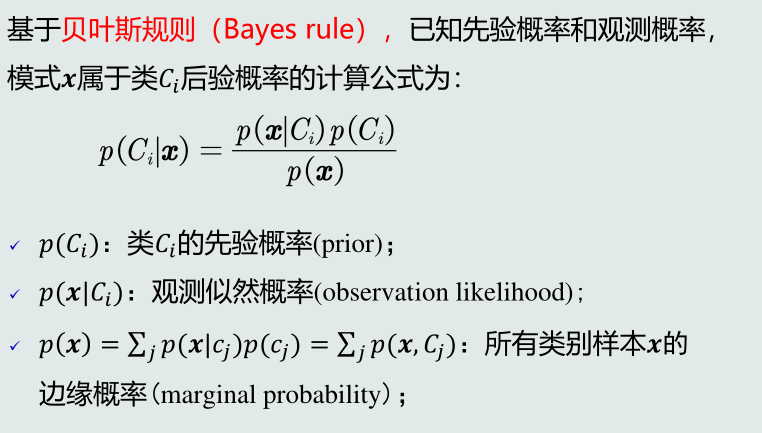

3.贝叶斯规则:

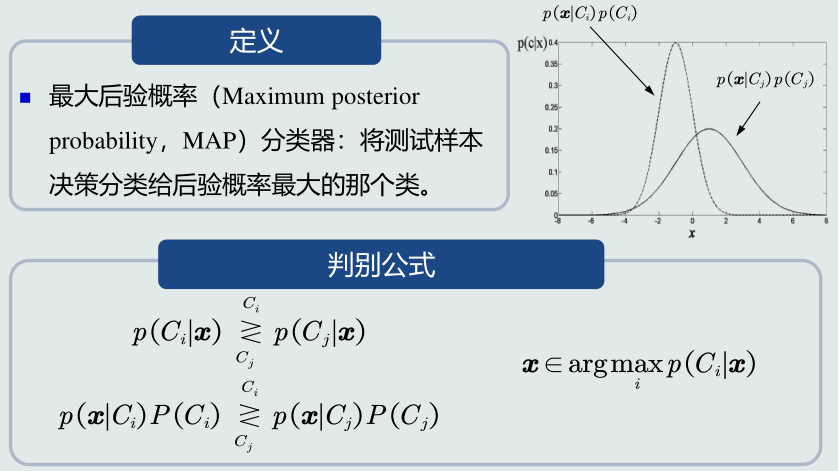

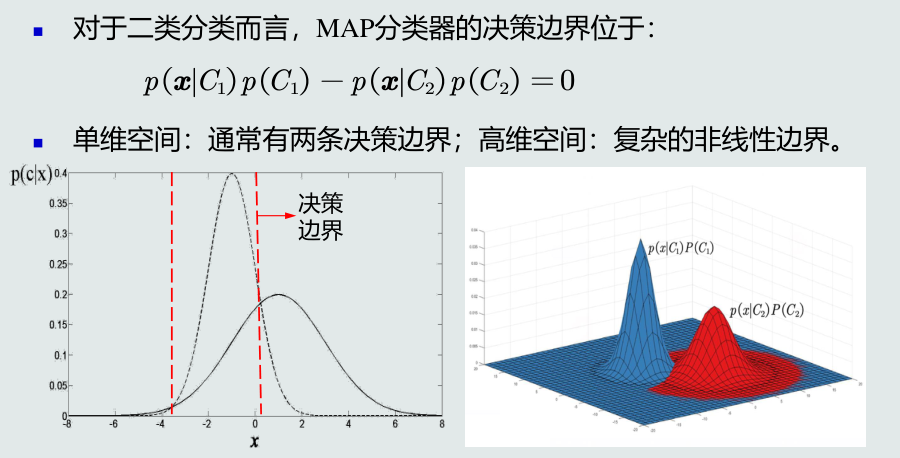

4.MAP分类器(最大后验概率分类器)

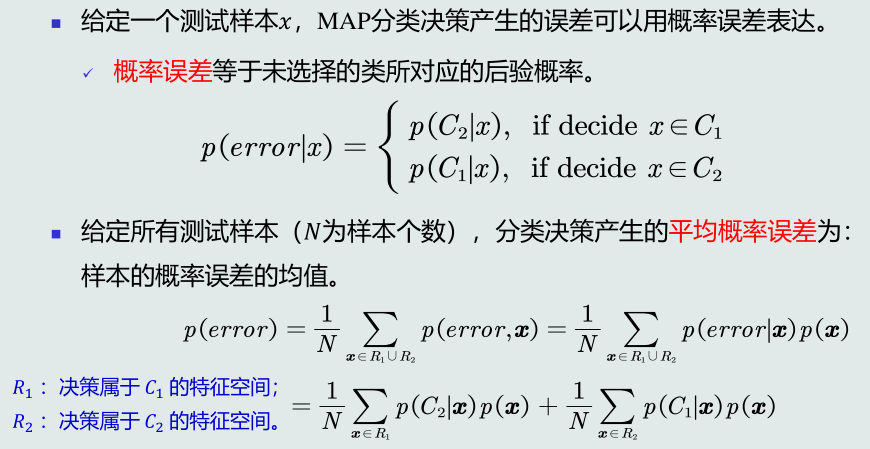

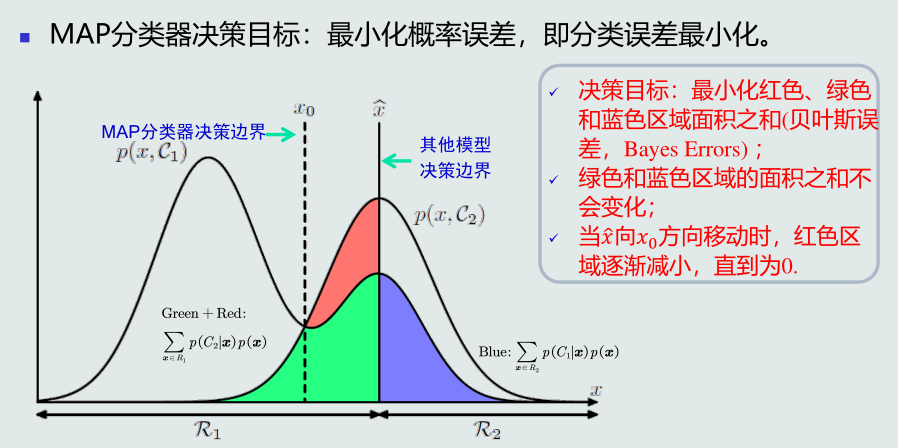

将测试样本分类到后验概率最大的类

决策产生的误差用概率误差表达,是未选择的类对应的后验概率

5.决策误差:

6.决策目标:最小化概率误差,即最小化分类误差

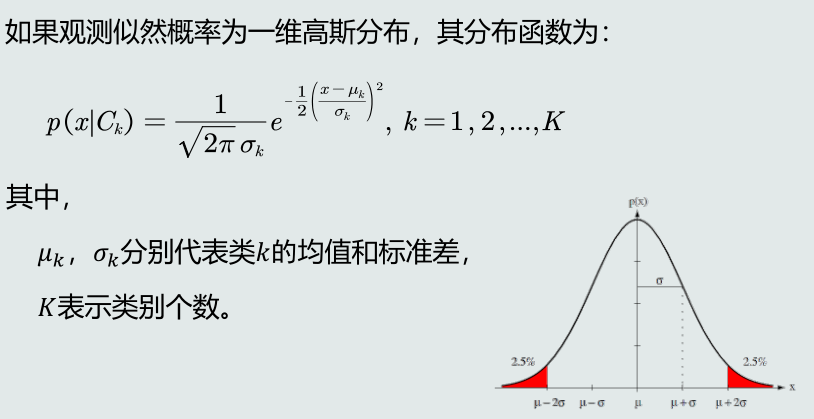

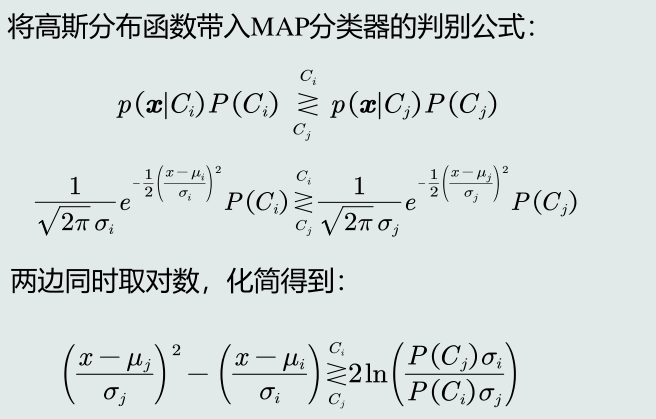

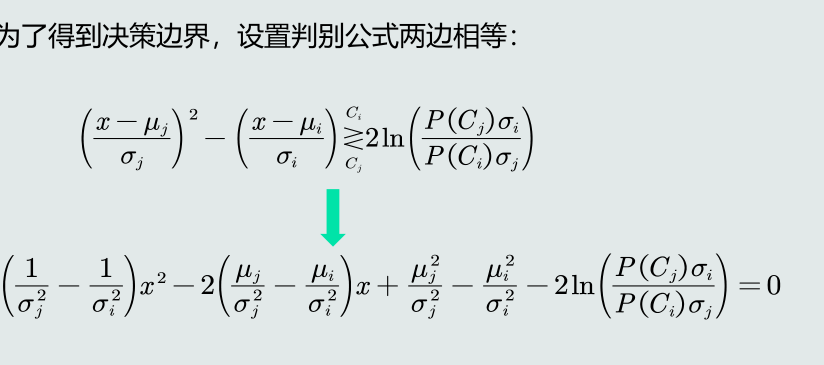

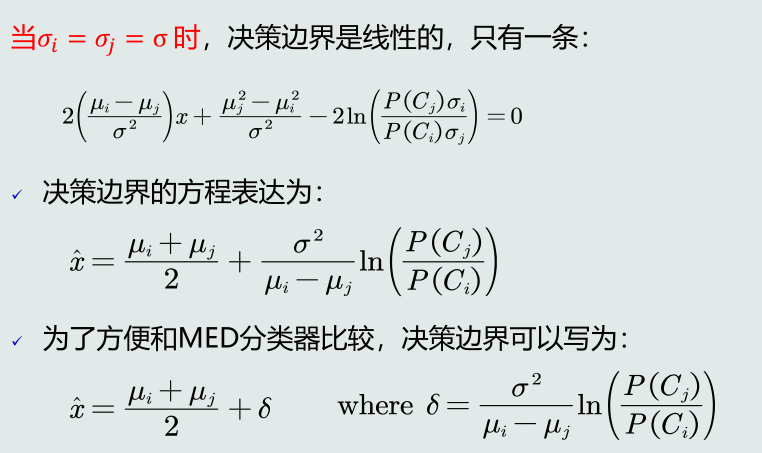

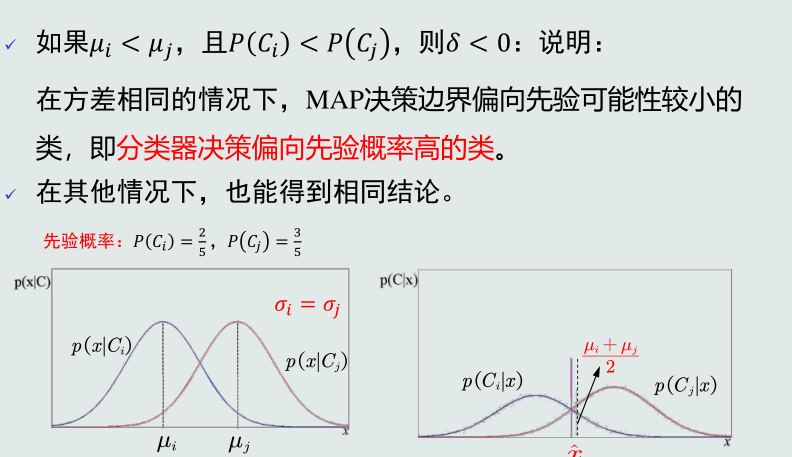

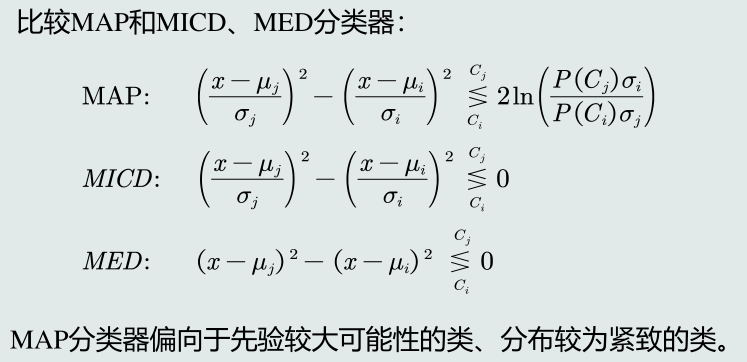

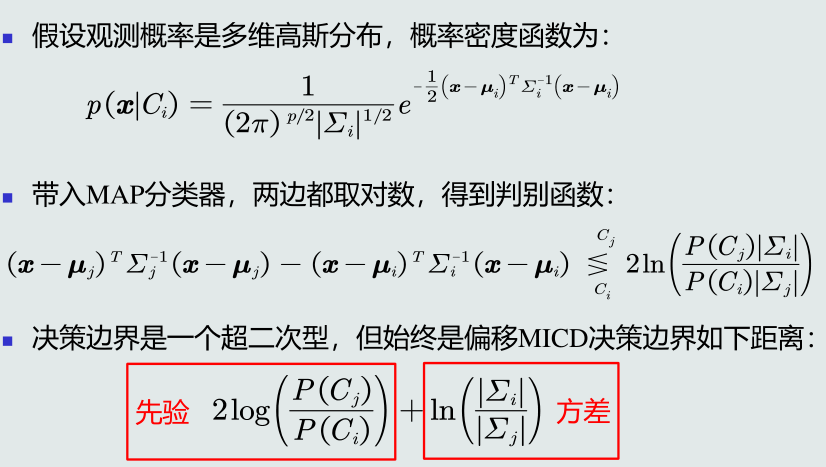

3.2 MAP分类器:高斯观测概率

1.先验和观测概率如何表达

2.分类器比较:

3.观测概率:高维高斯分布

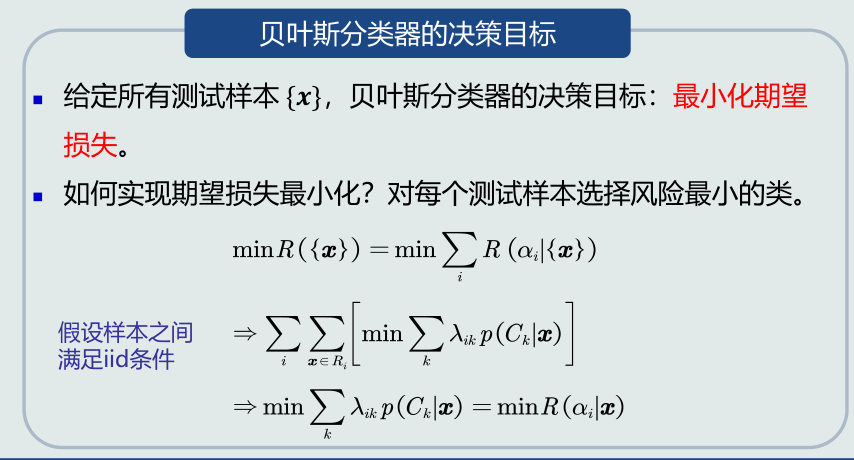

3.3决策风险与贝叶斯分类器

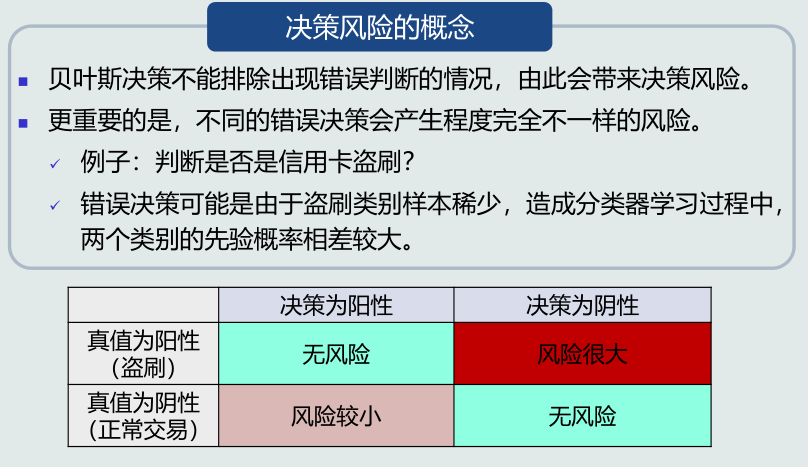

1.决策风险

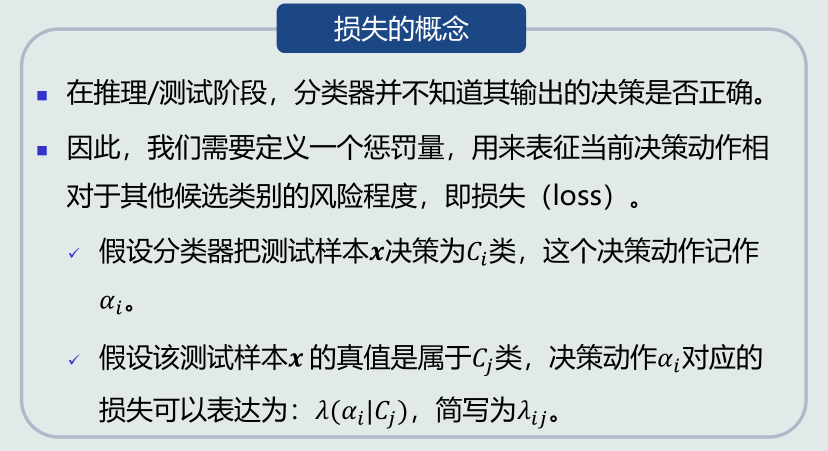

2.损失

2.贝叶斯分类器

在MAP分类器的基础上,加入决策风险因素

3.决策损失

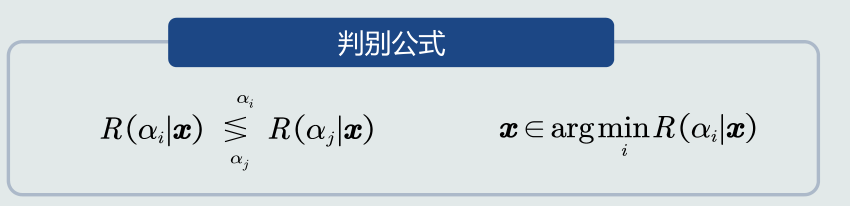

4.决策目标

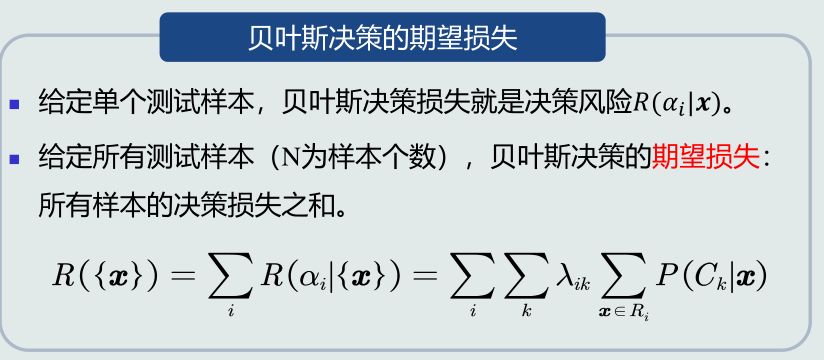

选择决策风险最小的类。即对于所有测试样本,选择损失最小的类,以达到期望损失最小

期望损失,即所有样本的决策损失之和

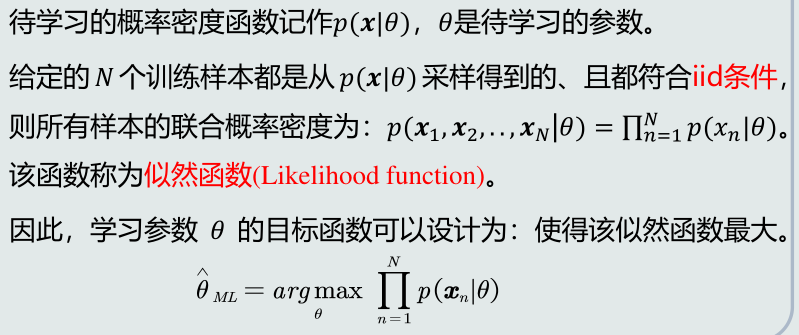

3.4最大似然估计

1.最大似然估计

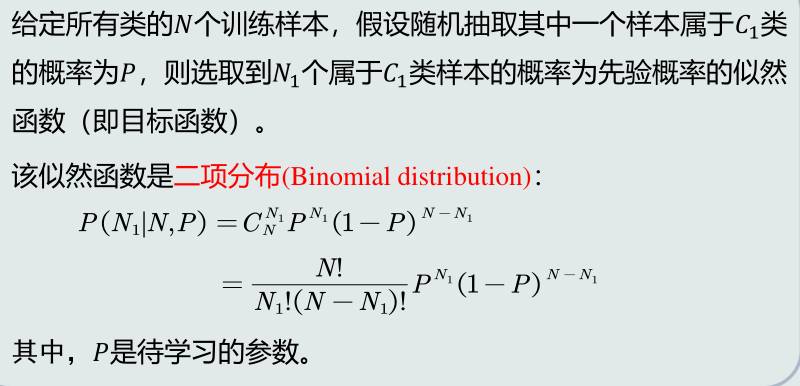

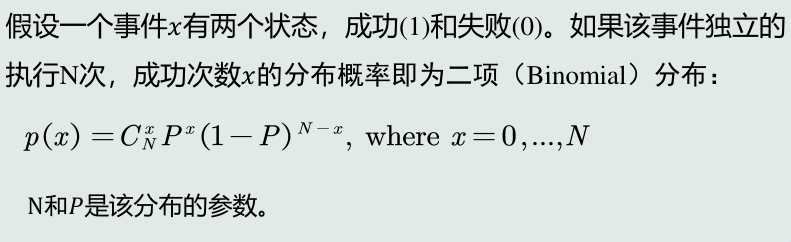

2.先验概率估计:给定所有类的N个训练样本,假设随机抽取其中一个样本属于C1类的概率为P,则选取到N1个属于C2类样本的概率为先验概率的似然函数(即目标函数)

*先验概率的最大似然估计就是该类训练样本出现的频率

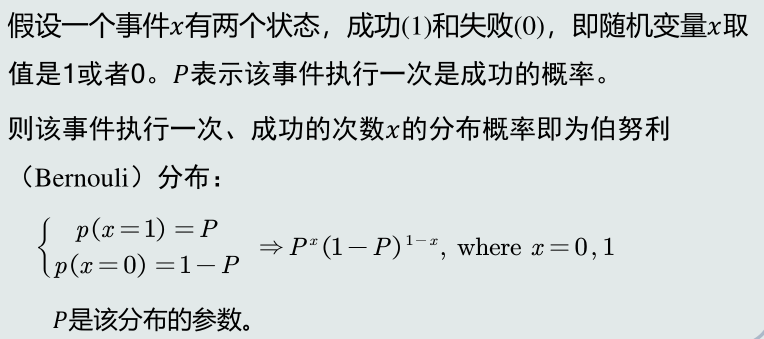

3.伯努利分布

4.高斯分布

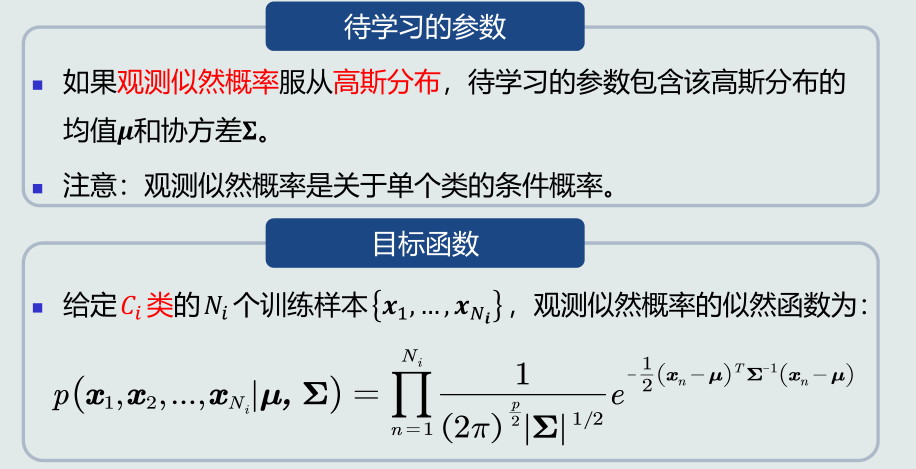

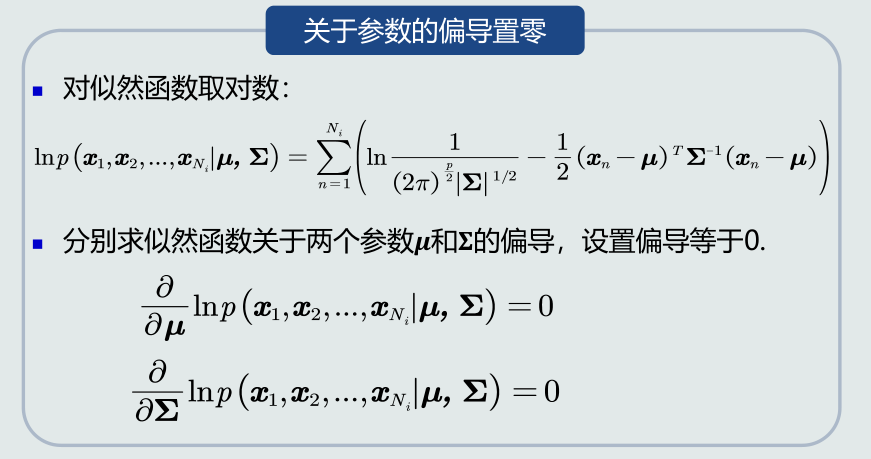

(1)高斯分布的参数估计

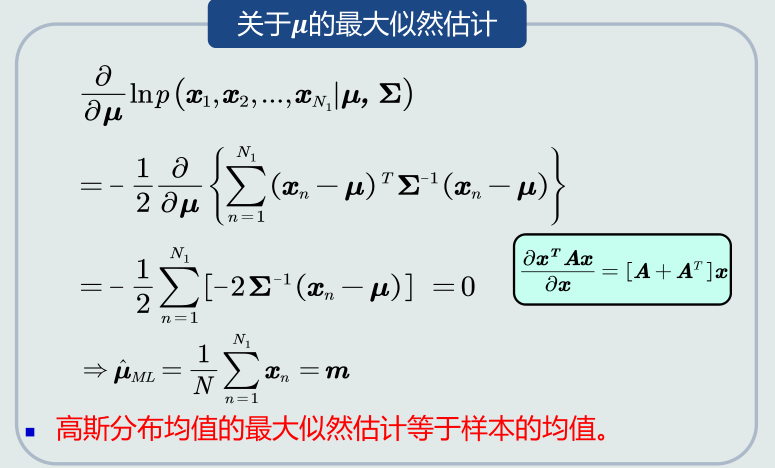

(2)均值估计

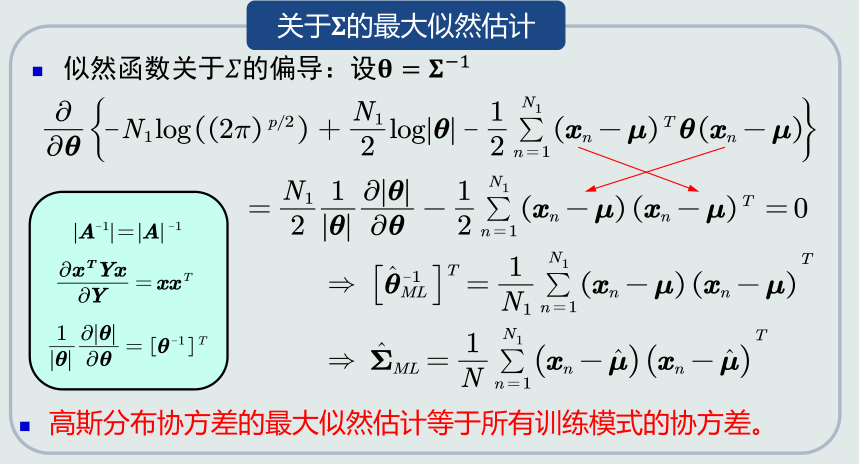

(3)协方差估计

3.5最大似然的估计偏差

1.无偏估计:

如果一个参数的估计量的数学期望是该参数的真值,则该估计量称作无偏估计

无偏估计意味着只要训练样本个数足够多,该估计值就是参数的真实值。

2.高斯分布

均值的最大似然估计是无偏估计

协方差的最大似然估计是有偏估计

估计偏差是一个较小的数,当N足够大时,最大似然估计可以看做是一个较好的估计

协方差估计的修正:

实际计算中可以将训练样本的协方差×N/(N-1)来修正

3.6贝叶斯估计(1)

1.概念:

已知样本满足某种未知参数的概率分布,把待估计参数看作符合先验概率分布的随机变量。

对样本进行观测的过程就是把先验概率密度转化为后验概率密度,利用样本信息修正了对参数的初始估计值

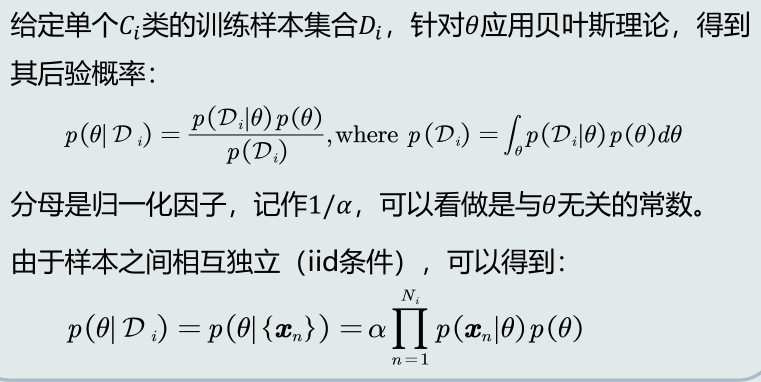

2.参数的后验概率

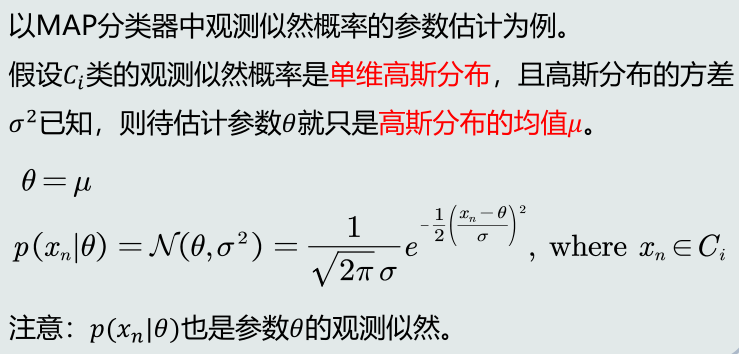

3.高斯观测似然

参数(高斯均值)先验概率

参数(高斯均值)后验概率

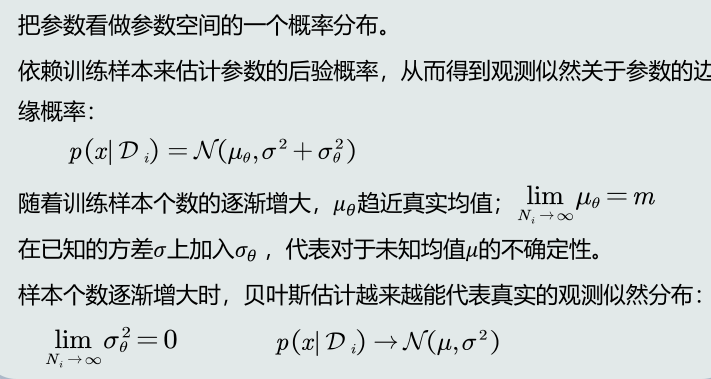

4.贝叶斯估计:不断学习能力

它允许最初的、基于少量训练样本的、不太准的估计

随着训练样本的不断增加,可以串行的不断修正参数的估计值,从而达到该参数的期望真值

3.7贝叶斯估计(2)

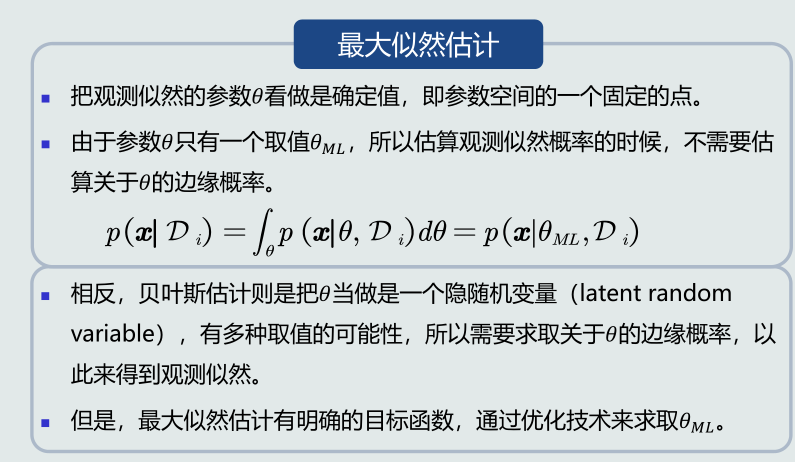

贝叶斯估计VS最大似然估计

1.贝叶斯估计

2.最大似然估计

3.8无参数概率密度估计

1.如果概率分布形式未知,可以通过无参数技术来实现概率密度估计

2.无参数估计:

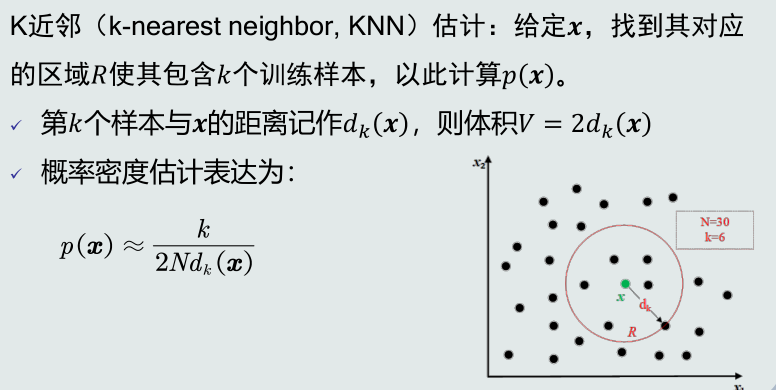

KNN估计(K-nearest neighbors)

(1)优点:

可以自适应的确定x相关的区域R的范围

(2)缺点:

KNN的概率密度估计不是连续函数

不是真正的概率密度表达,概率密度函数积分是无穷大而不是1

3.9直方图与核密度估计

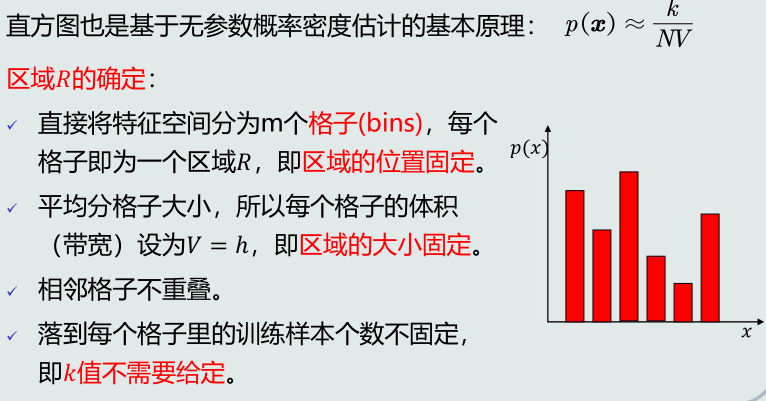

1.直方图原理

直方图技术(Histogram technique)

2.直方图优缺点

(1)优点

固定区域R:减少由于噪声污染造成的估计误差

不需要存储训练样本

(2)缺点:

固定区域R的位置:如果模式x落在相邻格子的交界区域,意味着当前格子不是以模式x为中心,导致统计和概率估计不准确

固定区域R的大小:缺乏概率估计的自适应能力,导致过于尖锐或平滑

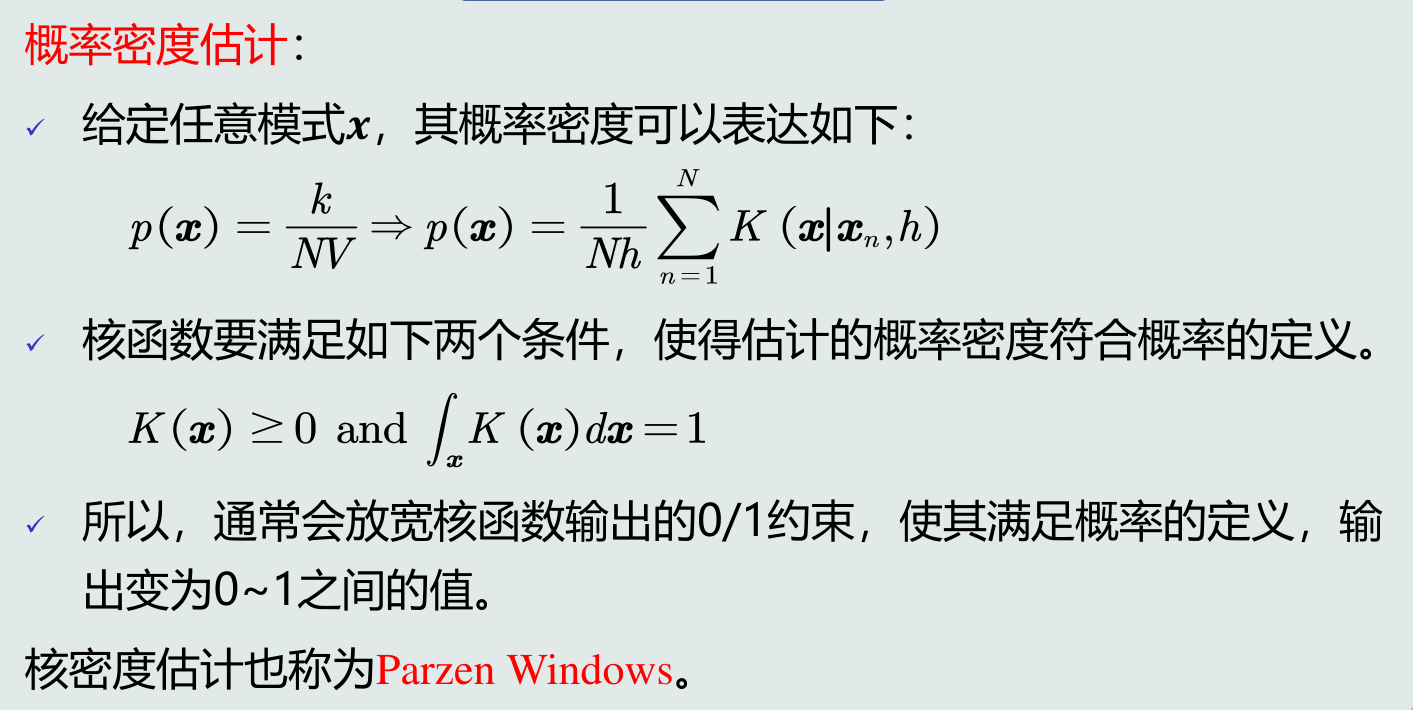

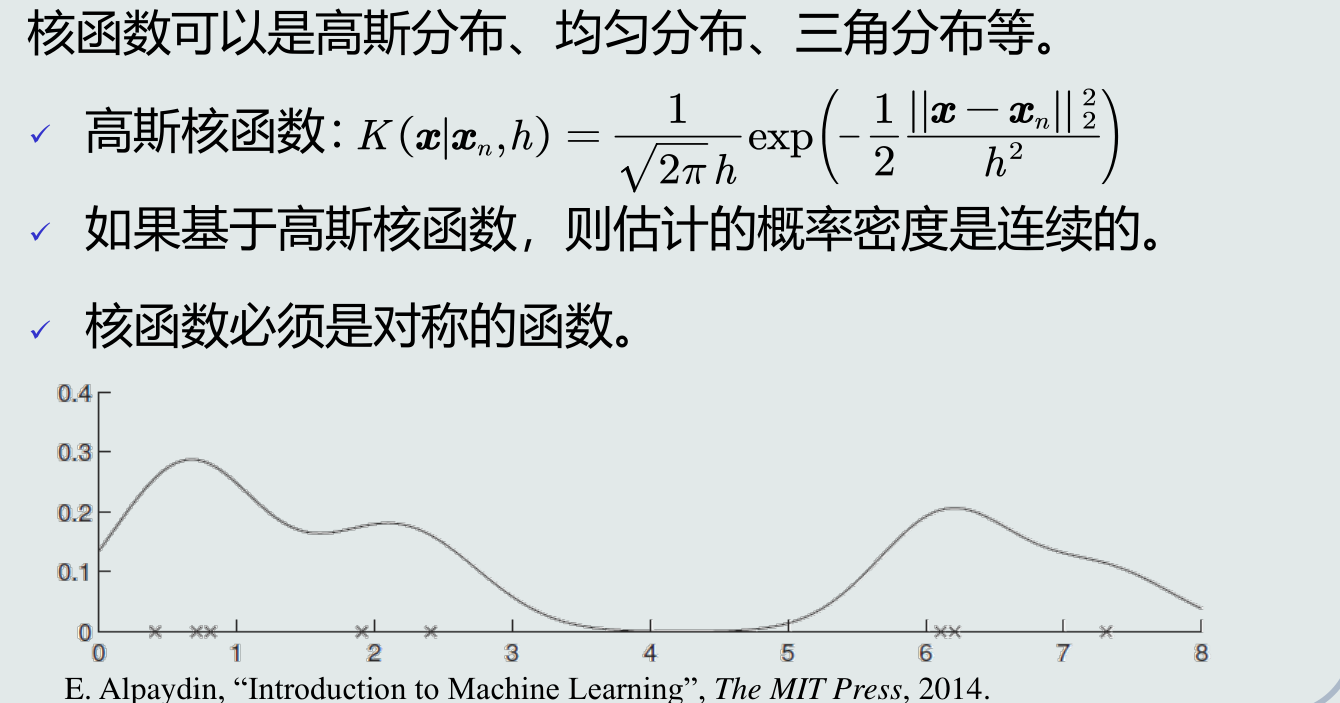

3.核密度估计(Keernel density estimation)

(1)优点:

以待估计模式𝒙为中心、自适应确定区域𝑅的位置(类似KNN)。

使用所有训练样本,而不是基于第 𝑘 个近邻点来估计概率密度,从而克服KNN估计存在的噪声影响。

如果核函数是连续,则估计的概率密度函数也是连续的。

(2)缺点:

与直方图估计相比,核密度估计不提前根据训练样本估计每个格子的统计值,所以它必须要存储所有训练样本!