Mint Linux 20.3Cinnamon 伪分布式安装Hadoop3.2.1、jdk1.8.0

一、安装Hadoop3.2.1

1.1 创建Hadoop用户(如果需要将本机的账户与Hadoop分开,可以新建一个新用户)

sudo useradd -m hadoop -s /bin/bash #创建hadoop用户,并使用/bin/bash作为shell

sudo passwd hadoop #为hadoop用户设置密码

sudo adduser hadoop sudo #为hadoop用户增加管理员权限

su - hadoop #切换当前用户为用户hadoop

sudo apt-get update #更新hadoop用户

1.2 安装SSH(hadoop用户)

sudo apt-get install openssh-server #安装SSH server

ssh localhost #登陆SSH,第一次登陆输入yes

exit #退出登录的ssh localhost

cd ~/.ssh/ #如果没法进入该目录,执行一次ssh localhost

ssh-keygen -t rsa #连续敲击三次,成功后继续下面操作

cd .ssh

touch authorized_keys

chmod 600 authorized_keys #创建authorized_keys文件并修改权限为600

cat ./id_rsa.pub >> ./authorized_keys #加入授权

ssh localhost #此时已不需密码即可登录localhost,如果失败则可以搜索SSH免密码登录来寻求答案

1.3 安装jdk1.8.0_131(hadoop用户)

oracle官网下载jdk1.8版本,其他版本可能不兼容

mkdir /usr/lib/jvm #创建jvm文件夹

sudo tar zxvf 你的jdk文件名 -C /usr/lib/jvm #/解压到/usr/lib/jvm目录下

cd /usr/lib/jvm #进入该目录

mv jdk1.8.0_231 java #重命名为java

给JDK配置环境变量

vim ~/.bashrc

#Java Environment

export JAVA_HOME=/usr/lib/jvm/java

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH

修改完成使用如下命令

source ~/.bashrc #使新配置的环境变量生效

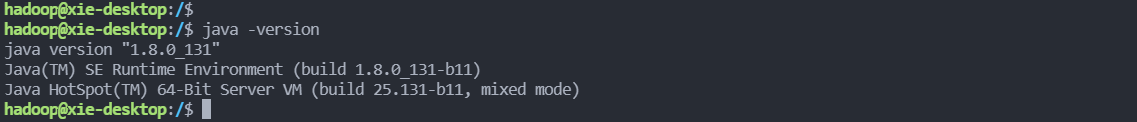

java -version #检测是否安装成功,查看java版本

(

)

1.4 下载安装Hadoop-3.2.1(hadoop用户)

https://archive.apache.org/dist/hadoop/common/

切换到下载文件的位置/Downloads,找到下载的文件进行安装

sudo tar -zxvf hadoop-3.2.1.tar.gz -C /usr/local #解压到/usr/local目录下

cd /usr/local

#sudo mv hadoop-3.2.1 hadoop #重命名为hadoop,可改可不改,如果修改下边的名字也要对应

sudo chown -R hadoop ./hadoop-3.2.1 #修改文件权限

给hadoop配置环境变量,将下面代码添加到.bashrc文件:

#Hadoop Environment

export HADOOP_HOME=/usr/local/hadoop-3.2.1

export CLASSPATH=$($HADOOP_HOME/bin/hadoop classpath):$CLASSPATH

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

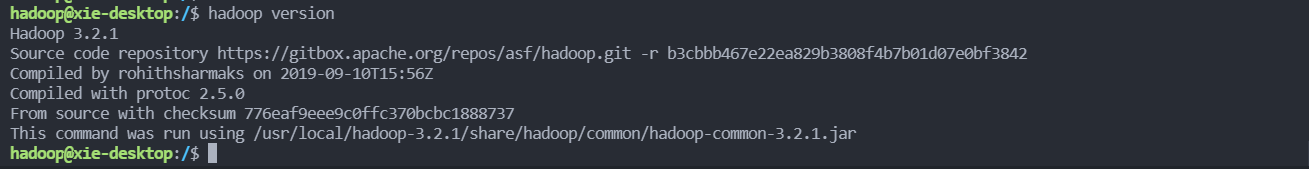

同样,执行source ~./bashrc使设置生效,并查看hadoop version是否安装成功,若出现hadoop版本即为安装成功

1.5 伪分布式配置

Hadoop 可以在单节点上以伪分布式的方式运行,Hadoop 进程以分离的 Java 进程来运行,节点既作为 NameNode 也作为 DataNode,读取的是 HDFS 中的文件。

Hadoop 的配置文件位于/usr/local/hadoop-3.2.1/etc/hadoop/,伪分布式需要修改2个配置文件 core-site.xml 和 hdfs-site.xml 。

Hadoop的配置文件是 xml 格式,每个配置以声明 property 的 name 和 value 的方式来实现。

首先将jdk1.8的路径添export JAVA_HOME=/usr/lib/jvm/java加到hadoop-env.sh文件

修改core-site.xml文件:

点击查看代码

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop-3.2.1/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

点击查看代码

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop-3.2.1/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop-3.2.1/tmp/dfs/data</value>

</property>

<property>

<name>dfs.http.address</name>

<value>0.0.0.0:50070</value>

</property>

</configuration>

Hadoop 的运行方式是由配置文件决定的(运行 Hadoop 时会读取配置文件),因此如果需要从伪分布式模式切换回非分布式模式,需要删除 core-site.xml 中的配置项。

此外,伪分布式虽然只需要配置 fs.defaultFS 和 dfs.replication 就可以运行(可参考官方教程),不过若没有配置 hadoop.tmp.dir 参数,则默认使用的临时目录为 /tmp/hadoo-hadoop,而这个目录在重启时有可能被系统清理掉,导致必须重新执行 format 才行。

所以我们进行了设置,同时也指定 dfs.namenode.name.dir 和 dfs.datanode.data.dir,否则在接下来的步骤中可能会出错。

配置完成后,执行 NameNode 的格式化

这个路径是在/usr/local/hadoop-3.2.1/bin

cd /usr/local/hadoop-3.2.1/bin

hdfs namenode -format

注意:

不能一直格式化NameNode,格式化NameNode,会产生新的集群id,导致NameNode和DataNode的集群id不一致,集群找不到已往数据。所以,格式NameNode时,一定要先删除data数据和log日志,然后再格式化NameNode。

启动namenode和datanode进程,并查看启动结果

路径:/usr/local/hadoop-3.2.1/sbin

cd /usr/local/hadoop-3.2.1/sbin

start-dfs.sh

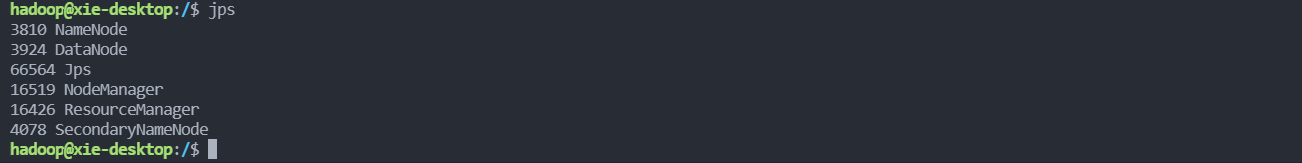

jps

启动完成后,可以通过命令 jps 来判断是否成功启动,若成功启动则会列出如下进程: “NameNode”、”DataNode” 和 “SecondaryNameNode”

图中只需有四个进程"JPS" “NameNode” “DateNode” "SecondaryNameNode"即可

此时也有可能出现要求输入localhost密码的情况 ,如果此时明明输入的是正确的密码却仍无法登入,其原因是由于如果不输入用户名的时候默认的是root用户,但是安全期间ssh服务默认没有开root用户的ssh权限

1.6

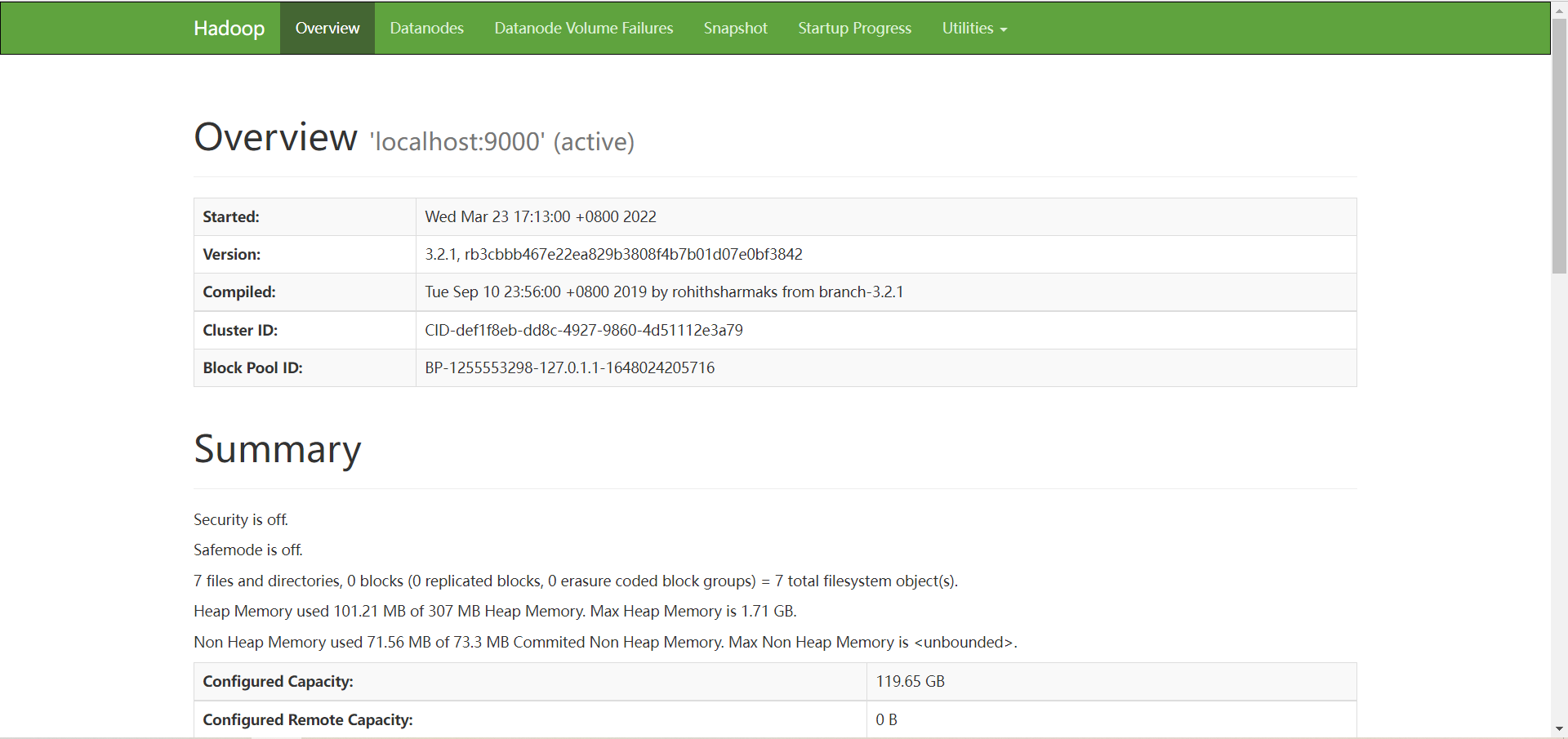

成功启动后,在浏览器中输入localhost:50070会出现以下页面

浙公网安备 33010602011771号

浙公网安备 33010602011771号