hadoop之HDFS概述

HDFS的定义?

Hadoop分布式文件管理系统。旨在对不同系统上的文件进行统一的管理。它是一个文件系统,用于存储文件,通过目录树来定位文件,其次,它是分布式的,由很多服务器联合起来实现其功能,集群中的服务器有各自的角色。

使用场景?

适合一次写入,多次读出的场景,且不支持文件的修改,适合用来做数据分析,并不适合用来做网盘应用。

它的优点?

(1)高容错性

- 数据自动保存多个副本,它通过增加副本的形式,提高容错性

- 某一个副本丢失以后,它可以自动恢复

(2)适合处理大数据

- 数据规模:能够处理数据规模达到GB、TB甚至是PB级别的数据

- 文件规模:能够处理百万规模以上的文件数据

(3)可构建在廉价机器上,通过多副本机制,提高可靠性

它的缺点?

(1)不适合低延时数据访问,比如毫秒级的存储数据,是做不到的

(2)无法高效的对大量小文件进行存储

- 存储大量小文件的话,它会占用NameNode大量的内存来存储文件目录和块信息,这样实不可取的,因为NameNode的内存总是有限的

- 小文件存储的寻址时间会超过读取时间,它违反了HDFS的设计目标

(3)不支持并发写入,文件的随机修改

- 一个文件只能有一个写,不允许多个线程同时写

- 仅支持数据的追加,不支持数据的随机修改

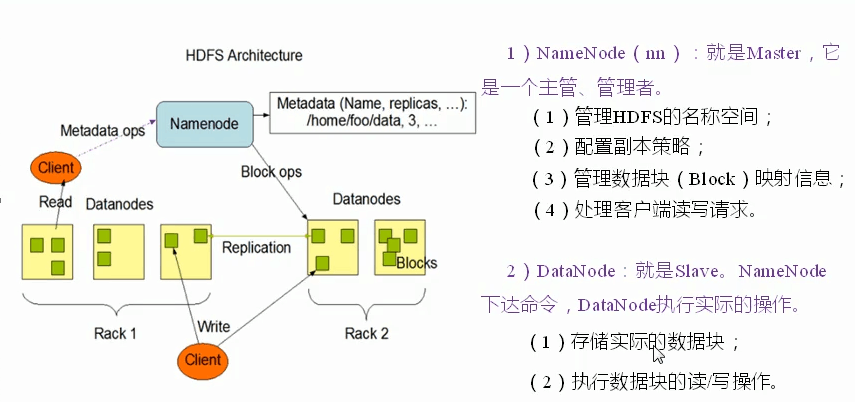

HDFS的组成架构?

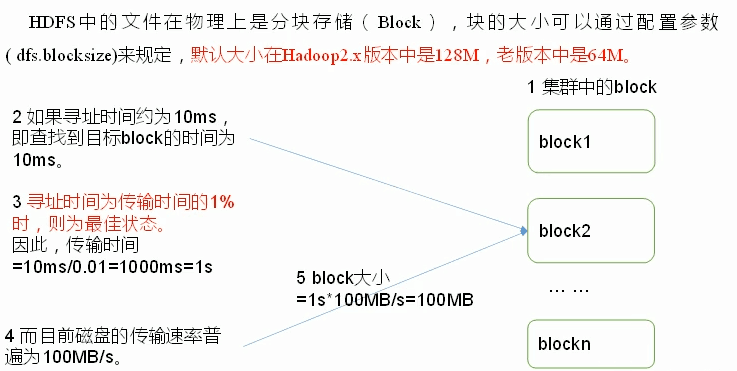

HDFS文件块的大小?

块设置的不能太小,也不能太大?

(1) HDFS块设置得太小,会增加寻址时间,程序一直寻找块的开始位置

(2)如果设置得太大,从磁盘传输数据的时间会明显大于定位这个块开始位置所需的时间,导致程序在处理这块数据时,会非常慢。

HDFS块的大小的设置主要取决于磁盘传输的速率。