Pathformer做时间序列

超越Transformer!时间序列预测新方法,霸榜AI顶会

超越Transformer,霸榜AI顶会,patch做时间序列预测成为新烫门,强烈推荐想发论文的伙伴多关注!

具体看,以往的时间序列预测创新着眼改模型,越来越卷,难度越来越大,而基于patch的方式,主要关注数据的输入形式,这是一个新思路,目前还在蓬勃发展中,创新机会多!而且patch的方式能够把各种复杂时序数据,转换成深度学习模型能处理的方式,在多变量预测等方面,独具优势,对提高模型性能等也很有帮助。

为了能够帮大家获取更多灵感启发,本次给大家挑选了10个基于Patch的时序预测改进思路,且提供了源码,方便大家改模型。

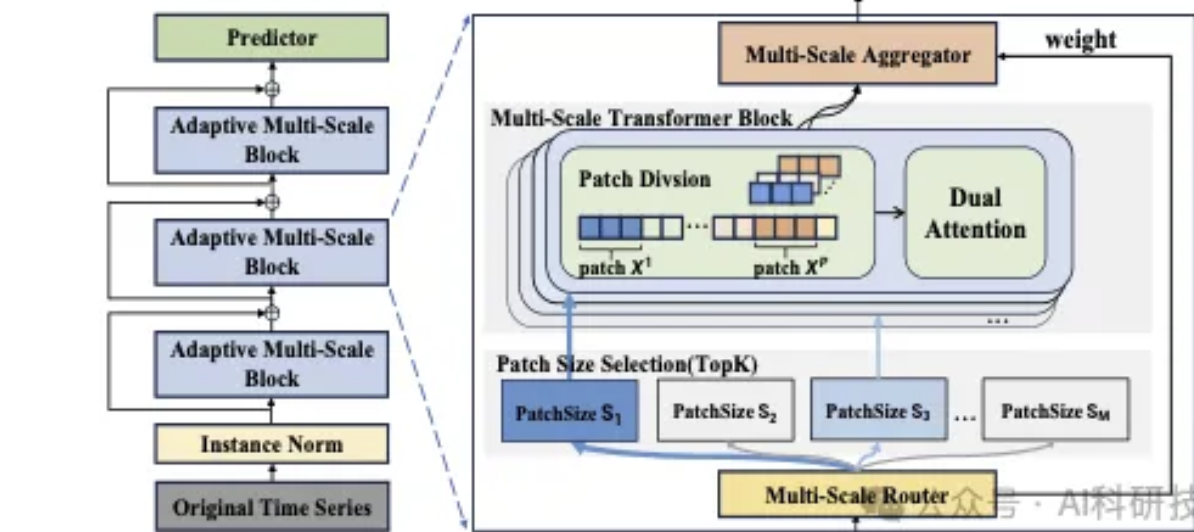

论文题目:《PATHFORMER: MULTI-SCALE TRANSFORMERS WITH ADAPTIVE PATHWAYS FOR TIME SERIES FORECASTING》

论文简述:基于变压器的模型在时间序列预测中取得了一定的成功。现有的方法主要是从有限或固定的尺度上对时间序列进行建模,很难捕捉到不同尺度上的不同特征。本文提出了一种具有自适应路径的多尺度变压器(Pathformer)。本文提出的Transformer集成了时间分辨率和时间距离,用于多尺度建模。多尺度分割利用不同大小的补丁将时间序列划分为不同的时间分辨率。基于每个尺度的划分,对这些补丁进行双重关注,以捕获全局相关性和局部细节作为时间依赖性。作者进一步丰富了多尺度变压器的自适应路径,该路径根据输入时间序列中变化的时间动态自适应调整多尺度建模过程,

图片

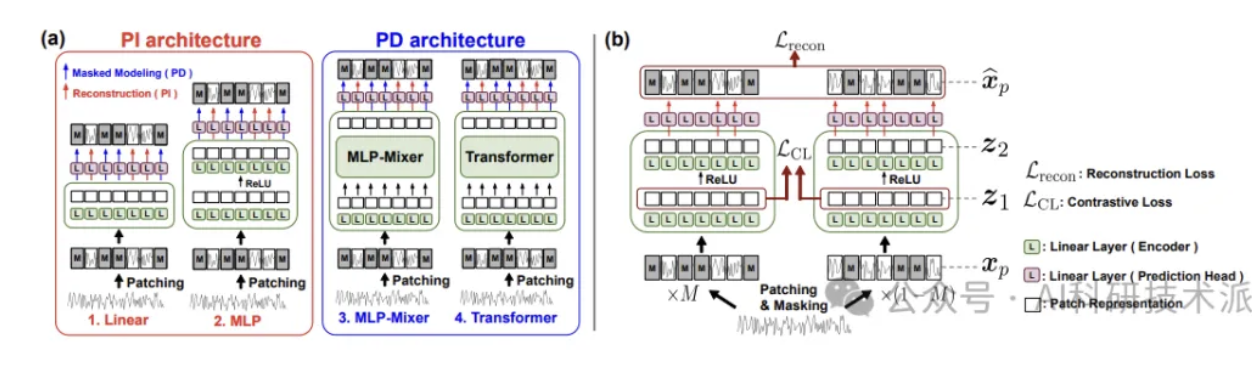

论文题目:《LEARNING TO EMBED TIME SERIES PATCHES INDEPENDENTLY》

论文简述:掩膜时间序列建模作为一种时间序列的自监督表示学习策略,近年来受到了广泛的关注。受计算机视觉中掩模图像建模的启发,最近的研究首先对时间序列进行拼接和部分掩模,然后通过从未掩模的斑块中预测掩模的斑块来训练变形金刚捕捉斑块之间的依赖关系。本文认为捕获这种补丁依赖关系可能不是时间序列表示学习的最佳策略;相反,学习独立嵌入补丁会产生更好的时间序列表示。具体来说,作者建议使用1)简单的补丁重建任务,它在不查看其他补丁的情况下自动编码每个补丁,以及2)简单的补丁智能MLP,它独立嵌入每个补丁。此外,本文还引入了互补对比学习,以有效地分层捕获相邻时间序列信息。

图片

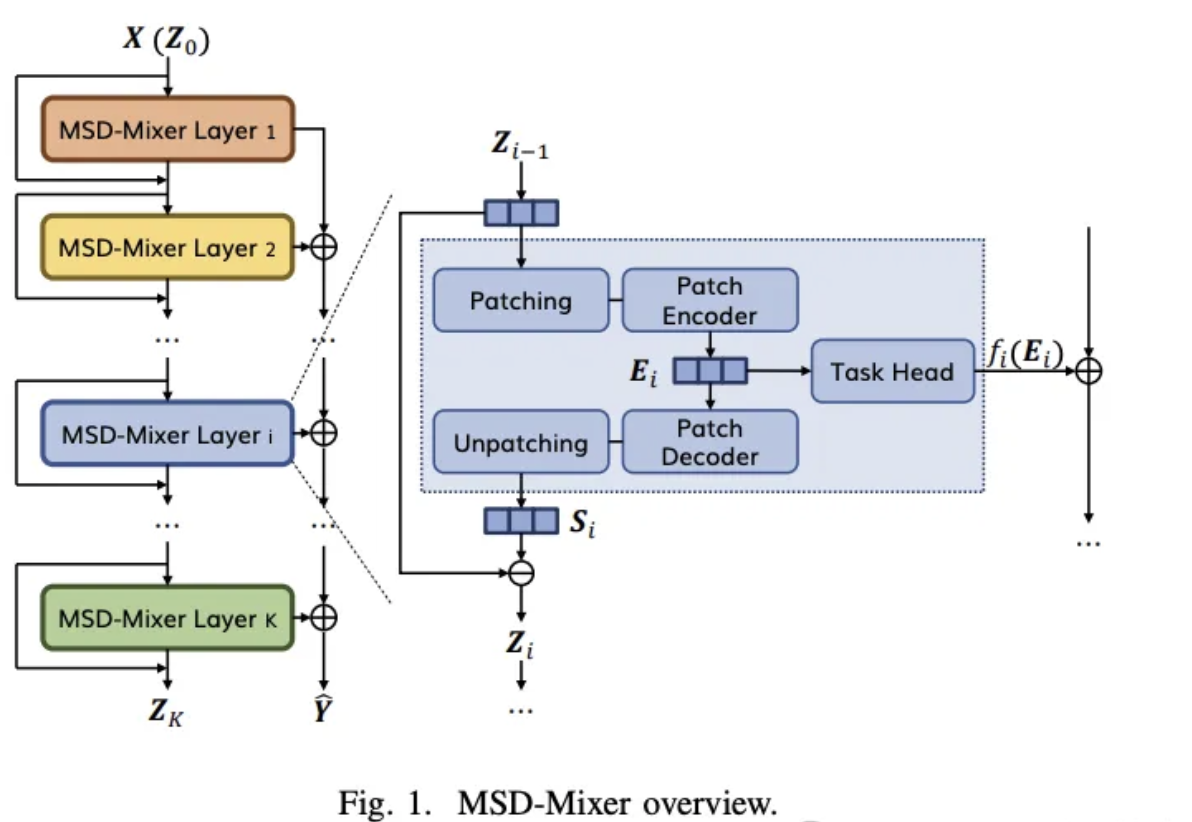

论文题目:《A Multi-Scale Decomposition MLP-Mixer for Time Series Analysis》

论文简述:时间序列数据往往具有独特的组成和复杂的多尺度时间变化特征,在分析时需要特别考虑分解和多尺度建模。现有的深度学习方法在这方面的最佳拟合仅适用于单变量时间序列,并且没有充分考虑子序列水平的建模和分解完整性。为了解决这个问题,本文提出了MSD-Mixer,一种多尺度分解MLP-Mixer,它学习将输入时间序列显式分解为不同的组件,并表示不同层中的组件。为了处理多尺度时间模式和通道间依赖关系,本文提出了一种新的时间补丁方法,将时间序列建模为多尺度子序列,即补丁,并使用mlp来混合补丁内和补丁间的变化和通道相关。

图片

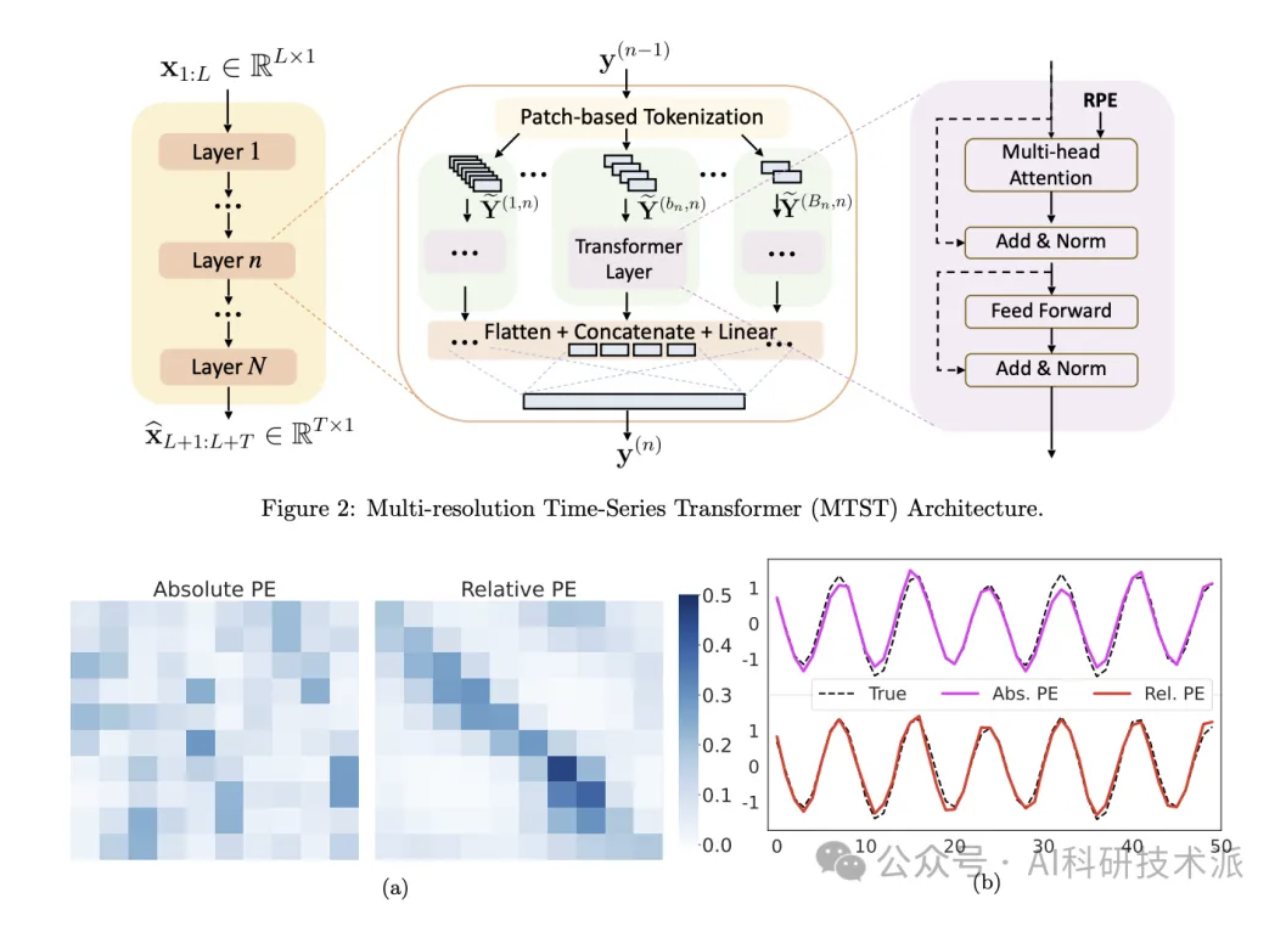

论文题目:《Multi-resolution Time-Series Transformer for Long-term Forecasting》

论文简述:变压器的时间序列预测性能有了明显的提高。最近的体系结构通过将时间序列分割成小块并使用小块作为标记来学习复杂的时间模式。斑块大小控制着变压器在不同频率下学习时间模式的能力:较短的斑块对于学习局部高频模式有效,而挖掘长期季节性和趋势则需要较长的斑块。受此启发,本文提出了一个新的框架,多分辨率时间序列变压器(MTST),它由一个多分支架构组成,用于在不同分辨率下同时建模不同的时间模式。与许多现有的时间序列变压器相比,本文采用相对位置编码,更适合于提取不同尺度的周期分量。

图片

扫描下方二维码,回复「Path时序预测」

免费获取全部论文合集及项目代码图片

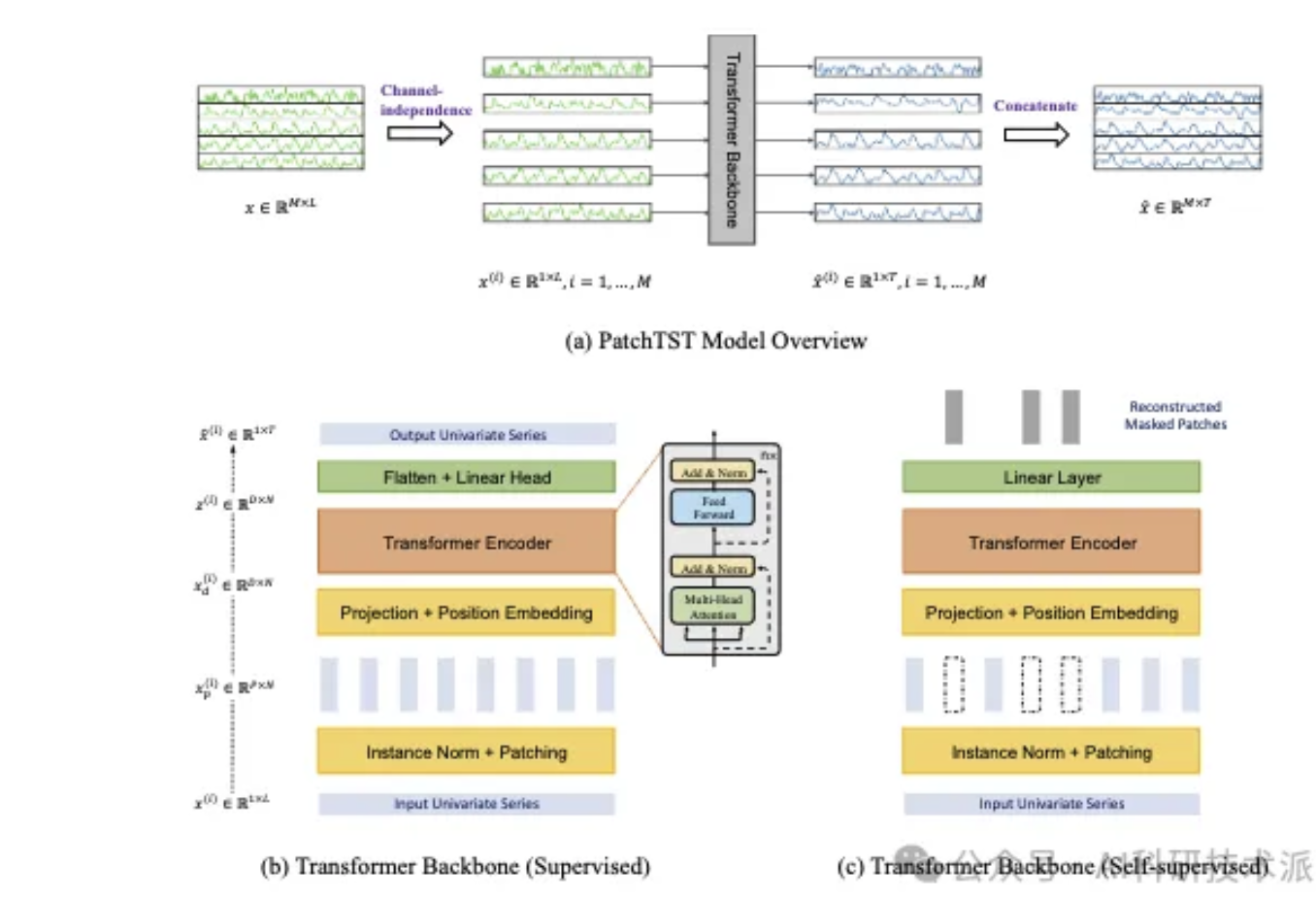

论文题目:《PatchTST:A Time Series is Worth 64 Words: Long-term Forecasting with Transformers》

论文简述:本文提出了基于变压器的多变量时间序列预测和自监督表示学习模型的有效设计。它基于两个关键组成部分:(i)将时间序列分割成子序列级别的补丁,这些补丁作为Transformer的输入令牌;(ii)通道独立性,其中每个通道包含一个单变量时间序列,该时间序列在所有序列中共享相同的嵌入和Transformer权重。修补设计自然有三方面的好处:在嵌入中保留了局部语义信息;给定相同的回溯窗口,注意力图的计算和内存使用量呈二次递减;模型可以关注更长的历史。

图片

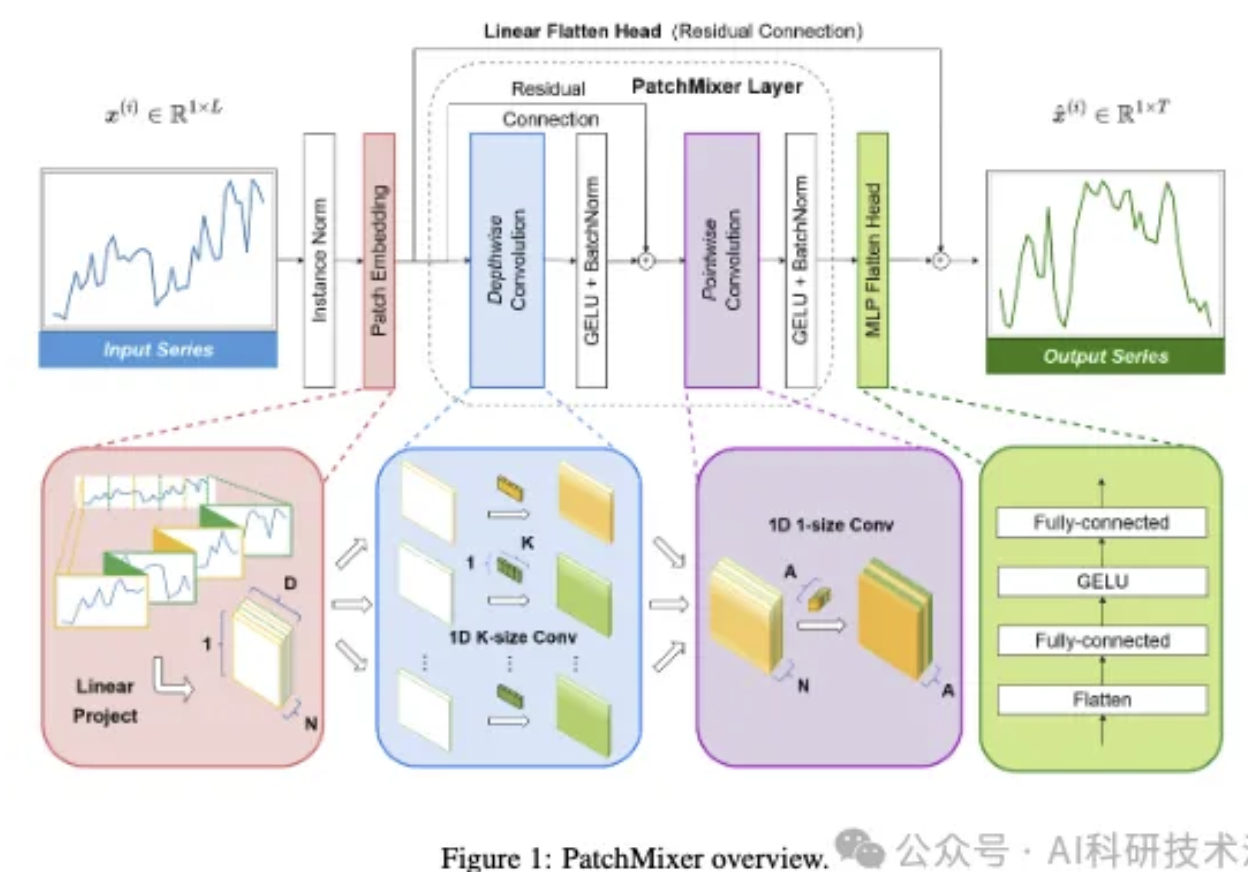

论文题目:《PATCHMIXER: A PATCH-MIXING ARCHITECTURE FOR LONG-TERM TIME SERIES FORECASTING》

论文简述:尽管Transformer近年来一直是时间序列预测任务的主要架构,但一个基本的挑战仍然存在:Transformer中的排列不变自关注机制导致时间信息的丢失。为了应对这些挑战,本文提出了PatchMixer,一个新颖的基于cnn的模型。它引入了一种排列变卷积结构来保存时间信息。与该领域通常使用多个尺度或多个分支的传统cnn不同,该方法完全依赖于深度可分离卷积。这允许我们使用单尺度架构提取局部特征和全局相关性。此外,本文采用双重预测头,包括线性和非线性成分,以更好地模拟未来的曲线趋势和细节。

图片

论文题目:《TSMixer: Lightweight MLP-Mixer Model for Multivariate Time Series Forecasting》

论文简述:本文提出了TSMixer,一个由多层感知器(MLP)模块组成的轻量级神经架构。TSMixer在补片时间序列上设计了公式变量预测和表示学习,为变压器提供了一种有效的替代方案。模型从计算机视觉中MLP-Mixer模型的成功中获得灵感。我们展示了将Vision MLP-Mixer用于时间序列并引入经验验证组件以提高准确性所涉及的挑战。这包括一种新的设计范例,将在线协调头附加到MLP-Mixerbackbone上,用于显式地建模时间序列属性,如层次结构和通道相关性。本文还提出了一种混合信道建模方法,以有效地处理噪声信道相互作用和跨不同数据集的泛化,这是现有补丁信道混合方法中的一个常见挑战。

本文仅供自己学习记录。

来自公众号,截图里有

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 单元测试从入门到精通

· 上周热点回顾(3.3-3.9)

· winform 绘制太阳,地球,月球 运作规律