Python 线程池原理及实现

Python 线程池原理及实现

前言

从Python3.2开始,标准库为我们提供了 concurrent.futures 模块,它提供了 ThreadPoolExecutor (线程池)和ProcessPoolExecutor (进程池)两个类。

相比 threading 等模块,该模块通过 submit 返回的是一个 future 对象,它是一个未来可期的对象,通过它可以获悉线程的状态主线程(或进程)中可以获取某一个线程(进程)执行的状态或者某一个任务执行的状态及返回值:

- 主线程可以获取某一个线程(或者任务的)的状态,以及返回值。

- 当一个线程完成的时候,主线程能够立即知道。

- 让多线程和多进程的编码接口一致。

✨ 线程池的基本使用

# coding: utf-8

from concurrent.futures import ThreadPoolExecutor

import time

def spider(page):

time.sleep(page)

print(f"crawl task{page} finished")

return page

with ThreadPoolExecutor(max_workers=5) as t: # 创建一个最大容纳数量为5的线程池

task1 = t.submit(spider, 1)

task2 = t.submit(spider, 2) # 通过submit提交执行的函数到线程池中

task3 = t.submit(spider, 3)

print(f"task1: {task1.done()}") # 通过done来判断线程是否完成

print(f"task2: {task2.done()}")

print(f"task3: {task3.done()}")

time.sleep(2.5)

print(f"task1: {task1.done()}")

print(f"task2: {task2.done()}")

print(f"task3: {task3.done()}")

print(task1.result()) # 通过result来获取返回值

执行结果如下:

task1: False

task2: False

task3: False

crawl task1 finished

crawl task2 finished

task1: True

task2: True

task3: False

1

crawl task3 finished

-

使用 with 语句 ,通过 ThreadPoolExecutor 构造实例,同时传入 max_workers 参数来设置线程池中最多能同时运行的线程数目。

-

使用 submit 函数来提交线程需要执行的任务到线程池中,并返回该任务的句柄(类似于文件、画图),注意 submit() 不是阻塞的,而是立即返回。

-

通过使用 done() 方法判断该任务是否结束。上面的例子可以看出,提交任务后立即判断任务状态,显示四个任务都未完成。在延时2.5后,task1 和 task2 执行完毕,task3 仍在执行中。

-

使用 result() 方法可以获取任务的返回值。

✨ 主要方法:

wait

wait(fs, timeout=None, return_when=ALL_COMPLETED)

wait 接受三个参数:

fs: 表示需要执行的序列

timeout: 等待的最大时间,如果超过这个时间即使线程未执行完成也将返回

return_when:表示wait返回结果的条件,默认为 ALL_COMPLETED 全部执行完成再返回

还是用上面那个例子来熟悉用法

示例:

from concurrent.futures import ThreadPoolExecutor, wait, FIRST_COMPLETED, ALL_COMPLETED

import time

def spider(page):

time.sleep(page)

print(f"crawl task{page} finished")

return page

with ThreadPoolExecutor(max_workers=5) as t:

all_task = [t.submit(spider, page) for page in range(1, 5)]

wait(all_task, return_when=FIRST_COMPLETED)

print('finished')

print(wait(all_task, timeout=2.5))

# 运行结果

crawl task1 finished

finished

crawl task2 finished

crawl task3 finished

DoneAndNotDoneFutures(done={<Future at 0x28c8710 state=finished returned int>, <Future at 0x2c2bfd0 state=finished returned int>, <Future at 0x2c1b7f0 state=finished returned int>}, not_done={<Future at 0x2c3a240 state=running>})

crawl task4 finished

- 代码中返回的条件是:当完成第一个任务的时候,就停止等待,继续主线程任务

- 由于设置了延时, 可以看到最后只有 task4 还在运行中

as_completed

上面虽然提供了判断任务是否结束的方法,但是不能在主线程中一直判断啊。最好的方法是当某个任务结束了,就给主线程返回结果,而不是一直判断每个任务是否结束。

ThreadPoolExecutorThreadPoolExecutor 中 的 as_completed() 就是这样一个方法,当子线程中的任务执行完后,直接用 result() 获取返回结果

用法如下:

# coding: utf-8

from concurrent.futures import ThreadPoolExecutor, as_completed

import time

def spider(page):

time.sleep(page)

print(f"crawl task{page} finished")

return page

def main():

with ThreadPoolExecutor(max_workers=5) as t:

obj_list = []

for page in range(1, 5):

obj = t.submit(spider, page)

obj_list.append(obj)

for future in as_completed(obj_list):

data = future.result()

print(f"main: {data}")

# 执行结果

crawl task1 finished

main: 1

crawl task2 finished

main: 2

crawl task3 finished

main: 3

crawl task4 finished

main: 4

as_completed() 方法是一个生成器,在没有任务完成的时候,会一直阻塞,除非设置了 timeout。

当有某个任务完成的时候,会 yield 这个任务,就能执行 for 循环下面的语句,然后继续阻塞住,循环到所有的任务结束。同时,先完成的任务会先返回给主线程。

map

map(fn, *iterables, timeout=None)

fn: 第一个参数 fn 是需要线程执行的函数;

iterables:第二个参数接受一个可迭代对象;

timeout: 第三个参数 timeout 跟 wait() 的 timeout 一样,但由于 map 是返回线程执行的结果,如果 timeout小于线程执行时间会抛异常 TimeoutError。

用法如下:

import time

from concurrent.futures import ThreadPoolExecutor

def spider(page):

time.sleep(page)

return page

start = time.time()

executor = ThreadPoolExecutor(max_workers=4)

i = 1

for result in executor.map(spider, [2, 3, 1, 4]):

print("task{}:{}".format(i, result))

i += 1

# 运行结果

task1:2

task2:3

task3:1

task4:4

使用 map 方法,无需提前使用 submit 方法,map 方法与 python 高阶函数 map 的含义相同,都是将序列中的每个元素都执行同一个函数。

上面的代码对列表中的每个元素都执行 spider() 函数,并分配各线程池。

可以看到执行结果与上面的 as_completed() 方法的结果不同,输出顺序和列表的顺序相同,就算 1s 的任务先执行完成,也会先打印前面提交的任务返回的结果。

✨ 实战

以某网站为例,演示线程池和单线程两种方式爬取的差异

# coding: utf-8

import requests

from concurrent.futures import ThreadPoolExecutor, as_completed

import time

import json

from requests import adapters

from proxy import get_proxies

headers = {

"Host": "splcgk.court.gov.cn",

"Origin": "https://splcgk.court.gov.cn",

"User-Agent": "Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/71.0.3578.98 Safari/537.36",

"Referer": "https://splcgk.court.gov.cn/gzfwww/ktgg",

}

url = "https://splcgk.court.gov.cn/gzfwww/ktgglist?pageNo=1"

def spider(page):

data = {

"bt": "",

"fydw": "",

"pageNum": page,

}

for _ in range(5):

try:

response = requests.post(url, headers=headers, data=data, proxies=get_proxies())

json_data = response.json()

except (json.JSONDecodeError, adapters.SSLError):

continue

else:

break

else:

return {}

return json_data

def main():

with ThreadPoolExecutor(max_workers=8) as t:

obj_list = []

begin = time.time()

for page in range(1, 15):

obj = t.submit(spider, page)

obj_list.append(obj)

for future in as_completed(obj_list):

data = future.result()

print(data)

print('*' * 50)

times = time.time() - begin

print(times)

if __name__ == "__main__":

main()

运行结果如下:

可以看到,14 页只花了 2 秒钟就爬完了

下面我们可以使用单线程来爬取,代码基本和上面的一样,加个单线程函数

代码如下:

def single():

begin = time.time()

for page in range(1, 15):

data = spider(page)

print(data)

print('*' * 50)

times = time.time() - begin

print(times)

if __name__ == "__main__":

single()

运行结果:

可以看到,总共花了 19 秒。真是肉眼可见的差距啊!如果数据量大的话,运行时间差距会更大!

作者:GoPython

链接:https://www.jianshu.com/p/6d6e4f745c27

来源:简书

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

多种方法实现 python 线程池

最近在做一个爬虫相关的项目,单线程的整站爬虫,耗时真的不是一般的巨大,运行一次也是心累,,,所以,要想实现整站爬虫,多线程是不可避免的,那么python多线程又应该怎样实现呢?这里主要要几个问题(关于python多线程的GIL问题就不再说了,网上太多了)。

一、 既然多线程可以缩短程序运行时间,那么,是不是线程数量越多越好呢?

显然,并不是,每一个线程的从生成到消亡也是需要时间和资源的,太多的线程会占用过多的系统资源(内存开销,cpu开销),而且生成太多的线程时间也是可观的,很可能会得不偿失,这里给出一个最佳线程数量的计算方式:

最佳线程数的获取:

1、通过用户慢慢递增来进行性能压测,观察QPS(即每秒的响应请求数,也即是最大吞吐能力。),响应时间

2、根据公式计算:服务器端最佳线程数量=((线程等待时间+线程cpu时间)/线程cpu时间) * cpu数量

3、单用户压测,查看CPU的消耗,然后直接乘以百分比,再进行压测,一般这个值的附近应该就是最佳线程数量。

二、为什么要使用线程池?

对于任务数量不断增加的程序,每有一个任务就生成一个线程,最终会导致线程数量的失控,例如,整站爬虫,假设初始只有一个链接a,那么,这个时候只启动一个线程,运行之后,得到这个链接对应页面上的b,c,d,,,等等新的链接,作为新任务,这个时候,就要为这些新的链接生成新的线程,线程数量暴涨。在之后的运行中,线程数量还会不停的增加,完全无法控制。所以,对于任务数量不端增加的程序,固定线程数量的线程池是必要的。

三、如何实现线程池?

这里,我分别介绍三种实现方式:

1、过去:

使用threadpool模块,这是个python的第三方模块,支持python2和python3,具体使用方式如下:

#! /usr/bin/env python

# -*- coding: utf-8 -*-

import threadpool

import time

def sayhello (a):

print("hello: "+a)

time.sleep(2)

def main():

global result

seed=["a","b","c"]

start=time.time()

task_pool=threadpool.ThreadPool(5)

requests=threadpool.makeRequests(sayhello,seed)

for req in requests:

task_pool.putRequest(req)

task_pool.wait()

end=time.time()

time_m = end-start

print("time: "+str(time_m))

start1=time.time()

for each in seed:

sayhello(each)

end1=time.time()

print("time1: "+str(end1-start1))

if __name__ == '__main__':

main()

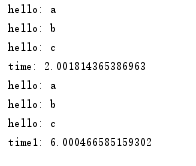

运行结果如下:

threadpool是一个比较老的模块了,现在虽然还有一些人在用,但已经不再是主流了,关于python多线程,现在已经开始步入未来(future模块)了

2、未来:

使用concurrent.futures模块,这个模块是python3中自带的模块,但是,python2.7以上版本也可以安装使用,具体使用方式如下:

#! /usr/bin/env python

# -*- coding: utf-8 -*-

from concurrent.futures import ThreadPoolExecutor

import time

def sayhello(a):

print("hello: "+a)

time.sleep(2)

def main():

seed=["a","b","c"]

start1=time.time()

for each in seed:

sayhello(each)

end1=time.time()

print("time1: "+str(end1-start1))

start2=time.time()

with ThreadPoolExecutor(3) as executor:

for each in seed:

executor.submit(sayhello,each)

end2=time.time()

print("time2: "+str(end2-start2))

start3=time.time()

with ThreadPoolExecutor(3) as executor1:

executor1.map(sayhello,seed)

end3=time.time()

print("time3: "+str(end3-start3))

if __name__ == '__main__':

main()

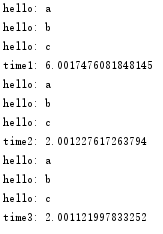

运行结果如下:

注意到一点:

concurrent.futures.ThreadPoolExecutor,在提交任务的时候,有两种方式,一种是submit()函数,另一种是map()函数,两者的主要区别在于:

2.1、map可以保证输出的顺序, submit输出的顺序是乱的

2.2、如果你要提交的任务的函数是一样的,就可以简化成map。但是假如提交的任务函数是不一样的,或者执行的过程之可能出现异常(使用map执行过程中发现问题会直接抛出错误)就要用到submit()

2.3、submit和map的参数是不同的,submit每次都需要提交一个目标函数和对应的参数,map只需要提交一次目标函数,目标函数的参数放在一个迭代器(列表,字典)里就可以。

3.现在?

这里要考虑一个问题,以上两种线程池的实现都是封装好的,任务只能在线程池初始化的时候添加一次,那么,假设我现在有这样一个需求,需要在线程池运行时,再往里面添加新的任务(注意,是新任务,不是新线程),那么要怎么办?

其实有两种方式:

3.1、重写threadpool或者future的函数:

这个方法需要阅读源模块的源码,必须搞清楚源模块线程池的实现机制才能正确的根据自己的需要重写其中的方法。

3.2、自己构建一个线程池:

这个方法就需要对线程池的有一个清晰的了解了,附上我自己构建的一个线程池:

#! /usr/bin/env python

# -*- coding: utf-8 -*-

import threading

import Queue

import hashlib

import logging

from utils.progress import PrintProgress

from utils.save import SaveToSqlite

class ThreadPool(object):

def __init__(self, thread_num, args):

self.args = args

self.work_queue = Queue.Queue()

self.save_queue = Queue.Queue()

self.threads = []

self.running = 0

self.failure = 0

self.success = 0

self.tasks = {}

self.thread_name = threading.current_thread().getName()

self.__init_thread_pool(thread_num)

# 线程池初始化

def __init_thread_pool(self, thread_num):

# 下载线程

for i in range(thread_num):

self.threads.append(WorkThread(self))

# 打印进度信息线程

self.threads.append(PrintProgress(self))

# 保存线程

self.threads.append(SaveToSqlite(self, self.args.dbfile))

# 添加下载任务

def add_task(self, func, url, deep):

# 记录任务,判断是否已经下载过

url_hash = hashlib.new('md5', url.encode("utf8")).hexdigest()

if not url_hash in self.tasks:

self.tasks[url_hash] = url

self.work_queue.put((func, url, deep))

logging.info("{0} add task {1}".format(self.thread_name, url.encode("utf8")))

# 获取下载任务

def get_task(self):

# 从队列里取元素,如果block=True,则一直阻塞到有可用元素为止。

task = self.work_queue.get(block=False)

return task

def task_done(self):

# 表示队列中的某个元素已经执行完毕。

self.work_queue.task_done()

# 开始任务

def start_task(self):

for item in self.threads:

item.start()

logging.debug("Work start")

def increase_success(self):

self.success += 1

def increase_failure(self):

self.failure += 1

def increase_running(self):

self.running += 1

def decrease_running(self):

self.running -= 1

def get_running(self):

return self.running

# 打印执行信息

def get_progress_info(self):

progress_info = {}

progress_info['work_queue_number'] = self.work_queue.qsize()

progress_info['tasks_number'] = len(self.tasks)

progress_info['save_queue_number'] = self.save_queue.qsize()

progress_info['success'] = self.success

progress_info['failure'] = self.failure

return progress_info

def add_save_task(self, url, html):

self.save_queue.put((url, html))

def get_save_task(self):

save_task = self.save_queue.get(block=False)

return save_task

def wait_all_complete(self):

for item in self.threads:

if item.isAlive():

# join函数的意义,只有当前执行join函数的线程结束,程序才能接着执行下去

item.join()

# WorkThread 继承自threading.Thread

class WorkThread(threading.Thread):

# 这里的thread_pool就是上面的ThreadPool类

def __init__(self, thread_pool):

threading.Thread.__init__(self)

self.thread_pool = thread_pool

#定义线程功能方法,即,当thread_1,...,thread_n,调用start()之后,执行的操作。

def run(self):

print (threading.current_thread().getName())

while True:

try:

# get_task()获取从工作队列里获取当前正在下载的线程,格式为func,url,deep

do, url, deep = self.thread_pool.get_task()

self.thread_pool.increase_running()

# 判断deep,是否获取新的链接

flag_get_new_link = True

if deep >= self.thread_pool.args.deep:

flag_get_new_link = False

# 此处do为工作队列传过来的func,返回值为一个页面内容和这个页面上所有的新链接

html, new_link = do(url, self.thread_pool.args, flag_get_new_link)

if html == '':

self.thread_pool.increase_failure()

else:

self.thread_pool.increase_success()

# html添加到待保存队列

self.thread_pool.add_save_task(url, html)

# 添加新任务,即,将新页面上的不重复的链接加入工作队列。

if new_link:

for url in new_link:

self.thread_pool.add_task(do, url, deep + 1)

self.thread_pool.decrease_running()

# self.thread_pool.task_done()

except Queue.Empty:

if self.thread_pool.get_running() <= 0:

break

except Exception, e:

self.thread_pool.decrease_running()

# print str(e)

break

python线程池(threadpool)

一、安装

pip install threadpool

二、使用介绍

(1)引入threadpool模块

(2)定义线程函数

(3)创建线程 池threadpool.ThreadPool()

(4)创建需要线程池处理的任务即threadpool.makeRequests()

(5)将创建的多个任务put到线程池中,threadpool.putRequest

(6)等到所有任务处理完毕theadpool.pool()

import threadpool

def ThreadFun(arg1,arg2):

pass

def main():

device_list=[object1,object2,object3......,objectn]#需要处理的设备个数

task_pool=threadpool.ThreadPool(8)#8是线程池中线程的个数

request_list=[]#存放任务列表

#首先构造任务列表

for device in device_list:

request_list.append(threadpool.makeRequests(ThreadFun,[((device, ), {})]))

#将每个任务放到线程池中,等待线程池中线程各自读取任务,然后进行处理,使用了map函数,不了解的可以去了解一下。

map(task_pool.putRequest,request_list)

#等待所有任务处理完成,则返回,如果没有处理完,则一直阻塞

task_pool.poll()

if __name__=="__main__":

main()

说明:makeRequests存放的是要开启多线程的函数,以及函数相关参数和回调函数,其中回调函数可以不写(默认是无),也就是说makeRequests只需要2个参数就可以运行。

二、代码实例

import time

def sayhello(str): print "Hello ",str time.sleep(2) name_list =['xiaozi','aa','bb','cc']

start_time = time.time() for i in range(len(name_list)): sayhello(name_list[i]) print '%d second'% (time.time()-start_time)

改用线程池代码,花费时间更少,更效率

import time

import threadpool

def sayhello(str):

print "Hello ",str

time.sleep(2)

name_list =['xiaozi','aa','bb','cc']

start_time = time.time()

pool = threadpool.ThreadPool(10)

requests = threadpool.makeRequests(sayhello, name_list)

[pool.putRequest(req) for req in requests]

pool.wait()

print '%d second'% (time.time()-start_time)

当函数有多个参数的情况,函数调用时第一个解包list,第二个解包dict,所以可以这样:

def hello(m, n, o):

""""""

print "m = %s, n = %s, o = %s"%(m, n, o)

if __name__ == '__main__':

# 方法1

lst_vars_1 = ['1', '2', '3']

lst_vars_2 = ['4', '5', '6']

func_var = [(lst_vars_1, None), (lst_vars_2, None)]

# 方法2

dict_vars_1 = {'m':'1', 'n':'2', 'o':'3'}

dict_vars_2 = {'m':'4', 'n':'5', 'o':'6'}

func_var = [(None, dict_vars_1), (None, dict_vars_2)]

pool = threadpool.ThreadPool(2)

requests = threadpool.makeRequests(hello, func_var)

[pool.putRequest(req) for req in requests]

pool.wait()

需要把所传入的参数进行转换,然后带人线程池。

def getuserdic():

username_list=['xiaozi','administrator']

password_list=['root','','abc123!','123456','password','root']

userlist = []

for username in username_list:

user =username.rstrip()

for password in password_list:

pwd = password.rstrip()

userdic ={}

userdic['user']=user

userdic['pwd'] = pwd

tmp=(None,userdic)

userlist.append(tmp)

return userlist

扩展阅读:

Python 多进程 multiprocessing.Pool类详解

浙公网安备 33010602011771号

浙公网安备 33010602011771号