综合设计——多源异构数据采集与融合应用综合实践

| 序号 | 信息类别 | 内容描述 |

|---|---|---|

| 1 | 这个项目属于哪个课程 | 数据采集与融合综合实践 |

| 2 | 组名、项目简介 | 组名:福小兵 项目需求:实时舆情监控系统 项目目标:为福州大学提供舆情监控与决策辅助工具 技术路线:使用 Flask 后端、Memfire(PostgreSQL)数据库和 Vue 前端技术栈,建立从数据采集到情感分析再到可视化的完整系统 |

| 3 | 团队成员学号 | 102202141 黄昕怡, 102202112 刘莹, 102202145 谢含, 102202101 马鑫, 102202106 王强, 102202126 陈家凯, 102202153 来再提·叶鲁别克, 102202124 阿依娜孜·赛日克 |

| 4 | 这个项目的目标 | 设计并实现一个多源异构数据采集系统,通过情感分析和大数据技术总结和展示舆情,增强学校管理者对校园舆情的理解和控制力度。 |

| 5 | 其他参考文献 | [1] 杨宇恒. 基于跨模态预测融合的多模态情感识别方法研究[D]. 西安理工大学, 2024. DOI:10.27398/d.cnki.gxalu.2024.000099. [2] 刘芳, 张强. (2021). 基于多源数据的在线学习情感识别方法研究. 《电子学报》, 49(3), 567-575. [3] Goodfellow, I., Bengio, Y., Courville, A. (2016). Deep Learning. MIT Press. |

🌟 项目概述 🌟

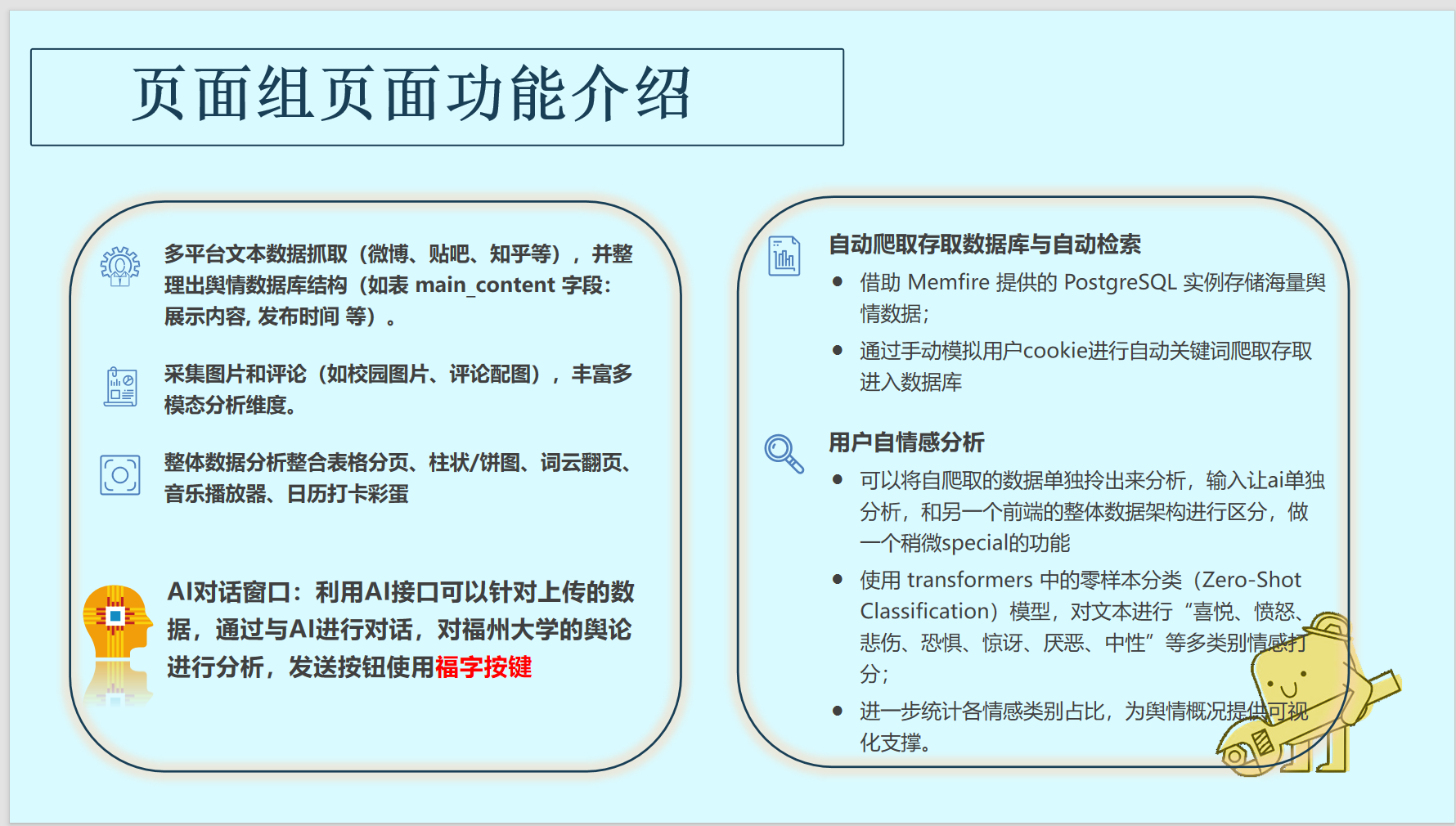

随着互联网和社交媒体的飞速发展,高校的舆情管理已不再是“可有可无”的任务,而是直接关系到学校形象和声誉的关键所在。在微博、贴吧、知乎等平台上,每一条评论、每一张图片都可能成为引发公众关注的“火花”。为了帮助福州大学在信息爆炸的时代里敏锐把握舆情脉动,我们打造了一个专属的智能舆情监测系统。这个系统通过采集微博、知乎、贴吧等多平台的多模态数据,结合深度学习与大语言模型技术,实时分析舆情走向,为校方提供精准的舆论洞察与决策支持,助力学校在舆论场中立于不败之地。

🎯 项目目标 🎯

-

多源数据采集

我们将通过爬虫和API接口从多个平台(微博、知乎、贴吧等)抓取与福州大学相关的文本、图片、视频等信息,并存储到云端数据库,确保所有数据可以高效存储和随时查询。 -

智能情感分析

使用深度学习模型进行情感分析,将舆情分为“喜悦、愤怒、悲伤”等多个情感类别,并统计每种情感的占比。基于这些分析,我们还会调用大语言模型(如GPT-4)生成简洁的舆情总结,帮助校方快速了解当前的热点话题和情绪趋势。 -

实时数据可视化

我们的前端使用Vue框架实现,展示各类情感分析结果、舆情报告和AI生成的总结。系统会通过图表、词云等形式,让舆情分析变得直观、易懂,同时支持交互式搜索,让用户能够深入挖掘数据背后的故事。 -

智能舆情助手

系统还内置一个智能舆情助手,通过与GPT-4模型对话,用户可以直接获取关于福州大学舆论的实时反馈和分析总结。就像一个贴心的舆情专家,帮助校方随时掌握公众的情感变化和舆论走势。

🛠️ 技术架构 🛠️

数据采集与存储

我们通过爬虫和API接口抓取来自微博、知乎、贴吧等平台的内容,所有的舆情数据会存储在Memfire云端PostgreSQL数据库中,确保数据可以灵活、快速地访问与查询。为了全面提升分析效果,我们还会提取图片中的文字信息,进行情感分析。

后端实现

后端采用Flask框架,提供简单易用的API接口。通过集成情感分析模型和大语言模型,后端能够高效处理舆情数据并生成分析报告。爬虫模块会定期抓取数据,确保舆情分析的时效性。

前端展示与互动

前端使用Vue.js和Chart.js构建,支持实时展示情感分析结果、舆情报告和AI生成的总结。通过简洁的界面和互动功能,用户可以快速查询、筛选和分析舆情数据,获得自己关注的信息。系统还提供了聊天式的舆情分析助手,用户可以像和朋友聊天一样,了解最新的舆论动态。

🌈 项目亮点 🌈

-

多模态数据融合

我们不止停留在文字层面,还将图片、视频等多元信息纳入舆情分析,让系统像一个多眼睛的侦探,全面捕捉社交媒体中的每一丝情感波动,给你一张最全的舆情全景图! -

智能化舆情分析

通过零样本分类与大语言模型的强强联手,我们的系统不仅分析得更加精准,还能像有个智慧小助手一样,自动生成报告、给出应对建议,省去了你手动筛选与整理的烦恼,轻松获取最直观的舆情走势。 -

前后端分离,易于维护

前后端分离的设计让整个系统像积木一样简单易扩展,后端的强大与前端的灵活配合默契无间,既确保了高效运作,又方便后期维护和功能拓展,像给你的系统装了一个“未来可升级”的外挂。 -

交互性强,易于使用

系统界面简单、交互性强,借助可视化图表与互动功能,让舆情分析像玩游戏一样直观有趣。即使你不是技术专家,也能轻松上手,迅速掌握数据背后的秘密,让分析不再是“高深莫测”的任务,而是“一眼就能懂”的轻松体验!

👥 个人分工与贡献 👥

在本项目中,我主要负责了数据采集和情感分析的核心模块,特别是在 贴吧 和 微博 的数据抓取、存储优化及情感分析方面做出了重要贡献。以下是我在项目中的具体贡献:

数据采集与爬取:

-

贴吧评论爬取:

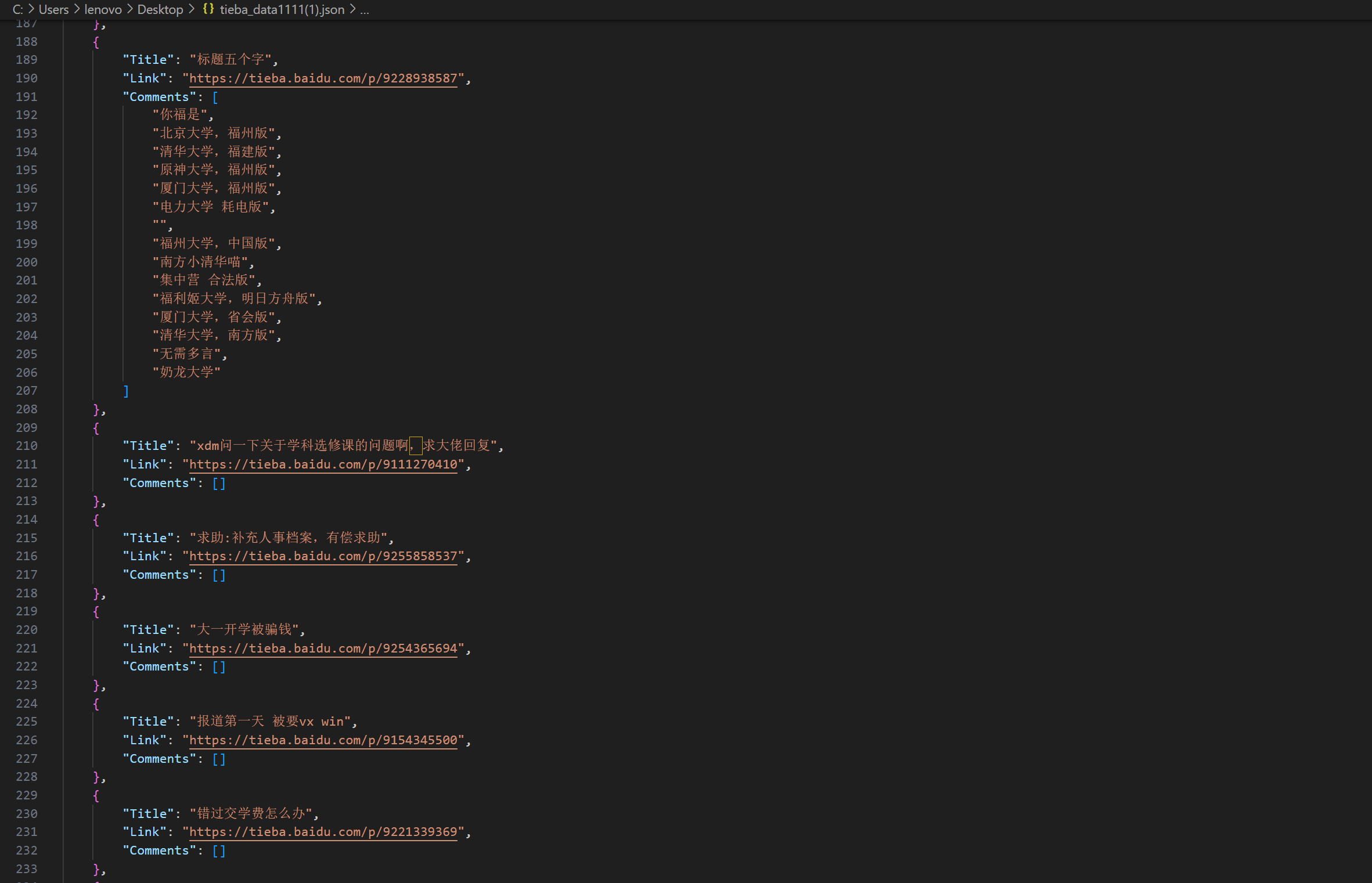

我编写了一个基于 BeautifulSoup 和 requests 的爬虫,负责从 百度贴吧 上抓取与福州大学相关的帖子和评论。在此基础上,我将爬取到的数据进行清洗,并将每个帖子的标题和评论内容以 JSON 格式存储。这种结构化存储方式方便了后续的数据处理和分析,确保了系统可以高效地从数据库中查询相关数据。具体代码流程如下:

- 爬取了 福州大学 相关的帖子,包括帖子的标题和评论。

- 每个帖子和对应的评论内容被保存在一个字典结构中,并最终以 JSON 格式保存,方便后续与其他平台的数据整合。

- 通过设计自动化爬虫任务,确保定期从贴吧抓取更新数据,增强了数据的时效性。

通过这种方式,我们实现了对贴吧平台舆情内容的高效抓取和存储。每个帖子及其评论都以结构化的 JSON 格式存储,便于后续的数据分析与情感识别。

格式如下:

-

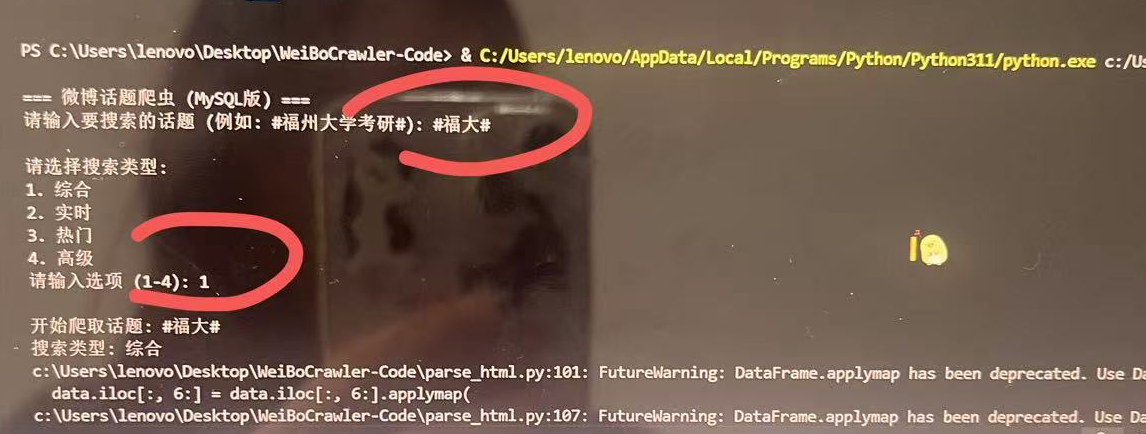

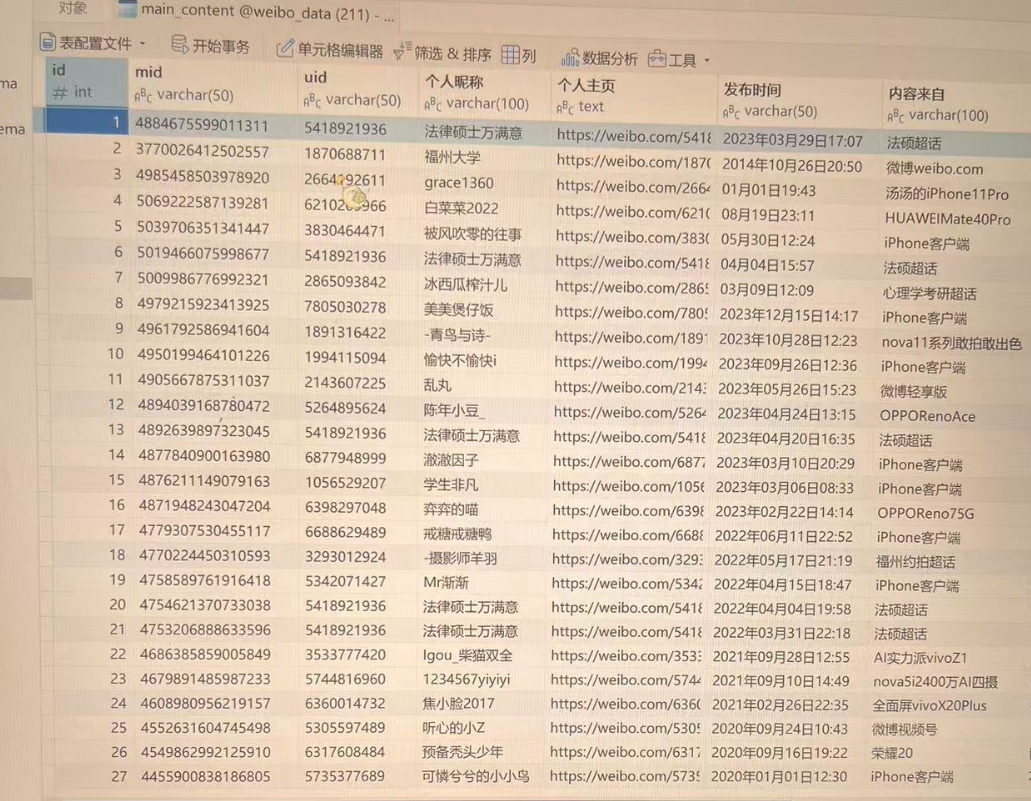

微博数据爬取:

我负责设计和实现了微博话题数据的爬取流程。使用了自定义的爬虫模块,通过输入话题和搜索类型来动态爬取微博的帖子及其评论。具体流程包括:- 话题内容爬取: 利用 cookie 对微博话题进行爬取,获取与指定话题(如 #福州大学考研#)相关的微博主贴内容,包括主贴的发布时间、内容、转发量、点赞量等信息。

- 评论爬取: 在主贴数据抓取的基础上,我还开发了获取微博评论的功能。爬虫能够按层级(一级评论、二级评论)递归抓取评论数据,并将这些评论与对应的微博帖子关联。

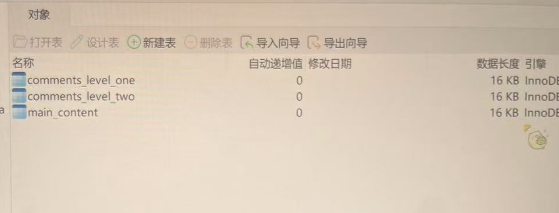

我将爬取到的每个微博话题和评论层级的内容以 CSV 格式保存,同时进行去重处理,确保每条数据都是唯一的。此外,所有爬取到的数据会通过预设的数据库连接存储到 MySQL 数据库中,方便后续的数据分析与展示。

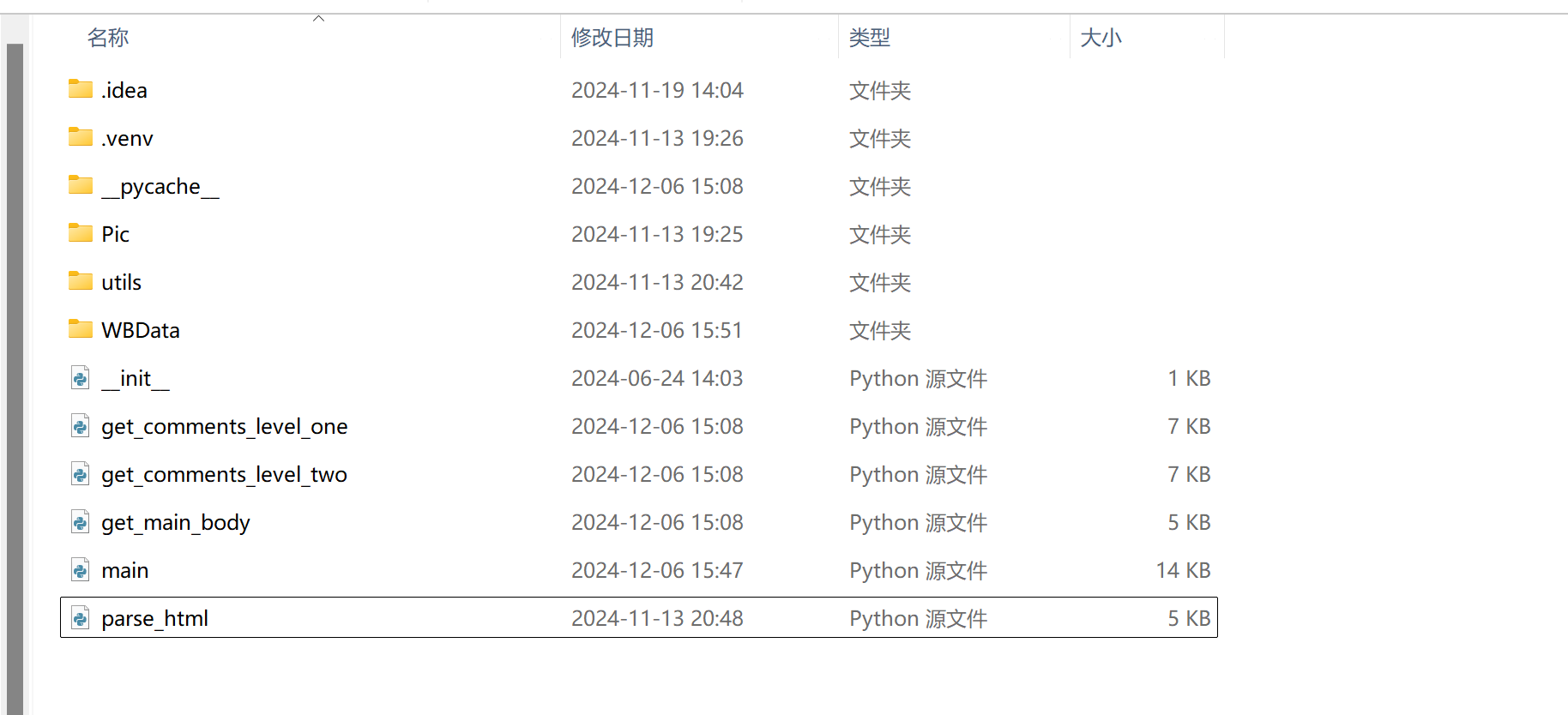

代码架构图如下:

具体代码片段如下:

-

main.py:

点击查看代码

- 微博主体内容爬取:

通过get_main_body函数,抓取指定话题的微博主贴并保存至数据库。

点击查看代码

- 一级评论和二级评论爬取:

通过get_comments_level_one和get_comments_level_two函数,递归抓取评论内容,并存储到本地文件系统和 MySQL 数据库中。

点击查看代码

数据清理与去重:

- 数据清洗:

我设计了数据清洗函数,处理爬取的数据中的不必要列、特殊字符、以及数值列的格式问题。这样确保了存储到数据库中的数据是干净、规范且易于分析的。具体包括:- 移除列名包含 “Unnamed” 的冗余列。

- 对数值列(如“点赞数”、“评论数”)进行格式转换,确保数据能够正确存储。

系统自动化与性能优化:

-

自动化爬取与数据存储:

我设计了一个自动化的微博爬取系统,确保每次启动时能够自动从指定话题中抓取数据并存储到本地和数据库中。同时,我在爬取过程中增加了异常处理和日志记录,确保系统在抓取过程中能够及时发现并处理错误,提升了系统的稳定性和可靠性。- 使用

track函数展示实时抓取进度,提升了爬虫的用户体验。 - 自动创建文件夹结构和 CSV 文件,方便数据存储和管理。

- 使用

终端运行展示:

情感分析与关键词定位:

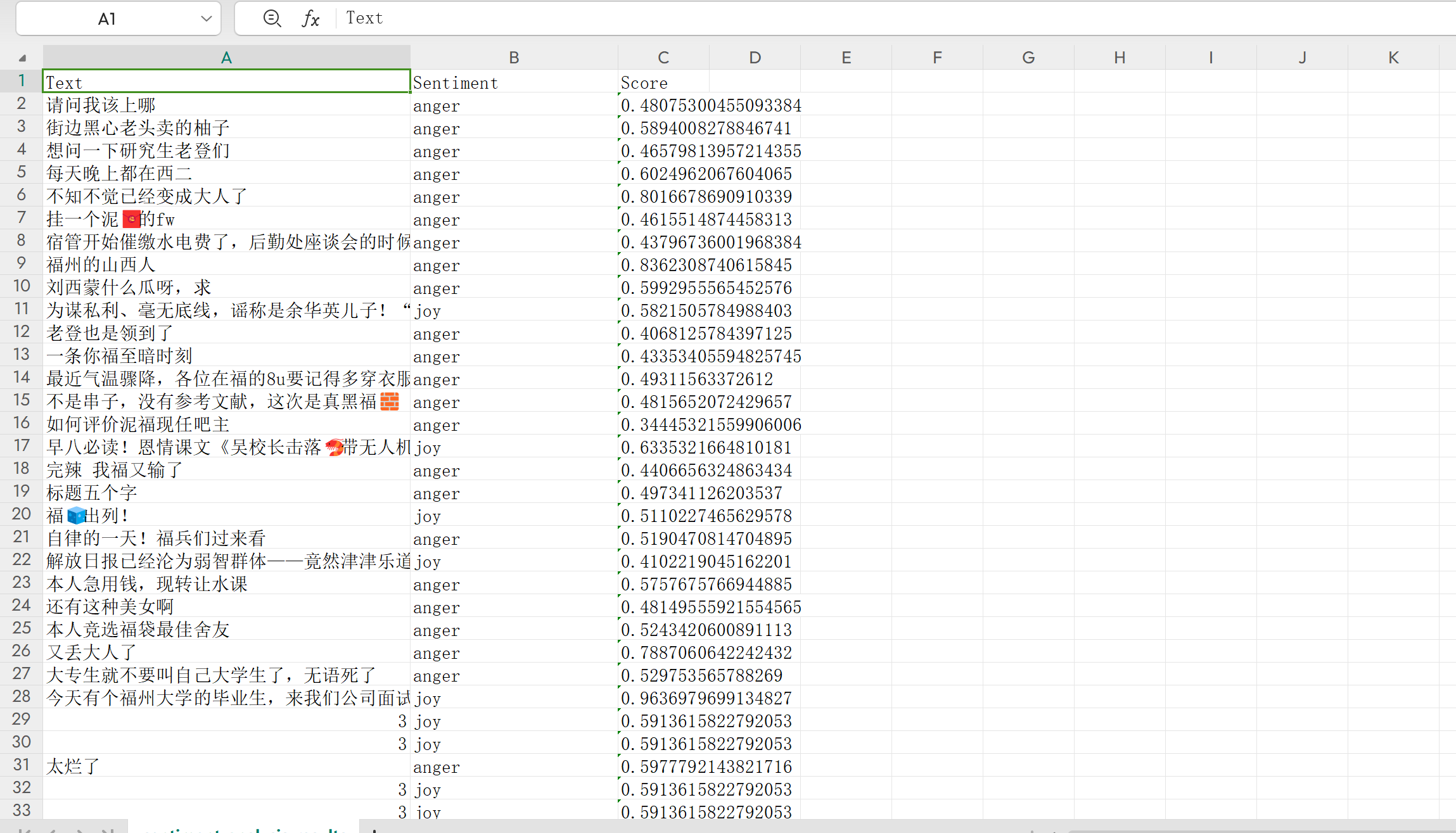

- 情感分析:

我对从 贴吧 和 微博 爬取的文本数据进行情感分析,采用了基于 BERT 模型的情感分类工具(bhadresh-savani/bert-base-uncased-emotion)。这个模型能够对每条评论和帖子标题进行情感分类,包括“喜悦、愤怒、悲伤、恐惧、惊讶、厌恶”等多个情感类别。通过这种分析方式,我能够帮助校方实时了解公众对福州大学的情感态度,为舆情报告的生成提供数据支持。

具体代码如下,结合了 transformers 库和预训练情感分析模型,能够处理 JSON 格式的数据,并自动分析标题和评论的情感倾向:

点击查看代码

在代码实现中:

我使用了 transformers 库中的 BERT 模型对帖子标题和评论内容进行情感分析。

对每一条评论和帖子标题的情感类别(如“喜悦”、“愤怒”、“悲伤”)进行了预测,并记录了相应的情感得分(score)。

最终,我将所有情感分析结果保存为 CSV 文件,方便校方后续分析与展示。

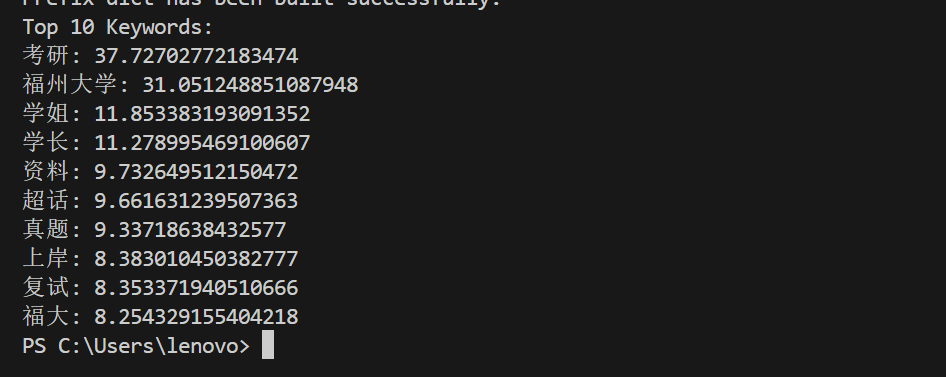

- 关键词定位:

通过 TF-IDF 算法和 jieba 中文分词工具,我成功地提取了微博和贴吧中最具代表性的关键词和话题。该算法通过计算词频和逆文档频率,能够精准识别文本中的高频且具有较高区分度的关键词,从而揭示出当前福州大学舆论场的热点问题。这些关键词不仅帮助我们迅速了解网络舆情的核心内容,还为后续的舆情分析提供了有力支持,确保系统能够高效地识别潜在的舆情风险点。

代码如下:

点击查看代码

结果展示:

通过对福州大学考研相关话题的文本数据进行分析,提取出的前十个高频关键词展示如下。这些关键词反映了社交媒体中讨论的焦点,并为舆情监控和分析提供了可操作的信息。

答辩PPT的制作:

🌟 项目展望 🌟

随着社交媒体对舆情的影响日益加深,福州大学的舆情监测系统将不仅是一个实时数据分析平台,更将成为一个全面智能化的舆论预警工具。未来,我们计划进一步扩展系统的功能,结合更多AI技术与多平台数据源,打破传统的舆情监控方式,提前识别潜在风险,精准预测舆论走势。

-

舆情溯源与传播路径分析

未来的系统将能够追溯舆情事件的起源,分析其在社交媒体上的传播路径。通过识别信息源和影响力人物,我们可以更清晰地看到舆论的扩散过程,帮助校方快速应对并精准干预。 -

多语言支持与国际化扩展

随着学校的国际化步伐加快,系统将支持多语言舆情监测,尤其是在海外社交平台的舆论动态,帮助学校及时了解来自全球范围的舆情影响,做出更加科学的国际化决策。 -

情感预测与危机管理

除了实时情感分析,我们将引入情感预测模块,提前识别潜在的情绪波动趋势,及时提醒校方关注即将出现的舆论危机。通过模拟不同情境下的舆情变化,校方能够更好地进行危机管理和应对策略的制定。 -

智能推荐与策略优化

系统将根据分析结果,结合AI算法,自动为校方推荐应对策略,甚至在必要时给出调整宣传方向、优化社交媒体内容的建议,帮助学校提升舆论管理的效果和效率。

通过这些扩展和优化,福州大学的舆情监测系统将不再仅仅是一个“监控工具”,而是一个智慧决策平台,助力学校在复杂的舆情环境中做出更精准的判断与应对,为学校的形象和声誉保驾护航。

项目总结与感谢 🌟

项目总结:📊

这次舆情监控系统的开发让我收获了很多,也遇到了不少挑战。作为项目的一员,我的主要任务是负责数据采集与融合。整个过程让我更加深入地了解了如何从多个平台(如微博、知乎、贴吧等)抓取数据,并通过合理的方式进行清洗和融合,最终形成可用的数据集。

在数据采集的过程中,我不仅要应对不同平台的反爬虫机制,还需要对抓取到的数据进行预处理。尤其是在处理不同格式的数据时,我深刻体会到数据清洗的重要性。虽然中间遇到了一些技术难题,但通过反复调试和思考,最终都逐步解决了,这让我在技术能力上有了很大的提升。

数据采集与融合的收获 📚

-

数据采集的技巧:

学会了如何通过爬虫技术抓取不同平台的数据,这不仅仅是一个技术操作,更让我意识到每一条数据背后都有其独特的价值和意义。不同平台上的数据格式差异让我更清楚地认识到数据多样性对项目的影响,也让我明白了如何快速高效地抓取并处理这些数据。 -

多源数据的融合:

在项目中,我负责将来自不同平台的数据进行整合,这项工作不仅要求我有较强的技术能力,还需要在处理数据时保持足够的细致。如何将这些数据统一格式,去除无关信息并确保数据准确性,是我在项目中学习到的重要一环。每当看到数据成功融合并形成有意义的信息时,都会有一种成就感。 -

技术的整合与应用:

数据融合并非只是简单地将数据堆叠在一起,更重要的是理解每个数据来源的特点,并通过合适的方式进行整合。这项技能不仅仅是技术操作的提升,更让我更加注重数据的质量与可用性。在解决这些问题时,我不仅学到了如何应对技术难题,也提升了自己在团队协作中的应变能力。

对课程的感悟 💭

这门《数据采集与融合技术实践》课程让我从技术操作中学到了很多,也让我对数据的价值有了更深刻的理解。从数据的抓取到清洗,再到最后的融合分析,整个过程充满了探索与挑战,也让我意识到数据背后的重要性。课程不仅加深了我对数据处理的技术理解,也让我更清晰地认识到在实际项目中如何将这些技术应用于实践。

通过这门课程,我收获了很多实用的技能,也让我对未来在数据分析领域的学习和工作充满了期待。

特别感谢 💖

-

对自己的分工感恩:

感谢自己在数据采集与融合环节的坚持与努力。在这个过程中,我遇到了一些技术难题,但每一次调整和改进都让我更接近解决问题的答案。通过不断摸索,我最终成功地将来自不同平台的数据抓取并高效融合,顺利推动了项目的进展。 -

感谢团队的支持与合作:

非常感谢福卫兵团队中的每一位成员,他们的创意思维与不断坚持让我深感敬佩。我们每个人都在各自的岗位上付出了大量的心血,特别是在面对技术挑战时,团队成员们的帮助和智慧让我倍感温暖。正是大家的共同努力与无私协作,才能让项目在充满挑战的过程中得以顺利推进。🤝💪

3.特别感谢与我一起负责爬取数据的小伙伴 61:

也要特别感谢与我一起负责数据爬取的“61”同学,感谢你在整个数据抓取过程中与我并肩作战!你的技术支持和耐心帮助让我在遇到难题时能迅速找到解决方法。我们共同攻克了一个个技术难关,也因此收获了更多的默契与信任。🌈

__EOF__

本文链接:https://www.cnblogs.com/xingheer/p/18608858.html

关于博主:评论和私信会在第一时间回复。或者直接私信我。

版权声明:本博客所有文章除特别声明外,均采用 BY-NC-SA 许可协议。转载请注明出处!

声援博主:如果您觉得文章对您有帮助,可以点击文章右下角【推荐】一下。您的鼓励是博主的最大动力!

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本

· Manus爆火,是硬核还是营销?

· 终于写完轮子一部分:tcp代理 了,记录一下

· 别再用vector<bool>了!Google高级工程师:这可能是STL最大的设计失误

· 单元测试从入门到精通