kafka集群搭建(图文并用)

将安装包上传服务器并解压

scp kafka_2.11-1.0.0.tgz username@{ip}:~/.

mkdir /usr/local/kafka

mv kafka_2.11-1.0.0.tgz /usr/local/kafka/.

cd /usr/local/kafka

tar zxvf kafka_2.11-1.0.0.tgz

```

# 创建软连接

```

cd /usr/local/kafka

ln -s kafka_2.11-1.0.0 inuse

```

# 配置kafka的环境变量

A:

```

vi /etc/profile

```

B:添加内容:

```

export KAFKA_HOME=/usr/local/kafka/inuse

export PATH=$PATH:$KAFKA_HOME/bin

```

C:重新编译文件:

```

source /etc/profile

```

# 修改三台节点的配置文件

进入kafka的config目录

```

cd /usr/local/kafka/inuse/config

```

修改配置文件server.properties

```

vim server.properties

修改以下配置(如果没有该配置项则手动添加)

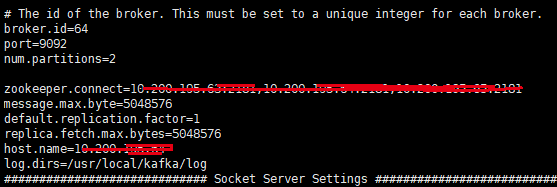

broker.id=25 (kafka节点的标识,多节点的id不允许相同,建议同ip的最末位序号保持一致)

port=9092

num.partitions=2 原先的配置为1

zookeeper.connect={ip1}:{port1},{ip2}:{port2},{ip3}:{port3}(如172.16.204.23:2181,172.16.204.24:2181,172.16.204.25:2181)

message.max.byte=5048576

default.replication.factor=1

replica.fetch.max.bytes=5048576

host.name={本机ip}

log.dirs=/usr/local/kafka/log

kafka3节点的ip,分别填入host.name

最终目录差不多是这样:

新建一个start.sh脚本,见上图。

创建日志目录

```

mkdir /usr/local/kafka/log

```

#启动kafka

```

cd /usr/local/kafka/inuse/bin

./kafka-server-start.sh -daemon ../config/server.properties

kafka集群测试

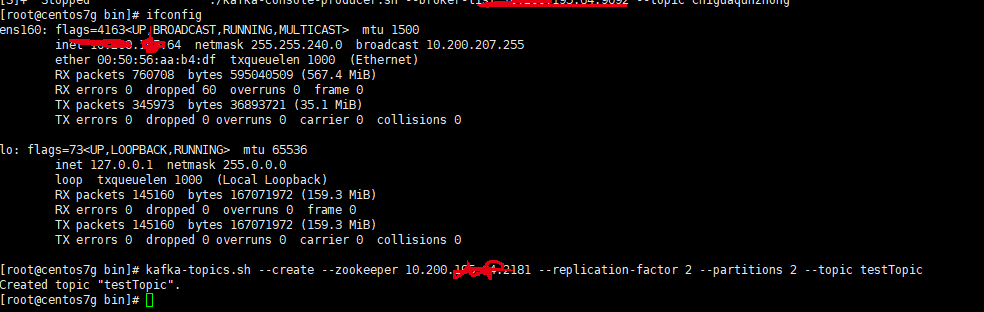

1. 创建一个吃瓜群众的topic

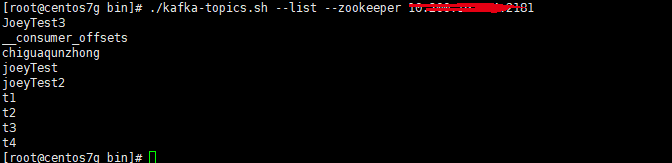

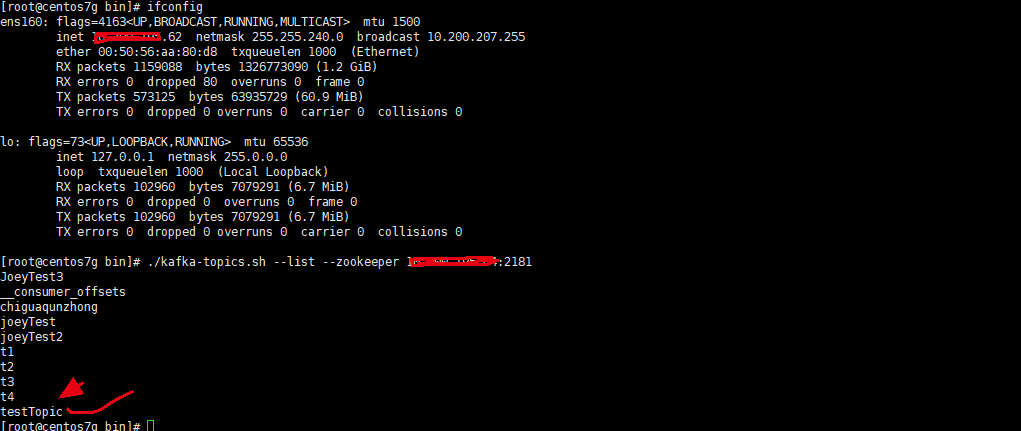

2.查看所有的topic

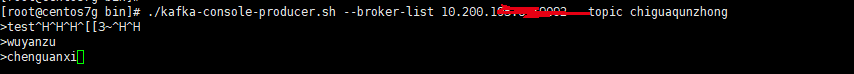

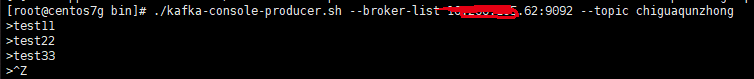

3.在某个topic下如吃瓜群众下 生产消息

此处的broker-list为kafka的服务ip及端口号

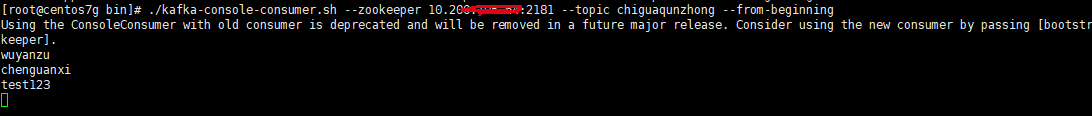

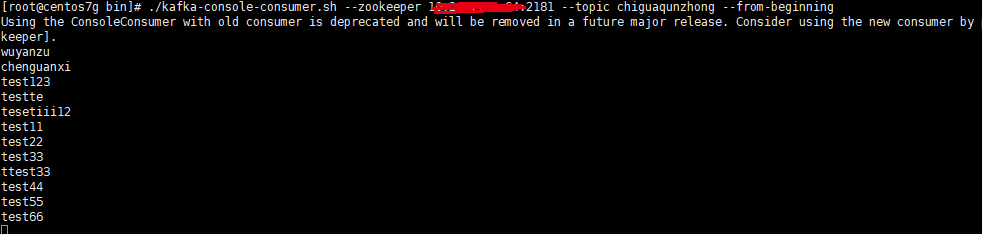

4.消费某个topic消息

我在62,63,64三台机器上安装了kafka集群,在任一台创建的topic,其他两台都能看到,并且都能进行topic消息的消费。

在62机器上直接查看所有topic,zookeeper的地址随意填一个集群内的就行,不用都填,效果都一样

注意点:

不管是生产消息,还是消费消息,kafka的服务地址或zookeeper的地址随意填一个集群内的就行,不用都填,效果都一样。

最后给大家介绍一个工具,kafka-manager,主要可以对集群及topic进行相应的管理。

zookeeper的地址,需要填满,逗号分隔。

详细参考: https://blog.csdn.net/LA7388/article/details/101935535

有任何疑问或有错误,请留言告之,希望能帮助到大家!

如果,您认为阅读这篇博客让您有些收获, 如果,您希望更容易地发现我的新博客,不妨关注一下。因为,我的写作热情也离不开您的肯定支持。

感谢您的阅读,如果您对我的博客所讲述的内容有兴趣,请继续关注我的后续博客。

因为有小孩,兼职卖书,路过的朋友有需要低价购买图书、点读笔、纸尿裤等资源的,可扫最上方二维码,质量有保证,价格很美丽,欢迎咨询! 欢迎关注微信公众号:18般武艺