点云分割网络---Point Transformer V1

PDF: 《Point Transformer》

CODE: https://github.heygears.com/POSTECH-CVLab/point-transformer

一、大体内容

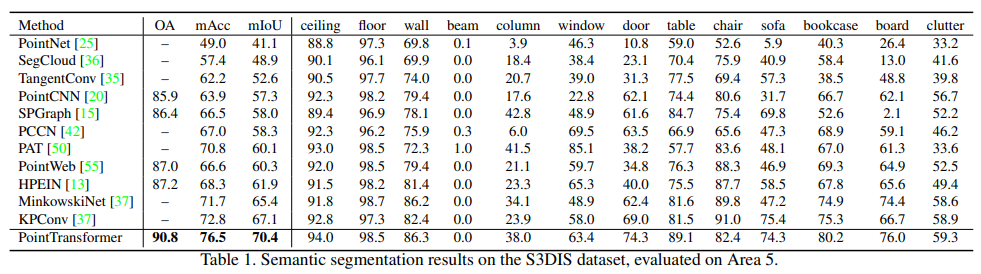

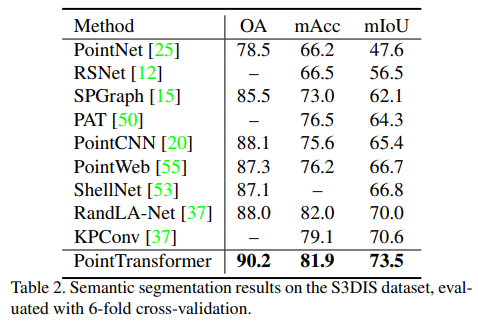

Point Transformer基于自注意力网络实现网络模型的构建。通过设计针对点云的自注意力层,结合位置编码构建Transformer block,利用自注意力机制,实现包括语义分割,部件分割以及识别任务,并取得了不错的效果,如在用于大规模场景分割的具有挑战性的S3DIS数据集上,Point Transformer在区域5上的mIoU达到70.4%,比最强的先前模型高3.3个绝对百分点,并首次超过70%mIoU阈值。

二、贡献点

- 设计了基于点云的自注意力层,自注意力层与顺序无关天然适合处理无序点云数据

- 基于点自注意力层,构建了高性能的点变换器网络,可直接用于点云的分类和密集预测,也可以作为3D场景理解的骨干网络。

三、细节

3.1 Point Transformer Layer

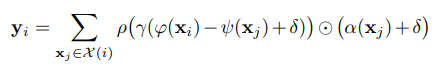

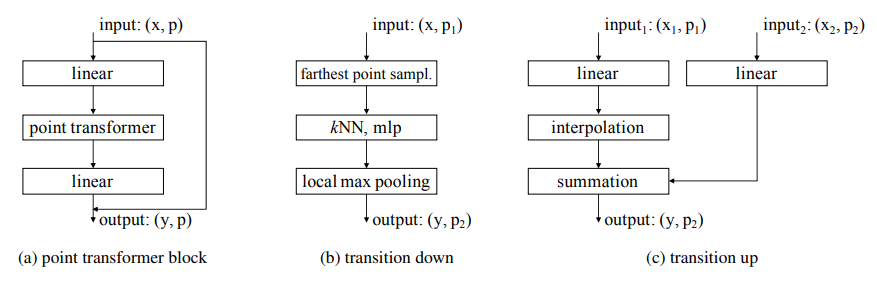

主要用于分析点在其邻域内的自注意力,可以用下式表示:

其中表示输出特征,表示输入特征,表示的邻域, 表示逐点特征变换, 表示位置编码, 表示标准化操作, 表示映射函数。

Point Transformer Layer如下图所示:

3.2 位置编码(Position Encoding)

由于点云坐标本身就可以表示位置信息,所以这里直接对相对坐标进行映射。

这里的映射函数是一个包含两层线性层的MLP和一个Relu层的组合。

3.3 网络结构

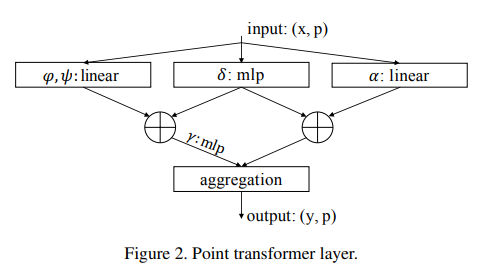

将Point Transformer Layer作为基础算子,然后构建分割网络和分类网络如下:

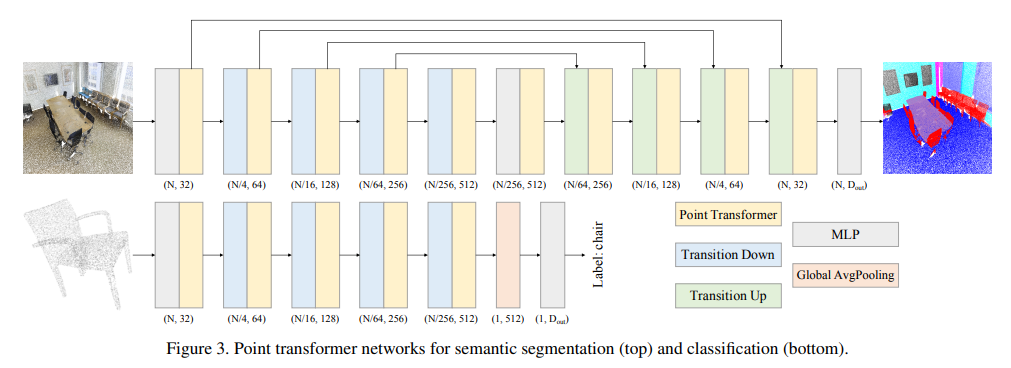

分割网络采用Encoder和Deconder编码结构,而分类网络特征提取后直接接一个线性层输出,point transformer block、transition down和transition up的结构如下:

四、效果

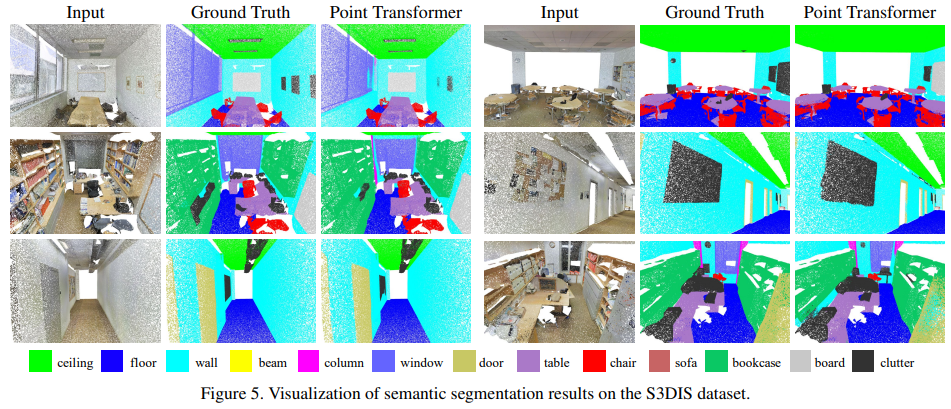

4.1 语义分割

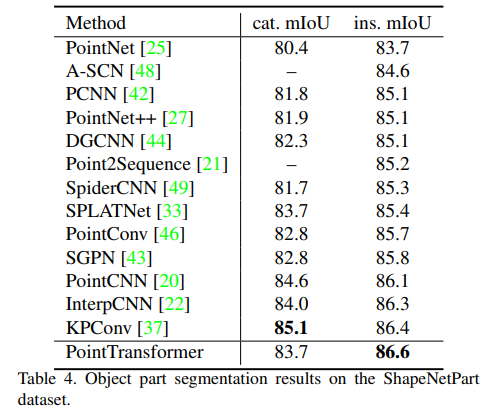

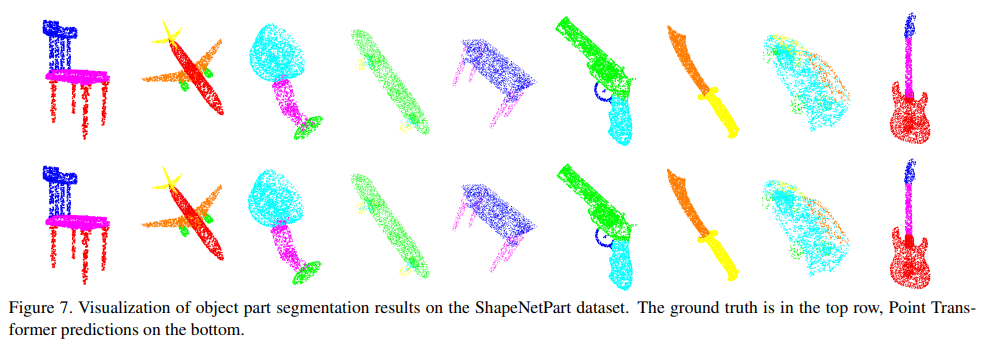

4.2 部件分割

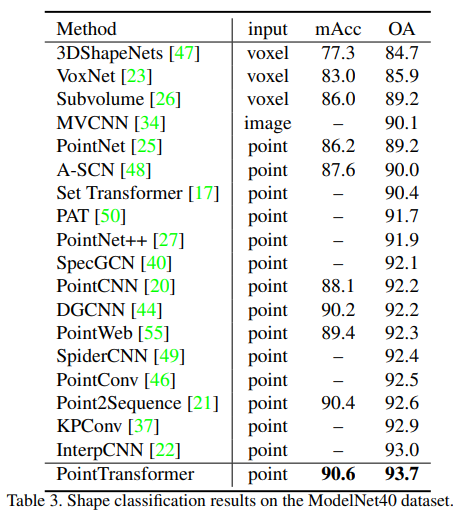

4.3 分类

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 分享一个免费、快速、无限量使用的满血 DeepSeek R1 模型,支持深度思考和联网搜索!

· 基于 Docker 搭建 FRP 内网穿透开源项目(很简单哒)

· ollama系列1:轻松3步本地部署deepseek,普通电脑可用

· 按钮权限的设计及实现

· 25岁的心里话

2022-06-26 draco编译及使用

2017-06-26 MySQL数据库学习笔记----MySQL多表查询之外键、表连接、子查询、索引