机器学习系列(二)——回归模型

一、学习资源:

北京博雅数据酷客平台大讲堂:http://cookdata.cn/auditorium/course_room/10012/

1.线性回归(Linear Regression)

回归是在建模过程中用于分析变量之间的关系、以及变量是如何影响结果的一种技术。线性回归是指全部由线性变量组成的回归模型。例如,最简单的单变量线性回归(Single Variable Linear Regression)是用来描述单个变量和对应输出结果的关系,可以简单的表示成下面的式子:

因为在实际的建模过程中遇到的问题往往更加复杂,用单个变量不能满足描述输出便变量的关系,所以需要用到更多的变量来表示与输出之间的关系,也就是多变量线性回归(Multi Variable Linear Regression)。多变量线性回归模型如下:

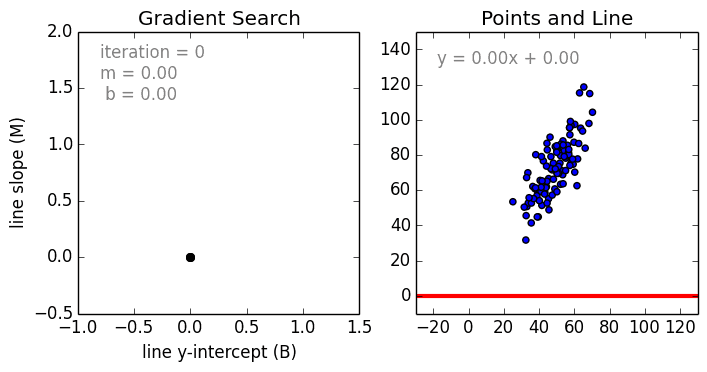

其中a为系数,x是变量,b为偏置。因为这个函数只有线性关系,所以只适用于建模线性可分数据。我们只是使用系数权重来加权每个特征变量的重要性。我们使用随机梯度下降(SGD)来确定这些权重a和偏置b,过程如图所示:

2. 多项式回归(Polynomial Regression)

线性回归适合于线性可分的数据,当我们处理非线性可分的数据时可以使用多项式回归。在这种回归中,我们是要找到一条曲线来拟合数据点,可以表示成下面的式子:

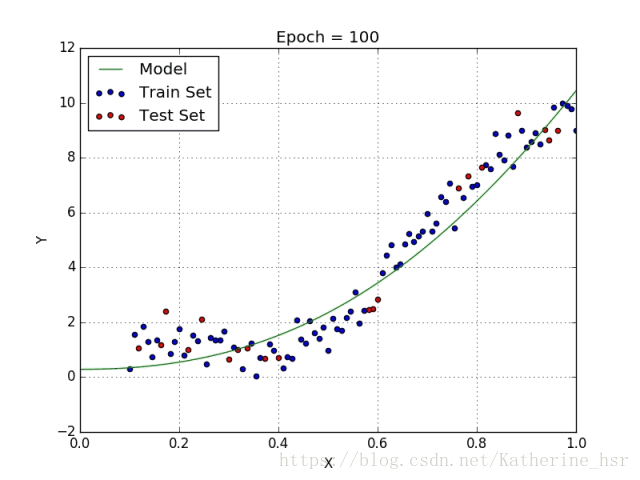

选择每个变量的确切的质数需要当前数据集合与最终输出的一些先验知识。下面两个图描述了线性回归与多项式回归的比较:

3.岭回归(Ridge Regression)

4.Lasso回归

5.弹性网络回归(ElasticNet Regression)