Spark安装及环境配置

本人环境:win10

安装spark环境所需的安装包已经打包好,放在文末的网盘中,只需解压后配置下面步骤中的环境变量即可。

安装包及步骤:

Jdk + 环境变量配置

Hadoop + 环境变量配置

Spark + 环境变量配置

Scala

JDK:

下载官网

根据电脑配置选择要下载的版本,本人下载的是jdk-8u211-windows-x64

环境变量配置

在系统变量中添加:

变量名:JAVA_HOME

变量值:安装路径

如下图所示,D:\spark_home\Java\jdk1.8.0_211是本人jdk的安装路径

在系统变量中添加:

变量名:CLASSPATH

变量值:%JAVA_HOME%\lib

在Path中添加:

%JAVA_HOME%\bin

Hadoop:

下载网址:

本人下载的是hadoop-2.7.5

环境变量配置:

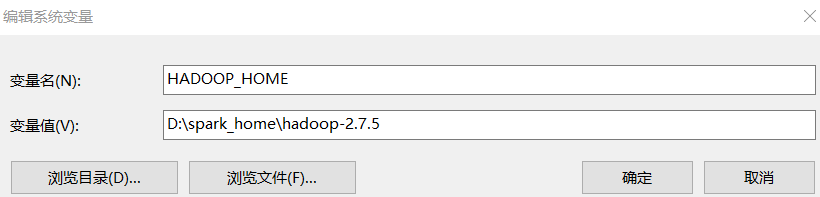

在系统变量中添加:

变量名:HADOOP_HOME

变量值:安装路径

如下图所示:D:\spark_home\hadoop-2.7.5是本人的安装路径

在Path中添加:

%HADOOP_HOME%\bin

用winutils-master中对应版本的bin文件替换掉,hadoop安装文件中的bin文件

winutils-master文件在文末网盘中

Spark

下载官网:

本人下载的是spark-2.4.2-bin-hadoop2.7

环境变量配置:

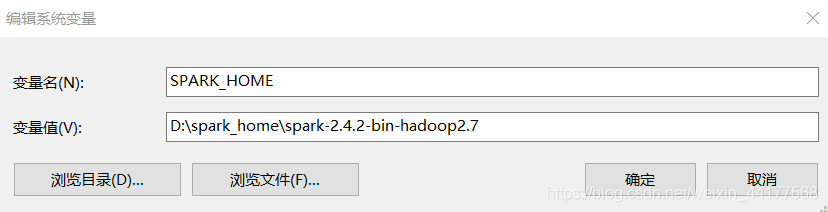

在系统变量中添加:

变量名:SPARK_HOME

变量值:安装路径

如下图所示:D:\spark_home\spark-2.4.2-bin-hadoop2.7是本人的安装路径

在Path中添加:

%SPARK_HOME%\bin

%SPARK_HOME%\sbin

Scala:

下载网址

本人下载的是2.13.3版本的

验证是否安装成功:

重启电脑

win + R:打开cmd,进入命令框

输入:spark-shell

我们可以看到spark安装成功