在使用 docker 的过程中,我们可以使用docker restart {container_id}来重启容器,但是在 kubernetes 中并没有重启命令(没有 kubectl restart {podname}),有时候我们的 Pod 出现 Bug意外终止,导致我们需要重启 Pod ,却没有一个很好的方式,特别是没有 yaml 文件的情况下,所以我总结了以下几种重启 Pod 的方式。

0x01 方法 1

有最新的 yaml 文件。

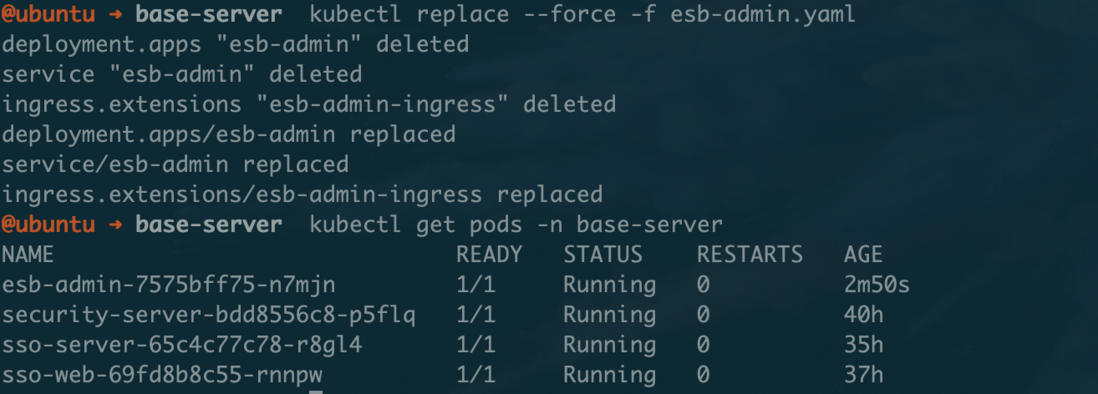

在有 yaml 文件的情况下可以直接使用kubectl replace --force -f xxxx.yaml来强制替换Pod 的 API 对象,从而达到重启的目的。如下图:

0x02 方法 2

没有 yaml 文件,但是使用的是 Deployment 对象。

kubectl scale deployment esb-admin --replicas=0 -n {namespace}kubectl scale deployment esb-admin --replicas=1 -n {namespace}

由于 Deployment 对象并不是直接操控的 Pod 对象,而是操控的 ReplicaSet 对象,而 ReplicaSet 对象就是由副本的数目的定义和Pod 模板组成的。所以这条命令分别是将ReplicaSet 的数量 scale 到 0,然后又 scale 到 1,那么 Pod 也就重启了。

0x03 方法 3

同样没有 yaml 文件,但是使用的是 Deployment 对象。

使用命令kubectl delete pod {podname} -n {namespace}

这个方法就很简单粗暴了,直接把 Pod 删除,因为 Kubernetes 是声明式 API,所以删掉了之后,Pod API 对象就与预期的不一致了,所以会自动重新创建 Pod 保持与预期一致,但是如果ReplicaSet 管理的 Pod 对象很多的话,那么要一个个手动删除,会很麻烦,所以可以使用kubectl delete replicaset {rs_name} -n {namespace}命令来删除 ReplicaSet

0x04 方法 4

没有 yaml 文件,直接使用的 Pod 对象。

使用命令kubectl get pod {podname} -n {namespace} -o yaml | kubectl replace --force -f -

在这种情况下,由于没有 yaml 文件,且启动的是 Pod 对象,那么是无法直接删除或者 scale 到 0 的,但可以通过上面这条命令重启。这条命令的意思是 get 当前运行的 pod 的 yaml声明,并管道重定向输出到 kubectl replace命令的标准输入,从而达到重启的目的。

转自:

https://segmentfault.com/a/1190000020675199?utm_source=tag-newest

浙公网安备 33010602011771号

浙公网安备 33010602011771号