2024-3-19

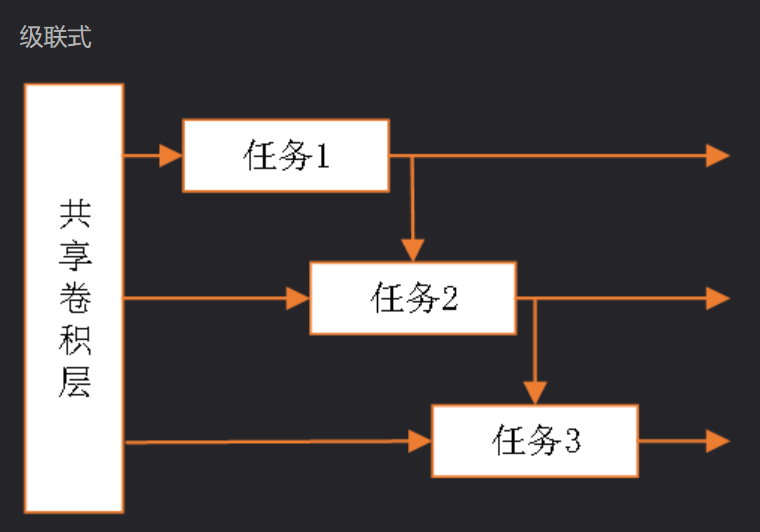

多任务级联

通过级联(即顺序连接)不同的任务来改善整体模型性能。这种方法通常涉及将几个相关的任务组织成一个流水线,其中每个任务的输出都作为下一个任务的输入。多任务级联的核心思想是利用不同任务之间的内在联系和互补信息,以此来增强模型的泛化能力和提高特定任务的精度。

多任务级联网络,来自https://blog.csdn.net/jiebaoshayebuhui/article/details/128258888

深度可分离卷积

https://zhuanlan.zhihu.com/p/166736637/

深度卷积

- Depthwise Convolution:对输入feature map的每个通道分别使用一个卷积核,然后将所有卷积核的输出再进行拼接得到它的最终输出。

逐点卷积

- Pointwise Convolution: 实际为1×1卷积, 将得到的特征进行融合(不是昨天看的论文进行简单的张量拼接了),最终的输出通道为1。

线性瓶颈

- Linear Bottleneck:通常指的是网络中的一个层或模块,它通过减少中间层的维度来压缩信息。这种设计模式常见于轻量级网络架构中,目的是减少计算复杂度和模型参数,同时尽量保留重要信息,如MobileNet中的逐点卷积层。

倒残差结构

先扩展然后再压缩通道数的方式来构建残差模块。这种设计在轻量级网络中尤为有效,因为它能在减少计算复杂度和模型大小的同时,增强特征提取能力。

深度学习的流形是指什么?(from GPT)

一个流形是一个在局部区域内近似为欧几里得空间的空间,这意味着虽然数据的整体结构可能在高维空间中非常复杂,但在小的局部区域内,数据点可以通过较低维度的空间来描述。

- 流形假设

深度学习中的流形假设基于这样一个观点:尽管实际数据(如图像、文本、声音等)可以存在于高维空间中,但它们通常局限在这些高维空间中的某些低维流形上。这是因为真实世界中的数据往往由一些内在的规律或约束所支配,这些规律或约束限制了数据的变化范围,使得数据在本质上不需要用全部的高维空间来表示。

网络退化

随着神经网络层数的增加,网络的训练误差和测试误差反而会增加,导致性能下降的问题。

- 原因:

梯度消失/爆炸:在深层网络中,梯度通过层反向传播时可能变得非常小(消失)或非常大(爆炸),这使得权重难以更新,从而阻碍了网络的学习。

优化困难:深层网络的优化问题可能更加复杂和非凸,找到良好的全局最小值变得更加困难。

参数效率降低:随着层数的增加,模型参数的数量急剧增加,但这些额外的参数并不总能带来性能上的提升,有时甚至会导致性能下降。

浙公网安备 33010602011771号

浙公网安备 33010602011771号