报错

/home/gwxa/workspace/PaddleOCR/deploy/cpp_infer/build/third-party/extern_autolog-src/auto_log/autolog.h:66:27: error: ‘accumulate’ is not a member of ‘std’; did you mean ‘cv::accumulate’?

66 | << std::accumulate(this->time_info_.begin(), this->time_info_.end(), 0);

| ^~~~~~~~~~

In file included from /home/gwxa/workspace/PaddleOCR/deploy/cpp_infer/include/utility.h:17,

from /home/gwxa/workspace/PaddleOCR/deploy/cpp_infer/include/paddleocr.h:17,

from /home/gwxa/workspace/PaddleOCR/deploy/cpp_infer/include/paddlestructure.h:17,

from /home/gwxa/workspace/PaddleOCR/deploy/cpp_infer/src/paddlestructure.cpp:16:

修改cpp_infer/include/utility.h

文件中添加头文件

#include <numeric>

1.编译报错为make[2]: *** 没有规则可制作目标“/home/ceshi/workspace/paddle_inference/third_party/install/onednn/lib/libmkldnn.so.0”,由“ppocr” 需求。

下载paddle编译库但是编译的时候会缺少东西

报错信息为make[2]: *** 没有规则可制作目标“/home/ceshi/workspace/paddle_inference/third_party/install/onednn/lib/libmkldnn.so.0”,由“ppocr” 需求。

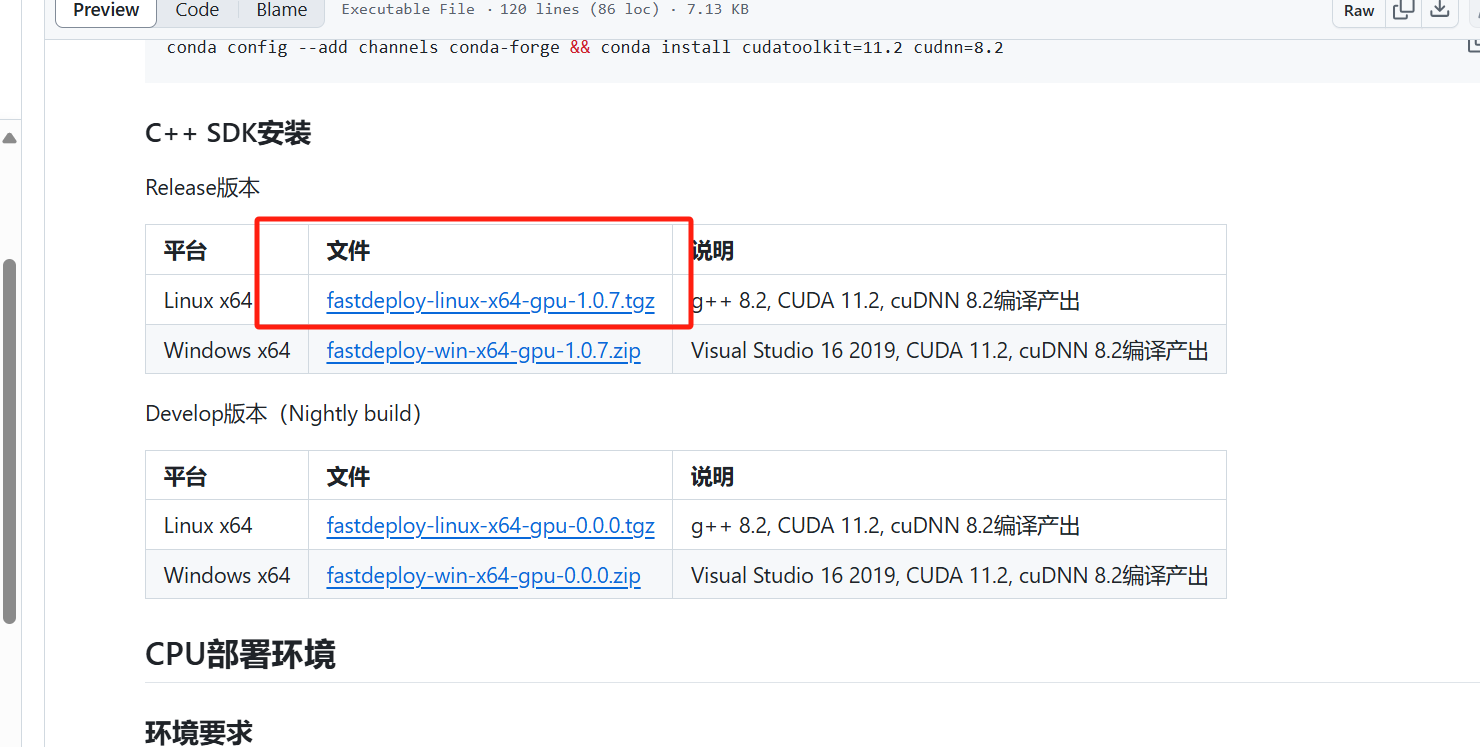

需要去fastdelpy

https://github.com/PaddlePaddle/FastDeploy/blob/develop/docs/cn/build_and_install/download_prebuilt_libraries.md

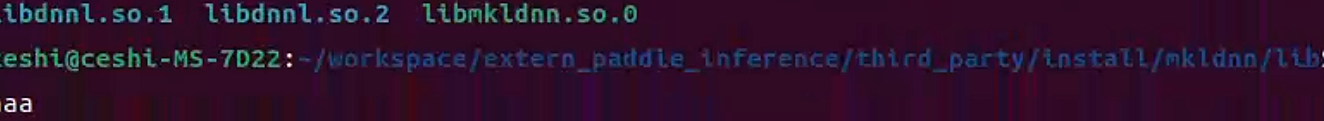

在对应的paddle_infrene中的这个路径下

直接拷贝过去就可以了

2*** 没有规则可制作目标“/lib/libnvinfer.so”,由“ppocr” 需求。

编译缺少trt的依赖,使用下面的编译就可以了最好使用静态库

OPENCV_DIR=/home/ceshi/workspace/opencv347

LIB_DIR=/home/ceshi/workspace/paddle_inference

CUDA_LIB_DIR=/usr/local/cuda-12.3/lib64

CUDNN_LIB_DIR=/usr/local/cuda-12.3/lib64

TENSORRT_DIR=/home/ceshi/opt/TensorRT-8.6.1.6

BUILD_DIR=build

# rm -rf ${BUILD_DIR}

# mkdir ${BUILD_DIR}

cd ${BUILD_DIR}

cmake .. \

-DPADDLE_LIB=${LIB_DIR} \

-DWITH_MKL=ON \

-DWITH_GPU=ON \

-DWITH_STATIC_LIB=OFF \

-DWITH_TENSORRT=ON \

-DOPENCV_DIR=${OPENCV_DIR} \

-DCUDNN_LIB=${CUDNN_LIB_DIR} \

-DCUDA_LIB=${CUDA_LIB_DIR} \

-DTENSORRT_DIR=${TENSORRT_DIR} \

make -j

3

报错

[100%] Linking CXX executable ppocr

/usr/bin/ld: 找不到 -lz: 没有那个文件或目录

/usr/bin/ld: 找不到 -lz: 没有那个文件或目录

collect2: error: ld returned 1 exit status

make[2]: *** [CMakeFiles/ppocr.dir/build.make:333:ppocr] 错误 1

make[1]: *** [CMakeFiles/Makefile2:100:CMakeFiles/ppocr.dir/all] 错误 2

make: *** [Makefile:91:all] 错误 2

Linux中添加

安装 zlib 开发库 Ubuntu/Debian 系统 sudo apt update && sudo apt install zlib1g-dev # 安装动态库和头文件[1,7,8](@ref) 验证安装:检查库文件是否存在: ls /usr/lib/x86_64-linux-gnu/libz.* # 正常应显示 libz.so 和 libz.a

3.报错没有环境变量这个最简单添加环境变量

export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/home/ceshi/workspace/paddle_inference/third_party/install/onednn/lib:/home/ceshi/workspace/paddle_inference/third_party/install/mklml/lib

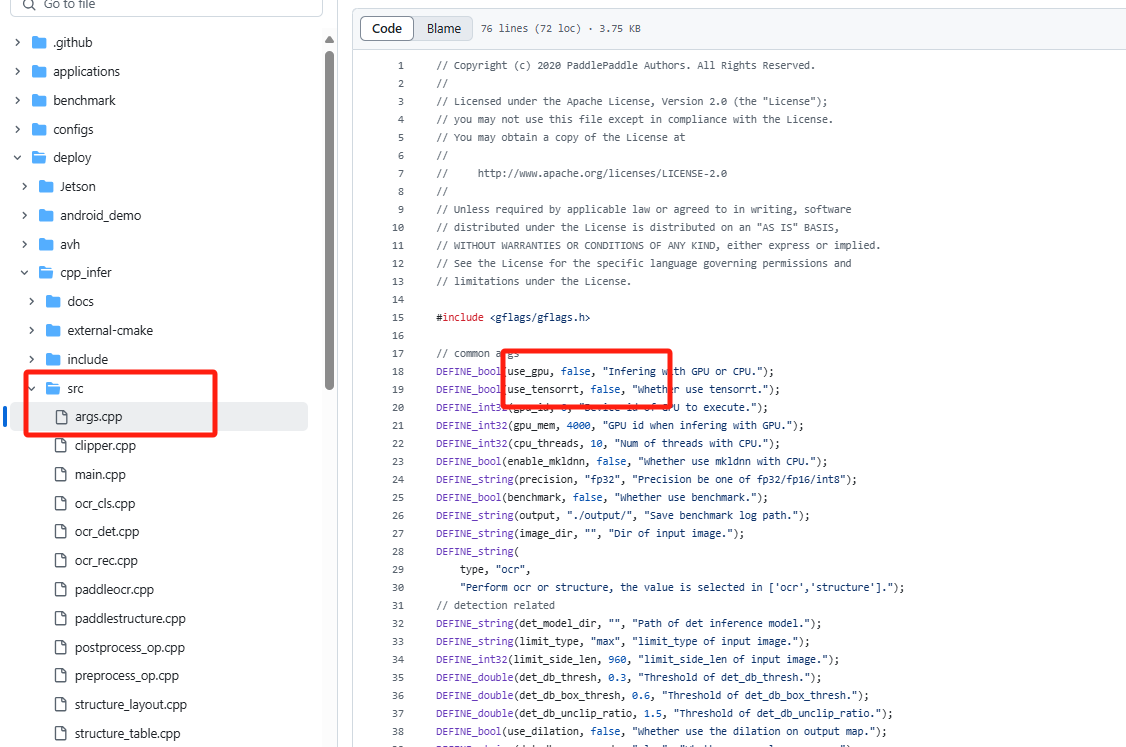

4.没用使用上GPU

需要更改代码对应位置改为true

浙公网安备 33010602011771号

浙公网安备 33010602011771号