互信息 Mutual Information

互信息的定义

它度量知道这两个变量其中一个,对另一个变量不确定性减少的程度

互信息的定义式:

这不就跟KL散度一样的形式了吗,没错

通过考察联合概率分布与边缘概率分布乘积之间的KL散度来判断它们是否“接近”于相互独立

当X和Y相互独立时: \(H(X|Y) =H(X), \ I(Y;X)=0\)。 从一个事件不能得到另一个事件的任何信息

性质

对称性

由Y提取到的关于X的信息量与从X中提取到的关于Y的信息量是一样的。\(I(X;Y)\)和\(I(Y;X)\)只是观察者的立足点不同。

非负性

可以从KL散度的性质推出

从一个事件提取关于另一个事件的信息, 最坏的情况是0,也就是当\(X,Y\)独立时,\(I(X;Y)=0\), 不会由于知道了一个事件,反而使另一个事件的不确定度增加。

极值性

从一个事件提取关于另一个事件的信息量, 至多是另一个事件的熵那么多, 不会超过另一个事件自身所含的信息量

当X和Y是一一对应关系时: \(I(X;Y)=H(X)\), 这时\(H(X|Y)=0\)。从一个事件可以充分获得关于另一个事件的信息, 从平均意义上来说, 代表信源的信息量可全部通过信道。

当X和Y相互独立时: \(H(X|Y) =H(X), I(Y;X)=0\)

当X和Y随机变量相同时:互信息最大化,可以认为从数据集中拟合出来的随机变量的概率分布与真实分布相同

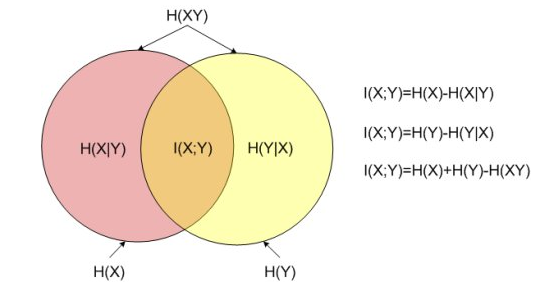

与其他熵的关系

其中\(H(X)\)和\(H(Y)\)是边缘熵,也就是\(X,Y\)自身的信息熵,\(H(X|Y)\)和\(H(Y|X)\)是条件熵,而\(H(X,Y)\)是\(X\)和\(Y\)的联合熵

给出\(I(X;Y)=H(Y)-H(Y|X)\)的详细推导

\(I(X;Y)=H(Y)-H(Y|X)\)可以解释为:\(Y\)的不确定度,减去在\(X\)已知之后\(Y\)的剩余不确定度的量

这证实了互信息的直观意义为知道其中一个变量提供的另一个的信息量(即不确定度的减少量)

与KL散度的关系

分布\(p(x|y)\)和\(p(x)\)之间的平均差异越大,信息增益越大