Azkaban介绍与使用

本文基于尚硅谷Azkaban 资料整理而来

1. Azkaban是一个工作流调度工具

常见的工作流调度工具有Ooize、Azkaban、airflow、DolphinScheduler等。

Ooize 相比 Azkaban 是一个重量级的任务调度系统,功能全面,但配置使用

也更复杂。如果可以不在意某些功能的缺失,轻量级调度器 Azkaban 是很不错的候选对象。

2. 集群模式安装部署(3.84.4版本)

- 集群模式是一个Web多个Executor的方式,这里准备三台服务器hadoop102、hadoop103、hadoop104 以及一个MySQL数据库服务

- 上传安装包以及配置MySQL

将 azkaban-db-3.84.4.tar.gz,azkaban-exec-server-3.84.4.tar.gz,azkaban-web-

server-3.84.4.tar.gz 上传到 hadoop102 的/opt/software 路径

[root@hadoop102 software]$ ll 总用量 35572 -rw-r--r--. 1 root root 6433 4月 18 17:24 azkaban-db- 3.84.4.tar.gz -rw-r--r--. 1 root root 16175002 4 月 18 17:26 azkaban-exec- server-3.84.4.tar.gz -rw-r--r--. 1 root root 20239974 4 月 18 17:26 azkaban-web- server-3.84.4.tar.gz

新建/opt/module/azkaban 目录,并将所有 tar 包解压到这个目录下

解压azkaban-db-3.84.4.tar.gz、 azkaban-exec-server-3.84.4.tar.gz和azkaban- web-server-3.84.4.tar.gz 到/opt/module/azkaban 目录下

[root@hadoop102 software]$ tar -zxvf azkaban-db-3.84.4.tar.gz - C /opt/module/azkaban/ [root@hadoop102 software]$ tar -zxvf azkaban-exec-server- 3.84.4.tar.gz -C /opt/module/azkaban/ [root@hadoop102 software]$ tar -zxvf azkaban-web-server- 3.84.4.tar.gz -C /opt/module/azkaban/

进入到/opt/module/azkaban 目录,依次修改名称

[root@hadoop102 azkaban]$ mv azkaban-exec-server-3.84.4/ azkaban-exec [root@hadoop102 azkaban]$ mv azkaban-web-server-3.84.4/ azkaban-web

配置MySQL

登陆 MySQL,创建 Azkaban 数据库,创建 azkaban 用户并赋予权限。这里对数据库密码策略做了简化设置,生产环境不建议这样做。

最后 刷Azkaban数据库初始化脚本。

mysql> create database azkaban; mysql> set global validate_password_length=4; mysql> set global validate_password_policy=0; mysql> CREATE USER 'azkaban'@'%' IDENTIFIED BY '000000'; mysql> GRANT SELECT,INSERT,UPDATE,DELETE ON azkaban.* to 'azkaban'@'%' WITH GRANT OPTION; mysql> use azkaban; mysql> source /opt/module/azkaban/azkaban-db-3.84.4/create-all- sql-3.84.4.sql mysql> quit;

更改MySQL数据库服务的包大小限制,改完后重启MySQL服务

[root@hadoop102 software]$ sudo vim /etc/my.cnf # 在[mysqld]下面加一行 max_allowed_packet=1024M [mysqld] max_allowed_packet=1024M

- 配置Executor Server

编辑 azkaban.properties

[root@hadoop102 azkaban]$ vim /opt/module/azkaban/azkaban- exec/conf/azkaban.properties # 修改以下属性的值 default.timezone.id=Asia/Shanghai azkaban.webserver.url=http://hadoop102:8081 executor.port=12321 mysql.host=hadoop102 mysql.password=000000

同步 azkaban-exec 到所有节点,前提在103、104上创建目录/opt/module/azkaban/

scp -r /opt/module/azkaban/azkaban-exec root@hadoop103:/opt/module/azkaban/ scp -r /opt/module/azkaban/azkaban-exec root@hadoop104:/opt/module/azkaban/

必须进入到/opt/module/azkaban/azkaban-exec 路径,分别在三台机器上,启动 executor server,不进到这个目录启动很容易出现启动后配置以及页面有问题(好多配置使用的相对路径)。

[root@hadoop102 azkaban-exec]$ bin/start-exec.sh [root@hadoop103 azkaban-exec]$ bin/start-exec.sh [root@hadoop104 azkaban-exec]$ bin/start-exec.sh

如果在/opt/module/azkaban/azkaban-exec 目录下出现 executor.port 文件,说明 启动成功

激活executor

[root@hadoop102 azkaban-exec]$ curl -G "hadoop102:12321/executor?action=activate" && echo [root@hadoop103 azkaban-exec]$ curl -G "hadoop103:12321/executor?action=activate" && echo [root@hadoop104 azkaban-exec]$ curl -G "hadoop104:12321/executor?action=activate" && echo # 如果全部返回,下面内容则代表激活成功 {"status":"success"}

- 配置Web Server

Azkaban Web Server 处理项目管理,身份验证,计划和执行触发。(题外话:这个web单节点在生产遇到过挂掉,真个定时触发都没执行)

编辑 azkaban.properties

default.timezone.id=Asia/Shanghai mysql.host=hadoop102 mysql.password=000000 azkaban.executorselector.filters=StaticRemainingFlowSize,CpuStatus

StaticRemainingFlowSize:正在排队的任务数

CpuStatus:CPU 占用情况

MinimumFreeMemory:内存占用情况。MinimumFreeMemory过滤器会检查executor主机空余内存是否会大于6G,如果不足6G,则web-server不会将任务交由该主机执行

修改 azkaban-users.xml 文件,可以添加用户和修改用户密码,这里不做修改,使用默认的azkaban/azkaban

必须进入到 /opt/module/azkaban/azkaban-web 路径,启动 web server

[root@hadoop102 azkaban-web]$ bin/start-web.sh

访问 http://hadoop102:8081,并用 azkaban 用户登陆

3. Work Flow 示例

- 演示输出hello world 简单工作流

创建文件azkaban.project文件,指定使用的语法版本,azkaban 前面版本的工作流配置语法跟现在有所不同的。现在采用的yaml语法

azkaban-flow-version: 2.0

创建basic.flow文件,内容如下

nodes: - name: jobA type: command config: command: echo "Hello World"

将两个文件压缩为一个zip文件,文件名必须是英文的。

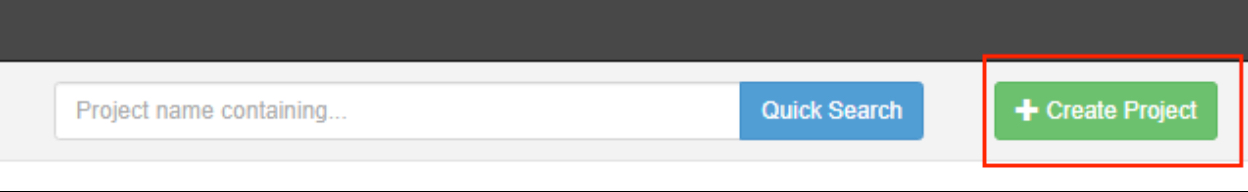

打开azkaban页面创建一个project,输入项目名称以及描述,这里也全部最好输入英文

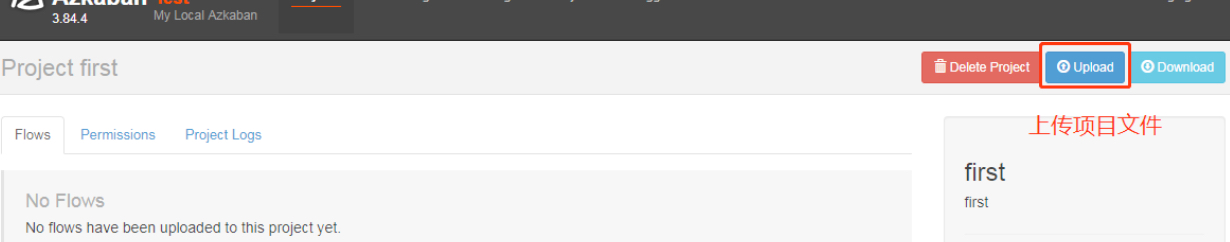

创建完成后,选择上传文件

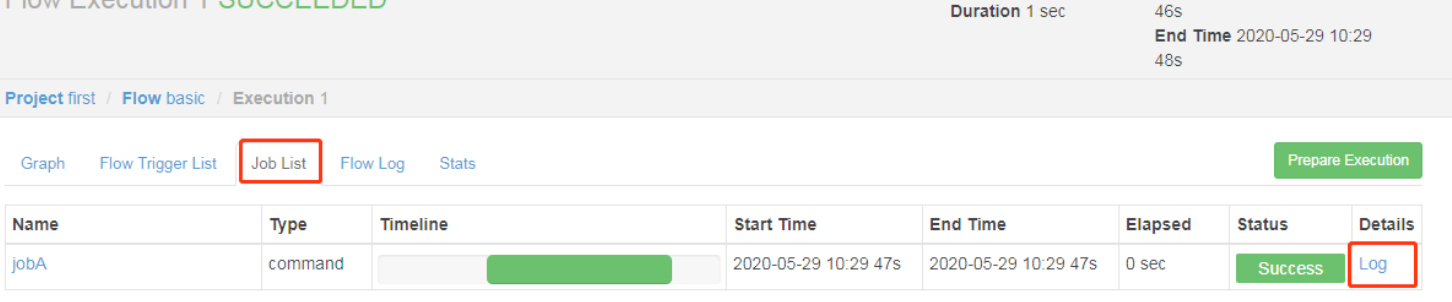

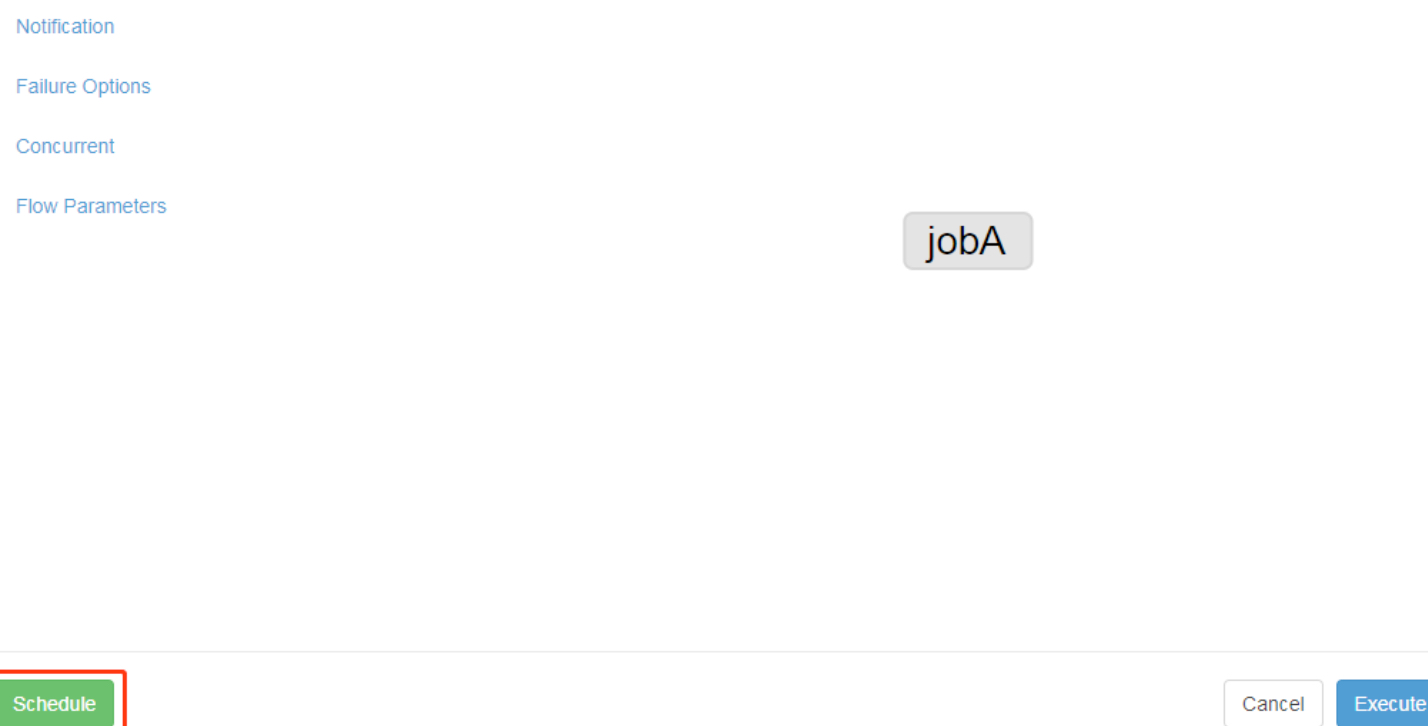

选择上传刚才的zip文件,如果文件没有语法或者其他问题,回来到下面页面,解析后的工作流。点击Execute Flow --> Execute 按钮执行工作流

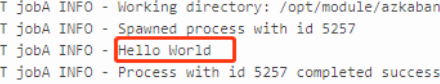

执行完后可以在日志那边看到执行结果了

日志中看到输出

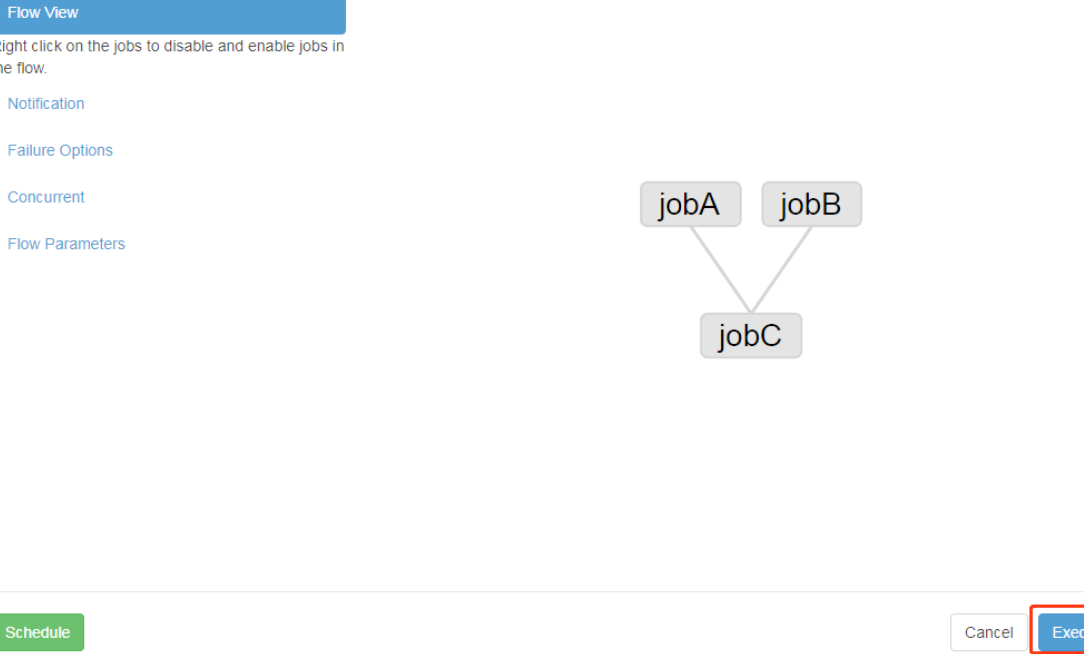

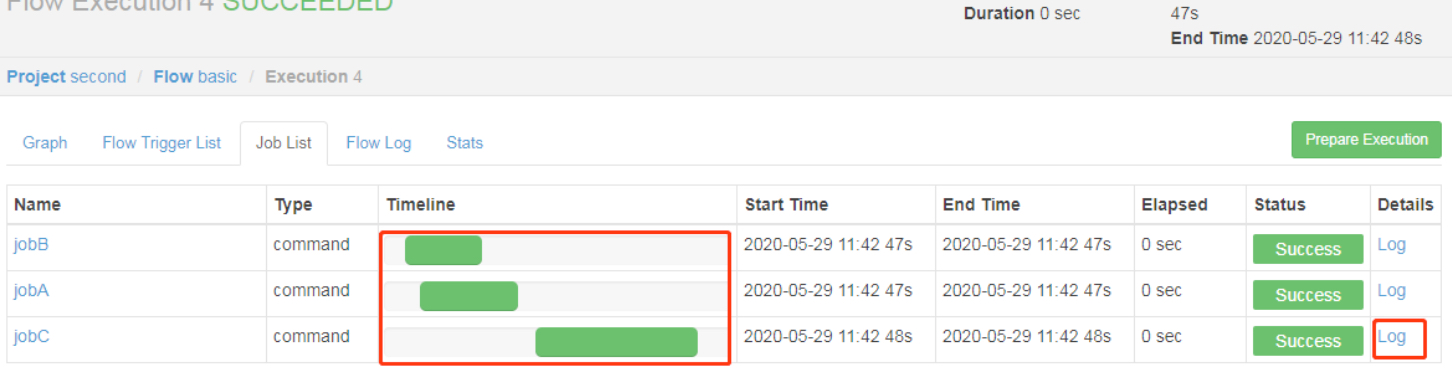

- 作业依赖示例

需求:JobA 和 JobB 执行完了,才能执行 JobC

修改 basic.flow 为如下内容

nodes: - name: jobC type: command # jobC 依赖 JobA 和 JobB dependsOn: - jobA - jobB config: command: echo "I’m JobC" - name: jobA type: command config: command: echo "I’m JobA" - name: jobB type: command config: command: echo "I’m JobB"

同上一个示例,压缩成zip文件,并且azkaban上创建一个project,名字为second 上传文件并执行

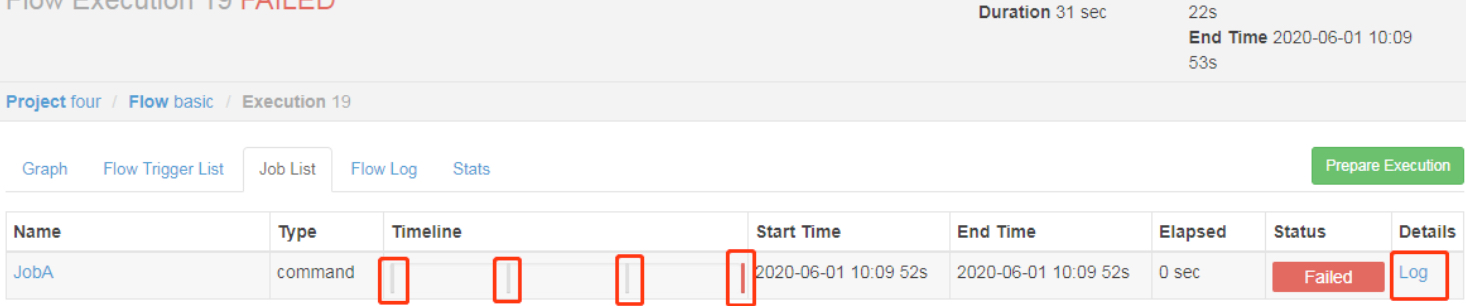

- 自动失败重试

如果执行任务失败,需要重试 3 次,重试的时间间隔 10000ms

编辑flow文件

nodes: - name: JobA type: command config: command: sh /not_exists.sh retries: 3 retry.backoff: 10000

参数说明:

retries:重试次数

retry.backoff:重试的时间间隔

也可以在 Flow 全局配置中添加任务失败重试配置,此时重试配置会应用到所有 Job

config: retries: 3 retry.backoff: 10000 nodes: - name: JobA type: command config: command: sh /not_exists.sh

- 手动失败重试

需求:JobA ---> JobB ---> JobC ---> JobD ---> JobE ---> JobF。生产环境,任何 Job 都 有可能挂掉,可以根据需求执行想要执行的 Job。

flow 文件

nodes: - name: JobA type: command config: command: echo "This is JobA." - name: JobB type: command dependsOn: - JobA config: command: echo "This is JobB." - name: JobC type: command dependsOn: - JobB config: command: echo "This is JobC." - name: JobD type: command dependsOn: - JobC config: command: echo "This is JobD." - name: JobE type: command dependsOn: - JobD config: command: echo "This is JobE." - name: JobF type: command dependsOn: - JobE config: command: echo "This is JobF."

创建project并上传flow后

选择 需要执行的步骤

Enable 和 Disable 下面都分别有如下参数:

Parents:该作业的上一个任务

Ancestors:该作业前的所有任务

Children:该作业后的一个任务

Descendents:该作业后的所有任务

Enable All:所有的任务

- JavaProcess作业类型

JavaProcess 类型可以运行一个自定义主类方法,type 类型为 javaprocess

可用的配置有以下:

Xms:最小堆

Xmx:最大堆

classpath:类路径

java.class:要运行的 Java 对象,其中必须包含 Main 方法 main.args:main 方法的参数

新建一个 azkaban 的 maven 工程,创建包名:com.example 创建 AzTest 类

package com.example; public class AzTest { public static void main(String[] args) { System.out.println("This is for testing!"); } }

创建flow文件,内容如下

nodes: - name: test_java type: javaprocess config: Xms: 96M Xmx: 200M java.class: com.example.AzTest

创建project并上传zip文件,执行即可

- 条件工作流

条件工作流功能允许用户自定义执行条件来决定是否运行某些 Job。条件可以由当前 Job 的父 Job 输出的运行时参数构成,也可以使用预定义宏。在这些条件下,用户可以在确定 Job 执行逻辑时获得更大的灵活性,例如,只要父 Job 之一成功,就可以运行当前 Job。

原理:

父 Job 将参数写入 JOB_OUTPUT_PROP_FILE 环境变量所指向的文件

子 Job 使用 ${jobName:param}来获取父 Job 输出的参数并定义执行条件

支持的运算符:

(1)== 等于(2)!= 不等于 (3)> 大于 (4)>= 大于等于 (5)< 小于 (6)<= 小于等于 (7)&& 与 (8)|| 或 (9)! 非

需求:

JobA 执行一个 shell 脚本。

JobB 执行一个 shell 脚本,但 JobB 不需要每天都执行,而只需要每个周一执行。

JobA.sh

#!/bin/bash echo "do JobA" wk=`date +%w` echo "{\"wk\":$wk}" > $JOB_OUTPUT_PROP_FILE

JobB.sh

#!/bin/bash echo "do JobB"

condition.flow

nodes: - name: JobA type: command config: command: sh JobA.sh - name: JobB type: command dependsOn: - JobA config: command: sh JobB.sh condition: ${JobA:wk} == 1

- 预定义宏

Azkaban 中预置了几个特殊的判断条件,称为预定义宏。

预定义宏会根据所有父 Job 的完成情况进行判断,再决定是否执行。可用的预定义宏如 下:

(1)all_success: 表示父 Job 全部成功才执行(默认)

(2)all_done:表示父 Job 全部完成才执行

(3)all_failed:表示父 Job 全部失败才执行

(4)one_success:表示父 Job 至少一个成功才执行

(5)one_failed:表示父 Job 至少一个失败才执行

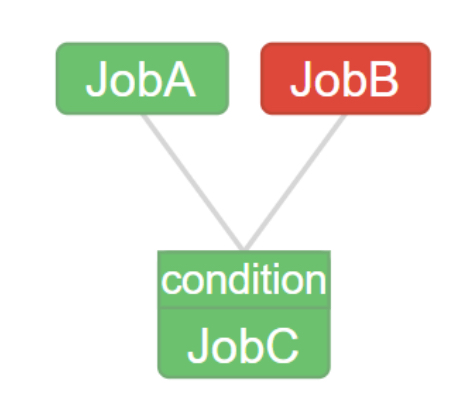

需求:

JobA 执行一个 shell 脚本

JobB 执行一个 shell 脚本

JobC 执行一个 shell 脚本,要求 JobA、JobB 中有一个成功即可执行

JobA.sh

#!/bin/bash echo "do JobA"

JobC.sh

#!/bin/bash echo "do JobC"

macro.flow

nodes: - name: JobA type: command config: command: sh JobA.sh - name: JobB type: command config: command: sh JobB.sh - name: JobC type: command dependsOn: - JobA - JobB config: command: sh JobC.sh condition: one_success

注意:没有 JobB.sh。

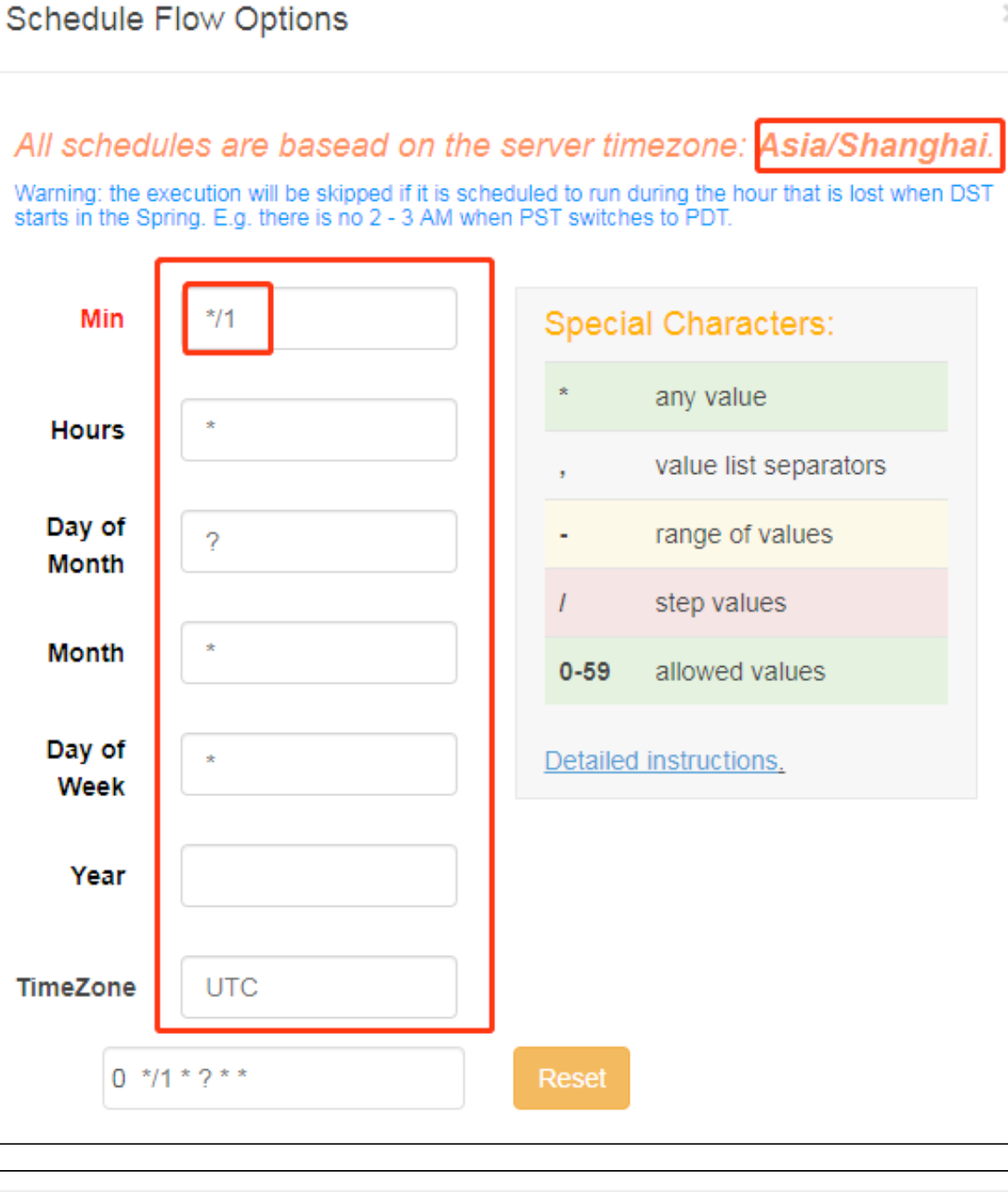

- 定时执行

使用crontab语法配置定时信息

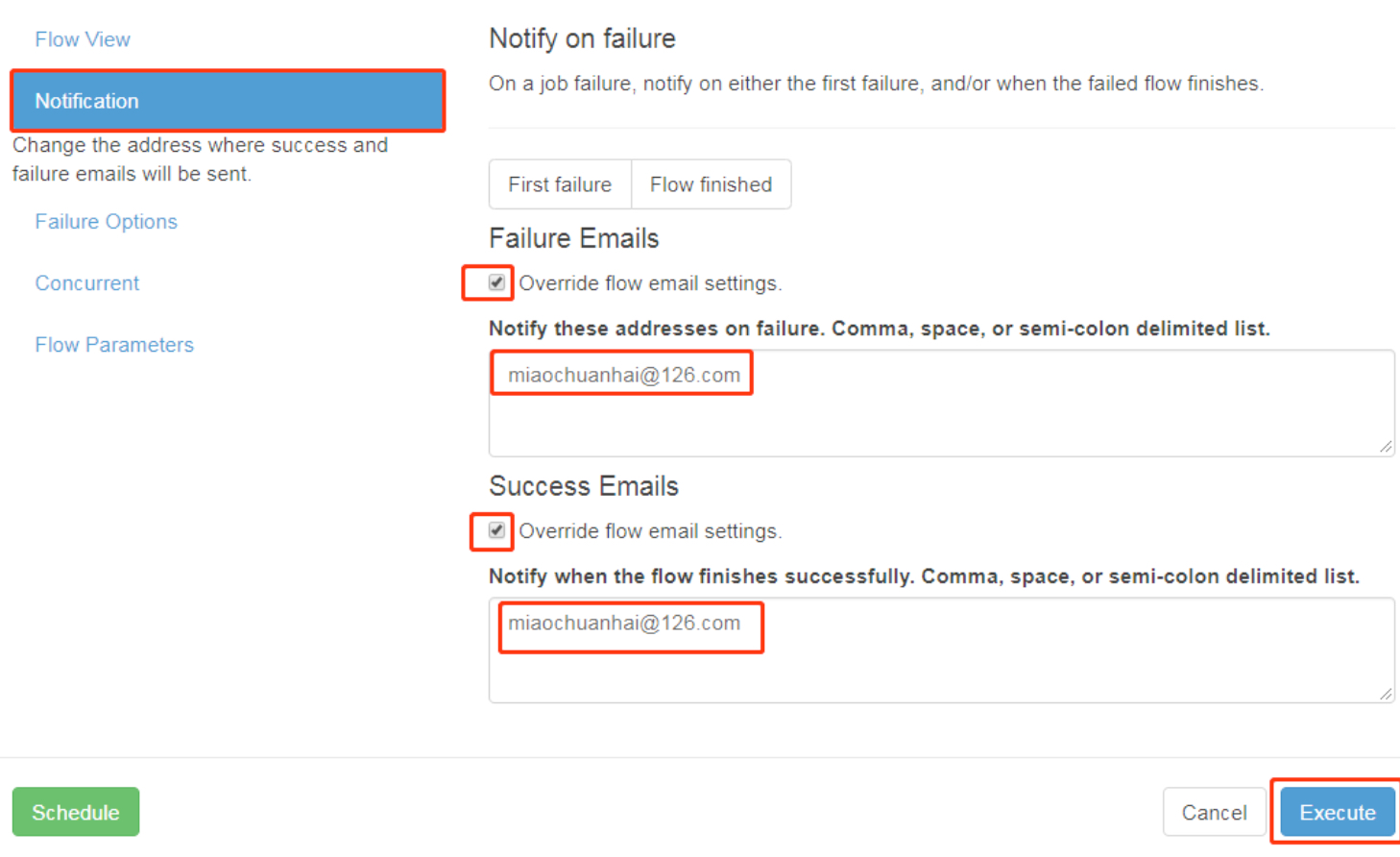

- 邮件报警设置

在web配置文件中添加一下内容

#这里设置邮件发送服务器,需要 申请邮箱,切开通 stmp 服务,以下只是例子 mail.sender=atguigu@126.com mail.host=smtp.126.com mail.user=atguigu@126.com mail.password=用邮箱的授权码

保存重启web服务

配置通知

4. Azkaban 多 Executor 模式注意事项

Azkaban 多 Executor 模式是指,在集群中多个节点部署 Executor。

在这种模式下, Azkaban web Server 会根据策略,选取其中一个 Executor 去执行任务。

为确保所选的 Executor 能够准确的执行任务,我们须在以下两种方案任选其一,推荐使 用方案二。

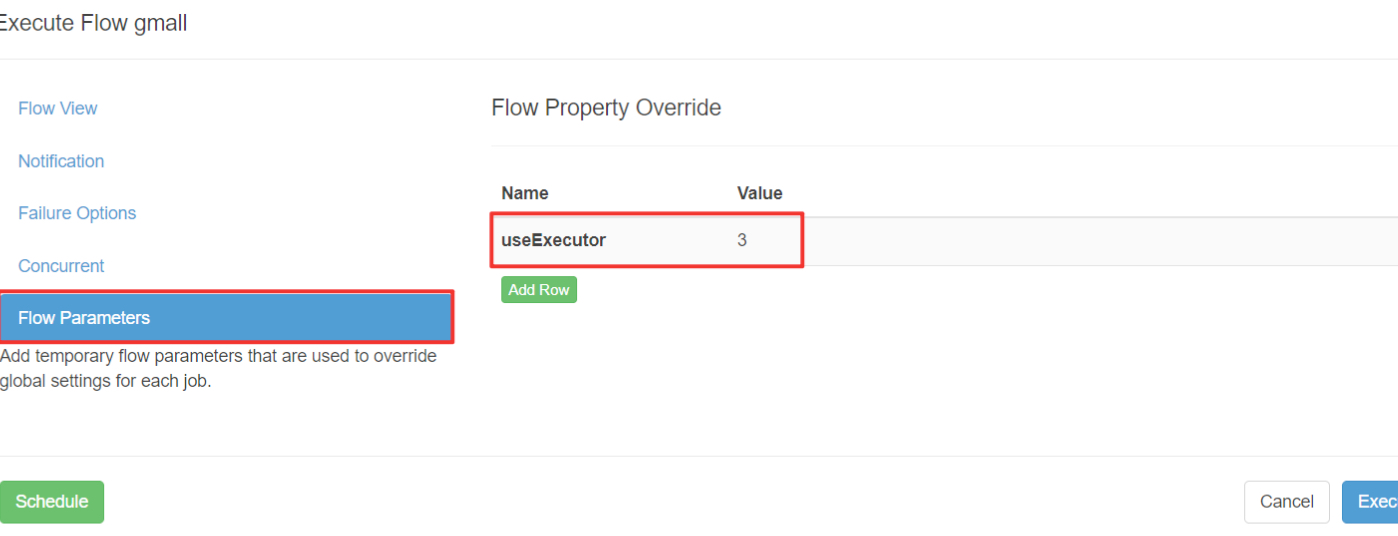

方案一: 指定特定的 Executor(hadoop102)去执行任务。

在 MySQL 中 azkaban 数据库 executors 表中,查询 hadoop102 上的 Executor 的 id

在执行工作流程时加入 useExecutor 属性

方案二: 在 Executor 所在所有节点部署任务所需脚本和应用。