人工智能 (AI) 测试

- 机器学习项目怎么测试

- 推荐系统项目怎么测试

- 图像识别项目怎么测试

- 自然语言处理项目怎么测试。

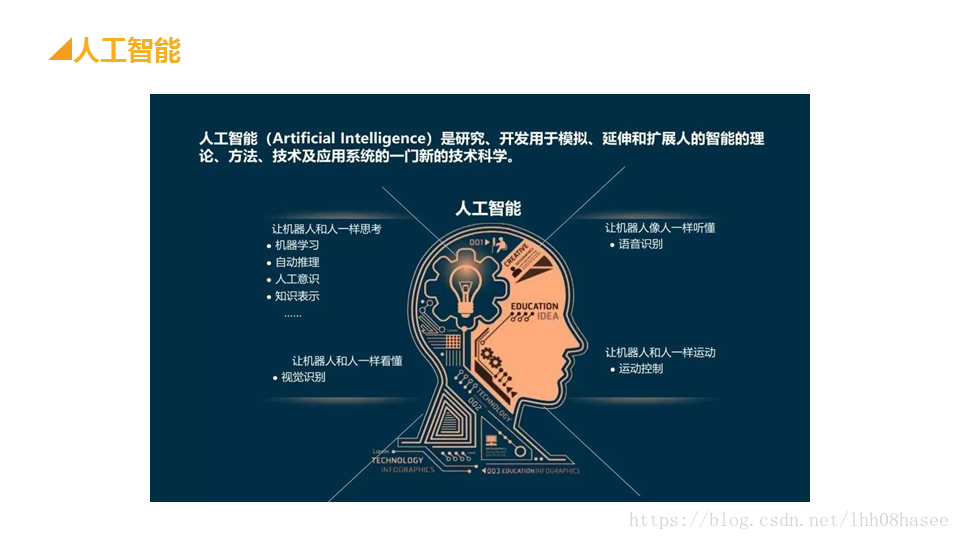

大家好,今天我们要讨论的是人工智能测试。在深入探讨之前,我们首先要明确一个问题:什么是人工智能?

人工智能的定义:

通俗地说,人工智能就是让机器完成原本只有人类才能完成的任务,比如【识别照片】、【理解语音】、【进行独立思考】等。

人工智能测试的正确问法:

当我们谈到人工智能测试时,其实这个问题本身有些笼统。就像问“水果怎么吃”一样,不同的水果有不同的吃法。

人工智能也有很多不同的应用类型,比如【机器学习】、【推荐系统】、【图像识别】和【自然语言处理】等。因此,更准确的问法应该是针对具体的人工智能应用来进行测试。

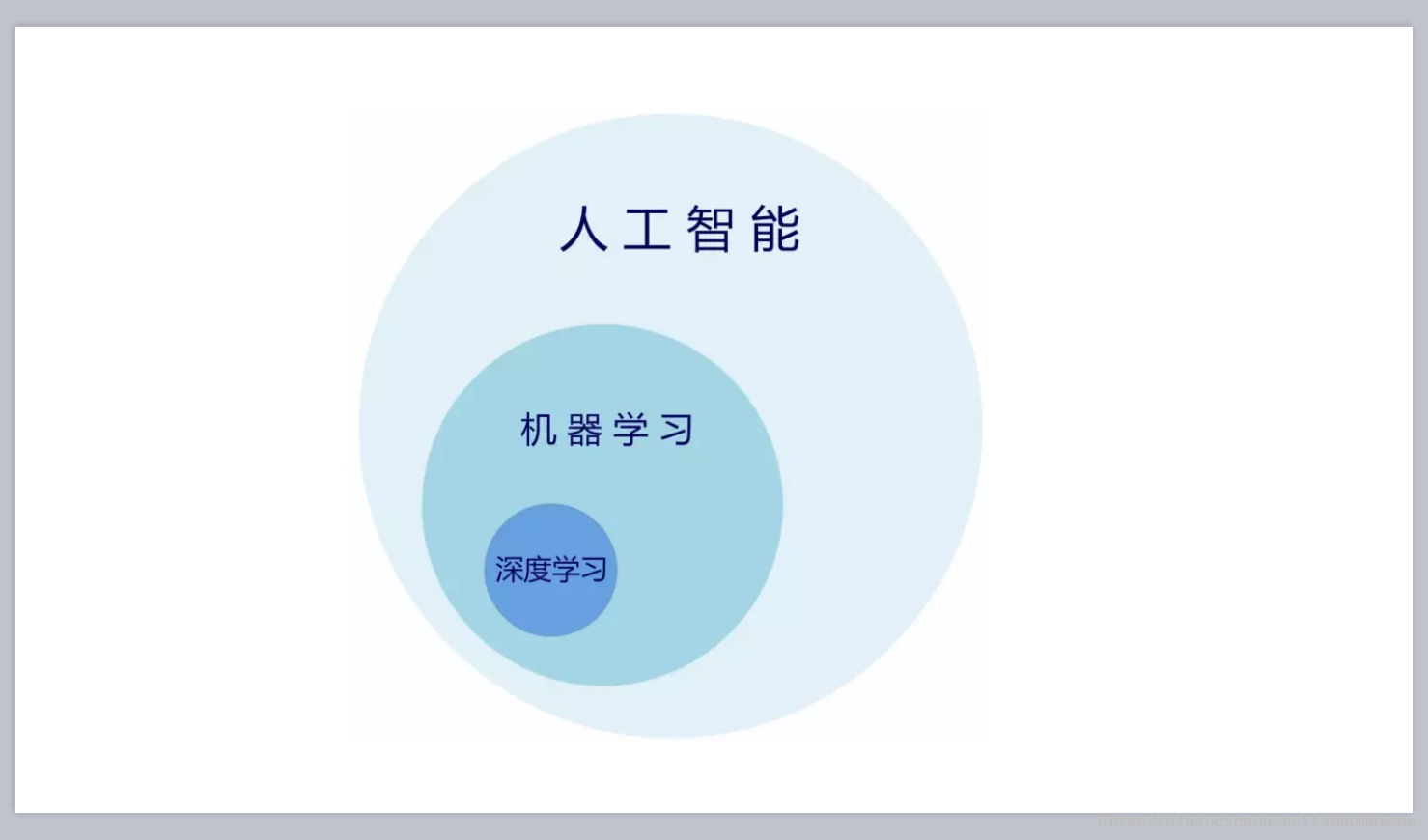

人工智能的分类与关系:

我们可以把机器学习比作一种吃水果的方法,而深度学习则是机器学习的一个分支。这种关系就像是一个大的水果类别中包含了多种不同的水果品种。

测试的内容与类型:

人工智能项目通常要测试哪些内容,以及进行哪些类型的测试。

-

模型评估测试:

- 主要测试模型对未知新数据的预测能力,即泛化能力。

- 性能度量指标包括错误率、准确率、精确率、召回率等。

-

稳定性/鲁棒性测试:

- 测试算法多次运行的稳定性。

- 检查算法在输入值发生微小变化时的输出稳定性。

-

系统测试:

- 将整个算法模型代码作为整体进行测试。

- 验证业务流程、用户场景和数据流动的正确性。

-

接口测试:

- 测试系统组件间的接口。

- 检查数据交换、传递和控制管理过程,以及系统间的逻辑依赖关系。

-

文档测试:

- 验证用户文档的完整性、正确性、一致性、易理解性和易浏览性。

-

性能测试(此处未详细展开,但可包括响应时间、吞吐量等)。

-

白盒测试–代码静态检查:

- 对代码进行静态分析,检查潜在的错误和缺陷。

-

竞品对比测试:

- 如果有涉及,可进行竞品对比测试,明确优势和劣势。

-

安全测试:

- 检查系统的安全性,防止潜在的安全漏洞。

发布上线后的线上模型监控:

上线只是完成了一半的测试工作。我们需要持续监控线上模型的性能,确保其在真实环境中的稳定性。

测试数据的选取:

对于人工智能测试来说,测试数据的选取至关重要。我们需要遵循以下两个原则:

- 测试集独立同分布:不能使用训练数据作为测试数据,测试数据需要与训练数据来自同一个分布。

- 测试数据的数量和训练数据的比例合理:根据数据量的不同,合理划分训练集、验证集和测试集的比例。

测试数据的收集:

测试数据可以由测试人员自己收集,或者由公司的数据标注人员整理提供,也可以通过爬虫或外部购买等方式获取。

测试流程:

- 测试人员先用算法工程师的测试集进行运行测试,查看结果。

- 再通过自己的测试集进行测试,进行指标对比。

总结:

人工智能测试是一个复杂而重要的过程,它涉及到多个方面的测试内容和类型。通过合理的测试数据和科学的测试方法,我们可以确保人工智能系统在实际应用中的稳定性和可靠性。

希望今天的讲解能帮助大家更好地理解和掌握人工智能测试的相关知识。谢谢大家!

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本

· C#/.NET/.NET Core优秀项目和框架2025年2月简报

· Manus爆火,是硬核还是营销?

· 终于写完轮子一部分:tcp代理 了,记录一下

· 【杭电多校比赛记录】2025“钉耙编程”中国大学生算法设计春季联赛(1)

2020-12-24 肖sir_高级讲师_ios手机系统抓包_高级讲师肖sir

2020-12-24 python+requests接口自动化分层框架设计