AdaBoost算法简介

adaboost算法是boosting算法的一种。boosting算法主要思想是用大量的简单的预测方法,得到一个比较准确的预测方法。譬如人脸检测中就是用的这种方法。

adaboost伪代码:

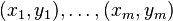

输入:

训练集: 其中

其中

训练的轮数T。

For :

:

初始化

//设置每组训练集的权重。开始都为1/m.

For :

:

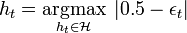

1.对于弱分类器H,找到误判率最小的分类器

是误判率。

其中

.

2.如果

,这里

是一个预先选择的阀值,停止训练。

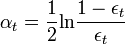

令

3.For

:

更新

其中分母

是标准化因子,保证

是一个概率分布

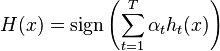

输出最终的分类器

这个算法可以用到很多地方,不过需要选择大量的分类器。

由于本人技术不是很好,欢迎来辩