信息论基础

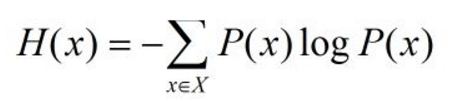

1. 信息熵:考虑随机x变量的所有可能取值,即所有可能发生事件所带来的信息量的期望

信息熵越大,变量中包含的信息量就越大。同时,也说明了变量的不确定性也越大。

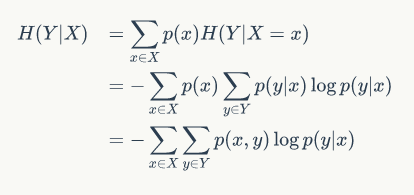

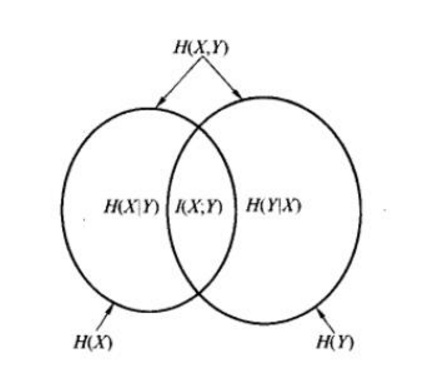

2.条件熵:定义为X给定条件下,Y的条件概率分布的熵对X的数学期望

条件熵H(Y|X)表示在已知随机变量X的条件下随机变量Y的不确定性。随机变量X给定的条件下随机变量Y的条件熵H(Y|X)

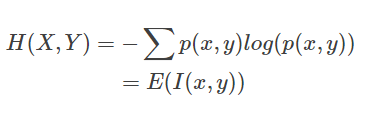

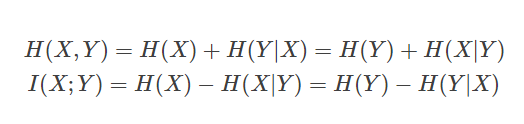

3. 联合熵

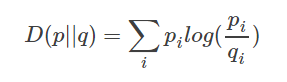

4. 相对熵

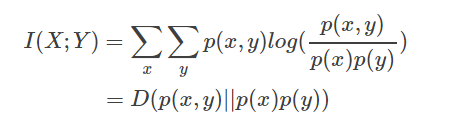

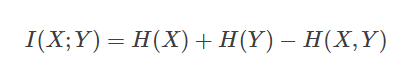

5. 互信息(Mulual information):也就是用来衡量两个信息的相关性大小的量。

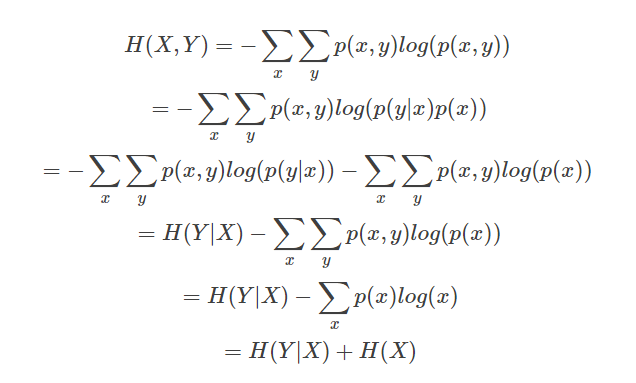

链式法则:

浙公网安备 33010602011771号

浙公网安备 33010602011771号