机器学习十一 ——分类与监督学习,朴素贝叶斯分类算法

1.理解分类与监督学习、聚类与无监督学习。

简述分类与聚类的联系与区别。

联系:均是用于对数据进行分类的机器学习方法

区别:

| 分类 | 聚类 |

| 监督学习 | 无监督学习 |

| 有标签的和无标签的都有 | 数据无标签 |

简述什么是监督学习与无监督学习。

2.朴素贝叶斯分类算法 实例

利用关于心脏病患者的临床历史数据集,建立朴素贝叶斯心脏病分类模型。

有六个分类变量(分类因子):性别,年龄、KILLP评分、饮酒、吸烟、住院天数

目标分类变量疾病:

–心梗

–不稳定性心绞痛

新的实例:–(性别=‘男’,年龄<70, KILLP=‘I',饮酒=‘是’,吸烟≈‘是”,住院天数<7)

最可能是哪个疾病?

上传手工演算过程。

|

|

性别 |

年龄 |

KILLP |

饮酒 |

吸烟 |

住院天数 |

疾病 |

|

1 |

男 |

>80 |

1 |

是 |

是 |

7-14 |

心梗 |

|

2 |

女 |

70-80 |

2 |

否 |

是 |

<7 |

心梗 |

|

3 |

女 |

70-81 |

1 |

否 |

否 |

<7 |

不稳定性心绞痛 |

|

4 |

女 |

<70 |

1 |

否 |

是 |

>14 |

心梗 |

|

5 |

男 |

70-80 |

2 |

是 |

是 |

7-14 |

心梗 |

|

6 |

女 |

>80 |

2 |

否 |

否 |

7-14 |

心梗 |

|

7 |

男 |

70-80 |

1 |

否 |

否 |

7-14 |

心梗 |

|

8 |

女 |

70-80 |

2 |

否 |

否 |

7-14 |

心梗 |

|

9 |

女 |

70-80 |

1 |

否 |

否 |

<7 |

心梗 |

|

10 |

男 |

<70 |

1 |

否 |

否 |

7-14 |

心梗 |

|

11 |

女 |

>80 |

3 |

否 |

是 |

<7 |

心梗 |

|

12 |

女 |

70-80 |

1 |

否 |

是 |

7-14 |

心梗 |

|

13 |

女 |

>80 |

3 |

否 |

是 |

7-14 |

不稳定性心绞痛 |

|

14 |

男 |

70-80 |

3 |

是 |

是 |

>14 |

不稳定性心绞痛 |

|

15 |

女 |

<70 |

3 |

否 |

否 |

<7 |

心梗 |

|

16 |

男 |

70-80 |

1 |

否 |

否 |

>14 |

心梗 |

|

17 |

男 |

<70 |

1 |

是 |

是 |

7-14 |

心梗 |

|

18 |

女 |

70-80 |

1 |

否 |

否 |

>14 |

心梗 |

|

19 |

男 |

70-80 |

2 |

否 |

否 |

7-14 |

心梗 |

|

20 |

女 |

<70 |

3 |

否 |

否 |

<7 |

不稳定性心绞痛 |

由表格可知

心梗条件下:

P(男 | 心梗) = 7/16

P(年龄<70 | 心梗) = 4/16

P( KILLP=‘I' | 心梗) = 9/16

P( 饮酒=‘是’ | 心梗) = 3/16

P( 吸烟=‘是’ | 心梗) = 7/16

P( 住院天数<7 | 心梗) = 4/16

不稳定性心绞痛条件下:

P(男 | 不稳定性心绞痛) = 1/4

P(年龄<70 | 不稳定性心绞痛) = 1/4

P( KILLP=‘I' | 不稳定性心绞痛) = 1/4

P( 饮酒=‘是’ | 不稳定性心绞痛) = 1/4

P( 吸烟=‘是’ | 不稳定性心绞痛) = 1/2

P( 住院天数<7 | 不稳定性心绞痛)= 1/2

设X为各特征的集合{性别=“男”、年龄<70,KILLP=‘I' ,饮酒=‘是‘, 吸烟=‘是’ ,住院天数<7},Y1为心梗,Y2为不稳定性心绞痛,根据贝叶斯定理

P(Y1 | X) = ( P(X | Y1)P(Y1) )/ P(X)

P(Y2 | X) = ( P(X | Y2)P(Y2) )/ P(X)

要比较P(Y1 | X)和P(Y2 | X) 哪一个概率更大,因为分母相同,所以直接比较分子即可

P(X | Y1)P(Y1) = P(男 | 心梗) * P(年龄<70 | 心梗)* P( KILLP=‘I' | 心梗)*P( 饮酒=‘是’ | 心梗) *P( 吸烟=‘是’ | 心梗)*P( 住院天数<7 | 心梗)

= 7/16 * 4/16 * 9/16 * 3/16 * 7/16 * 4/16 = 0.01614

P(X | Y2)P(Y2) = P(男 | 不稳定性心绞痛) * P(年龄<70 | 不稳定性心绞痛)* P( KILLP=‘I' | 不稳定性心绞痛)*P( 饮酒=‘是’ | 不稳定性心绞痛) *P( 吸烟=‘是’ | 不稳定性心绞痛)*P( 住院天数<7 | 不稳定性心绞痛)

= 1/4 * 1/4 * 1/4 * 1/4 * 1/2 * 1/2 = 0.00312

因为P(X | Y1)P(Y1) > P(X | Y2)P(Y2) ,

所以该新实例最可能得的是心梗。

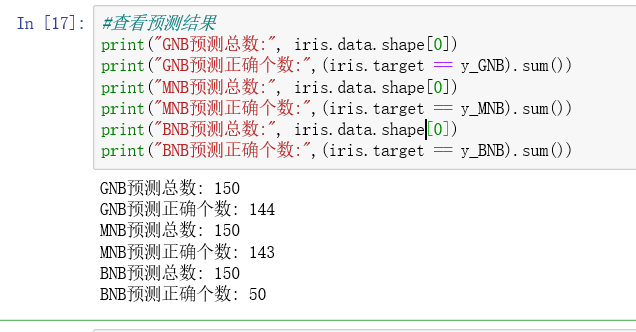

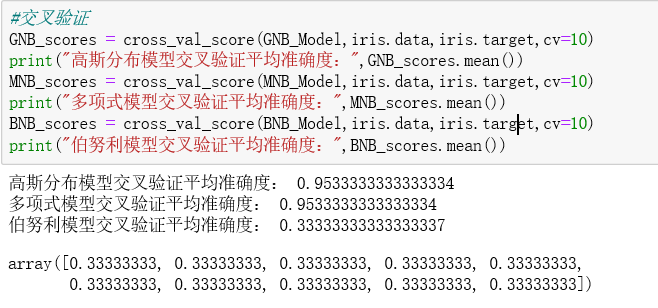

3.使用朴素贝叶斯模型对iris数据集进行花分类。

尝试使用3种不同类型的朴素贝叶斯:

- 高斯分布型

- 多项式型

- 伯努利型

并使用sklearn.model_selection.cross_val_score(),对各模型进行交叉验证。

from sklearn.datasets import load_iris from sklearn.naive_bayes import GaussianNB from sklearn.naive_bayes import MultinomialNB from sklearn.naive_bayes import BernoulliNB from sklearn.model_selection import cross_val_score iris = load_iris() #建模型 GNB_Model = GaussianNB() MNB_Model = MultinomialNB() BNB_Model = BernoulliNB() #训练模型 GNB_pre = GNB_Model.fit(iris.data,iris.target) MNB_pre = MNB_Model.fit(iris.data,iris.target) BNB_pre = BNB_Model.fit(iris.data,iris.target) #分类预测 y_GNB = GNB_pre.predict(iris.data) y_MNB = MNB_pre.predict(iris.data) y_BNB = BNB_pre.predict(iris.data) #查看预测结果 print("GNB预测总数:", iris.data.shape[0]) print("GNB预测正确个数:",(iris.target == y_GNB).sum()) print("MNB预测总数:", iris.data.shape[0]) print("MNB预测正确个数:",(iris.target == y_MNB).sum()) print("BNB预测总数:", iris.data.shape[0]) print("BNB预测正确个数:",(iris.target == y_BNB).sum()) #交叉验证 GNB_scores = cross_val_score(GNB_Model,iris.data,iris.target,cv=10) print("高斯分布模型交叉验证平均准确度:",GNB_scores.mean()) MNB_scores = cross_val_score(MNB_Model,iris.data,iris.target,cv=10) print("多项式模型交叉验证平均准确度:",MNB_scores.mean()) BNB_scores = cross_val_score(BNB_Model,iris.data,iris.target,cv=10) print("伯努利模型交叉验证平均准确度:",BNB_scores.mean())

结果:

学习链接: