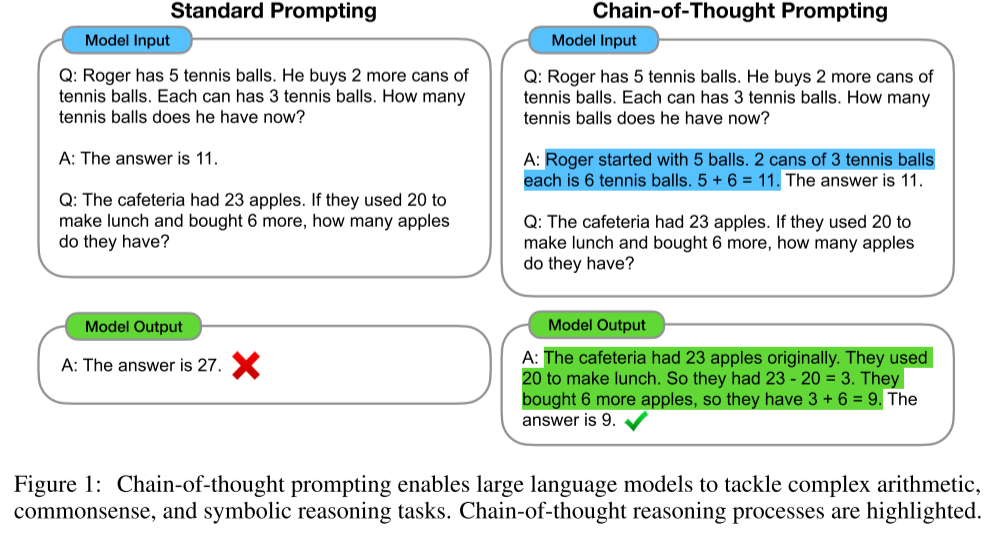

论文1:Chain-of-Thought Prompting Elicits Reasoning in Large Language Models (ICLR)

思维链是一系列导致最终输出的中间自然语言推理步骤,我们将这种方法称为思维链提示。

作者在算术、常识和符号推理上进行了实验,表明思维链提示优于标准提示,而且有时达到了惊人的效果。

模型参数规模:

大模型参数和显存换算:https://blog.csdn.net/Johntill/article/details/132629075?spm=1001.2014.3001.5506

论文2:Generalizable Chain-of-Thought Prompting in Mixed-task Scenarios with Large Language Models

作者将现有的cot方法分为:General Zero-Shot-CoT and Specific Few-Shot-CoT

并认为,前者具有很好的泛化性能,但是在具体任务上表现时又比后者差很多;而后者的泛化性能不好。

而且,现实场景中,很多任务都是混杂在一起的,无法具体区分属于哪一种任务,因此作者提出了一个新任务:混合场景下的COT问题,并在泛化和性能之间取了一个折中。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本

· C#/.NET/.NET Core优秀项目和框架2025年2月简报

· 葡萄城 AI 搜索升级:DeepSeek 加持,客户体验更智能

· 什么是nginx的强缓存和协商缓存

· 一文读懂知识蒸馏