线性回归

基本形式:

$f(x_{i})=W^{T}X_{i} + b$,使得$f(x_{i}) \approx y_{i}$

最小二乘估计:

$\widehat{w}^{*}= \underset{\widehat{w}}{arg min}(y - X\widehat{w})^{T}(y - X\widehat{w})$

令$E_{\widehat{w}}=(y - X\widehat{w})^{T}(y - X\widehat{w})$对$\widehat{w}$其求导:

$\frac{\partial E_{\widehat{w}}}{\partial x}=2 X^{T}(X\widehat{w}-y)$

如果$X^{T}X$为满秩矩阵或正定矩阵时,令上式为0:

$\widehat{w}^{*}=(X^{T}X)^{-1}X^{T}y$

logistic回归:把x映射到0-1范围内。

$y=\frac{1}{1+e^{-z}}$ (sigmoid函数)

$ln\frac{y}{1-y}=w^{T}x+b$

确定w和b:

$ln\frac{p(y=1|x)}{p(y=0|x)}=w^{T}x+b$

显然有:

$p(y=1|x) = \frac{e^{w^{T}x+b}}{1+e^{w^{T}x+b}}$

$p(y=0|x) = \frac{1}{1+e^{w^{T}x+b}}$

通过极大似然法:

最大化:

$\iota (w,b)=\sum_{i=1}^{m} ln(p(y_{i}|x_{i};w,b))$

因为$p(y_{i}|x_{i};w,b)=y_{i}P_{1}(\widehat{x_{i}};\beta )+(1-y_{i})P_{0}(\widehat{x_{i}};\beta )$,所以等价于最小化:

$\iota (\beta )=\sum_{i=1}^{m} (-y_{i}\beta^{T}x_{i} + ln(1+e^{\beta^{T}x_{i}}))$ (把常数去掉)

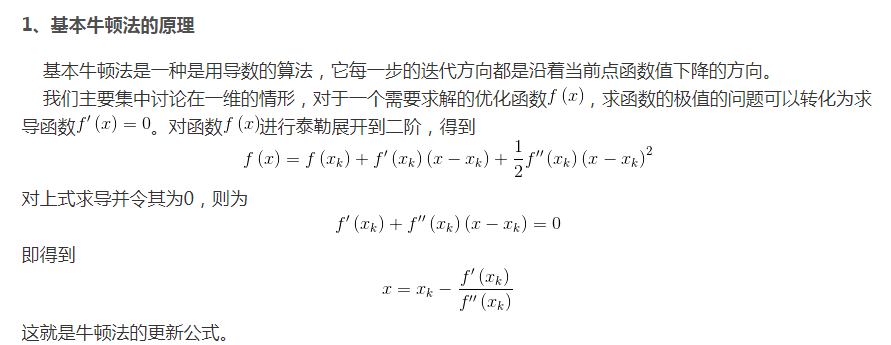

牛顿法:

$\beta^{t+1}=\beta^{t}-(\frac{\partial^2 \iota (\beta)}{\partial \beta \partial \beta^{T}})^{-1}\frac{\partial \iota (\beta)}{\partial \beta}$

LDA:给定训练样例集,设法将样例投影到一条直线上,使得同类样例的投影点尽可能接近,异类样例的投影点尽可能远离。

给定数据集$D= \{(x_{i},y_{i})\}_{i=1}^{m},y_{i} \in \{0,1\} $,令$X_{i}$、$\mu _{i}$、$ \sum_{i}$,分别表示第$i \in \{0,1\} $类示例的集合,均值向量、协方差矩阵。若将数据投影到直线w上,则俩类样本的中心在直线上的投影分别是$w^{T}\mu_{0}$和$w^{T}\mu_{1}$,若将所有样本点都投影到直线上,则俩类样本的协方差分别是$w^{T} \sum_{0} w$和$w^{T} \sum_{1} w$

使得同类样例的投影点尽可能接近,异类样例的投影点尽可能远离,即$w^{T} \sum_{0} w + w^{T} \sum_{1} w$尽可能小和$\| w^{T}\mu_{0}-w^{T}\mu_{1} \|^{2}_{2}$尽可能大,所以最大化:

$J=\frac {\| w^{T}\mu_{0}-w^{T}\mu_{1} \|^{2}_{2}}{w^{T} \sum_{0} w + w^{T} \sum_{1} w}$

$=\frac{w^{T}(\mu_{0}-\mu_{1})(\mu_{0}-\mu_{1})^{T}w}{w^{T}(\sum_{0}+\sum_{1})w}$

类内散度矩阵:

$S_{w}=\sum_{0}+\sum_{1}$

类间散度矩阵:

$S_{b}=(\mu_{0}-\mu_{1})(\mu_{0}-\mu_{1})^{T}$

则重写为:

$J=\frac{w^{T}S_{b}w}{w^{T}S_{w}w}$

因为分子和分母都有w的二次项,则w的解与w的长度无关,只与其方向有关,因为若w是一个解则对于任意常数a,aw也是w的一个解。所以等价于求解:

$\underset{w}{min}-w^{T}S_{b}w$

$s.t.w^{T}S_{w}w=1$

由于拉格朗日乘子:

$S_{b}w=\lambda S_{w}w$

如果$S_{w}$可逆等价于:

$S_{w}^{-1}S_{b} w=\lambda w$

$\lambda$是$S_{w}^{-1}S_{b}$的特征值。(可根据特征值与特征向量来求解)

由于$\lambda$是拉格朗日乘子且$(\mu_{0}-\mu_{1})^{T}w$为实数则$S_{b}w$的方向恒为$\mu_{0}-\mu_{1}$:

$S_{b}w=\lambda (\mu_{0}-\mu_{1})$

得:

$w=S_{w}^{-1}(\mu_{0}-\mu_{1})$