Hadoop综合大作业

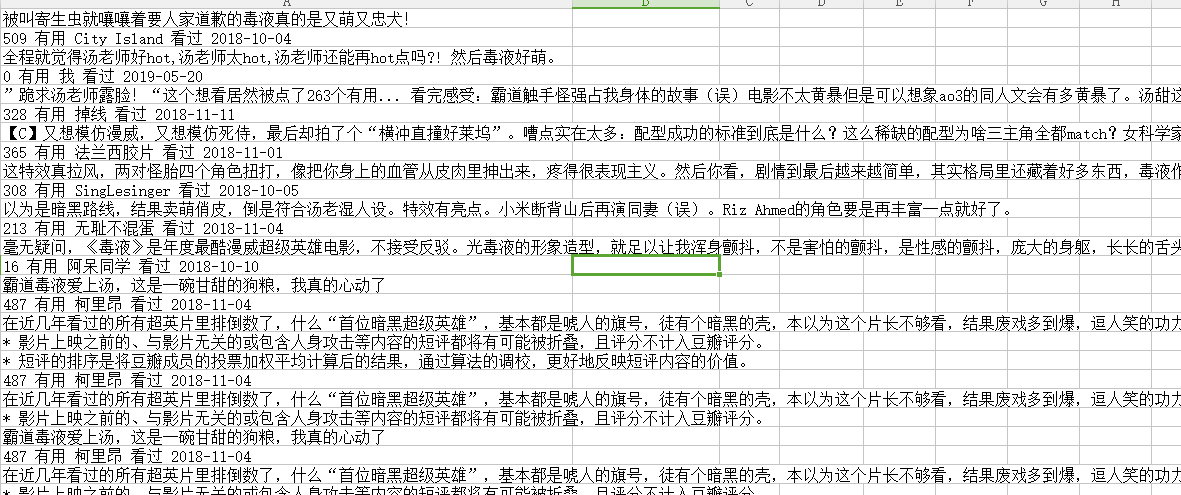

1.这是爬虫大作业的csv数据表,共计2万条数据左右。

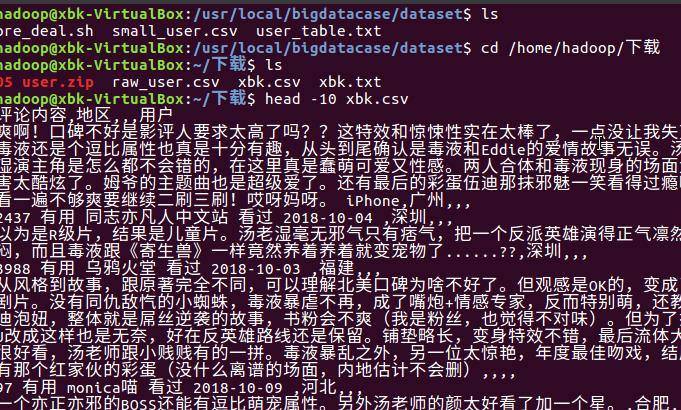

2、导入数据表并且去掉头部的第一条数据,然后查看签名10条数据

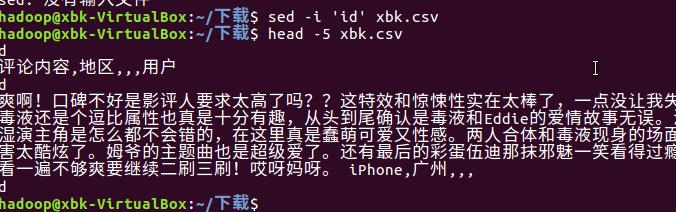

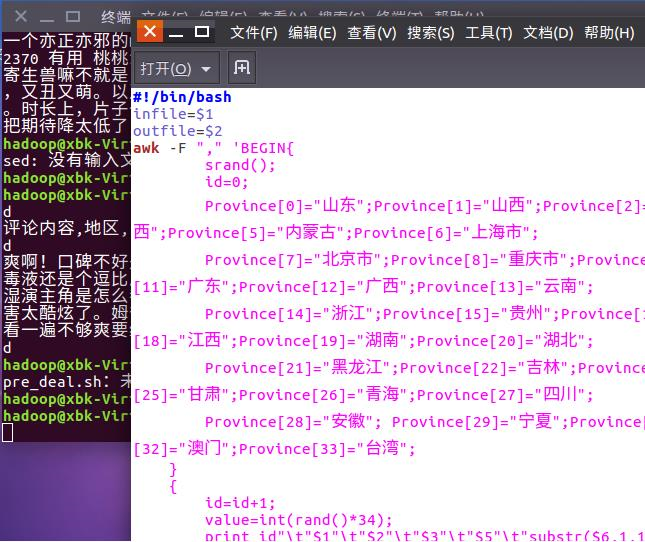

3、再进行预处理,创建一个脚本文件pre_deal.sh,对数据表中的地址进行省份转换:

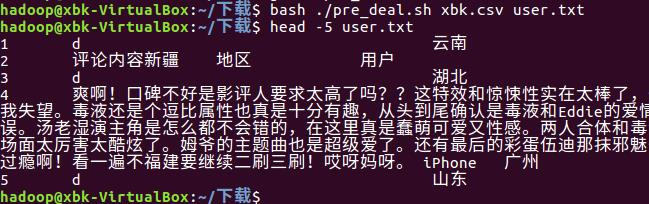

4、转换后的txt表,可以看见有中文的地区名

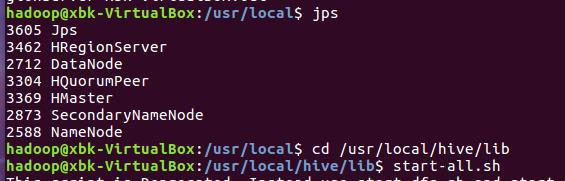

5、开启Hadoop和hive

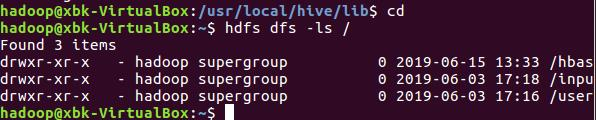

6、在hdfs上创建一个userst文件夹

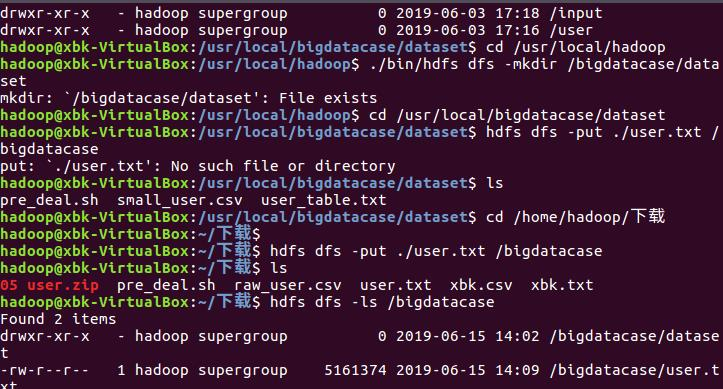

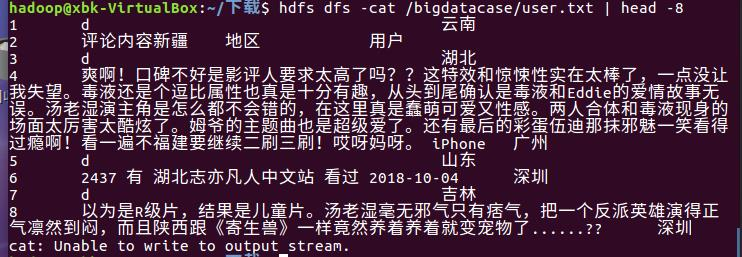

7、将之前转换后的txt文件上传到hdfs上面,然后查看内容

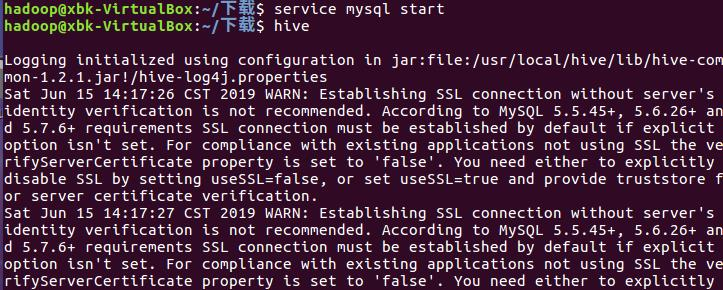

8、开启MySQL和hive

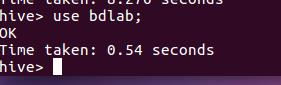

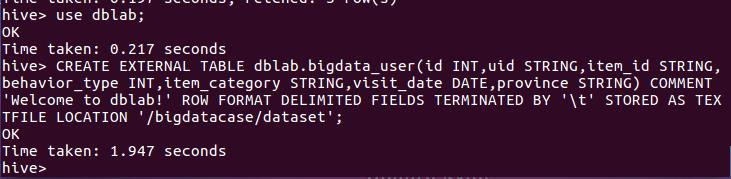

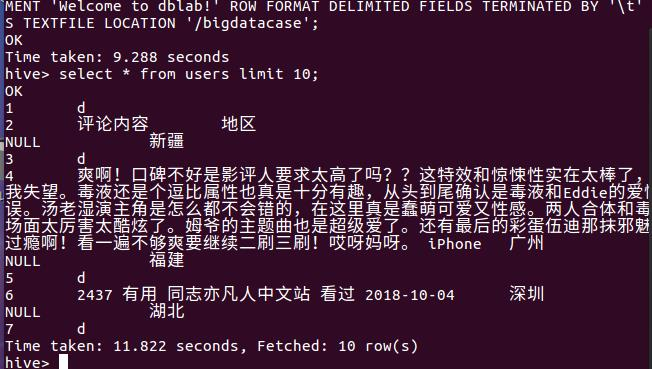

9、创建数据库dblab,并通过命令“use dblab”打开和使用数据库:

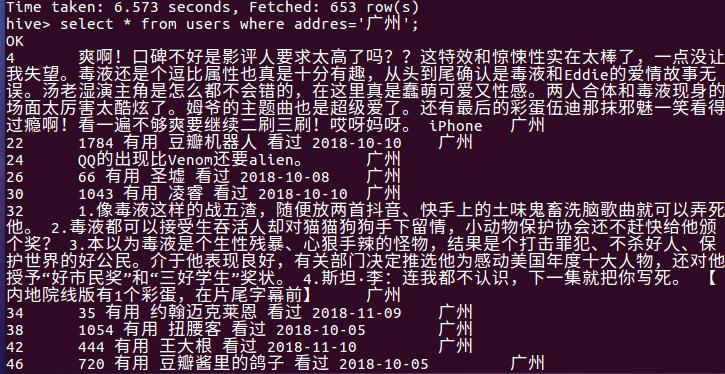

10、查找广州的评论

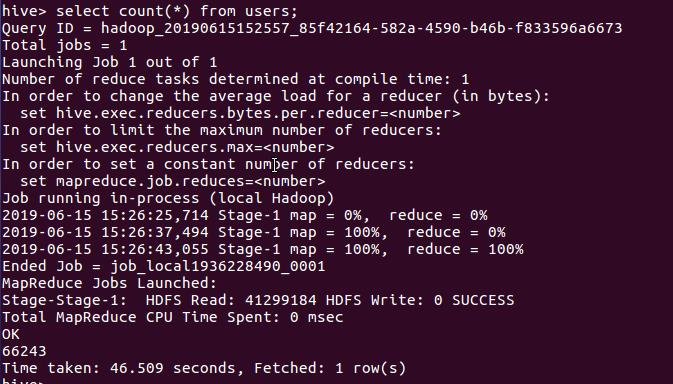

11、查找一共有多少人评论

12、查询8分以上用户的评论内容

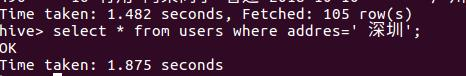

13、查找深圳的用户

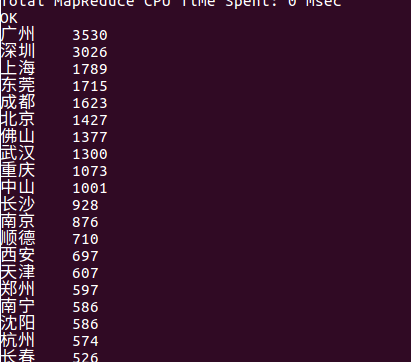

14、查询评论数量最多的城市

通过数据的分析可得出,对于漫威这种超级科幻大片来说,越大的城市对此最为感兴趣。

这也可以得出,多数年轻人来到大城市拼搏,而在二线城市和小城镇里,多数为老人和

小孩,所以对这种科幻大片的感冒程度也不高,所以评论数量也不会很多。

浙公网安备 33010602011771号

浙公网安备 33010602011771号