【Validation】林轩田机器学习基石

这一节主要讲如何通过数据来合理的验证模型好不好。

首先,否定了Ein来选模型和Etest来选模型。

(1)模型越复杂,Ein肯定越好;但是Eout就不一定了(见上一节的overfitting等)

(2)Etest是偷窥训练集,也没有效果

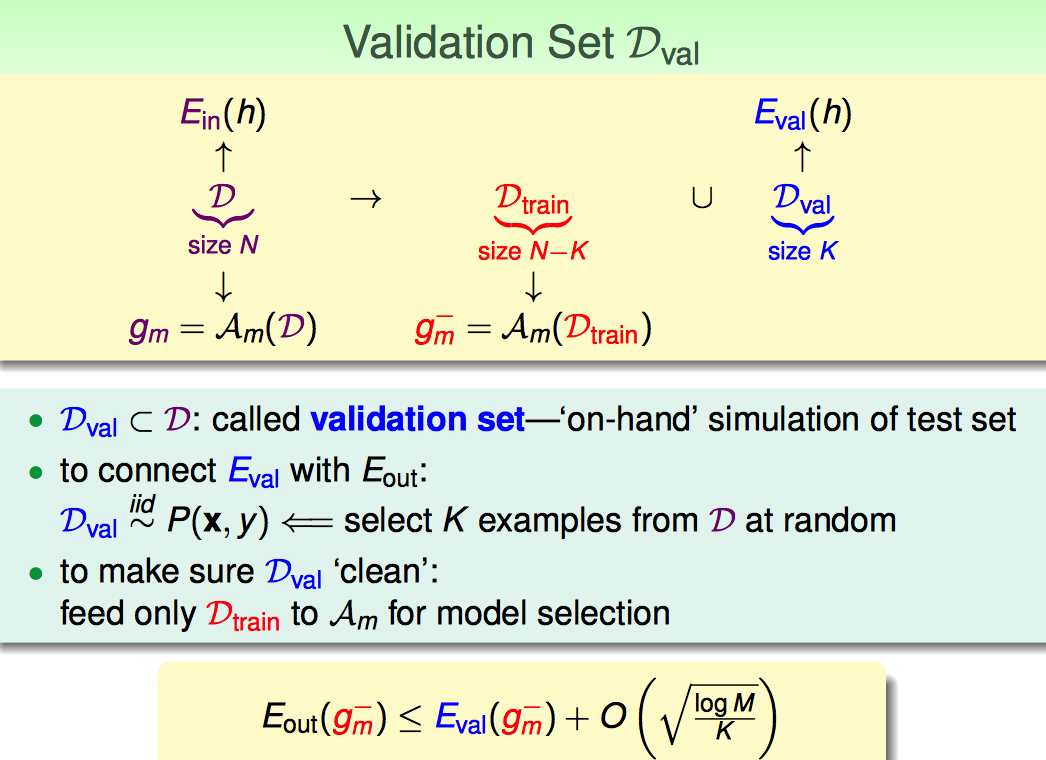

下面,集中讨论已有的数据集切分成train data和test data,怎么切分,怎么验证最合理。

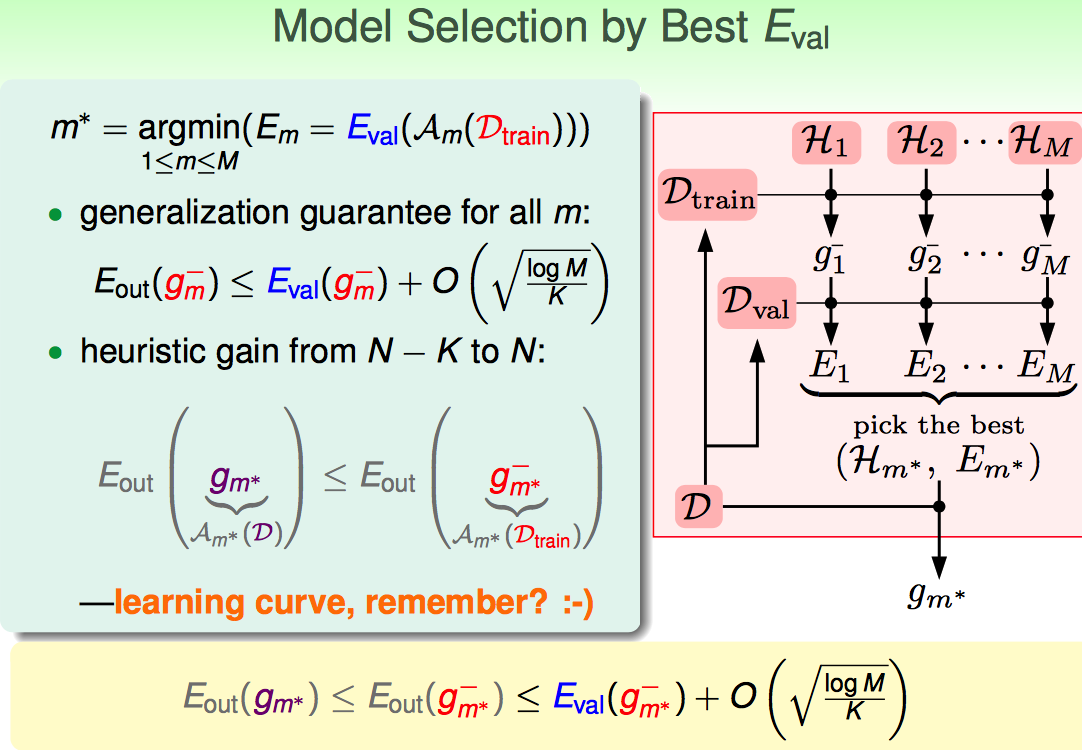

Model Selection的流程如下:

(1)切分数据,选一个Eval最小的

(2)再用全量数据去训练选出来的那个model

流程搞清楚了,接下来就要看怎么切数据(怎么选K)

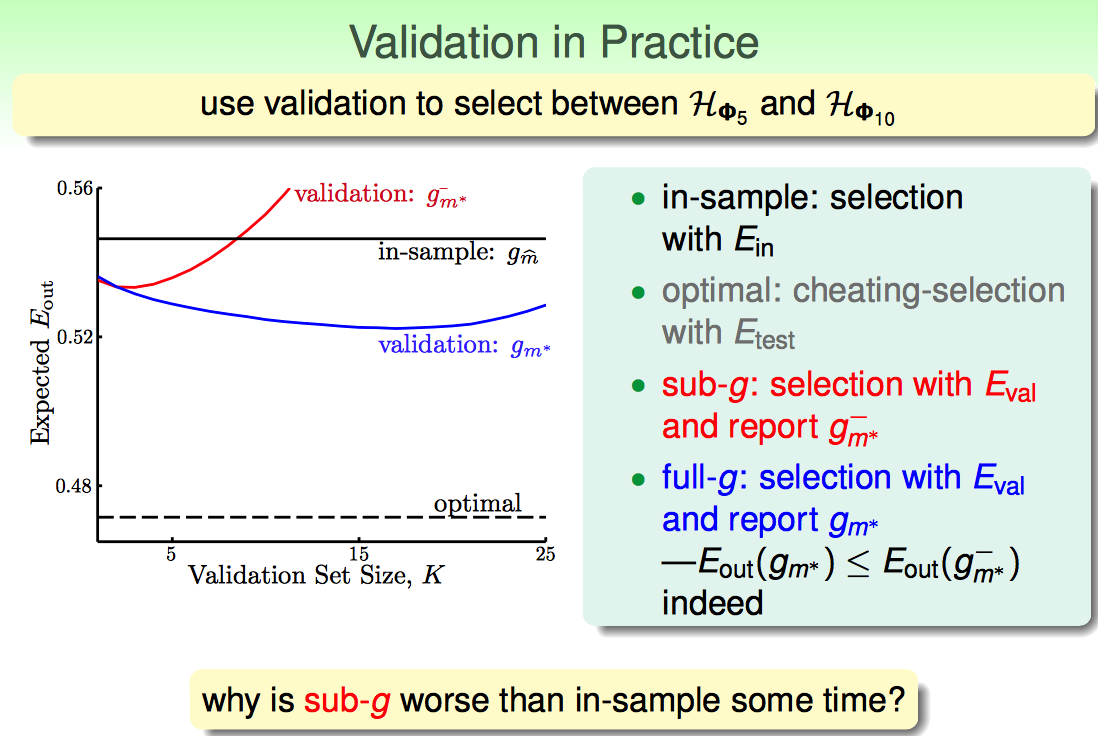

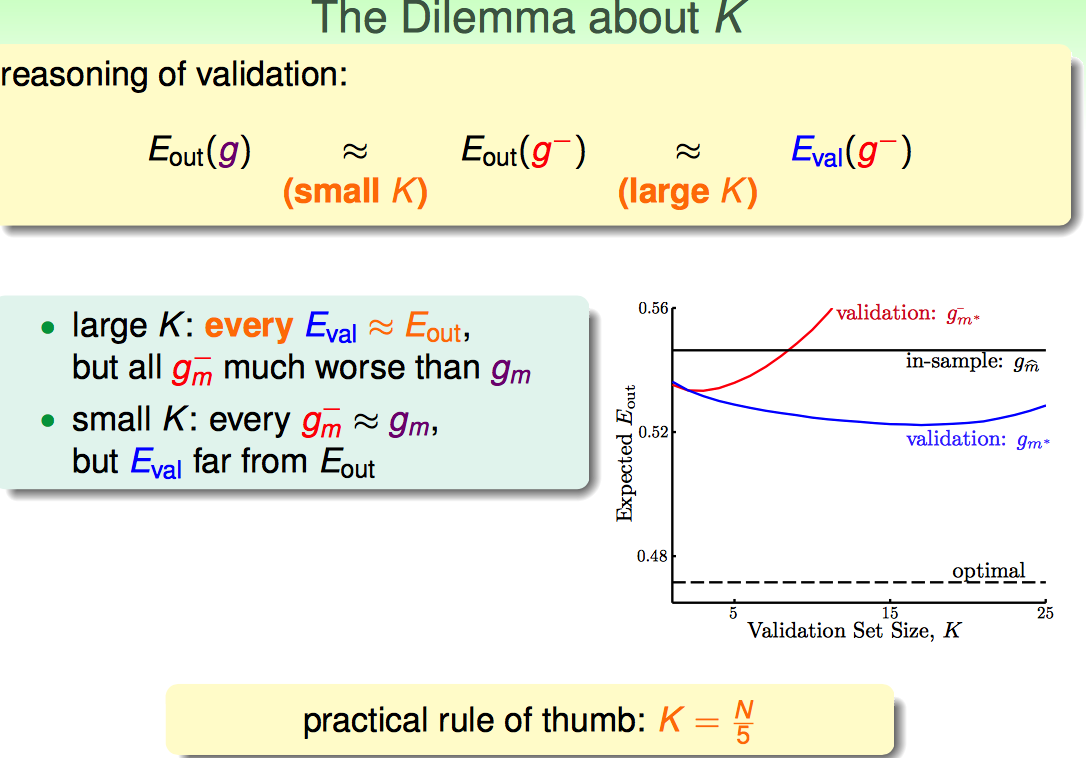

随着K增大,观察蓝线的变化趋势(因为蓝线是上边流程中应用的最终选出来模型的方法): K太小了,Eval跟Eout差距太大(因为有Finite-Hoeffding的不等式);K选择太大了,也不好,因为训练的数据太少了,效果肯定差。

实际中取K=N/5作为经验值。

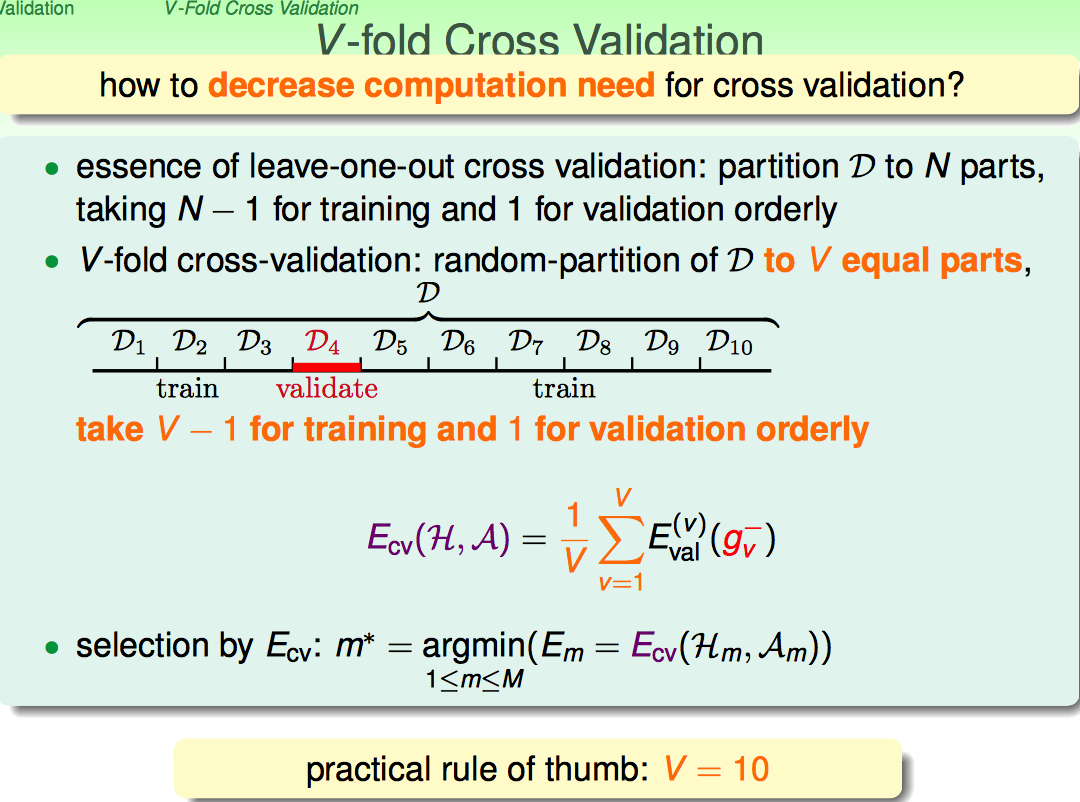

但上面的这种方法,毕竟只用一部分数据作为测试,效果容易不太稳定。所以才有了V-Fold cross validation。

最极端的情况是leave-one-out Estimate

这种情况基本是Eout的无偏估计,但是代价太高,不可行。

折中一下,10-fold cross validation是常用的方法。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· go语言实现终端里的倒计时

· 如何编写易于单元测试的代码

· 10年+ .NET Coder 心语,封装的思维:从隐藏、稳定开始理解其本质意义

· .NET Core 中如何实现缓存的预热?

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· 周边上新:园子的第一款马克杯温暖上架

· Open-Sora 2.0 重磅开源!

· 分享 3 个 .NET 开源的文件压缩处理库,助力快速实现文件压缩解压功能!

· Ollama——大语言模型本地部署的极速利器

· DeepSeek如何颠覆传统软件测试?测试工程师会被淘汰吗?