Image Super-Resolution Using Very Deep Residual Channel Attention Networks【RCAN】【阅读笔记】

图像超分任务可以看作是试图从LR图像中恢复尽可能多的高频信息。在SR任务中,输入的LR图像包含了丰富的低频信息。但是之前的任务把不同channel都同等对待,限制了CNN的表达能力。因此文中在EDSR的基础上结合了channel attention机制,构建了residual in residual模块用长跳连接多个残差组,组成了very deep residual channel attention network(RCAN)。这些长跳连接可以更好地传递低频信息,让主网络集中于学习高频信息。

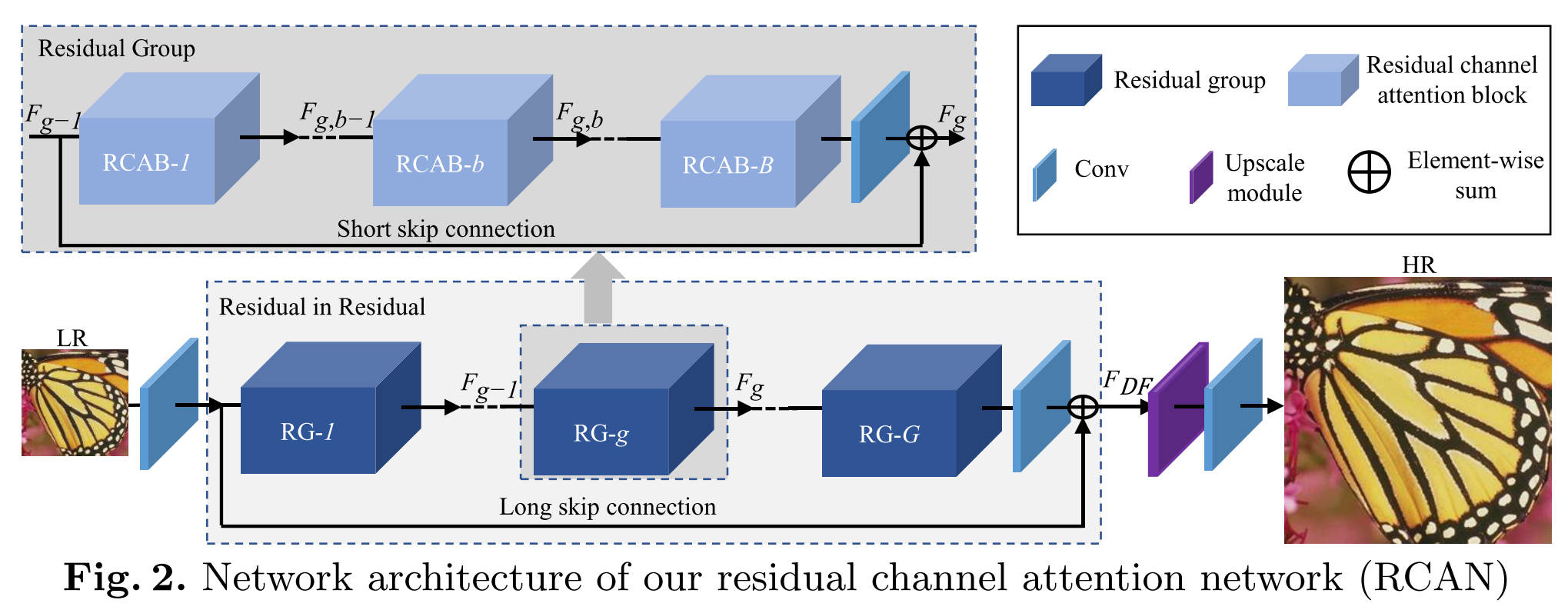

RCAN的完整网络结构如下图。多个RCAB模块通过短跳连接组成RG,再对RG进行残差连接称为长跳连接。

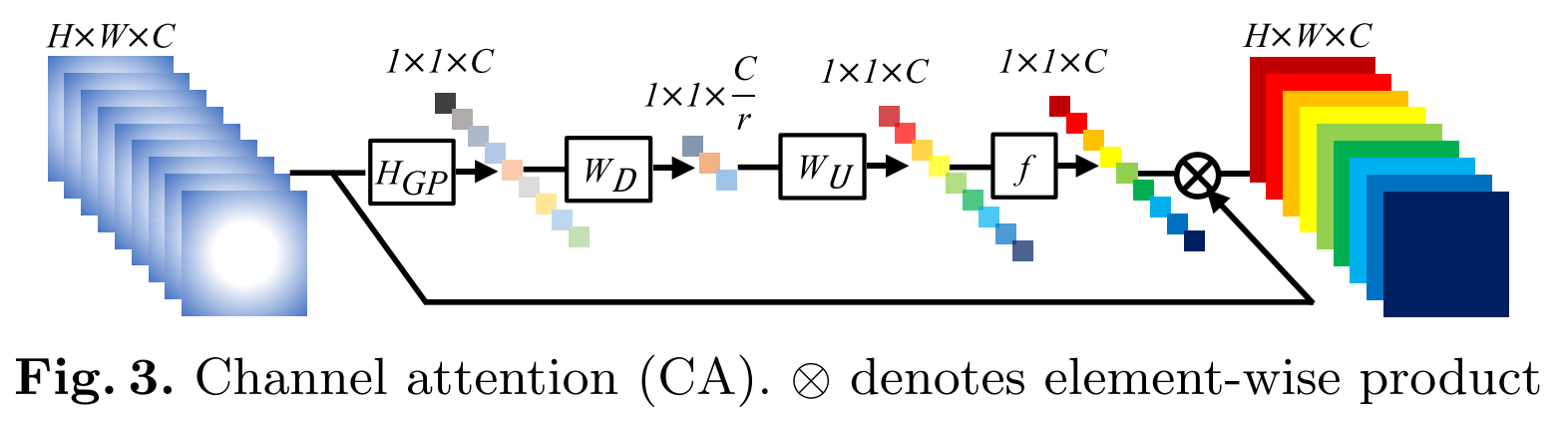

每一个RCAB中包含了channel attention(CA)模块,这个模块和SENet中的squeeze and excitation模块是一样的。先用一个average pooling把每一个channel的特征图变成一个1x1的point,然后也参照SENet引入了reduction来减小模型的复杂度。SENet中的SE block在阅读笔记中有讲过。

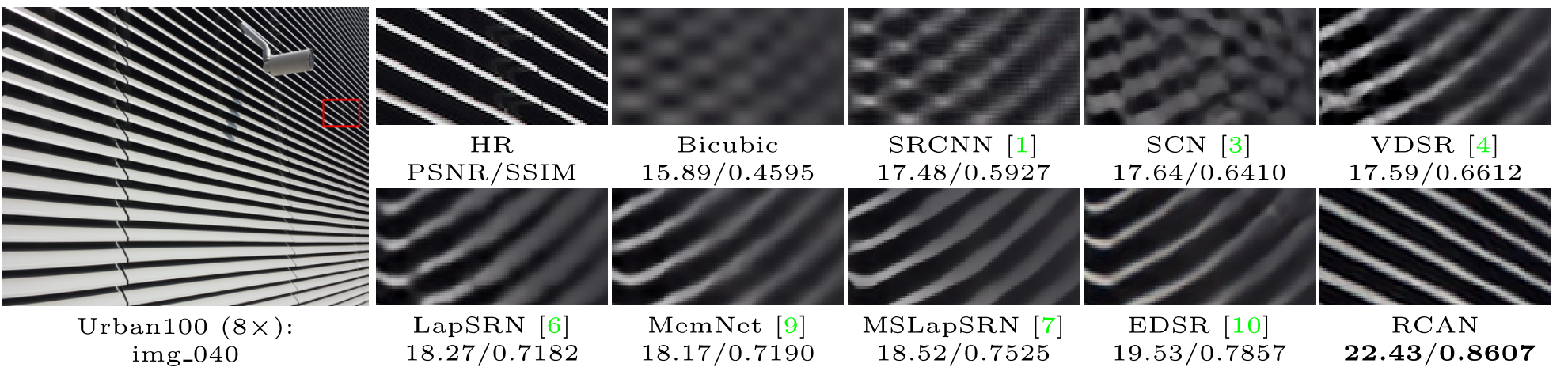

训练使用了DIV2K中800张图像,测试在Set5, Set14, B100, Urban100, Manga109. 在Y频道上计算PSNR和SSIM进行评估。

通过去除长短连接,说明了RIR结构的作用。如果LSC和SSC都被去除,不管有没有CA表现都要相对差一些。说明仅仅简单的堆叠残差模块是无法实现深层且有效的SR模型的。通过加入LSC或SSC都可以提升表现,加入两个效果更好。

对x2的任务RCAN在Set5, Set14, B100数据集上比EDSR大概好差不多0.2-0.3个点,对于倍数更大的任务比如x8任务提升要更大一点,差不多有0.6-0.7左右。EDSR参数量43M,RCAN参数量16M,RCAN的深度要比EDSR深。对于倍数大的任务优势要更大一些,一些模型在x8任务中会有明显的错误。

浙公网安备 33010602011771号

浙公网安备 33010602011771号