如何利用Python网络爬虫给自己跟朋友来一份穷游攻略!走到哪里穷到哪里的哦!

【一、项目背景】

穷游网提供原创实用的出境游旅行指南、攻略,旅行社区和问答交流平台,以及智能的旅行规划解决方案,同时提供签证、保险、机票、酒店预订、租车等在线增值服务。穷游“鼓励和帮助中国旅行者以自己的视角和方式体验世界”。

今天教大家获取穷游网的城市信息,使用Python将数据写入csv文档。

【二、项目目标】

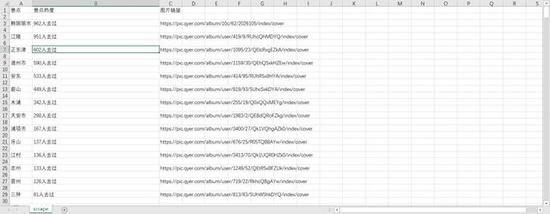

实现将获取对应的城市、图片链接、热点、批量下载 保存csv文档。

【三、涉及的库和网站】

1、网址如下:

https://place.qyer.com/south-korea/citylist-0-0-{}

2、涉及的库:requests、l****xml、fake_useragent、time、csv

【四、项目分析】

首先需要解决如何对下一页的网址进行请求的问题。可以点击下一页的按钮,观察到网站的变化分别如下所示:

https://place.qyer.com/south-korea/citylist-0-0-1 https://place.qyer.com/south-korea/citylist-0-0-2 https://place.qyer.com/south-korea/citylist-0-0-3

观察到只有citylist-0-0-{}/变化,变化的部分用{}代替,再用for循环遍历这网址,实现多个网址请求。

【五、项目实施】

1、我们定义一个class类继承object,然后定义init方法继承self,再定义一个主函数main继承self。准备url地址。

2、随机产生UserAgent。

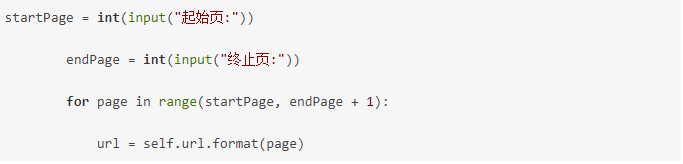

3、多页请求。

4、定义get_page方法,进行数据请求。

5、定义page_page,xpath解析数据, for循环遍历数组。

在谷歌浏览器上,右键选择开发者工具或者按F12。右键检查,xpath找到对应信息的字段。如下图所示。

6、定义csv文件保存数据,写入文档。

7、在main方法调用。

8、time模块,设置时间延迟。

【六、效果展示】

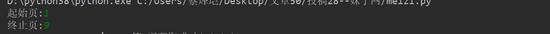

1、点击运行,输入起始页,终止页。

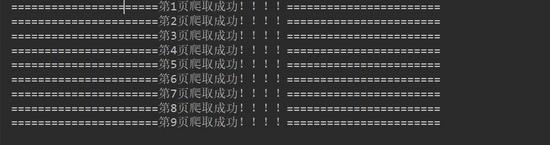

2、将下载成功信息显示在控制台。

3、保存csv文档。

【七、总结】

1、不建议抓取太多数据,容易对服务器造成负载,浅尝辄止即可。

2、希望通过这个项目,能够帮助大家对csv文档处理有进一步的了解。

3、本文基于Python网络爬虫,利用爬虫库,实现穷游网的获取。实现的时候,总会有各种各样的问题,切勿眼高手低,勤动手,才可以理解的更加深刻。

4、可以根据自己的需要选择自己的喜欢的城市获取自己想要的有效信息 。

此文转载文,著作权归作者所有,如有侵权联系小编删除!

原文地址:https://www.tuicool.com/articles/zeAfea6

需要源代码或者想了解更多的(点击这里下载)

浙公网安备 33010602011771号

浙公网安备 33010602011771号