顶刊IJCV 2024 | EfficientSCI++:高效的视频单曝光压缩成像重建框架

前言 来自浙江大学和西湖大学的研究人员提出了一种基于 CNN-Transformer 架构的高效、大尺度视频单曝光压缩成像重建算法 EfficientSCI++。

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

本文转载自PaperWeekly

仅用于学术分享,若侵权请联系删除

招聘高光谱图像、语义分割、diffusion等方向论文指导老师

背景介绍

在之前的工作中,人们通常使用高速相机采集高速运动场景,但是这样就会带来较高的硬件成本和数据传输带宽。受到压缩感知技术的启发,视频单曝光压缩成像系统提供了一种低成本、低带宽的解决方案用于高速运动场景的采集。

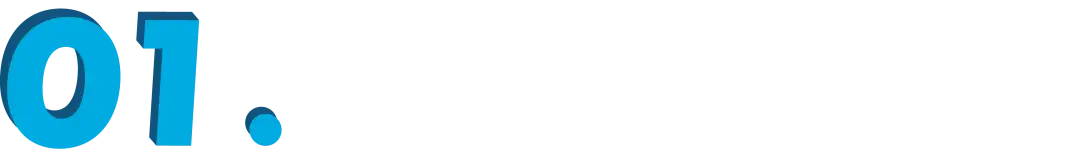

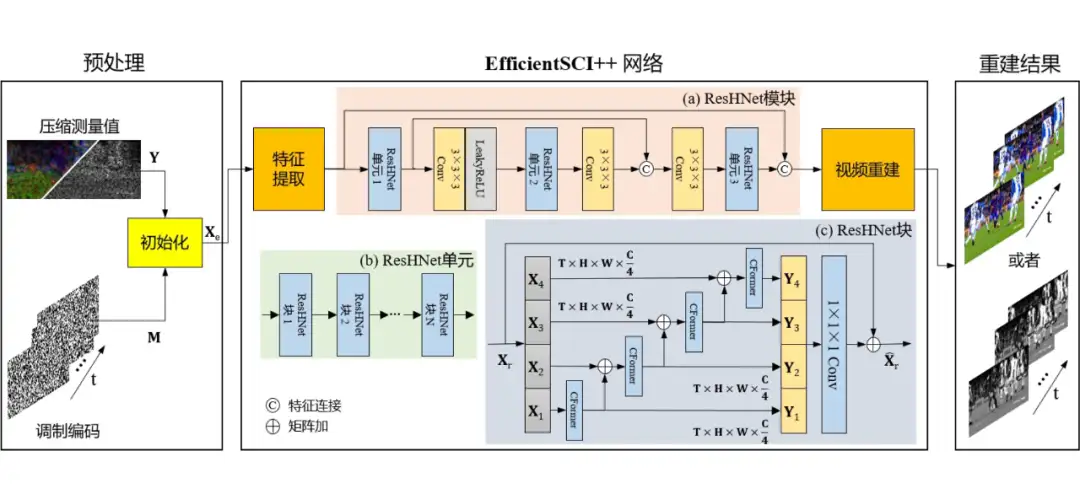

如图 1 所示,视频单曝光压缩成像系统由硬件编码器和软件解码器组成:硬件编码器采用多张不同的调制编码来调制高速运动场景,之后通过一个低速相机在其单个曝光时间内采集一系列单曝光压缩测量值;软件解码器将单曝光压缩测量值和相应的调制编码输入到视频单曝光压缩成像重建算法中恢复出高速运动场景的图像序列。

▲ 图1. 视频单曝光压缩成像系统的工作原理

一方面,视频单曝光压缩成像硬件系统已经比较成熟。另一方面,基于深度学习的重建算法也取得了不错的重建效果。但是,当前仍然面临以下挑战:1)目前的重建算法往往具有较高的计算复杂度;2)现有的重建算法无法重建大尺度、高压缩比的场景;3)之前的工作没有深入研究重建算法对于不同压缩比的灵活性。

针对以上问题,来自浙江大学和西湖大学的研究人员提出了一EfficientSCI++。

论文标题:Hybrid CNN-Transformer Architecture for Efficient Large-Scale Video Snapshot Compressive Imaging

论文链接:

https://link.springer.com/article/10.1007/s11263-024-02101-y

代码链接:

https://github.com/mcao92/EfficientSCI-plus-plus

EfficientSCI++算法详解

EfficientSCI++ 算法的网络结构如图 2 所示,其主要包括:

1. 初始化模块(给定压缩测量值和调制编码,生成模糊的视频帧);

2. 特征提取模块(由卷积核为 3×3×3 和 1×3×3 的两个 3D 卷积层以及对应的 LeakyReLU 激活函数组成,将输入图片序列映射到高维特征空间);

3. ResHNet 模块(由 3 个 ResHNet 单元组成,用于高效地构建时空关联性)。其中,每个 ResHNet 单元由多个 ResHNet 块堆叠而成;

4. 视频重建模块(由 PixelShuffle 操作和卷积核为 1×1×1,3×3×3 的两个 3D 卷积层组成,将高维特征映射到图片序列得到最终的重建结果)。

▲ 图2. EfficientSCI++网络结构图

现在,我们重点讲解一下 EfficientSCI++ 的核心网络设计:基于特征通道划分机制的 ResHNet 块。如图 2.c 所示,我们首先将输入特征沿着特征维度分成多份。然后,我们利用 CFormer 块高效地构建时空连接。最后,我们将所有 CFormer 块的输出特征沿着特征通道维度连接到一起,随后通过一个 1×1×1 卷积层更好地融合特征信息。

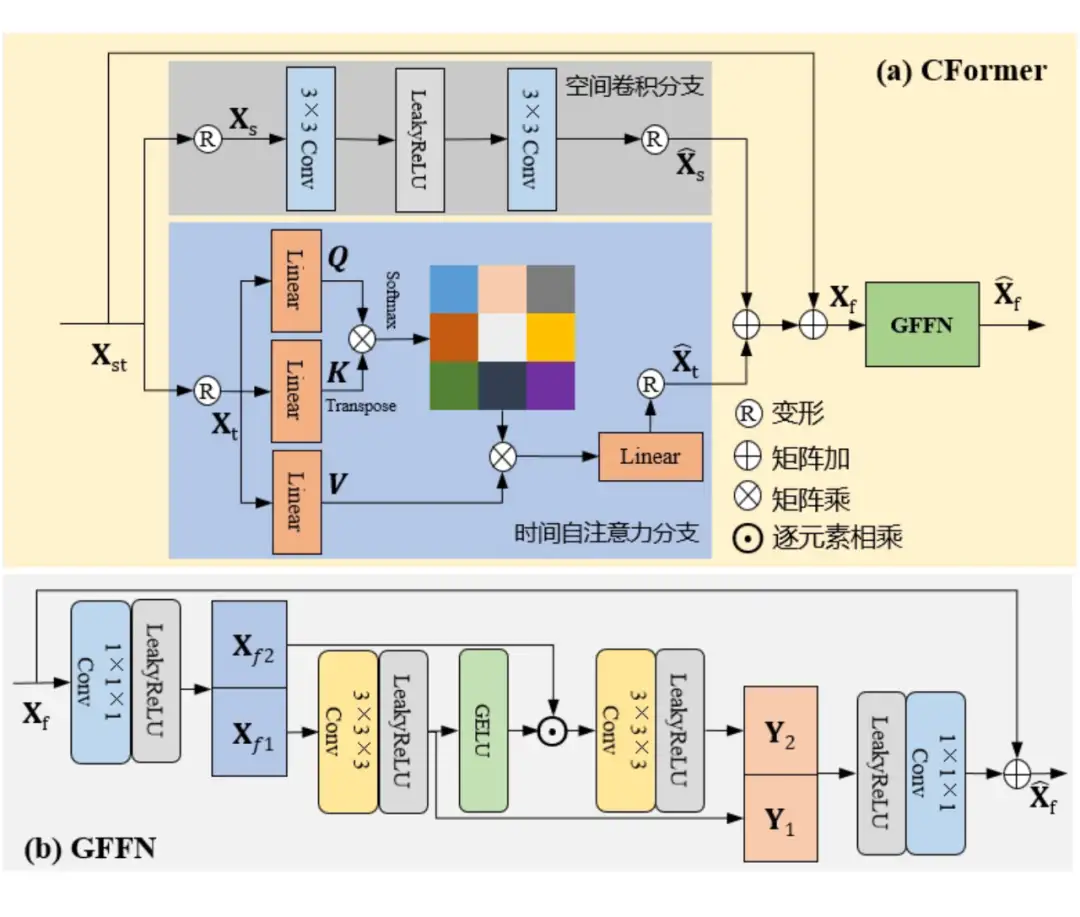

不难看出,CFormer 块在 ResHNet 块中起到至关重要的作用。如图 3 所示, CFormer 块基于时空分解机制和 CNN-Transformer 架构,其主要包括:

1. 空间域卷积分支(2 个卷积核为 3×3 的 2D 卷积层可以很好地提取局部空间特征,同时算法复杂度和内存占用也会大大降低);

2. 时间域自注意力分支(在每一个像素点位置,沿着时间维度使用自注意力机制,这么做可以很好地建立长时序特征关联);

3. 基于门控机制的前馈神经网络(Gating mechanism based Feed Forward Network,简称 GFFN)。

和之前的前馈神经网络相比,GFFN 可以更好地控制网络中的信息流从而抑制网络中的无用信息,只让有用信息在网络中传递。此外,我们在 GFFN 的第一个线性转换层后面加入一系列零填充大小为 1 的 3×3×3 卷积操作实现了动态位置编码。因此,在压缩比变化时,EfficientSCI++ 仍然可以给出很高的重建质量。

▲ 图3. CFormer块结构图

EfficientSCI++性能分析

在实验部分,我们在六个灰度仿真测试数据(256×256×8)、六个中等尺度彩色仿真测试数据(512×512×3×8)和四个大尺度彩色仿真测试数据上进行测试。然后,为了验证重建算法在真实测试数据上对于不同压缩比的灵活性,我们制作了一个压缩比从 10 到 50 逐渐变化的灰度和彩色真实测试数据集。最后,我们在另外两组真实测试数据上进一步验证 EfficientSCI++ 在实际系统中的性能。

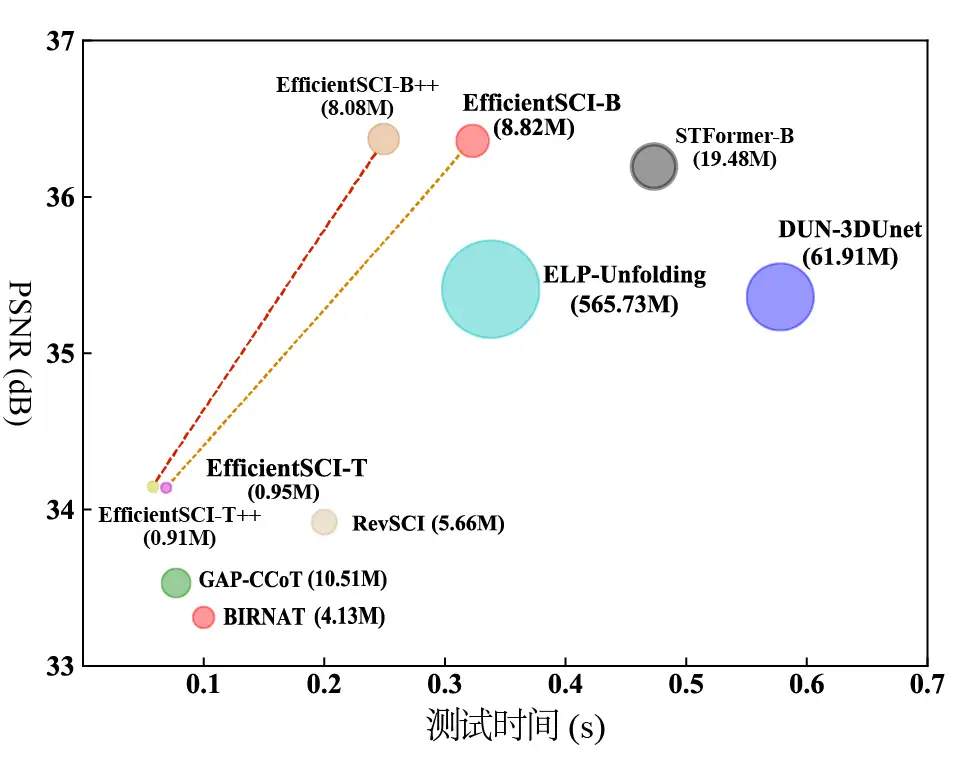

由于篇幅限制,这里只给出部分实验结果。其中:

1. 如图 4 所示, EfficientSCI++ 可以取得和之前的重建算法相当的重建质量,但是测试时间大大缩短;

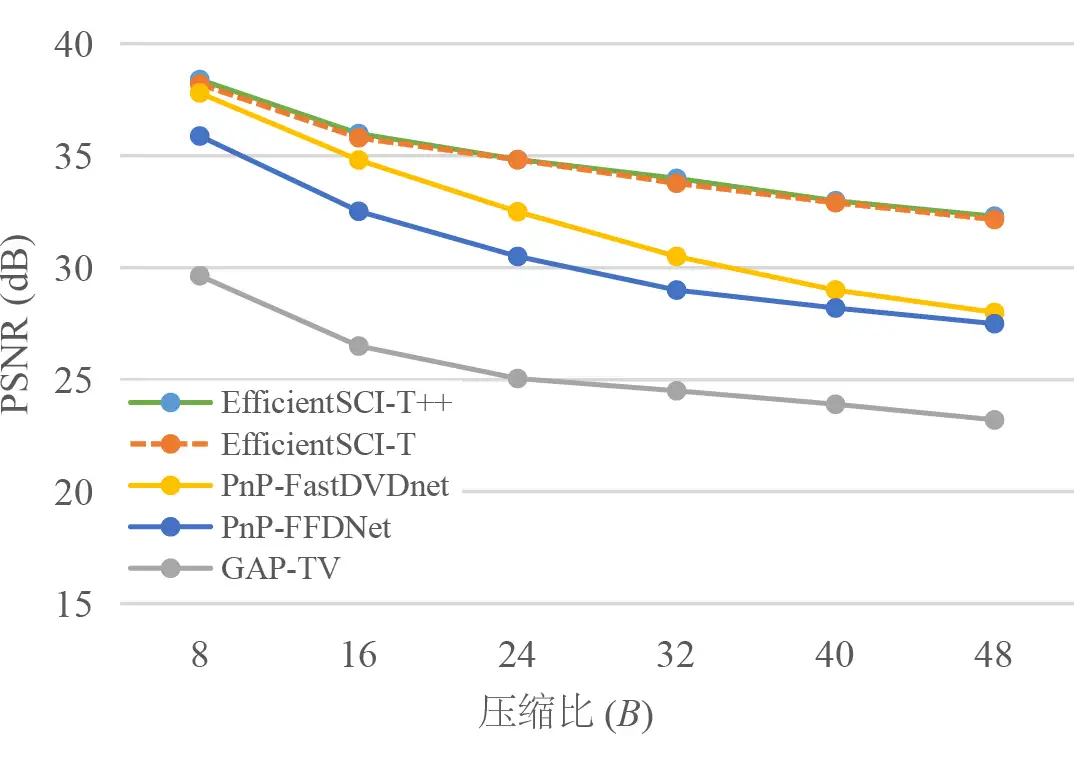

2. 如图 5 所示,压缩比从 8 变化到 48 时,EfficientSCI++ 能够更好地保证重建质量;

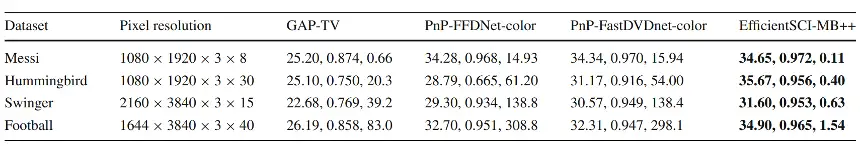

3. 从表 1 可以看出,EfficientSCI++ 第一次在 1644×3480×3,压缩比为 40 的大尺度彩色仿真测试数据上给出 34dB 以上的重建质量;

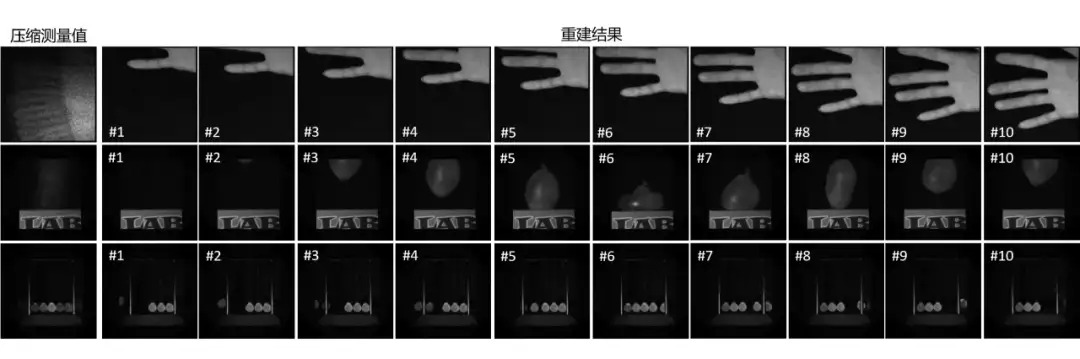

4. 针对快速运行的场景,EfficientSCI++ 也可以给出精确的重建结果,如图 6 所示。

▲ 图4. 不同算法的测试时间&重建质量对比

▲ 图5. 压缩比变化时,不同算法的表现

▲ 表1. EfficientSCI++ 在大尺度彩色测试数据上的性能,其中算法结果中每一格从左到右依次列出了 PSNR,SSIM 和测试时间

▲ 图6. EfficientSCI++ 重建的高速运动场景(压缩比为 10,相机的曝光时间为 20ms)

结论

基于 CNN-Transformer 架构,本文提出一种高效、大尺度的视频单曝光压缩成像重建算法 EfficientSCI++。大量的实验数据表明:相比于之前的视频单曝光压缩成像重建算法,EfficientSCI++ 可以给出相当的重建质量,然而计算复杂度大大降低。此外,为了验证视频单曝光压缩成像重建算法对于不同压缩比的灵活性,我们构建了一套压缩从 10 到 50 连续变化的灰度和彩色真实测试数据集。

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

【技术文档】《从零搭建pytorch模型教程》122页PDF下载

QQ交流群:470899183。群内有大佬负责解答大家的日常学习、科研、代码问题。

其它文章

LSKA注意力 | 重新思考和设计大卷积核注意力,性能优于ConvNeXt、SWin、RepLKNet以及VAN

CVPR 2023 | TinyMIM:微软亚洲研究院用知识蒸馏改进小型ViT

ICCV2023|涨点神器!目标检测蒸馏学习新方法,浙大、海康威视等提出

ICCV 2023 Oral | 突破性图像融合与分割研究:全时多模态基准与多交互特征学习

HDRUNet | 深圳先进院董超团队提出带降噪与反量化功能的单帧HDR重建算法

南科大提出ORCTrack | 解决DeepSORT等跟踪方法的遮挡问题,即插即用真的很香

1800亿参数,世界顶级开源大模型Falcon官宣!碾压LLaMA 2,性能直逼GPT-4

SAM-Med2D:打破自然图像与医学图像的领域鸿沟,医疗版 SAM 开源了!

GhostSR|针对图像超分的特征冗余,华为诺亚&北大联合提出GhostSR

Meta推出像素级动作追踪模型,简易版在线可玩 | GitHub 1.4K星

CSUNet | 完美缝合Transformer和CNN,性能达到UNet家族的巅峰!

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 阿里最新开源QwQ-32B,效果媲美deepseek-r1满血版,部署成本又又又降低了!

· AI编程工具终极对决:字节Trae VS Cursor,谁才是开发者新宠?

· 开源Multi-agent AI智能体框架aevatar.ai,欢迎大家贡献代码

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

2023-05-28 首个大规模使用工具的大模型来了:伯克利发布Gorilla