ICCV 2023|利用双重聚合的Transformer进行图像超分辨率

前言 本文提出了 DAT(Dual Aggregation Transformer),是一种用于图像超分辨率 Transformer 模型。DAT 以块间和块内双重方式,聚合空间和通道特征,实现强大的建模能力。

本文转载自将门创投

作者:陈铮

仅用于学术分享,若侵权请联系删除

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

【CV技术指南】CV全栈指导班、基础入门班、论文指导班 全面上线!!

本文提出一种同时利用图像空间和通道特征的 Transformer 模型,DAT(Dual Aggregation Transformer),用于图像超分辨(Super-Resolution,SR)任务。DAT 以块间和块内的双重方式,在空间和通道维度上实现特征聚合,从而具有强大的图像表示能力。具体来说,DAT 在连续的 Transformer 块中交替应用空间和通道自注意力,以实现块间聚合。同时,本文还提出自适应交互模块(Adaptive Interaction Module,AIM)和空间门前馈网络(Spatial-Gate Feed-forward Network,SGFN)来实现块内特征聚合。AIM 从空间与通道为徒改进现有注意力机制,SGFN 在前馈网络中引入了非线性空间信息。实验证明,DAT 实现目前最先进的图像超分辨率性能。

论文链接:https://arxiv.org/abs/2308.03364

代码链接:https://github.com/zhengchen1999/DAT

一、 研究问题

图像超分辨率(Image Super-Resolution,简称图像 SR)是一种图像处理技术,旨在通过增加图像的细节和清晰度,将低分辨率(LR)图像转换为高分辨率(HR)图像。简单来说,就是将一张小尺寸的模糊图像,变成大尺寸的清晰图像。图像超分辨率技术在实际应用中具有广泛的用途,包括高清电视、监控摄像头、医学影像、卫星图像等。现如今,随着人工智能、机器学习的发展,使用深度学习技术的图像超分辨率成为主流。

二、 方法动机

目前,Transformer 在 SR 任务中表现出色。其核心是自注意力(Self-Attention,SA)机制,能够建立全局依赖关系。而全局关系的建立,对于高分辨率图像的重建尤为重要。然而,全局SA的计算复杂度与图像大小成平方比,这极大的限制了其在高分辨率图像上的应用(这在图像 SR 中很常见)。考虑到这个原因,一些研究人员提出更加高效的 SA,以有效利用 Transformer。总的来说可以分为空间与通道两个方面:

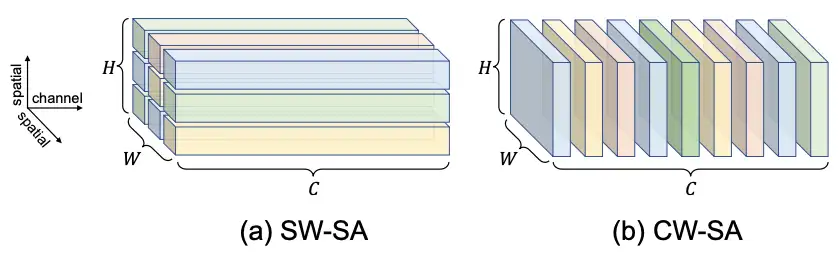

- 空间方面, 局部空间窗口被提出来限制全局 SA 的应用范围, 从而提出局部窗口注意力(Spatial-Window Self-Attention, SW-SA)。如图(a),空间维度被划分为多个窗口, 注意力在每个窗口中被执行。

- 通道方面, 提出通道自注意力(Channel-Wise Self-Attention, CW-SA)。如图(b),注意力沿着通道维度计算。也就是图中每一个独立的块都作为一个 token

这些方法都在降低计算复杂度的同时,实现优异的性能。同时这两种方法对于图像特征的建模,是针对不同(空间与通道)的维度的。那么,是否可以同时考虑两个维度,在现有方法的基础上,进一步提高Transformer的建模能力,实现更加出色的超分辨率性能呢?受以上发现的启发,我们提出 DAT(Dual Aggregation Transformer),通过块间和块内双重方式,实现空间和通道特征有效融合。具体来说,我们在连续的 Transformer 块中交替应用 SW-SA 和 CW-SA 。通过这在交替的方式,DAT 能够同时捕获空间和通道信息,实现块间特征聚合。同时,为了实现块内特征聚合,我们还提出自适应交互模块(Adaptive Interaction Module,AIM)和空间门前馈网络(Spatial-Gate Feed-forward Network,SGFN)。AIM 对 SW-SA 和 CW-SA 建模单一维度进行改进,SGFN 则在前馈网络中引入非线性空间信息。总体而言,我们的贡献可以总结为以下三点:

- 设计了一种新的图像超分辨率模型:DAT。该模型以块间和块内双重方式聚合空间和通道特征,增强 Transformer 的建模能力。

- 交替应用空间和通道自注意力,实现块间特征聚合。此外,还提出 AIM 和 SGFN 来实现块内特征聚合。

- 进行了大量实验,证明提出的 DAT 实现最先进的图像超分辨率性能,同时保持较低的复杂性和模型大小。

三、方法介绍

在本节中,我们首先介绍 DAT 的架构。随后,我们详细阐述自适应交互模块(AIM)和空间门前馈网络(SGFN)两个组件。

3.1 模型架构

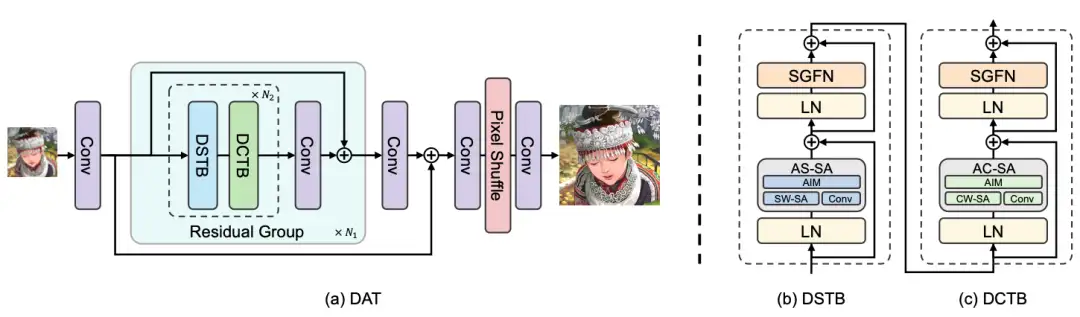

DAT 包含三个模块: 浅层特征提取、深层特征提取和图像重建模块。如图(a)所示, 浅层特征提取模块为单个卷积网络, 用于从低分辨率图像 中提取出浅层特征 。接着通过深层特征提取模块中进行处理, 得到深度特征 。深层特征提取模块由多个残差组(RG)堆叠而成, 每个残差组包含多对 Transformer 块, 每 对包含两个分别利用空间和通道自注意力的 Transformer 块。最后, 我们通过重建模块重建高分辨率图像 。在这个模块中, 深度特征通过像素洗牌方法进行上采样。

正如前文提到,在 DAT 中,我们以交替的方式同时使用 SW-SA 和 CW-SA 两种注意力模块。这种组合,能够对两个维度的特征进行建模,并利用它们的优势互补:

- SW-SA 对空间上下文进行建模,增强每个特征图的空间表达。

- CW-SA 可以更好地构建通道之间的依赖关系,扩大感受野,从而帮助 SW-SA 捕获空间特征。

因此,空间和通道信息在连续的 Transformer 块之间流动,以此实现块间特征聚合。

3.2 自适应交互模块(AIM)

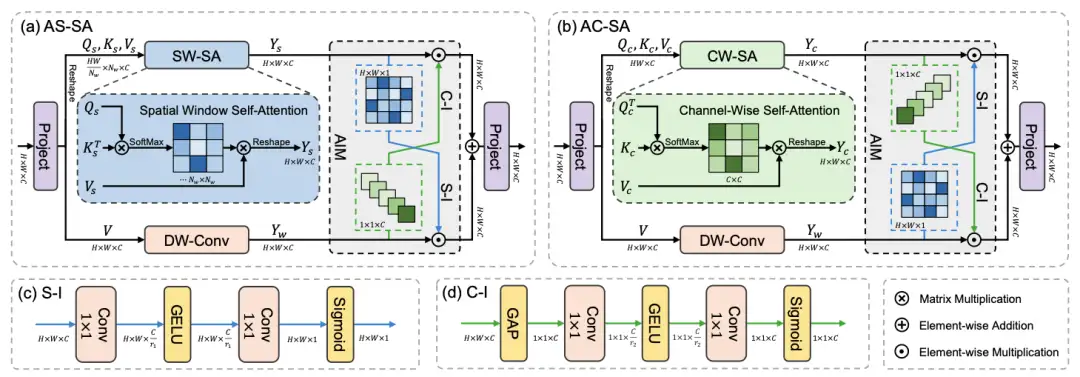

我们提出的 AIM 对 SW-SA 和 CW-SA 实现进一步改进。首先,考虑到自注意力主要是捕获全局特征,我们增加了与自注意力模块平行的卷积分支,依次引入局部性到 Transformer 中。接着,考虑到虽然交替执行 SW-SA 和 CW-SA 可以在块间实现空间与通道的特征聚合,但是对于每个自注意力(SA)而言,不同维度的信息仍然无法有效利用。因此,我们提出了AIM(灰色阴影区),作用于两个分支之间,并根据分支的类型,从空间或通道维度自适应地重新加权特征,从而在单个注意力模块中实现空间和通道信息的聚合。

具体来说,AIM是基于注意力机制设计,包括两种交互操作:空间交互(S-I)和通道交互(C-I):

- S-I:图(c),计算空间注意力图,对特征的空间维度动态调制,引入空间信息。

- C-I:图(d),计算通道注意力图,对特征的空间维度动态调制,引入通道信息。

综合上述改进,我们在 SW-SA 和 CW-SA 的基础上,提出改进版的自适应空间自注意力(Adaptive Spatial Self-Attention,AS-SA)和 自适应通道自注意力(Adaptive Channel Self-Attention,AC-SA)。相比原始自注意力机制,我们的方法具有:

- 局部(卷积)和全局(注意力)更好的耦合:两个分支的输出可以自适应调整以相互适应、融合。

- 更强的建模能力:对于 SW-SA,互补通道信息提高了其通道建模能力;对于 AC-SA,通过空间交互,额外的空间知识同样增强特征表征能力。

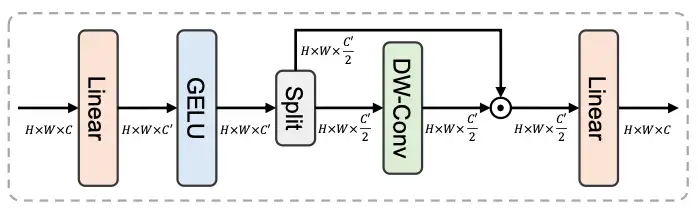

3.3 空间门前馈网络(SGFN)

传统的前馈网络(Feed-Forward Network,FFN)有线性层和非线性激活组成。只能够对特征通道进行建模,忽略了建模空间信息。此外,FFN会通过线性层在内部对特征通道进行放大,这导致通道之间存在冗余,从而阻碍了特征表达能力。

为了克服上述问题,我们提出了 SGFN:将空间门控(Spatial-Gate,SG)引入到 FFN 中。SG 是一个简单的门空机制,由深度卷积和逐元素乘法组成。同时,我们将特征图沿着通道维度,均匀的分为两个部分,分别送入卷积和乘法旁路中,以此来降低通道冗余性。并且该操作也能有效降低计算复杂度。

整体来看,AIM 和 SGFN 是 Transformer 块的两个主要组成。通过这个两个模块,我们实现块内的特征聚合:

- AIM 从通道维度增强 SW-SA,并从空间维度增强 CW-SA。

- SGFN 将非线性空间信息引入仅建模通道关系的 FFN 中。

四、实验结果

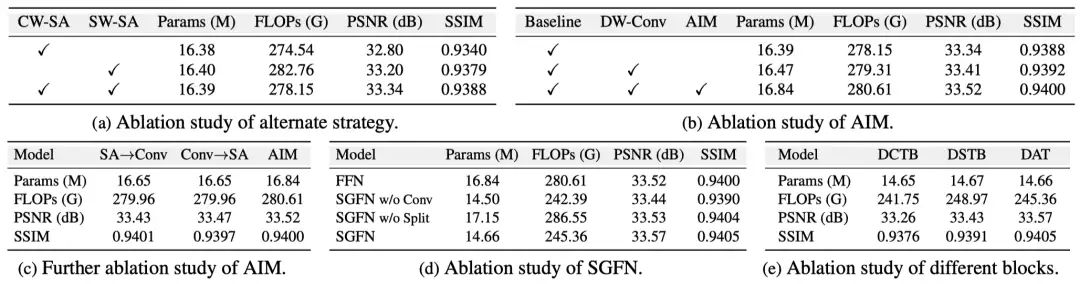

消融实验:我们对提出方法的各个进行详尽的消融实验,证明了方法的有效性。

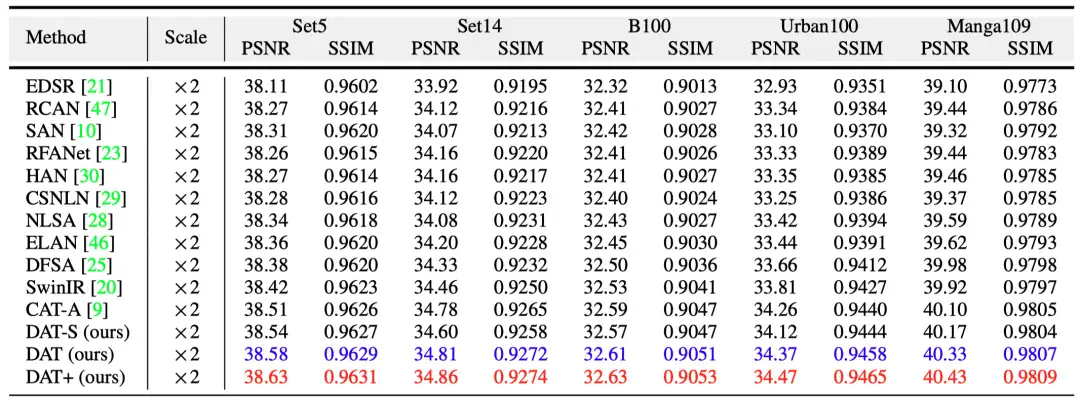

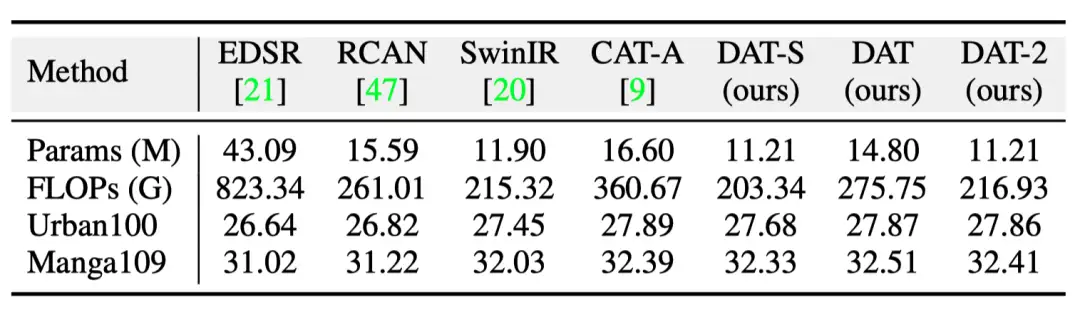

定量对比:我们提出了2个不同大小的模型变体(DAT-S、DAT),与目前最先进的图像超分辨率方法,在5个基准数据集上进行对比。如下表所示,我们的方法取得了最先进的结果。

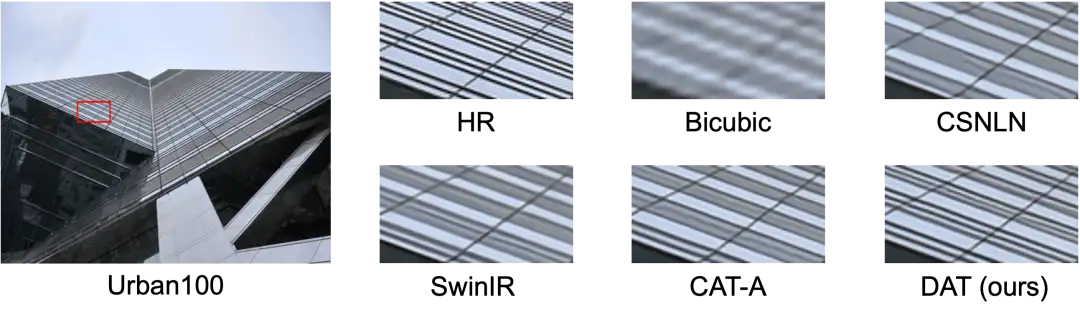

视觉对比:我们在下图中展示了视觉效果的对比结果。可以发现,我们的方法在细节的重建上具有明显的优势。

模型大小:我们还提供了模型大小(Params)、复杂度(FLOPs)、性能上的综合对比。我们的方法在实现性能提升的同时,也保持了较低的复杂性和模型大小。

五、结论

本文提出了 DAT(Dual Aggregation Transformer),是一种用于图像超分辨率 Transformer 模型。DAT 以块间和块内双重方式,聚合空间和通道特征,实现强大的建模能力。具体来说,连续的 Transformer 块交替应用空间窗口和通道自注意力,并实现了空间和通道维度在块间的特征聚合。此外,本文还提出了自适应交互模块(Adaptive Interaction Module,AIM)和空间门前馈网络(Spatial-Gate Feed-forward Network,SGFN),以在两个维度上实现块内特征聚合,从而增强每个 Transformer 块。AIM从两个维度增强自注意力机制的建模能力。而 SGFN 用非线性空间信息补充前馈网络。实验证明,DAT 实现目前最先进的图像超分辨率性能。

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

【技术文档】《从零搭建pytorch模型教程》122页PDF下载

QQ交流群:470899183。群内有大佬负责解答大家的日常学习、科研、代码问题。

其它文章

LSKA注意力 | 重新思考和设计大卷积核注意力,性能优于ConvNeXt、SWin、RepLKNet以及VAN

CVPR 2023 | TinyMIM:微软亚洲研究院用知识蒸馏改进小型ViT

ICCV2023|涨点神器!目标检测蒸馏学习新方法,浙大、海康威视等提出

ICCV 2023 Oral | 突破性图像融合与分割研究:全时多模态基准与多交互特征学习

HDRUNet | 深圳先进院董超团队提出带降噪与反量化功能的单帧HDR重建算法

南科大提出ORCTrack | 解决DeepSORT等跟踪方法的遮挡问题,即插即用真的很香

1800亿参数,世界顶级开源大模型Falcon官宣!碾压LLaMA 2,性能直逼GPT-4

SAM-Med2D:打破自然图像与医学图像的领域鸿沟,医疗版 SAM 开源了!

GhostSR|针对图像超分的特征冗余,华为诺亚&北大联合提出GhostSR

Meta推出像素级动作追踪模型,简易版在线可玩 | GitHub 1.4K星

CSUNet | 完美缝合Transformer和CNN,性能达到UNet家族的巅峰!

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 阿里最新开源QwQ-32B,效果媲美deepseek-r1满血版,部署成本又又又降低了!

· AI编程工具终极对决:字节Trae VS Cursor,谁才是开发者新宠?

· 开源Multi-agent AI智能体框架aevatar.ai,欢迎大家贡献代码

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!