ICCV23|速度提高 500 倍,让 Encoder 在 3D gan Inversion 中大显身手!

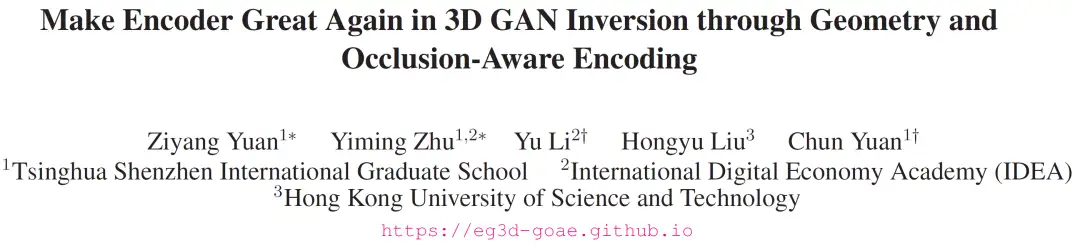

前言 本文介绍了一种基于 EG3D的新颖的基于编码器的反演框架,利用 EG3D 潜在空间的固有属性来设计鉴别器和背景深度正则化,能够训练一个几何感知编码器,将输入图像转换为相应的潜在代码。本文方法取得了与基于优化的方法相当的令人印象深刻的结果,同时运行速度提高了 500 倍。

本文转载自极市平台

仅用于学术分享,若侵权请联系删除

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

【CV技术指南】CV全栈指导班、基础入门班、论文指导班 全面上线!!

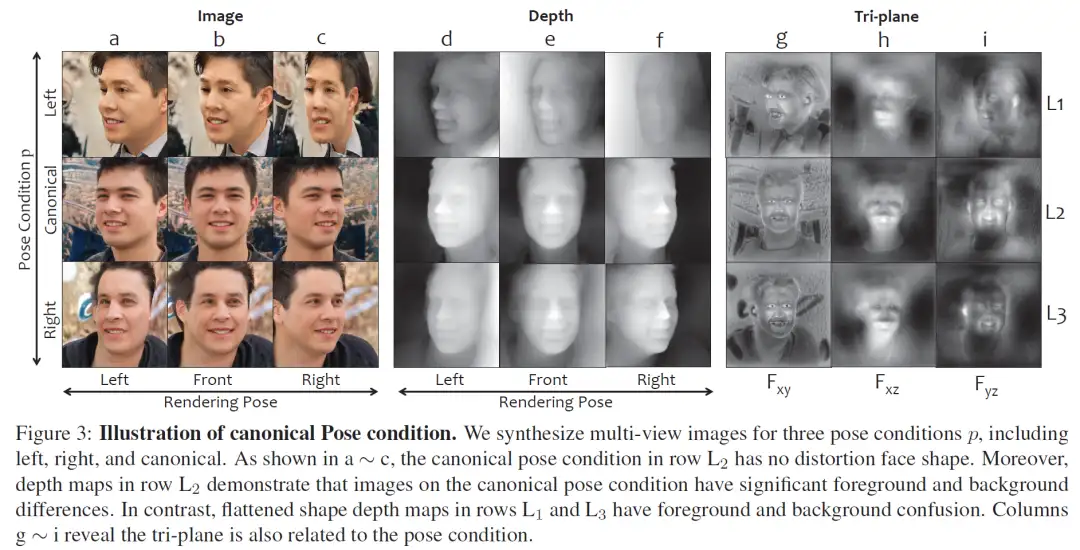

- 论文题目:Make Encoder Great Again in 3D GAN Inversion through Geometry and Occlusion-Aware Encoding

- 项目主页:https://eg3d-goae.github.io

- 论文代码:https://github.com/jiangyzy/GOAE

背景

GAN(生成对抗网络 )是一种生成式的模型,通过随机采样一个 latent(存在于 latent space,通常 W space 或 W+ space),将其输入到网络中可以生成一个真实图像。GAN Inversion 是其逆过程,旨在给定一张参考图片后,通过一系列方法获得其相应的 latent,从而可以输入到 GAN 的生成网络中恢复这个图片。

Inversion 在 2D GAN 中已经有广泛的研究,主要分为以下三种方法,optimization-based,encoder-based,hybrid。Optimization-based 通常通过迭代最小化目标损失函数不断优化一个随机初始的 latent 来得到目标 latent;encoder-based 通过训练一个 encoder 来经过一次网络前向就获得目标 latent;hybrid 会利用 encoder 提供一个合理的初始化 latent,之后再对其进行迭代优化。类似地,3D GAN Inversion 是在 3D GAN 的基础上,给定一张参考图片,找到其对应的 latent 从而获得其 3D 表示,达到三维重建的效果。

动机

不同于 2D, 3D Inversion 在训练过程仅靠单一视角的输入要产生多视角的几何,是一个病态的问题,容易陷入过拟合输入视角的图片,产生平坦的 3D 形状。需要特别考虑几何,遮挡等问题,因此更加复杂,且目前的方法集中在 optimization-based,耗时较久,且容易过拟合到输入视角上,难以获得完整合理的 3D 几何。

因此,我们设计了一个 encoder-based 的框架来解决 3D GAN Inversion。首先探究了 3D GAN 中 canonical space (标准空间)的性质,并以此提出了 geometry-aware (几何感知)的 encoder,以及 Adaptive Feature Align (AFA,自适应特征对齐)模块提升细节纹理,和 mix tri-plane (遮挡感知融合)模块来处理遮挡关系,从而达到了高效高质量的重建和一致的编辑效果。

方法

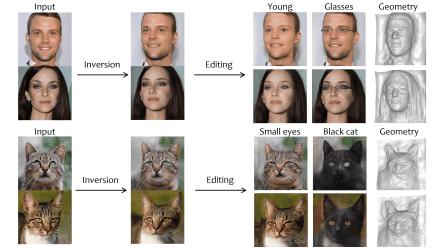

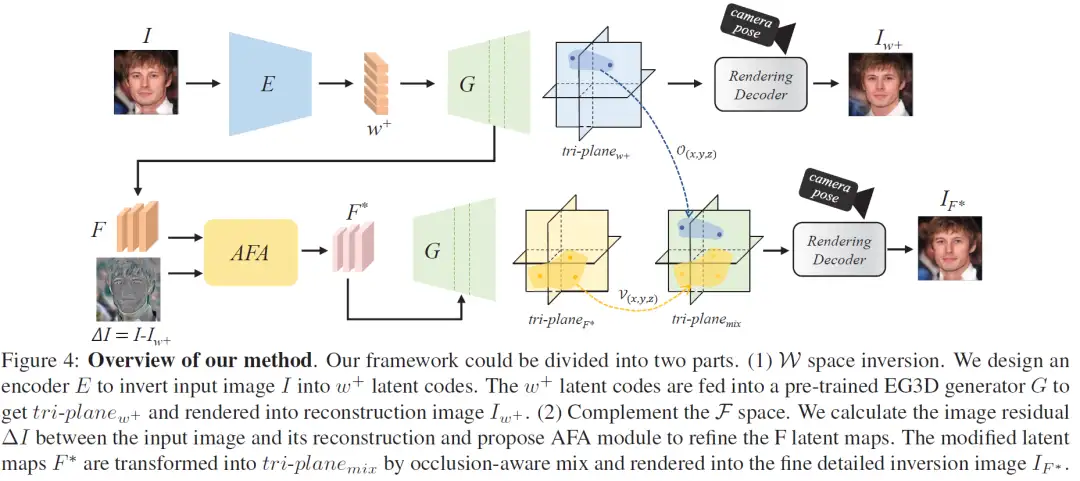

我们以 EG3D 为例进行分析,实验显示不同 condition 下采样的 latent 会产生不同质量的3D几何,在完整的 latent space 中,不是每一个采样的 w 都能产生完整的几何,只有在 canonical latent space 中采样得到的 latent 可以生成高质量的完整几何(Fig. 3 中间一行),其生成的相应 3D 表示 tri-plane上的特征也体现出 canonical 性质,因此定义为 canonical feature space。(以人脸为例,tri-plane 体现的是一个正脸的视角)

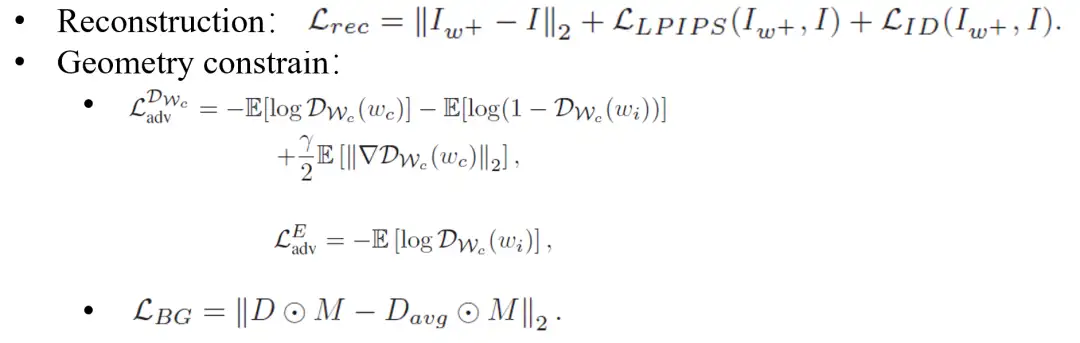

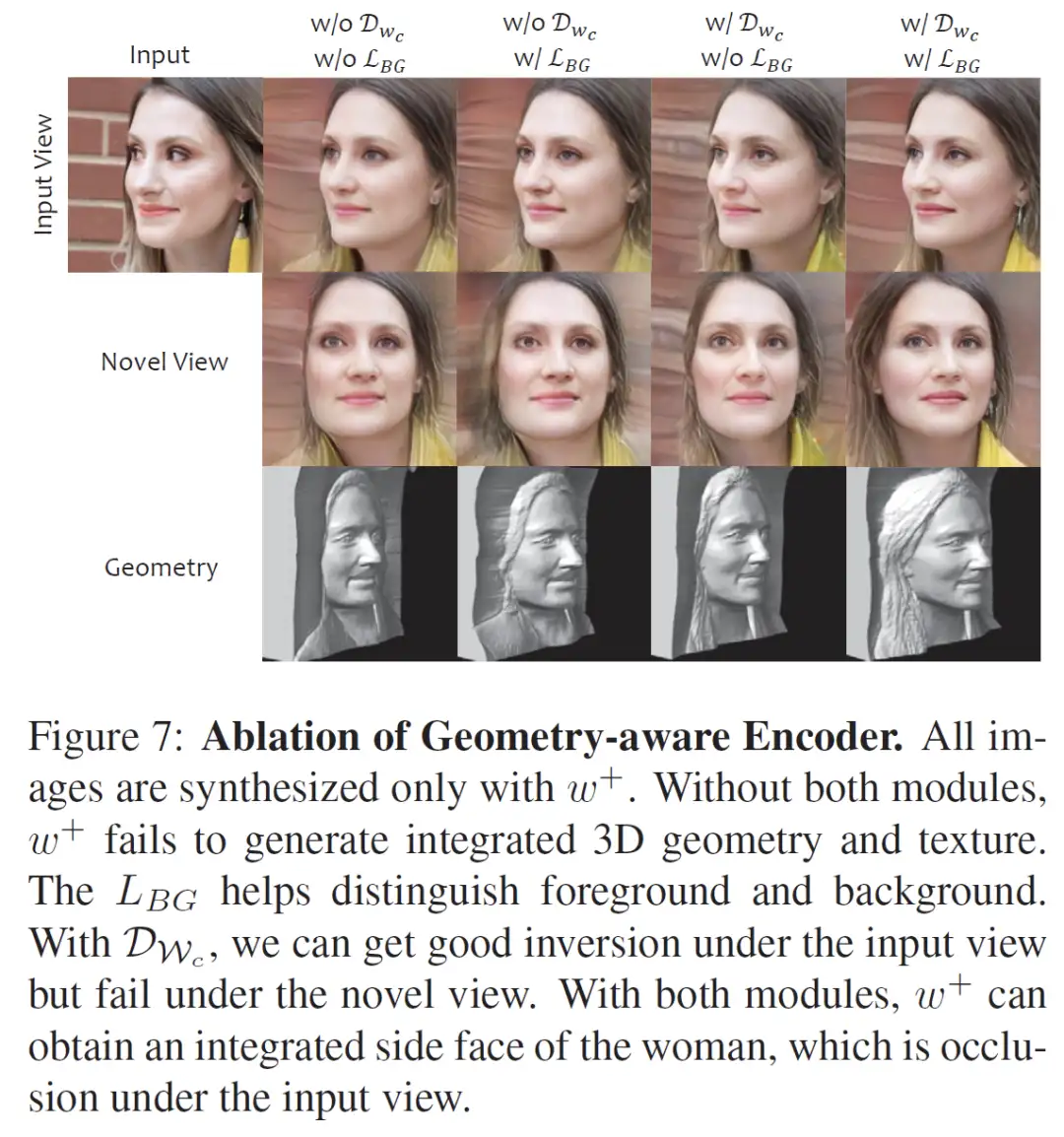

因此,我们第一步构建了一个 geometry-aware encoder,除了,LPIPS,ID 等重建损失,我们提出使用canonical latent space上的对抗损失,用于隐式地拉近重建的 latent space 和 canonical latent space 之间的分布,另一方面我们显式地正则 canonical view 下的背景深度,两者的共同约束让我们避免在训练中过拟合到输入视角,产生平坦几何,而是获得一个可以生成完整的几何的 latent。相关的损失函数定义如下。

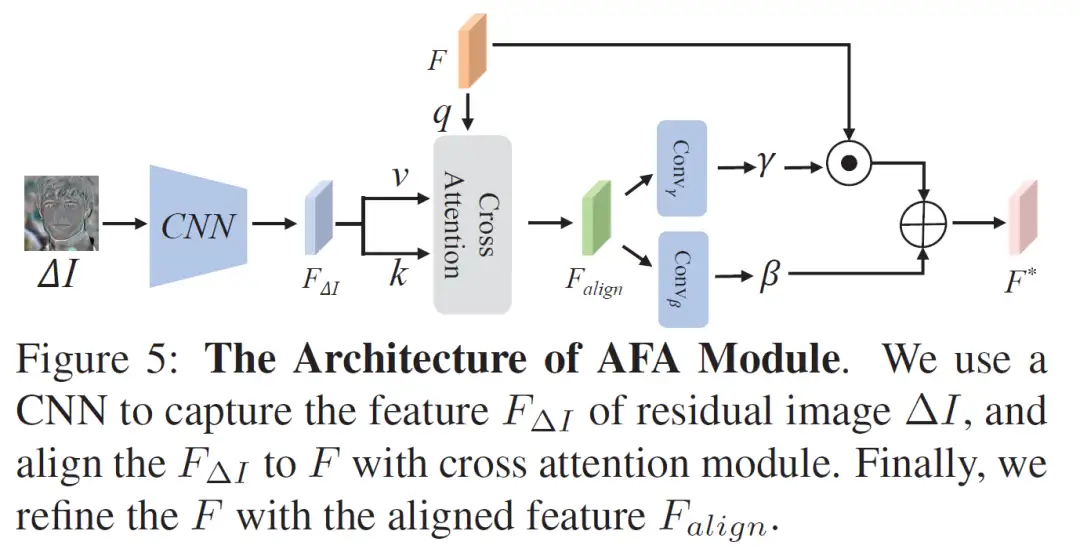

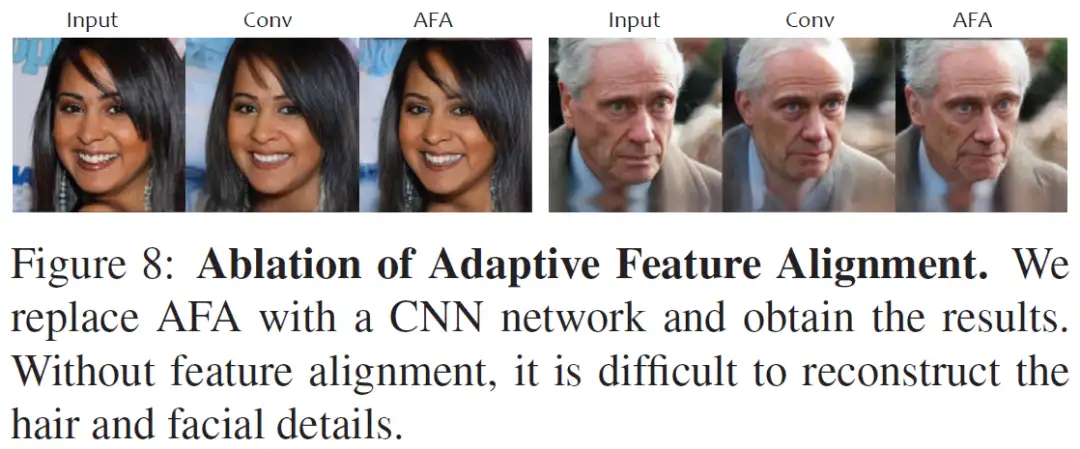

但是 latent (W space,W+ space) 的表达能力在之前 2D GAN Inversion 研究中已经被验证是比较有限的,无法做到高质量的重建,一些细节纹理需要补充,因此设计了自适应特征对齐的 AFA 模块。我们在第一步 encoder 的重建中获得的 latent 生成的 feature 是标准的,然而第一步重建结果和输入图片的残差 feature 是和输入图片的视角绑定在一起的,他们在 spacial 上不能直接对齐,因此这里设计了一个 attention 的调制,把 生成网络中间的 canonical feature 作为 query,残差的 feature 作为 key 和 value 从而将两者自适应地对齐,达到了补充细节纹理的效果。AFA 模块结构如下。

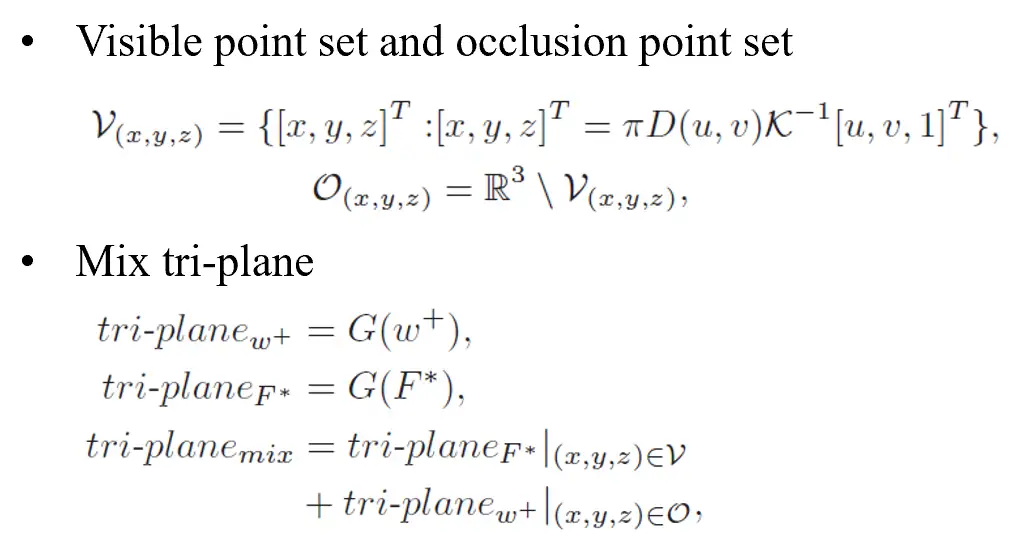

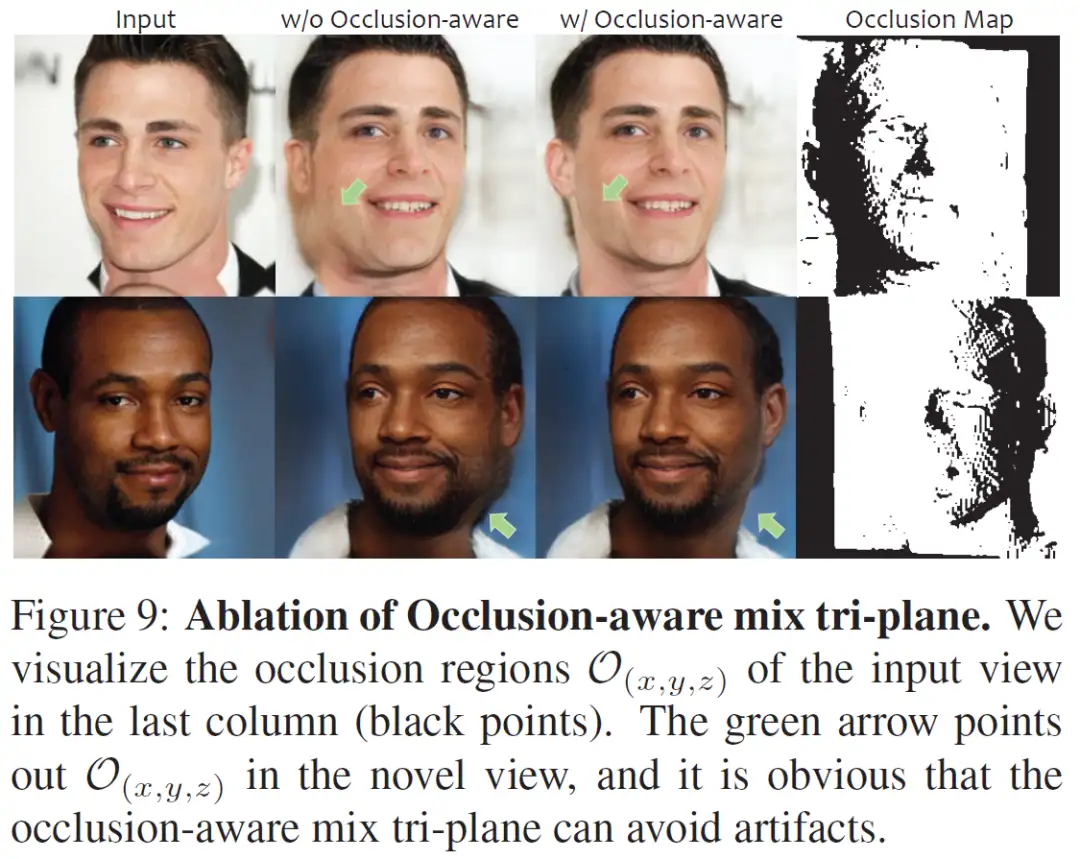

而给定的图片是2D的,存在遮挡的问题,应该只在输入图片能看见的位置补充的细节,因此我们根据相机的内外参和输入视角的深度,定义了可见点集和遮挡点集,在对tri-plane渲染进行特征选取的时候,对于可见点集,我们使用补充细节后的tri-plane的特征;对于遮挡点集,我们使用第一步 encoder 获得的能生成完整几何的 triplane 的特征。通过这种方法,将两个 tri-plane 结合在一起获得最后的 3D 表示。

实验

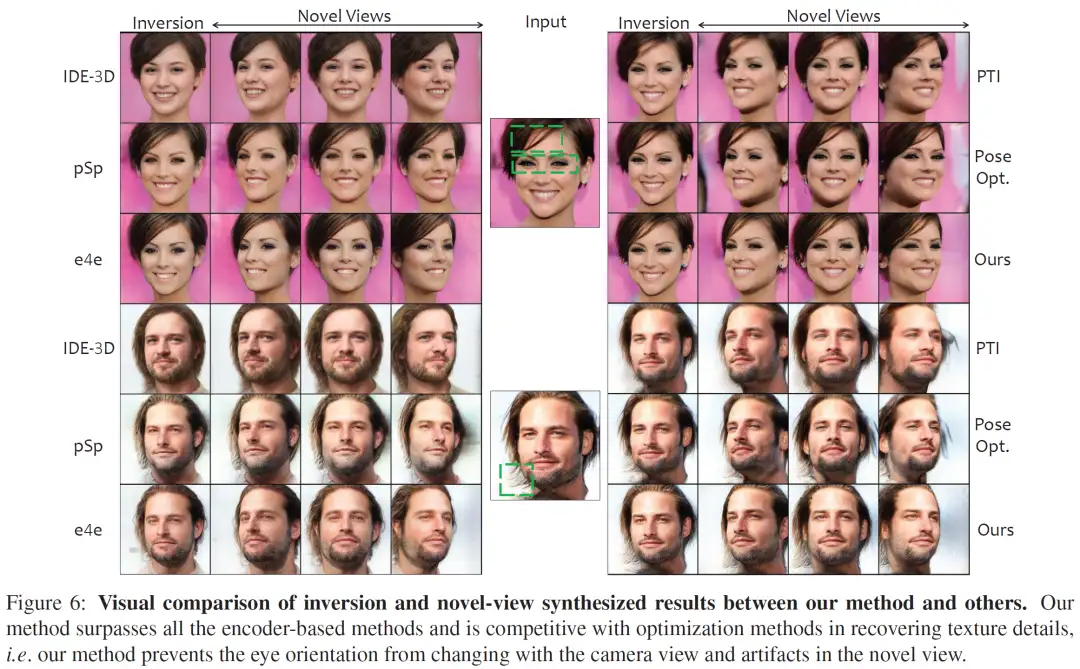

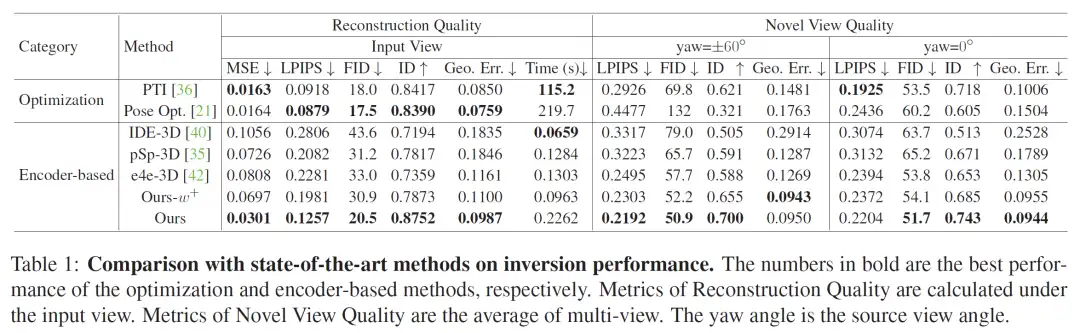

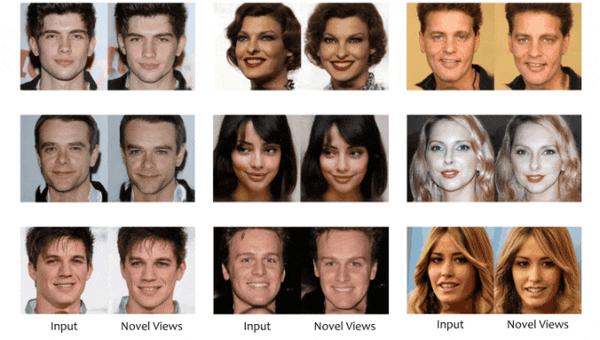

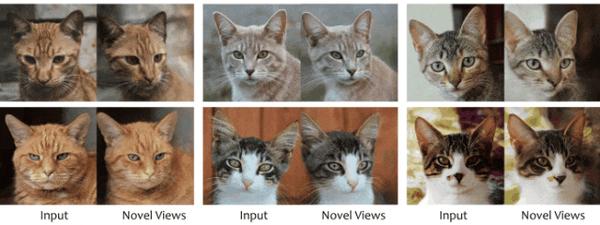

实验对比上,我们的方法和 optimization-based 的方法相比,在输入视角的重建上没有明显差别,且我们不会过拟合在输入视角,能生成高质量的多视角,在极端视角和表情下能有更好的表现。和其他 encoder-based 方法相比各方面质量明显更好。消融实验也体现出上述每一个模块的重要性。

- Qualitative Analysis

- Quantitative Analysis

- novel view video

- Ablation geometry-aware loss

- Ablation AFA

- Ablation mix tri-plane

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

【技术文档】《从零搭建pytorch模型教程》122页PDF下载

QQ交流群:470899183。群内有大佬负责解答大家的日常学习、科研、代码问题。

其它文章

LSKA注意力 | 重新思考和设计大卷积核注意力,性能优于ConvNeXt、SWin、RepLKNet以及VAN

CVPR 2023 | TinyMIM:微软亚洲研究院用知识蒸馏改进小型ViT

ICCV2023|涨点神器!目标检测蒸馏学习新方法,浙大、海康威视等提出

ICCV 2023 Oral | 突破性图像融合与分割研究:全时多模态基准与多交互特征学习

HDRUNet | 深圳先进院董超团队提出带降噪与反量化功能的单帧HDR重建算法

南科大提出ORCTrack | 解决DeepSORT等跟踪方法的遮挡问题,即插即用真的很香

1800亿参数,世界顶级开源大模型Falcon官宣!碾压LLaMA 2,性能直逼GPT-4

SAM-Med2D:打破自然图像与医学图像的领域鸿沟,医疗版 SAM 开源了!

GhostSR|针对图像超分的特征冗余,华为诺亚&北大联合提出GhostSR

Meta推出像素级动作追踪模型,简易版在线可玩 | GitHub 1.4K星

CSUNet | 完美缝合Transformer和CNN,性能达到UNet家族的巅峰!

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 阿里最新开源QwQ-32B,效果媲美deepseek-r1满血版,部署成本又又又降低了!

· AI编程工具终极对决:字节Trae VS Cursor,谁才是开发者新宠?

· 开源Multi-agent AI智能体框架aevatar.ai,欢迎大家贡献代码

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!