Meta-Transformer:1个框架理解12种模态引发的质变与涌现(已开源)

前言 近日,香港中文大学多媒体实验室(CUHK MMLab)联合上海人工智能实验室的OpenGVLAB研究团队提出一个统一多模态学习框架 Meta-Transformer,实现骨干网络的大一统,具有一个模态共享编码器,并且无需配对数据,即可理解 12 种模态信息, 并提供了多模态无边界融合的新范式。相比CLIP、BEiT-3、Imagebind,模态数目大幅增加,并且摆脱了多模态训练过程中对于配对数据的依赖性,为多模态学习提供了新路径。

本文转载自书生 OpenGVLab

仅用于学术分享,若侵权请联系删除

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

【CV技术指南】CV全栈指导班、基础入门班、论文指导班 全面上线!!

量变引起质变,12种模态的初步涌现

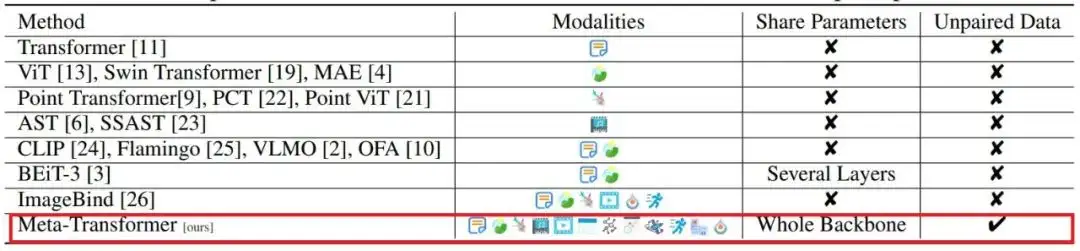

近日,香港中文大学多媒体实验室(CUHK MMLab)联合上海人工智能实验室的OpenGVLAB研究团队提出一个统一多模态学习框架 Meta-Transformer,实现骨干网络的大一统,具有一个模态共享编码器,并且无需配对数据,即可理解 12 种模态信息, 并提供了多模态无边界融合的新范式。相比CLIP、BEiT-3、Imagebind,模态数目大幅增加,并且摆脱了多模态训练过程中对于配对数据的依赖性,为多模态学习提供了新路径。

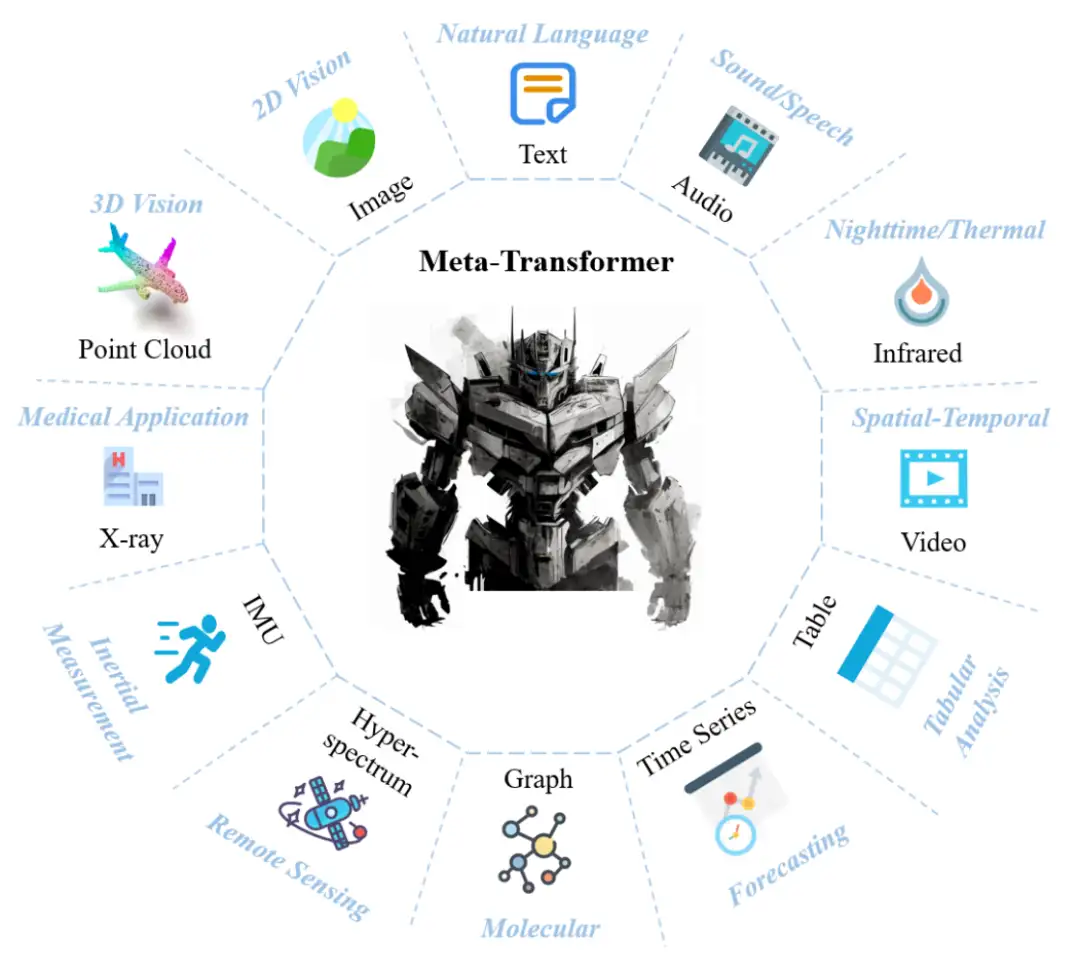

除了文本、图像、点云、音频、视频等常规模态,Meta-Transformer创新性的融合了时间序列,处理红外、超光谱、X 射线、表格、惯性测量单元(IMU)信息。我们惊喜的发现,当单一能力有序组合在一起时,量变引起质变,使得基础模型初步具备涌现能力,能够做天气预测、看X光片判断病情,识别遥感图像,高光谱图像,分析社交网络数据、甚至针对股票数据学习预测等。

进入网站查看报告:https://kxgong.github.io/meta_transformer/

开源代码地址:https://github.com/invictus717/MetaTransformer

外媒关注

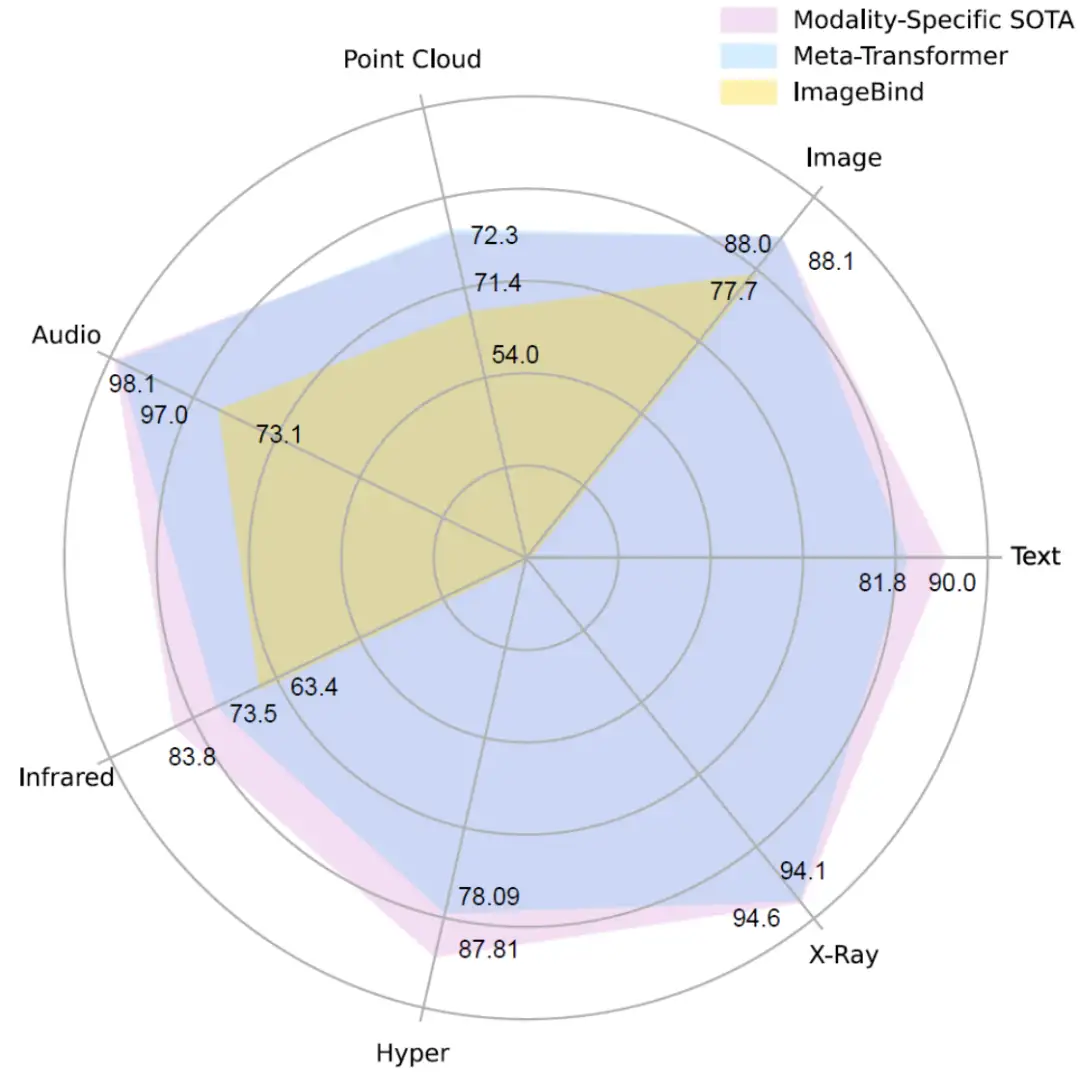

Meta-Transformer发布3天内,已在推特获得40万浏览量,MarketChpst发文解读,评论道:“不同于现有的多模态方法受困于测试任务数据只能是预训练模态的子集,Meta-Transformer仅需要LAION-2B的图文预训练,即可在没有见过的多个模态多个任务上表现出最优性能。”我们认为 ,ChatGPT在单一模态上通过纵向提升参数规模得到的涌现能力,Meta-Transformer可能通过横向的更多模态的通用流型嵌入空间内更加泛化的表征得到了通用感知能力的涌现。例如,在高光谱图像、点云理解、医疗诊断、图像、声音、时间等领域,Meta-Transformer性能均已接近相应领域的专用模型。

技术解读:三大特征

1.统一的模态共享编码器相比于先前 CLIP 使用不同的图像和文本编码器,以及 BEIT-3 的部分共享编码器框架,Meta-Transformer 的核心设计在于一个所有模态完全共享的编码器。该设计在编码器层面统一多达 12 个模态,证明了多模态数据完全共享编码器的可行性。共享编码器有助于在编码器阶段减小由不同的网络参数引入的表征差异,这离统一的多模态感知智能更近了一步,即一个通用的网络结构处理任意模态的信息。

Meta-Transformer 可以有效地处理和学习高达 12 种模态的数据,从常见的文本、图像到音频、视频,甚至在其他更复杂的数据类型上也有所突破,如点云和高光谱数据。该设计有助于拓宽未来的多模态工作的设计思路。

3. 通向模态通用感知现有的多模态模态框架多侧重于视觉和语言,较少衍生到更多其他模态。相比之下,Meta-Transformer 能够对于 12 种不同的数据模态提供一套统一的学习框架,包括文本、图像、点云、音频、视频、红外、超光谱、X 射线、表格、图形、时间序列和惯性测量单元(IMU)数据。这种广泛的数据模态覆盖,极大扩展了 Meta-Transformer 的应用范围,并且 Meta-transformer 框架对于扩展到更多的模态有着易扩展、低成本、高训练效率的优势。

技术解读:方法介绍

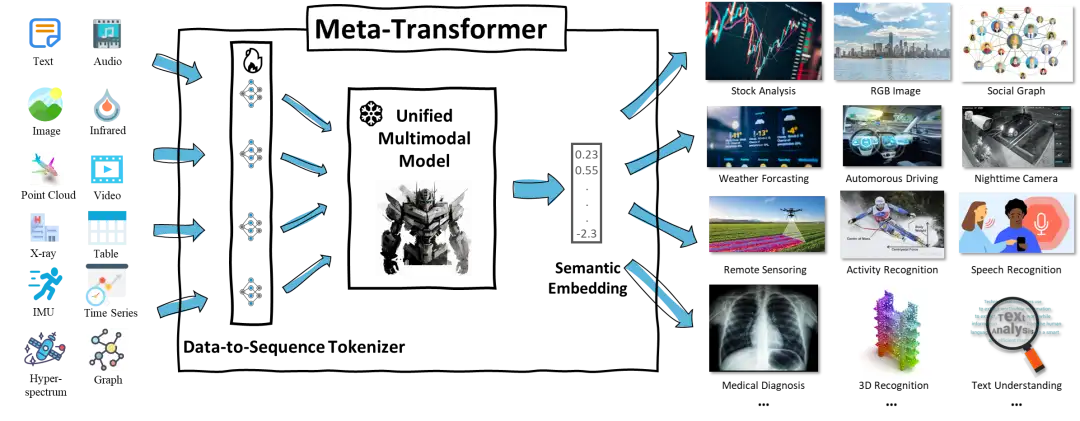

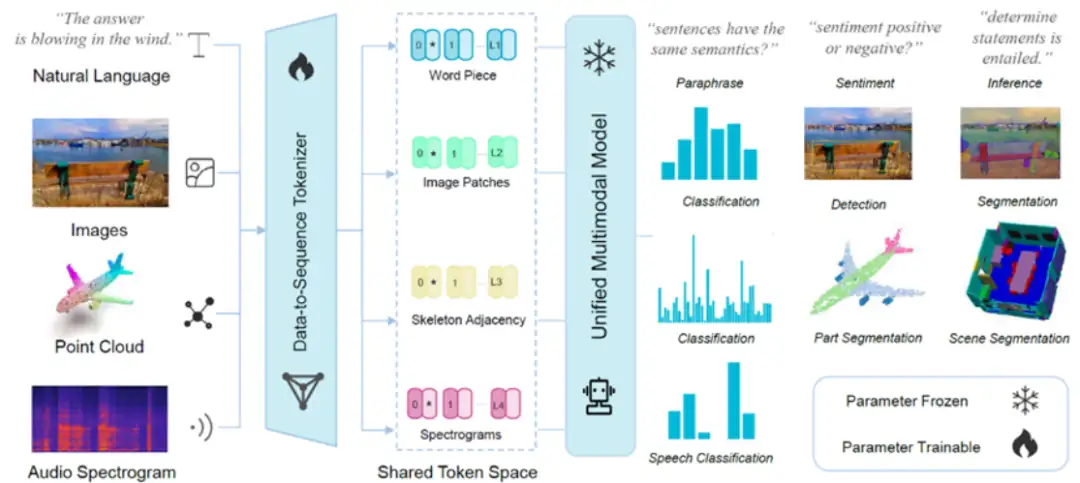

Meta-Transformer 统一处理来自不同模态的数据,并通过共享编码器完成对十二种模态的编码。为了实现这一目标,Meta-Transformer 由三个部分组成:Data2Seq tokenization 模块、统一的共享编码模块和下游任务学习模块。

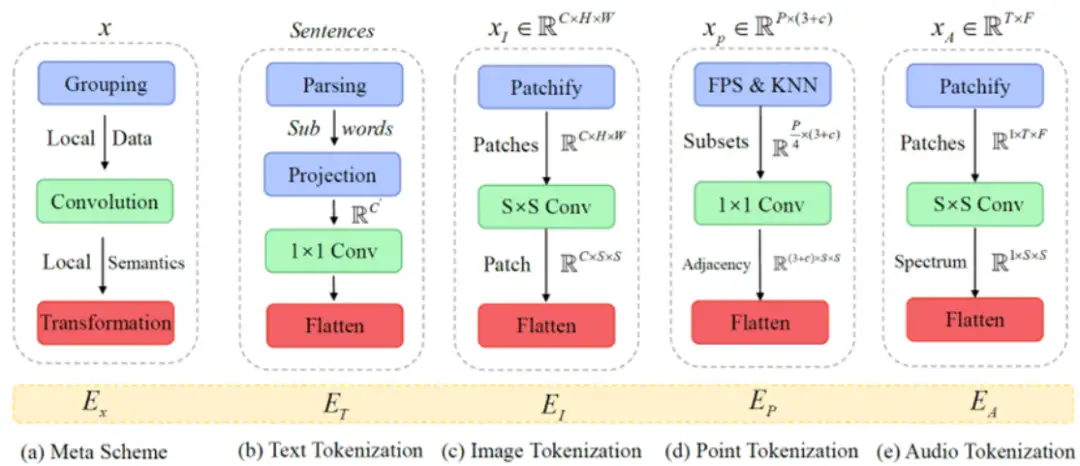

首先,研究人员提出了一套处理多模态数据的核心方案:数据分组 — 卷积提取局部语义 — 语义聚合 —— 空间映射,将各种模态的数据转换为在同一个共享的嵌入空间内的 token 序列。

紧接着,Meta-Transformer 将使用统一的共享编码器对上一步得到的的不同模态的 token 序列进行编码。研究人员使用 LAION-2B 数据集对于骨干网络进行预训练,在预训练之后冻结了模型参数,得到深度为 L 的 Transformer 编码器由多个堆叠的多头自注意力(MSA)层和 MLP 块组成。输入的 token 首先进入 MSA 层,然后进入 MLP 块。然后第 (ℓ- 1) 个 MLP 块的输出作为第ℓ个 MSA 层的输入,层归一化(LN)被添加到每一层之前。MLP 包含两个线性 FC 层和一个 GELU 非线性激活层。

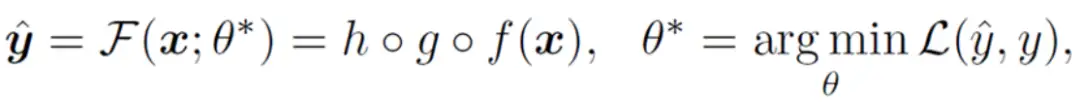

最后,在获得学习表征后,研究人员将表征输入特定任务的头,它主要由 MLP 组成,因模态和任务而异。Meta-Transformer 的学习目标可以概括为

其中 h (・),g (・),与 f (・),分别表示 tokenizer,模型骨干网络,以及下游任务网络中的运算过程。

技术解读:实验结果

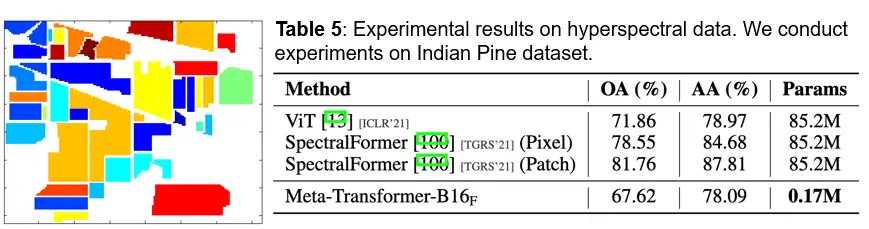

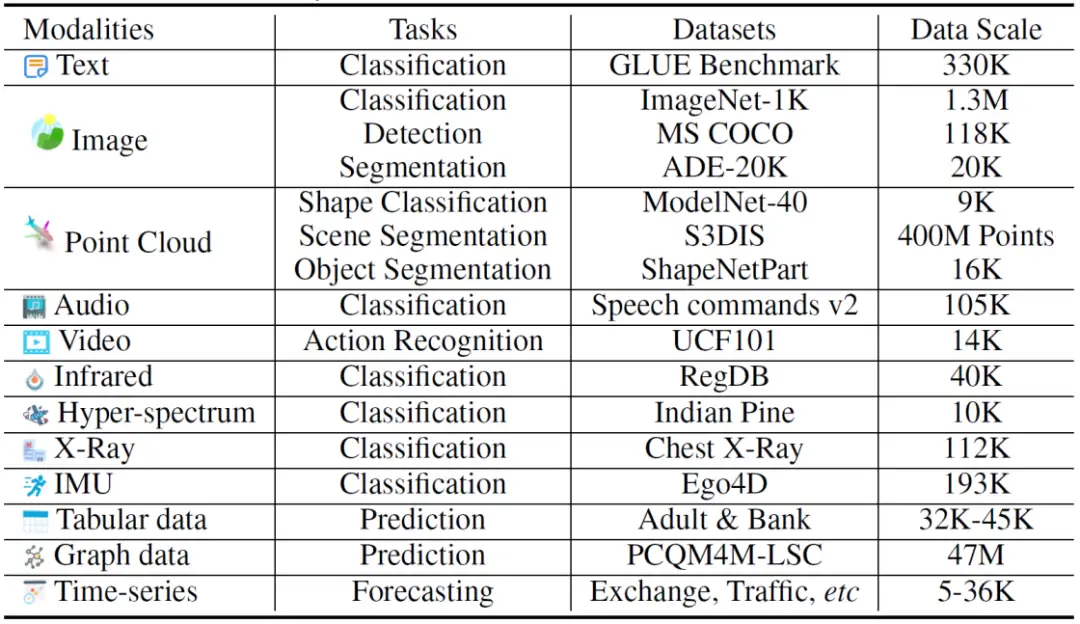

Meta-Transformer 具有丰富且优秀的实验结果。下表 2 展示了 Meta-Transformer 在不同模态上的实验内容。可以看出,Meta-Transformer 从 12 种模态中提取表征信息,能够有效地服务 16 个不同模态的下游任务,且拥有出色的性能。

图像理解能力:

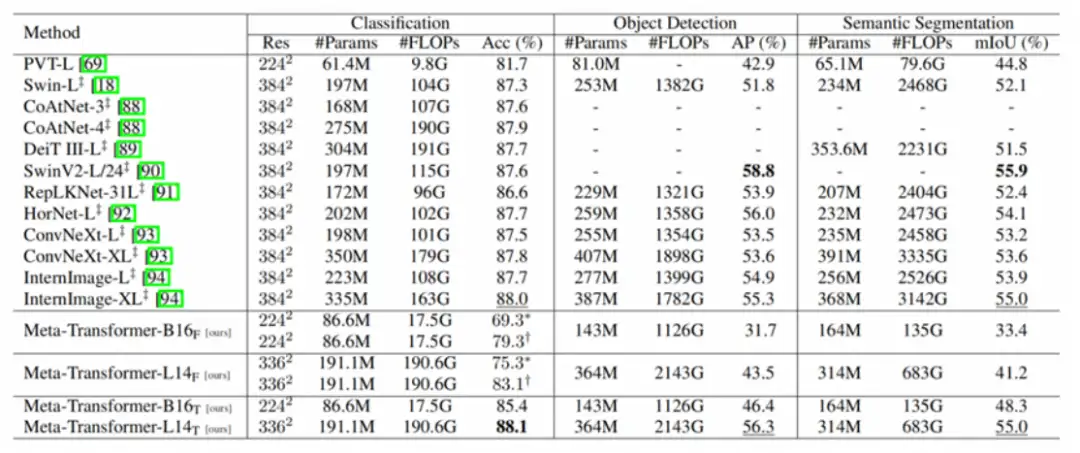

如下表 3 所示,与 Swin Transformer 系列和 InternImage 相比,Meta-Transformer 在图像理解任务中表现突出。在分类任务中,Meta-Transformer 与 Meta-Transformer-B16F 和 Meta-Transformer-L14F 在零镜头分类下的表现非常好,分别达到了 69.3% 和 75.3%。与此同时,当调整预训练参数时,Meta-Transformer-B16T 和 Meta-Transformer-L14T 分别达到 85.4% 和 88. 1% 的准确率,超越了现有最先进的方法。在目标检测与语义分割方面,Meta-Transformer 也提供了出色的性能,进一步证明了其对图像理解的通用能力。

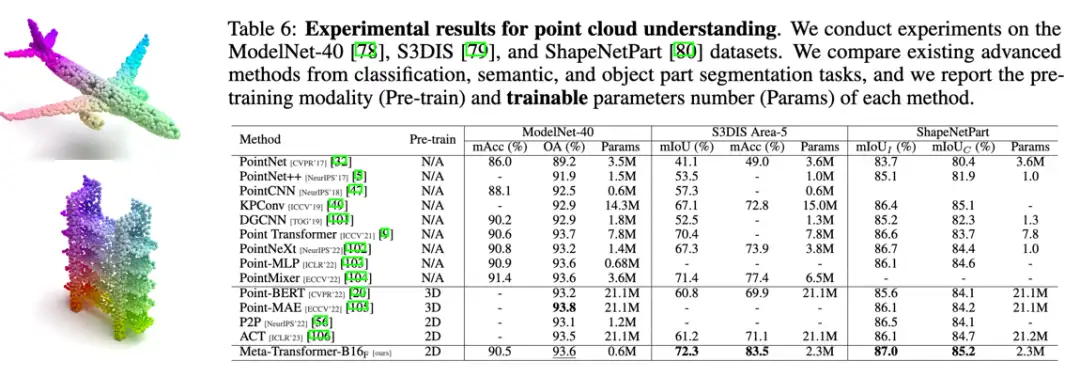

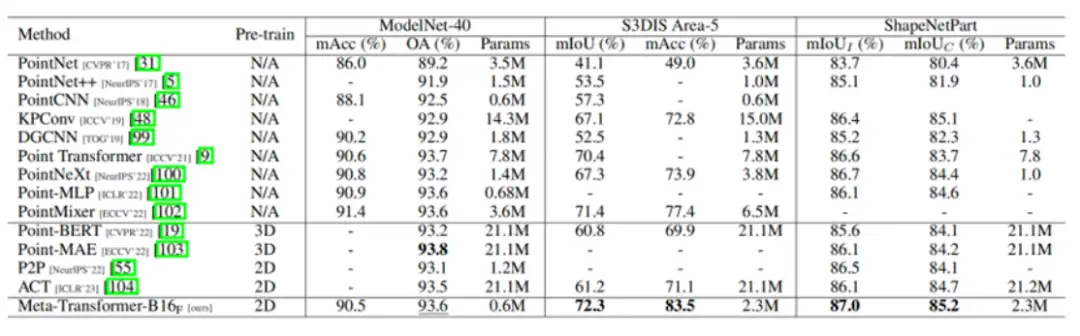

点云理解能力:

表 4 展示了 Meta-Transformer 在点云上的实验结果。当在二维数据上进行预训练时,Meta-Transformer 在 ModelNet-40 上仅用 0.6M 可训练参数就达到了 93.6% 的总体准确率(OA),与表现最好的模型不相上下。此外,Meta-Transformer 在 ShapeNetPart 数据集中表现出色,仅训练 2.3M 参数的情况下,在实例 mIoU 和类别 mIoU 方面都获得了最好的实验结果,分别为 87.0% 和 85.2%。由此可见,Meta-Transformer 在点云理解任务中表现出了显著的优势,在可训练参数较少的情况下提供了具有竞争力的性能。

研究结论

Meta-Transformer 是一种统一的多模态学习框架,它能处理并关联来自多种模态的信息,包括自然语言、2D 图像、3D 点云、音频、视频等。它实现了无配对训练数据的场景下进行多模态感知,是第一个能够在 12 种模态上进行统一学习的框架。Meta-Transformer 能够有助于将多模态大模型推广至更多模态,也为实现统一的多模态智能提供了参考。Meta-Transformer 具有的多模态感知理解能力也会为人工智能技术作为服务全社会的基础设施,对于教育、医疗、娱乐等领域提供更智能、更便捷、更丰富多元的服务。

网站地址:https://kxgong.github.io/meta_transformer/

开源代码地址:https://github.com/invictus717/MetaTransformer

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

【技术文档】《从零搭建pytorch模型教程》122页PDF下载

QQ交流群:470899183。群内有大佬负责解答大家的日常学习、科研、代码问题。

其它文章

比Meta「分割一切AI」更全能!港科大版图像分割AI来了:实现更强粒度和语义功能

Meta Segment Anything会让CV没前途吗?

CVPR'2023年AQTC挑战赛第一名解决方案:以功能-交互为中心的时空视觉语言对齐方法

6万字!30个方向130篇 | CVPR 2023 最全 AIGC 论文汇总

ICCV2023 | 当尺度感知调制遇上Transformer,会碰撞出怎样的火花?

新加坡国立大学提出最新优化器:CAME,大模型训练成本降低近一半!

SegNetr来啦 | 超越UNeXit/U-Net/U-Net++/SegNet,精度更高模型更小的UNet家族

libtorch教程(一)开发环境搭建:VS+libtorch和Qt+libtorch

NeRF与三维重建专栏(三)nerf_pl源码部分解读与colmap、cuda算子使用

NeRF与三维重建专栏(二)NeRF原文解读与体渲染物理模型

BEV专栏(一)从BEVFormer深入探究BEV流程(上篇)

可见光遥感图像目标检测(三)文字场景检测之Arbitrary

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 阿里最新开源QwQ-32B,效果媲美deepseek-r1满血版,部署成本又又又降低了!

· AI编程工具终极对决:字节Trae VS Cursor,谁才是开发者新宠?

· 开源Multi-agent AI智能体框架aevatar.ai,欢迎大家贡献代码

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

2020-07-28 ubuntu16安装ROS(包括win10子系统ubuntu同样能用)