视觉定位领域专栏(一)领域介绍、应用场景和研究难点

前言 本篇主要介绍三个方面,即视觉定位领域介绍、应用场景以及研究难点,同时会对专栏后续讲解内容做一个概述。

本教程禁止转载。同时,本教程来自知识星球【CV技术指南】更多技术教程,可加入星球学习。

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

【CV技术指南】CV全栈指导班、基础入门班、论文指导班 全面上线!!

视觉定位

首先,讲一下什么是视觉定位, 我们都知道,哲学领域存在三大问题,即我是谁,我在哪,我要到哪里去。视觉定位领域解决的问题就是“我在哪里”的问题。

多智能体比如扫地机器人、自动驾驶汽车等方面的研究通常会涉及定位、感知、规划、控制等方面,视觉定位则属于定位范畴,是其中的一种主要方法。我们知道定位可以通过很多方法去解决,比如室外环境下可以利用GNSS、GPS来定位手机或车辆,室内环境下可以利用WIFI定位、蓝牙定位等等,同时还可以辅助其他传感器一起定位,比如结合IMU(惯性测量单元)、激光雷达、相机等等,而视觉定位则是以相机为主要传感器,通过相机拍摄的图像来研究定位问题,他的定义很简单,即估计拍摄图像时相机相对于给定坐标系的六自由度的姿态,包括3自由度的位置和3自由度的方向。

应用场景

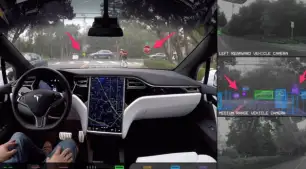

视觉定位的应用场景涉及非常广泛,在很多应用上都有其影子,比如在自动驾驶领域,针对智能车,只有知道了汽车当时自身所处的位置和方向才能进行下一步的规划控制,而特斯拉也以其纯视觉的自动驾驶解决方案闻名,因为在各厂商车企来说,相机的性价比是最高的。但是笔者认为视觉不是万能的,视觉的corner case还有很多,一定是需要其他传感器的支持的,但总的来说,以相机为主,辅以其他传感器,多元传感器融合的策略才是主流。

除了在自动驾驶上的应用,还有比如在各种机器人上的应用,比如服务机器人,我们吃海底捞经常会遇见的送餐机器人,还有扫地机器人,工业上的勘探机器人以及大疆的无人机等等都有其应用,这些机器人能够顺利的走进我们的生产生活中,很大程度上就源于定位技术的发 展,即机器人与环境的任何交互,都离不开机器人在环境中的准确定位。

除了上述应用,视觉定位在最近大火的元宇宙、增强现实、混合现实中也有着丰富的应用,譬如,微软的混合现实头戴式显示器 Hololens 2,荣获 2020 5G 全球应用大赛唯一金奖的华为河图,iRobot 搭载摄像头、可实现高效全景导航的 Roomba i7+系列扫地机器人,贝壳如视的 VR 看房系统等。

而且,视觉定位也可应用在SFM(Structure-from-motion)和SLAM中的闭环检测,总的来说,其应用领域很广泛,研究价值也很高,是一个研究了很久的课题,从三大CV顶会(ECCV、ICCV、CVPR)中关于视觉定位的文章数量就可见一斑。

研究难点

介绍完应用领域,可能有人会觉得,视觉定位都被研究这么久了,是不是可以做的点很少了啊,其实不尽然,领域中仍然有很多急需解决的问题。

衡量视觉定位算法的好坏在于其场景规模、鲁棒性以及效率上,即要在昼夜变化、天气季节的变化下仍可以估计准确的相机姿态,同时还要保证计算效率尽可能的快,还涉及不同规模场景下的定位算法。

目前大多数视觉定位方法是在提前构建好的三维地图基础上进行,地图大多依赖Structure-from-motion(SFM)方法构建,这势必存在一定的局限性,即当扩展到大规模城市级场景下地图的存储问题以及定位算法的效率问题,大规模场景下地图存储的点云以及描述子会存在大量的冗余性以及模糊性。而且每个构建的场景都必须经过仔细的预扫描和重建,首先需要从数百个不同的视点收集图像,理想的情况是跨越一天中的不同时间甚至一年中不同的季节,然后还需要准确估计拍摄这些图片的相机的空间位置和方向,这通常需要精确的多相机校准、与激光雷达扫描对齐等等以得到准确的相机姿态。在不计算收集场景数据的代价下,仅构建场景的三维模型根据场景的大小需要几小时到几天时间不等。

所以,目前领域内的研究点主要集中在以下几个方面:

- 可扩展性,即设计的算法要尽可能地覆盖大的应用范围,不仅可以在室内场景下工作,而且在城市级(自动驾驶领域)场景下仍要可以准确定位。

- 鲁棒性,即设计的算法不仅要在白天可以正常工作,而且在雨雪天、甚至是大雾、夜间等极端条件下仍可以定位定姿。

- 效率,即要求涉及的算法可以实时输出结果,因为很多应用,比如自动驾驶汽车等要求实时性。

介绍完了视觉定位领域主要内容以及应用场景和研究难点,之后对后续的内容做一个大纲,方便大家跟踪学习。

之后会介绍:

- 常用数据集以及评估度量标准,届时会贴上各数据集获取地址以及介绍几个很不错的开源项目。

- 领域需要的技能和基础几何数学知识,包括但不限于三维空间刚体运动、李群和李代数相关、相机模型和一些非线性优化的知识。

- 领域其他相关知识,包括特征提取和匹配、对极几何、三角化、PNP、BA和ICP等等

- 最后会对领域内几种主流研究方向根据代表论文的形式进行总结解读。

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

【技术文档】《从零搭建pytorch模型教程》122页PDF下载

QQ交流群:470899183。群内有大佬负责解答大家的日常学习、科研、代码问题。

其它文章

【CV技术指南】咱们自己的CV全栈指导班、基础入门班、论文指导班 全面上线!!

CVPR 2023|21 篇数据集工作汇总(附打包下载链接)

CVPR 2023|两行代码高效缓解视觉Transformer过拟合,美图&国科大联合提出正则化方法DropKey

ViT-Adapter:用于密集预测任务的视觉 Transformer Adapter

CodeGeeX 130亿参数大模型的调优笔记:比FasterTransformer更快的解决方案

CVPR 2023 深挖无标签数据价值!SOLIDER:用于以人为中心的视觉

上线一天,4k star | Facebook:Segment Anything

Efficient-HRNet | EfficientNet思想+HRNet技术会不会更强更快呢?

ICLR 2023 | SoftMatch: 实现半监督学习中伪标签的质量和数量的trade-off

目标检测创新:一种基于区域的半监督方法,部分标签即可(附原论文下载)

CNN的反击!InceptionNeXt: 当 Inception 遇上 ConvNeXt

拯救脂肪肝第一步!自主诊断脂肪肝:3D医疗影像分割方案MedicalSeg

AI最全资料汇总 | 基础入门、技术前沿、工业应用、部署框架、实战教程学习

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 阿里最新开源QwQ-32B,效果媲美deepseek-r1满血版,部署成本又又又降低了!

· AI编程工具终极对决:字节Trae VS Cursor,谁才是开发者新宠?

· 开源Multi-agent AI智能体框架aevatar.ai,欢迎大家贡献代码

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!