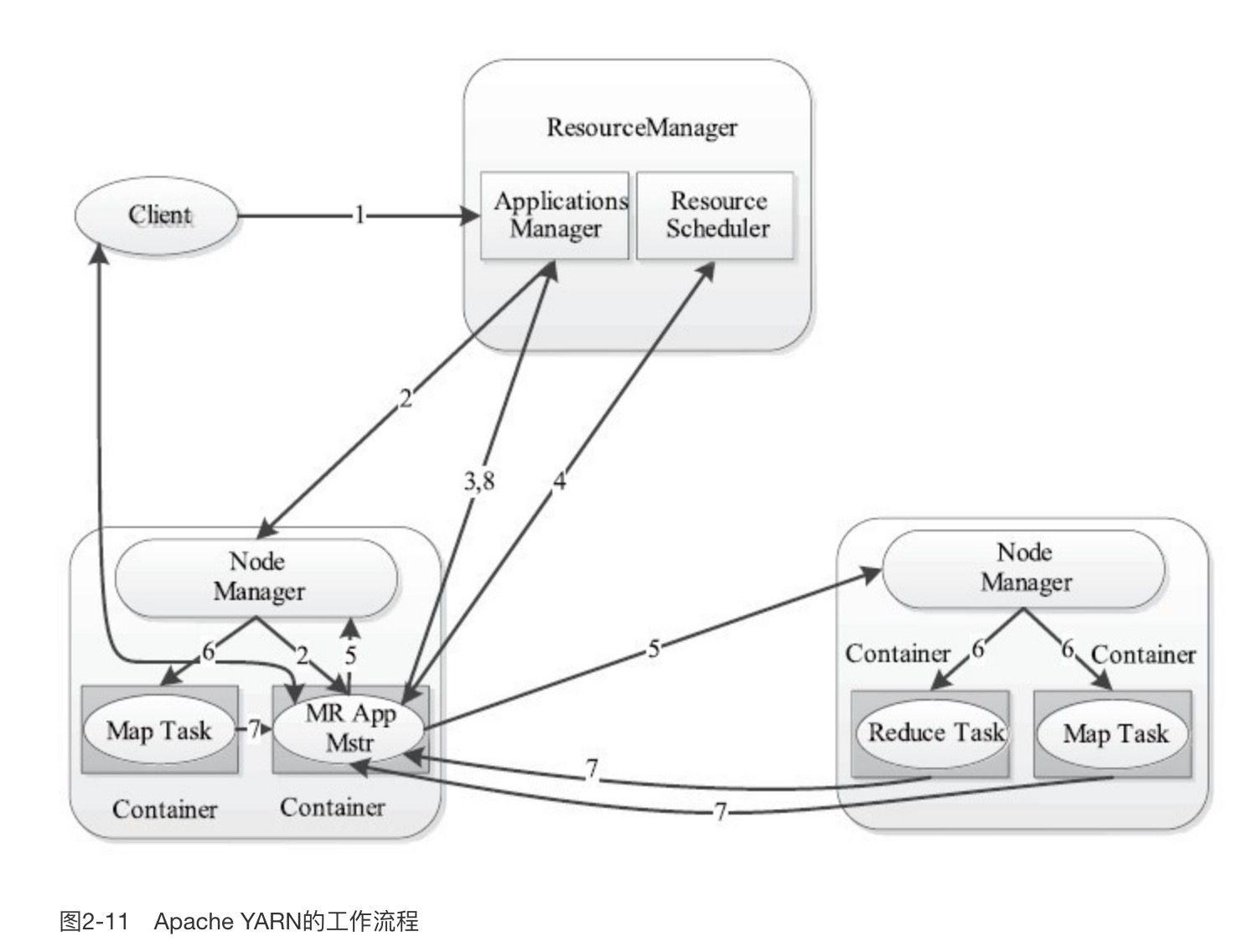

一、Yarn基本架构

YARN主要由ResourceManager、NodeManager、ApplicationMaster和Container组成,之间通过RPC通讯

1、ResourceManager:是一个全局的资源管理器,负责整个系统的资源管理和分配。它主要由两个组件构成:调度器(Scheduler)和应用程序管理器(Applications Manager,ASM)

2、NodeManager:是每个节点上的资源和任务管理器,一方面,它会定时地向ResourceManager汇报本节点上的资源使用情况和各个Container的运行状态;另一方面,它接收并处理来自ApplicationMaster的Container启动/停止等各种请求

3、Container:是YARN中的资源抽象,它封装了某个节点上的多维度资源,如内存、CPU、磁盘、网络等,当AM向RM申请资源时,ResourceManager为ApplicationMaster返回的资源便是用Container表示

4、ApplicationMaster:用户提交的每个应用程序均包含一个ApplicationMaster,主要功能包括:

1)与ResourceManager调度器协商以获取资源(用Container表示)

2)将得到的任务进一步分配给内部的任务

3)与NodeManager通信以启动/停止任务

4)监控所有任务运行状态,并在任务运行失败时重新为任务申请资源以重启任务

注意:MapTask、ReduceTask都运行在Container里面,ApplicationMaster也运作在Container里面,ApplicationMaster负责协调分发Task到Container

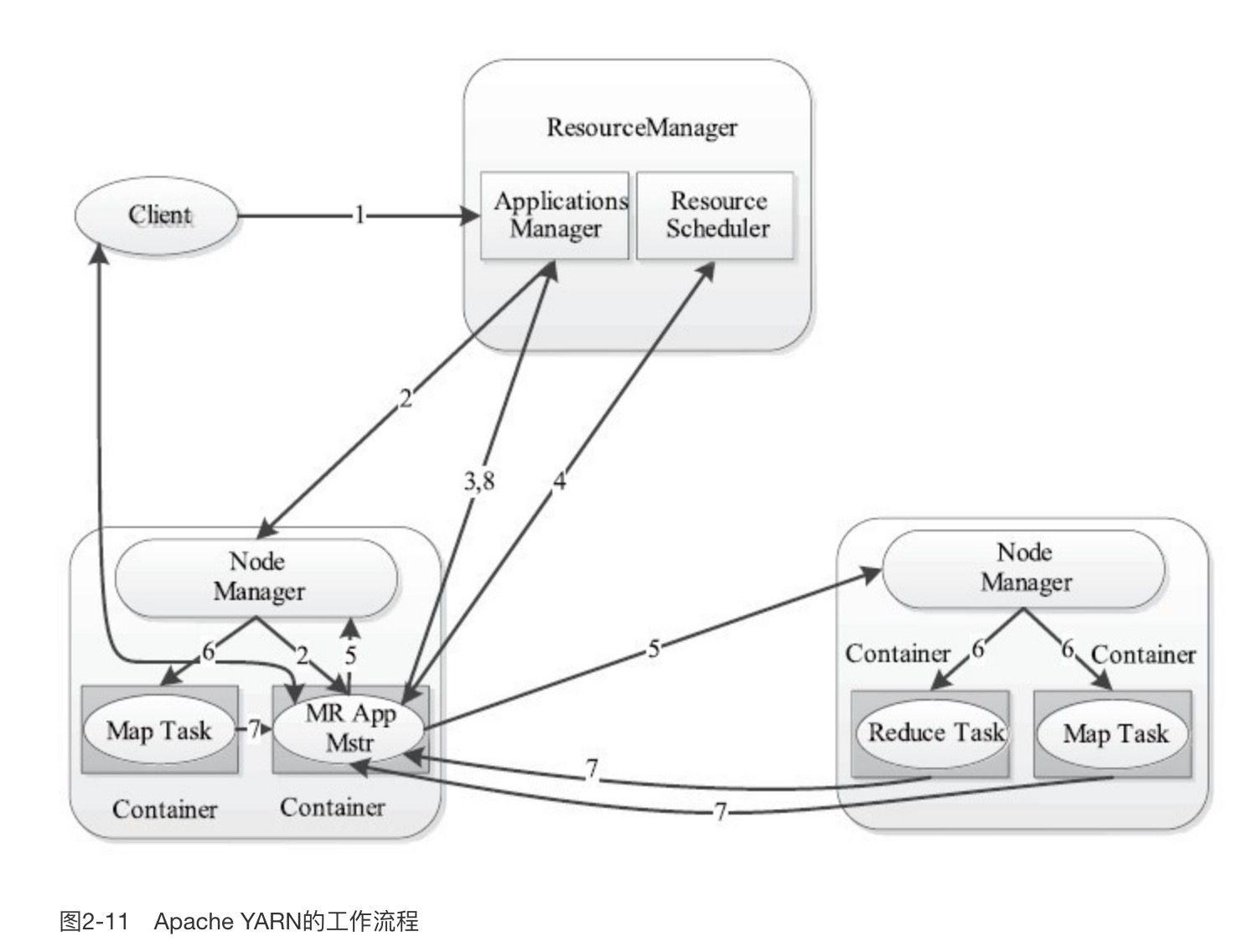

二、Yarn工作流程

当用户向YARN中提交一个应用程序后,YARN将分两个阶段运行该应用程序:第一个阶段是启动ApplicationMaster;第二个阶段是由ApplicationMaster创建应用程序,为它申请资源,并监控它的整个运行过程,直到运行完成。

如图2-11所示,YARN的工作流程分为以下几个步骤:

步骤1 用户向YARN中提交应用程序,其中包括ApplicationMaster程序、启动ApplicationMaster的命令、用户程序等

步骤2 ResourceManager为该应用程序分配第一个Container,并与对应的NodeManager通信,要求它在这个Container中启动应用程序的ApplicationMaster

步骤3 ApplicationMaster首先向ResourceManager注册,这样用户可以直接通过ResourceManage查看应用程序的运行状态,然后它将为各个任务申请资源,并监控它的运行状态,直到运行结束,即重复步骤4~7

步骤4 ApplicationMaster采用轮询的方式通过RPC协议向ResourceManager申请和领取资源

步骤5 一旦ApplicationMaster申请到资源后,便与对应的NodeManager通信,要求它启动任务

步骤6 NodeManager为任务设置好运行环境(包括环境变量、JAR包、二进制程序等)后,将任务启动命令写到一个脚本中,并通过运行该脚本启动任务

步骤7 各个任务通过某个RPC协议向ApplicationMaster汇报自己的状态和进度,以让ApplicationMaster随时掌握各个任务的运行状态,从而可以在任务失败时重新启动任务。在应用程序运行过程中,用户可随时通过RPC向ApplicationMaster查询应用程序的当前运行状态。

步骤8 应用程序运行完成后,ApplicationMaster向ResourceManager注销并关闭自己

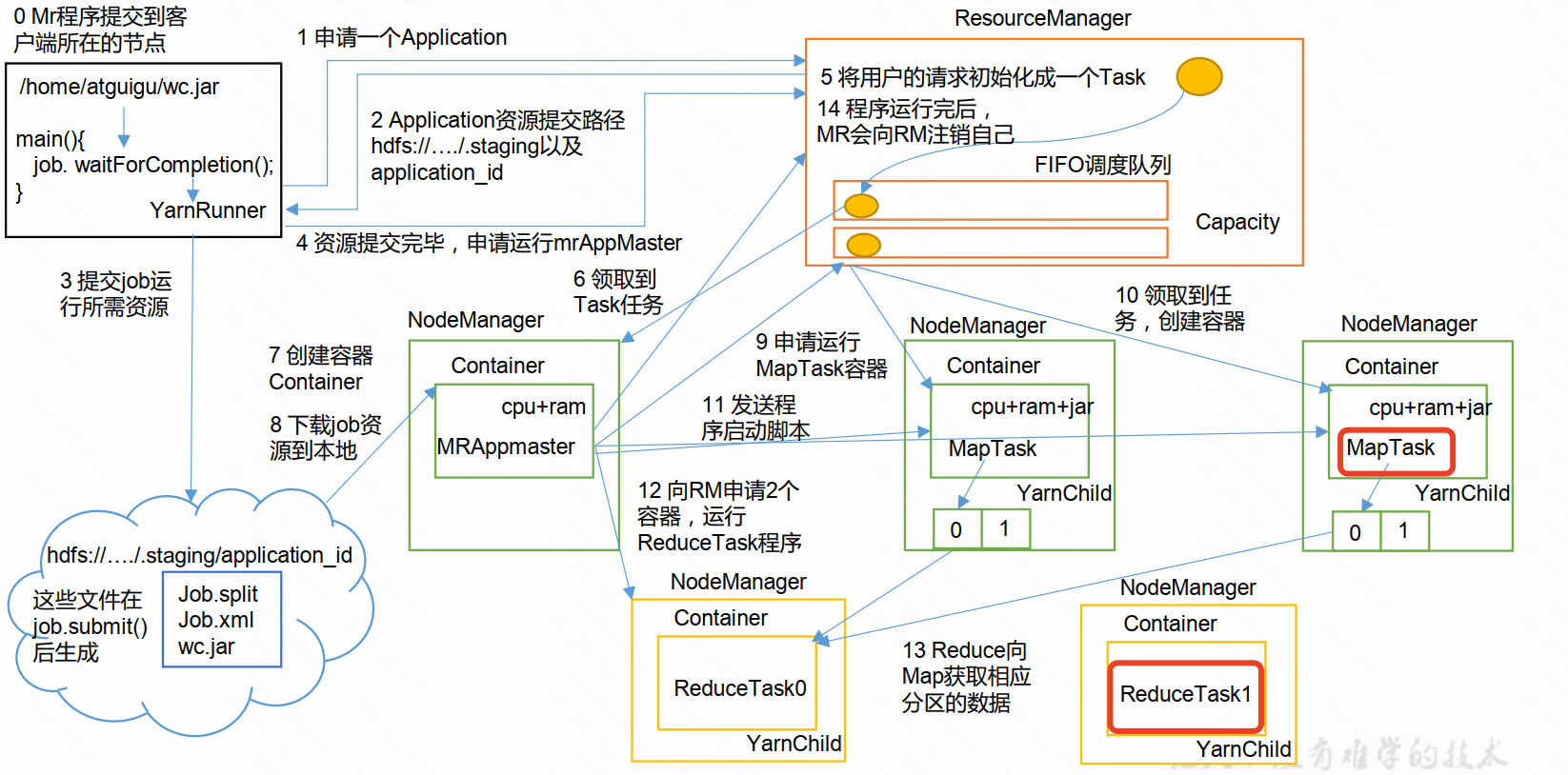

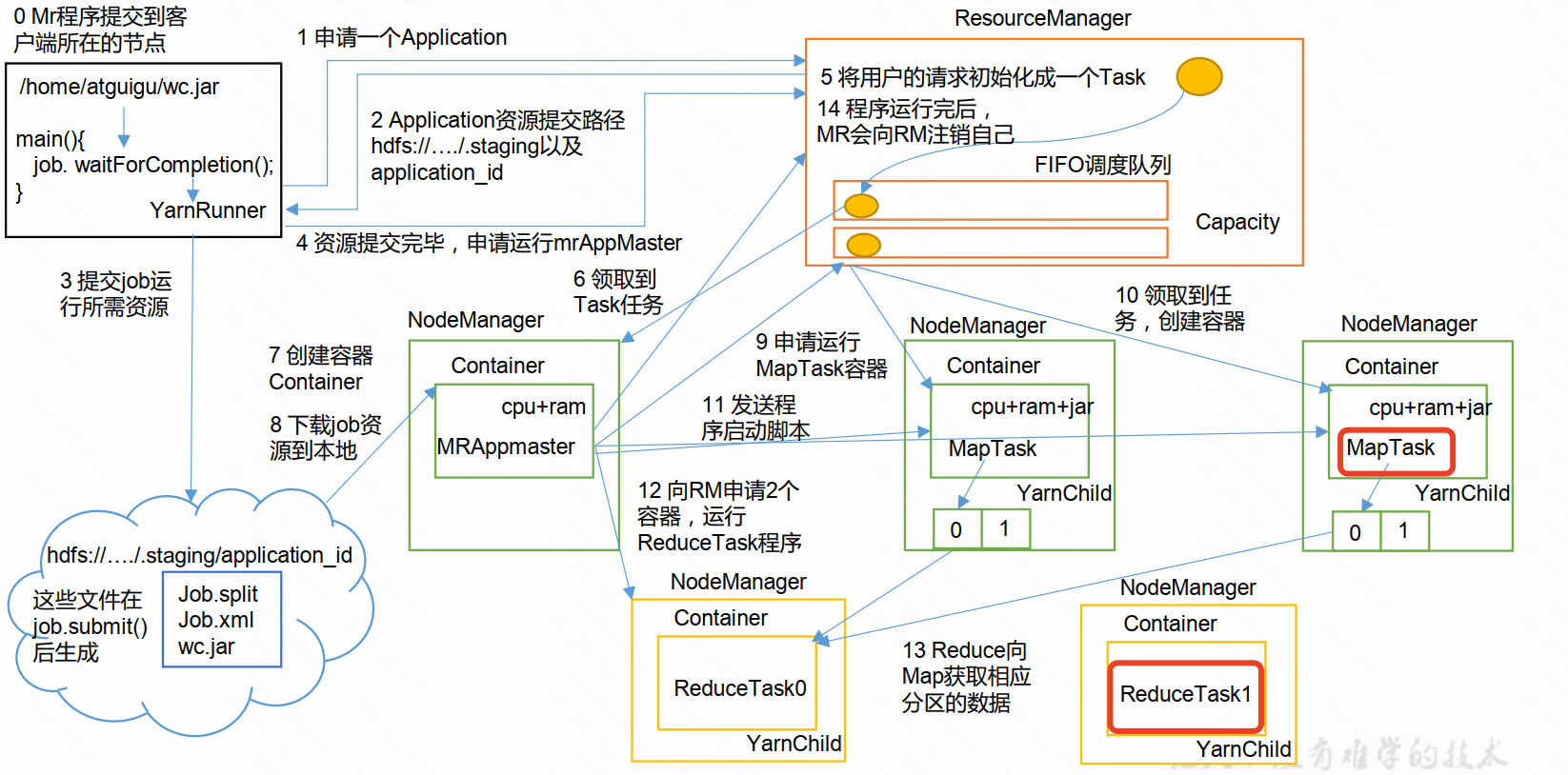

三、Yarn作业提交全过程

作业提交

第 1 步: Client 调用 job.waitForCompletion 方法,向整个集群提交 MapReduce 作业。

第 2 步: Client 向 RM 申请一个作业 id。

第 3 步: RM 给 Client 返回该 job 资源的提交路径和作业 id。

第 4 步: Client 提交 jar 包、切片信息和配置文件到指定的资源提交路径。

第 5 步: Client 提交完资源后,向 RM 申请运行 MrAppMaster。

作业初始化

第 6 步: 当 RM 收到 Client 的请求后,将该 job 添加到容量调度器中

第 7 步: 某一个空闲的 NM 领取到该 Job。

第 8 步: 该 NM 创建 Container, 并产生 MRAppmaster。

第 9 步:下载 Client 提交的资源到本地。

任务分配

第 10 步: MrAppMaster 向 RM 申请运行多个 MapTask 任务资源。

第 11 步: RM 将运行 MapTask 任务分配给另外两个 NodeManager, 另两个 NodeManager分别领取任务并创建容器。

任务运行

第 12 步: MR 向两个接收到任务的 NodeManager 发送程序启动脚本, 这两个NodeManager 分别启动 MapTask, MapTask 对数据分区排序。

第13步: MrAppMaster等待所有MapTask运行完毕后,向RM申请容器, 运行ReduceTask。

第 14 步: ReduceTask 向 MapTask 获取相应分区的数据。

第 15 步: 程序运行完毕后, MR 会向 RM 申请注销自己。

进度和状态更新

YARN 中的任务将其进度和状态(包括 counter)返回给应用管理器, 客户端每秒(通过mapreduce.client.progressmonitor.pollinterval 设置)向应用管理器请求进度更新, 展示给用户。

作业完成

除了向应用管理器请求作业进度外, 客户端每 5 秒都会通过调用 waitForCompletion()来检查作业是否完成。 时间间隔可以通过 mapreduce.client.completion.pollinterval 来设置。 作业完成之后, 应用管理器和 Container 会清理工作状态。 作业的信息会被作业历史服务器存储以备之后用户核查。

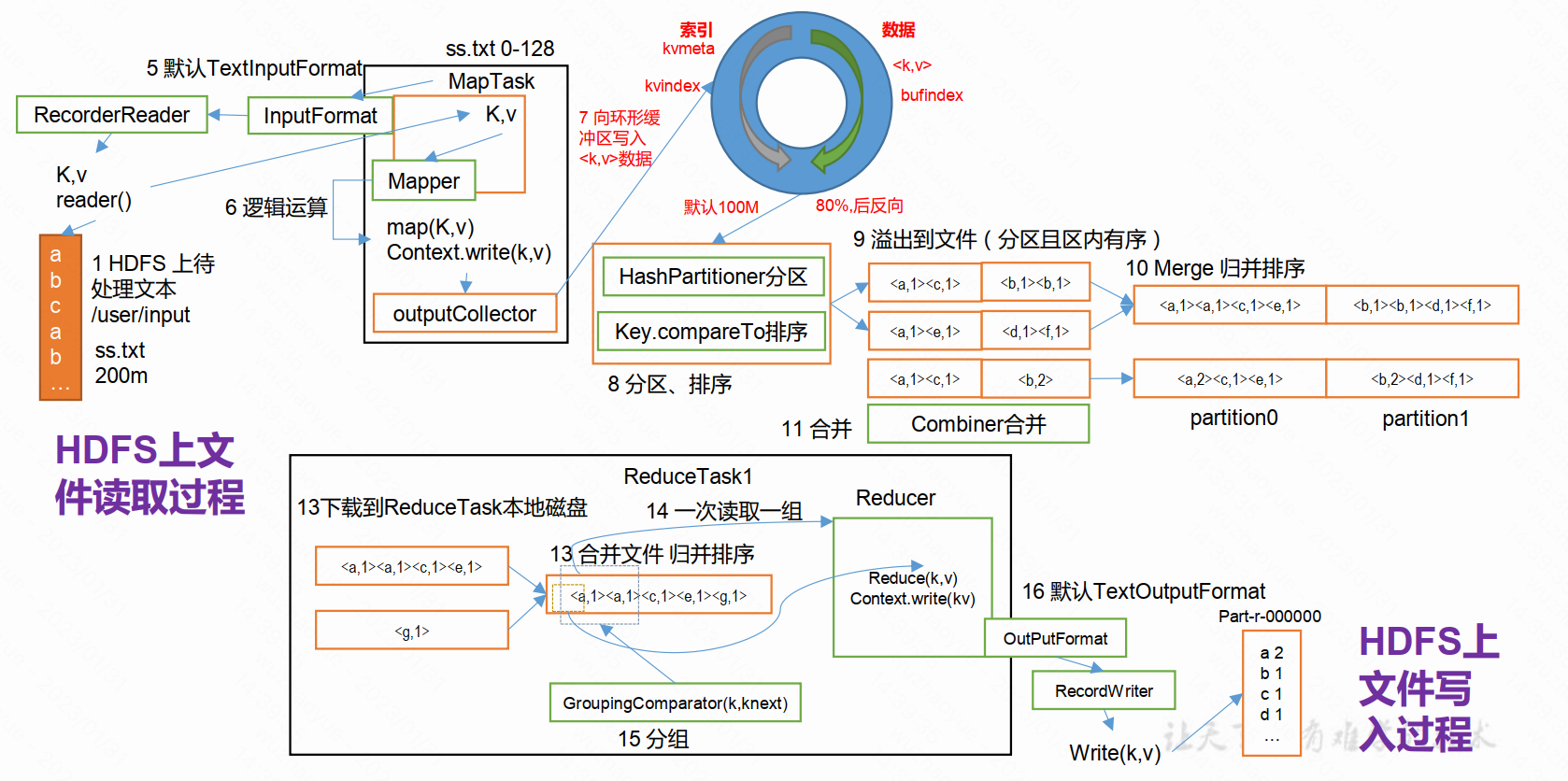

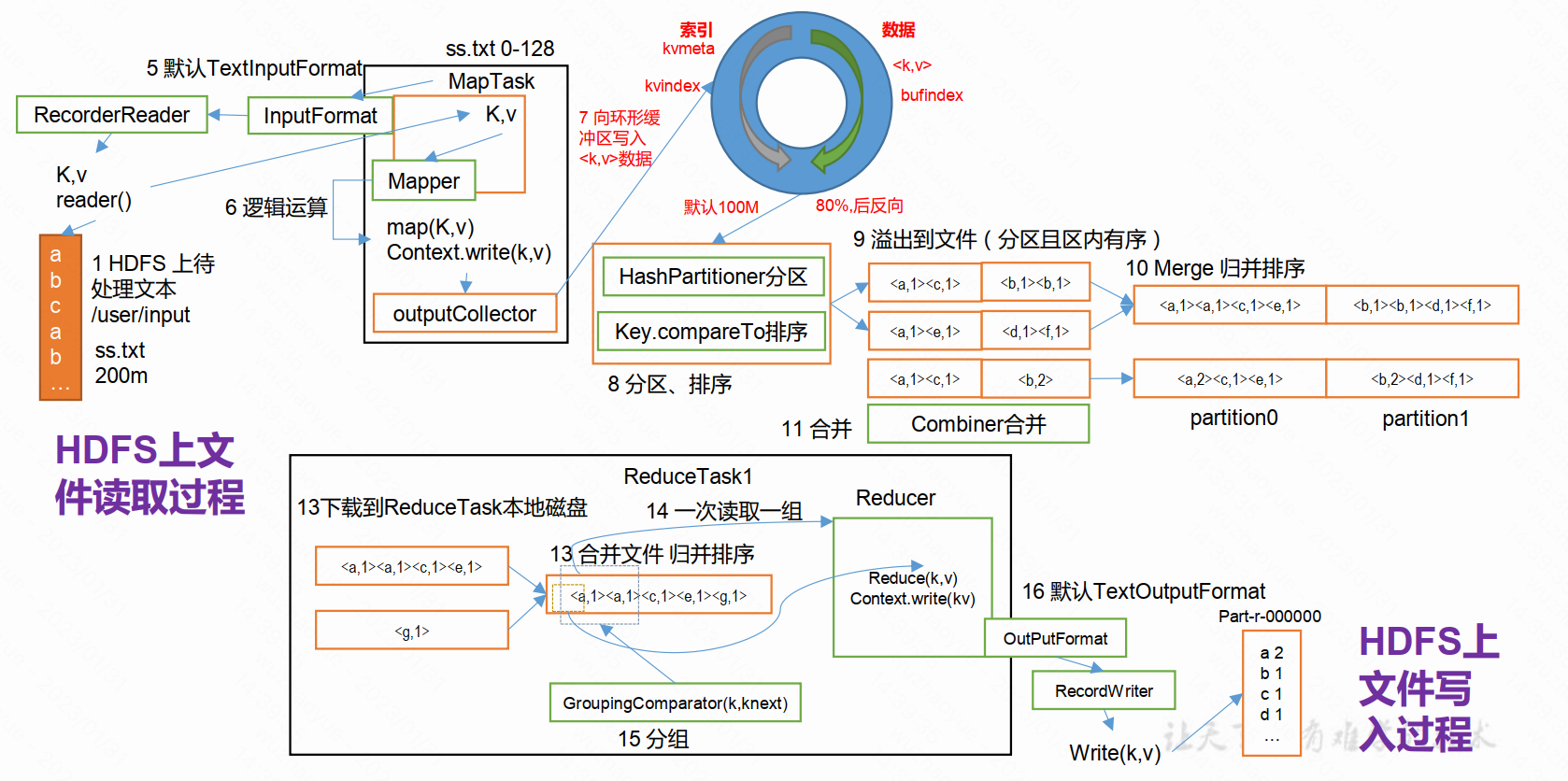

MR任务执行

当ApplicationMaster在Container启动之后,也就是MapReduce具体的运行过程,会通过InputFormat阶段从HDFS拉取对应的数据分片,执行Map、Shuffle、Reduce进行数据处理,最后通过OutputFormat将数据写到HDFS或其他存储引擎上。

四、Yarn调度器

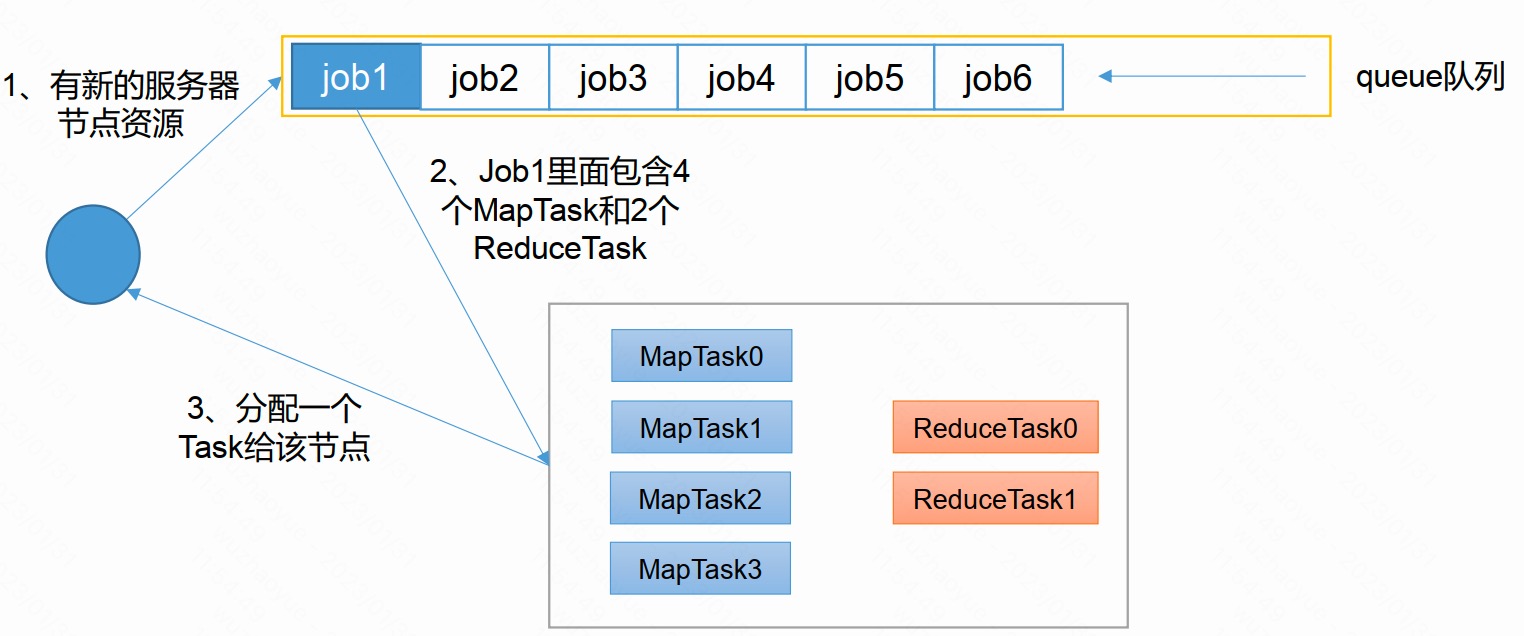

4.1 FIFO调度器

单队列,根据提交作业的先后顺序,先来先服务。优点:简单易懂。缺点:不支持多队列,生产环境很少使用

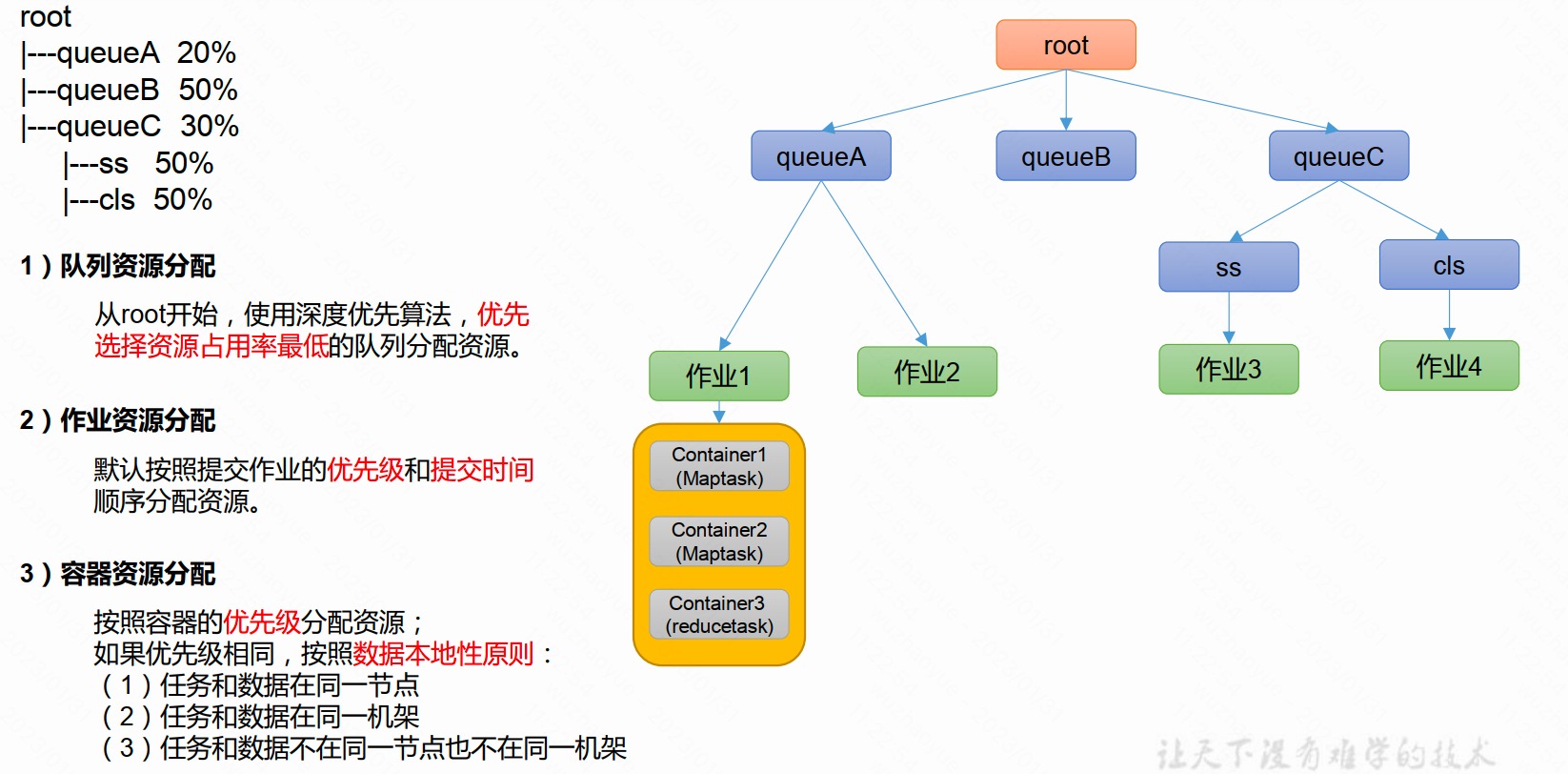

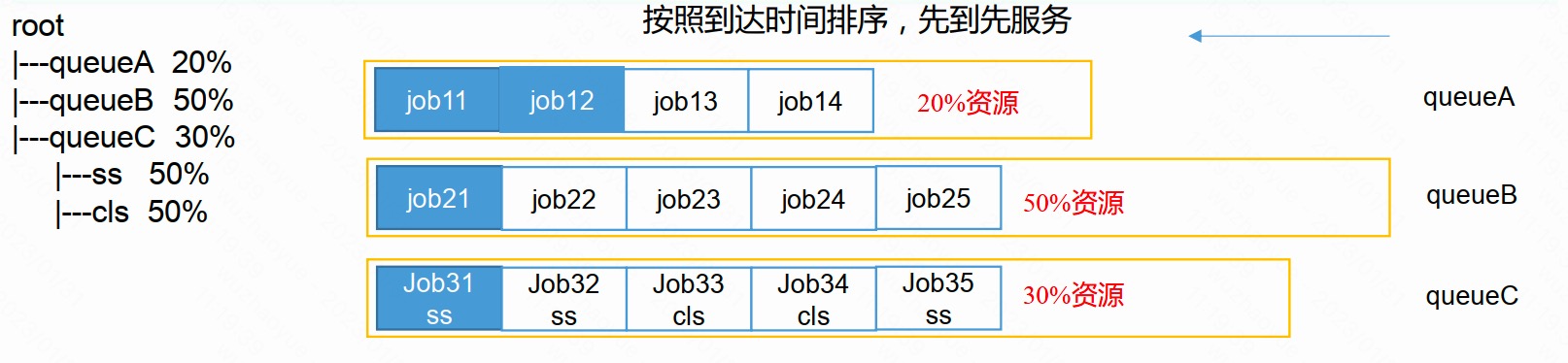

4.2 容量调度器(Capacity Scheduler)

Yarn默认调度器,特点如下:

- 多队列: 每个队列可配置一定的资源量,每个队列采用FIFO调度策略。

- 容量保证:管理员可为每个队列设置资源最低保证和资源使用上限

- 灵活性:如果一个队列中的资源有剩余,可以暂时共享给那些需要资源的队列,而一旦该队列有新的应用程序提交,则其他队列借调的资源会归还给该队列

- 多租户:支持多用户共享集群和多应用程序同时运行。为了防止同一个用户的作业独占队列中的资源,该调度器会对同一用户提交的作业所占资源量进行限定

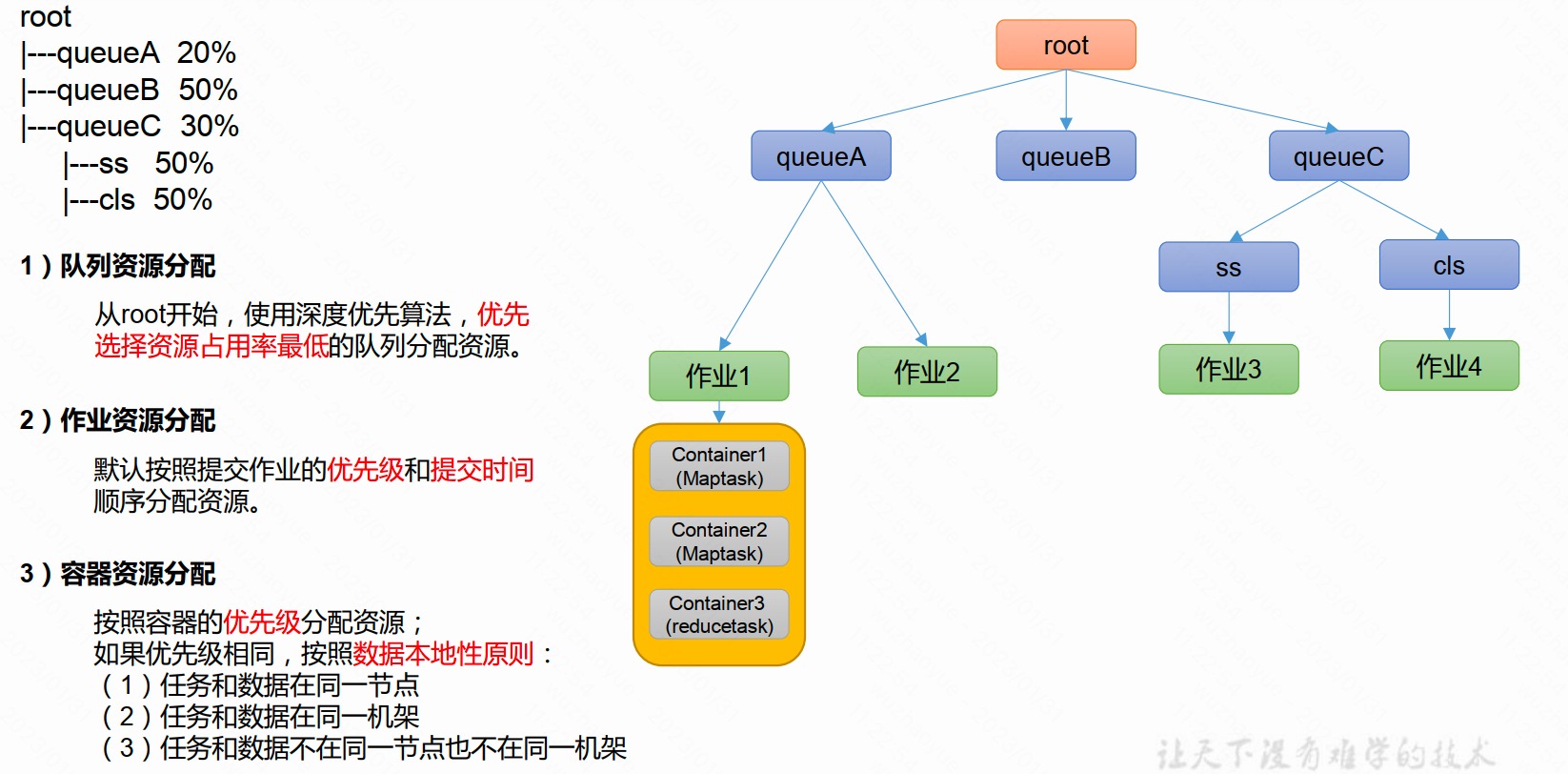

资源分配算法:

4.3 公平调度器(Fair Scheduler)

4.3.1 与容量调度器对比

1)与容量调度器相同点

- 多队列:支持多队列多作业

- 容量保证:管理员可为每个队列设置资源最低保证和资源使用上线

- 灵活性: 如果一个队列中的资源有剩余,可以暂时共享给那些需要资源的队列,而一旦该队列有新的应用程序提交,则其他队列借调的资源会归还给该队列。

- 多租户:支持多用户共享集群和多应用程序同时运行;为了防止同一个用户的作业独占队列中的资源,该调度器会对同一用户提交的作业所占资源量进行限定。

2)与容量调度器不同点

核心调度策略不同

- 容量调度器:优先选择资源利用率低的队列

- 公平调度器:优先选择对资源的缺额比例大的

每个队列可以单独设置资源分配方式

- 容量调度器: FIFO、 DRF

- 公平调度器: FIFO、 DRF、FAIR

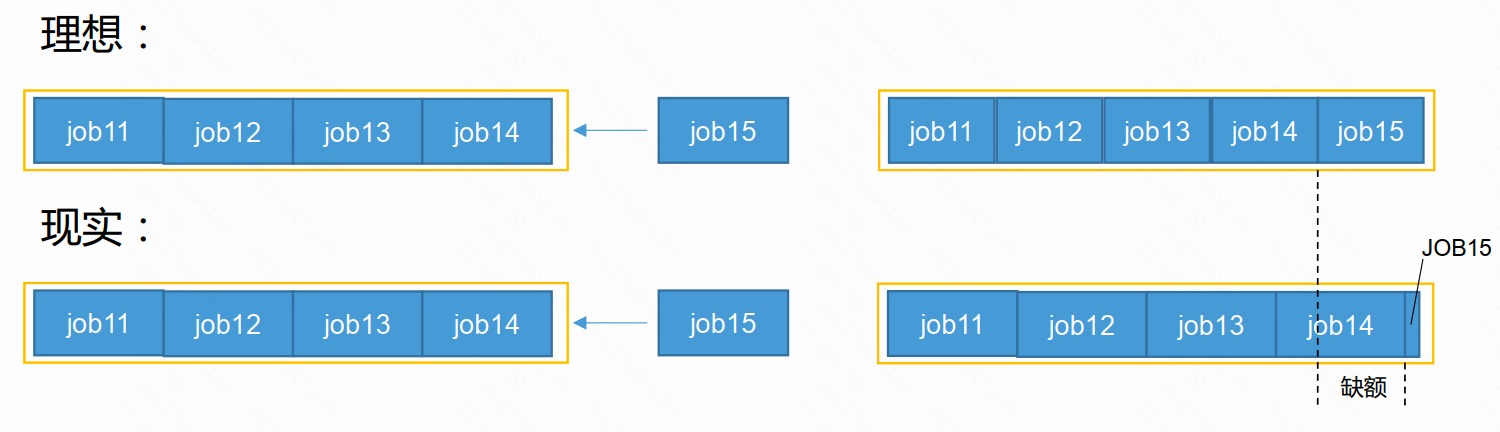

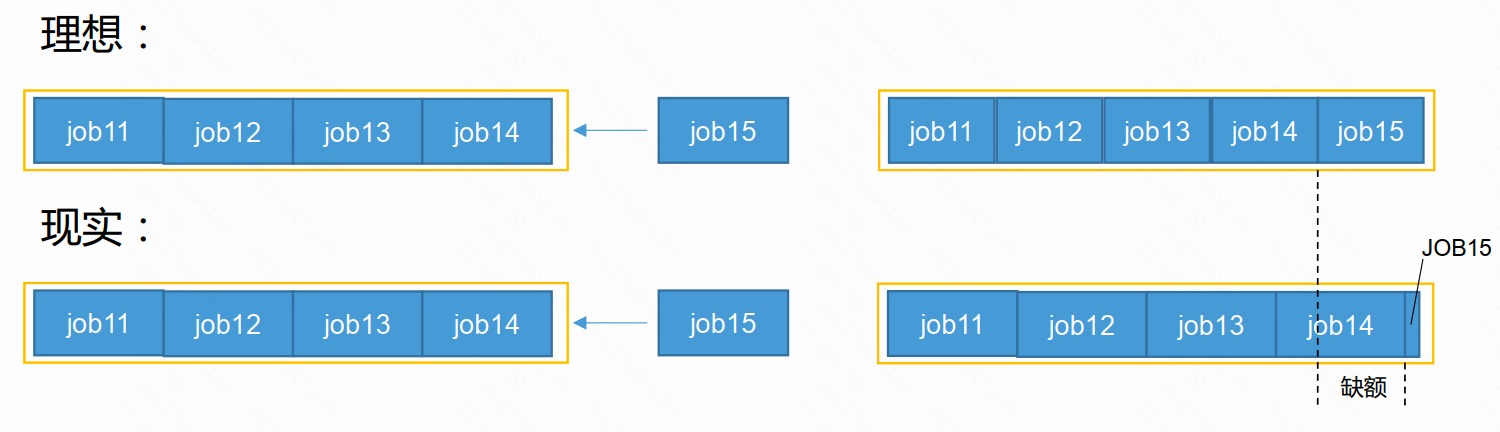

4.3.2 公平调度器缺额

- 公平调度器设计目标是:在时间尺度上,所有作业获得公平的资源。某一时刻一个作业应获资源和实际获取资源的差距叫“缺额”

- 调度器会优先为缺额大的作业分配资源

4.3.3 公平调度器策略

1) FIFO策略

公平调度器每个队列资源分配策略如果选择FIFO的话, 此时公平调度器相当于上面讲过的容量调度器

2) Fair策略

Fair 策略(默认) 是一种基于最大最小公平算法实现的资源多路复用方式, 默认情况下, 每个队列内部采用该方式分配资源。 这意味着, 如果一个队列中有两个应用程序同时运行, 则每个应用程序可得到1/2的资源;如果三个应用程序同时运行, 则每个应用程序可得到1/3的资源

具体资源分配流程和容量调度器一致;

(1) 选择队列

(2) 选择作业

(3) 选择容器

以上三步, 每一步都是按照公平策略分配资源

➢ 实际最小资源份额: mindshare = Min(资源需求量, 配置的最小资源)

➢ 是否饥饿: isNeedy = 资源使用量 < mindshare(实际最小资源份额)

➢ 资源分配比: minShareRatio = 资源使用量 / Max(mindshare, 1)

➢ 资源使用权重比: useToWeightRatio = 资源使用量 / 权重

3) DRF策略

DRF(Dominant Resource Fairness)我们之前说的资源, 都是单一标准, 例如只考虑内存(也是Yarn默认的情况)。但是很多时候我们资源有很多种, 例如内存、CPU、网络带宽等,这样我们很难衡量两个应用应该分配的资源比例。

那么在YARN中, 我们用DRF来决定如何调度:

假设集群一共有100 CPU和10T 内存,而应用A需要(2 CPU, 300GB),应用B需要(6 CPU, 100GB)。则两个应用分别需要A(2%CPU, 3%内存)和B(6%CPU, 1%内存)的资源, 这就意味着A是内存主导的, B是CPU主导的,针对这种情况,我们可以选择DRF策略对不同应用进行不同资源(CPU和内存)的一个不同比例的限制。

参考资料

《Hadopp技术内幕:深入解析YARN架构设计与实现原理》

《尚硅谷大数据课程》

浙公网安备 33010602011771号

浙公网安备 33010602011771号