OpenCV-Python系列之Meanshift算法

之前我们就已经用过OpenCV中的特征检测进行过目标跟踪,这次我们将介绍一种算法,用来寻找和追踪视频中的目标物体。

Meanshift算法:

meanshift算法的原理很简单。假设你有一堆点集,例如直方图反向投影得到的点集。

还有一个小的窗口,这个窗口可能是圆形的,现在要移动这个窗口到点集密度最大的区域当中。

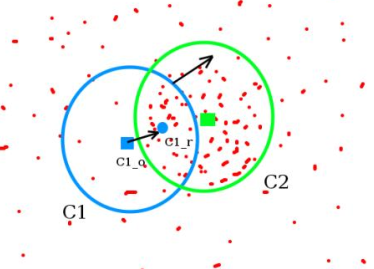

如下图:

最开始的窗口是蓝色圆环的区域,命名为C1。蓝色圆环的重音用一个蓝色的矩形标注,命名为C1_o。

然而,我们发现在这个窗口当中所有点的点集构成的质心在蓝色圆形点处。而且,圆环的型心和质心并不重合。所以,移动蓝色的窗口,使得型心与之前得到的质心重合。在新移动后的圆环的区域当中再次寻找圆环当中所包围点集的质心,然后再次移动,通常情况下,型心和质心是不重合的。不断执行上面的移动过程,直到型心和质心大致重合结束。

这样,最后圆形的窗口会落到像素分布最大的地方,也就是图中的绿色圈,命名为C2。

meanshift算法不仅仅限制在二维的图像处理问题当中,同样也可以使用于高维的数据处理。可以通过选取不同的核函数,来改变区域当中偏移向量的权重,最后meanshift算法的过程一定会收敛到某一个位置。

meanshift算法除了应用在视频追踪当中,在聚类,平滑等等各种涉及到数据以及非监督学习的场合当中均有重要应用,是一个应用广泛的算法。

假如在二维环境当中,meanshift算法处理的数据是一群离散的二维点集,但是图像是一个矩阵信息,如何在一个视频当中使用meanshift算法来追踪一个运动的物体呢?

大致流程如下:

1.首先在图像上使用矩形框或者圆形框选定一个目标区域

2.计算选定好区域的直方图分布。

3.对下一帧图像b同样计算直方图分布。

4.计算图像b当中与选定区域直方图分布最为相似的区域,使用meanshift算法将选定区域沿着最为相似的部分进行移动。(样例当中使用的是直方图反向投影)

5.重复3到4的过程。

OpenCV中的meanshift算法:

在opencv中使用meanshift算法,首先要设定目标,找到它的直方图,然后可以对这个直方图在每一帧当中进行反向投影。我们需要提供一个初试的窗口位置,计算HSV模型当中H(色调)的直方图。为了避免低亮度造成的影响,使用 cv2.inRange()将低亮度值忽略。

来看代码:

import cv2

import numpy as np

# 设置初始化的窗口位置

r,h,c,w = 0,200,0,200 # 设置初试窗口位置和大小

track_window = (c,r,w,h)

cap = cv2.VideoCapture(0)

ret, frame= cap.read()

# 设置追踪的区域

roi = frame[r:r+h, c:c+w]

# roi区域的hsv图像

hsv_roi = cv2.cvtColor(frame, cv2.COLOR_BGR2HSV)

# 取值hsv值在(0,60,32)到(180,255,255)之间的部分

mask = cv2.inRange(hsv_roi, np.array((0., 60.,32.)), np.array((180.,255.,255.)))

# 计算直方图,参数为 图片(可多),通道数,蒙板区域,直方图长度,范围

roi_hist = cv2.calcHist([hsv_roi],[0],mask,[180],[0,180])

# 归一化

cv2.normalize(roi_hist,roi_hist,0,255,cv2.NORM_MINMAX)

# 设置终止条件,迭代10次或者至少移动1次

term_crit = ( cv2.TERM_CRITERIA_EPS | cv2.TERM_CRITERIA_COUNT, 10, 1 )

while(1):

ret, frame = cap.read()

frame = cv2.flip(frame,1)

if ret == True:

# 计算每一帧的hsv图像

hsv = cv2.cvtColor(frame, cv2.COLOR_BGR2HSV)

# 计算反向投影

dst = cv2.calcBackProject([hsv],[0],roi_hist,[0,180],1)

# 调用meanShift算法在dst中寻找目标窗口,找到后返回目标窗口

ret, track_window = cv2.meanShift(dst, track_window, term_crit)

# Draw it on image

x,y,w,h = track_window

img2 = cv2.rectangle(frame, (x,y), (x+w,y+h), 255,2)

cv2.imshow('img2',img2)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cap.release()

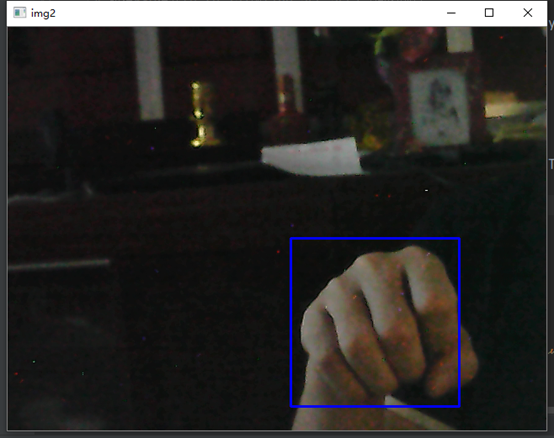

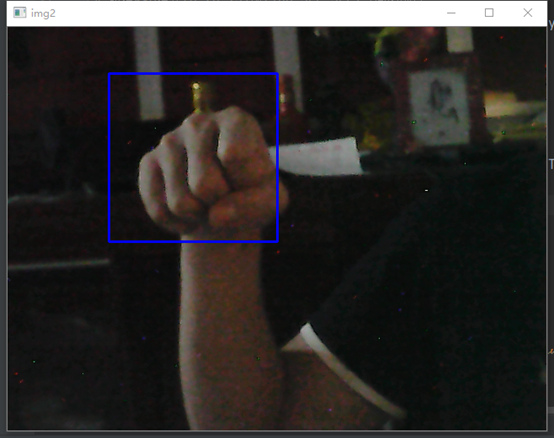

cv2.destroyAllWindows()把手放到视频的正方形框里,就可以实时的追踪了,来看部分的效果图: