回归

线性回归:

把自变量叫特征,把因变量叫标注,只是这个标注是连续值,而不是离散值,如果多个变量间的关系用线性关系去考量,那就是线性回归;若果多个变量间用多项式关系去考量,那就是多项式回归。类似的,可以由多种回归方法,同一系列的样本,可以用线性回归去拟合;

同样,也可以用二次函数去拟合

那么,如何判断哪个拟合关系更好?回归要考虑模型的复杂度和准确度两方面,当然,最重要的,是它对未知数据的预测的准确性。

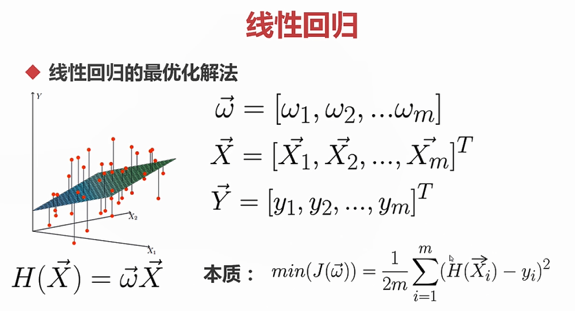

目的:使得 和

和 的差距尽可能小。

的差距尽可能小。

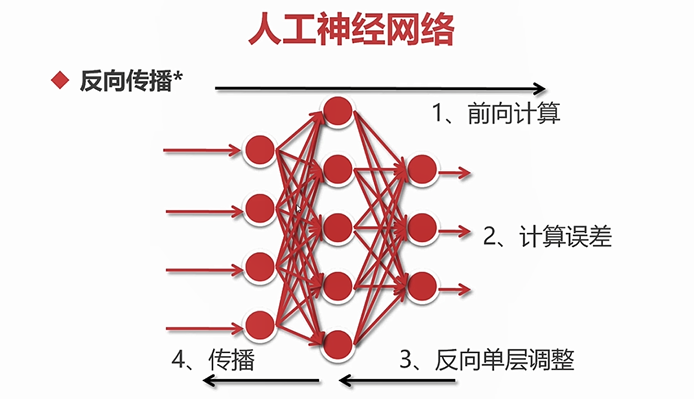

梯度下降法:对函数的未知数进行求导,然后求它们的各个极值,如果它的值域不是负无穷的,那么他们的极小值中一定就会有一个最小的,但使用计算机进行数值计算时,计算机全局求导,尤其是这种定义域可以取无穷情况下的求导是很耗费资源的而且也不现实。计算机进行数值计算,求它的最小值时,用到的一种方法,就是梯度下降法。

梯度下降法:步长,α

,

,

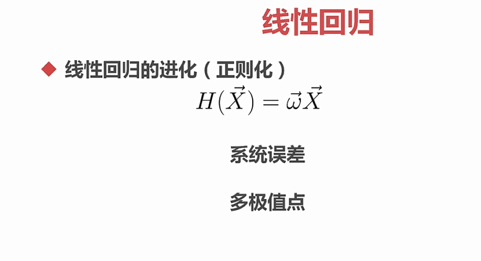

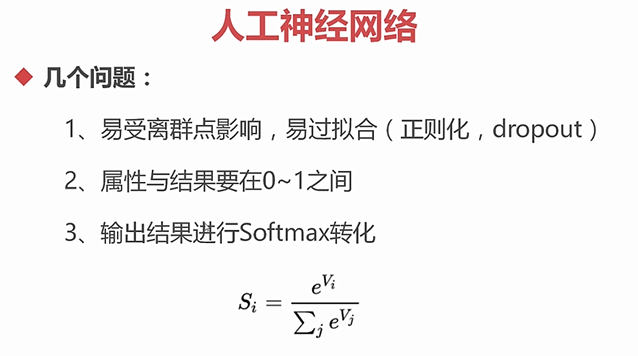

大的权值的决定权大,二小的权值几乎没什么话语权,这也是造成过拟合的原因之一。

不管使用哪种正则化,正则化的目的就是说在所有的参数中更倾向于选择系数更小的,这样就约束了一些起始的条件,可以有效的防止过拟合,也可以更快速的,更正确的找到我们的最优点。

,

,

,

,

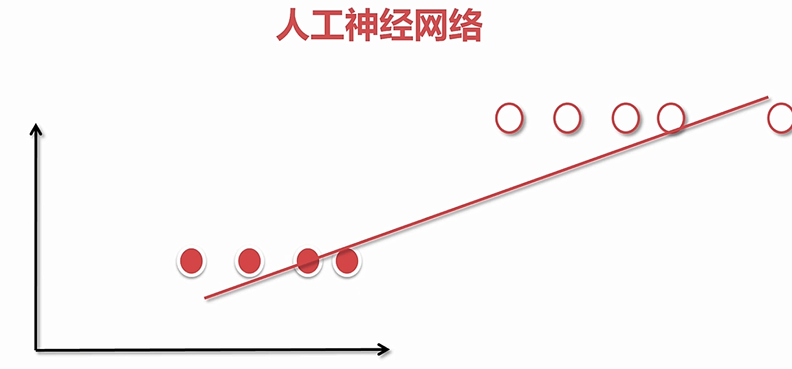

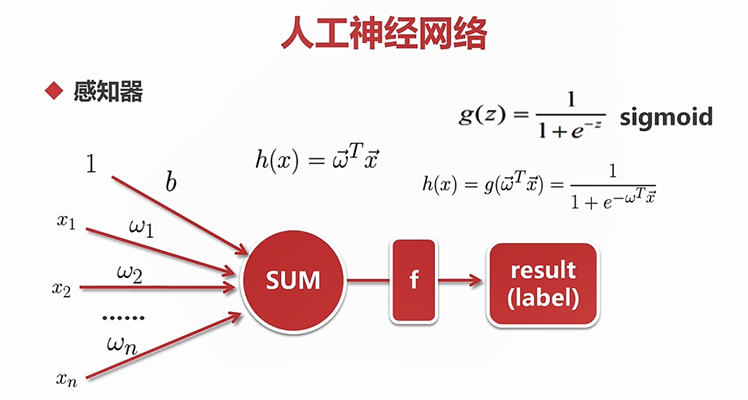

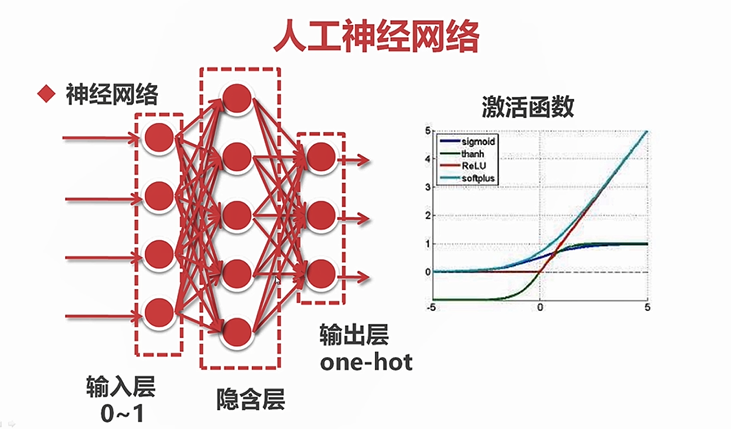

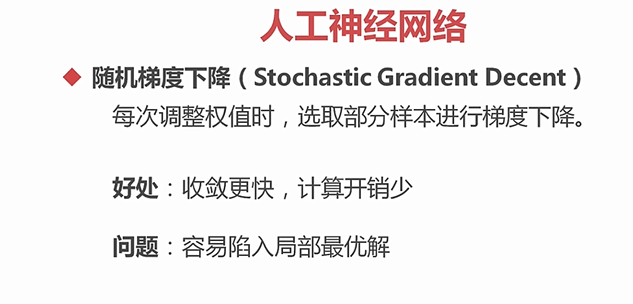

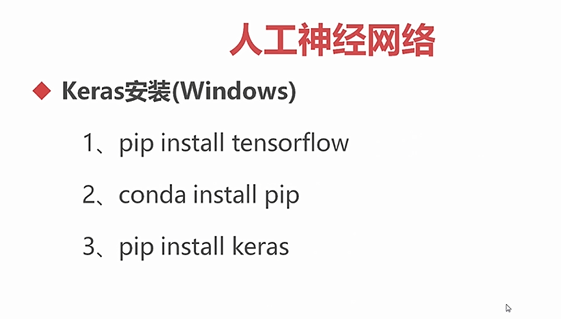

人工神经网络:分类就是一种有限状态的回归,二回归无线定序顺序的分类,人工神经网络是一种分类和回归都可以使用的模型。分类是线性回归的特殊情况,即它回归的值只有0和1.

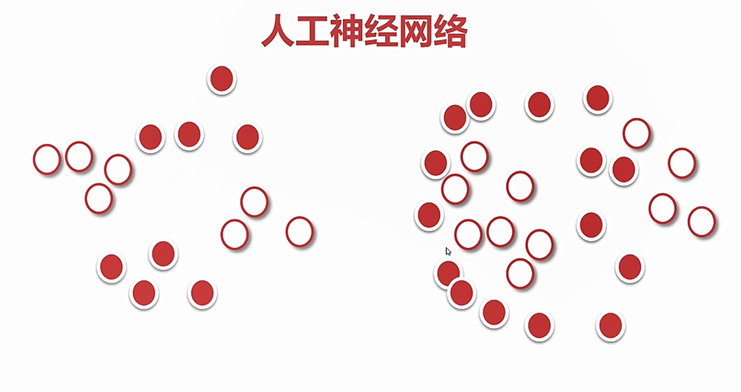

分类效果很大程度上受到离群点和异常值的影响。

逻辑回归:

,

,

非线性:可随意的划线组合

,

,

,

,

,

,

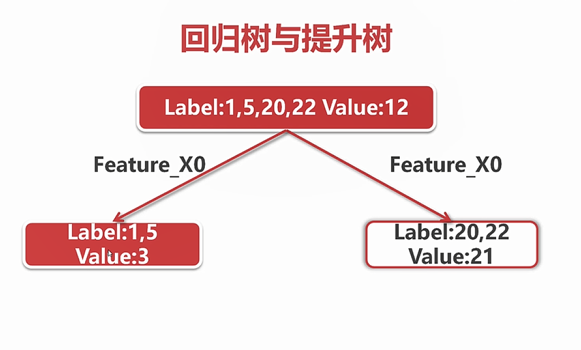

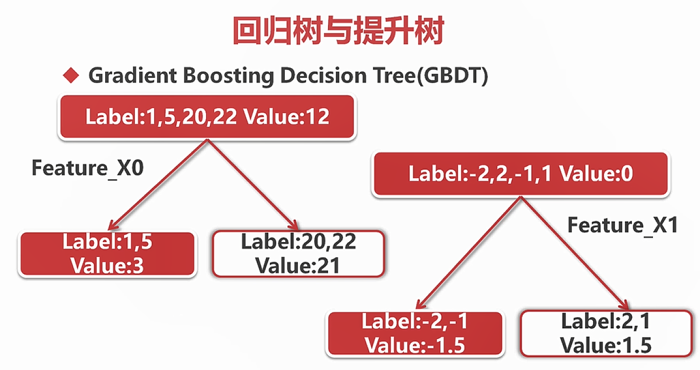

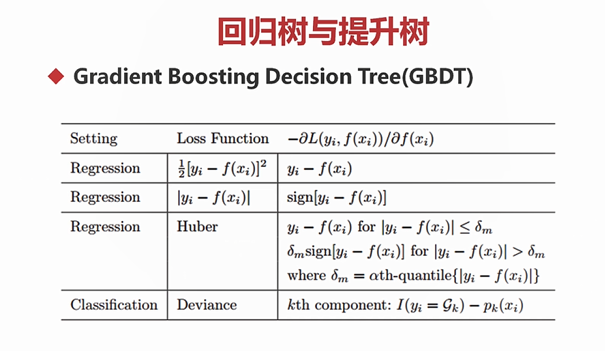

回归树与提升树:

,

,

,

,

浙公网安备 33010602011771号

浙公网安备 33010602011771号