第六章---机器学习与数据建模

点学习:通过接收到的数据,归纳提取相同与不同

机器学习: 让计算机以数据为基础,进行归纳与总结

模型:数据解释现象的系统

机器学习:

1.监督学习(机器学习的过程有标注:相当于告诉模型,在什么样的数据特征下应该输出什么样的结果,机器学习的任务就是提炼出输入与标注间的关系,并进行预测)

根据标注是离散值还是连续值,监督学习可分为分类问题和回归问题

1)分类(标注是离散值)

2)回归(标注是连续值)

2.非监督学习(机器学习的过程无标注,完全让数据自己说话,将数据自身的特征在不同的模型中进行不同的表现)

1)聚类

2)关联

3.半监督学习(部分有标注,部分没有标注,有标注的数据可以作用于没有标注的数据,规范与引导聚类或者关联的方向,同时没有标注的数据也可作用于有标注的数据,时刻获得模型对于数据整体情况的影响和反馈)

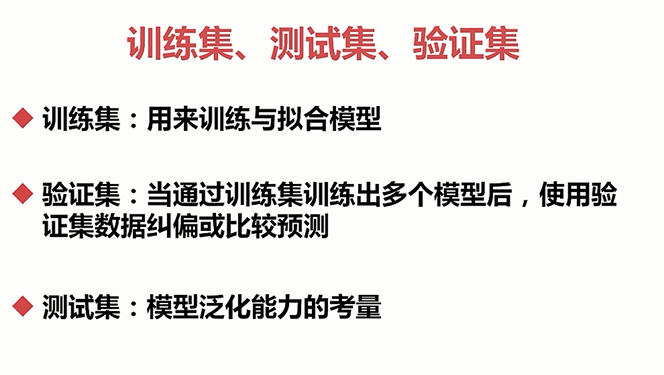

数据集:训练集、测试集、验证集(6:2:2)

测试集:通过训练集和测试集的出最优模型后,使用测试集进行模型的预测,用来衡量这个模型的性能和分类能力,即可以把测试集当做从来不存在的数据集,当已经确定模型的参数后,使用测试集进行模型的泛化能力的评价

泛化:对未知数据的预测能力

模型面对训练集和测试集以外的未知数据或者实际场景的数据时预测能力的大小,如果一个模型在训练集和验证集表现良好,而测试集表现不好,那么该模型的泛化能力就比较差,这种现象也叫做过拟合现象,一份数据集切分成训练集,测试集,验证集的方法也叫作交叉验证。有的时候我们会忽略验证集,而通过不断地重复的尝试,来达到验证的目的,这样一个数据集就会只分为训练集,测试集,比例通常取4:1(80%:20%)这些切分一般是随机的,为了全面衡量模型的质量,有时候也会采取K折叠交叉验证

监督学习中的分类问题:

注:逻辑斯特映射和人工神经网络大多数既可以做分类也可以做回归问题,主要以回归为主

,

,

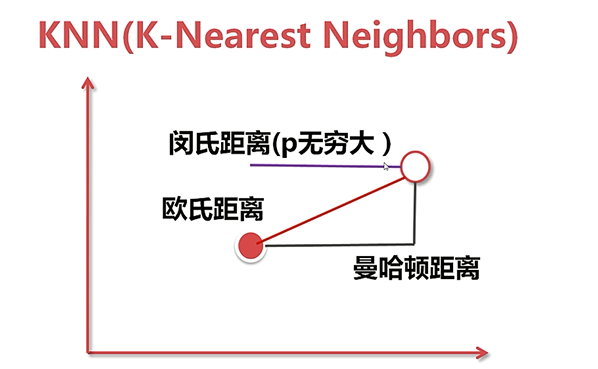

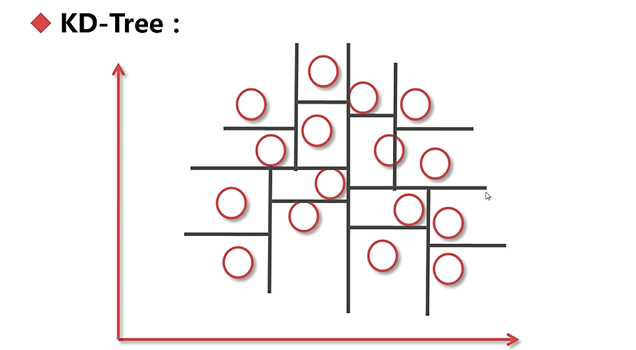

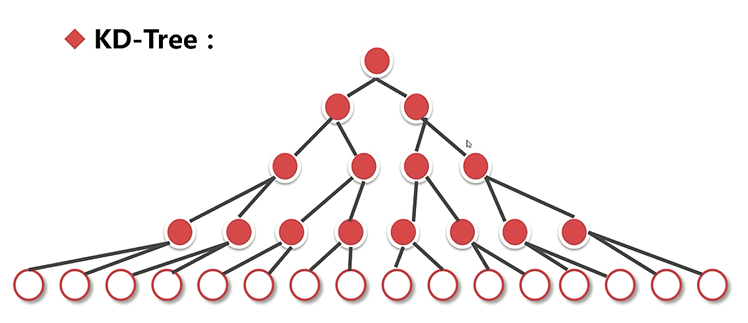

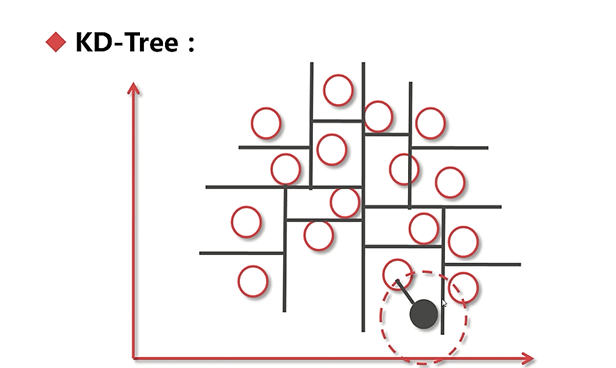

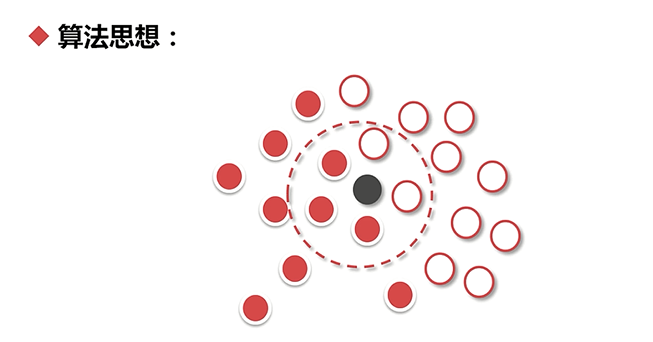

KD_Tree:如果一个空间中有很多的点,那么怎么去找我们随机指定的一个点附近的最近的K个点呢?

当然有一种方法就是遍历每一个点,然后进行从小到大的排序。不过效率过低,所以就有了KD-Tree,通过树形结构,可以达到快速寻找最近点的目的。

这样的话在空间里就会分成很多大小不一的格子,每个格子都通过这里的线建立成一个树形的索引,如果把这些线当成中间节点,而把这些点当做是叶子节点,

,

,

,

,

,

,

,

,

,

,

,

,

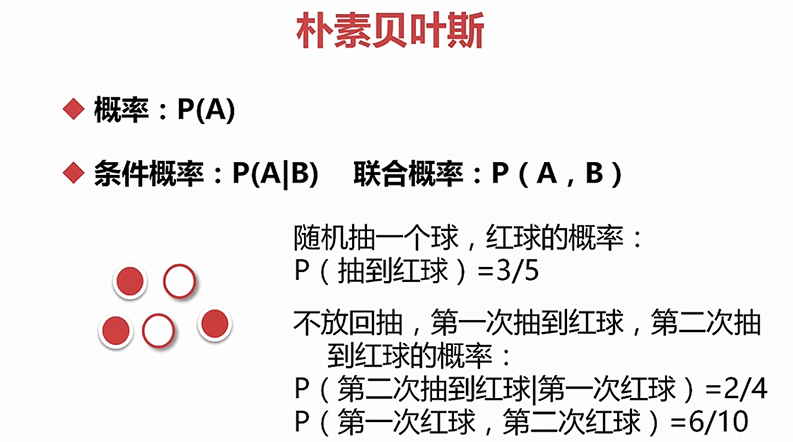

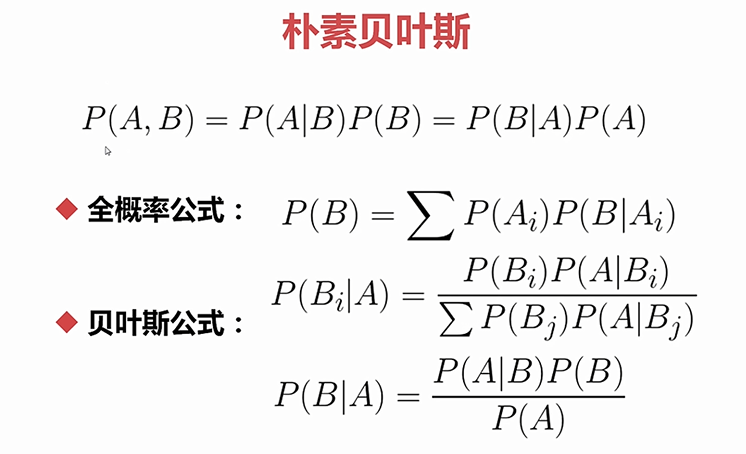

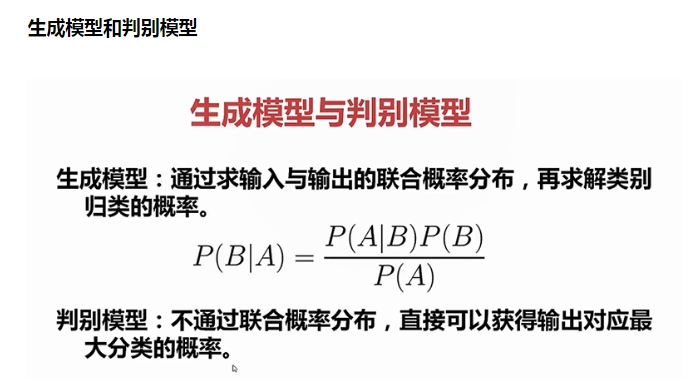

生成模型:一般情况下对数据的要求更高一些,比如朴素贝叶斯中要求数据是离散的,速度相对快一些

判别模型:速度相对慢些,但是对数据容忍程度的更大一些,使用的范围也更广一些

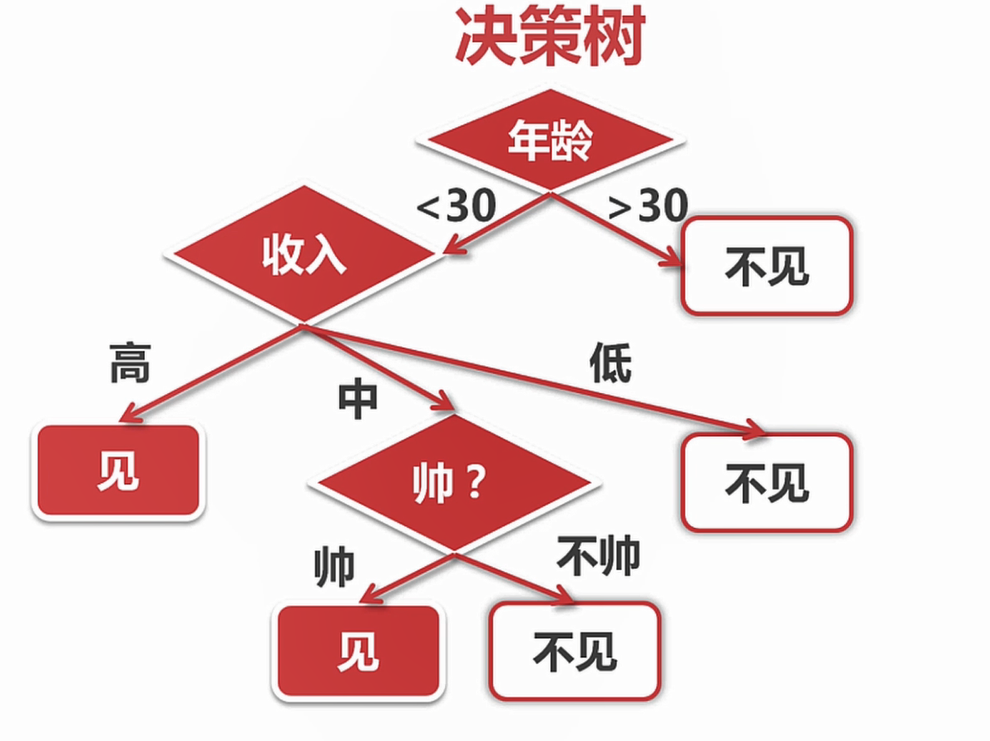

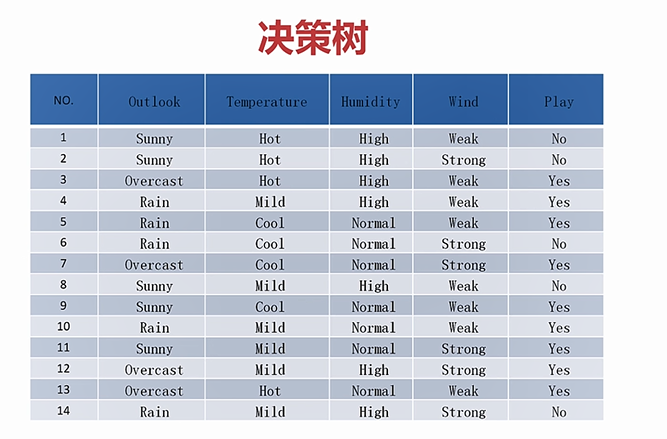

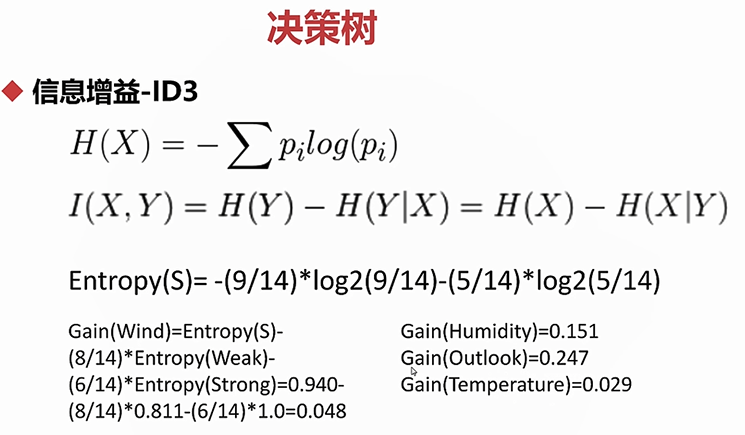

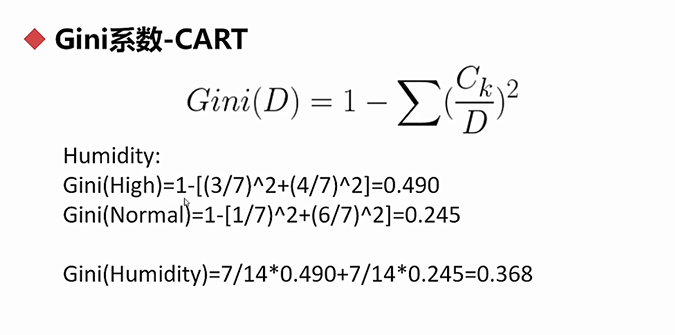

在构造决策树的时候,有个问题需要考虑,就是说这些特征的顺序如何摆放?

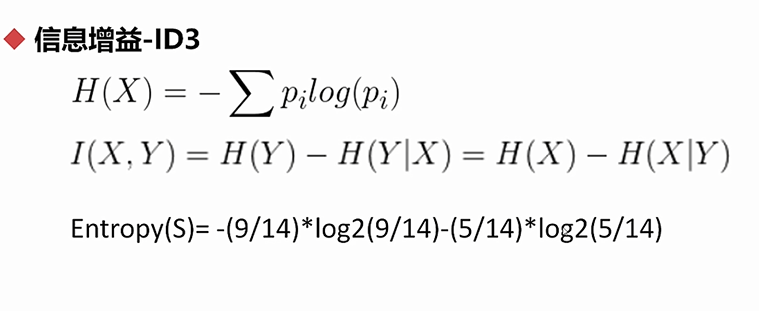

决定特征顺序的方法:

熵:代表随机变量或者整个系统的不确定性,熵越大,随机变量或者整个系统的不确定性就越大。

,

,

,

,

,

,

,

,

,

,

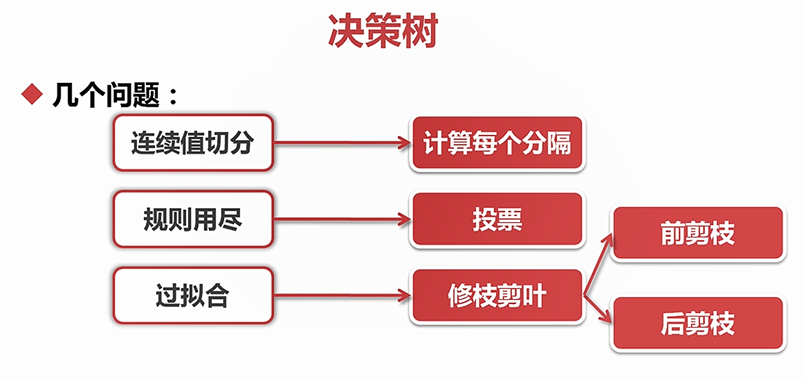

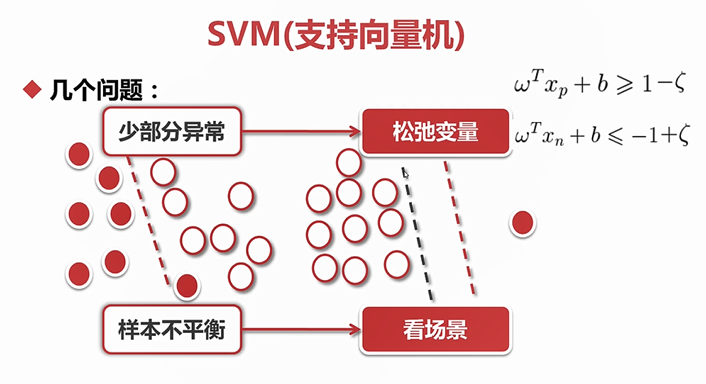

问题:

,

,

,

,

,

,

,

,

,

,

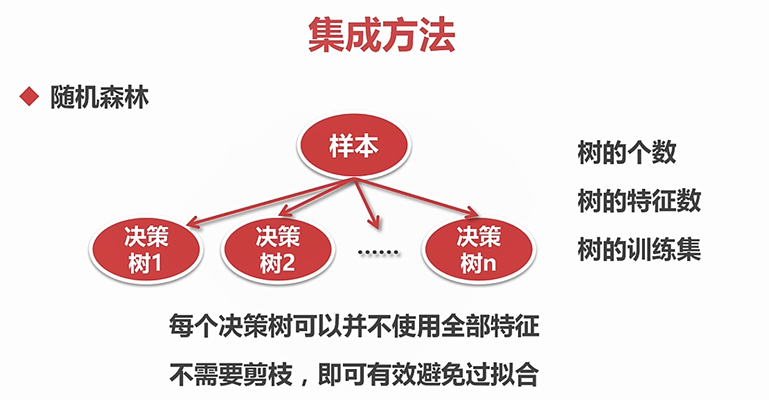

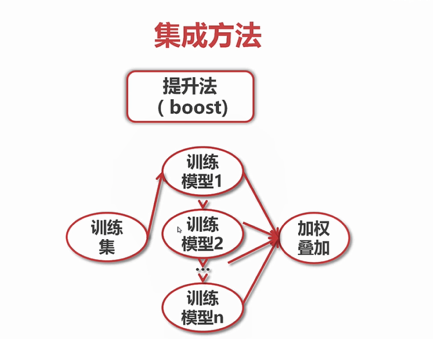

集成方法:组合多个模型,以获得更好的效果

n:数据规模,p,m为常数 ,

,

袋装法应用:随机森立算法

袋装法:把几个不同的分类模型进行独立袋装,然后投票表决,几个子模型间是互相独立的,互不影响的。

提升法:boost,如果我们这些子模型串联起来,一个模型以另一个模型的结果为基础,进行训练和预测,然后多个模型级联,最终将每个训练模型的结果进行加权求和,得到判决结果。

注:最后的结果是各个模型的加权叠加,并不是最后一个模型的输出,子模型对样本的差别的影响更大程度上取决于最终的权值,而不是它的顺序

,

,

,

,

浙公网安备 33010602011771号

浙公网安备 33010602011771号