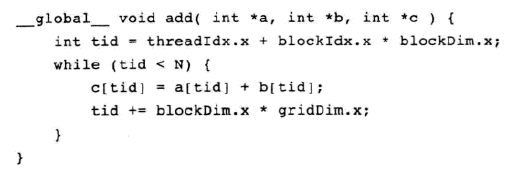

gpu对任意长度的矢量求和

blockDim.x*gridDim.x 跳过一个grid

int <<<参数1,参数2>>>(int *a,int * b,int * c);

如果是一维的,参数1表示一个grid里面有多少个block块,参数2表示一个block块里面有多少个thread线程

namespace caffe {

template <typename Dtype>

__global__ void LogwxlForward(const float scale_,const int n,const Dtype * in,Dtype * out){

CUDA_KERNEL_LOOP(index,n){

out[index]=scale_*in[index];

}

}

template <typename Dtype>

__global__ void LogwxlBackward(const float scale_,const int n,const Dtype *in_diff,Dtype* out_diff){

CUDA_KERNEL_LOOP(index,n) {

out_diff[index]=in_diff[index]*scale_;

}

}

template <typename Dtype>

void LogwxlLayer<Dtype>::Forward_gpu(

const vector<Blob<Dtype>*>& bottom, const vector<Blob<Dtype>*>& top) {

//this->Forward_cpu(bottom, top);

const Dtype* bottom_data=bottom[0]->gpu_data();

Dtype * top_data=top[0]->mutable_gpu_data();

const int count=bottom[0]->count();

LogwxlForward<Dtype><<<CAFFE_GET_BLOCKS(count),CAFFE_CUDA_NUM_THREADS>>>(scale_,count,bottom_data,top_data);

CUDA_POST_KERNEL_CHECK;

}

template <typename Dtype>

void LogwxlLayer<Dtype>::Backward_gpu(

const vector<Blob<Dtype>*>& top,

const vector<bool>& propagate_down,

const vector<Blob<Dtype>*>& bottom) {

//this->Backward_cpu(top, propagate_down, bottom);

if(propagate_down[0]){

const Dtype *top_diff=top[0]->gpu_diff();

Dtype * bottom_diff=bottom[0]->mutable_gpu_diff();

const int count=bottom[0]->count();

LogwxlBackward<Dtype><<<CAFFE_GET_BLOCKS(count),CAFFE_CUDA_NUM_THREADS>>>(scale_,count,top_diff,bottom_diff);

CUDA_POST_KERNEL_CHECK;

}

}

INSTANTIATE_LAYER_GPU_FUNCS(LogwxlLayer);

} // namespace caffe

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】凌霞软件回馈社区,博客园 & 1Panel & Halo 联合会员上线

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 深入理解 Mybatis 分库分表执行原理

· 如何打造一个高并发系统?

· .NET Core GC压缩(compact_phase)底层原理浅谈

· 现代计算机视觉入门之:什么是图片特征编码

· .NET 9 new features-C#13新的锁类型和语义

· 手把手教你在本地部署DeepSeek R1,搭建web-ui ,建议收藏!

· Spring AI + Ollama 实现 deepseek-r1 的API服务和调用

· 《HelloGitHub》第 106 期

· 数据库服务器 SQL Server 版本升级公告

· C#/.NET/.NET Core技术前沿周刊 | 第 23 期(2025年1.20-1.26)