TDA4与Openvx技术开发示例

TDA4与Openvx技术开发示例

[TI TDA4 J721E]基于TDA4平台 FFmpeg / X264 的ARM平台移植

创建了开源的Demo演示案例库,后续会把Demo代码放到这个Gitee库里:

TDA4/TI TDA4

https://gitee.com/tda4/ti-tda4

欢迎大家加入,一起维护这个开源库,给更多的朋友提供帮助。

由于需要使用TDA4完成一个推流的工作,在查找各种资料以后,决定移植ffmpeg,进行rtmp的推流工作。下面开始演示移植过程:

一、下载源码

1、X264源码(总览:http://download.videolan.org/pub/videolan/x264/snapshots/)

博主使用源码版本:

http://download.videolan.org/pub/videolan/x264/snapshots/x264-snapshot-20191217-2245.tar.bz2

2、ffmpeg源码(总览:Index of /releases)

博主使用源码版本:http://ffmpeg.org/releases/ffmpeg-4.4.1.tar.bz2

二、准备工作

将两个文件拷贝到TDA4的开发板上,使用开发板本身的gcc编译器进行编译,可以省去使用交叉编译链进行编译的步骤,比较方便!(实际上是移植了很久,没搞定,编译总是报错,无奈……)

在开发板/home/root/ 目录下新建一个文件夹,命名为ffmpeg

进入ffmpeg文件夹,通过scp将两个下载好的文件拷贝到开发板上来。

(开发板可以联网,关于联网,请查看这篇博客!

[TI TDA4 J721E]开发板网络调试功能及开机自动配置网络_AIRKernel的博客-CSDN博客)

mkdir ~/ffmpeg

cd ~/ffmpeg

scp ubuntu@192.168.1.100:/home/ubuntu/x264-snapshot-20191217-2245.tar.bz2 ffmpeg-4.4.1.tar.bz2 ~ffmpeg

两个文件要放在同一个目录下进行解压!!!

因为ffmpeg配置的时候,需要使用到x264生成的库(路径!)

解压两个源码

tar -vxf x264-snapshot-20191217-2245.tar.bz2

tar -vxf ffmpeg-4.4.1.tar.bz2

三、x264配置、编译和安装

进入x264的源码文件夹,分别执行以下命令

cd ./x264-snapshot-20191217-2245

./configure --host=arm-linux-gnueabihf --prefix=$PWD/tmp --enable-shared --disable-asm

make -j16 && make install

四、ffmpeg配置、编译和安装

注意!!

编译ffmpeg之前,需要将系统时间设置为当前的时间时间,因为编译会使用到系统时间。

时间格式:月、日、年 时、分、秒

例:date -s "11/20/2021 10:15:05"

进入ffmpeg的源码文件夹,分别执行以下指令

最后一个编译的过程时间很久,请耐心等待!不要着急!

cd ./ffmpeg-4.4.1

./configure --enable-shared --enable-pic --disable-static --enable-gpl --enable-nonfree --enable-pthreads --enable-ffmpeg --disable-ffplay --enable-swscale --disable-armv5te --disable-armv6 --disable-armv6t2 --disable-stripping --enable-libx264 --extra-cflags=-I$PWD/../x264-snapshot-20191217-2245/tmp/include --extra-ldflags=-L$PWD/../x264-snapshot-20191217-2245/tmp/lib

make -j16 && make install

这一步时间很长……很长……(可能有40分钟左右吧!!)

五、示例

1、流推送:(将RTSP流推送到RTMP服务器)

ffmpeg -i "rtsp://admin:12345678@192.168.8.154:554/stream2" -an -c:v copy -f flv rtmp://192.168.1.1:554/mystream

2、RTSP流保存成.avi(RTSP流来自局域网内部网络摄像头)

ffmpeg -i rtsp://admin:12345678@192.168.8.154:554/stream2 -vcodec copy /home/root/myout.avi

3、USB摄像头流获取并保存成.avi:

ffmpeg -f video4linux2 -s 640x480 -i /dev/video1 /home/root/test.avi

4、使用ffmpeg RTMP推流USB摄像头

测试成功推流的指令代码:(注意设备名,我这里是video1)

ffmpeg -f v4l2 -framerate 25 -video_size 640x480 -i /dev/video1 -f flv -y rtmp://myserver.cn/MINILIVE/mystream

PS:我在实际测试阿里云给的指令的时候出错了,不知道大家能不能成功。

Linux下用FFMPEG采集usb摄像头到RTMP-阿里云开发者社区

ffmpeg -f video4linux2 -qscale 10 -r 12 -s 640x480 -i /dev/video1 -f alsa -i hw:1 -ab 16 -ar 22050 -ac 1 -f mp3 -f flv rtmp://127.0.0.1/rtmpsvr/rtmp1

测试结束。

原文链接:https://blog.csdn.net/AIRKernel/article/details/121483611

参考文献链接

[TI TDA4 J721E](升级版)单屏显示多路摄像头数据(img_mosaic_module节点使用)

此篇教程的完整资源在这里下载

TITDA4单屏多路显示Demo完整资源ImgMosaic节点的使用教程-C/C++文档类资源-CSDN下载

前几天写了一个关于单屏多显示的帖子:

[TI TDA4]TIOVX 单屏显示多路摄像头数据(Mosaic节点使用)_AIRKernel的博客-CSDN博客

当时只是研究了其中的一个Demo,这个Demo里面的图像显示还是有点问题,应该是当时作者算法的问题,我也没有详细研究。

这两天重新梳理了以下,发现有一个Node是专门做这个图像镶嵌的工作的,img_mosaic节点。这个imgMosaic Node的主要作用目前看来就是将图像进行镶嵌到一张大图上,进行显示。比如将多个图像区域,内嵌到一个1920*1080尺寸的image上,然后显示出来。(个人理解,如有不同或者错误,欢迎大家指正一下)。

这篇博客就写一下这个节点的移植和实际应用。

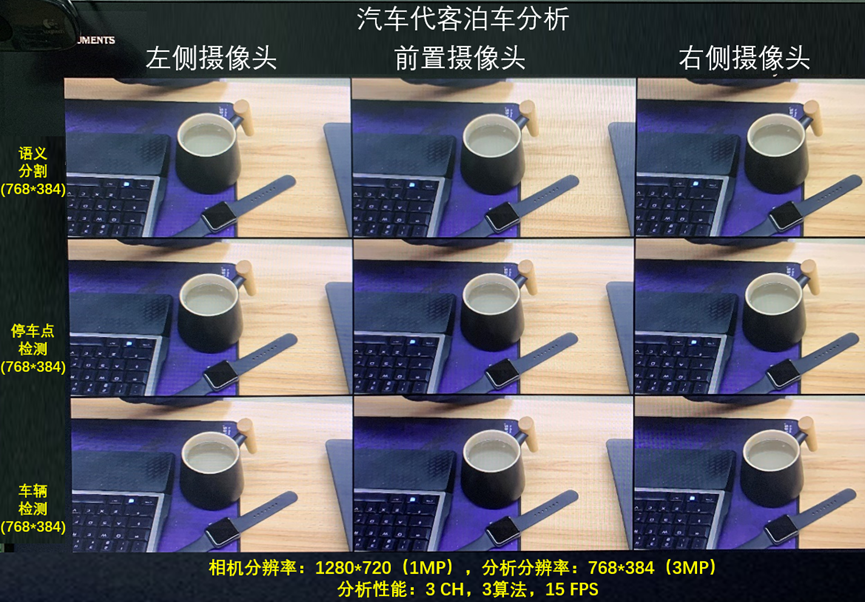

首先看一下效果图:

这里可以设置屏幕显示2个~多个,应该是可以随意分屏的。这个大家可以去试一下,我这里分了9个。另外,我这里只有一个YUV摄像头,如果有多个,大家可以将多个图像替换进去就可以显示不同的图像了,这个替换比较简单,看到代码就应该明白了。

一、基于Demo的移植

(基于ti-processor-sdk-rtos-j721e-evm-08_00_00_12下的app_usb_disp_templete)

app_usb_disp_templete下载地址如下:

TDA4开发板USB摄像头显示NV12图像完整资源-C/C++文档类资源-CSDN下载

这个Node的相关操作文件,是从

ti-processor-sdk-rtos-j721e-evm-08_00_00_12/vision_apps/apps/dl_demos/app_tidl_avp2路径里面拷贝过来的。

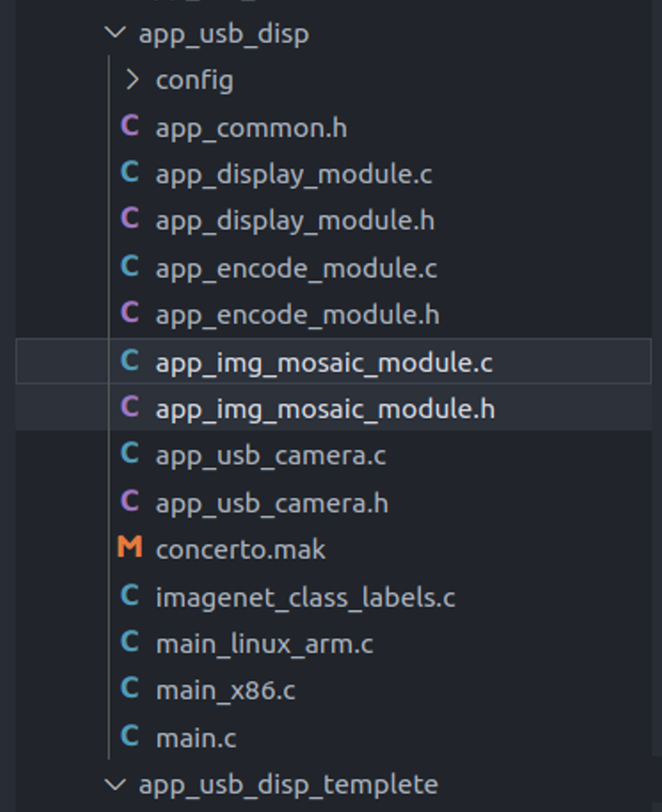

1、拷贝一份app_usb_disp_templete,命名为app_usb_disp。

2、将两个文件:avp_img_mosaic_module.c avp_img_mosaic_module.h,拷贝到app_usb_disp下。(请忽略encode这两个文件,暂时用不到,还有点问题没有解决,后面会专门处理这个问题)。

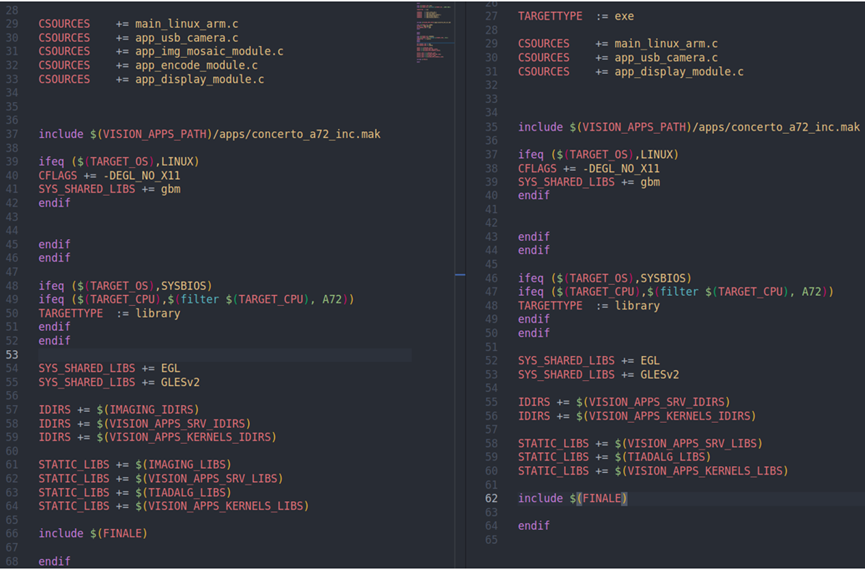

3、修改concerto.mak内容

这里有四个地方需要修改 添加参与编译的源文件、添加头文件路径、添加库路径

A、 修改TARGET ,这里可以根据自己的需要进行命名。如:vx_app_usb_disp

B、 CSOURCES += app_img_mosaic_module.c

C、 IDIRS += $(IMAGING_IDIRS)

D、 STATIC_LIBS += $(IMAGING_LIBS)

如图,左边是修改过的,右边是修改前的。大家对照以下(忽略encode相关)

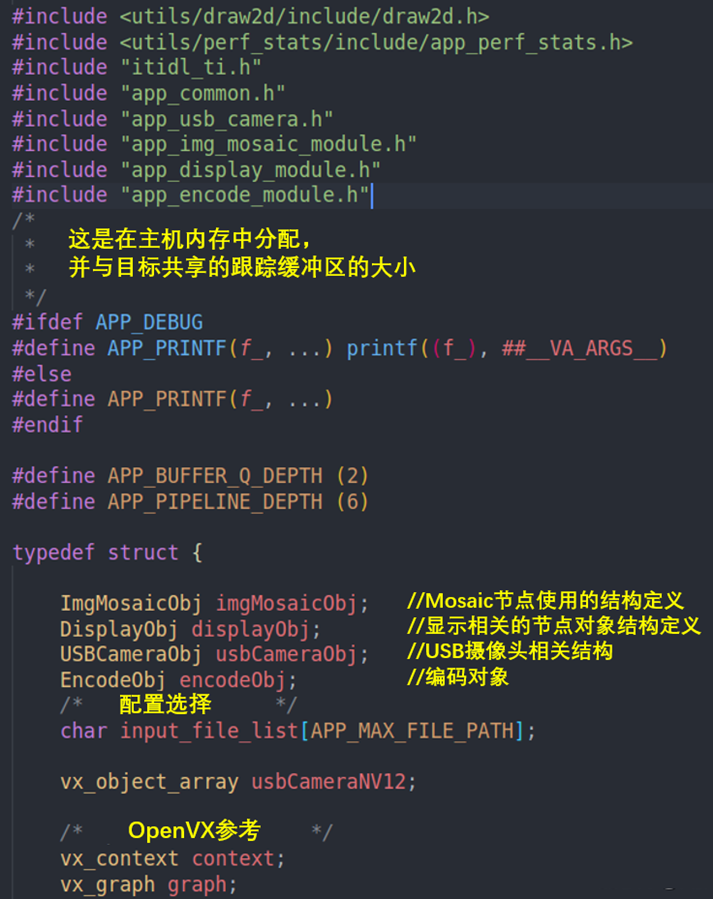

4、main.c中添加头文件

#include "app_img_mosaic_module.h"

在AppObj中添加一个img的对象:ImgMosaicObj imgMosaicObj;

在AppObj中添加一个 graph,用于执行Mosaic节点。

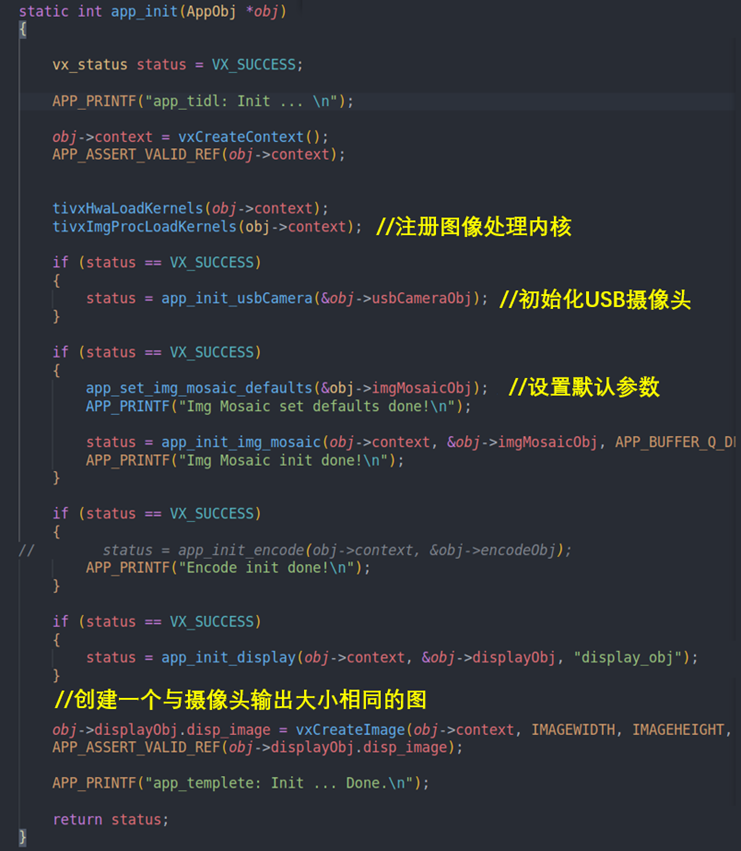

5、 分别在app_init / app_create_graph / app_verify_graph / app_run_graph_for_one_frame 中添加关于imgMosaic相关的内容。

app_init中对imgMosaic节点进行初始化操作/添加注册图像处理的kernel。

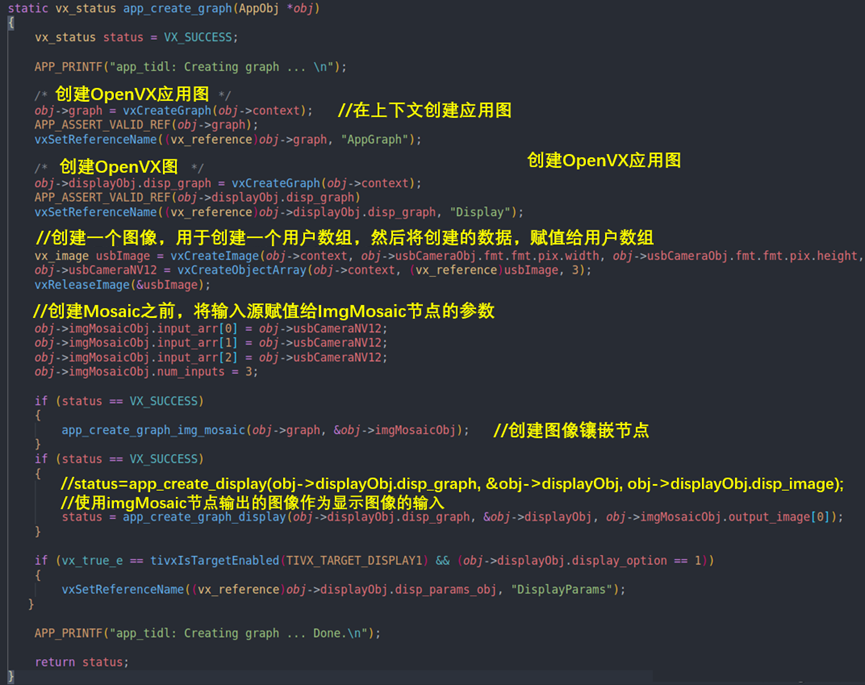

app_create_graph 中创建 graph。

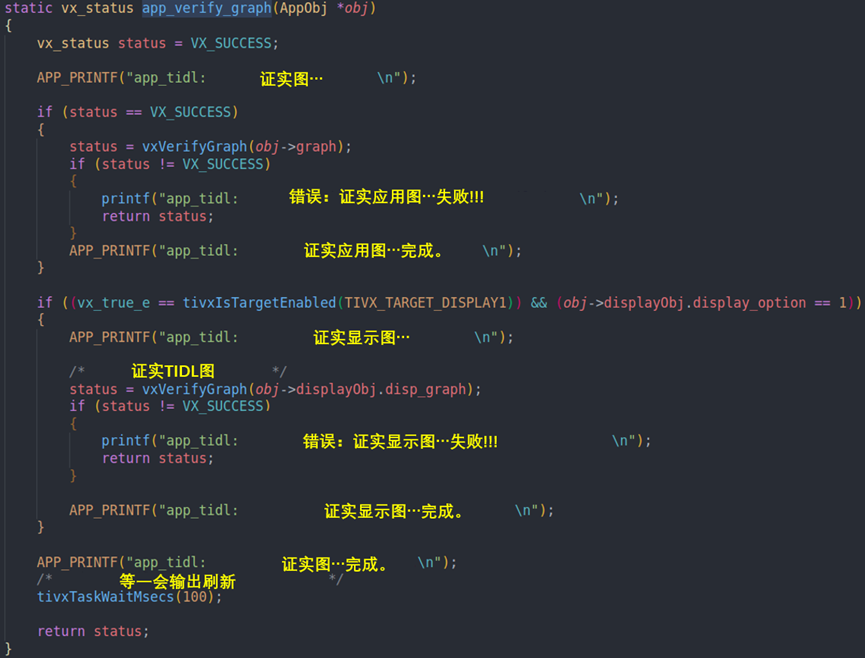

app_verify_graph 中对 graph进行检查。

app_run_graph_for_one_frame 中执行graph。

分别如下图(对应的函数都在刚刚拷贝的两个文件中):

本工程的工作总体流程是(具体大家还是跟着代码走读一下):

A、创建了两个Graph,一个用于执行imgMosaic,一个用于执行Display。

B、imgMosaic节点的输入是9个NV12格式的图像组成的array(用户数组),输出是一个1920*1080的image。

C、display节点的输入是imgMosaic节点的输出图像。

D、首先usb摄像头先工作,生成YUV图像,在内存中以指针形式传递出去。

E、将usb摄像头生成的YUV数据,复制到imgMosaic节点的输入数组中。

F、执行imgMosaic节点,将输入的数组,生成一个输出的显示图像。

G、将输出的显示图像,传递给display节点,然后执行disp_graph,显示出图像。

D-G 的过程,每一次都会执行一次,将数组更新,然后显示也会更新。

添加完上述这些东西以后,基本上就可以正常编译核运行了。

其中有一个函数是我后来添加的:app_running_imgMosaic,位于app_img_mosaic_module.c内,这个函数用于拷贝摄像头生成的数据,到imgMosaic节点的用户数组内。大家可以通过修改这个函数的传入指针,将不同摄像头的数据传入即可得到想要的数据。

//动态更新imgMosaic节点内的输入数组的内容

//目前此函数仅支持NV12格式数据的拷贝,大家可以根据自己需要改一下,比如可以拷贝BMP图像的RGB数据等等

vx_status app_running_imgMosaic(vx_object_array *array, char *image)

{

vx_status status = VX_SUCCESS;

if (status == VX_SUCCESS)

{

status = vxGetStatus((vx_reference)(*array)); //查看array状态,如果为空则表示错误

vx_size arrLen;

vxQueryObjectArray((*array), VX_OBJECT_ARRAY_NUMITEMS, &arrLen, sizeof(vx_size)); //查询数组内元素的个数

vx_int32 i;

for (i = 0; i < arrLen; i++) //将数据拷贝到数组中

{

vx_rectangle_t rect;

vx_imagepatch_addressing_t image_addr;

vx_map_id map_id;

void *data_ptr;

vx_uint32 img_width;

vx_uint32 img_height;

vx_image in_img;

in_img = (vx_image)vxGetObjectArrayItem((*array), i); //获取array内对象的属性,这里是设置为图像格式

vxQueryImage(in_img, VX_IMAGE_WIDTH, &img_width, sizeof(vx_uint32)); //查询图像宽度

vxQueryImage(in_img, VX_IMAGE_HEIGHT, &img_height, sizeof(vx_uint32)); //查询图像的高度

rect.start_x = 0;

rect.start_y = 0;

rect.end_x = img_width;

rect.end_y = img_height;

status = vxMapImagePatch(in_img, //向内核申请图像访问的指针地址,用于拷贝用户数据到vx内核空间

&rect,

0,

&map_id,

&image_addr,

&data_ptr,

VX_WRITE_ONLY,

VX_MEMORY_TYPE_HOST,

VX_NOGAP_X);

memcpy(data_ptr, image, img_width * img_height); //拷贝数据

vxUnmapImagePatch(in_img, map_id); //释放map_id

rect.start_x = 0;

rect.start_y = 0;

rect.end_x = img_width;

rect.end_y = img_height / 2;

status = vxMapImagePatch(in_img, //向内核申请图像访问的指针地址,用于拷贝用户数据到vx内核空间

&rect,

1,

&map_id,

&image_addr,

&data_ptr,

VX_WRITE_ONLY,

VX_MEMORY_TYPE_HOST,

VX_NOGAP_X);

memcpy(data_ptr, image + img_width * img_height, img_width * img_height / 2); //拷贝数据,这里需要注意拷贝源地址的偏移量

vxUnmapImagePatch(in_img, map_id); //释放map_id

vxReleaseImage(&in_img);//释放临时图像

}

}

return status;

}

我会将完整工程放过来,资源上传审核需要时间,链接如下:

TITDA4单屏多路显示Demo完整资源ImgMosaic节点的使用教程-C/C++文档类资源-CSDN下载

PS:这个不是广告,我自己在用的笔记软件。给大家推荐一款比较实用的在线云笔记 Notion(免费),下载链接如下:

NotionForUbuntu.tar.xz-管理软件文档类资源-CSDN下载

https://blog.csdn.net/AIRKernel/article/details/125731020

参考文献链接

https://blog.csdn.net/AIRKernel/article/details/121210285

人工智能芯片与自动驾驶

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 全程不用写代码,我用AI程序员写了一个飞机大战

· DeepSeek 开源周回顾「GitHub 热点速览」

· 记一次.NET内存居高不下排查解决与启示

· MongoDB 8.0这个新功能碉堡了,比商业数据库还牛

· .NET10 - 预览版1新功能体验(一)

2023-07-01 自研光刻机与光刻机技术分析

2022-07-01 激光雷达与自动驾驶详解

2021-07-01 DSP与CEVA芯片

2020-07-01 矩阵分解

2020-07-01 电影数据集

2020-07-01 CVPR2020:基于自适应采样的非局部神经网络鲁棒点云处理(PointASNL)

2020-07-01 CVPR2020:三维点云无监督表示学习的全局局部双向推理