HBM技术与市场分析

HBM技术与市场分析

大厂疯抢HBM,但很缺

HBM的火最近越烧越旺。SK海力士今年5月刚刚推出最新的HBM3E,英伟达、AMD、亚马逊等巨头已经在排队抢样品了。

HBM的热度随着AI的盛行水涨船高,还引起了投资圈的关注,据说开一个HBM的线上会议,能有上万人预约报名。

爆火的HBM究竟是个啥?为什么大厂们都在抢HBM?HBM的玩家都有谁?能供应得上吗?

HBM是个啥为什么都在抢

存储芯片的行情自去年以来一直不好,虽然一直有触底的声音,但是今年二季度DRAM和NAND的价格还在进一步下跌,DRAM价格跌幅扩大至18%,NAND扩大至13%。与此同时,据集邦咨询最新预测,第三季NAND Flash市场仍处于供给过剩,NAND Flash均价预估将续跌3-8%。

在存储市场惨淡的大背景下,HBM作为DRAM的一种,却在今年年初涨了5倍。HBM到底是个啥,凭啥逆势涨价?

HBM(High Bandwidth Memory),意为高带宽存储器,是一种面向需要极高吞吐量的数据密集型应用程序的DRAM,常被用于高性能计算、网络交换及转发设备等需要高存储器带宽的领域,高端GPU是其目前最瞩目的应用场合。

HBM的作用类似于数据的“中转站”,就是将使用的每一帧,每一幅图像等图像数据保存到帧缓存区中,等待GPU调用。

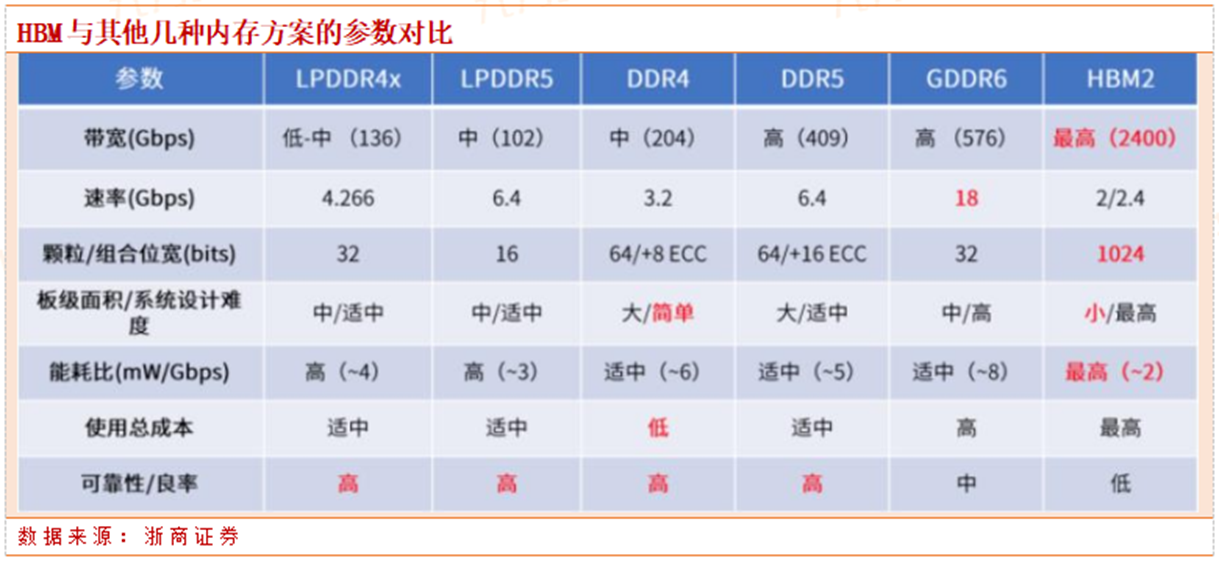

HBM与其他DRAM最大的差别就是拥有超高的带宽。目前最新的HBM3的带宽最高可以达到819 GB/s,而最新的GDDR6的带宽最高只有96GB/s,CPU和硬件处理单元的常用的DDR4的带宽更是只有HBM的1/10。这次被争抢的SK海力士即将推出的HBM3E,带宽甚至达到了1TB/s。

HBM能拥有如此大的带宽,简单来说,是因为“布局”变了。

HBM的原始形态——GDDR,是独立封装,在PCB上围着处理器转一圈。而变身后的HBM,则在硅中阶层(Silicon Interposer)上叠了起来并和GPU封装在一起。这样一来,面积一下子缩小了很多,并且,HBM离GPU更近了,数据传输也就更快了。

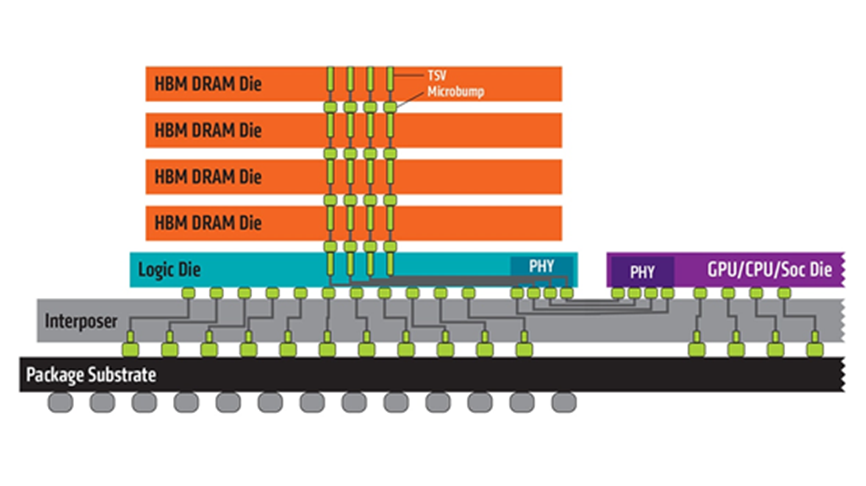

HBM是怎么叠起来的,可以参考下面这张图。

HBM将DRAM裸片像摩天大楼一样垂直堆叠,并通过硅通孔(Through Silicon Via, 简称“TSV”)技术将“每层楼”连接在一起,贯通所有芯片层的柱状通道传输信号、指令、电流,以增加吞吐量并克服单一封装内带宽的限制。你可以将HBM想象成一个切的整整齐齐的三明治,TSV就是扎在里面的那根牙签,将整个三明治固定并打通。

叠起来之后,直接结果就是接口变得更宽,其下方互联的触点数量远远多于DDR内存连接到CPU的线路数量。因此,与传统内存技术相比,HBM具有更高带宽、更多I/O数量、更低功耗、更小尺寸。高带宽到底有啥魔力,为啥大厂都在抢HBM?

最大的原因,应该是AI服务器需求的爆发。

自ChatGPT爆火之后,国内外大厂争相竞逐AI大模型。而AI大模型的基础,就是靠海量数据和强大算力来支撑训练和推理过程。参数量越大,AI模型越智能,最新的GPT-4模型据说有1.76万亿参数量。不过,要想支撑如此庞大的数据处理和传输,就要打破“内存墙”。

存储和处理器并没有同步发展,过去20年中,硬件的峰值计算能力增加了90,000倍,但是内存/硬件互连带宽却只是提高了30倍。当存储的性能跟不上处理器,对指令和数据的搬运(写入和读出)的时间将是处理器运算所消耗时间的几十倍乃至几百倍。

可以想象一下,数据传输就像处在一个巨大的漏斗之中,不管处理器灌进去多少,存储器都只能“细水长流”。而数据交换通路窄以及其引发的高能耗,便是通常所说的“内存墙”。

HBM的高带宽相当于把漏斗中间的通道打得更开,让数据可以快速流通,面对AI大模型这种动不动千亿、万亿的参数,服务器中负责计算的GPU几乎必须搭载HBM。

目前,高端GPU市场被英伟达和AMD瓜分,两家尖端的GPU都配备了HBM,最新的H100和MI300X都配备了目前最新的HBM3。

数据来源:NVIDIA官网,AMD官网,芯八哥整理

英伟达将在2024年发布其下一代专为AI和HPC专用的高性能显卡Hopper-Next ,有消息称这款GPU将搭载目前尚未量产的HBM3E, 英伟达已经向SK 海力士寻求样品。据传AMD、微软和亚马逊不甘落后,也在向SK 海力士要HBM3E的样品。千年老二SK海力士这次成了第一

大厂们都在争抢的HBM3E是SK 海力士预计明年量产的最新版HBM,并且,现在市面上最先进的HBM3,目前也只有SK 海力士一家可以量产。

此外,集邦咨询的数据显示,2022年三大原厂HBM市占率分别为SK海力士50%、三星约40%、美光约10%。预计到2023年,SK 海力士市占率有望提升至 53%,而三星、美光市占率分别为38%及9%。可以说,在HBM领域,SK海力士是名副其实的老大。

HBM是DRAM的一种,SK 海力士在DRAM领域长年屈居于三星之后,可以说是DRAM界的“千年老二”。为什么在HBM领域,SK海力士突然“翻身当老大”了呢?SK 海力士在发展HBM的过程中,做对了哪些事?

简单来说,就是找对了方向,第一个用技术打开了市场,又能在关键时刻及时调整产能,用数量占据市场。

谈SK海力士的反超,还得从另一个“千年老二”AMD开始说起。

早在2009年,AMD就意识到了DDR在未来发展的局限性。除了上文所说的“内存墙”,也就是数据流得很慢;“功耗墙”也是GPU发展的制约,数据从内存转移到处理器,再从处理器回到内存,一来一回的过程需要挤占功耗,当数据量越来越大,功耗也面临不够用的问题。

AMD早早地“预见”到了这点,并且想到了用3D堆叠的方式大幅增加带宽,于是在2009年就开始着手HBM的研发。

AMD毕竟不是专业做内存的,得找个专业的一起干。要想实现3D堆叠,连接每一块DDR的那根“柱子”很重要,也就是TSV硅通孔技术。

来源:Amkor

2011年的时候SK海力士成功研发采用TSV技术的16GB DDR3内存,同年,三星也发布了采用TSV技术的DDR3。最后AMD选择了SK 海力士,两家一起研究HBM。2013年,SK 海力士和AMD终于推出了HBM这项全新的技术,HBM1的工作频率约为1600 Mbps,漏极电源电压为1.2V,芯片密度为2Gb(4-hi),其带宽为4096bit,远超GDDR5的512bit,带宽的增加也就很大程度上缓解了“内存墙”的问题。

在功耗方面,GDDR5每瓦功耗的带宽为10.66GB/秒,而HBM每瓦带宽超过35GB/秒,每瓦能效提高了3倍,“功耗墙”的问题也在一定程度上被缓解。

SK 海力士第一个站上了HBM的跑道。

虽然具有先发优势,但由于成本高昂,AMD之后便再次投向GDDR的怀抱,没有了“用武之地”,HBM暂时冷了下来。

直到2016年,存储老大三星跳过HBM1,直接量产HBM2,同年,英伟达发布Tesla P100显卡,内置三星的16GB HBM2显存,这一下子再将HBM拉回大众视线。

此后,SK 海力士便开始和三星进行HBM追逐战。

基本上一家发布新的,半年内另外一家马上跟上,有时你先,有时我先。就这样从4GB HBM2,到8GB HBM2,再到HBM2E。

两家韩厂忙着追赶HBM的时候,另一个巨头美光还在“自娱自乐”。美光没有跟着搞HBM,而是和英特尔一起搞出了一个叫HMC(混合内存)的技术,虽然也使用了TSV,但是和HBM完全不同,也完全不兼容。推出后一直响应寥寥,美光在2018年才正式放弃HMC,开始追赶HBM,2020年才推出HBM2,被韩厂拉开了不小的距离。

让SK 海力士真正超过三星的,是HBM3。

SK海力士早在2021年10月就发布了全球首款HBM3,并于2022年6月正式量产,供货英伟达。三星虽然在路线图里显示2022年HBM3技术已经量产,但是要等到今年下半年才能大规模生产,出现在市场上。也就是说,现在市面上只有SK 海力士有HBM3。

来源:SK 海力士 & Rambus

恰逢天时地利,去年年末ChatGPT横空出世,带动了轰轰烈烈的AI大浪潮,并且这股热潮目前看起来还将持续较长的时间,一下子把HBM这个“冷门”高端内存带到了需求的中心。要想在AI激战中活下来,就必须要抢高端GPU,而高端GPU几乎必备HBM。SK 海力士成为了目前HBM的最大赢家。不过,下一代的HBM3E将在2024年量产,而三星下一代的HBM3P也将在2024年实现。三星在HBM上咬得很紧,SK 海力士能不能保持住目前的优势还有待观察。

除了技术上的领先,SK 海力士可以说是审时度势第一名。在HBM 的需求被炒热后不久,就当机立断地扩产,成为三巨头里第一个扩产HBM的厂家。

受整个半导体市场行情低迷的影响,以存储为主要业务的SK 海力士的财报很不好看,今年第一季度亏损3.4023万亿韩元(约合人民币191.93亿元),创近十年之最。在这种惨状之下,SK 海力士表示今年的投资规模将减少50%或以上。

但是,今年6月初,SK 海力士宣布决定使用最新的尖端 10 纳米级第五代 (1b) 技术大幅提高明年的产量,大部分增量将由 HBM3E 填充。此外,有消息称SK 海力士已着手扩建HBM产线,目标将 HBM产能翻倍,扩产焦点在于HBM3。

靠技术打开市场,并用数量占据市场,SK 海力士铁了心要靠HBM克服半导体低迷。

HBM能供应上吗?

除了SK 海力士,三星和美光也开启了HBM的扩产步伐。

SK 海力士:投资1万亿韩元,目标HBM产能翻倍

今年6月有报道指出,SK海力士正在准备投资后段工艺设备,将扩建封装HBM3的利川工厂,预计到今年年末,后道工艺设备规模将增加近一倍。由于HBM主要是通过垂直堆叠多个DDR来提高数据处理速度,因此只有增加后道设备才能扩大HBM的出货量。这笔投资金额大约在1万亿韩元(约合人民币56.41亿元)。

此外,SK 海力士宣布决定使用最新的尖端 10 纳米级第五代 (1b) 技术大幅提高明年的产量,大部分增量将由 HBM3E 填充。

三星:同样投资一万亿韩元,下半年量产HBM3

今年7月,三星宣布将投资一万亿韩元在天安工厂展开扩产,该厂主要负责半导体封装等后道工艺,三星计划在该厂生产目前正在供应的HBM2和HBM2E等产品,目标明年底之前将 HBM产能提高一倍。此外,三星还计划于下半年量产8层堆叠HBM3和12层HBM3E。

美光:增加HBM投资

美光已开始向客户提供HBM3产品样品,预计这款HBM3产品将于2024年初开始量产,并在2024财年实现可观的收入。此外,美光决定在中国台湾增加HBM内存产品组装和测试能力的投资,以应对人工智能浪潮下该领域出现的强劲需求。

存储大厂们都在积极扩产HBM,但这样可以保证HBM的供应吗?

先从需求端来看,HBM目前仍然主要被应用于高端GPU中,例如英伟达的H100和AMD的MI300,不过谷歌在其TPU中也采用了HBM来构建Bard基础设施,也可能带动HBM 的需求。

花旗预期,2023年HBM DRAM需求(1Gb)将达到35亿片,较去年增加99%,而2024年将达到102亿片,再增191%。

从供应端来看,花旗预计,2023年HBM DRAM供应量(1Gb)将达到31亿片,年增长80%,2024年将成长至87亿片,年增183%。

虽然大厂们都在积极扩产HBM,但是从预计的供需量来看,供应的增长速度略慢于需求的飞涨。此外,有相关研究单位分析,2023年HBM供需比为-13%,2024年为-15%。近两年HBM或许仍将处于供不应求的状态。

存储芯片HBM

今年上半年的最强主题毫无疑问是AI,包括硬件端的服务器产业链、软件端的算法、以及应用端传媒、游戏等等,都一度成为资金追逐的重点。

7月伊始,相关领域依然是资金追逐的对象,11日,海光信息大涨超10%,江波龙、深科技等存储概念均大幅拉升,这些都折射出AI产业链的热度依旧。今天我们主要从硬件层面来分析产业趋势。

·GPT-4引领大模型热度,AI服务器预期加速渗透

本轮AI行情的两大主导者,硬件层面英伟达独领风骚,而算法层面则是OpenAI独占鳌头。英伟达在硬件上的持续突破,为全球人工智能领域巨头们提供了基础支持,导致人工智能算法领域大力出奇迹,再多年的迭代与积累后,GPT-4横空出世,并引起了硬件、算法、应用端的高关注度,已经有不少人认为GPT-4等大模型将引起新一轮技术革命。

目前,海外主要大模型包括 OpenAI 的 ChatGPT-3、 Anthropic 的 Claude、英伟达与微软的 Megatron Turing-NLG 以及 Meta 的 OPT 等。

中国大模型主要包括百度文心、华为盘古、阿里通义、腾讯混云以及商汤的视觉模型等。百度推出文心大模型,基本实现跨模态和多下游多领域的应用,目前已上线文心一言。华为则通过模型泛化,解决传统 AI 作坊式开放模式下不能解决的 AI 规模化和产业化难题,中国 AI 大模型正加速突破中。

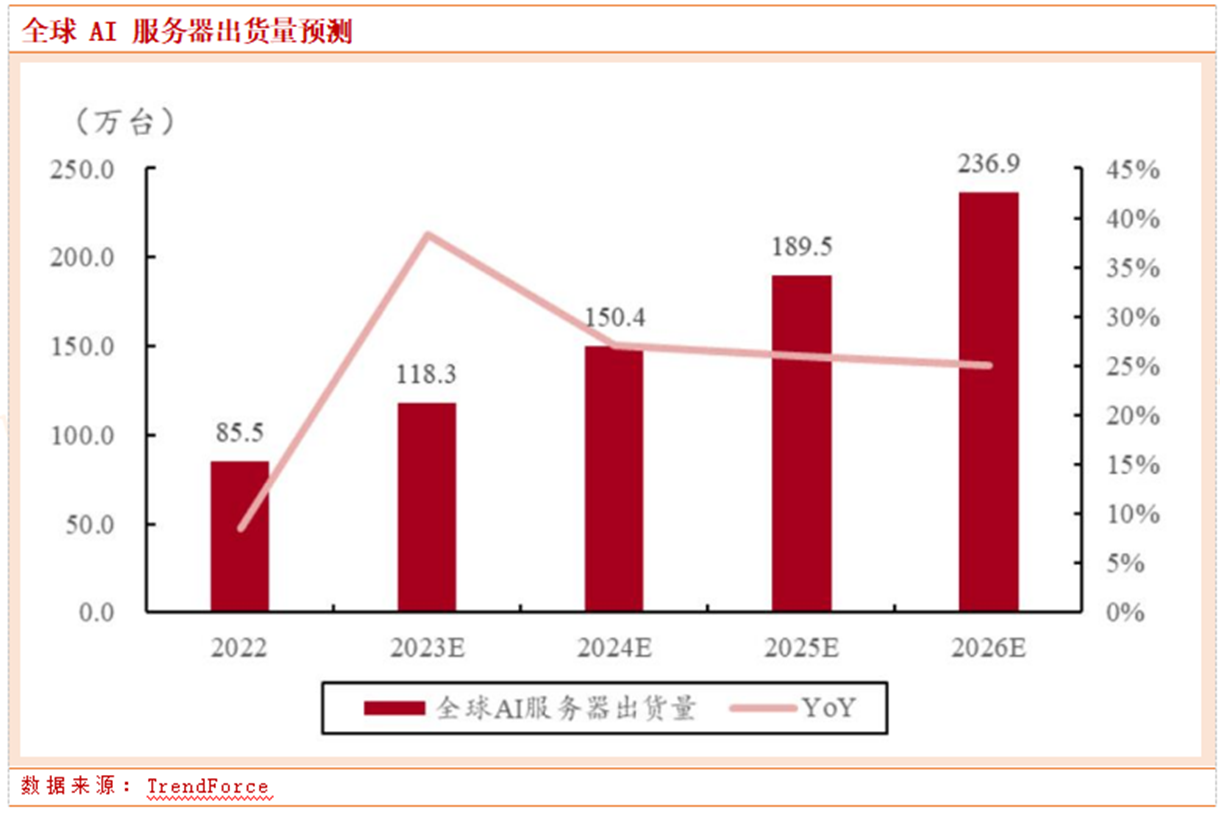

AI大模型的火爆,让人们开始憧憬AI服务器开启1-10的量变。据统计,截至2022年底,全球AI服务器占服务器总量的比例大约1%。而随着AI的出圈,机构开始预期预期2023年AI服务器占比将达到9%,2026年占比15%,实现出货量的跨越式增长。

根据TrendForce,预计 2023 年 AI 服务器(包含搭载 GPU、FPGA、ASIC等)出货量近120万台,年增 38.4%,占整体服务器出货量近9%,至2026年将占15%,同步上修2022~2026年AI服务器出货量年复合成长率至22%。

·服务器产业链划分

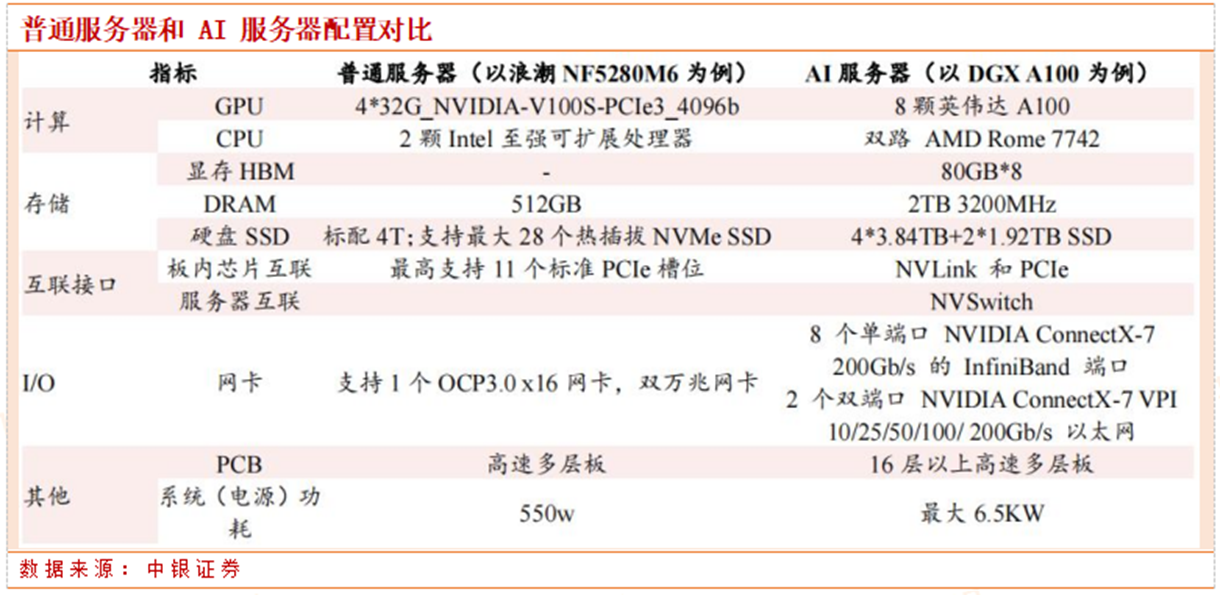

AI 浪潮之下,与之适配的高性能 AI 服务器更是支撑算力的主要载体。AI 服务器是一种高性能计算机,专门用于运行人工智能算法和处理大规模数据。它通常具备高处理能力、大内存和高速存储器、多核心处理器、高速网络接口等特点,能够处理复杂的计算任务和大数据量的处理任务。

从硬件角度来看,与传统服务器相比,AI 服务器通常配备高性能的 GPU 或 TPU 加速器,大容量显存及存储器,兼有较多的 PCIe 显示设备作为外设,以实现图像识别及人工智能学习等功能,以实现更快、更高效的数据处理和计算能力,以满足人工智能等大数据应用的需求。

今年服务器产业链的上中下游几乎都被资金重点关注过,CPU、GPU、存储、接口芯片、网卡、光模块、PCB等等领域都出现过涨幅居前的个股。

我们认为目前服务器产业链目前还是以主题投资为主,许多个股短期不一定能释放业绩,但大家对于AI服务器中长期渗透率提升的预期,导致该领域的交投情绪居高不下。

·近期高光的HBM是什么?

从上文的AI服务器与普通服务器的对比中,AI服务器DGX A100搭载了8颗英伟达A100芯片(GPU),而每颗GPU搭配了80GB HBM内存。我们注意到,近期A股市场对于HBM的炒作热情不减,如子公司是海力士代理商的香农芯创连续大涨,HBM前驱体供应商雅克科技表现也不俗,即便与AI服务器存储搭不上边的兆易创新、北京君正都有所表现。

那么,HBM到底是个什么东西?HBM(High Bandwidth Memory),意为高带宽存储器,是一种面向需要极高吞吐量的数据密集型应用程序的DRAM,HBM的作用类似于数据的“中转站”,就是将使用的每一帧,每一幅图像等图像数据保存到帧缓存区中,等待GPU调用。

正如其名,HBM与其他DRAM最大的差别就是拥有超高的带宽。最新的HBM3的带宽最高可以达到819 GB/s,而最新的GDDR6的带宽最高只有96GB/s,CPU和硬件处理单元的常用外挂存储设备DDR4的带宽更是只有HBM的1/10。

超高的带宽让HBM成为了高性能GPU的核心组件。自从去年ChatGPT出现以来,HBM作为AI服务器的“标配”,更是开始狠刷存在感。从“鲜有问津”的高岭之花,变成了大厂们争相抢夺的“香饽饽”。

HBM为什么可以拥有这么高的带宽?它和其他DRAM的差别在哪?为什么会成为高端GPU的标配呢?

先说一下HBM是怎么发展而来的。

按照不同应用场景,JEDEC(固态技术协会)将DRAM分为三个类型:标准DDR、移动DDR以及图形DDR,HBM属于最后一种。

图形DDR中,先出现的是GDDR(Graphics DDR),它是为了设计高端显卡而特别设计的高性能DDR存储器规格,是打破“内存墙”的有效方案。

由于处理器与存储器的工艺、封装、需求的不同,二者之间的性能差距越来越大,过去20年中,硬件的峰值计算能力增加了90,000倍,但是内存/硬件互连带宽却只是提高了30倍。当存储的性能跟不上处理器,对指令和数据的搬运(写入和读出)的时间将是处理器运算所消耗时间的几十倍乃至几百倍。

可以想象一下,数据传输就像处在一个巨大的漏斗之中,不管处理器灌进去多少,存储器都只能“细水长流”。而数据交换通路窄以及其引发的高能耗,便是通常所说的“内存墙”。

为了让数据传输更快,就必须要提高内存带宽,内存带宽是处理器可以从内存读取数据或将数据存储到内存的速率。GDDR采用传统的方法将标准PCB和测试的DRAMs与SoC连接在一起,旨在以较窄的通道提供更高的数据速率,进而实现必要的吞吐量,具有较高的带宽和较好的能耗效率。

不过,随着AI等新需求的出现以及风靡,对带宽的要求更高了,GDDR也开始不够用。但是按照GDDR现有的模式很难有突破性的带宽进展,存储厂商们望着现有的GDDR,终于顿悟:这样“躺平”下去不行,得“叠”起来!于是,HBM出现了。

所以,HBM其实是GDDR的替代品,是将DDR芯片堆叠在一起后和GPU封装在一起,实现大容量,高位宽的DDR组合阵列。听起来有点复杂,看下面这张图就一目了然了。

GDDR作为独立封装,在PCB上围绕在处理器的周围,而HBM则排布在硅中阶层(Silicon Interposer)上并和GPU封装在一起,面积一下子缩小了很多,举个例子,HBM2比GDDR5直接省了94%的表面积。并且,HBM离GPU更近了,这样数据传输也就更快了。

HBM之所以可以做到这样的布局,是因为采用了3D堆叠技术。HBM将DRAM裸片像摩天大楼一样垂直堆叠,并通过硅通孔(Through Silicon Via, 简称“TSV”)技术将“每层楼”连接在一起,贯通所有芯片层的柱状通道传输信号、指令、电流,以增加吞吐量并克服单一封装内带宽的限制。你可以将HBM想象成一个切的整整齐齐的三明治,TSV就是扎在里面的那根牙签,将整个三明治固定并打通。

采用3D堆叠技术之后,其直接结果就是接口变得更宽,其下方互联的触点数量远远多于DDR内存连接到CPU的线路数量。从传输位宽的角度来看,4层DRAM裸片高度的HBM内存总共就是1024 bit位宽。很多GPU、CPU周围都有4片这样的HBM内存,则总共位宽就是4096bit。

因此,与传统内存技术相比,HBM具有更高带宽、更多I/O数量、更低功耗、更小尺寸。

HBM成本在AI服务器成本中占比排名第三,约占9%,单机ASP(单机平均售价)高达18,000美元。所以,AI服务器是HBM目前最瞩目的应用领域。

·HBM竞争格局

HBM作为DRAM的一种,其市场也被三巨头瓜分。目前技术走在最前面的是SK海力士,并且它也拥有第一的市占率,高达50%,紧随其后的是三星,市占率约40%,美光约占10%。预计到2023年,SK 海力士市占率有望提升至 53%,而三星、美光市占率分别为38%及9%。

从技术上先来看,SK海力士是目前唯一实现HBM3量产的厂商,并向英伟达大量供货,配置在英伟达高性能GPU H100之中,持续巩固其市场领先地位。

根据此前的资料介绍,SK海力士提供了两种容量产品,一个是12层硅通孔技术垂直堆叠的24GB(196Gb),另一个则是8层堆叠的16GB(128Gb),均提供819 GB/s的带宽,前者的芯片高度也仅为30微米。相比上一代HBM2E的460 GB/s带宽,HBM3的带宽提高了78%。此外,HBM3内存还内置了片上纠错技术,提高了产品的可靠性。

三星在2022年技术发布会上发布的内存技术发展路线图中,显示HBM3技术已经量产,其单芯片接口宽度可达1024bit,接口传输速率可达6.4Gbps。2024年预计实现接口速度高达7.2Gbps的HBM3P,预计2025年在新一代面向AI的GPU中见到HBM3P的应用。

美光科技走得较慢,于2020年7月宣布大规模量产HBM2E,HBM3也仍作为其产品线在持续研发之中。

下游厂商主要是CPU/GPU厂商,如英特尔、英伟达以及AMD。因为HBM是于GPU封装在一起的,所以HBM的封装基本也由晶圆代工厂一同包揽完成,而晶圆代工厂商包括台积电、格芯等也在发力HBM相关技术。国内厂商布局不大,只有一些企业涉及封测,如国芯科技与深科技。

最后,需要注意的是,HBM还是在内存领域占比仅约1-1.5%的份额,未来是不是能如机构预期那样,实现快速跨越,还有待继续跟踪,目前该领域还处于概念炒作阶段,能否放出业绩还不确定。

不过,随着市场对于存储领域景气触底的预期不断提升,三四季度存储业绩有望边际改善,这或是存储领域的重要支撑。

参考文献链接

https://mp.weixin.qq.com/s/kCejr4sz9R9elb42T4jNhQ

https://mp.weixin.qq.com/s/IQnmwGFW_aeXNghDou1CHw

浙公网安备 33010602011771号

浙公网安备 33010602011771号