李宏毅深度学习笔记-特征归一化与梯度下降

李宏毅深度学习笔记 https://datawhalechina.github.io/leeml-notes

李宏毅深度学习视频 https://www.bilibili.com/video/BV1JE411g7XF

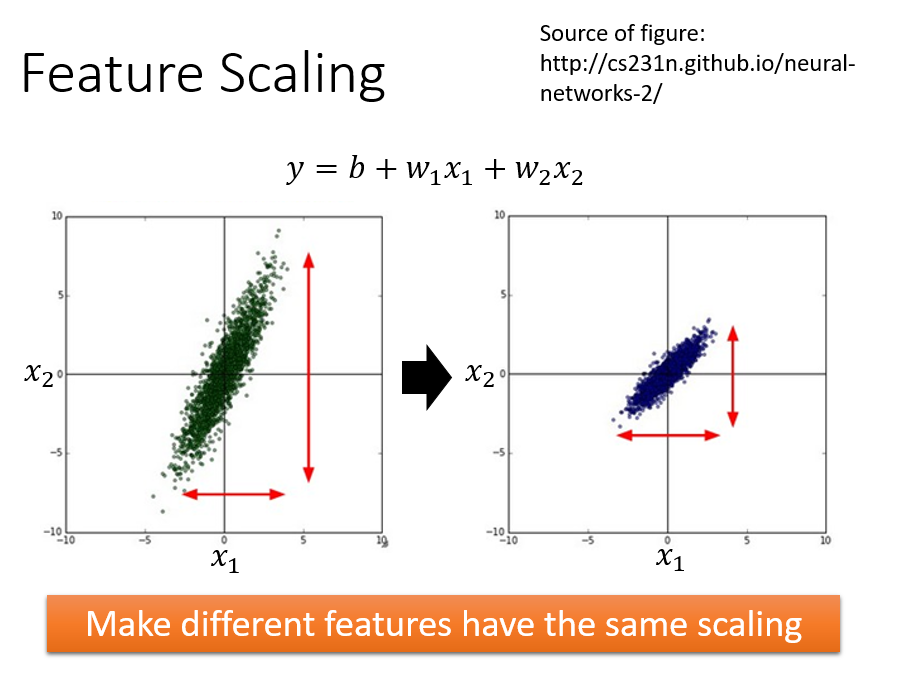

特征分布range差异很大,建议做特征缩放

为什么要这么做?

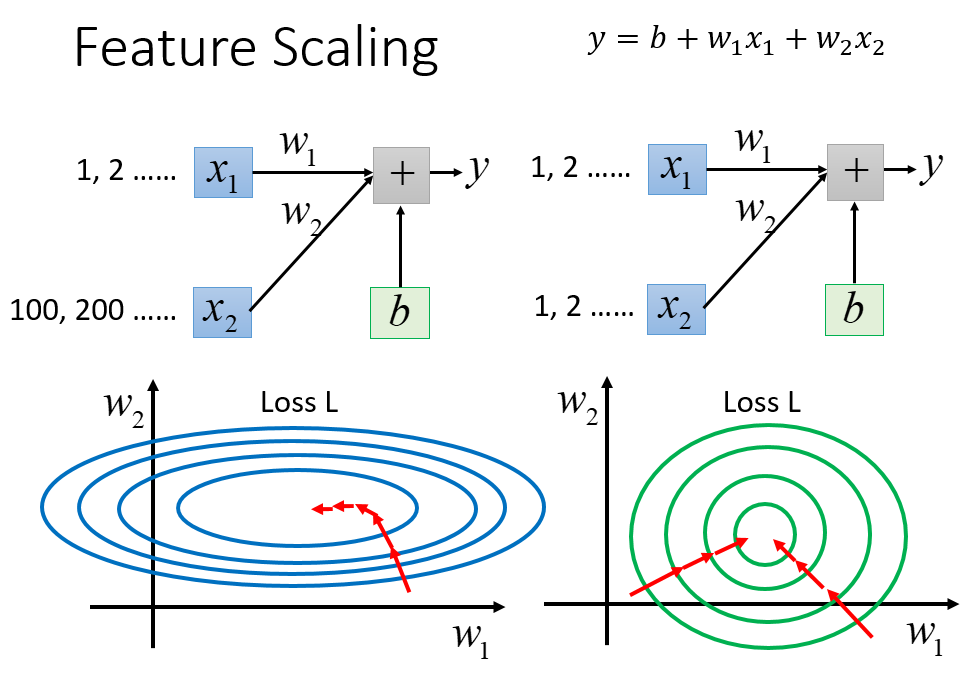

\(x_1\)的scale比\(x_2\)小得多,\(w_1\)和\(w_2\)变化幅度一样时,\(x_2\)对\(y\)的影响比\(x_1\)大

画出error surface如左下图(蓝色),\(y\)关于\(w_1\)的微分小,\(w_1\)对\(y\)的影响小,那么在\(w_1\)方向等高线比较平滑;同理,\(w_2\)方向则比较狭小

当两个参数的scale比较接近时,error surface就接近于圆形

特征缩放有什么影响?

如果不缩放,像长椭圆形的error surface,所有参数使用同一种学习率效果差,不使用Adagrad这种自适应梯度下降是很难处理的。参数update是顺着等高线方向走的,再update不会指向最低点走。

而缩放后,圆形的error surface,参数update效率高,指向圆心走。

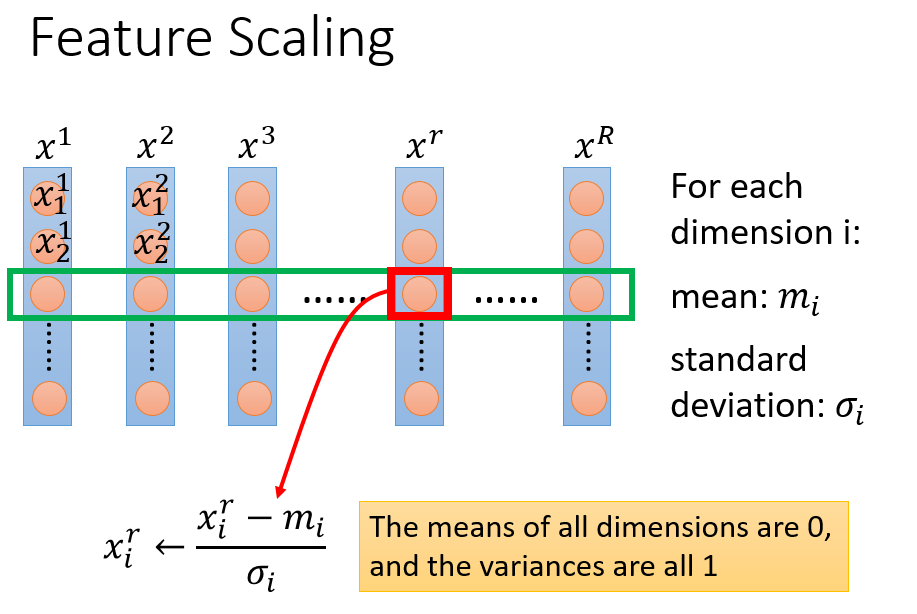

如何进行缩放?

比较普通的就是标准化

浙公网安备 33010602011771号

浙公网安备 33010602011771号