Python爬虫学习总结-爬取某素材网图片

⭐Python爬虫学习总结-爬取某素材网图片

最近在学习python爬虫,完成了一个简单的爬取某素材网站的功能,记录操作实现的过程,增加对爬虫的使用和了解。

1️⃣ 前期准备

1.1 浏览器安装xpath插件(以chrome浏览器为例)

插件下载地址:https://wwa.lanzout.com/iUwy601einob

将插件手动拖拽到浏览器扩展中即可完成安装(安装完后需要重启浏览器)

启动插件快捷键Ctrl+shift+x

1.2 安转lxml依赖

安转lxml依赖前,需要安装有pip才能下载依赖

查看电脑是否安装pip指令:pip -V

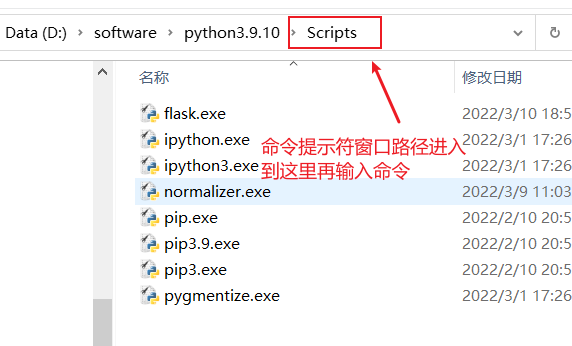

安装lxml前需要先进入到python解释器的Scripts路径中

安装指令:pip install lxml ‐i https://pypi.douban.com/simple

1.3 学习xpath基本语法

xpath基本语法:

1.路径查询

//:查找所有子孙节点,不考虑层级关系

/ :找直接子节点

2.谓词查询

//div[@id]

//div[@id="maincontent"]

3.属性查询

//@class

4.模糊查询

//div[contains(@id, "he")]

//div[starts‐with(@id, "he")]

5.内容查询

//div/h1/text()

6.逻辑运算

//div[@id="head" and @class="s_down"]

//title | //price

2️⃣ 分析界面

以站长素材网站为例:https://sc.chinaz.com/

2.1查看图片页面的源码,分析页面链接规律

打开有侧边栏的风景图片(以风景图片为例,分析网页源码)

第一页图片的地址:https://sc.chinaz.com/tupian/fengjingtupian.html

第二页图片的地址:https://sc.chinaz.com/tupian/fengjingtupian_2.html

第三页图片的地址:https://sc.chinaz.com/tupian/fengjingtupian_3.html

第n页图片的地址:https://sc.chinaz.com/tupian/fengjingtupian_page.html page是代表当前的页数

⭐通过分析网址可以得到每页网址的规律,接下来分析图片地址如何获取到

2.2 分析如何获取图片下载地址

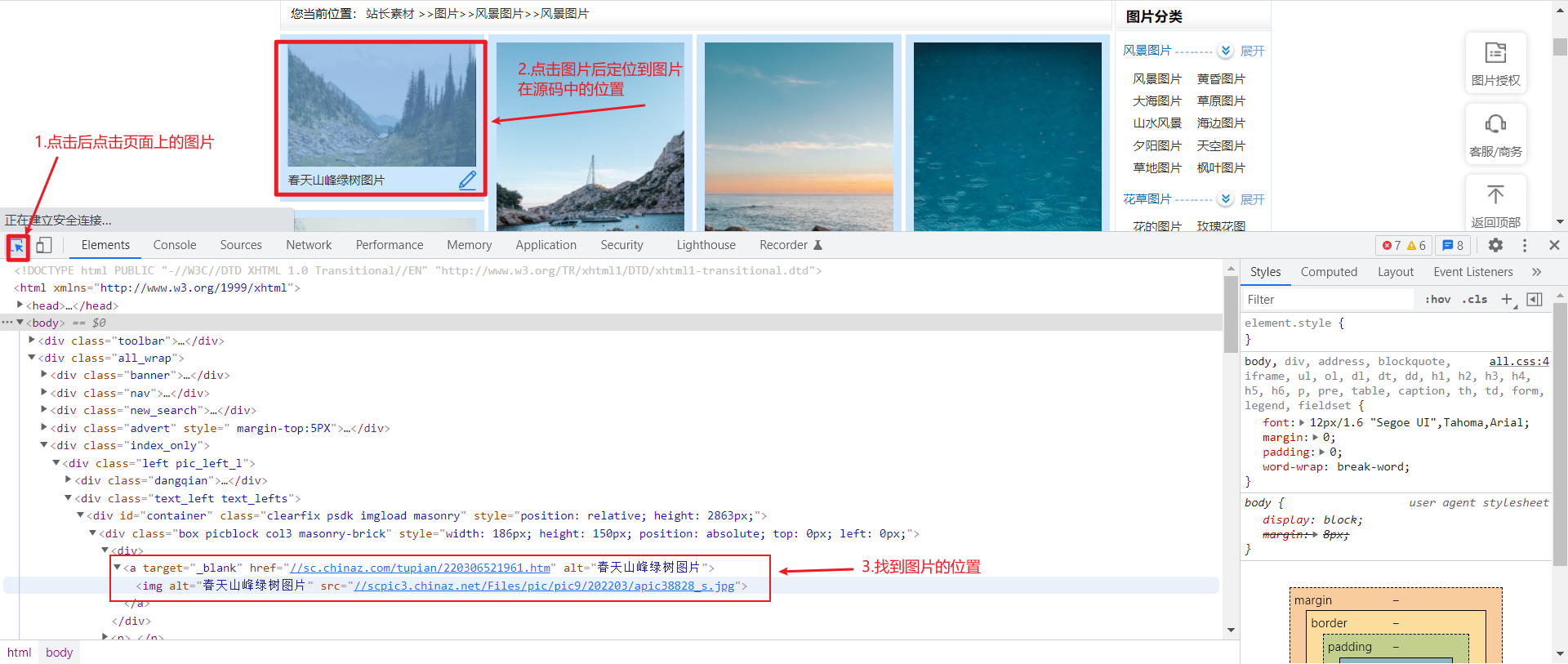

首先在第一页通过F12打开开发者工具,找到图片在源代码中位置

:⭐通过分析源码可以看到图片的下载地址和图片的名字,接下来通过xpath解析,获取到图片名字和图片地址

2.3 xpath解析获取图片地址和名字

调用xpath插件得到图片名字://div[@id="container"]//img/@alt

图片下载地址://div[@id="container"]//img/@src2

注意:由于该界面图片的加载方式是懒加载,一开始获取到的图片下载地址才是真正的下载地址也就是src2标签

⭐前面的工作准备好了,接下来就是书写代码

3️⃣代码实现

3.1 导入对应库

3.2 函数书写

请求对象的定制

获取网页源码

下载图片到本地

主函数

💻完整代码

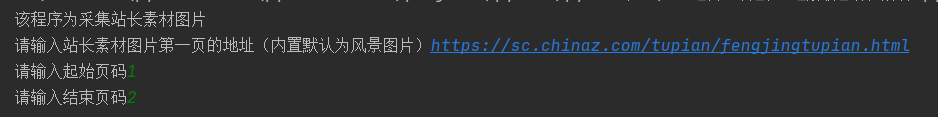

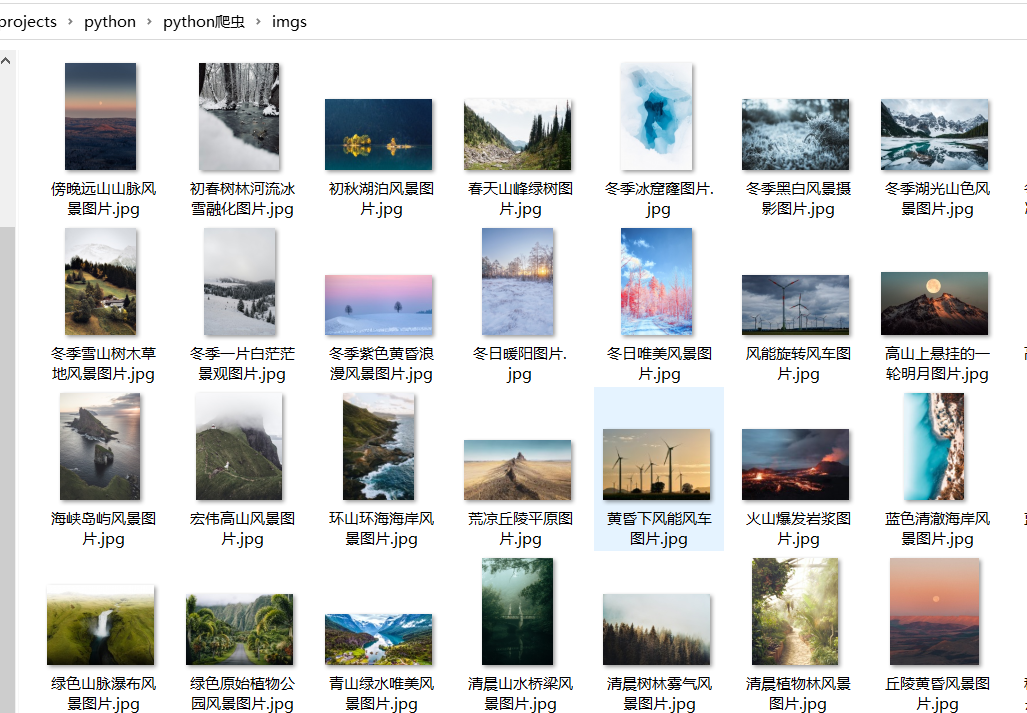

4️⃣运行结果

🚀总结

此次案例是基于尚硅谷的python视频学习后的总结,感兴趣的可以去看全套视频,尚硅谷Python爬虫教程小白零基础速通(含python基础+爬虫案例)_哔哩哔哩_bilibili

人们总说兴趣是最好的老师,自从接触爬虫后我觉得python十分有趣,这也是我学习的动力,通过对一次案例的简单总结,回顾已经学习的知识,并不断学习新知识,是记录也是分享。

__EOF__

本文链接:https://www.cnblogs.com/wlunan/p/16008891.html

关于博主:评论和私信会在第一时间回复。或者直接私信我。

版权声明:本博客所有文章除特别声明外,均采用 BY-NC-SA 许可协议。转载请注明出处!

声援博主:如果您觉得文章对您有帮助,可以点击文章右下角【推荐】一下。您的鼓励是博主的最大动力!

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本

· C#/.NET/.NET Core优秀项目和框架2025年2月简报

· Manus爆火,是硬核还是营销?

· 一文读懂知识蒸馏

· 终于写完轮子一部分:tcp代理 了,记录一下