01 2022 档案

摘要:一、凸二次规划(convex quadratic programming)问题 凸函数:这里的凸函数与高数不一样:国内分为下凸函数(就是高数中的凹函数)上凸函数 f(x)=x直线也是凸函数,但不严格 严格的来说应该是f[(x1+x2)/2]<[f(x1)+f(x2)]/2例如f(x)=x2 仿射函数

阅读全文

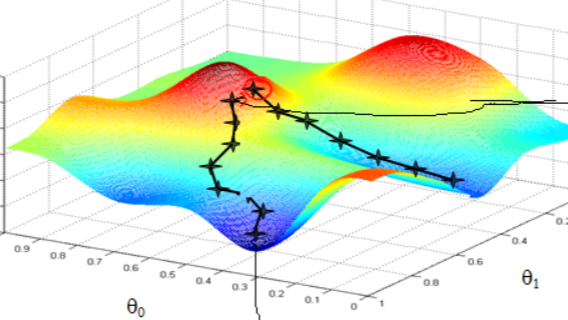

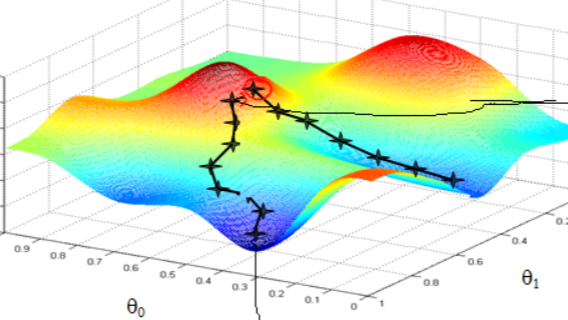

摘要:一、神经网络--反向传播详细推导过程中的公式推导 其中,aL和y为特征维度为n_out的向量,而||S||2为S的L2范数。 损失函数有了,现在我们开始用梯度下降法迭代求解每一层的W,b 首先是输出层第L层。注意到输出层的W,b满足下式: 求导用到的公式有: 1:标量对多个向量的链式求导法则:x→y

阅读全文

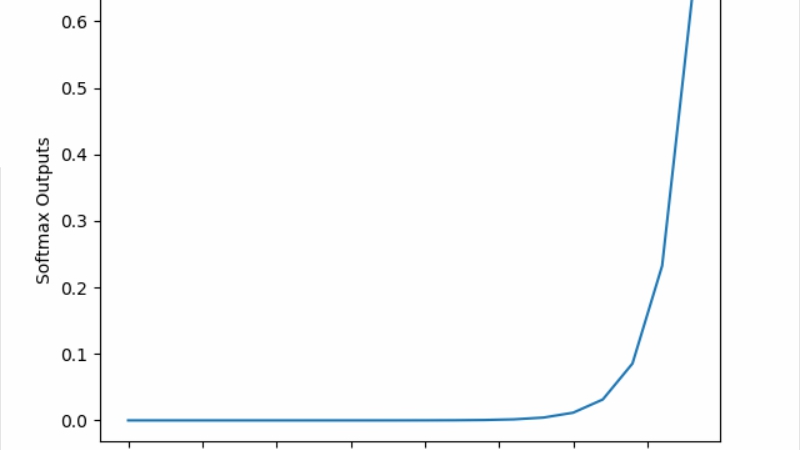

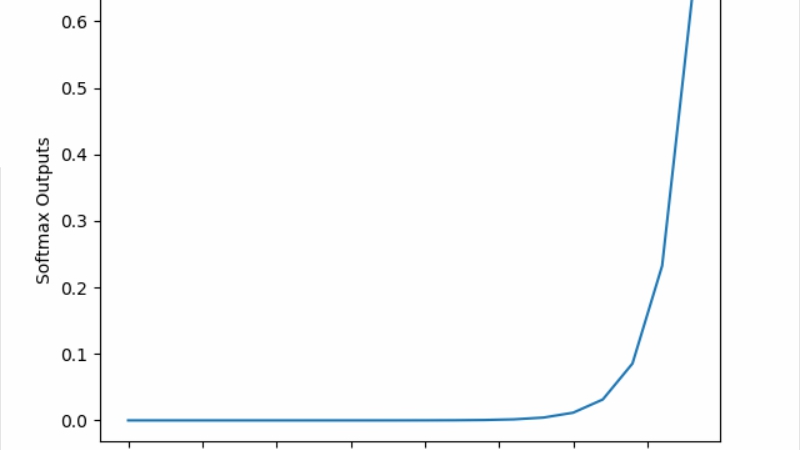

摘要: 前文介绍 在深度学习中,输入值和矩阵的运算是线性的,而多个线性函数的组合仍然是线性函数,对于多个隐藏层的神经网络,如果每一层都是线性函数,那么这些层在做的就只是进行线性计算,最终效果和一个隐藏层相当!那这样的模型的表达能力就非常有限 。 实际上大多数情况下输入数据和输出数据的关系都是非线性的。所以我

阅读全文

前文介绍 在深度学习中,输入值和矩阵的运算是线性的,而多个线性函数的组合仍然是线性函数,对于多个隐藏层的神经网络,如果每一层都是线性函数,那么这些层在做的就只是进行线性计算,最终效果和一个隐藏层相当!那这样的模型的表达能力就非常有限 。 实际上大多数情况下输入数据和输出数据的关系都是非线性的。所以我

阅读全文

前文介绍 在深度学习中,输入值和矩阵的运算是线性的,而多个线性函数的组合仍然是线性函数,对于多个隐藏层的神经网络,如果每一层都是线性函数,那么这些层在做的就只是进行线性计算,最终效果和一个隐藏层相当!那这样的模型的表达能力就非常有限 。 实际上大多数情况下输入数据和输出数据的关系都是非线性的。所以我

阅读全文

前文介绍 在深度学习中,输入值和矩阵的运算是线性的,而多个线性函数的组合仍然是线性函数,对于多个隐藏层的神经网络,如果每一层都是线性函数,那么这些层在做的就只是进行线性计算,最终效果和一个隐藏层相当!那这样的模型的表达能力就非常有限 。 实际上大多数情况下输入数据和输出数据的关系都是非线性的。所以我

阅读全文

摘要:DDA(深度域自适应):DDA 基于为 DA 设计的深度学习架构 1、解决域转移的机制 2、一步与多步适应方法

阅读全文

摘要: 损失函数与风险函数 监督学习问题是在假设空间F中选取模型f作为决策函数,对于给定的输入X,由f(X)给出相应的输出Y,这个输出的预测值f(X)与真实值Y可能一致也可能不一致,用一个损失函数(loss function)或代价函数(cost function)来度量预测错误的程度.损失函数是f(X)和

阅读全文

损失函数与风险函数 监督学习问题是在假设空间F中选取模型f作为决策函数,对于给定的输入X,由f(X)给出相应的输出Y,这个输出的预测值f(X)与真实值Y可能一致也可能不一致,用一个损失函数(loss function)或代价函数(cost function)来度量预测错误的程度.损失函数是f(X)和

阅读全文

损失函数与风险函数 监督学习问题是在假设空间F中选取模型f作为决策函数,对于给定的输入X,由f(X)给出相应的输出Y,这个输出的预测值f(X)与真实值Y可能一致也可能不一致,用一个损失函数(loss function)或代价函数(cost function)来度量预测错误的程度.损失函数是f(X)和

阅读全文

损失函数与风险函数 监督学习问题是在假设空间F中选取模型f作为决策函数,对于给定的输入X,由f(X)给出相应的输出Y,这个输出的预测值f(X)与真实值Y可能一致也可能不一致,用一个损失函数(loss function)或代价函数(cost function)来度量预测错误的程度.损失函数是f(X)和

阅读全文

摘要:数据集的表示方法: 数据集 数据集中的X是矩阵T={(X1,Y1),(X2,Y2).....(Xn,Yn)} 向量 其中有N个样本n个特征 联合概率=边缘概率*条件概率(X,Y遵循联合概率分布P(X,Y)) P(X,Y)=P(Y)*P(X|Y) 统计学习方法的三个要素: 模型:假设空间中有很多模型供

阅读全文

浙公网安备 33010602011771号

浙公网安备 33010602011771号