多模态学习之论文阅读:《Pre-gating and Contextual Attention Gate — A new fusion method for multi-modal data tasks》

《Pre-gating and Contextual Attention Gate — A new fusion method for multi-modal data tasks》 -2024.11 影响因子7.9

(一)要点

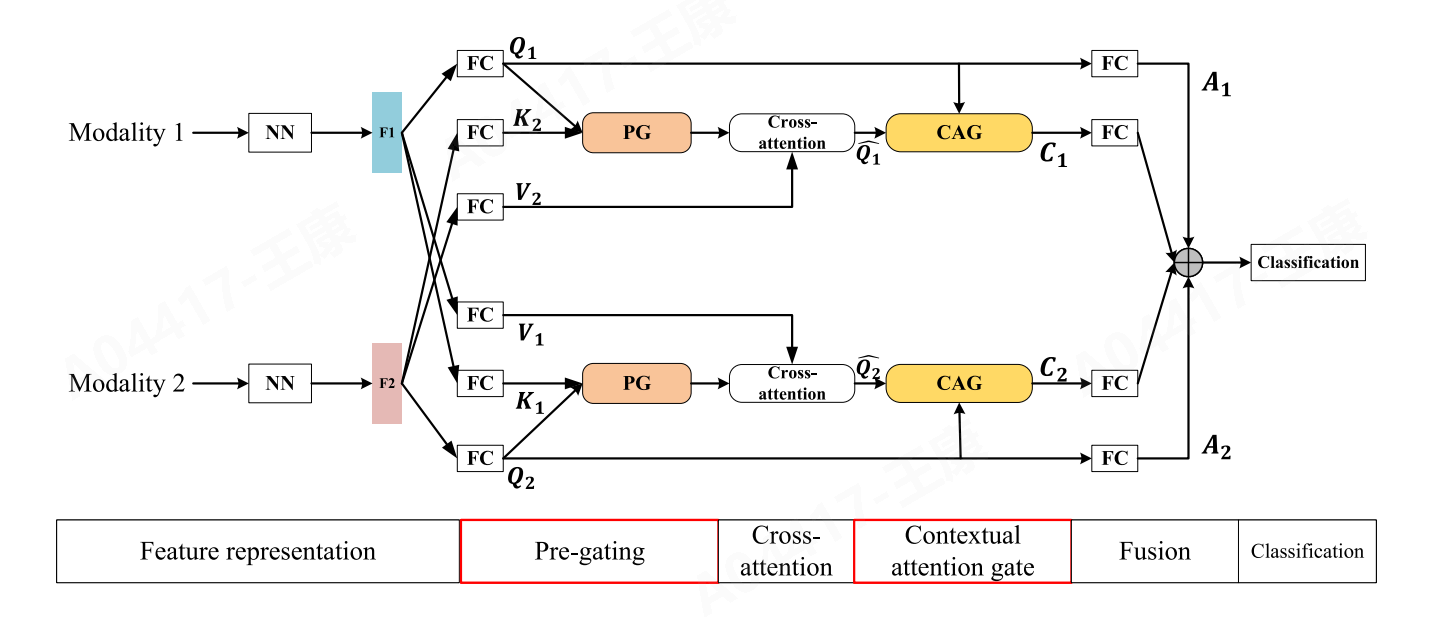

- 提出一种新的多模态数据融合方法,即PCAG(Pre-gating and Contextual Attention Gate),以解决现有跨模态交互学习中的噪声问题和不确定性问题。

- PCAG包含两个关键机制:Pre-gating和Contextual Attention Gate (CAG)。Pre-gating在跨注意力之前直接控制跨模态交互的生成,而CAG则在跨注意力之后,利用上下文信息来评估生成的注意力向量的相关性。

与现有方法相比,PCAG的特点和优势在于其预过滤和上下文评估的设计:

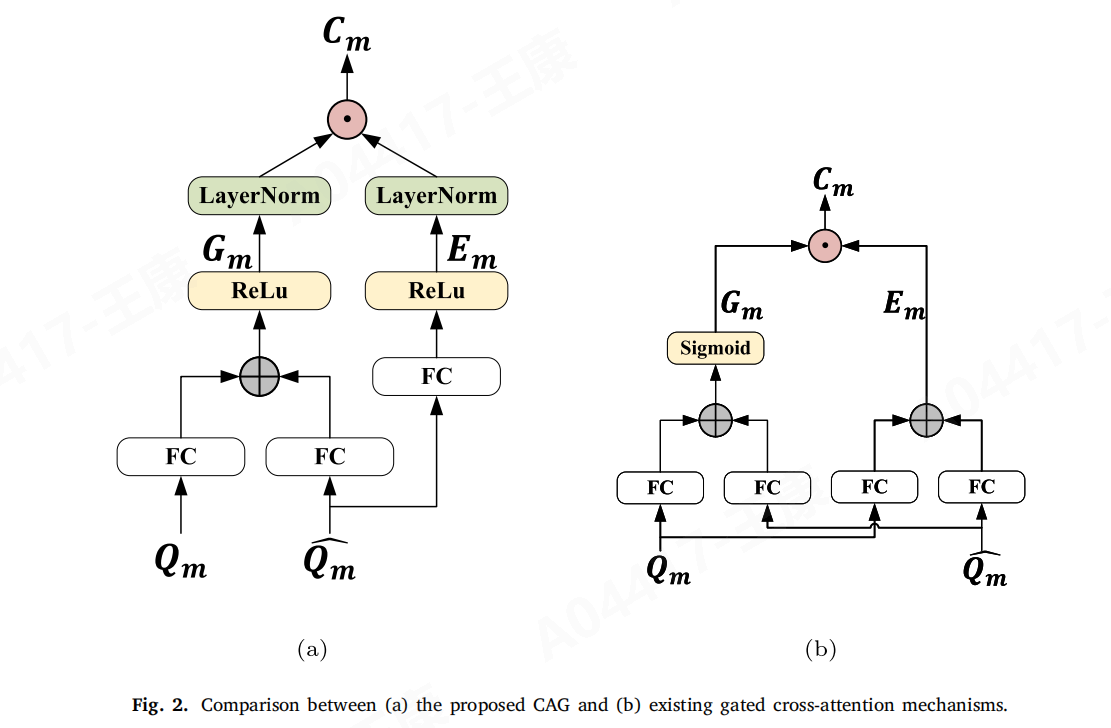

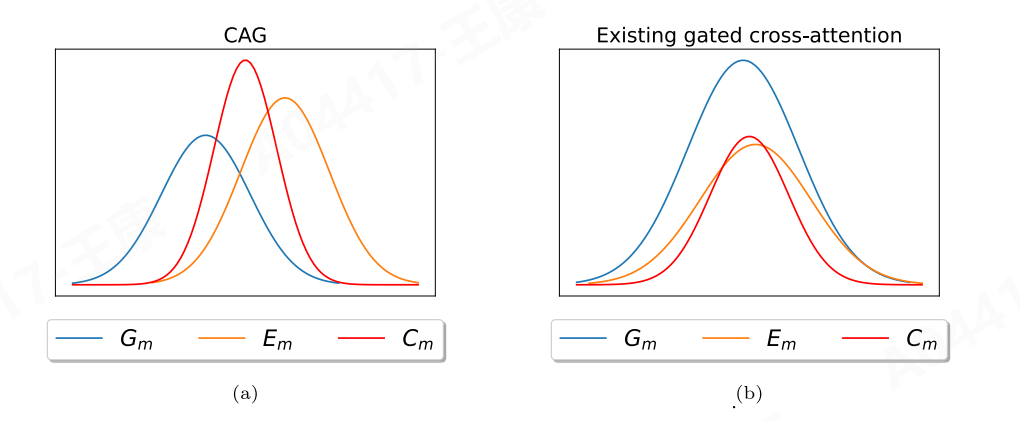

CAG(Contextual Attention Gate)与现有的最先进带门控的跨注意力机制(the CAG and the state-of-the-art gated cross-attention mechanisms (Jiang et al., 2020; Kumar & Vepa, 2020))的区别:

激活函数的使用:

现有方法:通常使用sigmoid激活函数。Sigmoid函数的输出范围是(0, 1),这允许模型学习到哪些信息是相关的,哪些是无关的,从而尝试阻断无关信息。

CAG方法:不同于现有方法,CAG中的激活函数主要用于限制特征空间,以便在后续步骤中对特征向量E(Information features)和G(Gated features)进行比较。这意味着CAG可能使用ReLU等其他激活函数,这些函数有助于在特征空间中保持信息的动态范围,而不是像sigmoid那样压缩到(0, 1)范围内。

学习E和G的方式:

现有方法:在现有方法中,E和G的学习涉及查询特征和注意力特征,即基于查询Q和注意力向量α的组合来计算。

CAG方法:CAG只利用跨模态信息(例如,通过跨注意力机制Q帽)来学习E,目的是确定哪些部分的信息应该保留。CAG专注于使用上下文信息来指导哪些特征是重要的,而不是简单地混合所有可用的特征。

- Pre-gating:预门控机制,是在应用跨模态注意力之前使用的一个机制,用于在计算注意力分数之前通过预期机制,减轻噪声交互的影响、过滤掉无用的交互、筛选出对下游任务有用的交互,提高注意力分数的生成质量。

- Contextual Attention Gate (CAG):上下文注意力门,利用上下文信息来减少由跨注意力交互生成的注意力向量与原始上下文信息不相关的这种不确定性情况,增强分类性能。例如若注意力向量与原始上下文信息不相关,则减少其对下游任务的影响。

- PCAG模块的工作原理:

l 阶段1 - Pre-gating:在跨模态交互之前,PCAG模块首先应用预门控机制。这一阶段,模型评估不同模态特征之间的潜在交互,并决定哪些交互是有价值的。这有助于在交互发生之前就减少噪声。

l 阶段2 - 跨模态交互:在预门控之后,模型进行跨模态交互,生成初步的注意力向量。

l 阶段3 - CAG应用:一旦得到注意力向量,CAG机制就会介入。CAG利用上下文信息来评估每个注意力向量的相关性,并据此调整它们的权重。如果发现某个向量与上下文不匹配,CAG会降低其重要性,从而减少对最终结果的影响。

(二)步骤

1. 实验设计:

实验在八个多模态分类任务上进行,覆盖了不同的领域,如社交媒体文本和图像的情感分析、音频和图像的手写数字识别、医疗数据的死亡率预测等,采用了RoBERTa和Vision Transformer等预训练模型来提取特征,并在这些特征上应用PCAG模块。

2. 实验数据和结果:

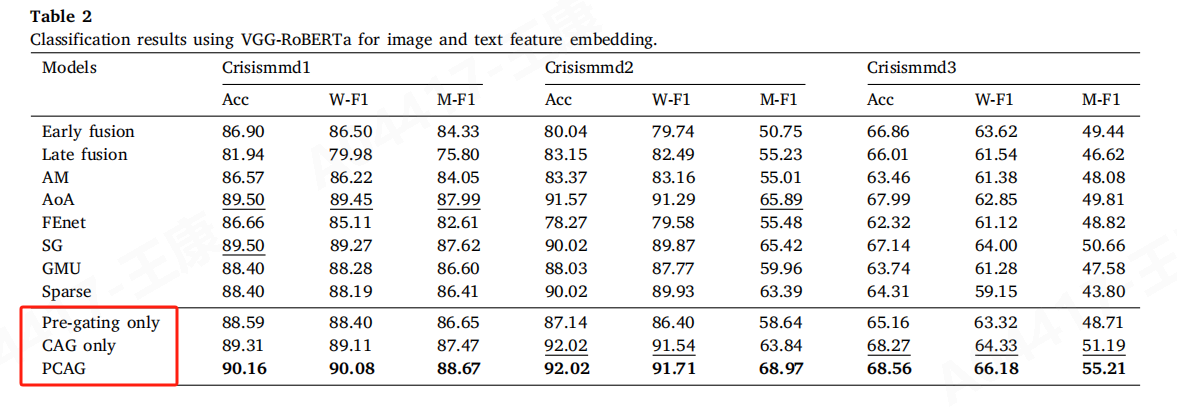

实验结果显示,PCAG模型在多个数据集上的性能均优于现有的多模态融合模型。例如,在Crisismmd数据集上,PCAG模型的准确率(ACC)达到了90.16%,加权F1分数(W-F1)为90.08%,宏观F1分数(M-F1)为88.67%,相较于其他模型有显著提升。

3. 可视化展示:

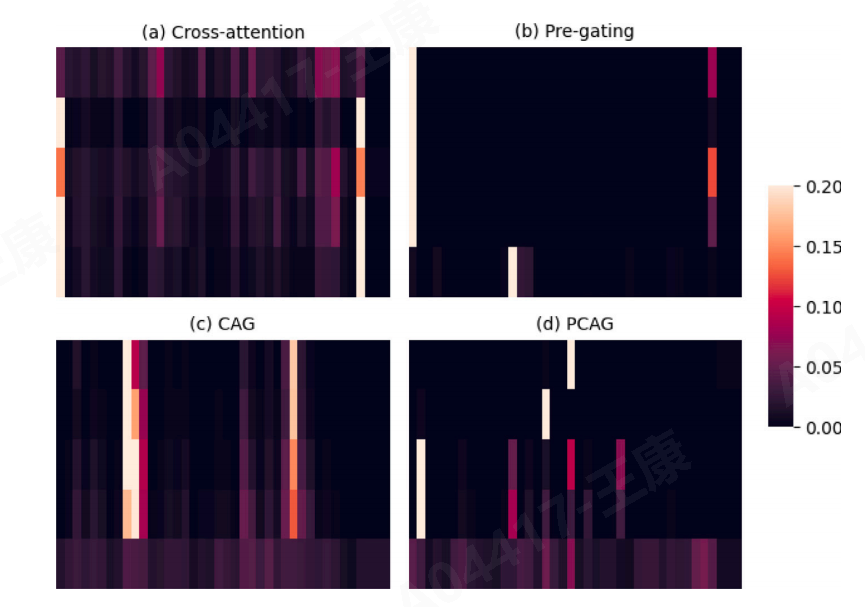

展示了使用Crisismmd2数据集时,PCAG(Pre-gating and Contextual Attention Gate)、Pre-gating、CAG以及传统跨注意力模型的注意力分数的可视化。

说明:

坐标轴:垂直轴(y轴)代表图像特征,水平轴(x轴)代表文本标记(tokens)。

每一行:代表了一个图像特征(由Vision Transformer,ViT生成)与所有文本标记之间的交互。

颜色深浅:颜色越浅表示注意力分数越高,颜色越深表示注意力分数接近零。白色表示注意力分数大于0.2。

PCAG、Pre-gating、CAG与跨注意力模型的比较:

PCAG:展示出平衡的注意力分数分布,其中Pre-gating和CAG的结合使得模型能够选择性地关注对任务最有用的交互。

Pre-gating:展示出较为集中的高注意力分数区域,表明Pre-gating机制集中过滤并强化了与下游任务相关的特定交互。

CAG:展示出不同的注意力分数分布,其中CAG专注于减少与查询不相关的交互,可能在某些区域显示出高注意力分数,而在其他区域则降低。

传统跨注意力:展示出较为分散的高注意力分数,表明传统方法在没有特定过滤机制的情况下,对所有可能的模态交互给予了较高的注意力。

结论:

上图的可视化提供了对不同模型如何处理和分配跨模态交互注意力的直观理解。PCAG模型通过结合Pre-gating和CAG机制,能够更加精确地识别和强化与任务相关的特征交互,同时减少噪声和不相关交互的影响。这种可视化有助于理解不同模型在实际数据上的表现,并为进一步优化模型提供指导。

(三)心得

1. 一种新颖的多模态数据融合方法,特别是PCAG模块如何通过Pre-gating和CAG机制有效地减少噪声和不确定性,提高模型性能。为设计后续改进型多模态学习模型时提供了新的视角。

2. 需要补充多模态学习的基础理论、研读论文提到的一些既往融合方法论文。

3. 需进一步挖掘论文提到的注意力机制和门控网络的工作原理。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 单元测试从入门到精通

· winform 绘制太阳,地球,月球 运作规律

· 上周热点回顾(3.3-3.9)